Hay una cosa que está en boca de todos desde hace un par de años: ChatGPT.

Profesores preocuparse de que esté escribiendo los deberes de los alumnos.

Escritores temen que la IA escriba libros e historias en su lugar.

Codificadores temen que construya sitios web y aplicaciones mejor que los humanos.

Algunos incluso predicen que millones de puestos de trabajo podrían desaparecer debido a la IA.

Todos hemos oído hablar de ella. Pero, ¿se ha preguntado alguna vez cómo ¿Funciona ChatGPT?

¿Cómo escribe ChatGPT los deberes de un niño? ¿Qué ocurre entre bastidores cuando escribes una pregunta y te responde como una persona real?

¿Cómo puede una máquina escribir poemas, historias y códigos, aunque no entienda las palabras como nosotros?

En este blog, miraremos dentro ChatGPT y explicar qué es ChatGPT y cómo funciona, paso a paso.

Aprenderás cómo recuerda las cosas, cuáles son sus límites y cómo se crean este tipo de herramientas.

Empecemos.

La Fundación: Modelos lingüísticos GPT

ChatGPT es una IA hecha para entender y escribir como un humano.

Se llama modelo lingüístico porque trabaja con el lenguaje: lo lee, lo predice y lo genera.

Pero no entiende como la gente. No piensa. No conoce los hechos. Sólo observa patrones.

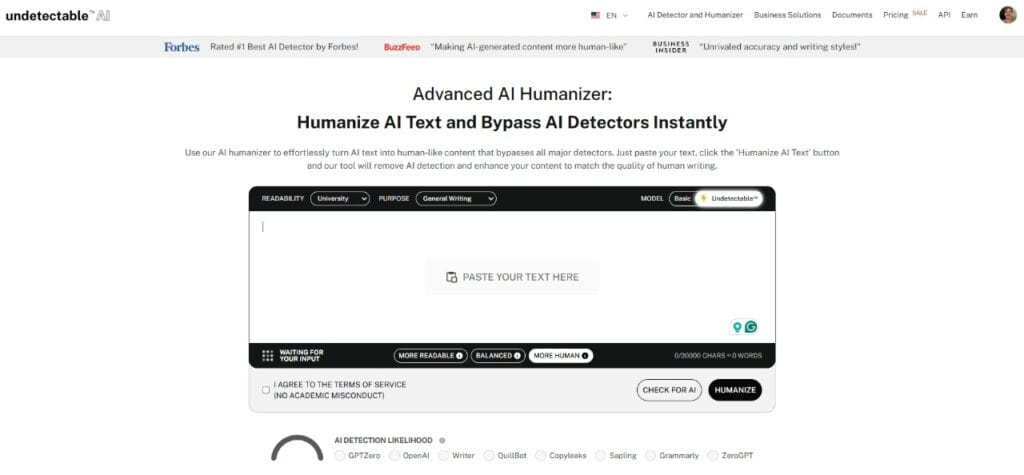

No vuelvas a preocuparte de que la IA detecte tus textos. Undetectable AI puede ayudarle:

- Haz que aparezca tu escritura asistida por IA de aspecto humano.

- Bypass las principales herramientas de detección de IA con un solo clic.

- Utilice AI de forma segura y con confianza en la escuela y el trabajo.

Por ejemplo,

- Si tecleas, "El cielo es..."

- Puede decir "Azul".

No porque sepa que el cielo es azul, sino porque vio esa frase millones de veces durante el entrenamiento. Aprendió que "azul" suele ir después de "el cielo es".

Este tipo de IA se denomina LLMque significa Modelo lingüístico grande.

Se entrena con montones de libros de texto, páginas web y demás para averiguar cómo utilizan las palabras los seres humanos. Pero no lee en busca de significado. Aprende cómo suelen aparecer las palabras una junto a otra.

GPT es un tipo específico de LLM.

GPT significa "Transformador generativo preentrenado".

- Generativo - puede crear texto nuevo.

- Preentrenado - que aprenda antes de hablar contigo.

- Transformador - la tecnología clave del funcionamiento de ChatGPT, que le ayuda a comprender cómo se relacionan las palabras en una frase, un párrafo o incluso una conversación.

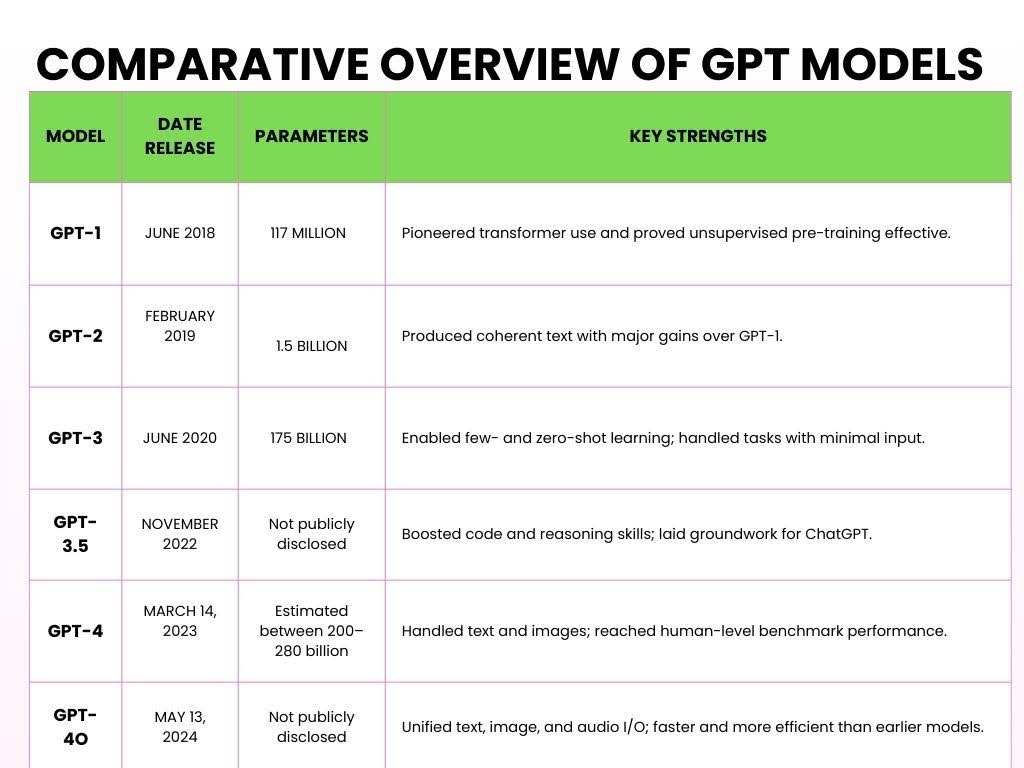

Estas son las diferentes versiones de GPT que se han lanzado a lo largo de los años.

Cómo funciona ChatGPT

Aquí tienes un desglose simplificado de cómo funciona ChatGPT y procesa tus entradas en cinco pasos clave.

- Paso 1: Preentrenamiento con datos masivos

Grandes modelos lingüísticos (LLM) como ChatGPT se entrenan previamente procesando grandes cantidades de texto de Internet para aprender patrones lingüísticos.

Durante el preentrenamiento, el modelo procesa billones de fichas (pequeños fragmentos de texto).

A ficha puede ser una palabra, parte de una palabra o incluso signos de puntuación, dependiendo de cómo el modelo tokenice la entrada.

Por ejemplo,

Le haces una pregunta matemática a ChatGPT, como por ejemplo

Problema:

- 2 + 3 = ?

Durante su entrenamiento, ChatGPT lee cientos de miles de millones de palabras de libros, noticias, artículos, Wikipedia, relatos, artículos científicos e incluso hilos de Reddit.

Esta formación y la lectura le ayudan a comprender cómo funciona la suma.

Por ejemplo,

Podría aprender la propiedad conmutativa (es decir, 2 + 3 = 3 + 2) a través de dichos contextos.

ChatGPT ve muchos ejemplos como

- "2 + 3 = 5,"

- "7 + 8 = 15,"

- "9 + 4 = 13."

No aprende sólo estos ejemplos concretos, aprende el patrón de la suma.

Entiende cómo interactúan los números con el símbolo "+" y cómo el resultado suele seguir al símbolo "=".

- Paso 2: La arquitectura del transformador

Una vez que ChatGPT había visto una cantidad ingente de palabras, necesitaba un cerebro que pudiera dar sentido a toda esa información. Ese cerebro de IA se llama "Transformer".

Lo que diferencia al Transformer es su capacidad para centrar la atención en las partes más importantes de la entrada, de forma muy parecida a cómo procesamos el lenguaje.

Por ejemplo,

Apliquemos esto a un problema matemático:

- "¿Cuál es la suma de 5 y 7?"

Al procesarlo, el Transformer no se limita a ir palabra por palabra.

En su lugar, examina el contexto completo: "suma", "5" y "7", todo a la vez.

Reconoce que "suma" se refiere a "adición" y que "5" y "7" son los números implicados.

El Transformador da entonces más "atención" a aquellas palabras que inciden directamente en la respuesta, por lo que se centra en la operación ("suma") y en los números ("5" y "7").

Esta es una de las claves del funcionamiento de ChatGPT. no procesa linealmente el problema, pero de forma que le ayude a comprender la relación entre los elementos.

Esta capacidad de verlo todo en su contexto es lo que hace tan poderoso al Transformer.

En lugar de limitarse a averiguar lo que viene a continuación, entiende el significado conectando las piezas relevantes de la frase.

- Paso 3: Tokenización y procesamiento lingüístico

Cuando escribes un texto en ChatGPT, éste lo divide en pequeños fragmentos. fichas.

Algunas fichas son palabras completas, mientras que otras son sólo partes de palabras.

Por ejemplo,

Al introducir "ChatGPT es inteligente". ChatGPT lo divide en los siguientes tokens:

["Chat", "G", "PT", "es", "inteligente"]

Incluso el nombre "ChatGPT" se divide en diferentes fichas.

Este proceso se denomina tokenización. Como los modelos se han entrenado con tokens en lugar de palabras completas, es mucho más flexible de lo que puede manejar:

Varios idiomas (ya que las distintas lenguas tienen estructuras de palabras diferentes),

Jerga y abreviaturas (como "u" por "tú" o "idk" por "no sé").

Incluso palabras inventadas o variaciones (como dividir "increíble" en "un", "believ", "able").

- Paso 4: Puesta a punto y capas de seguridad

Una vez que ChatGPT se ha entrenado con una gran cantidad de datos, aún no está listo para el prime time.

Sigue necesitando ayuda para asegurarse de que responde de la forma más útil, educada y segura.

A través de ajuste fino supervisadoLos revisores humanos dan a ChatGPT ejemplos de lo que constituye una buena respuesta. Por ejemplo,

- "¿Cuánto es 5 + 7?"

- Mala respuesta: Es una pregunta fácil. ¿Por qué no lo sabes?

- Buena respuesta: La suma de 5 y 7 es 12.

Con el tiempo, ChatGPT se entrena con mejores ejemplos para ser más educado, claro y centrado.

Una vez que tiene una base sólida, recibe ayuda más avanzada a través de Aprendizaje por refuerzo a partir de información humana (RLHF).

El proceso es el siguiente:

- ChatGPT responde.

- Tasa humana Esa respuesta se basa en su calidad, es decir, en su utilidad, precisión y seguridad.

- ChatGPT aprende de estos comentarios e intenta dar mejores respuestas en el futuro.

Por ejemplo, Imagina que ChatGPT responde a un problema matemático, como por ejemplo "¿Cuánto es 12 dividido por 4?":

- ChatGPT responde: "3."

- Respuesta humana: Esta respuesta es genial.

- ChatGPT aprende: Sigue dando este tipo de respuesta cuando surgen preguntas similares.

El objetivo es que ChatGPT siga mejorando, como un estudiante que aprende de los errores del pasado.

Por último, un objetivo importante del ajuste fino por parte del ser humano es la alinearse con los valores humanos.

Queremos que no sólo sea inteligente, sino también útil, inofensiva y honesta.

Por ejemplo, si un usuario hace una pregunta compleja como "¿Cuál es la raíz cuadrada de -1?"

En lugar de dar una respuesta incorrecta como "i es la respuesta" sin ningún contexto, proporcionaría:

Respuesta segura y alineada: La raíz cuadrada de -1 es un número imaginario, comúnmente representado como 'i'. Este concepto se utiliza en matemáticas avanzadas.

- Etapa 5: Entrada de la pregunta, salida de la respuesta

Este es el paso final en el que ChatGPT está listo para responder a sus preguntas.

Un prompt es el texto (es decir, pregunta, comando o declaración) que escribes en ChatGPT para iniciar la conversación y obtener una respuesta.

Por ejemplo,

Usted introduce la pregunta "¿Qué tiempo hace hoy?"

A continuación te explicamos cómo funciona ChatGPT entre bastidores:

Usted escribe una pregunta → ChatGPT la descompone en tokens → Busca patrones en los tokens → Predice la siguiente palabra → Forma una respuesta → Ajusta el tono en función de su texto → Obtiene su respuesta final.

Para el aviso "¿Qué tiempo hace hoy?", ChatGPT probablemente respondería con algo como:

"No puedo dar actualizaciones meteorológicas en tiempo real, pero puedes consultar una web o aplicación meteorológica como Weather.com o las noticias locales para obtener la información más precisa".

Esto se debe a que ChatGPT no tiene acceso a datos en directo a menos que esté conectado a una herramienta que obtenga información en tiempo real.

Cómo "recuerda" las conversaciones

Cuando hablas con ChatGPT, parece que recuerda cosas que has dicho antes.

Y lo hace, pero sólo mientras el chat está abierto. Imagina un gran bloc de notas en el que todo lo que escribes queda anotado:

Tú dirás:

- Mi perro se llama Max.

Unas líneas más adelante, usted dice:

- ¿Qué trucos puede aprender Max?

ChatGPT conecta los puntos. Recuerda que Max es tu perro, porque sigue en el bloc de notas.

Este bloc de notas se denomina ventana contextual, y contiene un número limitado de palabras (llamadas tokens).

Algunas versiones pueden contener unas 8.000 fichas, mientras que las más recientes pueden llegar hasta las 32.000 fichas.

Pero una vez alcanzado el límite, tiene que empezar a borrar las partes más antiguas para dejar espacio al texto nuevo.

Así que si dices "Mi perro se llama Max" al principio de una larga charla, y 50 párrafos después pregunta, "¿Cuál es una buena correa para él?" - podría olvidar quién es "él".

Porque esa información ya se ha borrado del bloc de notas.

Hablemos ahora de la memoria entre chats.

Normalmente, cuando cierras el chat, el bloc de notas se limpia.

Así, la próxima vez que abras ChatGPT, empezará de cero.

Pero si activas la memoria personalizada, ChatGPT puede recordar cosas entre sesiones. Por ejemplo,

- Dímelo tú: Dirijo una pequeña panadería en línea llamada Sweet Crumbs.

- Una semana después, dices: Escríbame una descripción del producto.

- Podría responder: ¡Claro! Aquí tienes una descripción para tus galletas Sweet Crumbs...

No lo recuerda todo. Sólo recuerda lo que tú permites, y se te avisará cuando se añada algo. Puedes ver, editar o borrar recuerdos en cualquier momento.

Así que...

ChatGPT en realidad no "Recuerda" como una persona. Sólo mira lo que tiene delante: la conversación actual.

Si parece que recuerda algo de antes, es porque esa información sigue dentro de la ventana contextual.

Limitaciones del funcionamiento de ChatGPT

ChatGPT es increíblemente útil, pero es importante comprender sus limitaciones, especialmente si lo utiliza para cualquier cosa relacionada con el cliente o la conversión.

1 - Sin comprensión ni conciencia reales

ChatGPT no entiende el contenido como los humanos. No "conoce" hechos, simplemente predice la siguiente palabra probable basándose en datos de entrenamiento.

Por ejemplo,

Si preguntas, "¿Qué significa el éxito?" puede generar una respuesta fluida, pero no tiene creencias, valores ni conciencia. Está imitando patrones, no formando percepciones.

2 - Sesgos de los datos de formación

Dado que ChatGPT se entrena a partir de grandes fuentes mixtas procedentes de Internet, libros, foros y artículos, puede heredar los sesgos que se encuentran en esos datos.

Si Internet se inclina hacia un lado en un tema, ChatGPT puede reflejar esa perspectiva -a veces sutilmente, a veces no- incluso cuando se requiere neutralidad.

3 - No navega por Internet

ChatGPT no puede obtener datos en tiempo real. Pregúntale por un producto lanzado la semana pasada o por el precio de una acción hoy, y no tendrá ni idea.

Sus datos de entrenamiento tienen un punto de corte, y cualquier cosa después de ese punto está fuera de su alcance.

4 - Puede "alucinar" con los hechos o citar fuentes falsas

Una de las peculiaridades más peligrosas: ChatGPT puede inventarse cosas. Pídele una estadística o una cita y puede que te responda,

"Según la Organización Mundial de la Salud, 80% de los adultos prefieren la marca X a la marca Y".

Suena oficial, pero es probable que esa estadística no exista.

No se recuperó, se inventó. Esta cuestión se conoce como alucinacióny es especialmente arriesgado en la investigación, el periodismo o los contenidos técnicos.

Si le preguntas a ChatGPT cómo funciona, verás que no siempre se ajusta a los hechos.

Si utilizas ChatGPT para escribir, el resultado te parecerá rígido, robótico o carente de ese toque humano.

Para esos matices, puede utilizar AI Humanizer.

En Humanizador AI reescribe las salidas de ChatGPT en función del tono, los matices y la emoción, lo que da a su contenido un latido.

En suaviza las frases incómodas, añade calidez, y hace que los textos técnicos o áridos resuenen entre el público.

Cuando tus contenidos suenan humanos, rinden más.

Tanto si está escribiendo páginas de destino, correos electrónicos o publicaciones en LinkedIn, la relacionabilidad impulsa la respuesta. Y la emoción impulsa la conversión.

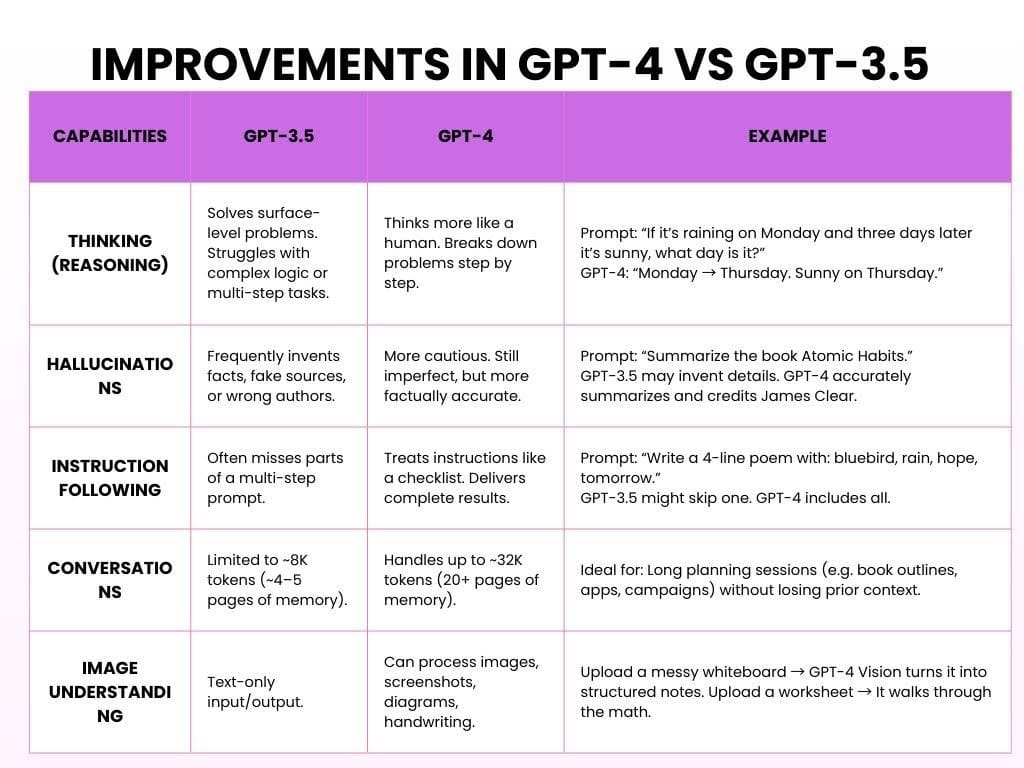

Mejoras en GPT-4 frente a GPT-3.5

GPT-3.5 es la versión gratuita, que es rápida, sólida y estupenda para tareas sencillas. GPT-4 es una versión de pago de OpenAI que es más inteligente, más potente y mucho más útil.

A continuación se explica cómo funciona ChatGPT con ambos modelos:

En resumidas cuentas, GPT-3.5 era útil. GPT-4 es fiable, reflexivo y da la sensación de que escucha.

Empieza a explorar: nuestro Detector de IA y nuestro Humanizador te esperan en el widget de abajo.

Cómo se crean herramientas de IA como ChatGPT

Crear una IA como ChatGPT u otros grandes modelos lingüísticos es un proyecto de varios años que implica conjuntos de datos masivos, equipos de expertos y una iteración incesante.

Así es como suele ocurrir:

- Primera fase: Recogida de datos (6-12 meses)

Objetivo: Enseñar las pautas lingüísticas modelo.

Antes de que una IA pueda responder a preguntas, tiene que aprender cómo escriben y hablan los humanos.

Esto comienza con la recopilación de cientos de miles de millones de palabras de libros, sitios web, noticias, artículos, trabajos académicos, etc.

No "lee" como los humanos. En su lugar, identifica patrones, tal y como hemos explicado en las secciones anteriores.

Tiempo necesario: De 6 a 12 meses, según la escala y el tamaño del equipo.

- Segunda fase: Preentrenamiento del modelo (6-9 meses)

Objetivo: Construye el cerebro.

El preentrenamiento consiste en alimentar el modelo con grandes volúmenes de texto y dejar que prediga las palabras que faltan una y otra vez hasta que empiece a acertar.

Esta fase suele requerir Clusters de GPU y cientos de millones de dólares en recursos informáticos.

Tiempo necesario: De 6 a 9 meses de formación ininterrumpida en GPU.

3. Tercera fase: Puesta a punto y retroalimentación humana (3-6 meses)

Objetivo: Haz que la IA sea útil.

Ahora puede hablar, pero ¿tiene sentido? Puede que sí o puede que no. En este punto, los revisores humanos evalúan los resultados, corrigen los errores y guían el modelo mediante el Aprendizaje por Refuerzo a partir de la Retroalimentación Humana (RLHF).

Tiempo necesario: De 3 a 6 meses, a menudo en paralelo a las primeras pruebas.

4. Cuarta fase: Despliegue e infraestructura (en curso)

Objetivo: Que sea escalable.

Una vez entrenado, el modelo se despliega en sitios web, aplicaciones, API y plataformas empresariales. Esto requiere una infraestructura de backend importante: centros de datos, API autoescalables y sistemas de equilibrio de carga para gestionar millones de usuarios simultáneos.

Calendario: Comienza después de la formación, pero continúa indefinidamente.

5. Quinta fase: Seguridad, parcialidad y ética (en curso, paralela)

Objetivo: Que sea seguro, honesto y no dañino.

La IA no es sólo inteligencia, sino también responsabilidad. Los equipos éticos trabajan en paralelo para detectar posibles usos indebidos, reducir la parcialidad, bloquear contenidos nocivos y respetar las normas de privacidad. Evalúan constantemente cómo se comporta el modelo en el mundo real.

Calendario: Proceso permanente; integrado en todas las etapas anteriores.

Preguntas frecuentes sobre el funcionamiento de ChatGPT

¿Busca ChatGPT respuestas en Internet?

A partir de octubre de 2024, ChatGPT adquirió la capacidad de navegar por Internet en tiempo real.

Al principio, esta función era exclusiva de los usuarios de pago, pero en diciembre de 2024 pasó a estar disponible para todos.

¿Es como un chatbot o algo más?

ChatGPT es un modelo de IA generativa. La IA generativa genera respuestas dinámicas y contextualizadas mediante el aprendizaje profundo.

Además de chatear, la IA generativa puede escribir ensayos, generar imágenes, componer música e incluso crear vídeos, lo que demuestra su versatilidad en diversos ámbitos.

¿Piensa ChatGPT?

No, el ChatGPT no piensa como los humanos. No tiene conciencia, creencias, intenciones ni emociones.

Lo que hace es predecir estadísticamente la siguiente palabra de una frase basándose en patrones de sus datos de entrenamiento. Esto puede parecer pensar, pero no lo es.

Reflexiones finales

Los grandes modelos lingüísticos (LLM) han cambiado nuestra forma de interactuar con la tecnología.

Pueden crear texto que suene como si lo hubiera escrito un humano, ayudando en tareas como responder preguntas y elaborar contenidos creativos.

Pero los LLM no "entender" cosas o piensan como personas. Funcionan prediciendo patrones en los datos, no mediante el pensamiento humano real.

A medida que mejoran los LLM, tenemos que pensar en los problemas que pueden causar, como la parcialidad, los problemas de privacidad y el uso indebido.

Es importante utilizar la IA con cuidado, asegurándose de que es justa, transparente y no difunde información falsa ni daña la privacidad.

Aquí están los directrices de uso:

- Ten en cuenta que la IA puede tener sesgos en su contenido.

- Utilice las herramientas de IA de forma que se respeten las normas de privacidad.

- Compruebe dos veces la información importante de fuentes fiables.

- No confíes demasiado en la IA. Es una herramienta, no un sustituto del pensamiento humano.

A medida que la tecnología de IA se hace más potente, surge la pregunta: ¿Cómo podemos garantizar que sus avances potencien la creatividad y la toma de decisiones humanas, en lugar de sustituir las cosas que nos hacen únicos?