De term deepfake dook voor het eerst op op Reddit in 2017toen een gebruiker met dezelfde schermnaam gewijzigde video's begon te delen waarin AI werd gebruikt om gezichten te verwisselen, in eerste instantie in inhoud voor volwassenen.

Hoewel Reddit de oorspronkelijke subreddit verbood, was het idee al van de grond gekomen.

Maar de wortels van deze technologie gaan nog verder terug.

In 1997 begonnen onderzoekers al te experimenteren met videobewerking door middel van machinaal leren.

Hun vroege lipsynchronisatietool, genaamd Video herschrijven zou het kunnen lijken alsof iemand iets heeft gezegd wat hij niet heeft gezegd.

Het was technisch gezien geen deepfake naar hedendaagse maatstaven, maar het legde wel de basis voor wat daarna zou komen.

De blog van vandaag gaat over hoe deze evoluerende technologie werkt, waar ze opduikt in het dagelijkse leven en welke risico's en voordelen ze met zich meebrengt.

Laten we beginnen met te begrijpen wat een deepfake eigenlijk is.

Belangrijkste opmerkingen:

- Deepfakes zijn door AI gegenereerde media die mensen dingen laten zeggen of doen die ze in werkelijkheid nooit hebben gedaan.

- Met gratis tools en basisvaardigheden kan bijna iedereen nu overtuigende deepfake video's, afbeeldingen of audioclips maken.

- Hoewel deepfakes creatief of vermakelijk kunnen zijn, brengen ze ook serieuze risico's met zich mee, zoals oplichting, laster en verkeerde informatie.

- Je kunt de meeste deepfakes herkennen door detectietools te gebruiken of goed te letten op visuele en gedragsmatige inconsistenties.

Wat is een Deepfake?

Een deepfake is nepmedium, meestal een video, audioclip of afbeelding, dat is aangepast met behulp van kunstmatige intelligentie om iemand eruit te laten zien of te laten klinken alsof hij iets doet of zegt wat hij in werkelijkheid nooit heeft gedaan.

Verwar dit niet met slecht Photoshop werk of een slechte voice-over.

We hebben het over manipulatie op hoog niveau met behulp van een technologie die deep learning wordt genoemd, een subset van AI.

Maak je nooit meer zorgen dat AI je sms'jes herkent. Undetectable AI Kan je helpen:

- Laat je AI-ondersteund schrijven verschijnen mensachtig.

- Omleiding alle grote AI-detectietools met slechts één klik.

- Gebruik AI veilig en vol vertrouwen op school en op het werk.

Dat is wat de term "deepfake" impliceert: deep learning en nepcontent.

Het doel van een deepfake is meestal om iets te maken dat er echt genoeg uitziet om mensen voor de gek te houden.

Misschien heb je wel eens van die virale video's gezien van beroemdheden die bizarre dingen doen of politici die schandalige uitspraken doen die ze nooit echt zouden zeggen.

Dat zijn klassieke deepfake-gebruiksgevallen. Wat je ziet is niet echt, maar de technologie erachter is zo goed geworden dat je hersenen de vervalsing niet meteen doorhebben, tenzij je echt goed kijkt.

Dat is waar tools zoals TruthScan stap in.

TruthScan is ontwikkeld voor organisaties die media op schaal moeten verifiëren, zoals bedrijven, nieuwsredacties, universiteiten en overheidsinstellingen. Het helpt teams manipulatie op te sporen voordat valse inhoud het vertrouwen of de reputatie schaadt.

Volgens het onderzoeksteam van Undetectable AI, 85 % van de Amerikanen zegt dat deepfakes hun vertrouwen in online informatie hebben aangetast.

Je hebt net geleerd wat een deepfake video of media eigenlijk is, nu hoe mensen deze maken.

Hoe deepfakes worden gemaakt

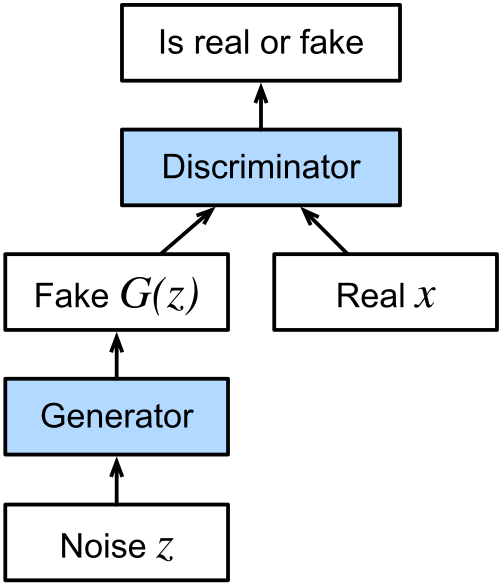

De technologie achter de meeste deepfakes is een categorie machine learning-algoritmen die generatieve adversariële netwerken of GAN's worden genoemd.

GAN's bestaan uit twee delen: een generator en een discriminator.

De generator creëert valse media op basis van wat is getraind om na te maken en het is de taak van de discriminator om aan te geven wat er nep uitziet.

Ze blijven heen en weer gaan totdat de generator beter wordt in het maken van valse inhoud die de discriminatortest kan doorstaan.

Na verloop van tijd leidt dit heen-en-weergeloop tot media die er schokkend realistisch uitzien.

Wat is een Deepfake Video-generatieproces?

Bij het maken van een deepfake video analyseert het systeem video's vanuit meerdere hoeken, bestudeert hoe de persoon praat, hoe zijn gezicht beweegt en hoe zijn lichaam verschuift.

Al die informatie wordt in de generator ingevoerd zodat deze inhoud kan maken die dat gedrag nabootst.

Vervolgens helpt de discriminator bij de fijnafstemming door aan te geven wat er niet klopt, totdat het eindresultaat er precies goed uitziet.

Daardoor blijft de illusie zo goed in beweging.

Er worden een paar verschillende technieken gebruikt, afhankelijk van het doel van de deepfake video.

Als het de bedoeling is om iemand in een video iets te laten zeggen of doen wat hij in werkelijkheid nooit heeft gezegd of gedaan, dan hebben we te maken met een zogenaamde bronvideo deepfake.

Een deepfake autoencoder, bestaande uit een encoder en decoder, bestudeert de originele beelden en past de uitdrukkingen, gebaren en subtiele hoofdbewegingen van het doelwit erop toe.

Audio Deepfakes

Een audio deepfake werkt door iemands stem te klonen, opnieuw met behulp van GAN's, gebaseerd op opnames van hoe iemand van nature spreekt.

Eenmaal getraind kan het model nieuwe spraak genereren met die stem, zelfs als de persoon die woorden nooit echt heeft gezegd.

Een andere laag die vaak wordt toegevoegd is lipsynchronisatie.

Hier koppelt het systeem gegenereerde of vooraf opgenomen audio aan een video.

Het doel is om de lippen in de video overeen te laten komen met de woorden in de audio.

Voorbeelden van Deepfakes in de echte wereld

Deepfakes duiken tegenwoordig overal op.

We laten je kennismaken met een aantal populaire deepfakes die laten zien hoe ver de technologie is gekomen.

Deepfake van president Zelenskyy die Oekraïense troepen vraagt zich over te geven

In maart 2022, tijdens het begin van de oorlog tussen Rusland en Oekraïne, dook er een video online op met de Oekraïense president Volodymyr Zelenskyy die zijn soldaten aanspoorde zich over te geven.

Het leek op een nationale toespraak, compleet met Zelenskyy's stem en maniertjes.

De video verspreidde zich via sociale media en werd zelfs geplaatst op een gecompromitteerde Oekraïense nieuwswebsite.

De president handelde snel en gaf een officiële verklaring vrij via zijn geverifieerde kanalen om de beelden te ontkrachten.

De virale Deepfake-afbeelding van paus Franciscus in een designerpufferjack

Soms hoeft een deepfake-afbeelding niet kwaadaardig te zijn om verwarring te zaaien.

In 2023, een virale foto van Paus Franciscus loopt rond in een stijlvolle witte Balenciaga pofjas veroverde het internet stormenderhand.

Het werd tientallen miljoenen keer bekeken en veel gedeeld op verschillende platforms.

De afbeelding is gemaakt met behulp van een AI-tool genaamd Midjourney door een anonieme gebruiker in Chicago.

Elon Musk Deepfakes gebruikt in online oplichtingspraktijken

In 2024, deepfakes met Elon Musk werd een centraal onderdeel van verschillende grootschalige online zwendelpraktijken.

AI-gegenereerde video's van Musk begonnen op te duiken op Facebook, TikTok en andere platforms en promoten nep-cryptocurrency weggeefacties en investeringsplannen.

Deze clips zagen er opmerkelijk echt uit en klonken ook echt.

De schade was niet alleen theoretisch. Een oudere gepensioneerde verloor naar verluidt bijna $700.000 nadat hij was overtuigd door een van deze video's.

De Joe Biden Deepfake Robocall die zich richtte op Amerikaanse kiezers

Begin 2024, vlak voor de New Hampshire voorverkiezing, kiezers ontvingen robocalls die precies klonk als de Amerikaanse president Joe Biden.

In het gesprek spoorde Joe Biden kiezers aan om thuis te blijven en hun stem te bewaren voor de algemene verkiezingen in november. De bedoeling was om kiezers te verwarren en te misleiden zodat ze de voorverkiezingen zouden overslaan.

Het incident leidde tot de roep om regelgeving. Belangengroepen drongen er bij de U.S. Federal Election Commission op aan om in te grijpen, maar de FEC wees dit uiteindelijk af met het argument dat haar bevoegdheden beperkt waren.

Ondertussen heeft het telecombedrijf dat verantwoordelijk is voor de distributie van de oproep stemde ermee in een boete van $1 miljoen te betalen.

Politiek Deepfake-gebruik bij de Indiase verkiezingen van 2020

Niet alle toepassingen van deepfake technologie zijn schadelijk of misleidend van opzet (meer hierover verderop in deze blog).

Tijdens de Delhi Legislative Assembly-verkiezingen van 2020 is de Bharatiya Janata Party gebruikt AI om campagneadvertentie op maat te maken voor verschillende taalpublieken.

De partij nam een video van haar leider Manoj Tiwari die in het Engels sprak en gebruikte deepfake lipsynchronisatie om een versie in het Haryanvi, een regionaal dialect, te produceren.

Terwijl de voice-over afkomstig was van een acteur, werden de beelden aangepast aan de nieuwe audio met behulp van AI die was getraind op echte beelden van Tiwari.

Partijleden zagen het als een positieve toepassing van de technologie die hen in staat stelde contact te leggen met kiezers in een taal die ze begrepen, zelfs als de kandidaat deze taal niet vloeiend sprak.

Deepfakes verifiëren in de echte wereld

Nu deepfakes zich verspreiden in de politiek, de entertainmentwereld en de dagelijkse communicatie, is het belangrijker dan ooit om te weten hoe je kunt controleren wat echt is.

Ondanks de opkomst van geavanceerde voorbeelden bestaan er betrouwbare tools om de dreiging van deepfake-technologie tegen te gaan.

Niet-opspoorbare AI's AI-videodetector is zo'n tool, die laat zien dat er betrouwbare tools bestaan om de geavanceerde voorbeelden van deepfake-technologie tegen te gaan.

Dat is waar Undetectable AI's Deepfake-detectie komt binnen.

Het is ontworpen om te controleren of audio- of video-inhoud kunstmatig is gegenereerdmet behulp van geavanceerde forensische modellen die frame-per-frame beweging, consistentie op pixelniveau en vocale fingerprinting analyseren.

Binnen enkele seconden kunnen gebruikers zien of een video digitaal is aangepast of dat een stem is gekloond door AI.

Upload gewoon het bestand en de tool levert een gedetailleerd echtheidsrapport met een visuele uitsplitsing en vertrouwensscore.

Of het nu gaat om een viral clip, een verdacht interview of een gedeelde opname, Deepfake Detection helpt journalisten, docenten en gewone gebruikers de waarheid te achterhalen achter wat ze zien en horen.

Zijn Deepfakes gevaarlijk? Risico's en zorgen

Tot nu toe hebben we gekeken naar wat een deepfake is, hoe het wordt gemaakt en waar het al is opgedoken in de echte wereld.

De technologie is onmiskenbaar indrukwekkend, maar de risico's die eraan verbonden zijn, zijn ernstig en nemen snel toe.

Deepfakes kunnen op meerdere manieren worden bewapend. Hier zijn een paar belangrijke punten van zorg.

Smaad

Als iemands gelijkenis of stem wordt gebruikt om nepopmerkingen, -verklaringen of -video's te maken, vooral als die aanstootgevend of controversieel zijn, kan dat reputaties vrijwel onmiddellijk ruïneren.

En in tegenstelling tot oudere hoaxes of nepcitaten laat een overtuigende deepfake weinig ruimte voor twijfel bij de kijker.

In dit opzicht kunnen deepfakes verontwaardiging opwekken, relaties vernietigen of simpelweg een schadelijk verhaal pushen.

Wat vooral verontrustend is, is dat de deepfake niet eens perfect hoeft te zijn.

Zolang de persoon herkenbaar is en de inhoud geloofwaardig genoeg, kan het een blijvende impact hebben op de publieke opinie.

Geloofwaardigheid van informatie

Een andere grote zorg is hoe deepfakes het idee van de waarheid zelf ondermijnen.

Nu deepfakes steeds vaker voorkomen, wordt het steeds moeilijker om te weten of wat we zien of horen echt is. Na verloop van tijd kan dit leiden tot een bredere erosie van vertrouwen in elke vorm van digitale communicatie.

Deze geloofwaardigheidscrisis gaat verder dan individuele incidenten.

In democratische samenlevingen vertrouwen mensen op gedeelde feiten om beslissingen te nemen, te debatteren en collectieve problemen op te lossen.

Maar als kiezers, kijkers of burgers alles in twijfel beginnen te trekken, wordt het veel gemakkelijker om de publieke opinie te manipuleren of om onwelgevallige waarheden af te doen als "gewoon weer zo'n deepfake".

Chantage

AI-gegenereerde media kunnen worden gebruikt om individuen valselijk te beschuldigen door het te laten lijken alsof ze iets illegaals, onethisch of gênants hebben gedaan.

Dit soort gefabriceerd bewijs kan dan gebruikt worden om hen te bedreigen of te controleren.

En het mes snijdt aan twee kanten. Omdat deepfakes nu zo realistisch zijn, kan iemand die geconfronteerd wordt met echte chantage beweren dat het bewijs nep is, zelfs als dat niet zo is.

Dit wordt ook wel chantage-inflatie genoemd, waarbij het grote aantal geloofwaardige vervalsingen uiteindelijk de waarde van het werkelijke belastende materiaal vermindert.

De geloofwaardigheid van echt bewijsmateriaal gaat verloren in de mist en dat maakt het alleen maar ingewikkelder om te proberen wangedrag aan het licht te brengen.

Fraude en oplichting

Met behulp van AI-gegenereerde video's of stemmen van betrouwbare publieke figuren creëren fraudeurs ongelooflijk overtuigende oplichtingspraktijken.

In sommige gevallen worden deepfakes van beroemdheden zoals Elon Musk, Tom Hanks of Oprah Winfrey gebruikt om producten of diensten aan te prijzen waar ze nog nooit van hebben gehoord.

Deze video's worden vervolgens op sociale platforms geplaatst, waar ze miljoenen mensen bereiken.

Zelfs privépersonen lopen risico, vooral in spearphishing-campagnes die zich richten op specifieke mensen met gepersonaliseerde inhoud die is ontworpen om te manipuleren of te misleiden.

Volgens een 2024 rapport door ForbesDe door deepfakes veroorzaakte fraude heeft wereldwijd al naar schatting $12 miljard aan verliezen opgeleverd en dat bedrag zal de komende jaren naar verwachting meer dan verdrievoudigen.

Daarom is detectie niet alleen voor individuen. Het is essentieel voor bedrijven die omgaan met gevoelige gegevens, communicatie of openbare inhoud. TruthScan helpt deze organisaties gewijzigde video's te identificeren voordat verkeerde informatie zich verspreidt.

Positief en creatief gebruik van deepfakes

Het is de moeite waard om op te merken dat niet elke toepassing van de technologie negatief is.

Terwijl veel blogs die uitleggen wat een deepfake is zich richten op misbruik, is er een groeiende lijst van creatieve en productieve manieren waarop deepfakes worden gebruikt.

Toch moet voor bedrijven zelfs artistiek of marketinggebruik van deepfakes worden gecontroleerd op echtheid voordat ze worden uitgebracht.

Tools zoals TruthScan kunnen bevestigen dat er geen onbedoelde manipulatie achterblijft in de uiteindelijke versie.

Hieronder staan enkele opmerkelijke voorbeelden.

Film- en acteerprestaties

Studio's beginnen te vertrouwen op deepfake technologie voor dingen als:

- Visuele effecten verbeteren

- Productiekosten verlagen

- Karakters terugbrengen die er niet meer zijn

Disneyis bijvoorbeeld bezig met het verfijnen van deepfake-modellen met een hoge resolutie waarmee gezichten kunnen worden verwisseld en acteurs kunnen worden verouderd met een indrukwekkend realisme.

Hun technologie werkt met een resolutie van 1024 x 1024 en kan gezichtsuitdrukkingen nauwkeurig volgen om personages er jonger of expressiever uit te laten zien.

Naast Hollywood hebben deepfakes wereldwijde campagnes mogelijk gemaakt, zoals toen David Beckham werd digitaal gekloond om een gezondheidsboodschap in meerdere talen over te brengen.

Art

In 2018 gebruikte multimediakunstenaar Joseph Ayerle deepfake technologie om een AI-acteur te creëren die het gezicht van de Italiaanse filmster Ornella Muti vermengde met het lichaam van Kendall Jenner.

Het resultaat was een surrealistische verkenning van generatie-identiteit en artistieke provocatie, onderdeel van een videokunstwerk getiteld Un'emozione per sempre 2.0.

Deepfakes zijn ook opgedoken in satire en parodieën.

De webserie Sassy Justice uit 2020 van de makers van South Park, Trey Parker en Matt Stone, is hier een goed voorbeeld van.

Het gebruikte gefingeerde publieke figuren om de draak te steken met actuele gebeurtenissen en tegelijkertijd het bewustzijn van de technologie zelf te vergroten.

Klantenservice

Buiten de creatieve industrie vinden bedrijven nut in deepfakes voor klantgerichte diensten.

Sommige callcenters gebruiken nu synthetische stemmen die worden aangestuurd door deepfake-technologie om basisverzoeken te automatiseren, zoals het opvragen van een rekening of het registreren van klachten.

In deze gevallen is de bedoeling niet kwaadaardig, maar gewoon om te stroomlijnen.

Responssystemen voor bellers kunnen worden gepersonaliseerd met behulp van AI-gegenereerde stemmen om geautomatiseerde diensten natuurlijker en boeiender te laten klinken.

Omdat de taken die worden uitgevoerd meestal laag risico en repetitief zijn, helpen deepfakes in deze context de kosten te verlagen en menselijke agenten vrij te maken voor complexere zaken.

Onderwijs

Onderwijsplatforms zijn ook begonnen met het integreren van deepfake-gestuurde tutoren om leerlingen op een meer interactieve manier te helpen.

Deze AI-gestuurde docenten kunnen lessen geven met behulp van synthetische stemmen en persoonlijke begeleiding.

Tools en technieken voor Deepfake-detectie

Naarmate deepfakes geavanceerder en toegankelijker worden, neemt ook de noodzaak toe om ze te identificeren voordat ze schade veroorzaken.

Mensen en organisaties hebben ook de juiste hulpmiddelen en technieken nodig om een stap voor te blijven. Hier zijn een paar hulpmiddelen en technieken.

Voor beeldgerichte verificatie, AI-beelddetector van TruthScan analyseert belichting, pixelpatronen en samengestelde elementen om door AI gegenereerde of bewerkte beelden in realtime te markeren.

Het helpt teams om de authenticiteit van afbeeldingen en videoframes snel te bevestigen voordat inhoud wordt gepubliceerd of gedeeld.

TruthScan: Deepfake-detectie op bedrijfsniveau

TruthScan is ontworpen voor bedrijven, universiteiten en media-organisaties die op grote schaal visuele en audio-inhoud moeten verifiëren.

Het analyseert video authenticiteit over meerdere dimensies:

- Gezicht verwisseldetectie: Identificeert gemanipuleerde gezichtskenmerken frame voor frame.

- Gedragsafdruk: Detecteert subtiele uitdrukkingspatronen en microbewegingen die niet overeenkomen met natuurlijk menselijk gedrag.

- Video forensisch onderzoek: Onderzoekt framepressie, pixelruis en geknoei met stemmen.

- Real-time detectie: Maakt live verificatie mogelijk tijdens videogesprekken, persberichten of broadcast streams.

Met TruthScan kunnen teams video's verifiëren voordat ze worden gepubliceerd of openbaar worden gemaakt, waardoor reputatieschade en financiële schade worden voorkomen.

Voor alledaagse gebruikers bieden de tools van Undetectable AI vergelijkbare bescherming op individueel niveau.

AI beelddetector door Undetectable AI

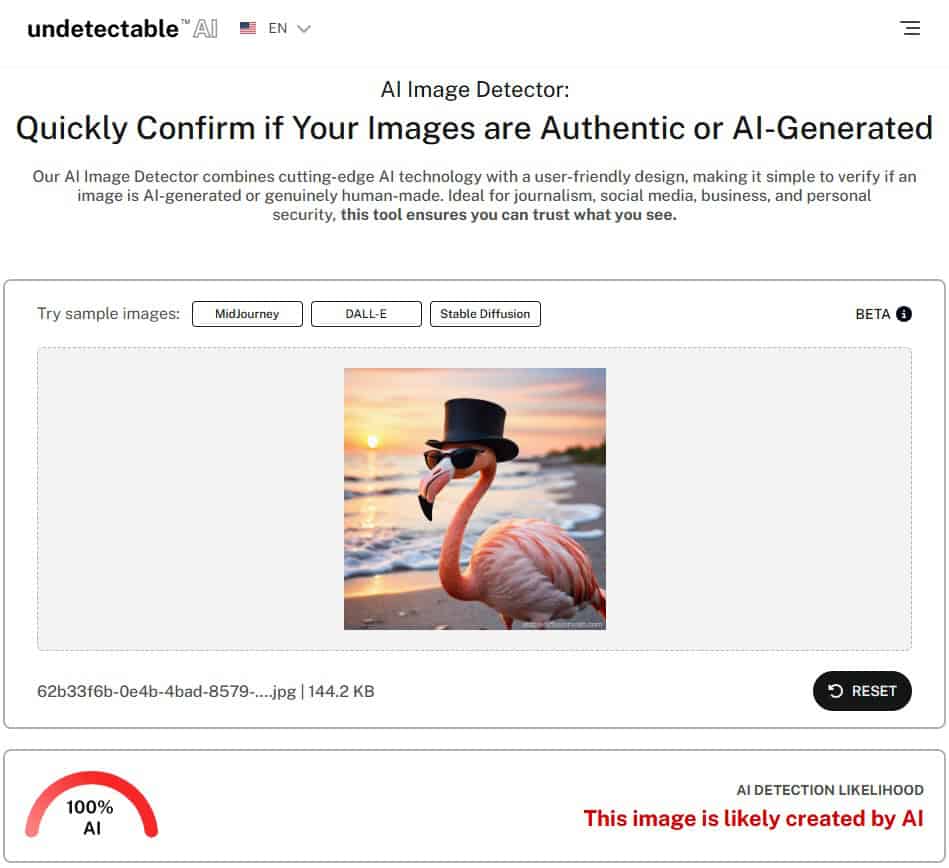

De AI Image Detector van Undetectable AI maakt deepfake detectie eenvoudiger, zelfs voor mensen zonder technische achtergrond.

De detector werkt door verschillende elementen in een geüploade afbeelding te analyseren, zoals kleurpatronen, texturen, gezichtskenmerken en structurele inconsistenties.

Het ondersteunt detectie voor media die zijn gemaakt met de bekendste AI-afbeeldingsgeneratoren, zoals

- Reis halverwege

- DALL-E

- Stabiele verspreiding

- Ideogram

- Op GAN gebaseerde modellen

Om het te gebruiken upload je gewoon een afbeelding, laat je de tool deze analyseren en ontvang je een duidelijk oordeel met een vertrouwensscore.

Als je niet zeker weet of een afbeelding die je bent tegengekomen echt is, probeer dan onze AI beelddetector om te controleren op tekenen van AI-vervalsing.

Laten we nu De AI-detector van Undetectable aan de test en kijk of het nauwkeurig kan vertellen dat de afbeelding AI-gegenereerd is.

Zoals je kunt zien, heeft de AI-detector van Undetectable AI deze afbeelding gemarkeerd als 100% AI-gegenereerd.

Visuele en gedragstechnieken voor handmatige detectie

Er zijn ook praktische technieken die mensen kunnen gebruiken om deepfakes handmatig te detecteren, vooral in situaties waar onmiddellijke analyse nodig is.

Enkele visuele rode vlaggen zijn:

- Onhandige gezichtshouding of vreemde uitdrukkingen.

- Inconsistente belichting of kleuren in verschillende delen van de afbeelding of video.

- Flikkeren rond het gezicht of de haargrens, vooral tijdens beweging.

- Gebrek aan natuurlijk knipperen of onregelmatige oogbewegingen.

- Discrepanties in lipsynchronisatie wanneer de audio niet overeenkomt met de spraak.

Vanuit gedragsperspectief hebben deepfakes vaak moeite om subtiele menselijke eigenschappen na te bootsen. Let op lichaamstaal, emotionele uitdrukkingen en gewoontegebaren.

En vraag in realtime gesprekken, vooral live video's, om een zijaanzicht.

Veel deepfake modellen hebben nog steeds moeite met het nauwkeurig weergeven van een gezichtshoek van 90 graden of complexe bewegingen zoals het draaien van het hoofd met behoud van natuurlijke uitdrukkingen.

Deepfakes herkennen in tekst en context

Deepfakes zijn niet beperkt tot visuals. Bij sommige versies gaat het om synthetische tekst, stem of gedrag dat iemands communicatiestijl nabootst.

Let bij het analyseren van tekst of dialoog op:

- Spelfouten en vreemde grammatica.

- Zinnen die geforceerd aanvoelen of niet natuurlijk vloeien.

- Ongebruikelijke e-mailadressen of inconsistente formuleringen.

- Berichten die uit hun context vallen of geen verband houden met de situatie.

De context is ook belangrijk. Als een video of bericht verschijnt in een omgeving die niet logisch is, zoals een politicus die terloops een belangrijke beslissing aankondigt in een clip van lage kwaliteit, is het de moeite waard om de authenticiteit in twijfel te trekken.

Nieuwsgierig naar onze AI Detector en Humanizer? Probeer ze uit in de widget hieronder!

Veelgestelde vragen over Deepfakes

Zijn deepfakes illegaal?

Deepfakes zijn niet standaard illegaal, maar dat kan wel het geval zijn als ze bestaande wetten overtreden, zoals die over laster, kinderpornografie of niet-consensuele expliciete inhoud.

Sommige Amerikaanse staten hebben wetten aangenomen die deepfakes aanpakken die verkiezingen beïnvloeden of betrekking hebben op wraakporno.

Federale wetsvoorstellen zoals de DEFIANCE Act en GEEN FAKES zijn ook bezig met het reguleren van kwaadwillig gebruik van deepfake-technologie.

Kan iemand een deepfake maken?

Ja, bijna iedereen kan een deepfake maken met gratis of goedkope software en AI-tools.

Veel platforms bieden tegenwoordig gebruiksvriendelijke interfaces, zodat er geen geavanceerde technische vaardigheden nodig zijn om aan de slag te gaan.

Hoe kan ik mezelf beschermen tegen deepfakes?

Beperk je blootstelling door het online plaatsen van hoge resolutie afbeeldingen of video's te vermijden. Gebruik privacy-instellingen en detectietools zoals Niet detecteerbare AI of TruthScan om alles wat verdacht is dubbel te controleren.

Zijn er apps voor deepfake-detectie?

Ja, TruthScan is ontworpen voor zakelijke gebruikers die videocontent op schaal moeten analyseren, terwijl de detectors van Undetectable AI bedoeld zijn voor individuen en makers die kleinere hoeveelheden content willen verifiëren.

Eindgedachten

Deepfakes veranderen de manier waarop we online naar de waarheid kijken. Of je nu je merk beschermt, publieke communicatie beheert of gewoon veilig surft, het gebruik van de juiste detectietools maakt het verschil.

Voor bedrijven en instellingen, TruthScan biedt bescherming op bedrijfsniveau tegen AI-gestuurde desinformatie.

Voor individuen, Niet-opspoorbare AI's AI beelddetector biedt een eenvoudige, snelle manier om beelden te controleren en op de hoogte te blijven.

Samen zorgen ze ervoor dat wat je ziet en deelt echt blijft.