Термин deepfake впервые появилось на Reddit в 2017 году.Когда пользователь с таким же именем начал выкладывать измененные видео, в которых искусственный интеллект менял лица местами, вначале в контенте для взрослых.

Хотя Reddit запретил оригинальный сабреддит, идея уже получила распространение.

Но корни этой технологии уходят еще дальше.

В 1997 году исследователи уже начали экспериментировать с редактированием видео с помощью машинного обучения.

Их ранний инструмент для синхронизации губ, названный Перезапись видео может создать впечатление, что человек сказал то, чего не говорил.

Это не было техническим deepfake по сегодняшним стандартам, но оно заложило основу для того, что будет дальше.

Сегодняшний блог посвящен тому, как работает эта развивающаяся технология, где она встречается в повседневной жизни, какие риски и преимущества несет с собой.

Для начала давайте разберемся, что же такое deepfake на самом деле.

Основные выводы:

- Глубокие подделки - это сгенерированные искусственным интеллектом медиа, которые заставляют людей говорить или делать то, чего они на самом деле не делали.

- С помощью бесплатных инструментов и базовых навыков практически каждый может создавать убедительные видео, изображения или аудиоклипы в стиле deepfake.

- Хотя подделки могут быть творческими или развлекательными, они также представляют серьезную опасность, например, мошенничество, клевету и дезинформацию.

- Большинство подделок можно распознать с помощью инструментов обнаружения или внимательно следя за визуальными и поведенческими несоответствиями.

Что такое глубокая подделка?

Глубокая подделка - это поддельное медиа, обычно видео, аудиоклип или изображение, которое было изменено с помощью искусственного интеллекта, чтобы заставить человека выглядеть или звучать так, будто он делает или говорит то, чего на самом деле не делал.

Не думайте, что это просто плохая работа фотошопа или небрежный голос за кадром.

Речь идет о высокоуровневых манипуляциях с помощью технологии глубокого обучения, которая является подмножеством ИИ.

Никогда больше не беспокойтесь о том, что ИИ обнаружит ваши сообщения. Undetectable AI Мы можем помочь вам:

- Сделайте так, чтобы ваши записи с помощью искусственного интеллекта появились человекоподобный.

- Байпас все основные инструменты обнаружения ИИ одним щелчком мыши.

- Используйте AI безопасно и уверенно в школе и на работе.

Именно это и подразумевает термин "deepfake": глубокое обучение и поддельный контент.

Целью глубокой подделки обычно является создание чего-то, что выглядит достаточно реалистично, чтобы обмануть людей.

Возможно, вам доводилось видеть вирусные видео, на которых знаменитости совершают странные поступки, а политики делают возмутительные заявления, которые на самом деле никогда бы не произнесли.

Это классические случаи использования deepfake. То, что вы видите, не настоящее, но технологии, стоящие за этим, стали настолько хороши, что ваш мозг не сразу распознает подделку, если только вы действительно не присматриваетесь.

Именно здесь и пригодятся такие инструменты, как TruthScan заходите.

TruthScan создан для организаций, которым требуется масштабная проверка медиа - компаний, новостных редакций, университетов и государственных учреждений. Он помогает командам обнаружить манипуляции до того, как ложный контент нанесет ущерб доверию или репутации.

На самом деле, по данным исследовательской группы Undetectable AI, 85 % американцев утверждают, что фальшивки подорвали их доверие к информации в Интернете.

Вы только что узнали, что на самом деле представляет собой видео или медиа deepfake, теперь перейдем к тому, как люди их создают.

Как создаются подделки

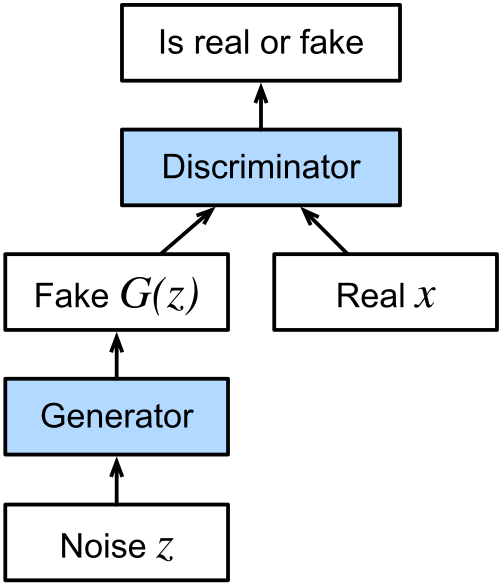

Технология, лежащая в основе большинства глубоких подделок, относится к категории алгоритмов машинного обучения, называемых генеративными состязательными сетями (generative adversarial networks, или GAN).

GAN состоят из двух частей: генератора и дискриминатора.

Генератор создает поддельные материалы на основе того, что его научили воспроизводить, а задача дискриминатора - выявлять то, что выглядит поддельным.

Они продолжают ходить туда-сюда, пока генератор не научится создавать поддельный контент, способный пройти тест дискриминатора.

Со временем это взаимодействие приводит к созданию медиа, которое выглядит до ужаса реалистично.

Что такое процесс генерации видео Deepfake?

При создании видео deepfake система анализирует видео с нескольких ракурсов, изучает, как человек говорит, как двигается его лицо, как смещается его тело.

Вся эта информация поступает в генератор, чтобы он мог создавать контент, имитирующий это поведение.

Затем дискриминатор помогает откорректировать его, указывая на недостатки, пока конечный результат не станет идеальным.

Именно поэтому иллюзия так хорошо держится в движении.

В зависимости от цели создания видео deepfake используется несколько различных техник.

Если идея состоит в том, чтобы создать впечатление, что кто-то сказал или сделал что-то на видео, чего он на самом деле не говорил и не делал, то мы имеем дело с так называемой глубокой подделкой исходного видео.

Автокодировщик deepfake, состоящий из кодировщика и декодировщика, изучает исходные кадры и накладывает на них выражения, жесты и едва уловимые движения головы объекта съемки.

Аудиоподделки

Аудиоподделка работает путем клонирования голоса человека, опять же с помощью GAN, на основе записей его естественной речи.

После обучения модель может генерировать новую речь этим голосом, даже если человек никогда не произносил этих слов.

Еще один часто добавляемый слой - синхронизация губ.

Здесь система накладывает сгенерированный или предварительно записанный звук на видео.

Цель - сделать так, чтобы губы на видео соответствовали словам на аудио.

Реальные примеры глубоких подделок

В наши дни подделки появляются повсюду.

Давайте познакомимся с некоторыми популярными подделками, которые показывают, как далеко продвинулась технология.

Глубокий фейк о том, как президент Зеленский просит украинские войска сдаться

В марте 2022 года, на начальном этапе российско-украинской войны, в сети появилось видео показывая президента Украины Владимира Зеленского призывая своих солдат сдаться.

Это было похоже на национальное обращение, с голосом и манерами Зеленского.

Видео распространилось по социальным сетям и даже было размещено на взломанном украинском новостном сайте.

Президент отреагировал быстро и выпустил официальное заявление по своим проверенным каналам, чтобы опровергнуть эти кадры.

Вирусная подделка изображения Папы Франциска в дизайнерской куртке-пуховике

Иногда для того, чтобы вызвать недоумение, не обязательно использовать вредоносное изображение.

В 2023 году вирусная фотография Папа Франциск прогуливается в стильной белой куртке-пуховике Balenciaga захватили интернет.

Она набрала десятки миллионов просмотров и получила широкое распространение на всех платформах.

Изображение было создано с помощью инструмента искусственного интеллекта под названием Midjourney анонимным пользователем из Чикаго.

Глубокие подделки Элона Маска используются в онлайн-мошенничестве

В 2024 г, глубокие подделки с участием Элона Маска стал центральной частью нескольких масштабных онлайн-мошенничеств.

На Facebook, TikTok и других платформах стали появляться сгенерированные искусственным интеллектом видеоролики с Маском, рекламирующие фальшивые криптовалютные раздачи и инвестиционные схемы.

Эти клипы выглядели и звучали удивительно реалистично.

Ущерб был не только теоретическим. Сообщается, что пожилой пенсионер потерял почти $700 000, убедившись в этом с помощью одного из таких видео.

Робозвонок-фейк Джо Байдена, направленный на американских избирателей

В начале 2024 года, прямо перед праймериз в Нью-Гэмпшире, избиратели получили робозвонки который звучал в точности как президент США Джо Байден.

В этом звонке Джо Байден призывал избирателей остаться дома и сохранить свой голос для всеобщих выборов в ноябре. Намерение состояло в том, чтобы запутать и ввести в заблуждение избирателей, заставив их пропустить праймериз.

Этот инцидент вызвал призывы к регулированию. Группы защитников призвали Федеральную избирательную комиссию США вмешаться, но FEC в итоге отказалась, сославшись на ограничения в своих полномочиях.

Тем временем телекоммуникационная компания, ответственная за распространение робозвонка согласилась выплатить штраф в размере $1 млн..

Использование политических фейков на выборах в Индии в 2020 году

Не все случаи использования технологии deepfake являются вредными или обманчивыми по своему замыслу (подробнее об этом далее в блоге).

Во время выборов в Законодательное собрание Дели в 2020 году Партия "Бхаратия Джаната" использовала искусственный интеллект для адаптации предвыборной рекламы для разных языковых аудиторий.

Партия взяла видео, на котором ее лидер Манодж Тивари говорит на английском языке, и с помощью искусственной синхронизации губ создала версию на харьянви, региональном диалекте.

В то время как голос за кадром принадлежал актеру, визуальные эффекты были изменены в соответствии с новым звуком с помощью искусственного интеллекта, обученного на реальных кадрах Тивари.

Члены партии рассматривали это как положительное применение технологии, позволяющее общаться с избирателями на понятном им языке, даже если кандидат не говорил на нем свободно.

Как проверить подделку в реальном мире

С распространением дипфейков в политике, развлечениях и повседневном общении умение отличать реальность от подделки стало как никогда важным.

Несмотря на появление сложных примеров, существуют надежные инструменты для противодействия угрозе технологии дипфейков.

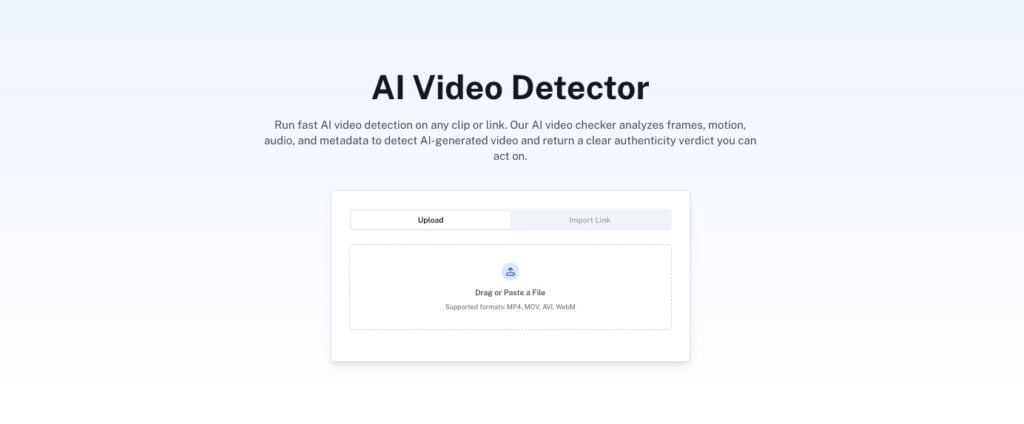

Необнаруживаемый ИИ AI-детектор видео является одним из таких инструментов, демонстрирующим, что существуют надежные средства для противодействия сложным примерам технологии deepfake.

Именно здесь Undetectable AI Обнаружение подделок входит.

Он предназначен для проверки того. аудио- или видеоматериалы были созданы искусственноВ них используются передовые криминалистические модели, анализирующие покадровое движение, согласованность на уровне пикселей и голосовые отпечатки пальцев.

За считанные секунды пользователи могут узнать, было ли видео изменено с помощью цифровых технологий или был ли голос клонирован искусственным интеллектом.

Просто загрузите файл, и инструмент предоставит подробный отчет о подлинности с визуальной разбивкой и оценкой достоверности.

Будь то вирусный ролик, подозрительное интервью или общая запись, Deepfake Detection помогает журналистам, преподавателям и обычным пользователям раскрыть правду за тем, что они видят и слышат.

Опасны ли подделки? Риски и опасения

До сих пор мы рассматривали, что такое deepfake, как его делают и где он уже проявлялся в реальном мире.

Технология, безусловно, впечатляет, но риски, связанные с ней, очень серьезны и быстро растут.

Глубокие подделки могут быть использованы в качестве оружия различными способами. Вот несколько основных.

Диффамация

Когда чье-то сходство или голос используются для создания фальшивых высказываний, заявлений или видео, особенно оскорбительных или спорных, это может практически мгновенно разрушить репутацию.

И в отличие от старых мистификаций или поддельных цитат, убедительный deepfake оставляет мало места для сомнений в сознании зрителя.

В этом отношении фальшивки могут вызвать возмущение, разрушить отношения или просто навязать вредную информацию.

Что особенно тревожно, так это то, что глубокая подделка даже не должна быть идеальной.

Если человек узнаваем, а содержание достаточно правдоподобно, оно может оказать длительное влияние на общественное мнение.

Достоверность информации

Еще одна серьезная проблема заключается в том, что глубокие подделки подрывают саму идею правды.

По мере того как подделки становятся все более распространенными, становится все труднее понять, является ли то, что мы видим или слышим, настоящим. Со временем это может привести к более широкому подрыву доверия к любой форме цифровой коммуникации.

Этот кризис доверия выходит за рамки отдельных инцидентов.

В демократических обществах люди опираются на общие факты при принятии решений, обсуждении вопросов и решении коллективных проблем.

Но если избиратели, зрители или граждане начинают сомневаться во всем, становится гораздо проще манипулировать общественным мнением или отвергать неудобные истины как "очередную глубокую фальшивку".

Шантаж

Созданные ИИ средства массовой информации могут использоваться для ложного уличения людей, создавая впечатление, что они совершили что-то незаконное, неэтичное или постыдное.

Такие сфабрикованные доказательства могут быть использованы для угроз или контроля над ними.

И это касается обеих сторон. Поскольку фальшивки стали настолько реалистичными, человек, столкнувшийся с настоящим шантажом, может заявить, что улики поддельные, даже если это не так.

Иногда это называют "инфляцией шантажа", когда огромное количество правдоподобных подделок снижает ценность реальных инкриминируемых материалов.

Достоверность реальных доказательств теряется в тумане, и это только добавляет еще один слой сложностей при попытке разоблачить правонарушения.

Мошенничество и аферы

Используя созданные искусственным интеллектом видеоролики или голоса доверенных общественных деятелей, мошенники создают невероятно убедительные схемы.

В некоторых случаях глубокие подделки знаменитостей, таких как Элон Маск, Том Хэнкс или Опра Уинфри, используются для рекламы продуктов или услуг, о которых они никогда не слышали.

Затем эти видеоролики распространяются по социальным платформам, где их смотрят миллионы людей.

Даже частные лица подвергаются риску, особенно в ходе копьеметательных кампаний, которые направлены на конкретных людей и содержат персонализированный контент, предназначенный для манипулирования или обмана.

Согласно Отчет Forbes за 2024 годМошенничество с использованием deepfake уже принесло глобальные убытки в размере $12 миллиардов, и ожидается, что в ближайшие несколько лет эта цифра увеличится более чем в три раза.

Именно поэтому обнаружение не только для частных лиц. Оно необходимо компаниям, которые работают с конфиденциальными данными, коммуникациями или публичным контентом. TruthScan помогает таким организациям выявлять измененные видеоролики до того, как распространится дезинформация.

Позитивное и творческое использование подделок

Стоит отметить, что не каждое применение этой технологии является негативным.

Хотя многие блоги, объясняющие, что такое deepfake, сосредоточены на злоупотреблениях, растет список творческих и продуктивных способов использования deepfake.

Тем не менее, для бизнеса даже художественное или маркетинговое использование глубоких подделок должно быть проверено на подлинность перед выпуском.

Такие инструменты, как TruthScan, могут подтвердить, что в финальной версии не осталось никаких непреднамеренных манипуляций.

Ниже приведены несколько ярких примеров.

Фильмы и актерские работы

Студии начинают использовать технологию глубокой подделки для таких вещей, как:

- Улучшение визуальных эффектов

- Снижение производственных затрат

- Возвращение персонажей, которых больше нет

Disneyнапример, совершенствует модели deepfake высокого разрешения, которые позволяют менять лица и старить актеров с впечатляющим реализмом.

Их технология работает в разрешении 1024 x 1024 и может точно отслеживать мимику, чтобы персонажи выглядели моложе или выразительнее.

Помимо Голливуда, глубокие подделки позволяют проводить глобальные кампании, например, когда Дэвид Бекхэм был клонирован с помощью цифровых технологий чтобы донести информацию о здоровье на нескольких языках.

Искусство

В 2018 году мультимедийный художник Джозеф Айерле использовал технологию deepfake для создания ИИ-актера, в котором лицо итальянской кинозвезды Орнеллы Мути сочеталось с телом Кендалл Дженнер.

Результатом стало сюрреалистическое исследование идентичности поколений и художественная провокация, ставшая частью видеоарта под названием Un'emozione per sempre 2.0.

Глубокие подделки также появляются в сатире и пародиях.

Ярким примером является веб-сериал Sassy Justice, созданный в 2020 году создателями South Park Треем Паркером и Мэттом Стоуном.

В нем использовались глубоко подделанные общественные деятели, чтобы высмеять текущие события и одновременно повысить осведомленность о самой технологии.

Обслуживание клиентов

За пределами творческих индустрий предприятия находят применение глубоким подделкам для обслуживания клиентов.

Некоторые колл-центры теперь используют синтетические голоса, созданные с помощью технологии deepfake, для автоматизации базовых запросов, например, запросов о состоянии счета или регистрации жалоб.

В этих случаях цель не злая, а просто оптимизация.

Системы ответа на звонки можно персонализировать, используя голоса, генерируемые искусственным интеллектом, чтобы автоматизированные услуги звучали более естественно и увлекательно.

Поскольку выполняемые задачи обычно не связаны с большим риском и являются повторяющимися, deepfakes в этом контексте помогают сократить расходы и высвободить человеческие ресурсы для решения более сложных задач.

Образование

Образовательные платформы также начали внедрять репетиторов на основе deepfake, чтобы помочь учащимся в более интерактивном режиме.

Эти управляемые искусственным интеллектом репетиторы могут проводить уроки, используя синтетические голоса и индивидуальные рекомендации.

Инструменты и методы обнаружения фальшивок

По мере того как подделки становятся все более совершенными и доступными, растет и необходимость выявлять их до того, как они причинят вред.

Людям и организациям также нужны правильные инструменты и методы, чтобы оставаться на шаг впереди. Вот несколько инструментов и методик.

Для проверки сфокусированного изображения, ИИ-детектор изображений TruthScan Анализирует освещение, пиксельные узоры и композитные элементы, чтобы в режиме реального времени выявить визуальные эффекты, созданные или отредактированные искусственным интеллектом.

Он помогает командам быстро подтверждать подлинность изображений и видеокадров перед публикацией или распространением контента.

TruthScan: Обнаружение глубоких подделок корпоративного уровня

TruthScan предназначен для предприятий, университетов и медиа-организаций, которым требуется масштабная проверка визуального и аудиоконтента.

Он анализирует подлинность видео по нескольким параметрам:

- Обнаружение смены лиц: Идентифицирует манипулируемые черты лица кадр за кадром.

- Поведенческие отпечатки пальцев: Обнаруживает тончайшие особенности выражения лица и микродвижения, несовместимые с естественным поведением человека.

- Видеокриминалистика: Исследует сжатие кадров, пиксельный шум и фальсификацию голоса.

- Обнаружение в режиме реального времени: Обеспечивает проверку в режиме реального времени во время видеозвонков, пресс-релизов или трансляций.

С помощью TruthScan команды могут проверять подлинность видео перед публикацией или публичным распространением, предотвращая репутационный и финансовый ущерб.

Для обычных пользователей инструменты Undetectable AI предлагают аналогичную защиту на индивидуальном уровне.

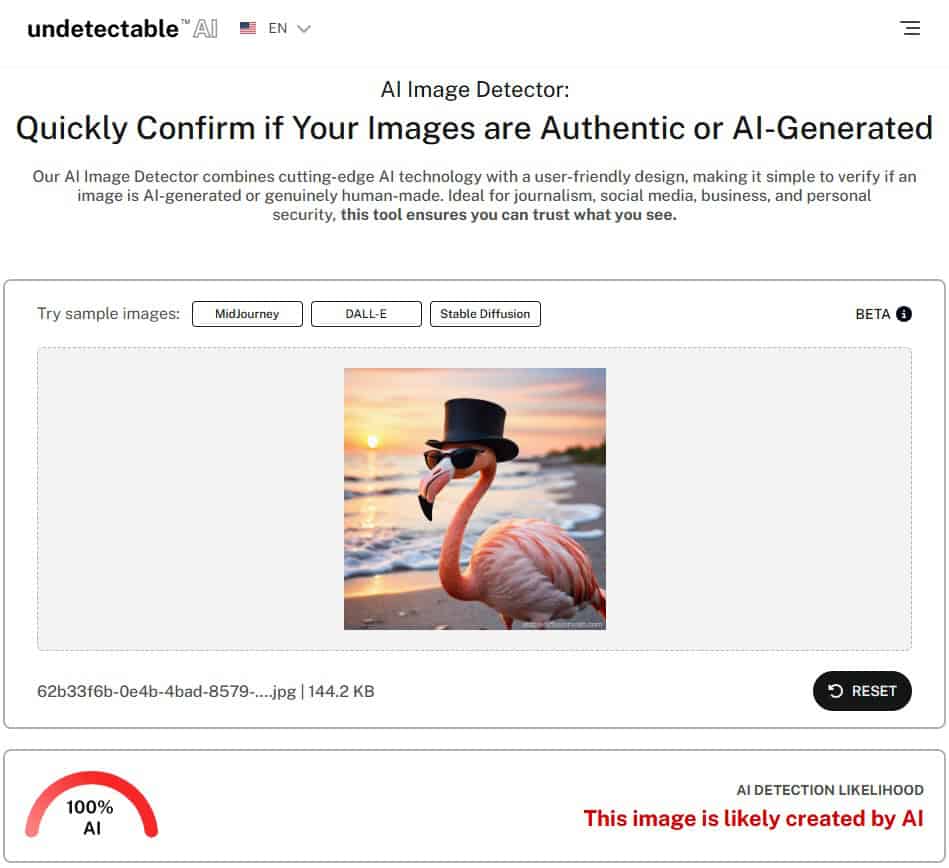

ИИ-детектор изображений от Undetectable AI

ИИ-детектор изображений Undetectable AI упрощает обнаружение подделок даже для тех, кто не имеет технического образования.

Детектор работает, анализируя различные элементы загруженного изображения, такие как цветовые узоры, текстуры, черты лица и структурные несоответствия.

Он поддерживает обнаружение медиафайлов, созданных с помощью самых известных генераторов изображений AI, таких как

- Середина путешествия

- ДАЛЛ-И

- Стабильная диффузия

- Идеограмма

- Модели на основе GAN

Чтобы воспользоваться им, просто загрузите изображение, позвольте инструменту проанализировать его и получите четкий вердикт с оценкой достоверности.

Если вы не уверены, что изображение, на которое вы наткнулись, является подлинным, попробуйте воспользоваться нашим сервисом Детектор изображений AI чтобы проверить наличие признаков вмешательства ИИ.

Теперь давайте поставим Детектор искусственного интеллекта Undetectable чтобы проверить, сможет ли он точно определить, что изображение сгенерировано искусственным интеллектом.

Как видите, детектор искусственного интеллекта изображений Undetectable AI пометил это изображение как 100%, созданное искусственным интеллектом.

Визуальные и поведенческие техники для ручного обнаружения

Существуют и практические приемы, которые можно использовать для обнаружения подделок вручную, особенно в ситуациях, когда требуется немедленный анализ.

Некоторые визуальные "красные флажки" включают в себя:

- Неловкое положение лица или странное выражение.

- Несоответствие освещения или цвета в разных частях изображения или видео.

- Мерцание вокруг лица или линии роста волос, особенно во время движения.

- Отсутствие естественного моргания или неравномерное движение глаз.

- Несоответствие синхронизации губ, когда звук не совпадает с речью.

С точки зрения поведения, глубокие подделки часто пытаются имитировать тонкие человеческие черты. Обратите внимание на язык тела, эмоциональные выражения и привычные жесты.

А при общении в режиме реального времени, особенно при просмотре видео, попросите показать боковой профиль.

Многие модели deepfake по-прежнему не могут точно передать угол наклона лица в 90 градусов или сложные движения, такие как поворот головы, сохраняя при этом естественное выражение лица.

Выявление подделок в тексте и контексте

Глубокие подделки не ограничиваются визуальными эффектами. Некоторые варианты включают в себя синтетический текст, голос или поведение, имитирующие чей-то стиль общения.

Анализируя текстовый контент или диалог, обратите внимание на:

- Опечатки и странная грамматика.

- Предложения, которые кажутся вынужденными или не выстраиваются естественно.

- Необычные адреса электронной почты или несовместимые формулировки.

- Сообщения, вырванные из контекста или не имеющие отношения к ситуации.

Контекст также имеет значение. Если видеоролик или сообщение появляются в обстановке, не имеющей смысла, например политик случайно объявляет о важном решении в низкокачественном ролике, стоит усомниться в их подлинности.

Вам интересно узнать о наших детекторах искусственного интеллекта и гуманизаторах? Попробуйте их в виджете ниже!

Вопросы и ответы о подделках

Являются ли подделки незаконными?

Глубокие подделки не являются незаконными по умолчанию, но они могут стать таковыми, если нарушают существующие законы, например, законы о диффамации, детской порнографии или откровенном контенте без согласия.

В некоторых штатах США приняты законы, направленные на борьбу с подделками, которые влияют на выборы или связаны с порно из мести.

Федеральные законопроекты, такие как закон DEFIANCE и Закон об отсутствии подделок Также ведутся работы по регулированию злонамеренного использования технологии deepfake.

Кто-нибудь может сделать deepfake?

Да, практически любой может сделать deepfake, используя бесплатное или недорогое программное обеспечение и инструменты искусственного интеллекта.

Многие платформы сегодня предлагают удобные интерфейсы, поэтому для начала работы не требуется никаких сложных технических навыков.

Как защитить себя от подделок?

Ограничьте свою уязвимость, не публикуя в Интернете изображения и видео высокого разрешения. Используйте настройки конфиденциальности и такие инструменты обнаружения, как Необнаруживаемый ИИ или TruthScan чтобы перепроверить все подозрительное.

Существуют ли приложения для обнаружения подделок?

TruthScan предназначен для бизнес-пользователей, которым требуется масштабный анализ видеоконтента, в то время как детекторы Undetectable AI предназначены для частных лиц и создателей, которым требуется проверка небольших объемов контента.

Заключительные мысли

Глубокие подделки меняют наше представление о правде в Интернете. Если вы защищаете свой бренд, управляете общественными коммуникациями или просто безопасно просматриваете веб-страницы, использование правильных инструментов обнаружения фальшивок имеет большое значение.

Для предприятий и учреждений, TruthScan обеспечивает защиту корпоративного уровня от дезинформации, управляемой искусственным интеллектом.

Для отдельных людей, необнаруженные ИИ Детектор изображений AI Это простой и быстрый способ проверять изображения и быть в курсе событий.

Вместе они помогают гарантировать, что то, что вы видите и чем делитесь, остается реальным.