Kan GPT o1 skriva innehåll utan att bli upptäckt av AI-detektorer?

Det är en rättvis fråga.

I den här artikeln kommer du att läsa att GPT o1 är en modell som tränats för att hantera komplexa uppgifter relaterade till vetenskap, kodning och matematik.

Men om den kan skriva, och om du kan smyga den förbi AI-detektorer eller inte, är det värt att utforska.

Här är vad du kommer att få med dig efter att ha läst den här artikeln:

- Vad är GPT-o1?

- Hur fungerar AI-detektorer?

- Kan innehållet i GPT-o1 upptäckas?

- Är OpenAI: s o1-mini och o1-preview verkligen oupptäckbara?

- Hur kringgår man AI-detektorer med GPT-o1?

- GPT-o1 jämfört med GPT-4o: Vilket är mest detekterbart?

Så låt oss börja.

Vad är GPT-o1?

I september 2024 lanserade OpenAI GPT-o1-preview, tillsammans med en lättare och mer kostnadseffektiv variant kallad o1-mini.

I december 2024 ersattes förhandsversionen officiellt av den fullständiga GPT-o1-modellen.

Enligt OpenAI är GPT-o1 skapad för att hantera mycket komplexa problem genom att ägna mer tid åt att "tänka" innan den genererar svar.

Oroa dig aldrig för att AI upptäcker dina texter igen. Undetectable AI Kan hjälpa dig:

- Få din AI-assisterade skrivning att synas människoliknande.

- Bypass alla större AI-detekteringsverktyg med bara ett klick.

- Användning AI säkert och självsäkert i skolan och på jobbet.

Detta inkluderar avancerade uppgifter som tävlingsprogrammering, abstrakt matematik och vetenskapliga resonemang, som modellen kan hantera med nästan expertfiness.

Och testerna är ett bevis på denna expertis.

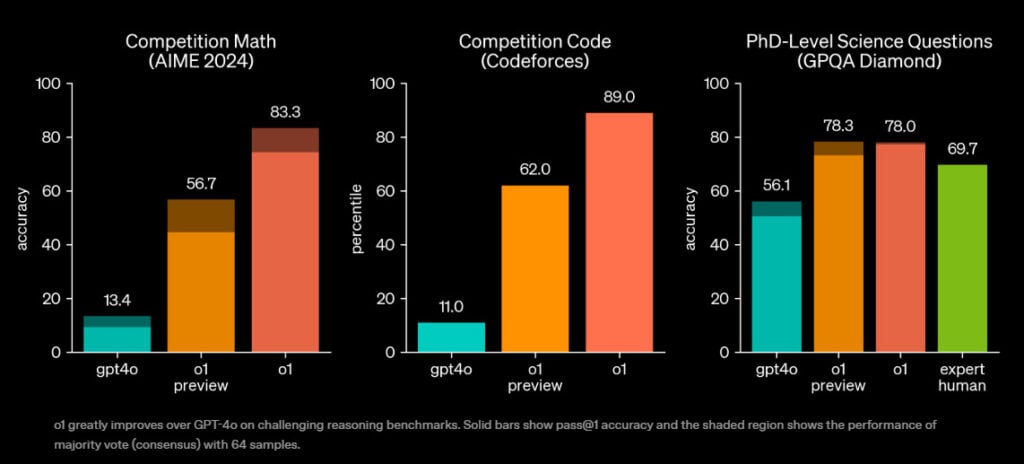

I jämförelsetesterna rankades o1-preview bland de 89:e percentilen på Codeforces tävlingar.

På den Amerikansk inbjudningsprov i matematiklöste o1 83% problem (12,5/15). Som jämförelse kan nämnas att GPT-4o knappt klarade 13% (1,8/15).

Denna modell uppvisade också kunskaper på doktorandnivå inom flera vetenskapliga områden (fysik, kemi och biologi).

Det är alltså tydligt att modellen i första hand är avsedd för forskning och tekniska tillämpningar.

Hur den skiljer sig från GPT-3.5, GPT-4 & GPT-4o

Ur GPT-o1:s perspektiv är skillnaderna mot GPT-3.5, GPT-4 och GPT-4o både små och stora, beroende på vilken uppgift som ska utföras.

GPT-3.5 arbetar med ett äldre dataset med ett begränsat kontextfönster på 16.385 (4.096 utdatatokens) och erbjuder grundläggande resonemang och hyfsade kodningsfärdigheter.

Den klarar sig bra med allmänna uppmaningar, men om du ger den ett problem med nästlad logik eller en knepig algoritm kommer du snabbt att se dess kanter.

Jämfört med den fungerar GPT o1 i en annan kognitiv klass. Så jämförelsen är inte rätt.

GPT-4 är fortfarande solid, mer raffinerad än 3.5 och kapabel till ett bredare spektrum av uppgifter, särskilt de som behöver nyanser. Men även det gräver inte i teknisk komplexitet med samma rigor som o1.

GPT-4o förbättrade hastigheten och den multimodala förmågan ytterligare, men låg fortfarande efter när det gällde djupa analytiska uppgifter.

Det är snabbare, mer interaktivt och bättre utrustat för allmänt bruk. Den hanterar kreativt skrivande, chattar och multimediauppgifter bättre än o1 för tillfället.

Men när det gäller logiktunga användningsfall har o1 ett mätbart försprång.

GPT-o1 saknar dock vissa användarvänliga funktioner som webbsurfning eller filuppladdning, som GPT-4o stöder.

Läget kan också vara lite kortfattat. Dess nekande svar är kortare, vilket ibland hoppar över referenser eller djupare förklaringar som 4o tenderar att inkludera.

En annan viktig nackdel med o1 är att den kan förstärka riskerna när den hanterar farliga frågor.

Till exempel på frågan om klättringsteknik, GPT-o1:s djupgående engagemang kan uppmuntra till övertro, medan GPT-4o som standard använder generiska råd.

[källa]

| Funktion | GPT-3.5 | GPT-4 | GPT-4o | GPT o1 |

| Utbildningsdata | Äldre dataset | Nyare och mer omfattande | Mest aktuella | Mest aktuella |

| Tokens för utdata | 4.096 polletter | 8 192 polletter | 16.384 polletter | 100 000 tokens |

| Fönster för kontext | 16,385 | 8,192 | 128,000 | 200,000 |

| Noggrannhet och samstämmighet | Bra | Betydligt förbättrad | Hög | Exceptionell |

| Förmågan att resonera | Grundläggande | Avancerad | Avancerad | Doktorandnivå |

| Färdigheter i kodning | Hyfsad | Lämplig | Lämplig | Nära expertnivå |

| Kreativt skrivande | Kapabel | Mer kreativ och nyanserad | Snabb och kreativ | Inte genomförbart |

| Svarshastighet | Snabb | Måttlig | Snabbast | Långsammare (avsiktligt) |

| Bäst för | Tillfällig användning | Allmänna uppgifter | Hastighet + multitasking | Tekniskt djup |

Hur AI-detektorer fungerar

AI-detektorer har blivit allt vanligare efter GPT-boomen.

Deras syfte är att ta reda på om något har skrivits av en person eller spottats ut av en modell som GPT-o1.

De gör en gissning baserad på en massa nördiga mätvärden och fyra stora maskininlärnings- och NLP-koncept.

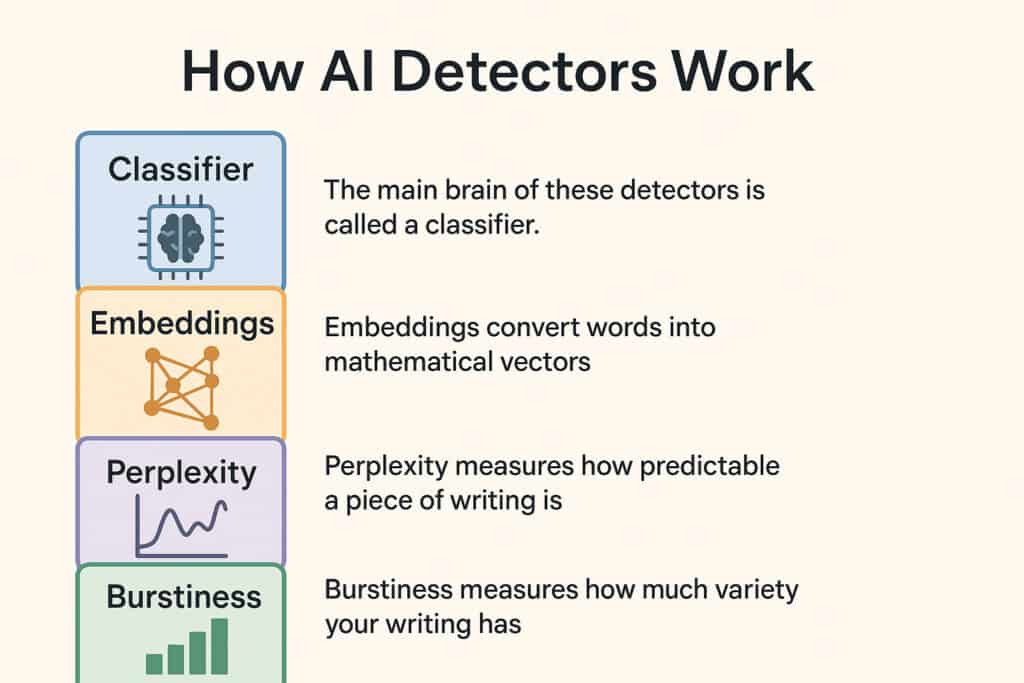

Klassificerare

Huvuddelen av dessa detektorer kallas för en klassificerare.

Dessa klassificerare tränas på massiva datamängder som är märkta som antingen AI-genererade eller mänskligt skrivna, och med tiden lär de sig vad som skiljer de två åt.

När modellen har tränats upp kan den bedöma en ny text och avgöra var den sannolikt hör hemma på AI-människans spektrum.

Den kontrollerar hur ofta vissa ord dyker upp, hur långa meningarna är och om det hela låter för rent.

Inbäddningar

Eftersom datorer inte kan förstå språk på samma sätt som vi gör, omvandlar inbäddningar ord till matematiska vektorer som representerar betydelse, sammanhang och ordrelationer.

Så när en detektor analyserar en mening tittar den på var orden befinner sig i det här flerdimensionella vektorrummet och hur deras positioner relaterar till mönster som ses i antingen mänskliga eller AI-utdata.

Det är så systemet vet att "drottning" och "kung" är saker som hör ihop.

Perplexitet

Inom AI-detektering är perplexitet ett mått som mäter hur förutsägbar en text är.

AI-genererat innehåll tenderar att ha lägre perplexitet eftersom det syftar till att producera text som flyter logiskt och läses tydligt.

Mänskligt skrivande kan däremot vara mer rörigt. Det är rikare på oförutsägbarhet, kreativa språng eller rakt igenom konstiga formuleringar.

Så en låg perplexitetspoäng kan vara en ledtråd till att något kommer från en AI, men den används aldrig isolerat eftersom, ja, även människor gillar att låta uppenbara ibland.

Sprickighet

Spänst mäter hur mycket variation det finns i texten.

Mänskliga författare visar vanligtvis högre sprängkraft eftersom vi naturligt blandar saker mellan korta, kvicka rader bredvid vidsträckta, komplexa rader.

AI tenderar att ta det säkra före det osäkra. Den tar inte konstiga omvägar eller spårar plötsligt ur mitt i en tanke. Och det gör det lättare att upptäcka.

Kan innehållet i GPT-o1 upptäckas?

Chat GPT o1 är inte tillgänglig gratis och ingår inte heller i det vanliga Plus-abonnemanget längre.

Den har höjts till OpenAI:s Pro-plan, som börjar på det höga priset $200.

Även om vi inte har full offentlig tillgång till att testa GPT o1 själva kan vi fortfarande göra en kvalificerad gissning om dess detekterbarhet.

OpenAI gjorde det ganska klart att denna modell byggdes med STEM i åtanke.

Så baserat på det är det en säker satsning att modellens förmåga att efterlikna mänskligt skrivande skulle vara ganska genomsnittlig, om inte helt dålig.

Tack vare ett par YouTube-kanaler som publicerade exempel på utdata från Chat GPT o1-modeller - särskilt o1-mini och o1-preview - fick vi köra dessa texter genom populära detekteringsverktyg och se vilken typ av röda flaggor som dyker upp.

Är OpenAI: s o1-mini och o1-preview verkligen oupptäckbara?

Vi tog två textexempel direkt från YouTube-videor som innehöll uppmaningar genom o1-preview och o1-mini.

Låt oss se om deras utdata faktiskt kan slinka förbi AI-detektorer utan att utlösa larm.

Är o1-preview detekterbar?

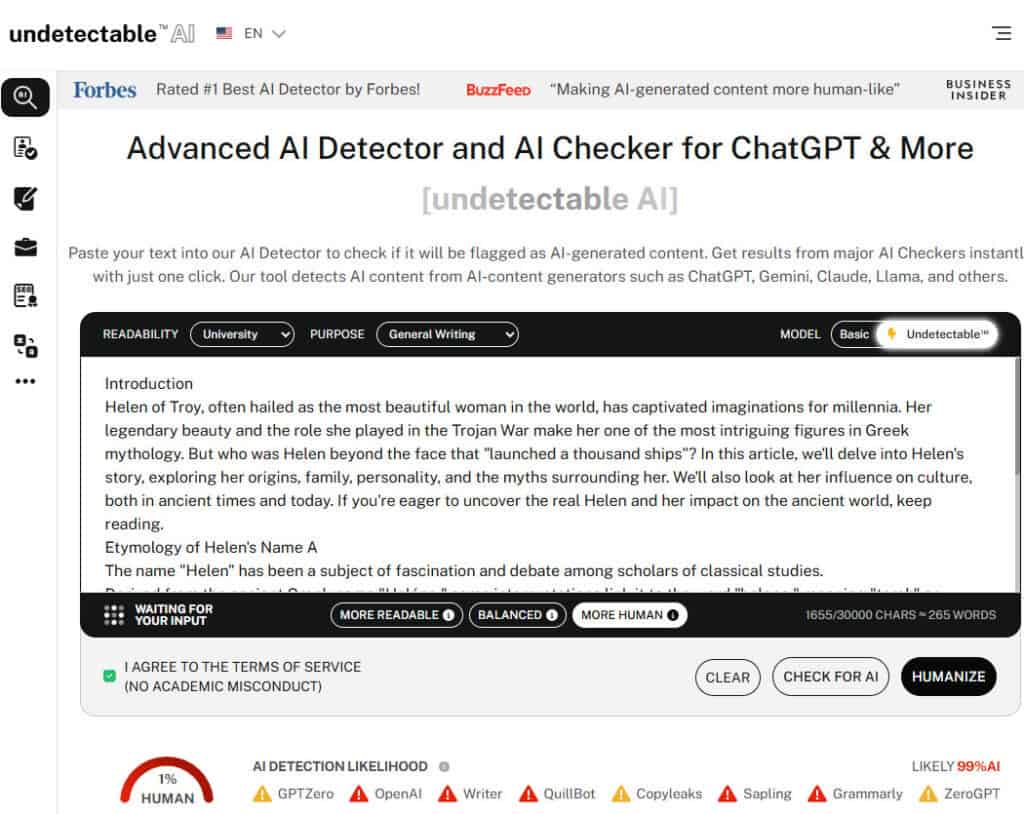

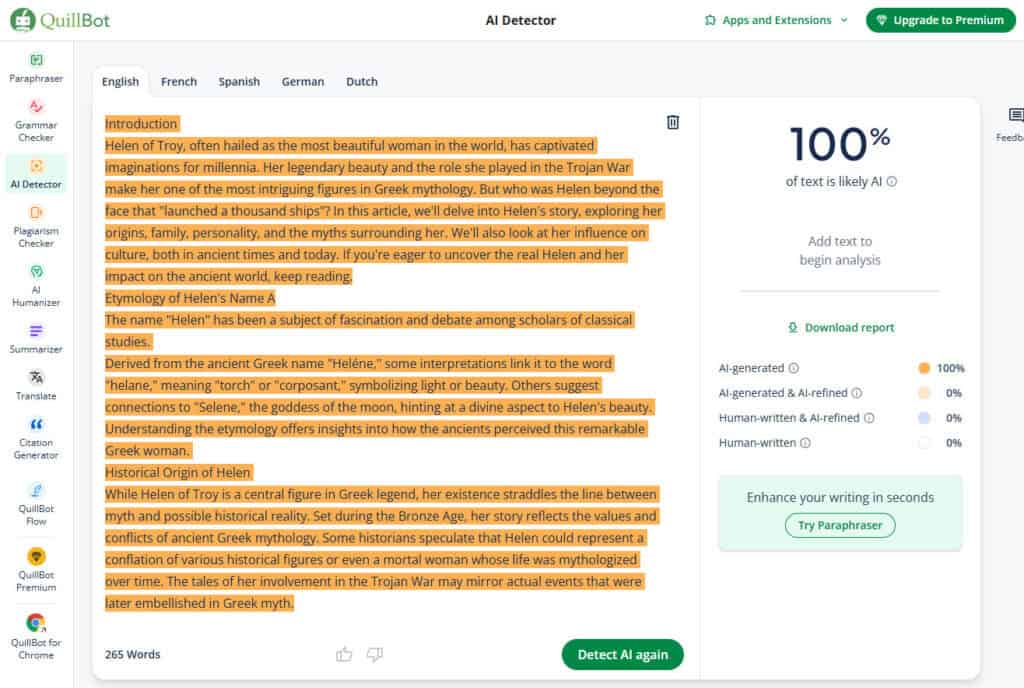

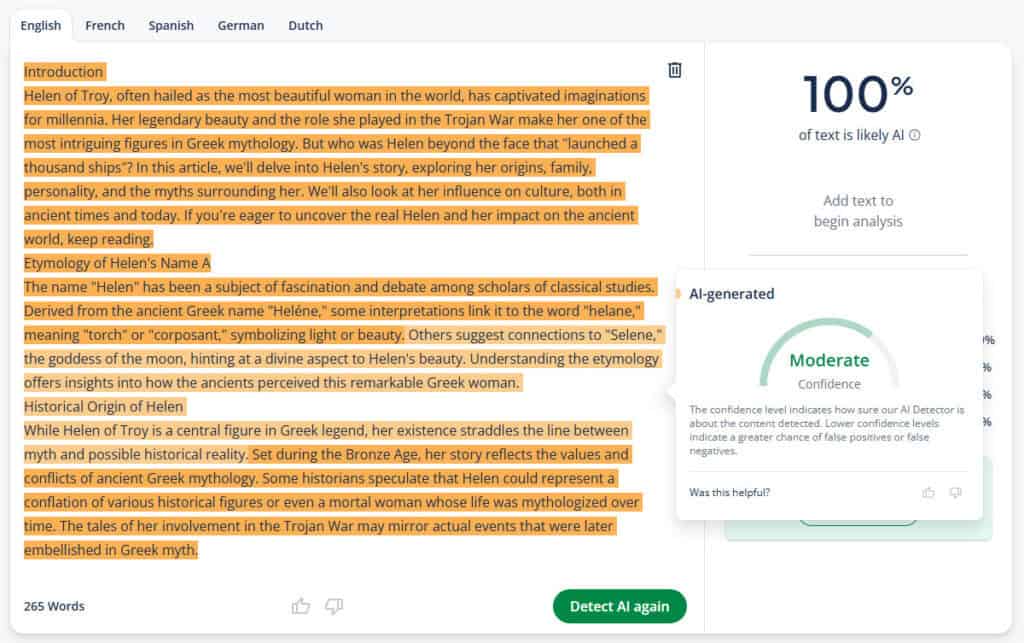

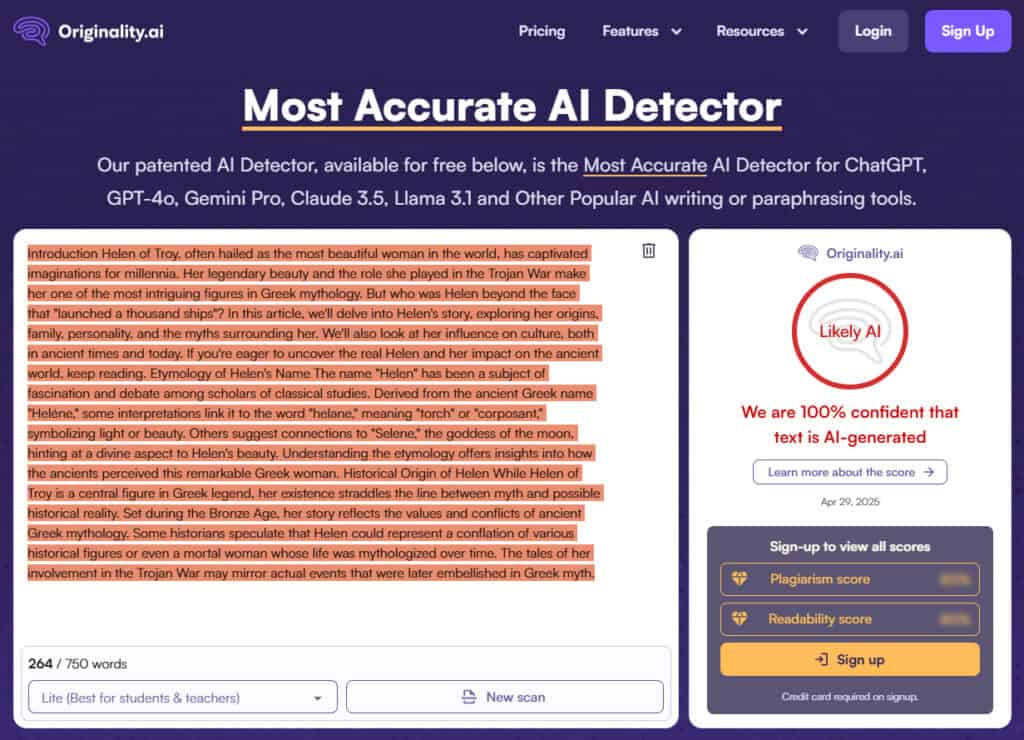

Vi valde ett textprov från en video av The Nerdy Novelist, där modellen o1-preview genererade en kort artikel med titeln "Helen of Troy: Ansiktet som satte tusen skepp i sjön".

Vi fokuserade på inledningen och de två första rubrikerna, som totalt omfattade 265 ord.

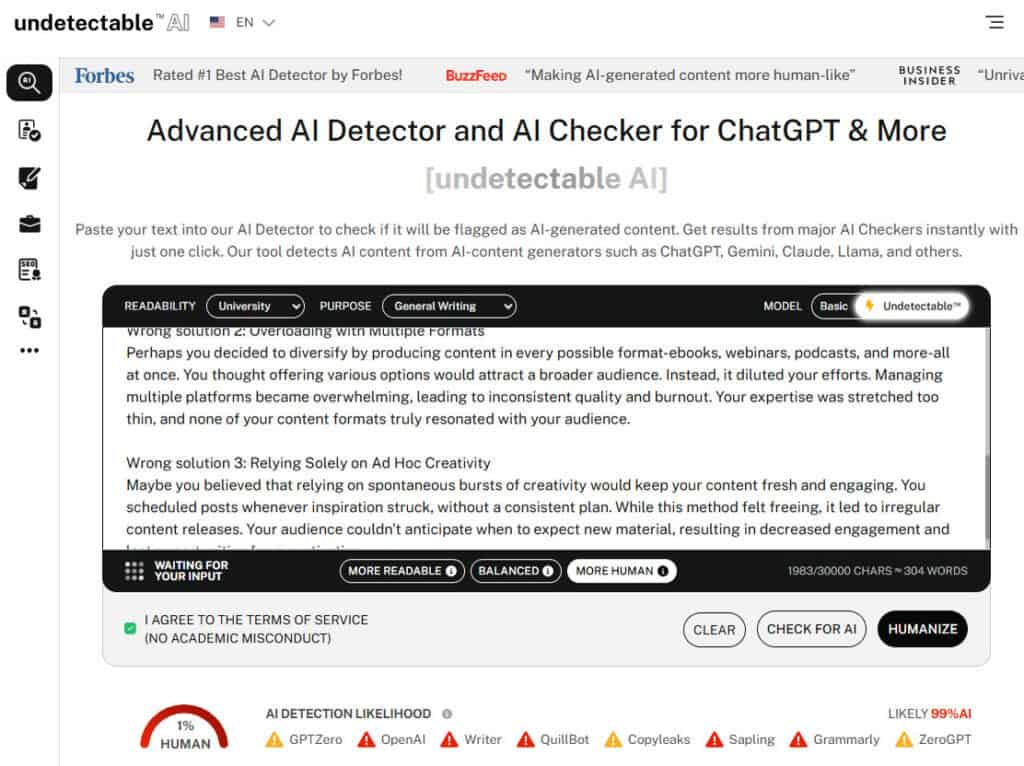

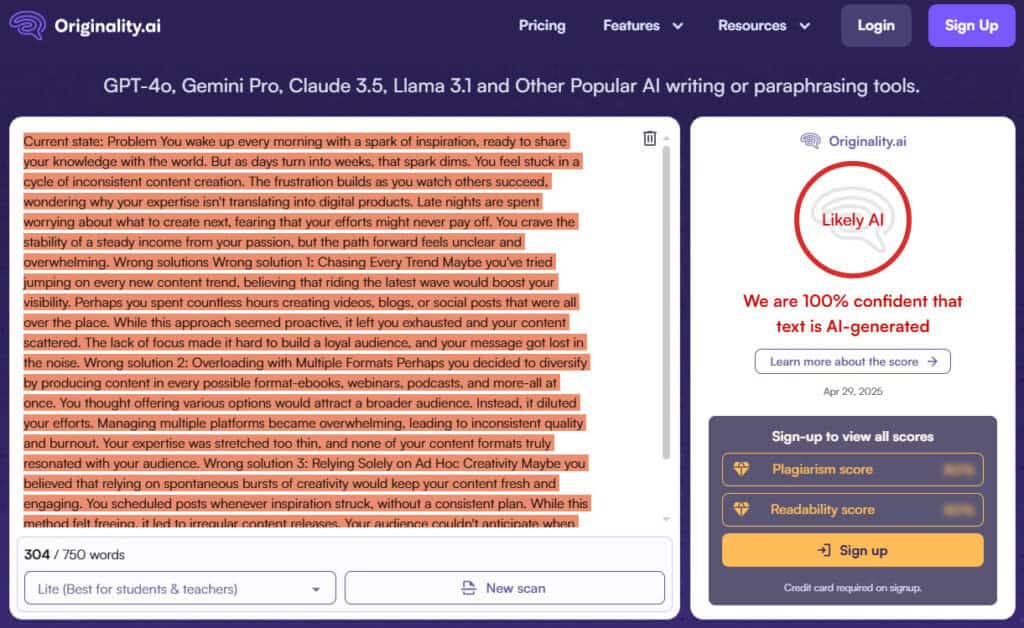

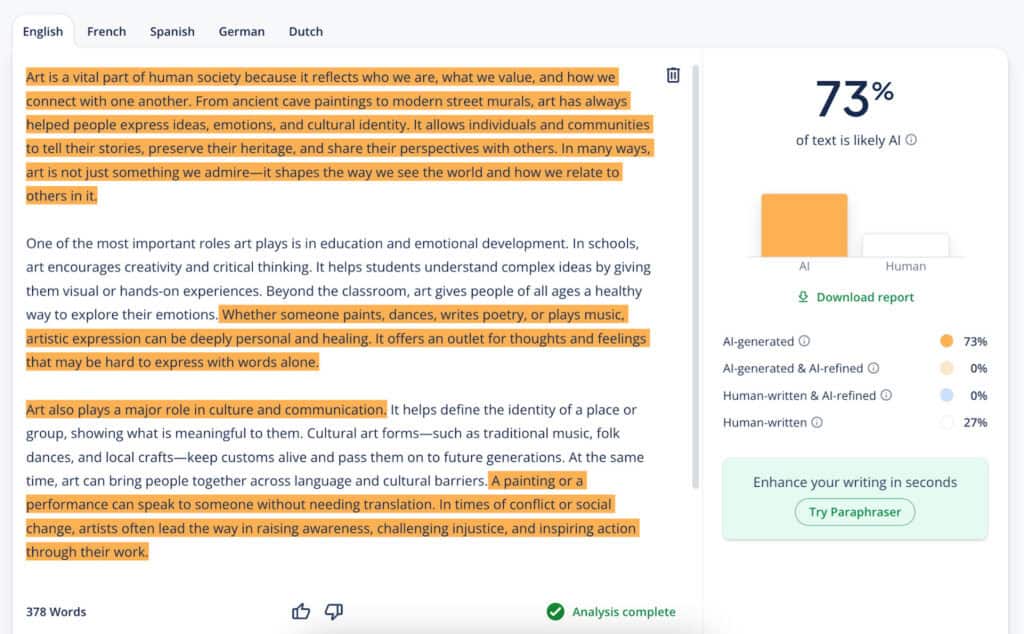

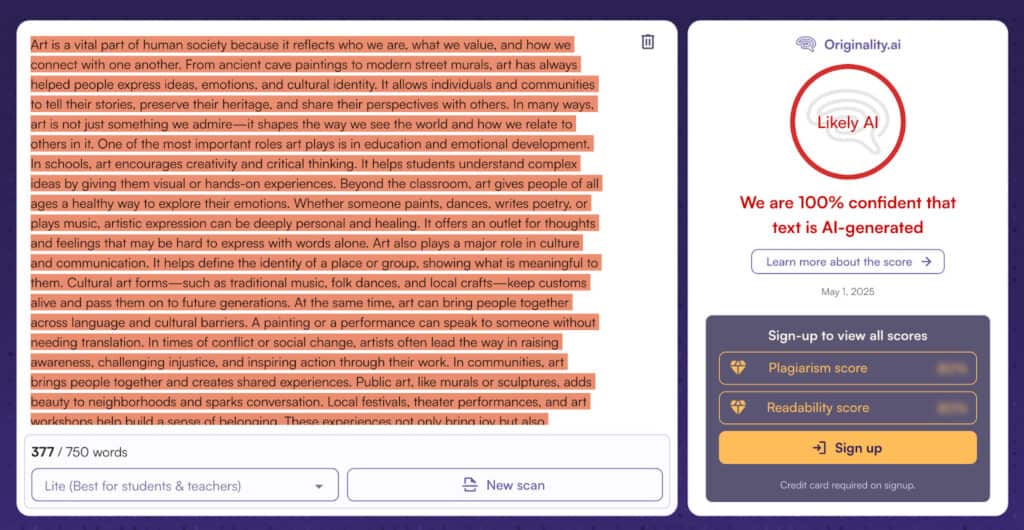

Vi kastade in texten i Odetekterbar AI, QuillBot, och Originalitet.aibara för att täcka alla baser.

Odetekterbar AI var inte imponerad. Den flaggade 99% av innehållet som AI-genererat och stannade inte där.

Den förutspådde också att andra detektorer - som QuillBot, ZeroGPT och Grammarly - skulle komma till samma slutsats. Så låt oss bekräfta detta genom att köra texten genom QuillBot.

QuillBot följde efter. Den flaggade texten som 100% sannolikt AI.

Men det gillar att ge en fördel av tvivel. Du kan hålla muspekaren över olika delar av texten och se konfidensnivåerna: låg, måttlig, hög.

Och så har vi Originality.ai. Den kom in med 100% förtroende för att texten var AI-skriven. Inte 98%. Inte 99. 100. Och den använder inte ens ordet "sannolikt".

Är o1-mini detekterbar?

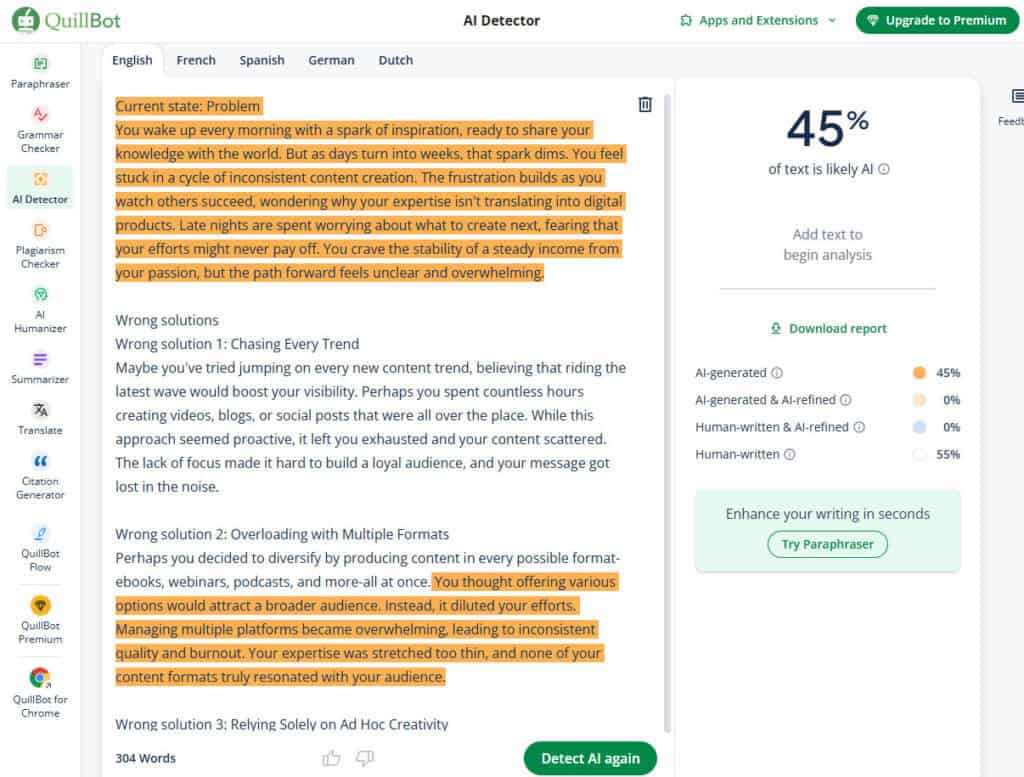

Låt oss nu prata om o1-mini.

Den text vi använt här är från en annan YouTuber som använde en mycket bättre uppmaning, och det syns. Texten hade mer personlighet och ett mer mänskligt flöde.

AI-detektorerna märkte det också. QuillBot kallade den här för ungefär 45% AI, 55% människa. Det är faktiskt ett anständigt resultat.

Om du bara läste den snabbt utan att kontrollera, skulle du kanske till och med tro att en person skrivit den.

Men bli inte för bekväm. Undetectable AI och Originality.ai lät sig inte luras.

Båda kallade det fortfarande AI med 99% respektive 100% säkerhet. Så även med en bättre uppmaning kunde skrivandet inte ta sig över stängslet.

Vilket leder oss till slutresultatet: OpenAI: s o1-preview och o1-mini är definitivt detekterbara, särskilt om du använder en Undetectable's AI-detektor.

Du kan justera din prompt, omformulera dina meningar, kanske till och med lura ett verktyg här och där. Men Chat GPT o1 har fortfarande stora chanser att upptäckas som AI-detektering.

Hur man förbikopplar AI-detektorer med GPT-o1

Så du har fått din skinande nya text direkt från GPT o1 - ren, snabb och kusligt sammanhängande. Jättebra. Men nu kommer det verkliga tricket: att få det att se ut som om en människa faktiskt skrev det.

När GPT o1 har gjort sitt jobb kan du inte bara publicera det som det är. Du måste få det att se ut som om en människa har skrivit det.

Men istället för att göra det manuellt kan du göra det med hjälp av AI-humanizers.

Dessa verktyg vet hur man tar robotklingande text och ger den lite mänsklig konstighet. Den typ som detektorer kämpar för att avkoda.

Men här är grejen. Det finns en hel del verktyg för det här ändamålet som lovar att "förmänskliga" din text men som i slutändan får den att låta som en dåligt omarbetad text.

Det är därför Undetectable AI förtjänar att uppmärksammas.

Vår uppsättning av verktyg som Humaniserare, Smygskrivare, och Parafraser faktiskt förstår hur AI-detektorer tänker.

- Humanizer justerar flödet och formuleringen precis tillräckligt för att flyga under radarn.

- Stealth Writer ger variation i meningsstrukturen, vilket är viktigt för att förvirra klassificerare.

- Och parafraseraren omformar texten samtidigt som den ursprungliga innebörden förblir intakt.

I grund och botten kan dessa verktyg AI:s språk och vet hur de ska få den att tappa greppet.

Så om du använder GPT o1 för skrivning och du vill att ditt arbete ska passera som mänskligt, hoppa inte över efterbehandlingssteget.

Även en liten upprensning med hjälp av Undetectable AI kan göra stor skillnad när det gäller att slå detekteringsverktyg.

Upptäck vår AI Detector och Humanizer direkt i widgeten nedan!

GPT-o1 jämfört med GPT-4o: Vilket är mest detekterbart?

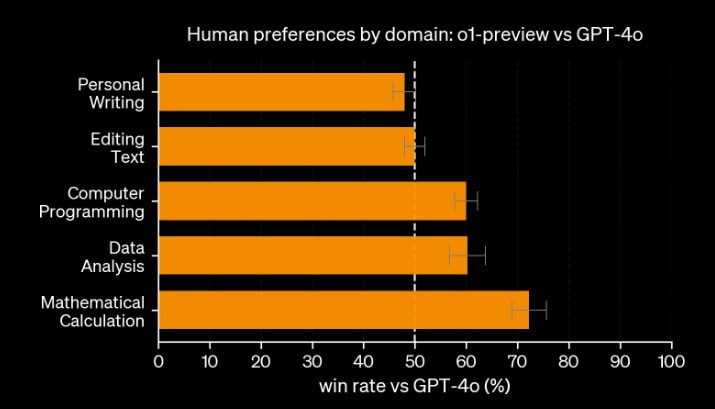

Vi har redan pratat om hur GPT o1 är starkt inriktad på matematik och vetenskap, medan GPT-4o är lite mer finkänslig när det gäller språk. Men hur står sig GPT o1 vs 4o när det gäller att skriva?

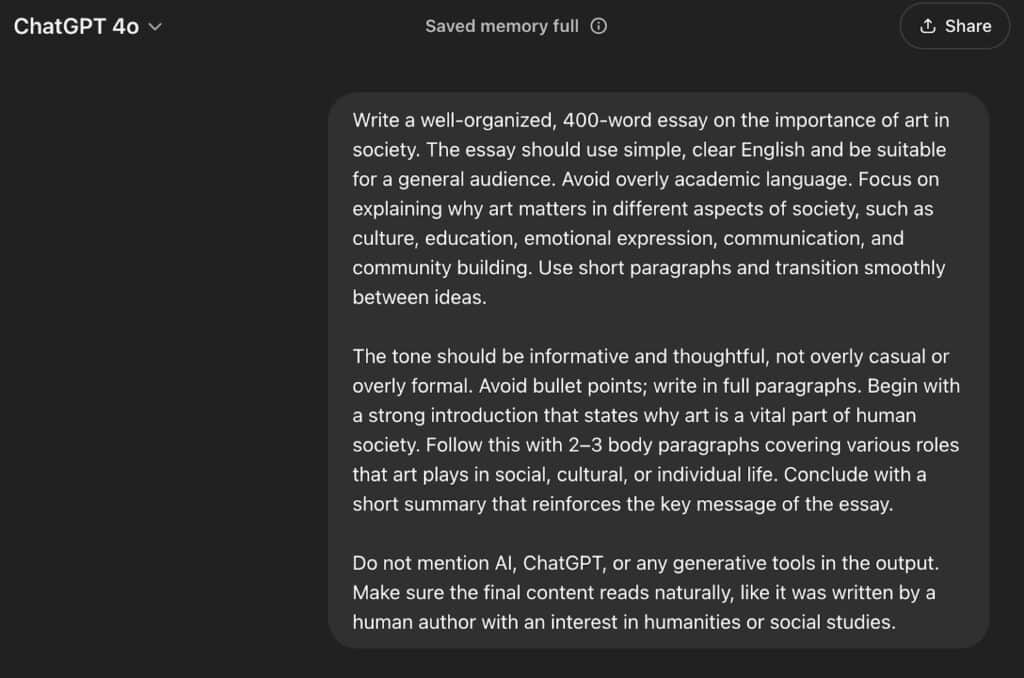

Först använde vi denna uppmaning för att generera 400 ords innehåll med hjälp av GPT 4o:

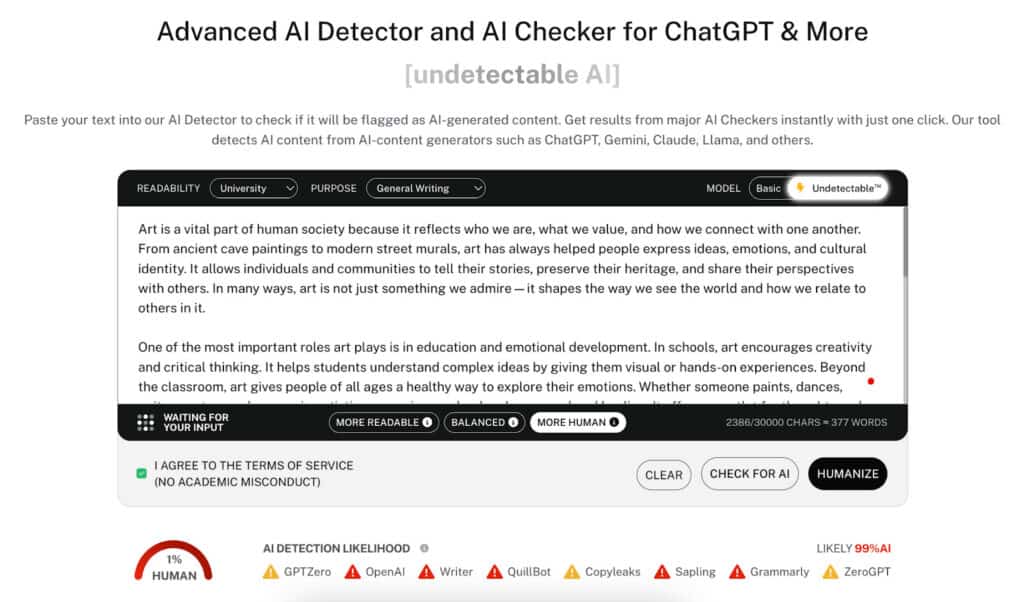

Sedan körde vi GPT-4os utdata genom samma tre AI-detektorer: Oupptäckbar AI, QuillBot och Originality.ai.

Odetekterbar AI flaggade 99% av innehållet som AI. Det är en imponerande AI-detektering, eller hur?

Sedan kom QuillBot in och sa: "Inte så snabbt." Den flaggade 73% av samma text som AI-genererad, en ännu hårdare bedömning än den gav till GPT o1-mini, som den bedömde till 45%.

Originality.ai var fortfarande fast i full misstanke-läge. Den klockade GPT-4os innehåll till 100% AI, samma som alltid.

Så vad betyder allt detta? De flesta Ai-detektorer som Undetectable AI och Orginality AI är bra på att fånga ChatGPT o1 och 4o text.

Men om vi håller räkningen är GPT o1 klart mer detekterbar. På flera detektorer flaggades den konsekvent vid 99-100% AI, även med förbättrad uppmaning.

Och ärligt talat, det är logiskt. GPT o1 byggdes inte för att vara en språkmodell. Det är en STEM-first-modell, byggd för att lösa problem.

GPT-4o, å andra sidan, vet hur man låter mer naturligt, särskilt när det paras ihop med en solid prompt.

Så om du väljer mellan de två för skrivuppgifter där smygande är viktigt, är GPT-4o din bättre chans att slinka förbi radarn.

Du kan också använda Undetectable AI:s Matematiklösare för att se hur modeller som GPT-o1 hanterar strukturerad problemlösning, eftersom den delar upp ekvationer i tydliga steg som gör det lättare att utvärdera deras resonemang.

Slutlig dom: Är GPT-o1 detekterbar?

Våra resultat visar att ja, GPT o1 är detekterbar.

Även med en hyfsad prompt-teknik är den text som genereras fortfarande ett problem för de flesta AI-detektorer.

Men i ärlighetens namn var skrivandet inte det jobb den var utbildad för att utföra. GPT o1 byggdes för STEM-relaterade uppgifter som att lösa ekvationer, koda och samla in data.

Så om du försöker få fram innehåll som faktiskt låter mänskligt är GPT o1 förmodligen inte rätt modell för det. Det är bättre att använda GPT-4o, som har mer språkflyt, eller ännu bättre, att använda ett verktyg som är byggt specifikt för att skriva oupptäckbart AI-innehåll.

Det är där Undetectable AI kommer in i bilden.

Vår AI Humanizer skriver om ditt innehåll på ett sätt som låter naturligt, nyanserat och övertygande mänskligt.

Oavsett om du skriver blogginlägg, essäer eller produktbeskrivningar anpassar den sig till ditt ämne utan att utlösa AI-detekteringslarm.

Och på tal om larm, om du vill testa hur detekterbart ditt innehåll verkligen är (oavsett om det kommer från GPT o1, GPT-4o eller någon annan modell) är vår AI Detector ett av de mest exakta verktygen på marknaden.

Så skippa gissningarna.

Försök Odetekterbar AI idag.