Generative KI-Tools haben Deepfakes von der wissenschaftlichen Forschung zu einem großen öffentlichen Anliegen gemacht. Die Menschen haben Angst vor synthetischen Medien und zeigen gleichzeitig, dass sie nicht in der Lage sind, sie zu erkennen, so die Ergebnisse der Umfrage vom Juni 2025.

Das FBI stellt fest, dass die KI-Depefake-Technologie kriminelle Aktivitäten durch drei Hauptmethoden ermöglicht: KI-generierte Spam-Nachrichten, KI-erstellte Social-Media-Personas und KI-codierte Phishing-Websites.

Das Ziel dieser Betrügereien ist es, sowohl Unternehmen als auch Privatpersonen finanziell auszunutzen. Die Kombination von Deepfake-Technologie mit KI führte zu mehr als $200 Millionen Verluste im Jahr 2025.

Die Mehrheit der Amerikaner (85%) hat im vergangenen Jahr aufgrund von Deepfakes ihr Vertrauen in Online-Informationen verloren und 81% befürchten persönliche Schäden durch gefälschte Audio- und Videoinhalte. Mehr als 90% der Nutzer nutzen keine Erkennungstools. Die Daten weisen auf eine wachsende "Vertrauenslücke" hin, die ein sofortiges Eingreifen der Regulierungsbehörden, Plattformbetreiber und Technologen erfordert.

Wichtigste Ergebnisse

| Einsicht | Unterstützende Daten |

|---|---|

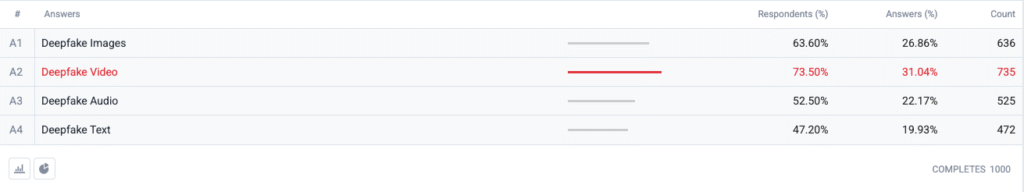

| Deepfake-Video führt den Angst-Index an. | 73,5 % der Befragten wählten Deepfake-Videos als ein Format, über das sie sich "am meisten Sorgen machen", gefolgt von Bildern (63,6 %), Audio (52,5 %) und Text (47,2 %). |

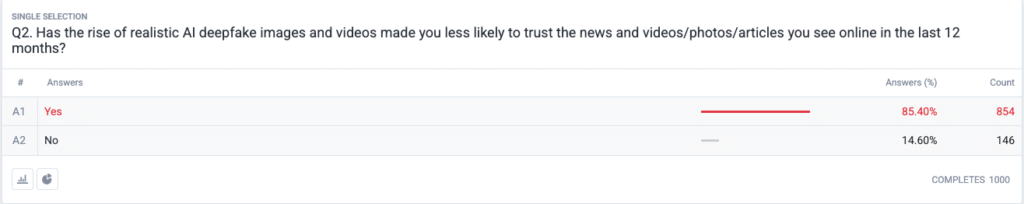

| Es entwickelt sich eine regelrechte Vertrauenskrise. | 85,4 % geben an, dass sie in den letzten 12 Monaten aufgrund von realistischen Fälschungen weniger Vertrauen in Nachrichten, Fotos oder Videos im Internet haben. |

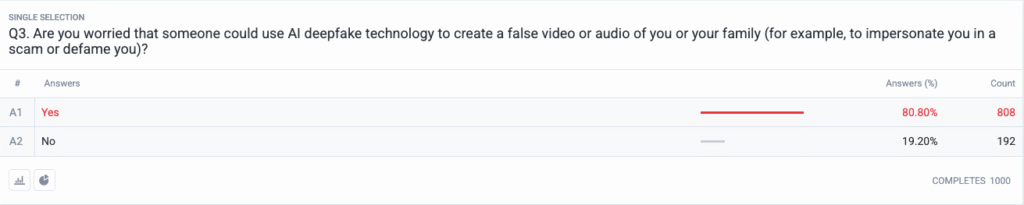

| Persönliche Bedrohung ist zum Mainstream geworden. | 80,8 % befürchten, dass Betrüger oder bösartige Akteure Deepfake-Inhalte gegen sie oder ihre Familie einsetzen könnten. |

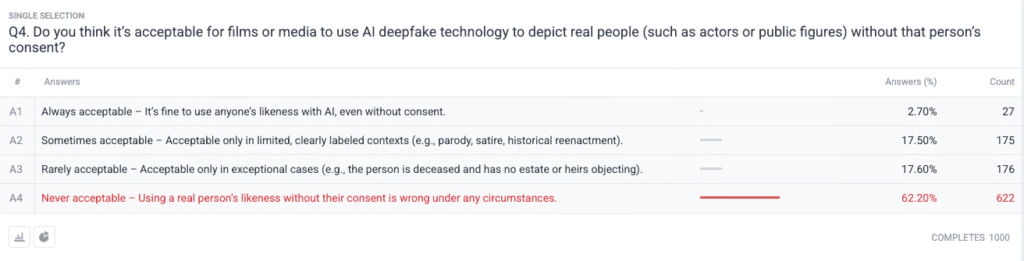

| Starker moralischer Konsens über die Zustimmung. | 62.2 % sagen, dass die Verwendung des Bildes einer realen Person ohne Erlaubnis eine niemals akzeptabel; nur 2.7 % sagen, es ist immer akzeptabel. |

Methodik

- Probe & Feldarbeit. Wir rekrutierten 1.000 U.S. Erwachsene unter Verwendung von Alters-, Geschlechts- und Regionalquoten, die sich an den Benchmarks der US-Volkszählung orientieren. Die Feldarbeit wurde abgeschlossen am 18. Juni 2025.

- Frage Design. Fünf geschlossene Fragen erfassten die Besorgnis über verschiedene Deepfake-Formate, die jüngsten Veränderungen im Vertrauen, das wahrgenommene persönliche Risiko, ethische Ansichten über die Zustimmung und die vorherige Verwendung von Erkennungssoftware.

- Irrtumswahrscheinlichkeit. ±3,1 Prozentpunkte bei einem Vertrauensniveau von 95 %.

- Gewichtung. Die Gewichtung nach der Stratifizierung korrigierte geringfügige Abweichungen von der nationalen Demografie.

Fragen

F1: Welche Form von KI-Depfakes bereitet Ihnen die größten Sorgen? (Wählen Sie alle zutreffenden Angaben)

F2: Hat die Zunahme von realistischen KI-Deefake-Bildern und -Videos dazu geführt, dass Sie den Nachrichten und Videos/Fotos/Artikeln, die Sie in den letzten 12 Monaten online gesehen haben, weniger vertrauen?

F3: Machen Sie sich Sorgen, dass jemand die KI-Depfake-Technologie nutzen könnte, um ein falsches Video oder Audio von Ihnen oder Ihrer Familie zu erstellen (z. B. um sich bei einem Betrug als Sie auszugeben oder Sie zu verleumden)?

F4: Halten Sie es für akzeptabel, dass Filme oder Medien KI-Deefake-Technologien einsetzen, um reale Personen (z. B. Schauspieler oder Personen des öffentlichen Lebens) ohne deren Zustimmung darzustellen?

Trendanalyse

- Videoangst überflügelt andere Formate

In der Vergangenheit war Video ein vertrauenswürdiges Medium, dem die Menschen glaubten, wenn sie es sahen. Seit Video seinen Vertrauensstatus verloren hat, dominieren in den Köpfen der Amerikaner synthetische Videos. Die Menschen haben 10 Prozentpunkte mehr Angst vor Videos als vor Bildern (73,5% gegenüber 63,6%), weil die Bewegung von Videos in Kombination mit synchronisierter Stimme und realistischem Aussehen ihre Bedenken verstärkt. Medienunternehmen sollten strenge Authentifizierungsverfahren für Videoinhalte einführen, bevor sie diese für die Öffentlichkeit freigeben.

- Erosion des Vertrauens in Informationen

Der massive Rückgang des Vertrauens in der Öffentlichkeit (85%) zeigt, dass jede Art von digitalen Inhalten ungeachtet ihrer offensichtlichen Unglaubwürdigkeit angezweifelt wird. Die Theorie der "billigen Rede" zeigt, wie einfach die Überprüfung des Wahrheitsgehalts durch Fälschungen in die Verantwortung des Verbrauchers übergegangen ist. Persönlichkeiten des öffentlichen Lebens und Journalisten sowie politische Entscheidungsträger müssen sich auf eine verstärkte Überwachung vorbereiten, indem sie in eindeutige Überprüfungsmethoden (wie kryptographische Wasserzeichen und signierte Metadaten) investieren.

Machen Sie sich nie wieder Sorgen, dass KI Ihre Texte erkennt. Undetectable AI Kann Ihnen helfen:

- Lassen Sie Ihr AI-unterstütztes Schreiben erscheinen menschenähnlich.

- Bypass alle wichtigen KI-Erkennungstools mit nur einem Klick.

- Verwenden Sie AI sicher und zuversichtlich in Schule und Beruf.

- Deepfakes werden persönlich

Die Mehrheit der Befragten (85%) kann sich vorstellen, selbst oder ihre Familienmitglieder Opfer von Deepfake-Angriffen zu werden. Die Wahrnehmung von Deepfakes als politische Desinformationswerkzeuge für Wahlen und Prominente hat sich in den letzten Zyklen auf persönliche Bedrohungen verlagert. Die Verbreitung von KI-Apps zum Klonen von Stimmen und zum Austauschen von Gesichtern hat Identitätsdiebstahl und Finanzbetrug zu einer plausiblen Bedrohung für normale Haushalte gemacht, was zu Forderungen nach verbesserten Mechanismen zur Entschädigung von Opfern und Gesetzen zum Schutz der Identität geführt hat.

- Nahezu universelle Forderung nach Zustimmung

Die ethische Frage der Umfrage zeigt, wie gespalten die Hollywood-Gemeinde in Bezug auf synthetische Schauspieler und posthume Aufführungen ist. Die starke öffentliche Haltung gegen die Verletzung von Persönlichkeitsrechten kristallisierte sich als die "niemals akzeptable" Wahl heraus, die von 62,2 Prozent der Teilnehmer unterstützt wurde. Die Behörden sollten diese Erkenntnisse nutzen, um Gesetze zu erlassen, die die ausdrückliche Zustimmung der Betroffenen vor der Erstellung von KI-generierten Darstellungen von Persönlichkeiten verlangen und eine ordnungsgemäße Kennzeichnung sicherstellen.

- Bereitschaftslücke und Bildungschancen

Obwohl das Thema sehr besorgniserregend ist, haben 89,5 % der Befragten keine Erkennungsinstrumente verwendet. Der Markt weist ein latentes Potenzial auf, da das Interesse die derzeitigen Nutzungsmöglichkeiten übersteigt, was auf Probleme bei der Benutzerfreundlichkeit und Sensibilisierung sowie Zweifel an der Wirksamkeit hinweist. Undetectable AI muss zusammen mit anderen Branchenakteuren einfache Onboarding-Prozesse schaffen, indem es Verbraucherplattformen mit Erkennungstools ausstattet und Bildungsprogramme entwickelt, die der Öffentlichkeit die KI-Technologie erklären.

Auswirkungen auf die Interessengruppen

| Interessensvertreter | Umsetzbare Erkenntnisse |

|---|---|

| Nachrichten und soziale Plattformen | Anwendung von Standards für authentifizierte Medien (C2PA, W3C Provenance) und Veröffentlichung von "herkunftsgeprüften" Plaketten, um das Vertrauen des Publikums wiederherzustellen. |

| Unterhaltung Studios | Einführung ausdrücklicher Opt-in-Verträge für synthetische Abbilder und Einführung von On-Screen-Offenlegungen, wenn KI-Nachbildungen verwendet werden. |

| Regulierungsbehörden | Gesetzesentwürfe zum Recht auf Veröffentlichung und zur Kennzeichnung von Fälschungen vorantreiben, um sie mit den Erwartungen der Öffentlichkeit in Einklang zu bringen. |

| Unternehmen & Marken | Überwachen Sie Markenbilder proaktiv auf Manipulationen und schulen Sie Ihre Mitarbeiter im Erkennen von verdächtigen Inhalten. |

| Verbraucher | Suchen Sie nach seriösen Erkennungsinstrumenten und praktizieren Sie digitale Hygiene nach dem Prinzip "anhalten, überprüfen, teilen", bevor Sie Medien weiterverbreiten. |

Kommentare

Wir haben weitere Antworten von Umfrageteilnehmern zu ihrer Nutzung von KI-Tools zur Erkennung von Fälschungen eingeholt. Dabei stellte sich heraus, dass einige diese Tools bereits nutzen und ein großer Teil der Teilnehmer angab, sie nicht zu kennen, aber daran interessiert zu sein, mehr darüber zu erfahren. Die vollständigen Umfragedaten sind auf Anfrage erhältlich.

Dieser Bericht ist eine AI-Zusammenfassung unserer vollständigen Ergebnisse, die auf Anfrage erhältlich sind. Diese Untersuchung wurde in Zusammenarbeit mit folgenden Unternehmen durchgeführt TruthScan, eine Lösung zur Erkennung von Fälschungen und zur Bekämpfung von Betrug.

Schlussfolgerung

Die Deepfake-Problematik im Jahr 2025 ist von einem starken Paradoxon geprägt: zunehmende Beunruhigung der Öffentlichkeit bei gleichzeitig minimalen Schutzmaßnahmen. Angesichts des schwindenden Vertrauens stehen Unternehmen vor der dringenden Aufgabe, digitale Inhalte zu verifizieren, zu kennzeichnen und zu authentifizieren.

Fairer Gebrauch

Sie können diese Informationen gerne in einem Artikel oder Blogbeitrag verwenden, sofern Sie uns einen Link und eine Quellenangabe zur Verfügung stellen. Wenn Sie Zugang zu den vollständigen Umfragedaten haben möchten, zögern Sie nicht, sich direkt mit uns in Verbindung zu setzen.

Für Presseanfragen oder Zugang zu den vollständigen Tabellen wenden Sie sich bitte an [email protected] oder [email protected]