Las herramientas de IA generativa han hecho que los deepfakes dejen de ser una investigación científica y se conviertan en una gran preocupación pública. Según los resultados de la encuesta de junio de 2025, la gente muestra temor hacia los medios sintéticos y, al mismo tiempo, incapacidad para detectarlos.

El FBI afirma que la tecnología deepfake de IA permite actividades delictivas a través de tres métodos principales que incluyen mensajes de spam generados por IA y personajes de redes sociales creados por IA y sitios web de phishing codificados por IA.

El objetivo de estas estafas es la explotación financiera tanto de organizaciones empresariales como de consumidores particulares. La combinación de la tecnología deepfake con la IA dio lugar a más de $200 millones en pérdidas durante 2025.

La mayoría de los estadounidenses (85%) perdieron la confianza en la información en línea durante el año pasado a causa de los deepfakes y 81% temen sufrir daños personales por contenidos de audio y vídeo falsos. Más de 90% de los usuarios no utilizan herramientas de detección. Los datos indican una creciente "brecha de confianza" que exige la intervención inmediata de los reguladores y de los operadores y tecnólogos de las plataformas.

Principales resultados

| Insight | Datos complementarios |

|---|---|

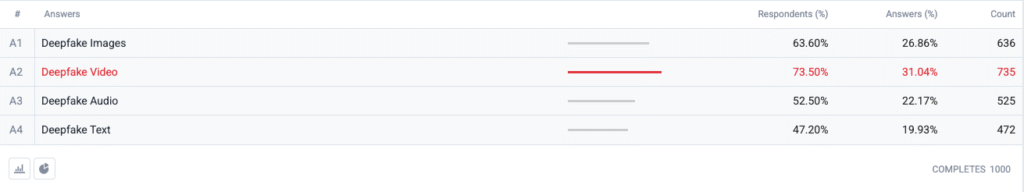

| El vídeo Deepfake encabeza el índice del miedo. | El 73,5 % de los encuestados eligió el vídeo deepfake como formato que "más les preocupa", seguido de las imágenes (63,6 %), el audio (52,5 %) y el texto (47,2 %). |

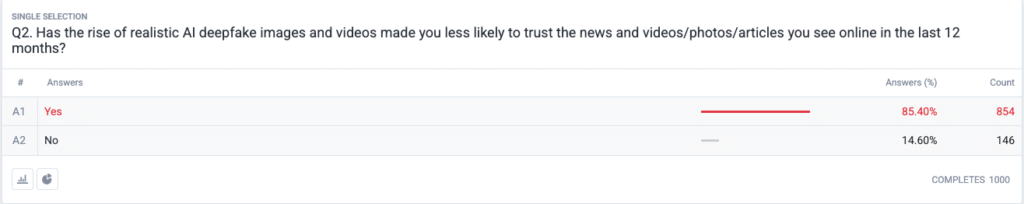

| Se está produciendo una crisis de confianza en toda regla. | 85,4 % afirman que es menos probable que confíen en las noticias, fotos o vídeos en línea en los últimos 12 meses debido a los deepfakes realistas. |

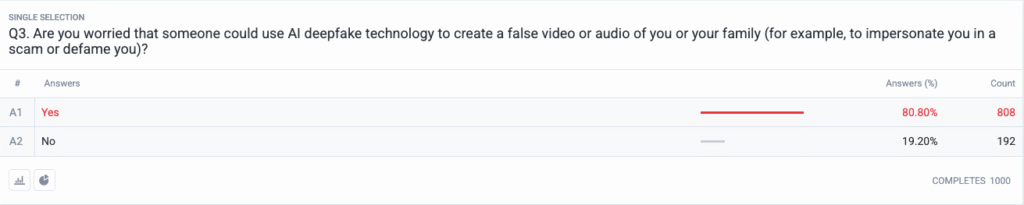

| La amenaza personal se ha generalizado. | 80,8 % temen que los estafadores o los malos actores puedan utilizar contenidos deepfake contra ellos o su familia. |

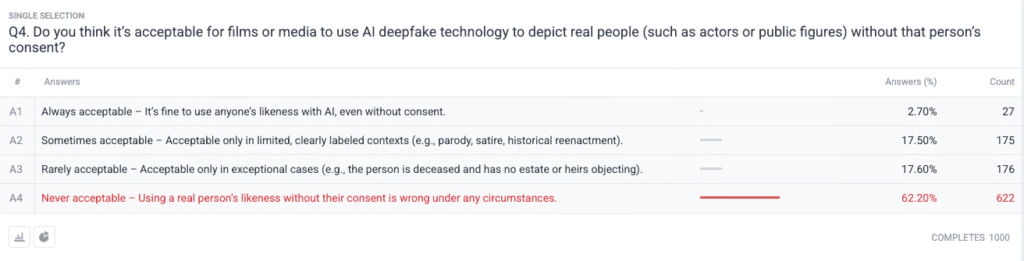

| Fuerte consenso moral sobre el consentimiento. | 62,2 % dicen que utilizar la imagen de una persona real sin permiso es nunca aceptable; sólo 2,7 % dicen que siempre es aceptable. |

Metodología

- Muestra y trabajo de campo. Reclutamos 1.000 adultos estadounidenses utilizando cuotas de edad, sexo y región acordes con las referencias del Censo de EE.UU. El trabajo de campo concluyó el 18 de junio de 2025.

- Diseño de la pregunta. Cinco preguntas cerradas midieron la preocupación por los distintos formatos de deepfake, los cambios recientes en la confianza, el riesgo personal percibido, las opiniones éticas sobre el consentimiento y el uso previo de software de detección.

- Margen de error. ±3,1 puntos porcentuales con un nivel de confianza del 95 %.

- Ponderación. La ponderación posterior a la estratificación corrigió pequeñas desviaciones de los datos demográficos nacionales.

Preguntas

P1: ¿Qué forma de Deepfakes de IA le preocupa más? (Elija todas las que procedan)

P2: En los últimos 12 meses, ¿le ha hecho el aumento de imágenes y vídeos falsos realistas con IA menos probable que confíe en las noticias y vídeos/fotos/artículos que ve en Internet?

P3: ¿Te preocupa que alguien pueda utilizar la tecnología de IA deepfake para crear un vídeo o audio falso tuyo o de tu familia (por ejemplo, para suplantar tu identidad en una estafa o difamarte)?

P4: ¿Cree que es aceptable que las películas o los medios de comunicación utilicen tecnología de IA deepfake para representar a personas reales (como actores o personajes públicos) sin el consentimiento de esa persona?

Análisis de tendencias

- La ansiedad por el vídeo supera a otros formatos

En el pasado, el vídeo era un medio fiable en el que la gente creía cuando lo veía. La preocupación por el vídeo sintético domina ahora las mentes de los estadounidenses desde que el vídeo perdió su estatus de medio fiable. La gente teme más al vídeo que a las imágenes por un margen de 10 puntos (73,5% frente a 63,6%) porque el movimiento del vídeo combinado con la voz sincronizada y la apariencia realista intensifica sus preocupaciones. Los medios de comunicación deben aplicar procedimientos estrictos de autenticación de los contenidos de vídeo antes de hacerlos públicos.

- Erosión de la confianza en la información

La caída masiva 85% de los niveles de confianza entre el público demuestra la duda generalizada sobre cualquier tipo de contenido digital, independientemente de su evidente falta de credibilidad. La teoría del "discurso barato" demuestra hasta qué punto la facilidad de fabricación ha hecho que la verificación de la verdad pase a ser responsabilidad del consumidor. Los personajes públicos y los periodistas, junto con los responsables políticos, deben prepararse para una mayor vigilancia invirtiendo en métodos de verificación claros (como marcas de agua criptográficas y metadatos firmados).

No vuelvas a preocuparte de que la IA detecte tus textos. Undetectable AI puede ayudarle:

- Haz que aparezca tu escritura asistida por IA de aspecto humano.

- Bypass las principales herramientas de detección de IA con un solo clic.

- Utilice AI de forma segura y con confianza en la escuela y el trabajo.

- Los deepfakes se vuelven personales

La mayoría de los encuestados (85%) se imaginan a sí mismos o a sus familiares como víctimas de ataques deepfake. La percepción de los deepfakes como herramientas de desinformación política centradas en elecciones y celebridades ha cambiado para incluir amenazas personales en los últimos ciclos. La propagación de las aplicaciones de clonación de voz y de intercambio de rostros ha convertido el robo de identidad y las estafas financieras en amenazas plausibles para los hogares ordinarios, lo que ha desencadenado demandas para mejorar los mecanismos de recurso de las víctimas y las leyes de protección de la identidad.

- Demanda casi universal de consentimiento

La pregunta ética de la encuesta revela cómo la comunidad de Hollywood sigue dividida sobre los actores sintéticos y las interpretaciones póstumas. La firme postura del público contra la vulneración de los derechos individuales surgió como la opción "nunca aceptable", que recibió el apoyo del 62,2 por ciento de los participantes. Los funcionarios públicos deberían utilizar estas pruebas para crear leyes que exijan el consentimiento explícito de las personas antes de crear representaciones de semejanza generadas por IA y garantizar la divulgación adecuada del etiquetado.

- Brecha de preparación y oportunidad educativa

Aunque existe una gran preocupación por el tema, el 89,5% de los encuestados no ha utilizado herramientas de detección. El mercado muestra un potencial latente, ya que los niveles de interés superan las capacidades de uso actuales, lo que indica problemas de usabilidad y concienciación y dudas sobre su eficacia. Undetectable AI, junto con otros actores del sector, debe crear procesos de incorporación sencillos, añadir herramientas de detección a las plataformas de consumo y desarrollar programas educativos que expliquen la tecnología de IA al público.

Implicaciones para las partes interesadas

| Partes interesadas | Conclusiones prácticas |

|---|---|

| Noticias y plataformas sociales | Implantar normas de autenticación de medios (C2PA, procedencia del W3C) y colocar distintivos de "origen verificado" para recuperar la confianza de la audiencia. |

| Estudios de entretenimiento | Instituir contratos de consentimiento explícito para las imágenes sintéticas y adoptar la divulgación en pantalla cuando se utilice la recreación por IA. |

| Reguladores | Avanzar en los proyectos de ley sobre el derecho a la publicidad y el etiquetado de falsificaciones para adaptarlos a las expectativas de consentimiento público. |

| Empresas y marcas | Supervise de forma proactiva las imágenes de marca en busca de manipulaciones y enseñe a los empleados a detectar contenidos sospechosos. |

| Consumidores | Busque herramientas de detección acreditadas y practique la higiene digital "pausar, verificar, compartir" antes de amplificar los medios. |

Comentarios

Recopilamos respuestas adicionales de los participantes en la encuesta en relación con su uso de herramientas de detección de falsificaciones profundas mediante IA, que revelaron que algunos ya las utilizan y que una gran parte de los individuos afirman que no las conocían pero que están interesados en saber más. Los datos completos de la encuesta están disponibles previa solicitud.

Este informe es un resumen de nuestros resultados completos, que están disponibles previa solicitud. Esta investigación se ha realizado en colaboración con TruthScanuna solución de detección de falsificaciones y lucha contra el fraude por internet.

Conclusión

En 2025, la preocupación por las falsificaciones se define por una cruda paradoja: el aumento de la alarma social se cruza con una acción protectora mínima. Con la confianza en declive, las organizaciones se enfrentan a un mandato urgente para verificar, etiquetar y autenticar el contenido digital.

Uso legítimo

No dude en utilizar esta información en un artículo o entrada de blog, siempre que nos proporcione un enlace y una cita. Para acceder al conjunto completo de datos de la encuesta, no dude en ponerse en contacto con nosotros directamente.

Para consultas de prensa o acceso a las tablas cruzadas completas, póngase en contacto con [email protected] o [email protected]