Les outils d'IA générative ont fait évoluer les deepfakes de la recherche scientifique vers une préoccupation publique majeure. Selon les résultats de l'enquête de juin 2025, les gens craignent les médias synthétiques tout en se montrant incapables de les détecter.

Le FBI affirme que la technologie de l'IA deepfake permet des activités criminelles par le biais de trois méthodes principales : les messages de spam générés par l'IA, les personas de médias sociaux créés par l'IA et les sites web d'hameçonnage codés par l'IA.

L'objectif de ces stratagèmes est d'exploiter financièrement les entreprises et les consommateurs. La combinaison de la technologie deepfake et de l'IA a permis d'obtenir plus de $200 millions d'euros de pertes au cours de l'année 2025.

La majorité des Américains (85%) ont perdu confiance dans les informations en ligne au cours de l'année écoulée à cause des deepfakes et 81% craignent d'être personnellement lésés par de faux contenus audio et vidéo. Plus de 90% des utilisateurs n'utilisent pas les outils de détection. Les données indiquent un "déficit de confiance" croissant qui exige une intervention immédiate de la part des régulateurs, des opérateurs de plateformes et des technologues.

Principaux résultats

| Aperçu | Données justificatives |

|---|---|

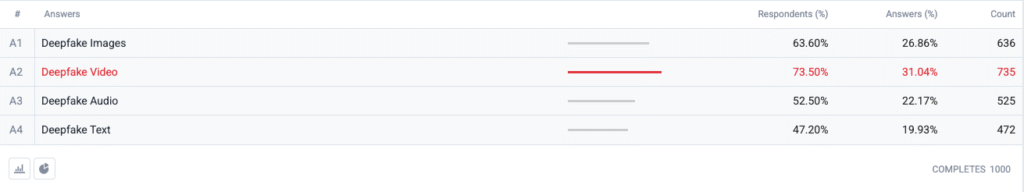

| La vidéo Deepfake en tête de l'indice de peur. | 73,5 % des personnes interrogées ont choisi la vidéo truquée comme le format qui les inquiète le plus, suivi par les images (63,6 %), l'audio (52,5 %) et le texte (47,2 %). |

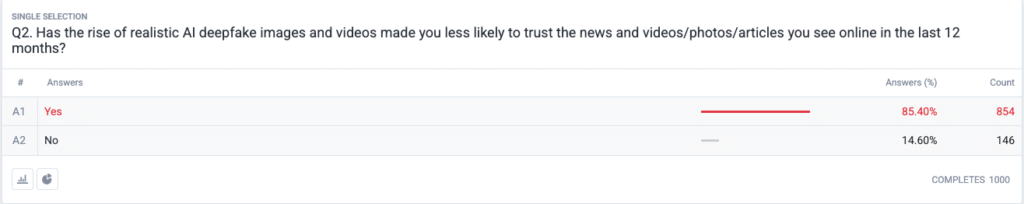

| Une véritable crise de confiance est en train de se développer. | 85,4 % déclarent avoir perdu confiance dans les informations, les photos ou les vidéos en ligne au cours des 12 derniers mois en raison des "deepfakes" réalistes. |

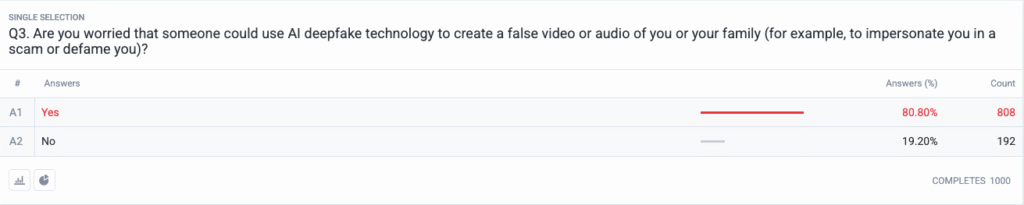

| Les menaces personnelles sont devenues monnaie courante. | 80,8 % s'inquiètent que des escrocs ou des acteurs malveillants puissent utiliser des contenus "deepfake" contre eux ou leur famille. |

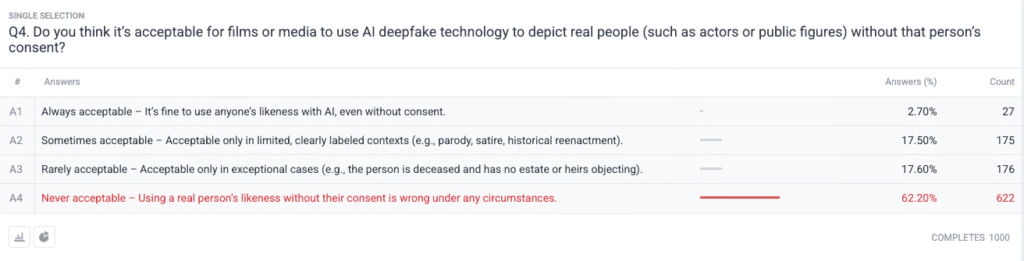

| Consensus moral fort sur le consentement. | 62.2 % déclarent qu'utiliser l'image d'une personne réelle sans autorisation est jamais acceptable ; il suffit de 2.7 % dire qu'elle est toujours acceptable. |

Méthodologie

- Échantillon et travail sur le terrain. Nous avons recruté 1 000 adultes américains en utilisant des quotas d'âge, de sexe et de région alignés sur les critères du recensement américain. Le travail sur le terrain s'est achevé le 18 juin 2025.

- Conception de la question. Cinq questions fermées ont permis d'évaluer l'inquiétude suscitée par les différents formats de deepfake, les changements récents en matière de confiance, la perception du risque personnel, les opinions éthiques sur le consentement et l'utilisation antérieure d'un logiciel de détection.

- Marge d'erreur. ±3,1 points de pourcentage au niveau de confiance de 95 %.

- Pondération. La pondération post-stratification a permis de corriger les écarts mineurs par rapport aux données démographiques nationales.

Questions

Q1 : Quelle forme d'IA Deepfakes vous préoccupe le plus ? (Choisissez toutes les réponses qui s'appliquent)

Q2 : L'apparition d'images et de vidéos réalistes et truquées par l'IA vous a-t-elle incité à ne plus faire confiance aux informations et aux vidéos/photos/articles que vous avez vus en ligne au cours des 12 derniers mois ?

Q3 : Craignez-vous que quelqu'un utilise la technologie AI deepfake pour créer une fausse vidéo ou un faux enregistrement audio de vous ou de votre famille (par exemple, pour usurper votre identité dans le cadre d'une escroquerie ou pour vous diffamer) ?

Q4 : Pensez-vous qu'il est acceptable que des films ou des médias utilisent la technologie de l'IA deepfake pour représenter des personnes réelles (telles que des acteurs ou des personnalités publiques) sans le consentement de ces personnes ?

Analyse des tendances

- L'anxiété vidéo dépasse les autres formats

Dans le passé, la vidéo était un support fiable auquel les gens croyaient lorsqu'ils la voyaient. Les préoccupations liées à la vidéo synthétique dominent désormais les esprits américains depuis que la vidéo a perdu son statut de média de confiance. Les gens craignent la vidéo plus que les images, avec une marge de 10 points (73,5% contre 63,6%), parce que le mouvement de la vidéo, combiné à la voix synchronisée et à l'apparence réaliste, intensifie leurs inquiétudes. Les médias devraient mettre en œuvre des procédures d'authentification strictes pour les contenus vidéo avant de les diffuser au public.

- Érosion de la confiance dans l'information

La chute massive du niveau de confiance du public démontre un doute généralisé à l'égard de tout type de contenu numérique, indépendamment de son manque évident de crédibilité. La théorie du "discours bon marché" montre à quel point la fabrication a facilité la vérification de la vérité, qui est devenue la responsabilité du consommateur. Les personnalités publiques, les journalistes et les décideurs politiques doivent se préparer à une surveillance accrue en investissant dans des méthodes de vérification claires (telles que les filigranes cryptographiques et les métadonnées signées).

Ne vous inquiétez plus jamais de la détection de vos messages par l'IA. Undetectable AI peut vous aider :

- Faites apparaître votre écriture assistée par l'IA à l'image de l'homme.

- By-pass tous les principaux outils de détection de l'IA en un seul clic.

- Utilisation AI en toute sécurité et en toute confiance à l'école et au travail.

- Les "deepfakes" deviennent personnels

La majorité des personnes interrogées (85%) s'imaginent elles-mêmes ou des membres de leur famille victimes d'attaques par deepfake. La perception des deepfakes en tant qu'outils de désinformation politique axés sur les élections et les célébrités a évolué pour inclure des menaces personnelles au cours des derniers cycles. La diffusion des applications de clonage de voix et d'échange de visages par l'IA a fait de l'usurpation d'identité et des escroqueries financières des menaces plausibles pour les ménages ordinaires, ce qui a déclenché des demandes d'amélioration des mécanismes de recours des victimes et des lois sur la protection de l'identité.

- Demande quasi-universelle de consentement

La question éthique de l'enquête révèle que la communauté hollywoodienne reste divisée au sujet des acteurs synthétiques et des représentations posthumes. La position ferme du public contre la violation des droits individuels est apparue comme le choix "jamais acceptable", qui a reçu le soutien de 62,2 % des participants. Les pouvoirs publics devraient s'appuyer sur ces éléments pour élaborer des lois exigeant le consentement explicite des individus avant de créer des représentations de leur ressemblance générées par l'IA et garantissant une divulgation adéquate de l'étiquetage.

- Le déficit de préparation et les possibilités d'éducation

Bien que le problème soit très préoccupant, 89,5 % des personnes interrogées n'ont pas utilisé d'outils de détection. Le marché présente un potentiel latent car les niveaux d'intérêt dépassent les capacités d'utilisation actuelles, ce qui indique des problèmes de convivialité et de sensibilisation et des doutes quant à l'efficacité. Undetectable AI et d'autres acteurs du secteur doivent créer des processus d'intégration simples tout en ajoutant des outils de détection aux plateformes grand public et en développant des programmes éducatifs qui expliquent la technologie de l'IA au public.

Implications pour les parties prenantes

| Partie prenante | A retenir |

|---|---|

| Actualités et plateformes sociales | Déployer des normes de médias authentifiés (C2PA, provenance W3C) et faire apparaître des badges "origine vérifiée" pour rétablir la confiance du public. |

| Studios de divertissement | Mettre en place des contrats explicites de consentement préalable pour les ressemblances synthétiques et adopter des divulgations à l'écran en cas d'utilisation de l'IA à des fins récréatives. |

| Régulateurs | Faire progresser les projets de loi sur le droit à l'image et sur l'étiquetage des "deepfakes" afin de les aligner sur les attentes du public en matière de consentement. |

| Entreprises et marques | Surveiller de manière proactive l'imagerie de la marque pour détecter les manipulations et former les employés à repérer les contenus suspects. |

| Consommateurs | Recherchez des outils de détection fiables et pratiquez l'hygiène numérique "pause, vérification, partage" avant d'amplifier les médias. |

Commentaires

Nous avons recueilli des réponses supplémentaires auprès des participants à l'enquête concernant leur utilisation d'outils d'IA pour la détection de fausses pistes, qui ont révélé que certains les utilisent déjà et qu'une grande partie des personnes déclarent qu'elles ne les connaissaient pas mais qu'elles souhaitent en savoir plus. Les données complètes de l'enquête sont disponibles sur demande.

Ce rapport est un résumé de nos conclusions complètes, qui sont disponibles sur demande. Cette recherche a été menée en collaboration avec TruthScanune solution de détection des faux et de lutte contre la fraude.

Conclusion

En 2025, les préoccupations relatives aux "deepfakes" se définissent par un paradoxe frappant : la montée en puissance de l'alarme publique se heurte à des mesures de protection minimales. Avec le déclin de la confiance, les organisations sont confrontées à un mandat urgent de vérification, d'étiquetage et d'authentification du contenu numérique.

Utilisation équitable

N'hésitez pas à utiliser ces informations dans un article ou un billet de blog, à condition de nous fournir un lien et une citation. Pour accéder à l'ensemble des données de l'enquête, n'hésitez pas à nous contacter directement.

Pour les demandes de renseignements de la presse ou l'accès aux tableaux croisés complets, contacter [email protected] ou [email protected]