Generatieve AI-tools hebben deepfakes doen evolueren van wetenschappelijk onderzoek tot een groot publiek probleem. Volgens de onderzoeksresultaten van juni 2025 tonen mensen angst voor synthetische media en tegelijkertijd onvermogen om deze te detecteren.

De FBI stelt dat AI deepfake-technologie criminele activiteiten mogelijk maakt via drie belangrijke methoden, waaronder AI-gegenereerde spamberichten, AI-gecreëerde social media persona's en AI-gecodeerde phishing-websites.

Het doel van deze zwendelpraktijken is gericht op zowel zakelijke organisaties als individuele consumenten voor financiële uitbuiting. De combinatie van deepfake technologie met AI resulteerde in meer dan $200 miljoen aan verliezen in de loop van 2025.

De meerderheid van de Amerikanen (85%) heeft het afgelopen jaar het vertrouwen in online informatie verloren door deepfakes en 81% vreest persoonlijke schade door nep audio- en video-inhoud. Meer dan 90% van de gebruikers maakt geen gebruik van detectietools. De gegevens wijzen op een groeiende "vertrouwenskloof" die onmiddellijk ingrijpen vereist van regelgevers, platformbeheerders en technologen.

Belangrijkste bevindingen

| Inzicht | Ondersteunende gegevens |

|---|---|

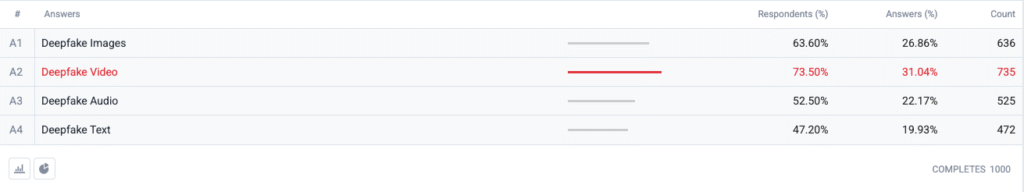

| Deepfake video staat bovenaan de angstindex. | 73,5 % van de respondenten koos deepfake video als formaat waar ze zich "het meest zorgen over maken", gevolgd door afbeeldingen (63,6 %), audio (52,5 %) en tekst (47,2 %). |

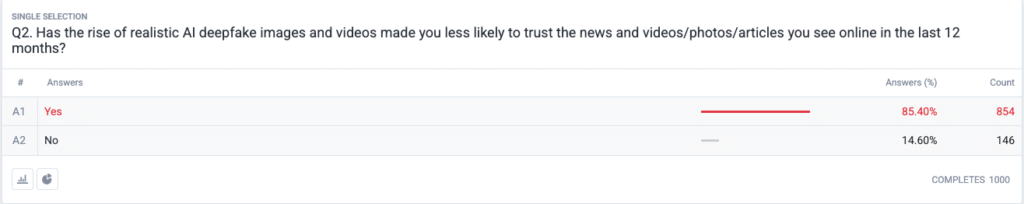

| Er ontvouwt zich een regelrechte vertrouwenscrisis. | 85,4 % geeft aan dat ze de afgelopen 12 maanden minder vertrouwen hebben gekregen in nieuws, foto's of video's online als gevolg van realistische deepfakes. |

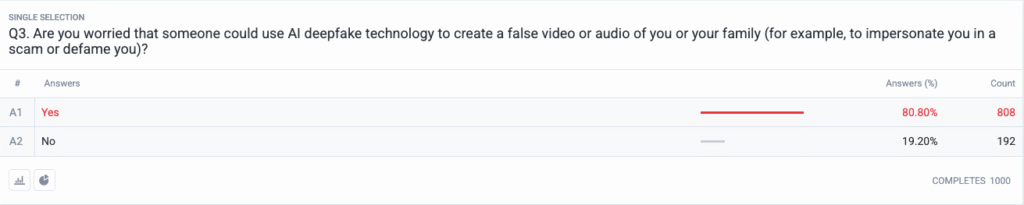

| Persoonlijke bedreiging is mainstream geworden. | 80,8 % vrezen dat scammers of slechte actoren deepfakecontent tegen hen of hun familie kunnen gebruiken. |

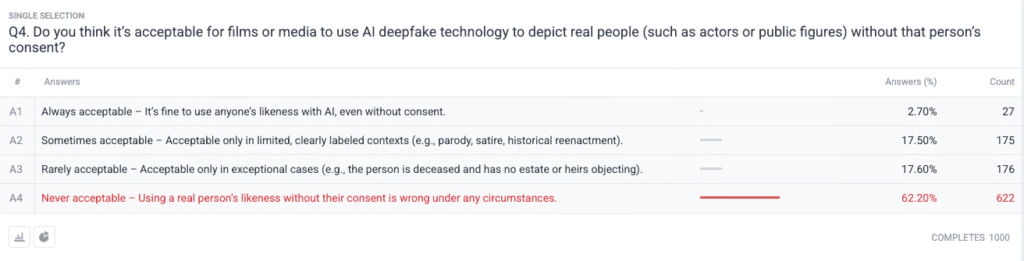

| Sterke morele consensus over toestemming. | 62,2 % zeggen dat het gebruiken van de gelijkenis van een echt persoon zonder toestemming is nooit acceptabel; maar 2.7 % zeggen dat het altijd acceptabel is. |

Methodologie

- Steekproef en veldwerk. We rekruteerden 1.000 Amerikaanse volwassenen met behulp van leeftijds-, geslachts- en regionale quota's die zijn afgestemd op de benchmarks van de Amerikaanse volkstelling. Het veldwerk werd voltooid op 18 juni 2025.

- Opzet van de vraag. Vijf gesloten vragen peilden naar bezorgdheid over verschillende deepfake formats, recente veranderingen in vertrouwen, waargenomen persoonlijk risico, ethische opvattingen over toestemming en eerder gebruik van detectiesoftware.

- Foutmarge. ±3,1 procentpunten op het 95 % betrouwbaarheidsniveau.

- Weging. Weging na stratificatie corrigeerde kleine afwijkingen van nationale demografische gegevens.

Vragen

V1: Over welke vorm van AI Deepfakes maakt u zich de meeste zorgen? (Kies alles wat van toepassing is)

V2: Heeft de opkomst van realistische AI deepfake afbeeldingen en video's ervoor gezorgd dat je het nieuws en de video's/foto's/artikelen die je online ziet de afgelopen 12 maanden minder snel vertrouwt?

V3: Maakt u zich zorgen dat iemand AI deepfake-technologie zou kunnen gebruiken om een valse video of audio van u of uw familie te maken (bijvoorbeeld om u te imiteren in een zwendel of om u te belasteren)?

V4: Vind je het acceptabel dat films of media AI deepfake technologie gebruiken om echte mensen (zoals acteurs of publieke figuren) af te beelden zonder toestemming van die persoon?

Trendanalyse

- Video-angst overtreft andere formaten

In het verleden was video een vertrouwd medium dat mensen geloofden als ze het zagen. Zorgen over synthetische video domineren nu de Amerikaanse gedachten sinds video zijn vertrouwde status heeft verloren. Mensen zijn banger voor video dan voor afbeeldingen met een marge van 10 punten (73,5% vs 63,6%) omdat de beweging van video in combinatie met gesynchroniseerde stem en realistisch uiterlijk hun bezorgdheid versterkt. Media-organisaties zouden strikte verificatieprocedures moeten implementeren voor video-inhoud voordat ze deze vrijgeven aan het publiek.

- Erosie van vertrouwen in informatie

De enorme daling van het 85% vertrouwen onder het publiek toont aan dat er een wijdverspreide twijfel is over elk type digitale inhoud, ongeacht het duidelijke gebrek aan geloofwaardigheid. De "goedkope toespraaktheorie" toont aan hoe gemakkelijk fabricage ervoor heeft gezorgd dat de verificatie van de waarheid de verantwoordelijkheid van de consument is geworden. Publieke figuren, journalisten en beleidsmakers moeten zich voorbereiden op meer controle door te investeren in duidelijke verificatiemethoden (zoals cryptografische watermerken en ondertekende metadata).

Maak je nooit meer zorgen dat AI je sms'jes herkent. Undetectable AI Kan je helpen:

- Laat je AI-ondersteund schrijven verschijnen mensachtig.

- Omleiding alle grote AI-detectietools met slechts één klik.

- Gebruik AI veilig en vol vertrouwen op school en op het werk.

- Deepfakes worden persoonlijk

De meerderheid van de respondenten (85%) ziet zichzelf of hun familieleden als slachtoffer van deepfake-aanvallen. De perceptie van deepfakes als op verkiezingen en beroemdheden gerichte politieke desinformatiemiddelen is in recente cycli verschoven naar persoonlijke bedreigingen. Door de verspreiding van AI-apps voor het klonen van stemmen en het verwisselen van gezichten zijn identiteitsdiefstal en financiële zwendel plausibele bedreigingen geworden voor gewone huishoudens.

- Bijna universele vraag naar toestemming

De ethische vraag van de enquête onthult hoe verdeeld de Hollywoodgemeenschap blijft over synthetische acteurs en postume optredens. Het sterke publieke standpunt tegen het schenden van individuele rechten kwam naar voren als de "nooit aanvaardbare" keuze die steun kreeg van 62,2 procent van de deelnemers. Overheidsfunctionarissen zouden dit bewijs moeten gebruiken om wetten op te stellen die expliciete toestemming van individuen vereisen voor het creëren van door AI gegenereerde gelijkenisrepresentaties en die een goede etikettering garanderen.

- Bereidheidskloof en onderwijskansen

Hoewel er grote bezorgdheid bestaat over dit probleem, heeft 89,5 procent van de respondenten geen detectietools gebruikt. De markt laat een latent potentieel zien, aangezien de belangstelling groter is dan de huidige gebruiksmogelijkheden, wat duidt op bruikbaarheids- en bewustzijnsproblemen en twijfels over de effectiviteit. Undetectable AI moet samen met andere spelers in de sector eenvoudige onboardingprocessen creëren en detectietools toevoegen aan consumentenplatforms en educatieve programma's ontwikkelen die AI-technologie uitleggen aan het publiek.

Implicaties voor belanghebbenden

| Stakeholder | Nuttige afleiding |

|---|---|

| Nieuws & sociale platforms | Gebruik geauthenticeerde media standaarden (C2PA, W3C provenance) en publiceer "origin verified" badges om het vertrouwen van het publiek te herstellen. |

| Entertainment Studio's | Stel expliciete opt-in contracten op voor synthetische beeltenissen en maak op het scherm bekend wanneer gebruik wordt gemaakt van AI-recreatie. |

| Regelaars | Wetsvoorstellen voor het recht op publiciteit en de etikettering van deepfakes bevorderen om ze in overeenstemming te brengen met de verwachtingen van het publiek ten aanzien van toestemming. |

| Bedrijven en merken | Controleer merkbeelden proactief op manipulaties en leer werknemers verdachte inhoud te herkennen. |

| Consumenten | Zoek gerenommeerde opsporingstools en oefen "pauze, verifieer, deel" digitale hygiëne uit voordat je media versterkt. |

Reacties

We hebben aanvullende antwoorden verzameld van deelnemers aan de enquête met betrekking tot hun gebruik van AI-tools voor het detecteren van diepe vervalsingen, waaruit bleek dat sommigen ze al gebruiken en dat een groot deel van de personen zegt dat ze er niet van op de hoogte waren, maar geïnteresseerd zijn in meer informatie. De volledige onderzoeksgegevens zijn op aanvraag beschikbaar.

Dit rapport is een AI-samenvatting van onze volledige bevindingen, die op verzoek verkrijgbaar zijn. Dit onderzoek is uitgevoerd in samenwerking met TruthScan, een oplossing voor deepfake-detectie en fraudebestrijding.

Conclusie

Deepfake zorgen in 2025 worden gedefinieerd door een grimmige paradox: stijgende publieke onrust die gepaard gaat met minimale beschermende maatregelen. Nu het vertrouwen aan het afnemen is, worden organisaties geconfronteerd met een dringende opdracht om digitale inhoud te verifiëren, labelen en authenticeren.

Eerlijk gebruik

Het staat u vrij om deze informatie te gebruiken in een artikel of blogpost, zolang u ons voorziet van een link en een citaat. Als u toegang wilt tot de volledige enquêtegegevens, aarzel dan niet om rechtstreeks contact met ons op te nemen.

Neem voor persvragen of toegang tot de volledige kruistabellen contact op met [email protected] of [email protected]