Narzędzia generatywnej sztucznej inteligencji przekształciły deepfakes z badań naukowych w poważny problem publiczny. Zgodnie z wynikami ankiety z czerwca 2025 r. ludzie wykazują strach przed syntetycznymi mediami, jednocześnie wykazując niezdolność do ich wykrycia.

FBI twierdzi, że technologia AI deepfake umożliwia działalność przestępczą za pomocą trzech głównych metod, które obejmują generowane przez AI wiadomości spamowe i tworzone przez AI personas w mediach społecznościowych oraz kodowane przez AI strony phishingowe.

Celem tych schematów są zarówno organizacje biznesowe, jak i indywidualni konsumenci w celu wykorzystania finansowego. Połączenie technologii deepfake ze sztuczną inteligencją zaowocowało ponad $200 milionów strat w 2025 roku.

Większość Amerykanów (85%) straciła zaufanie do informacji online w ciągu ostatniego roku z powodu deepfake'ów, a 81% obawia się szkód osobistych spowodowanych fałszywymi treściami audio i wideo. Ponad 90% użytkowników nie korzysta z narzędzi wykrywających. Dane te wskazują na rosnącą "lukę zaufania", która wymaga natychmiastowej interwencji ze strony organów regulacyjnych, operatorów platform i technologów.

Kluczowe ustalenia

| Wgląd | Dane pomocnicze |

|---|---|

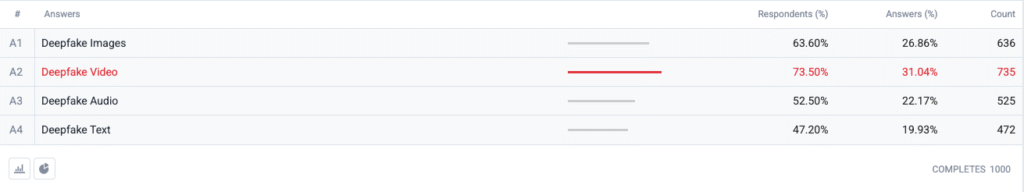

| Wideo Deepfake na szczycie indeksu strachu. | 73,5 % respondentów wybrało deepfake wideo jako format, którego "najbardziej się obawiają", a następnie obrazy (63,6 %), audio (52,5 %) i tekst (47,2 %). |

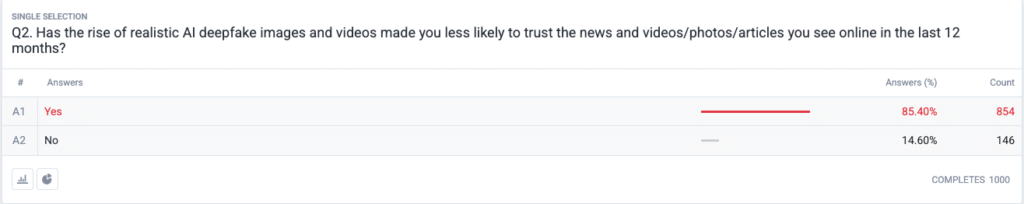

| Rozwija się kryzys zaufania na pełną skalę. | 85,4 % twierdzi, że w ciągu ostatnich 12 miesięcy zmniejszyło się ich zaufanie do wiadomości, zdjęć lub filmów online z powodu realistycznych deepfake'ów. |

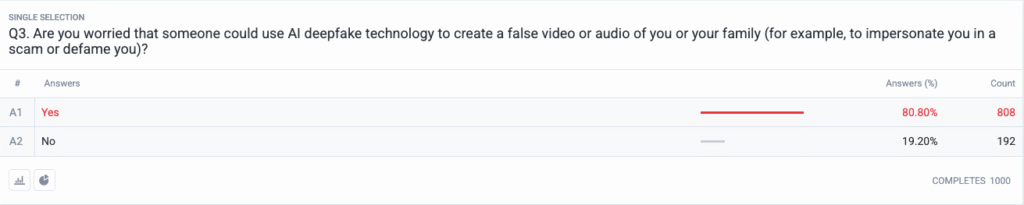

| Groźby osobiste stały się głównym nurtem. | 80,8 % obawia się, że oszuści lub źli aktorzy mogą wykorzystać fałszywe treści przeciwko nim lub ich rodzinie. |

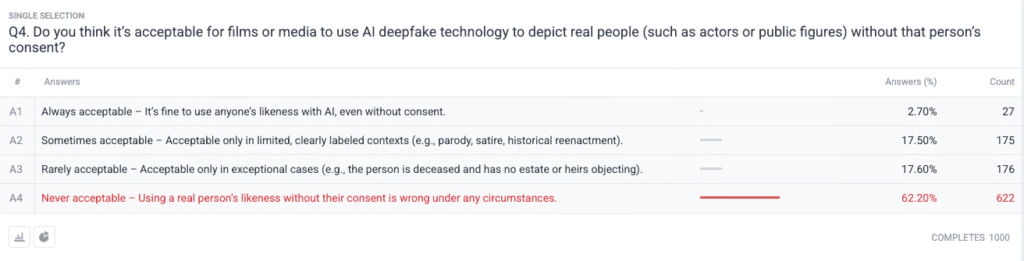

| Silny konsensus moralny w sprawie zgody. | 62.2 % twierdzi, że wykorzystywanie wizerunku prawdziwej osoby bez pozwolenia jest nigdy akceptowalne; tylko 2.7 % twierdzi, że jest to zawsze akceptowalne. |

Metodologia

- Próbka i praca w terenie. Przeprowadziliśmy rekrutację 1000 dorosłych osób w USA przy użyciu kwot wiekowych, płciowych i regionalnych dostosowanych do wzorców spisu ludności USA. Prace terenowe zostały zakończone 18 czerwca 2025 r..

- Projekt pytania. Pięć pytań zamkniętych dotyczyło obaw związanych z różnymi formatami deepfake, ostatnich zmian w zaufaniu, postrzeganego ryzyka osobistego, poglądów etycznych na temat zgody i wcześniejszego korzystania z oprogramowania wykrywającego.

- Margines błędu. ±3,1 punktu procentowego na poziomie ufności 95 %.

- Ważenie. Ważenie po stratyfikacji skorygowało niewielkie odchylenia od krajowych danych demograficznych.

Pytania

P1: Której formy AI Deepfakes obawiasz się najbardziej? (Wybierz wszystkie, które mają zastosowanie)

P2: Czy pojawienie się realistycznych obrazów i filmów deepfake ze sztuczną inteligencją sprawiło, że mniej ufasz wiadomościom i filmom/zdjęciom/artykułom, które oglądasz online w ciągu ostatnich 12 miesięcy?

P3: Czy obawiasz się, że ktoś mógłby wykorzystać technologię AI deepfake do stworzenia fałszywego nagrania wideo lub audio przedstawiającego ciebie lub twoją rodzinę (na przykład w celu podszycia się pod ciebie w oszustwie lub zniesławienia cię)?

P4: Czy uważasz, że dopuszczalne jest, aby filmy lub media wykorzystywały technologię AI deepfake do przedstawiania prawdziwych osób (takich jak aktorzy lub osoby publiczne) bez ich zgody?

Analiza trendów

- Lęk przed wideo przewyższa inne formaty

W przeszłości wideo było zaufanym medium, któremu ludzie wierzyli, gdy je widzieli. Odkąd wideo straciło swój zaufany status, w umysłach Amerykanów dominują obecnie obawy związane z syntetycznymi materiałami wideo. Ludzie obawiają się wideo bardziej niż obrazów o 10 punktów procentowych (73,5% vs 63,6%), ponieważ ruch wideo w połączeniu ze zsynchronizowanym głosem i realistycznym wyglądem potęguje ich obawy. Organizacje medialne powinny wdrożyć ścisłe procedury uwierzytelniania treści wideo przed ich publicznym udostępnieniem.

- Erozja zaufania do informacji

Ogromny 85% spadek poziomu zaufania wśród społeczeństwa pokazuje powszechne wątpliwości co do każdego rodzaju treści cyfrowych, niezależnie od ich oczywistego braku wiarygodności. Teoria "taniej mowy" pokazuje, jak łatwa fabrykacja sprawiła, że weryfikacja prawdy stała się obowiązkiem konsumenta. Osoby publiczne i dziennikarze wraz z decydentami muszą przygotować się na wzmożony monitoring, inwestując w jasne metody weryfikacji (takie jak kryptograficzne znaki wodne i podpisane metadane).

Nigdy więcej nie martw się, że sztuczna inteligencja wykryje twoje teksty. Undetectable AI Może ci pomóc:

- Spraw, by pisanie wspomagane przez sztuczną inteligencję wyglądało podobny do człowieka.

- Obejście wszystkie główne narzędzia do wykrywania AI za pomocą jednego kliknięcia.

- Użycie AI bezpiecznie i pewnie w szkole i pracy.

- Deepfakes stają się osobiste

Większość respondentów (85%) wyobraża sobie, że oni sami lub członkowie ich rodzin staną się ofiarami ataków typu deepfake. Postrzeganie deepfake'ów jako narzędzi dezinformacji politycznej skoncentrowanych na wyborach i celebrytach zmieniło się w ostatnich cyklach na zagrożenia osobiste. Rozprzestrzenianie się klonowania głosu za pomocą sztucznej inteligencji i aplikacji do zamiany twarzy sprawiło, że kradzież tożsamości i oszustwa finansowe stały się realnym zagrożeniem dla zwykłych gospodarstw domowych, co wywołało żądania ulepszenia mechanizmów dochodzenia roszczeń przez ofiary i przepisów dotyczących ochrony tożsamości.

- Niemal powszechne żądanie zgody

Pytanie etyczne ankiety ujawnia, jak społeczność Hollywood pozostaje podzielona w kwestii syntetycznych aktorów i pośmiertnych występów. Zdecydowane stanowisko opinii publicznej przeciwko naruszaniu praw jednostki okazało się wyborem "nigdy nie do przyjęcia", który uzyskał poparcie 62,2% uczestników. Urzędnicy państwowi powinni wykorzystać te dowody do stworzenia przepisów, które wymagają wyraźnej zgody osób fizycznych przed utworzeniem reprezentacji podobieństwa generowanych przez sztuczną inteligencję i zapewnić odpowiednie ujawnianie etykiet.

- Luka w gotowości i możliwości edukacyjne

Mimo głębokiego zaniepokojenia tą kwestią, 89,5% respondentów nie korzystało z narzędzi wykrywających. Rynek wykazuje ukryty potencjał, ponieważ poziom zainteresowania przekracza obecne możliwości użytkowania, co wskazuje na kwestie użyteczności i świadomości oraz wątpliwości co do skuteczności. Undetectable AI wraz z innymi graczami z branży musi stworzyć proste procesy wdrażania, dodając narzędzia wykrywające do platform konsumenckich i opracowując programy edukacyjne, które wyjaśniają technologię AI społeczeństwu.

Implikacje dla interesariuszy

| Interesariusz | Działanie na wynos |

|---|---|

| Wiadomości i platformy społecznościowe | Wdrażanie standardów uwierzytelnionych mediów (C2PA, W3C provenance) i identyfikatorów "origin verified" w celu odbudowania zaufania odbiorców. |

| Entertainment Studios | Wprowadzenie wyraźnych umów opt-in dla syntetycznych podobieństw i przyjęcie ujawnień na ekranie, gdy używana jest sztuczna inteligencja. |

| Regulatory | Przyspieszenie prac nad ustawami dotyczącymi prawa do publikacji i etykietowania deepfake, aby dostosować je do oczekiwań dotyczących zgody publicznej. |

| Firmy i marki | Proaktywnie monitoruj obrazy marki pod kątem manipulacji i edukuj pracowników w zakresie wykrywania podejrzanych treści. |

| Konsumenci | Poszukaj renomowanych narzędzi do wykrywania i praktykuj higienę cyfrową "wstrzymaj, zweryfikuj, udostępnij" przed wzmocnieniem mediów. |

Komentarze

Zebraliśmy dodatkowe odpowiedzi od uczestników ankiety dotyczące korzystania przez nich z narzędzi AI do głębokiego wykrywania fałszywych danych, które ujawniły, że niektórzy już z nich korzystają, a duża część osób twierdzi, że nie wiedziała o nich, ale jest zainteresowana dowiedzeniem się więcej. Pełne dane z ankiety są dostępne na życzenie.

Niniejszy raport stanowi podsumowanie naszych pełnych ustaleń, które są dostępne na żądanie. Badanie zostało przeprowadzone we współpracy z TruthScan, rozwiązanie do głębokiego wykrywania podróbek i przeciwdziałania oszustwom.

Wnioski

Obawy związane z deepfake w 2025 r. są definiowane przez wyraźny paradoks: rosnący alarm społeczny przecinający się z minimalnymi działaniami ochronnymi. W obliczu fundamentalnego spadku zaufania organizacje stają przed pilnym zadaniem weryfikacji, oznaczania i uwierzytelniania treści cyfrowych.

Dozwolony użytek

Zachęcamy do wykorzystania tych informacji w artykule lub wpisie na blogu, o ile podasz nam link i cytat. Aby uzyskać dostęp do pełnego zestawu danych ankiety, skontaktuj się z nami bezpośrednio.

W przypadku zapytań prasowych lub dostępu do pełnych tabel krzyżowych, skontaktuj się z [email protected] lub [email protected]