As ferramentas de IA generativa transformaram as falsificações profundas (deepfakes) de investigação científica numa grande preocupação pública. De acordo com os resultados do inquérito de junho de 2025, as pessoas mostram receio em relação aos meios de comunicação sintéticos e, simultaneamente, demonstram incapacidade para os detetar.

O FBI afirma que a tecnologia deepfake de IA permite actividades criminosas através de três métodos principais, que incluem mensagens de spam geradas por IA, personas de redes sociais criadas por IA e sítios Web de phishing codificados por IA.

O objetivo destes esquemas é a exploração financeira tanto de organizações empresariais como de consumidores individuais. A combinação da tecnologia deepfake com a IA resultou em mais de $200 milhões de euros de perdas durante 2025.

A maioria dos americanos (85%) perdeu a confiança nas informações em linha durante o ano passado devido aos deepfakes e 81% receiam sofrer danos pessoais devido a conteúdos áudio e vídeo falsos. Mais de 90% dos utilizadores não utilizam ferramentas de deteção. Os dados indicam um "défice de confiança" crescente que exige uma intervenção imediata dos reguladores e dos operadores e tecnólogos das plataformas.

Principais conclusões

| Visão | Dados de apoio |

|---|---|

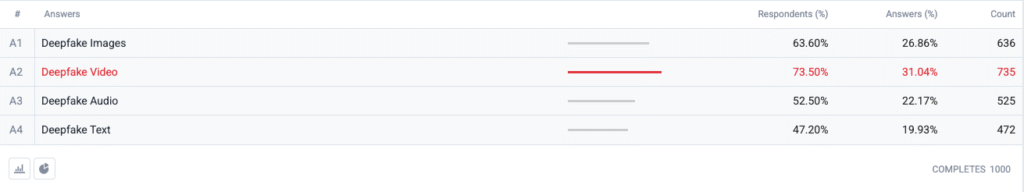

| O vídeo Deepfake está no topo do índice de medo. | 73,5 % dos inquiridos escolheram o vídeo deepfake como o formato que os "preocupa mais", seguido das imagens (63,6 %), do áudio (52,5 %) e do texto (47,2 %). |

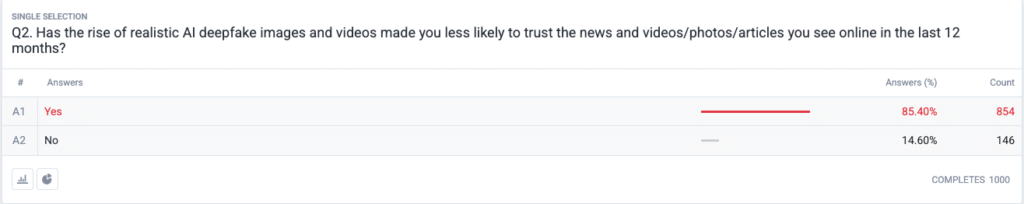

| Está a desenrolar-se uma verdadeira crise de confiança. | 85,4 % afirmam que passaram a confiar menos em notícias, fotografias ou vídeos em linha nos últimos 12 meses devido a deepfakes realistas. |

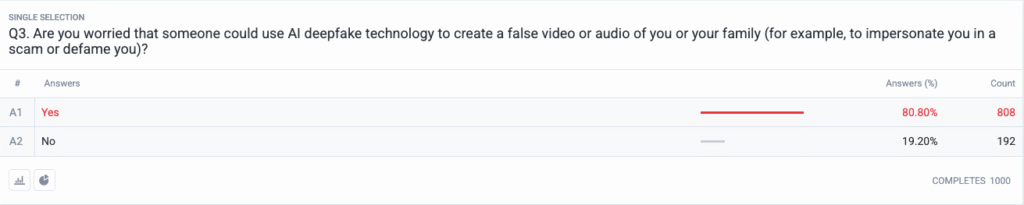

| As ameaças pessoais tornaram-se comuns. | 80,8 % receiam que os burlões ou os maus actores possam utilizar conteúdos deepfake como arma contra eles ou a sua família. |

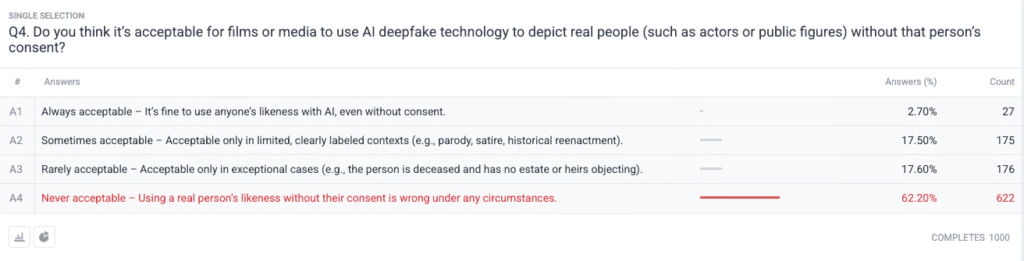

| Forte consenso moral sobre o consentimento. | 62.2 % afirma que utilizar a imagem de uma pessoa real sem autorização é nunca aceitável; apenas 2.7 % dizem que é sempre aceitável. |

Metodologia

- Amostra e trabalho de campo. Recrutámos 1.000 adultos dos EUA utilizando quotas por idade, género e região alinhadas com os parâmetros de referência dos Censos dos EUA. O trabalho de campo foi concluído em 18 de junho de 2025.

- Conceção da pergunta. Cinco perguntas fechadas avaliaram a preocupação com diferentes formatos de deepfake, mudanças recentes na confiança, perceção de risco pessoal, pontos de vista éticos sobre o consentimento e utilização prévia de software de deteção.

- Margem de erro. ±3,1 pontos percentuais ao nível de confiança de 95 %.

- Ponderação. A ponderação pós-estratificação corrigiu pequenos desvios em relação aos dados demográficos nacionais.

Perguntas

Q1: Com que forma de IA Deepfakes está mais preocupado? (Escolha todos os que se aplicam)

Q2: Nos últimos 12 meses, o aumento de imagens e vídeos realistas de IA deepfake tornou menos provável que confie nas notícias e vídeos/fotos/artigos que vê em linha?

Q3: Preocupa-o que alguém possa utilizar a tecnologia deepfake da IA para criar um vídeo ou áudio falso de si ou da sua família (por exemplo, para se fazer passar por si numa burla ou difamá-lo)?

P4: Considera aceitável que os filmes ou os meios de comunicação social utilizem a tecnologia deepfake da IA para representar pessoas reais (como actores ou figuras públicas) sem o consentimento dessas pessoas?

Análise de tendências

- A ansiedade do vídeo ultrapassa a de outros formatos

No passado, o vídeo era um meio de comunicação fiável em que as pessoas acreditavam quando o viam. Atualmente, as preocupações com o vídeo sintético dominam as mentes dos americanos, uma vez que o vídeo perdeu o seu estatuto de confiança. As pessoas temem o vídeo mais do que as imagens por uma margem de 10 pontos (73,5% vs 63,6%) porque o movimento do vídeo combinado com a voz sincronizada e a aparência realista intensifica as suas preocupações. As organizações de media devem implementar procedimentos de autenticação rigorosos para o conteúdo de vídeo antes de o divulgarem ao público.

- Erosão da confiança na informação

A queda maciça dos níveis de confiança entre o público demonstra uma dúvida generalizada sobre todo o tipo de conteúdos digitais, independentemente da sua óbvia falta de credibilidade. A teoria do "discurso barato" demonstra como a facilidade de fabrico fez com que a verificação da verdade se tornasse responsabilidade do consumidor. As figuras públicas e os jornalistas, juntamente com os decisores políticos, têm de se preparar para uma maior monitorização, investindo em métodos de verificação claros (como marcas de água criptográficas e metadados assinados).

Nunca mais se preocupe com o facto de a IA detetar os seus textos. Undetectable AI Pode ajudar-vos:

- Faça aparecer a sua escrita assistida por IA de tipo humano.

- Bypass todas as principais ferramentas de deteção de IA com apenas um clique.

- Utilização IA com segurança e com confiança na escola e no trabalho.

- Os deepfakes tornam-se pessoais

A maioria dos inquiridos (85%) prevê que eles próprios ou os seus familiares sejam vítimas de ataques de deepfake. A perceção dos deepfakes como ferramentas de desinformação política focadas em eleições e celebridades mudou para incluir ameaças pessoais nos últimos ciclos. A disseminação de aplicações de IA de clonagem de voz e de troca de rostos tornou o roubo de identidade e as fraudes financeiras ameaças plausíveis para as famílias comuns, o que desencadeou a exigência de melhores mecanismos de recurso das vítimas e de leis de proteção da identidade.

- Exigência quase universal de consentimento

A pergunta ética do inquérito revela como a comunidade de Hollywood continua dividida em relação aos actores sintéticos e às actuações póstumas. A forte posição do público contra a violação dos direitos individuais surgiu como a escolha "nunca aceitável" que recebeu o apoio de 62,2% dos participantes. Os funcionários públicos devem utilizar estas provas para criar leis que exijam o consentimento explícito dos indivíduos antes de criar representações semelhantes geradas por IA e garantir a divulgação adequada da rotulagem.

- Lacuna de preparação e oportunidade de educação

Embora exista uma grande preocupação com esta questão, 89,5% dos inquiridos não utilizaram ferramentas de deteção. O mercado apresenta um potencial latente, uma vez que os níveis de interesse excedem as capacidades de utilização actuais, o que indica problemas de utilização e sensibilização e dúvidas quanto à eficácia. A IA indetetável, juntamente com outros intervenientes do sector, deve criar processos de integração simples, acrescentando ferramentas de deteção às plataformas dos consumidores e desenvolvendo programas educativos que expliquem a tecnologia de IA ao público.

Implicações para as partes interessadas

| Partes interessadas | Conclusões práticas |

|---|---|

| Notícias e plataformas sociais | Aplicar normas de meios de comunicação social autenticados (C2PA, proveniência W3C) e colocar à superfície emblemas de "origem verificada" para restabelecer a confiança do público. |

| Estúdios de entretenimento | Instituir contratos explícitos de adesão para as semelhanças sintéticas e adotar a divulgação no ecrã quando é utilizada a recriação por IA. |

| Reguladores | Avançar com os projectos de lei sobre o direito de publicidade e a rotulagem de "deepfake" para os alinhar com as expectativas de consentimento do público. |

| Empresas e marcas | Monitorizar proactivamente as imagens da marca para detetar manipulações e ensinar os funcionários a identificar conteúdos suspeitos. |

| Consumidores | Procurar ferramentas de deteção respeitáveis e praticar a higiene digital "pausar, verificar, partilhar" antes de amplificar os meios de comunicação social. |

Comentários

Recolhemos respostas adicionais dos participantes no inquérito relacionadas com a sua utilização de ferramentas de deteção de falsificações profundas com IA, que revelaram que alguns já as utilizam e que uma grande parte dos indivíduos afirma que não as conhecia, mas que está interessada em saber mais. Os dados completos do inquérito estão disponíveis mediante pedido.

Este relatório é um resumo da IA das nossas conclusões completas, que estão disponíveis mediante pedido. Esta investigação foi efectuada em colaboração com TruthScanuma solução de deteção de deepfake e de combate à fraude.

Conclusão

As preocupações com o Deepfake em 2025 são definidas por um paradoxo gritante: alarme público crescente que se cruza com uma ação de proteção mínima. Com a confiança em declínio fundamental, as organizações enfrentam um mandato urgente para verificar, rotular e autenticar o conteúdo digital.

Utilização justa

Não hesite em utilizar estas informações num artigo ou publicação de blogue, desde que nos forneça uma hiperligação e uma citação. Para aceder ao conjunto completo de dados do inquérito, não hesite em contactar-nos diretamente.

Para questões relacionadas com a imprensa ou para aceder às tabelas cruzadas completas, contactar [email protected] ou [email protected]