Generativa AI-verktyg har utvecklat deepfakes från vetenskaplig forskning till en stor allmän angelägenhet. Människor visar rädsla för syntetiska medier samtidigt som de visar oförmåga att upptäcka dem enligt undersökningsresultaten från juni 2025.

FBI uppger att AI deepfake-teknik möjliggör kriminell verksamhet genom tre huvudsakliga metoder som inkluderar AI-genererade skräppostmeddelanden och AI-skapade personas i sociala medier och AI-kodade nätfiskewebbplatser.

Målet med dessa bedrägerier är att både företag och enskilda konsumenter ska utnyttjas ekonomiskt. Kombinationen av deepfake-teknik med AI resulterade i mer än $200 miljoner i förluster under 2025.

Majoriteten av amerikanerna (85%) har förlorat förtroendet för information på nätet under det senaste året på grund av deepfakes och 81% fruktar personlig skada från falskt ljud- och videoinnehåll. Mer än 90% av användarna misslyckas med att använda detekteringsverktyg. Uppgifterna tyder på ett ökande "förtroendegap" som kräver omedelbara åtgärder från tillsynsmyndigheter, plattformsoperatörer och tekniker.

Viktiga slutsatser

| Insikt | Stödjande data |

|---|---|

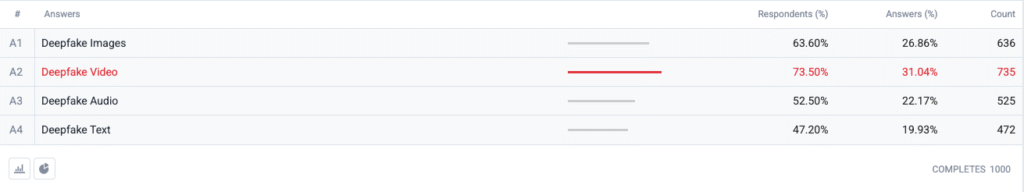

| Deepfake-videon toppar rädsloindexet. | 73,5 % av respondenterna valde deepfake-video som ett format de är "mest oroliga för", följt av bilder (63,6 %), ljud (52,5 %) och text (47,2 %). |

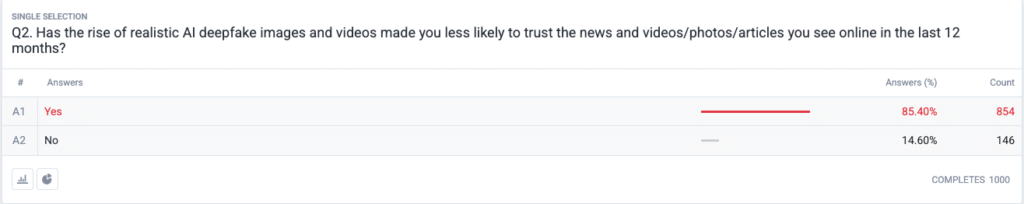

| En fullskalig förtroendekris håller på att utvecklas. | 85,4 % uppger att de har blivit mindre benägna att lita på nyheter, foton eller videor på nätet under de senaste 12 månaderna på grund av realistiska deepfakes. |

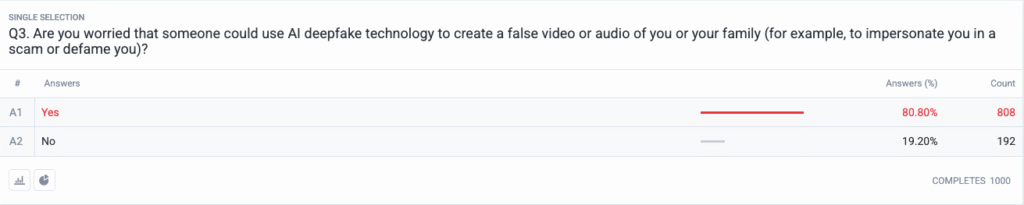

| Personliga hot har blivit mainstream. | 80,8 % oroar sig för att bedragare eller dåliga aktörer kan använda deepfake-innehåll som vapen mot dem eller deras familj. |

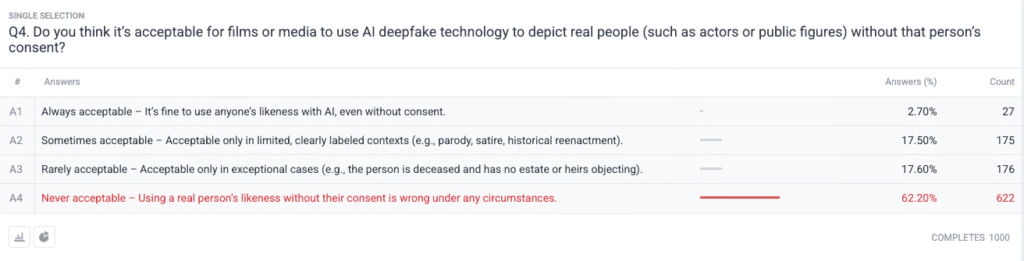

| Stark moralisk konsensus om samtycke. | 62,2 % säger att det är olagligt att använda en verklig persons bild utan tillstånd aldrig acceptabelt; bara 2.7 % säger att det alltid är acceptabelt. |

Metodik

- Provtagning och fältarbete. Vi rekryterade 1.000 vuxna i USA med hjälp av ålders-, köns- och regionkvoter i linje med US Census riktmärken. Fältarbetet slutfördes den 18 juni 2025.

- Fråga Design. Fem slutna frågor mätte oro för olika deepfake-format, nyligen inträffade förändringar i förtroendet, upplevd personlig risk, etisk syn på samtycke och tidigare användning av detekteringsprogramvara.

- Felmarginal. ±3,1 procentenheter vid en konfidensnivå på 95 %.

- Viktning. Viktning efter stratifiering korrigerade mindre avvikelser från den nationella demografin.

Frågor och svar

Q1: Vilken form av AI Deepfakes är du mest orolig för? (Välj alla som är tillämpliga)

Q2: Har ökningen av realistiska AI deepfake-bilder och videor gjort dig mindre benägen att lita på nyheter och videor/foton/artiklar som du ser på nätet under de senaste 12 månaderna?

F3: Är du orolig för att någon kan använda AI deepfake-teknik för att skapa en falsk video eller ett falskt ljud av dig eller din familj (till exempel för att utge sig för att vara dig i ett bedrägeri eller förtala dig)?

Fråga 4: Tycker du att det är acceptabelt att filmer eller media använder AI deepfake-teknik för att avbilda verkliga personer (t.ex. skådespelare eller offentliga personer) utan personens samtycke?

Trendanalys

- Videoångest överträffar andra format

Förr i tiden var video ett pålitligt medium som folk trodde på när de såg det. Syntetiska videoproblem dominerar nu amerikanska sinnen sedan video förlorat sin pålitliga status. Människor fruktar video mer än bilder med en 10-punkters marginal (73,5% vs 63,6%) eftersom videons rörelse i kombination med synkroniserad röst och realistiskt utseende intensifierar deras oro. Medieorganisationer bör införa strikta autentiseringsförfaranden för videoinnehåll innan de släpper det till allmänheten.

- Erosion av förtroendet för information

Den massiva 85% minskningen av förtroendenivåer bland allmänheten visar på ett utbrett tvivel på alla typer av digitalt innehåll oavsett dess uppenbara brist på trovärdighet. Teorin om "billigt tal" visar hur enkelt det är att fabricera information och hur konsumentens ansvar har blivit att verifiera sanningshalten. Offentliga personer och journalister samt beslutsfattare måste förbereda sig för ökad övervakning genom att investera i tydliga verifieringsmetoder (t.ex. kryptografiska vattenstämplar och signerade metadata).

Oroa dig aldrig för att AI upptäcker dina texter igen. Undetectable AI Kan hjälpa dig:

- Få din AI-assisterade skrivning att synas människoliknande.

- Bypass alla större AI-detekteringsverktyg med bara ett klick.

- Användning AI säkert och självsäkert i skolan och på jobbet.

- Deepfakes blir personliga

Majoriteten av respondenterna (85%) föreställer sig att de själva eller deras familjemedlemmar blir offer för deepfake-attacker. Uppfattningen om deepfakes som val- och kändisfokuserade politiska desinformationsverktyg har skiftat till att omfatta personliga hot under de senaste cyklerna. Spridningen av AI-appar för röstkloning och ansiktsbyten har gjort identitetsstöld och ekonomiska bedrägerier till rimliga hot för vanliga hushåll, vilket har lett till krav på förbättrade mekanismer för ersättning till brottsoffer och lagar om identitetsskydd.

- Nästan universell efterfrågan på samtycke

Undersökningens etiska fråga avslöjar hur Hollywood-gemenskapen fortfarande är splittrad när det gäller syntetiska skådespelare och postuma framträdanden. Allmänhetens starka ställningstagande mot intrång i individuella rättigheter framstod som det "aldrig acceptabla" valet som fick stöd av 62,2 procent av deltagarna. Offentliga tjänstemän bör använda dessa bevis för att skapa lagar som kräver uttryckligt samtycke från individer innan de skapar AI-genererade liknelser och säkerställa korrekt märkning.

- Förberedelsegap och utbildningsmöjligheter

Trots att frågan är mycket angelägen har 89,5% av de tillfrågade inte använt några detekteringsverktyg. Marknaden har en latent potential eftersom intresset är större än den nuvarande användningsmöjligheten, vilket tyder på problem med användbarhet och medvetenhet samt tvivel på effektiviteten. Undetectable AI måste tillsammans med andra branschaktörer skapa enkla onboarding-processer och samtidigt lägga till detekteringsverktyg i konsumentplattformar och utveckla utbildningsprogram som förklarar AI-teknik för allmänheten.

Konsekvenser för intressenter

| Intressent | Handlingsinriktad takeaway |

|---|---|

| Nyheter & sociala plattformar | Använd standarder för autentiserade medier (C2PA, W3C-proveniens) och "ursprungsverifierade" märken för att återuppbygga publikens förtroende. |

| Entertainment Studios | Inrätta uttryckliga opt-in-avtal för syntetiska liknelser och införa information på skärmen när AI-återskapande används. |

| Tillsynsmyndigheter | Förbättra lagförslagen om rätt till publicitet och deepfake-märkning för att anpassa dem till förväntningarna på allmänhetens samtycke. |

| Företag & varumärken | Övervaka proaktivt varumärkesbilder för att upptäcka manipulationer och utbilda anställda i hur man upptäcker misstänkt innehåll. |

| Konsumenter | Leta efter välrenommerade verktyg för upptäckt och tillämpa "pausa, verifiera, dela" digital hygien innan du förstärker medier. |

Kommentarer

Vi samlade in ytterligare svar från deltagarna i undersökningen om deras användning av AI-verktyg för att upptäcka djupa bedrägerier, vilket visade att vissa redan använder dem och att en stor del av deltagarna säger att de inte kände till dem men är intresserade av att lära sig mer. Fullständiga undersökningsdata finns tillgängliga på begäran.

Denna rapport är en AI-sammanfattning av våra fullständiga resultat, som finns tillgängliga på begäran. Denna forskning genomfördes i samarbete med TruthScan, en lösning för deepfake-detektering och anti-ai-bedrägeri.

Slutsats

Deepfake-problematiken år 2025 präglas av en stark paradox: skyhöga larm från allmänheten som korsas av minimala skyddsåtgärder. Eftersom förtroendet är på väg att minska står organisationer inför ett brådskande uppdrag att verifiera, märka och autentisera digitalt innehåll.

Rättvis användning

Du får gärna använda denna information i en artikel eller ett blogginlägg, så länge du ger oss en länk och referens. Om du vill ha tillgång till hela undersökningsdatasetet, tveka inte att kontakta oss direkt.

För pressförfrågningar eller tillgång till fullständiga jämförelsetabeller, kontakta [email protected] eller [email protected]