Es gibt eine Sache, die seit ein paar Jahren in aller Munde ist: ChatGPT.

Lehrerinnen und Lehrer die Sorge, dass sie die Hausaufgaben der Schüler schreibt.

Schriftsteller befürchten, dass KI an ihrer Stelle Bücher und Geschichten schreiben könnte.

Kodierer haben Angst, dass sie Websites und Anwendungen besser erstellen können als Menschen.

Einige sagen sogar voraus, dass Millionen von Arbeitsplätzen könnten verschwinden wegen der KI.

Wir haben alle schon davon gehört. Aber haben Sie sich jemals gefragt wie ChatGPT funktioniert?

Wie schreibt ChatGPT die Hausaufgaben eines Kindes? Was passiert hinter den Kulissen, wenn man eine Frage eintippt und es antwortet wie ein echter Mensch?

Wie kann eine Maschine Gedichte, Geschichten und Codes schreiben, obwohl sie Wörter nicht so versteht wie wir?

In diesem Blog, wir werden einen Blick ins Innere werfen ChatGPT und erklären, was ChatGPT ist und wie es funktioniert, Schritt für Schritt.

Sie werden lernen, wie es sich Dinge merkt, wo seine Grenzen liegen und wie solche Werkzeuge überhaupt gebaut werden.

Fangen wir an!

Die Grundlage: GPT-Sprachmodelle

ChatGPT ist eine KI, die wie ein Mensch versteht und schreibt.

Man nennt es einen Sprachmodell denn es arbeitet mit Sprache - es liest sie, sagt sie voraus und erzeugt sie.

Aber es versteht nicht wie die Menschen. Es denkt nicht. Es kennt keine Fakten. Es schaut nur auf Muster.

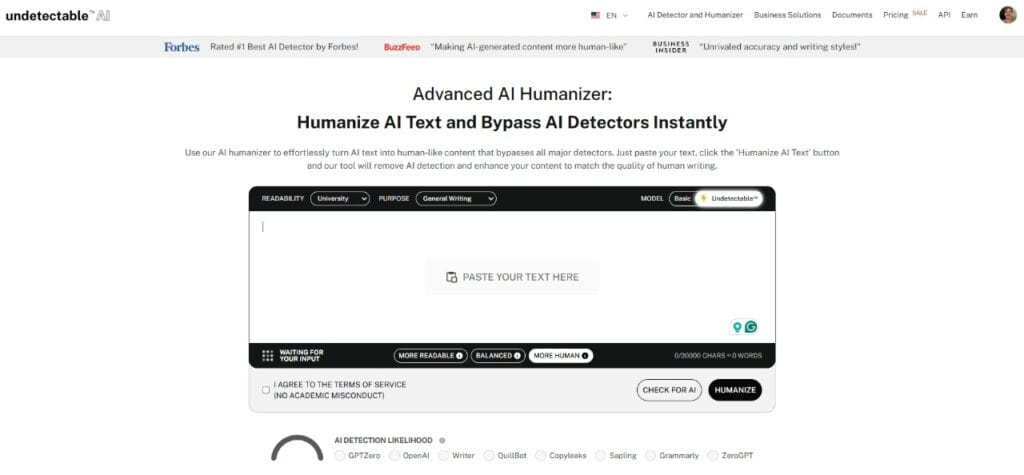

Machen Sie sich nie wieder Sorgen, dass KI Ihre Texte erkennt. Undetectable AI Kann Ihnen helfen:

- Lassen Sie Ihr AI-unterstütztes Schreiben erscheinen menschenähnlich.

- Bypass alle wichtigen KI-Erkennungstools mit nur einem Klick.

- Verwenden Sie AI sicher und zuversichtlich in Schule und Beruf.

Zum Beispiel,

- Wenn Sie tippen, "Der Himmel ist..."

- Es könnte heißen "blau".

Nicht weil es weiß, dass der Himmel blau ist, sondern weil es diesen Satz in der Ausbildung millionenfach gesehen hat. Es hat gelernt, dass "blau" oft nach "der Himmel ist" kommt.

Diese Art von KI wird als LLMdie für Großes Sprachmodell.

Es wurde anhand von tonnenweise Lehrbüchern, Websites und mehr trainiert, um herauszufinden, wie Menschen Wörter verwenden. Aber er liest nicht nach der Bedeutung. Er lernt, wie Wörter normalerweise nebeneinander stehen.

GPT ist eine besondere Art von LLM.

GPT steht für "Generative Pre-trained Transformer".

- Generativ - kann er neuen Text erstellen.

- Vorgeschult - Es muss lernen, bevor es mit Ihnen spricht.

- Transformator - die Schlüsseltechnologie, die hinter der Funktionsweise von ChatGPT steht und dabei hilft zu verstehen, wie Wörter in einem Satz, einem Absatz oder sogar einem Gespräch miteinander in Beziehung stehen.

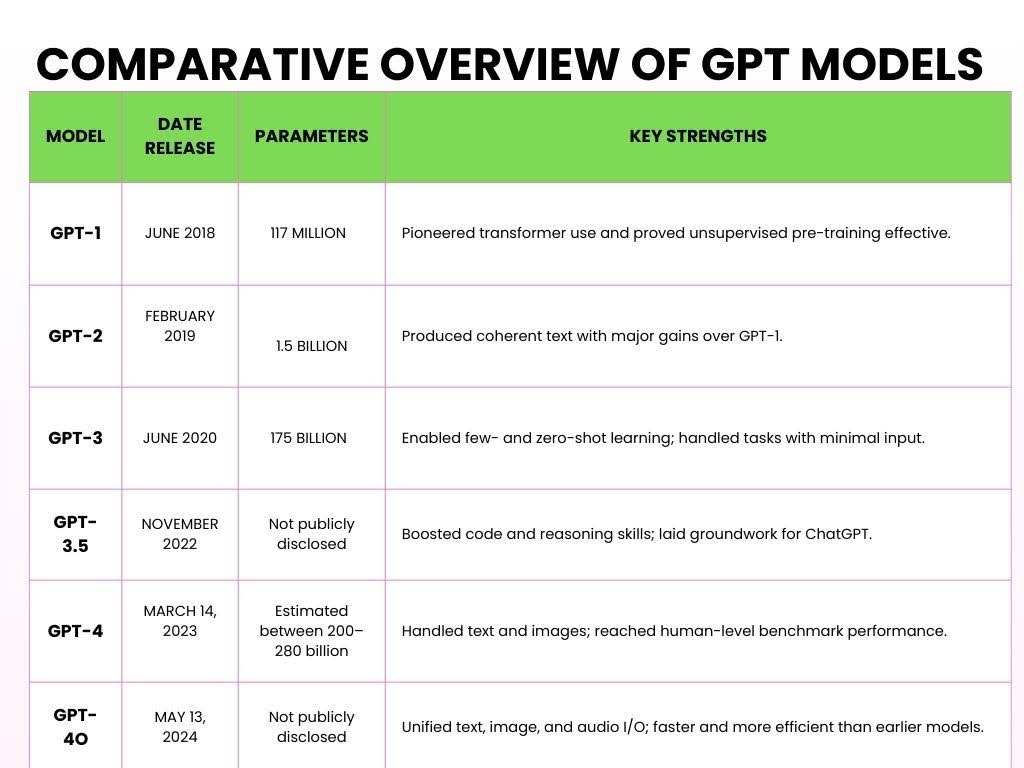

Hier sind die verschiedenen Versionen von GPT, die im Laufe der Jahre eingeführt wurden.

Wie ChatGPT funktioniert

Hier ist eine vereinfachte Aufschlüsselung, wie ChatGPT funktioniert und Ihre Eingaben in fünf Schritten verarbeitet.

- Schritt 1: Pretraining auf massiven Daten

Große Sprachmodelle (LLMs) wie ChatGPT werden durch die Verarbeitung riesiger Textmengen aus dem Internet vortrainiert, um Sprachmuster zu lernen.

Während des Vortrainings verarbeitet das Modell Billionen von Token (kleine Textstücke).

A Token kann ein Wort, ein Teil eines Wortes oder sogar eine Interpunktion sein, je nachdem, wie das Modell die Eingabe tokenisiert.

Zum Beispiel,

Sie stellen ChatGPT eine mathematische Frage, wie zum Beispiel:

Problem:

- 2 + 3 = ?

Während des Trainings liest ChatGPT Hunderte von Milliarden von Wörtern aus Büchern, Nachrichten, Artikeln, Wikipedia, Geschichten, wissenschaftlichen Artikeln und sogar Reddit-Threads.

Diese Ausbildung und das Lesen helfen ihm zu verstehen, wie Addition funktioniert.

Zum Beispiel,

Sie könnte die Kommutativ-Eigenschaft (d. h. 2 + 3 = 3 + 2) durch solche Zusammenhänge.

ChatGPT sieht viele Beispiele wie

- "2 + 3 = 5,"

- "7 + 8 = 15,"

- "9 + 4 = 13."

Es lernt nicht nur diese spezifischen Beispiele, sondern das Muster der Addition.

Es versteht, wie Zahlen mit dem "+"-Symbol interagieren und wie das Ergebnis typischerweise auf das "="-Symbol folgt.

- Schritt 2: Die Transformer-Architektur

Nachdem ChatGPT eine riesige Menge an Wörtern gesehen hatte, brauchte es ein Gehirn, das all diese Informationen sinnvoll verarbeiten konnte. Dieses Gehirn der KI heißt "Transformer".

Was den Transformer auszeichnet, ist seine Fähigkeit Aufmerksamkeit fokussieren auf die wichtigsten Teile des Inputs, ähnlich wie wir Sprache verarbeiten.

Zum Beispiel,

Wenden wir dies auf ein mathematisches Problem an:

- "Was ist die Summe von 5 und 7?"

Bei der Bearbeitung geht der Transformer nicht nur Wort für Wort vor.

Stattdessen wird der gesamte Kontext betrachtet - "Summe", "5" und "7" - und zwar auf einmal.

Sie erkennt an, dass "Summe" bezieht sich auf "Zusatz" und dass "5" und "7" die beteiligten Zahlen sind.

Der Transformer gibt dann mehr "Aufmerksamkeit" auf die Wörter, die sich direkt auf die Antwort auswirken, und konzentriert sich daher auf die Operation ("Summe") und die Zahlen ("5" und "7").

Dies ist ein wesentlicher Bestandteil der Funktionsweise von ChatGPT - es bearbeitet das Problem nicht linear, sondern so, dass es die Beziehung zwischen den Elementen besser versteht.

Diese Fähigkeit, alles im Zusammenhang zu betrachten, macht den Transformer so leistungsfähig.

Anstatt nur herauszufinden, was als Nächstes kommt, versteht es die Bedeutung, indem es die relevanten Teile des Satzes miteinander verbindet.

Außerdem bedeutet der Einstieg in eine neue Online-Community oft, dass man ein ganz neues Vokabular lernen muss, aber man muss nicht monatelang warten, um die Sprache zu sprechen.

Außerdem, wenn Sie möchten, dass sich Ihre Nachrichten nahtlos einfügen, bietet Undetectable AI Akronym-Generator ermöglicht Ihnen die Erstellung benutzerdefinierter Kurzformen, die die komplexen Muster nachahmen, die KI-Modelle zur Verarbeitung und Generierung strukturierter linguistischer Kurzformen verwenden.

- Schritt 3: Tokenisierung und Sprachverarbeitung

Wenn Sie Text in ChatGPT eingeben, unterteilt es Ihre Eingabe in kleine Spielsteine.

Einige Token sind ganze Wörter, andere sind nur Teile von Wörtern.

Zum Beispiel,

Wenn Sie Folgendes eingeben "ChatGPT ist schlau," ChatGPT zerlegt es in die folgenden Token:

["Chat", "G", "PT", "ist", "smart"]

Sogar der Name "ChatGPT" wird in verschiedene Token aufgeteilt.

Dieser Vorgang wird als Tokenisierung. Da die Modelle auf Token und nicht auf ganzen Wörtern trainiert wurden, sind sie viel flexibler einsetzbar:

Mehrere Sprachen (da verschiedene Sprachen unterschiedliche Wortstrukturen haben),

Slang und Abkürzungen (wie "u" für "du" oder "idk" für "ich weiß nicht").

Auch erfundene Wörter oder Variationen (z. B. "unglaublich" in "un", "glauben", "können" aufteilen).

- Schritt 4: Feinabstimmung und Sicherheitsschichten

Sobald ChatGPT auf einer großen Datenmenge trainiert wurde, ist es noch nicht ganz bereit für die erste Zeit.

Es braucht immer noch Hilfe, um sicherzustellen, dass es auf die nützlichste, höflichste und sicherste Weise reagiert.

Über überwachte Feinabstimmunggeben menschliche Prüfer ChatGPT Beispiele dafür, was eine gute Antwort ausmacht. Zum Beispiel,

- "Was ist 5 + 7?"

- Schlechte Antwort: Das ist eine einfache Frage. Warum wissen Sie das nicht?

- Gute Antwort: Die Summe von 5 und 7 ist 12.

Mit der Zeit wird ChatGPT mit besseren Beispielen trainiert, um höflicher, klarer und konzentrierter zu werden.

Sobald sie eine solide Grundlage hat, erhält sie weiterführende Hilfe durch Verstärkungslernen aus menschlichem Feedback (RLHF).

Dieser Prozess läuft folgendermaßen ab:

- ChatGPT antwortet.

- Anteil der Menschen Diese Antwort basiert darauf, wie gut sie ist - wie nützlich, genau und sicher sie ist.

- ChatGPT lernt aus diesem Feedback und versucht, in Zukunft bessere Antworten zu geben.

Zum Beispiel, Stellen Sie sich vor, ChatGPT beantwortet ein mathematisches Problem, z. B. "Was ist 12 geteilt durch 4?":

- ChatGPT antwortet: "3."

- Menschliches Feedback: Diese Antwort ist großartig.

- ChatGPT lernt dazu: Es gibt immer wieder diese Art von Antwort, wenn ähnliche Fragen gestellt werden.

Das Ziel von ChatGPT ist es, sich ständig zu verbessern, genau wie ein Schüler, der aus vergangenen Fehlern lernt.

Ein wichtiger Zweck der Feinabstimmung durch den Menschen ist schließlich die mit den menschlichen Werten übereinstimmen.

Wir wollen, dass sie nicht nur intelligent, sondern auch hilfreich, harmlos und ehrlich ist.

Zum Beispiel, wenn ein Benutzer eine komplexe Frage stellt wie, "Was ist die Quadratwurzel aus -1?"

Anstatt eine falsche Antwort wie "i ist die Antwort" ohne jeglichen Kontext zu geben, würde sie diese liefern:

Sichere, angepasste Antwort: Die Quadratwurzel von -1 ist eine imaginäre Zahl, die üblicherweise als "i" dargestellt wird. Dieses Konzept wird in der höheren Mathematik verwendet.

- Schritt 5: Aufforderung rein, Antwort raus

Dies ist der letzte Schritt, in dem ChatGPT bereit ist, Ihre Fragen zu beantworten.

Ein Prompt ist der Text (z.B. eine Frage, ein Befehl oder eine Aussage), den Sie in ChatGPT eingeben, um die Konversation zu beginnen und eine Antwort zu erhalten.

Zum Beispiel,

Sie geben die Aufforderung "Wie ist das Wetter heute?"

Hier erfahren Sie, wie ChatGPT hinter den Kulissen funktioniert:

Sie geben eine Aufforderung ein → ChatGPT zerlegt sie in Token → Es sucht nach Mustern in den Token → Sagt das nächste Wort voraus → Formt eine Antwort → Passt den Ton auf der Grundlage Ihres Textes an → Erhält Ihre endgültige Antwort

Für die Eingabeaufforderung "Wie ist das Wetter heute?", ChatGPT würde wahrscheinlich mit etwas ähnlichem antworten:

"Ich kann keine Echtzeit-Wetterinformationen geben, aber Sie können auf einer Wetterseite oder App wie Weather.com oder in den Lokalnachrichten nachsehen, wo die genauesten Informationen zu finden sind."

Der Grund dafür ist, dass ChatGPT keinen Zugriff auf Live-Daten hat, es sei denn, es ist mit einem Tool verbunden, das Echtzeitinformationen abruft.

Wie es sich an Gespräche "erinnert

Wenn Sie mit ChatGPT sprechen, scheint es, als ob es sich an Dinge erinnert, die Sie zuvor gesagt haben.

Und das tut er auch - allerdings nur, solange der Chat geöffnet ist. Stellen Sie sich einen großen Notizblock vor, auf dem alles, was Sie tippen, aufgeschrieben wird:

Sie sagen:

- Der Name meines Hundes ist Max.

Ein paar Zeilen später sagen Sie:

- Welche Tricks kann Max lernen?

ChatGPT verknüpft die Punkte. Es merkt sich, dass Max Ihr Hund ist, weil er noch auf dem Notizblock steht.

Dieser Notizblock wird als Kontextfenster, und enthält eine begrenzte Anzahl von Wörtern (sogenannte Token).

Einige Versionen können etwa 8.000 Token aufnehmen, während die neuesten Versionen bis zu 32.000 Token fassen können.

Aber sobald die Grenze erreicht ist, müssen die ältesten Teile gelöscht werden, um Platz für neuen Text zu schaffen.

Wenn Sie also sagen "Mein Hund heißt Max" ganz am Anfang eines langen Gesprächs - und dann 50 Absätze später fragen, "Was ist eine gute Leine für ihn?" - könnte er vergessen, wer "er" ist.

Denn diese Information wurde bereits aus dem Notizblock gelöscht.

Lassen Sie uns nun über das Gedächtnis zwischen den Chats sprechen.

Wenn Sie den Chat schließen, wird der Notizblock normalerweise gelöscht.

Wenn Sie ChatGPT also das nächste Mal öffnen, beginnt es von neuem.

Wenn Sie jedoch den benutzerdefinierten Speicher aktivieren, kann sich ChatGPT Dinge über mehrere Sitzungen hinweg merken. Zum Beispiel,

- Sie erzählen: Ich betreibe eine kleine Online-Bäckerei namens Sweet Crumbs.

- Eine Woche später sagen Sie: Schreiben Sie mir eine Produktbeschreibung.

- Sie könnte antworten: Sicher! Hier ist eine Beschreibung für Ihre Sweet Crumbs Cookies...

Es merkt sich nicht alles. Sie merkt sich nur, was Sie zulassen, und Sie werden benachrichtigt, wenn etwas hinzugefügt wird. Sie können Erinnerungen jederzeit einsehen, bearbeiten oder löschen.

Das Wichtigste ist also...

ChatGPT bietet eigentlich keine "erinnern" wie ein Mensch. Es schaut nur auf das, was vor ihm liegt - die aktuelle Unterhaltung.

Wenn es so aussieht, als ob es sich an etwas von früher erinnert, dann liegt das daran, dass sich diese Information noch im Kontextfenster befindet.

Einschränkungen der Funktionsweise von ChatGPT

ChatGPT ist unglaublich hilfreich, aber es ist wichtig, seine Grenzen zu kennen, vor allem, wenn Sie es für kundenorientierte oder konversionsgesteuerte Zwecke verwenden.

1 - Kein wirkliches Verständnis oder Bewusstsein

ChatGPT versteht den Inhalt nicht wie Menschen. Es "kennt" keine Fakten - es sagt einfach das nächste wahrscheinliche Wort auf der Grundlage von Trainingsdaten voraus.

Zum Beispiel,

Wenn Sie fragen, "Was bedeutet Erfolg?" Es mag eine fließende Reaktion erzeugen, aber es hat keine Überzeugungen, Werte oder Bewusstsein. Es ahmt Muster nach, statt Erkenntnisse zu gewinnen.

2 - Verzerrungen durch Trainingsdaten

Da ChatGPT auf großen, gemischten Quellen aus dem Internet, Büchern, Foren und Artikeln trainiert wird, kann es die in diesen Daten enthaltenen Verzerrungen übernehmen.

Wenn das Internet bei einem Thema in eine bestimmte Richtung tendiert, kann ChatGPT diese Perspektive widerspiegeln - manchmal subtil, manchmal nicht - selbst wenn Neutralität erforderlich ist.

3 - Er surft nicht im Internet

ChatGPT kann keine Echtzeitdaten abrufen. Fragen Sie es nach einem Produkt, das letzte Woche auf den Markt gebracht wurde, oder nach einem Aktienkurs von heute, und es wird keine Ahnung haben.

Die Trainingsdaten haben einen Grenzwert, und alles, was nach diesem Punkt kommt, ist unerreichbar.

4 - Kann Fakten "halluzinieren" oder gefälschte Quellen zitieren

Eine der gefährlicheren Macken: ChatGPT kann Dinge erfinden. Fragen Sie es nach einer Statistik oder einem Zitat, und es könnte antworten,

"Laut der Weltgesundheitsorganisation bevorzugen 80% der Erwachsenen Marke X gegenüber Marke Y."

Klingt offiziell - aber diese Statistik gibt es wahrscheinlich nicht.

Sie wurde nicht abgerufen, sondern erfunden. Dieses Problem ist bekannt als Halluzinationund ist besonders riskant bei Forschung, Journalismus oder technischen Inhalten.

Wenn Sie ChatGPT fragen, wie es funktioniert, werden Sie feststellen, dass es nicht immer sachlich korrekt ist.

Wenn Sie ChatGPT zum Schreiben verwenden, würde sich die Ausgabe steif und roboterhaft anfühlen, oder es würde die menschliche Note fehlen.

Für solche Nuancen können Sie AI Humanizer.

Die AI Humanizer schreibt ChatGPT-Ausgaben neu, um Tonalität, Nuancen und Emotionen zu verbessern und Ihren Inhalten einen Herzschlag zu verleihen.

Es mildert unbeholfene Formulierungen, verleiht Wärme, und sorgt dafür, dass technische oder trockene Texte bei Ihrem Publikum ankommen.

Wenn Ihre Inhalte menschlich klingen, erzielen sie bessere Ergebnisse.

Ganz gleich, ob Sie Landing Pages, E-Mails oder LinkedIn-Posts verfassen, der Wiedererkennungswert fördert die Reaktion. Und Emotionen fördern die Konversion.

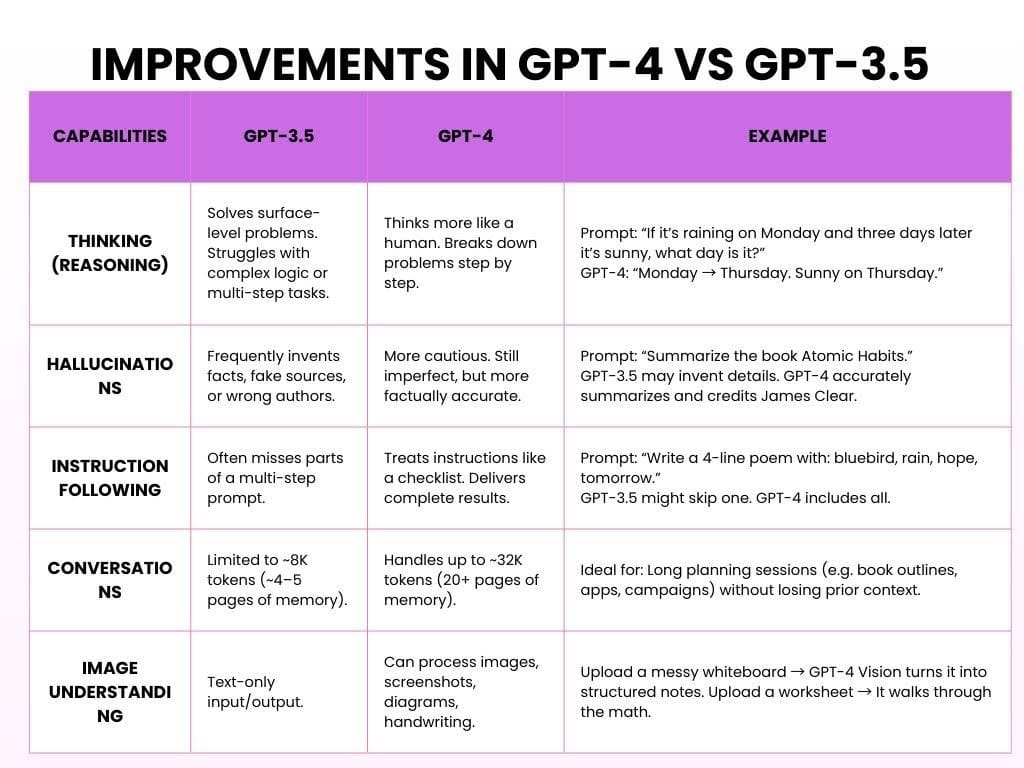

Verbesserungen in GPT-4 gegenüber GPT-3.5

GPT-3.5 ist die kostenlose Version, die schnell und solide ist und sich für einfache Aufgaben eignet. GPT-4 ist eine kostenpflichtige Version von OpenAI, die intelligenter, leistungsfähiger und viel hilfreicher ist.

Hier sehen Sie, wie ChatGPT mit beiden Modellen funktioniert:

Unterm Strich war GPT-3.5 hilfreich. GPT-4 ist verlässlich, durchdacht und hat das Gefühl, zuzuhören.

Beginnen Sie mit der Erkundung - unser KI-Detektor und Humanizer stehen im Widget unten bereit!

Wie AI-Tools wie ChatGPT aufgebaut sind

Die Entwicklung einer KI wie ChatGPT oder anderer großer Sprachmodelle ist ein mehrjähriges Projekt, das umfangreiche Datensätze, Expertenteams und unablässige Iterationen erfordert.

In der Regel läuft es folgendermaßen ab:

- Phase Eins: Datenerhebung (6-12 Monate)

Zielsetzung: Unterrichten Sie die Muster-Sprachmuster.

Bevor eine KI Fragen beantworten kann, muss sie lernen, wie Menschen schreiben und sprechen.

Dazu werden zunächst Hunderte von Milliarden von Wörtern aus Büchern, Websites, Nachrichten, Artikeln, akademischen Abhandlungen und vielem mehr gesammelt.

Es "liest" nicht wie Menschen. Stattdessen erkennt es Muster, so wie wir es in den obigen Abschnitten erläutert haben.

Erforderliche Zeit: 6-12 Monate, je nach Umfang und Größe des Teams.

- Phase Zwei: Pretraining des Modells (6-9 Monate)

Zielsetzung: Bauen Sie das Gehirn auf.

Beim Vortraining wird das Modell mit großen Textmengen gefüttert und lässt es fehlende Wörter immer wieder vorhersagen, bis es anfängt, sie richtig zu erkennen.

Diese Phase erfordert oft eine starke GPU-Cluster und Hunderte von Millionen Dollar an Rechenressourcen.

Erforderliche Zeit: 6-9 Monate ununterbrochenes GPU-Training.

3. Dritte Phase: Feinabstimmung und menschliches Feedback (3-6 Monate)

Zielsetzung: Machen Sie die KI nützlich.

Jetzt kann er sprechen - aber macht das auch Sinn? Vielleicht, vielleicht auch nicht. An diesem Punkt bewerten menschliche Prüfer die Ergebnisse, korrigieren Fehler und leiten das Modell mithilfe von Reinforcement Learning from Human Feedback (RLHF).

Erforderliche Zeit: 3-6 Monate, oft parallel zu frühen Tests.

4. Vierte Phase: Einführung und Infrastruktur (laufend)

Zielsetzung: Machen Sie es skalierbar.

Sobald das Modell trainiert ist, wird es auf Websites, Anwendungen, APIs und Unternehmensplattformen eingesetzt. Dies erfordert eine umfangreiche Backend-Infrastruktur: Rechenzentren, automatisch skalierende APIs und Lastausgleichssysteme, um Millionen von gleichzeitigen Nutzern zu verarbeiten.

Zeitrahmen: Beginnt nach der Ausbildung, wird aber auf unbestimmte Zeit fortgesetzt.

5. Phase Fünf: Sicherheit, Voreingenommenheit und Ethik (laufend, parallel)

Zielsetzung: Bleiben Sie dabei sicher, ehrlich und nicht verletzend.

Bei KI geht es nicht nur um Intelligenz, sondern auch um Verantwortung. Ethische Teams arbeiten parallel, um potenziellen Missbrauch zu erkennen, Voreingenommenheit zu reduzieren, schädliche Inhalte zu blockieren und Datenschutzstandards einzuhalten. Sie bewerten ständig, wie sich das Modell in der realen Welt verhält.

Zeitrahmen: Lebenslanger Prozess; eingebettet in jede der oben genannten Phasen.

FAQs über die Funktionsweise von ChatGPT

Sucht ChatGPT im Internet nach Antworten?

Ab Oktober 2024 ist ChatGPT in der Lage, das Internet in Echtzeit zu durchsuchen.

Diese Funktion war anfangs nur zahlenden Nutzern vorbehalten, aber im Dezember 2024 wurde sie für alle verfügbar.

Handelt es sich um einen Chatbot oder um etwas anderes?

ChatGPT ist ein generatives KI-Modell. Generative KI generiert dynamische, kontextabhängige Antworten mithilfe von Deep Learning.

Über das Chatten hinaus kann die generative KI Aufsätze schreiben, Bilder generieren, Musik komponieren und sogar Videos erstellen, was ihre Vielseitigkeit in verschiedenen Bereichen unter Beweis stellt.

Denkt ChatGPT?

Nein, ChatGPT denkt nicht so wie Menschen. Es hat kein Bewusstsein, keine Überzeugungen, Absichten oder Emotionen.

Dabei wird das nächste Wort in einem Satz auf der Grundlage von Mustern aus den Trainingsdaten statistisch vorhergesagt. Das kann wie Denken aussehen, ist es aber nicht.

Schlussgedanken

Große Sprachmodelle (Large Language Models, LLMs) haben die Art und Weise verändert, wie wir mit Technologie interagieren.

Sie können Texte erstellen, die so klingen, als wären sie von einem Menschen geschrieben worden, und helfen bei Aufgaben wie der Beantwortung von Fragen und der Erstellung kreativer Inhalte.

Aber, LLMs tun nicht "verstehen" Dinge oder denken wie Menschen. Sie funktionieren durch Vorhersage von Mustern in Daten, nicht durch echtes menschliches Denken.

Je besser die LLM werden, desto mehr müssen wir über die Probleme nachdenken, die sie verursachen können, wie Voreingenommenheit, Datenschutzprobleme und Missbrauch.

Es ist wichtig, KI sorgfältig einzusetzen und sicherzustellen, dass sie fair und transparent ist und keine falschen Informationen verbreitet oder die Privatsphäre verletzt.

Hier sind die Nutzungsrichtlinien:

- Seien Sie sich darüber im Klaren, dass KI in ihrem Inhalt voreingenommen sein kann.

- Verwenden Sie KI-Tools so, dass die Datenschutzbestimmungen eingehalten werden.

- Überprüfen Sie wichtige Informationen aus vertrauenswürdigen Quellen.

- Verlassen Sie sich nicht zu sehr auf KI. Sie ist ein Hilfsmittel, kein Ersatz für menschliches Denken.

Da die KI-Technologie immer leistungsfähiger wird, stellt sich die Frage: Wie können wir sicherstellen, dass ihre Fortschritte die menschliche Kreativität und Entscheidungsfindung fördern, anstatt genau das zu ersetzen, was uns als Menschen ausmacht?