A medida que herramientas de IA como ChatGPT se vuelven más sofisticadas y accesibles, surge una preocupación acuciante en el sector educativo:

¿Pueden las universidades detectar con fiabilidad los contenidos generados por ChatGPT?

En este artículo, examinamos cómo están respondiendo las instituciones al auge de la IA generativa, qué métodos de detección se están utilizando en 2025.

Los retos a los que se enfrentan y cómo los estudiantes pueden utilizar la IA de forma responsable sin comprometer la integridad académica.

Principales conclusiones

- Las universidades pueden detectar ChatGPT, pero no con una precisión perfecta. Herramientas como Turnitin y Copyleaks se utilizan habitualmente, pero siguen produciendo falsos positivos y negativos.

- La revisión humana y el análisis estilométrico son fundamentales para evaluar las incoherencias entre el trabajo anterior de un estudiante y los nuevos envíos.

- La detección se basa en patrones lingüísticos, estadísticos y contextuales, pero los resultados de la IA avanzada a menudo pueden eludir el análisis superficial.

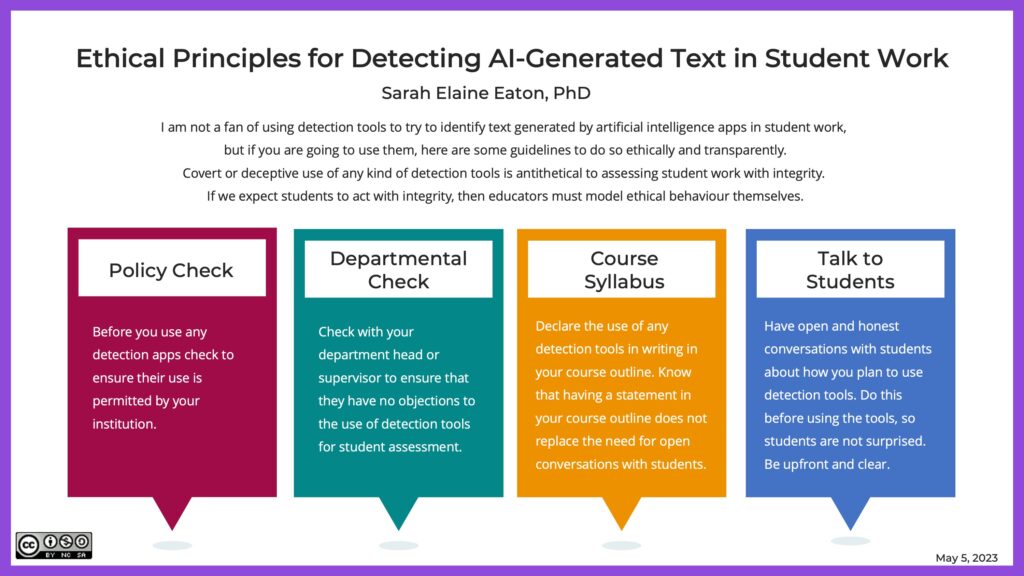

- Los educadores están actualizando las políticas y adoptando exámenes orales, tareas de redacción en tiempo real y evaluaciones con inteligencia artificial para reducir la dependencia de las herramientas de detección por sí solas.

- El uso ético de la IA es posible, especialmente cuando se guía por la transparencia, la honestidad académica y herramientas como Undetectable AI.

¿Se podrá detectar el ChatGPT en 2025?

ChatGPT y otros grandes modelos lingüísticos han mejorado espectacularmente su capacidad para generar textos naturales, coherentes y de apariencia humana.

Aunque este avance libera un poderoso potencial educativo, también plantea nuevos retos a las instituciones académicas que tratan de preservar la integridad del trabajo de los estudiantes.

La mayoría de los detectores de IA utilizand por universidades-incluida la función de detección de IA de Turnitin- se basan en patrones lingüísticos, perplejidady estallido para marcar la escritura generada por IA.

No vuelvas a preocuparte de que la IA detecte tus textos. Undetectable AI puede ayudarle:

- Haz que aparezca tu escritura asistida por IA de aspecto humano.

- Bypass las principales herramientas de detección de IA con un solo clic.

- Utilice AI de forma segura y con confianza en la escuela y el trabajo.

Sin embargo, estos sistemas no son infalibles. Muchos estudiantes modifican los resultados de la IA o los humanizan utilizando herramientas avanzadas para eludir su detección.

Esta carrera armamentística entre la IA generativa y los detectores de IA ha hecho que las universidades caminen por la cuerda floja, equilibrando la imparcialidad, la integridad académica y la evolución de las necesidades de los estudiantes.

Métodos de detección habituales en la enseñanza superior

1. Estilometría

La estilometría examina el estilo único de escritura de un estudiante en envíos anteriores, analizando la gramática, la puntuación, la estructura de las frases y el vocabulario.

Una desviación brusca en el tono o la complejidad suele indicar el uso de IA. Este método es especialmente eficaz cuando los educadores disponen de una carpeta de trabajos anteriores del alumno para comparar.

2. Análisis estadístico de patrones

Los contenidos generados por la IA suelen mostrar una coherencia poco natural en la longitud de las frases, la formalidad o la estructura.

Los detectores como Turnitin buscan anomalías basándose en patrones conocidos de la escritura humana. Sin embargo, los contenidos de IA muy editados pueden eludir este tipo de análisis.

3. Análisis contextual y semántico

En lugar de limitarse a la gramática superficial, el análisis contextual evalúa profundidad, pertinencia y coherencia.

Las herramientas de IA pueden producir contenidos que "suenen bien" pero que carezcan de un análisis profundo o de conexión con el material del curso.

4. Detección por aprendizaje automático

Algunas instituciones utilizan la IA para luchar contra la IA: entrenan modelos de aprendizaje automático para distinguir entre el texto humano y el generado por la máquina basándose en miles de ensayos de muestra.

5. Revisión humana

A pesar de la automatización, los educadores experimentados siguen siendo los detectores de IA más precisossobre todo cuando conocen la voz de sus alumnos.

De hecho, un 2025 Estudio arXiv descubrieron que los instructores experimentados superaban a los detectores de IA a la hora de detectar tareas sutiles generadas por IA.

Limitaciones de la detección de IA en el mundo académico

Aunque los sistemas de detección han mejorado, varios limitaciones críticas permanecer:

- Falsos positivos pueden acusar erróneamente a los alumnos, especialmente a aquellos cuya escritura se desvía de la norma (por ejemplo, alumnos de ESL o alumnos neurodiversos).

- Coste y accesibilidad restringir a las universidades con presupuestos más reducidos la adquisición de las herramientas de detección de IA más avanzadas.

- Cuestiones éticas surgen cuando las prácticas invasivas de detección vulneran la intimidad de los alumnos o fomentan la desconfianza.

- Desigualdad en el uso de la IA puede aumentar aún más las diferencias de rendimiento entre los estudiantes con distintos niveles de acceso a la alfabetización y las herramientas de la IA.

Estas preocupaciones han empujado a muchas instituciones a reevaluar no sólo cómo detectan la IA, sino cómo lo hacen. replantearse la evaluación en conjunto.

Implicaciones del uso de ChatGPT para estudiantes y universidades

Integridad académica: Las presentaciones generadas por IA pueden oscurecer la verdadera comprensión del alumno.

Cuando se utiliza de forma poco ética, ChatGPT cuestiona la exactitud de la evaluación académica y compromete el valor de las calificaciones y credenciales.

Dilemas éticos: Desde la equidad hasta la privacidad de los datos, las universidades se debaten sobre dónde trazar la línea en el uso de la IA. ¿Debe prohibirse la IA o debe integrarse con cuidado?

Impacto a largo plazo: La dependencia excesiva de la IA podría debilitar competencias esenciales como el pensamiento crítico, la argumentación y la creatividad.

Si los resultados académicos se perciben como asistidos por la IA, la credibilidad de los títulos podría disminuir a ojos de los empleadores y los programas de posgrado.

Formas de utilizar con seguridad las herramientas de IA (con IA indetectable)

La IA no tiene por qué ser enemiga de la honestidad académica: si se utiliza correctamente, puede mejorar la comprensión sin sustituir al pensamiento original.

He aquí cómo los estudiantes pueden utilizar la IA de forma segura y transparente:

- Utiliza la IA para hacer lluvia de ideas, no para escribir ensayos completos.

- Cite sus fuentes si la IA le ha ayudado a generar ideas.

- Edita en profundidad para hacer tuya la obra.

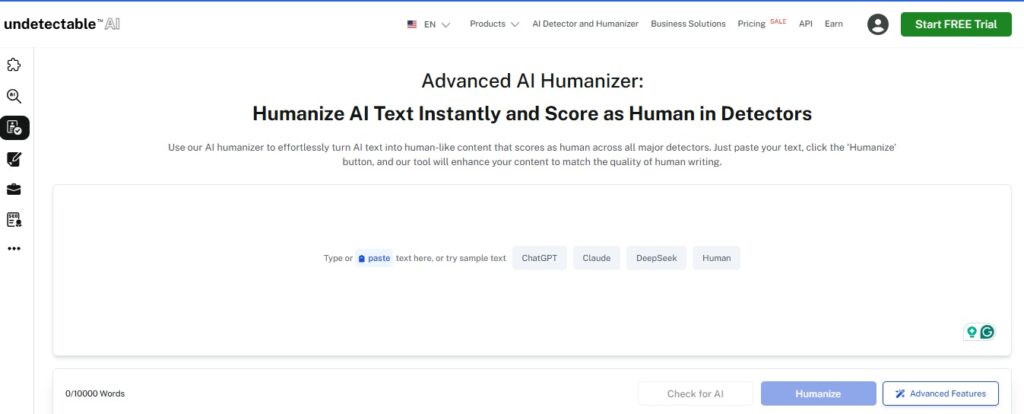

- Utiliza herramientas humanizadoras para asegurarte de que tus escritos reflejan tu voz personal.

Herramientas recomendadas por Undetectable AI

- Humanizador AI - Convierte las salidas robóticas de la IA en una escritura similar a la humana que se ajusta a su voz única.

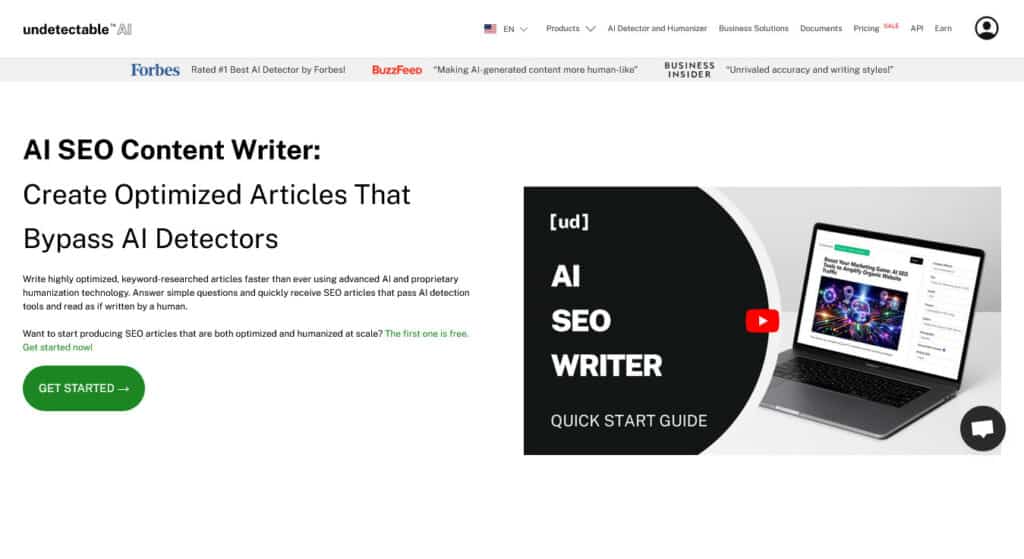

- AI SEO Redactor de contenidos - Ideal para estudiantes que gestionan blogs o portafolios personales y necesitan contenidos éticamente optimizados.

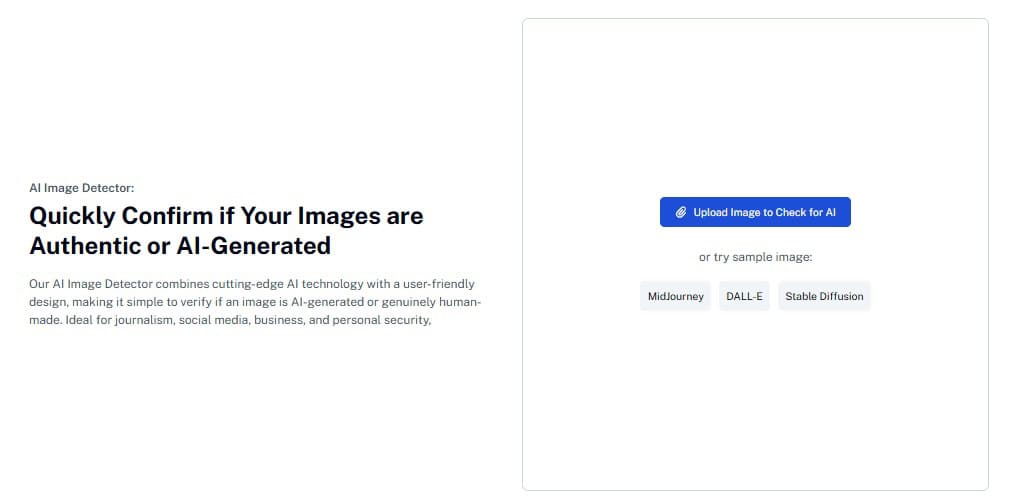

- AI Image Detector - Diseñado para proyectos visuales y presentaciones multimedia, ayuda a garantizar la originalidad y la conformidad.

Mediante el uso responsable de las herramientas de IA indetectable, los estudiantes pueden adoptar la IA sin violar las expectativas académicas, y los educadores pueden generar confianza a través de la transparencia.

Asegúrese de que su redacción se ajusta a las normas de la plataforma: comience con el widget que aparece a continuación.

Preguntas más frecuentes (FAQ)

¿Pueden las universidades detectar los contenidos generados por ChatGPT?

Sí, pero no siempre. Las herramientas de detección pueden señalar el uso probable de IA, pero a menudo no identifican el contenido o lo hacen erróneamente. La revisión humana sigue siendo esencial.

¿Es hacer trampas utilizar ChatGPT para obtener ayuda?

Depende. Utilizar ChatGPT para aportar ideas o aclarar un tema puede estar bien si lo aprueba tu profesor. Hacer pasar un trabajo generado por IA como propio se considera deshonestidad académica.

¿Qué ocurre si un acusan falsamente a un estudiante de utilizar IA?

Los falsos positivos ocurren. Por eso se insta a las instituciones a combinar las herramientas de IA con el juicio de los educadores antes de tomar medidas disciplinarias.

¿Pueden las herramientas de IA indetectables eludir la detección?

La IA indetectable ayuda a humanizar los contenidos y restablecer el flujo natural, pero su objetivo principal es garantizar la claridad y la originalidad, no engañar a los sistemas de detección.

¿Seguirán las universidades evolucionando sus políticas de IA?

Por supuesto. La mayoría de las instituciones están revisando activamente sus políticas, desarrollando nuevas evaluaciones y explorando cómo incorporar la IA de forma responsable a la educación.

Conclusión

El futuro de la educación no está en evitar la IA, sino en aprender a utilizarla con sensatez.

Las universidades en 2025 están adoptando cada vez más métodos de detección, pero la verdadera integridad académica proviene de la comprensión, la transparencia y la confianza de los estudiantes.

Tanto si eres un estudiante que busca formas éticas de utilizar la IAo un educador que se adapta a un nuevo panorama de aprendizaje, la IA indetectable le proporciona las herramientas necesarias para acompañarle en su viaje con integridad.

Explorar la IA indetectable y descubrir formas éticas y eficaces de trabajar con la IA en las aulas de hoy en día.