ここ数年、誰もが舌を巻いていることがある: ChatGPT。

教員 生徒の宿題を書いているのではないかと心配している。

ライター AIが彼らの代わりに本や物語を書くかもしれないことを恐れている。

コーダー は、人間よりも優れたウェブサイトやアプリを構築することを恐れている。

という予測さえある。 数百万人の雇用が失われる可能性がある AIのせいだ。

誰もが耳にしたことがあるだろう。しかし どのように ChatGPTは機能しますか?

ChatGPTはどうやって子供の宿題を書くのですか?ChatGPTはどのように子供の宿題を書いているのですか?

機械は私たちと同じように言葉を理解できないのに、どうして詩や物語やコードを書くことができるのだろう?

このブログでは 私たちは内部を見る ChatGPTとは何か、どのように機能するのか、順を追って説明します。

どのように記憶するのか、どのような限界があるのか、そもそもこのようなツールがどのように作られているのかを学ぶことができる。

始めよう!

基礎GPT言語モデル

ChatGPTは、人間のように理解し、書くように作られたAIです。

これは 言語モデル なぜなら、それは言語を扱うからだ。

でも、人間のようには理解できない。考えない。事実を知らない。ただパターンを見るだけだ。

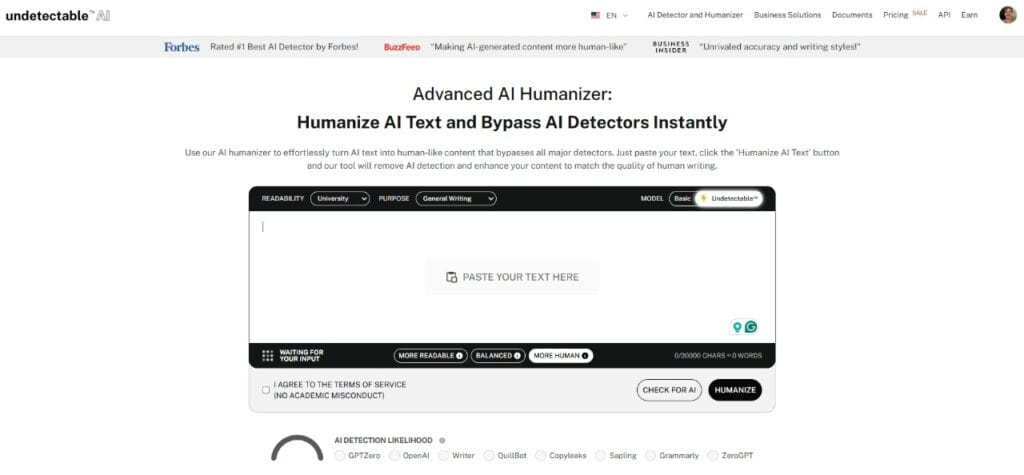

もうAIがあなたのテキストを検出する心配はありません。 Undetectable AI あなたを助けることができる:

- AIがアシストする文章を出現させる 人間らしい。

- バイパス ワンクリックですべての主要なAI検出ツール。

- 用途 AI 無事に そして 堂々 学校でも仕事でも。

例えば、こうだ、

- と入力すると "空は..."

- それは次のようなものだ。 "ブルー"

空が青いと知っているからではなく、トレーニング中に何百万回もこの文章を見たからだ。"空は "の後に "青 "が来ることが多いことを学んだのだ。

このようなAIは「AI」と呼ばれる。 LLMの略である。 大きな言語モデル。

人間がどのように言葉を使うかを理解するために、大量の教科書やウェブサイトなどで訓練されている。しかし、意味を読み取るのではない。単語が通常どのように隣り合って表示されるかを学習しているのだ。

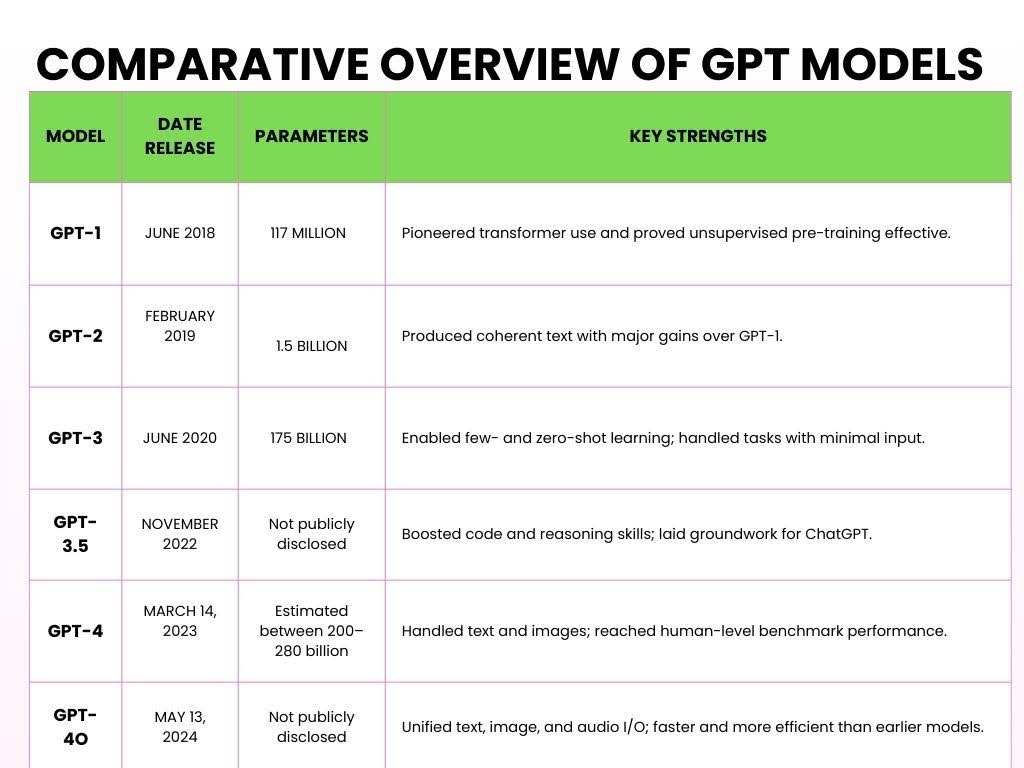

ジーピーティー はLLMの一種である。

GPTとは "生成的な事前訓練された変圧器"

- ジェネレイティブ - 新しいテキストを作成することができる。

- トレーニング済み - 話す前に学ぶのだ。

- 変圧器 - ChatGPTは、文や段落、あるいは会話の中で単語がどのように関連し合っているかを理解することができます。

ここでは、長年にわたって発売されてきたGPTのさまざまなバージョンを紹介する。

ChatGPTの仕組み

ここでは、ChatGPTがどのように機能し、5つの重要なステップであなたの入力を処理するかを簡単に説明します。

- ステップ1:大量データでの事前トレーニング

大規模言語モデル(LLM) ChatGPTは、インターネット上の膨大な量のテキストを処理して言語パターンを学習することで、あらかじめ訓練されている。

事前トレーニング中、モデルは以下の処理を行う。 兆トークン (小さなテキストの断片)。

A トークン は、モデルが入力をどのようにトークン化するかによって、単語、単語の一部、あるいは句読点になる。

例えば、こうだ、

ChatGPTに数学の質問をします:

問題だ:

- 2 + 3 = ?

トレーニング中、ChatGPTは本、ニュース、記事、ウィキペディア、物語、科学論文、さらにはRedditのスレッドから数千億の単語を読み込む。

この訓練と読書は、足し算がどのように機能するかを理解するのに役立つ。

例えば、こうだ、

を学ぶかもしれない。 可換性 (すなわち、2+3=3+2)。

ChatGPTには、次のような例がたくさんある。

- "2 + 3 = 5,"

- "7 + 8 = 15,"

- "9 + 4 = 13."

これらの具体例だけを学ぶのではなく、足し算のパターンを学ぶのだ。

数字が「+」記号とどのように相互作用し、結果が通常「=」記号の後にどのように続くかを理解する。

- ステップ2:トランスフォーマー・アーキテクチャー

ChatGPTが膨大な量の単語を目にしたら、そのすべての情報を理解できる脳が必要になった。そのAIの脳は 「トランスフォーマー

トランスフォーマーの特徴は、次のような能力だ。 注意を集中する 私たちが言語を処理するのと同じように。

例えば、こうだ、

これを数学の問題に当てはめてみよう:

- 「5と7の和は?

これを処理するとき、トランスフォーマーは単に単語ごとに処理するのではない。

その代わりに、「合計」「5」「7」といった文脈をすべて一度に見る。

それは次のようなものだ。 "合計" とは "追加" そして、"5 "と "7 "が関係する数字である。

トランスフォーマーはさらに 注目 は、答えに直接影響する語句に集中するため、演算(「合計」)と数字(「5」と「7」)に集中する。

これがChatGPTの重要な機能です。 は問題を線形処理しない、 しかし、要素間の関係を理解するのに役立つ方法で。

このようにすべてを文脈で見る能力が、トランスフォーマーを強力なものにしているのだ。

ただ次に何が来るかを考えるのではなく、文の関連する部分をつなげて意味を理解するのだ。

さらに、新しいオンラインコミュニティに参加することは、まったく新しい語彙を学ぶことを意味することが多いが、その言語を話し始めるのに何ヶ月も待つ必要はない。.

さらに、メッセージを自然に溶け込ませたいなら、Undetectable AIの 頭字語ジェネレーター AIモデルが構造化された言語の短縮形を処理・生成するために使用する複雑なパターンを模倣したカスタム略語を作成できます。.

- ステップ3:トークン化と言語処理

ChatGPTにテキストを入力すると、プロンプトは次のように分割されます。 トークン。

トークンには完全な単語もあれば、単語の一部だけのものもある。

例えば、こうだ、

を入力すると 「ChatGPTは賢い。 ChatGPTはこれを以下のトークンに分割します:

["チャット""G""PT""is""smart"]。

ChatGPT "という名前でさえ、異なるトークンに分割される。

このプロセスをこう呼ぶ。 トークン化。 モデルは完全な単語ではなくトークンで学習されているため、より柔軟に対応できる:

複数の言語 (言語によって単語の構造が異なるため)、

スラングと略語 (例えば、"you "なら "u"、"I don't know "なら "idk")。

造語やバリエーションも ("unbelievable "を "un"、"believ"、"able "に分けるように)。

- ステップ4:微調整と安全層

ChatGPTが膨大な量のデータでトレーニングされた後では、まだ本番には間に合いません。

最も有用で、丁寧で、安全な方法で対応するためには、まだ助けが必要だ。

を通して 監視付き微調整また、人間のレビュアーがChatGPTに良い回答の例を挙げている。 例えば、こうだ、

- 「5+7って何?

- 悪い答えだ: 簡単な質問だ。なぜこれを知らない?

- 良い答え: 5と7の和は12である。

時間をかけて、ChatGPTはより良い例で訓練され、より礼儀正しく、明瞭で、集中できるようになります。

基礎が固まったら、次のステップに進む。 人間のフィードバックからの強化学習 (RLHF)。

このプロセスはこうだ:

- ChatGPTがお答えします。

- 人間率 その答えは、それがどれだけ優れているか、つまりどれだけ有用で、正確で、安全であるかということに基づいている。

- ChatGPTが学ぶ このフィードバックから、今後より良い答えを出すように努める。

例えば、こうだ、 ChatGPTが次のような数学の問題に答えるとします。 「12を4で割ると?

- ChatGPTが答える:"3."

- 人間のフィードバックこの答えは素晴らしい。

- ChatGPTは学習する:同じような質問が出ると、このような返答をし続けます。

ChatGPTの目標は、過去の失敗から学ぶ学生のように、常に向上し続けることだ。

最後に、人間による微調整の重要な目的のひとつがある。 人間の価値観に合致する。

スマートなだけでなく、役に立ち、害がなく、正直であってほしい。

例えば、こうだ、 というような複雑な質問をした場合、 「の平方根は?

何の脈絡もなく「iが答えです」のような不正解を与えるのではなく、「iが答えです」を提供するのだ:

安全で整列した対応:の平方根は虚数であり、一般に「i」と表される。この概念は上級数学で使われる。

- ステップ5:プロンプト・イン、レスポンス・アウト

これはChatGPTがあなたのプロンプトに答える準備ができている最後のステップです。

プロンプトとは、ChatGPTに入力するテキスト(質問、コマンド、ステートメントなど)のことです。

例えば、こうだ、

プロンプトを入力する 「今日の天気は?

ChatGPTの舞台裏は以下の通りです:

プロンプトを入力 → ChatGPTがそれをトークンに分割 → トークンのパターンを探す → 次の単語を予測 → 応答を作成 → テキストに基づいてトーンを調整 → 最終的な回答を取得

プロンプト 「今日の天気は? ChatGPTはおそらくこう答えるだろう:

"リアルタイムの天気予報をお伝えすることはできませんが、Weather.comのような天気予報サイトやアプリ、あるいは地元のニュースなどで最も正確な情報を確認してください"

ChatGPTは、リアルタイム情報を取得するツールに接続しない限り、ライブデータにアクセスできないからだ。

会話を "記憶 "する方法

ChatGPTに話しかけると、あなたが以前話したことを覚えているようです。

そして、それはチャットが開いている間だけである。大きなメモ帳を想像してみてください:

あなたは言う:

- 愛犬の名前はマックス。

その数行後、あなたはこう言った:

- マックスはどんなトリックを学ぶことができるのか?

ChatGPTは点と点を結ぶ。マックスがあなたの犬であることを覚えています。

このメモ帳は コンテキスト・ウィンドウ トークンと呼ばれる)限られた数の単語を保持する。

約8,000枚のトークンを収納できるバージョンもあれば、最新のものでは32,000枚まで収納できるものもある。

しかし、限界に達すると、新しいテキストのためのスペースを確保するために、古い部分を消去し始めなければならない。

ということは 「愛犬の名前はマックス と50段落後に尋ねた、 「リードは何がいい? - 彼」が誰なのか忘れてしまうかもしれない。

なぜなら、その情報はすでにメモ帳から消されているからだ。

さて、チャットとチャットの間の記憶について話そう。

通常、チャットを閉じるとメモ帳は消去される。

次にChatGPTを開くときは、新しく始まります。

しかし、カスタムメモリをオンにすると、ChatGPTはセッションをまたいで記憶することができます。 例えば、こうだ、

- あなたは言う: 私はスウィート・クラムスという小さなオンライン・ベーカリーを経営している。

- 一週間後、あなたは言った: 商品の説明を書いてください。

- と答えるかもしれない: 勿論!スイート・クランブス・クッキーの説明です。

すべてを記憶しているわけではない。あなたが許可したものだけが記憶され、何かが追加されるとあなたに通知されます。メモリーはいつでも見たり、編集したり、削除することができます。

で、肝心の内容はというと...。

ChatGPTは実際には "思い出せ" 人のように。目の前にあるもの、つまり現在の会話を見るだけだ。

もし、それが以前の何かを思い出しているように見えるなら、その情報はまだコンテキストウィンドウの中にあるからだ。

ChatGPTの仕組みの限界

ChatGPTは非常に便利ですが、その限界を理解することが重要です。

1 - 理解も意識もない

ChatGPTは人間のようにコンテンツを理解しません。事実を "知っている "のではなく、単に学習データに基づいて次に出てきそうな単語を予測するだけなのです。

例えば、こうだ、

と訊かれたら、 「成功とは何か? それは流暢な反応を生み出すかもしれないが、信念も価値観も意識も持っていない。パターンを模倣しているのであって、洞察力を形成しているわけではないのだ。

2 - 訓練データからのバイアス

ChatGPTは、インターネット、書籍、フォーラム、記事からの大規模な混合ソースで訓練されているため、そのデータに見られるバイアスを継承することができます。

あるトピックについてインターネットが一方向に傾いている場合、ChatGPTは中立性が求められているときでも、その視点を反映させるかもしれない。

3 - インターネットを閲覧しない

ChatGPTはリアルタイムのデータを取得することができません。先週発売された製品や今日の株価について質問しても、手がかりは得られません。

そのトレーニングデータにはカットオフがあり、そのポイント以降は手が届かない。

4 - 事実を「幻覚」したり、偽の情報源を引用したりすることがある。

より危険な癖の一つ:ChatGPTは作り話をすることがある。統計や引用を求めれば、答えてくれるかもしれません、

「世界保健機関(WHO)によれば、成人の80%はYブランドよりXブランドを好む。

公式に聞こえるが、この統計は存在しない可能性が高い。

回収されたのではなく、発明されたのだ。この問題は 幻覚研究、ジャーナリズム、技術的なコンテンツでは特にリスクが高い。

ChatGPTの仕組みを聞けば、必ずしも事実が正しいとは限らないことが分かる。

ChatGPTをライティングのために使っているのであれば、アウトプットは硬く、ロボット的で、人間的なエッジがないように感じるでしょう。

このようなニュアンスには AIヒューマナイザー。

について AIヒューマナイザー ChatGPTの出力をトーン、ニュアンス、感情のためにリライトし、コンテンツに鼓動を与えます。

それは ぎこちないフレージングを和らげ、温かみを加える、 そして、技術的なコピーや無味乾燥なコピーを読者の心に響かせる。

コンテンツが人間的であれば、パフォーマンスは向上する。

ランディングページ、Eメール、LinkedInの投稿のどれを書いていても、親近感が反響を呼ぶ。そして、感情はコンバージョンを促進する。

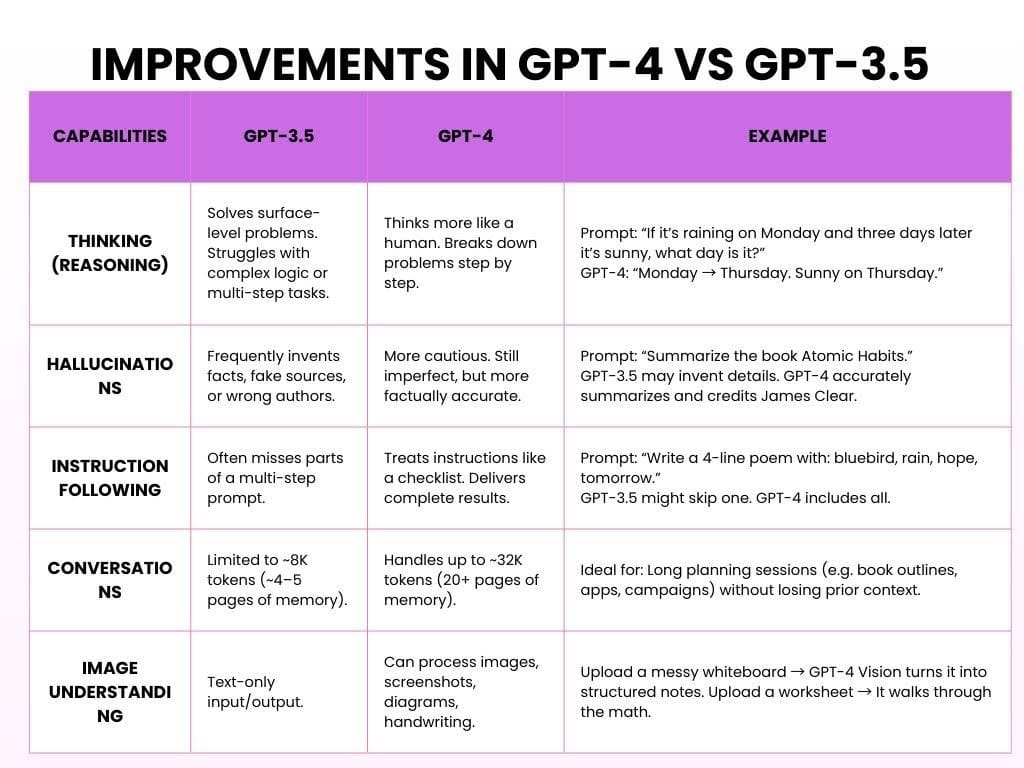

GPT-4とGPT-3.5の比較における改善点

GPT-3.5は無料版で、速く、しっかりしていて、シンプルなタスクに最適です。GPT-4はOpenAIの有料版で、より賢く、より強力で、より役に立ちます。

両モデルのChatGPTの動作は以下の通りです:

結論から言うと、GPT-3.5は役に立った。GPT-4は頼りがいがあり、思慮深く、耳を傾けている感じがする。

AIディテクターとヒューマナイザーが下のウィジェットでお待ちしています!

ChatGPTのようなAIツールはどのように構築されているか

ChatGPTやその他の大規模言語モデルのようなAIの作成は、膨大なデータセット、専門家チーム、絶え間ない反復を伴う数年にわたるプロジェクトです。

一般的にはこうだ:

- 第1段階:データ収集(6~12カ月)

目的 模範的な言語パターンを教える。

AIが質問に答える前に、人間の書き方や話し方を学ぶ必要がある。

これは、書籍、ウェブサイト、ニュース、記事、学術論文などから数千億語を集めることから始まる。

人間のように「読む」のではない。その代わり、上記のセクションで説明したように、パターンを識別する。

所要時間 6~12ヶ月、規模やチームサイズによって異なる。

- 第2段階:モデルの事前トレーニング(6~9カ月)

目的 脳を作る。

事前トレーニングでは、大量のテキストをモデルに与え、正しい結果が得られるようになるまで、何度も何度も欠落単語を予測させる。

この段階では、しばしば強力な GPUクラスター と数億ドルのコンピュート・リソースがある。

所要時間 6-9ヶ月のノンストップGPUトレーニング。

3.第3段階微調整と人的フィードバック(3~6ヶ月)

目的 AIを役立たせる。

しかし、それは意味があるのだろうか?そうかもしれないし、そうでないかもしれない。この時点で、人間のレビュアーが出力を評価し、間違いを修正し、人間のフィードバックからの強化学習(RLHF)を使ってモデルを導く。

所要時間 3~6ヶ月、多くの場合、初期のテストと並行して実施される。

4.第4段階展開とインフラ(継続中)

目的 拡張性を持たせる。

一度学習されたモデルは、ウェブサイト、アプリ、API、企業プラットフォーム全体に展開される。これには、データセンター、自動スケーリングAPI、数百万人の同時ユーザーを処理するための負荷分散システムなど、本格的なバックエンド・インフラストラクチャが必要になる。

時間枠 トレーニング後に開始されるが、無期限に継続される。

5.第5段階安全、偏見、倫理(継続中、並行開催)

目的 安全で、正直で、傷つけないようにすること。

AIは単なる知能の問題ではなく、責任の問題なのだ。倫理チームは、悪用の可能性を指摘し、バイアスを減らし、有害なコンテンツをブロックし、プライバシー基準を守るために並行して働きます。彼らは常に、モデルが現実世界でどのように振る舞うかを評価する。

時間枠 生涯のプロセスであり、上記のすべての段階に組み込まれている。

よくある質問 ChatGPTの仕組みについて

ChatGPTはインターネットで検索して答えを探すのですか?

2024年10月現在、ChatGPTはリアルタイムでインターネットを閲覧する能力を得た。

この機能は当初は有料ユーザー専用だったが、2024年12月には誰でも利用できるようになった。

チャットボットのようなものですか?

ChatGPTは生成AIモデルです。生成的AIは、ディープラーニングを使用して、動的でコンテキストを認識した返信を生成します。

チャットだけでなく、ジェネレーティブAIはエッセイを書いたり、画像を生成したり、音楽を作曲したり、動画を作成したりすることもできる。

ChatGPTはどう思う?

いいえ、ChatGPTは人間と同じようには考えません。意識も信念も意思も感情もありません。

これは、学習データのパターンに基づいて、文中の次の単語を統計的に予測するものだ。これは思考しているように見えるが、そうではない。

最終的な感想

大規模言語モデル(LLM)は、私たちのテクノロジーとの関わり方を変えた。

まるで人間が書いたかのような文章を作成し、質問に答えたり、クリエイティブなコンテンツを作ったりする作業をサポートする。

しかし、LLMはそうではない。 "理解する" 物事を考えたり、人間のように考えたりする。人間の思考ではなく、データのパターンを予測することによって機能するのだ。

LLMが良くなるにつれて、偏見やプライバシーの問題、悪用など、LLMが引き起こす可能性のある問題について考える必要がある。

AIを慎重に利用し、公正で透明性があり、誤った情報を流したりプライバシーを傷つけたりしないようにすることが重要だ。

以下はその内容である。 使用ガイドライン

- AIはその内容にバイアスを持つ可能性があることを意識してください。

- プライバシーのルールに従った方法でAIツールを使用する。

- 信頼できる情報源から重要な情報をダブルチェックする。

- AIに頼りすぎてはいけない。AIはツールであって、人間の思考に取って代わるものではない。

AI技術がより強力になるにつれ、疑問が生じる: その進歩が、人間を人間たらしめているものを置き換えるのではなく、人間の創造性や意思決定を高めるようにするにはどうすればいいのだろうか?