Als je tegenwoordig op internet rondkijkt, vind je waarschijnlijk overal AI-elementen in allerlei vormen.

Het is niet langer iets uit een sciencefictionfilm.

Van de autocorrectiefunctie van je telefoon tot Netflix-aanbevelingen en je ChatGPT-tabblad dat nu open is, het verscheen niet van de ene op de andere dag als een TikTok-sensatie.

Het is verbazingwekkend hoe ver we zijn gekomen van "wat als machines konden denken" naar "ChatGPT, schets me een bedrijfsstrategie voor een jaar".

Tijdens de ontwikkeling heeft AI veel mislukkingen en doorbraken gekend en veel briljante denkers voortgebracht.

In deze post zullen we niet alleen herinneringen ophalen, maar zullen we ook ontdekken hoe AI onderdeel werd van de dagelijkse conversatie.

Spoiler alert: er komt veel meer wiskundeangst en existentiële angst bij kijken dan je zou verwachten.

Belangrijkste opmerkingen

- AI-onderzoek begon in de jaren 1940 met vroege computerpioniers die droomden van denkende machines.

- Het veld werd officieel gelanceerd in 1956 op de Dartmouth Conferentie, waar de term "kunstmatige intelligentie" werd bedacht.

- AI heeft meerdere "winters" gekend waarin de financiering opdroogde en de aandacht verslapte.

- Moderne doorbraken op het gebied van AI zijn het resultaat van het combineren van enorme datasets met krachtige computers.

- De huidige generatieve AI is het nieuwste hoofdstuk in een 70-jarig verhaal van menselijke ambitie.

Hoe AI evolueerde van theorie naar realiteit

Zie de geschiedenis van AI als de carrière van je favoriete band.

Het begon met de undergroundjaren toen alleen echte fans er aandacht aan besteedden.

Toen kwam de doorbraak die iedereen beweert te hebben zien aankomen.

Maak je nooit meer zorgen dat AI je sms'jes herkent. Undetectable AI Kan je helpen:

- Laat je AI-ondersteund schrijven verschijnen mensachtig.

- Omleiding alle grote AI-detectietools met slechts één klik.

- Gebruik AI veilig en vol vertrouwen op school en op het werk.

Een paar flops en comebacks later zijn ze opeens overal en vragen je ouders ernaar.

AI volgde precies dit traject. Vroege onderzoekers probeerden niet om ChatGPT bouwen.

Ze stelden fundamentele vragen: Kunnen machines denken? Kunnen ze leren? Kunnen ze problemen oplossen zoals mensen dat doen?

Het antwoord bleek "een beetje, maar het is ingewikkeld".

Ontstaan van AI (vóór 1950)

Voordat we computers hadden, hadden we dromers. Oude mythen vertelden verhalen over kunstmatige wezens die tot leven werden gewekt.

De Griekse mythologie gaf ons Talos, de bronzen reus die Kreta beschermde. De Joodse folklore kende golems, dat zijn wezens van klei die bezield worden door mystieke woorden.

Maar het echte AI-verhaal begint tijdens de Tweede Wereldoorlog met Alan Turing. Turing brak Nazi-codes en legde de basis voor moderne computers. Over multitasking gesproken.

In 1936, Turing introduceerde het concept van een universele computermachine.

Dit theoretische apparaat kan elke berekening uitvoeren als het de juiste instructies krijgt.

Het klinkt een beetje saai totdat je je realiseert dat dit idee de basis is geworden voor elke computer die je ooit hebt gebruikt, inclusief de computer waarop je dit artikel leest.

De oorlog versnelde alles en creëerde een nodig voor innovatie. Plotseling gebruikten overheden hun budgetten voor elke technologie die hen een voorsprong kon geven.

De eerste elektronische computers kwamen voort uit deze snelkookpanomgeving.

Machines zoals ENIAC vulden hele kamers en er waren teams van ingenieurs nodig om ze te laten werken, maar ze konden in seconden uitrekenen waar mensen uren over deden.

Tegen het einde van de jaren 1940 begonnen onderzoekers zich af te vragen: als deze machines kunnen rekenen, kunnen ze dan ook denken?

1950s: De geboorte van kunstmatige intelligentie

Het jaar 1956 was het belangrijkste moment voor AI. Een groep onderzoekers kwam bijeen op het Dartmouth College in New Hampshire voor een zomerworkshop die alles zou veranderen.

John McCarthy, Marvin Minsky, Nathaniel Rochester en Claude Shannon sloten zichzelf op in een kamer en besloten om denkende machines te maken.

Ze de term "kunstmatige intelligentie" bedacht en zette een ambitieuze routekaart uit.

Deze onderzoekers geloofden dat machines binnen een generatie elk probleem dat mensen konden oplossen, zouden kunnen oplossen.

Uiteindelijk zaten ze er tientallen jaren naast, maar hun vertrouwen was bewonderenswaardig.

De Dartmouth Conference lanceerde AI als een legitiem studiegebied.

Plotseling richtten universiteiten AI-laboratoria op, schreven overheden cheques uit en deden onderzoekers gedurfde voorspellingen over de toekomst.

Alan Turing had hen al een voorsprong gegeven met zijn beroemde test.

De Turingtest stelde een eenvoudige vraag: als je een gesprek hebt met iets en je kunt niet zien of het een mens of een machine is, maakt dat dan iets uit?

Het is de ultieme "doe alsof tot je het maakt" filosofie, en die is vandaag de dag nog steeds relevant.

1960-1970: Vroeg optimisme en eerste modellen

De jaren 1960 begonnen met een ongelooflijk momentum. Onderzoekers hadden geld, media-aandacht en een duidelijke missie. Wat kon er misgaan?

Alles, zo bleek.

Vroege AI-programma's werkten goed in gecontroleerde omgevingen, maar vielen uit elkaar toen ze werden geconfronteerd met de complexiteit van de echte wereld.

Het is alsof je geweldig bent in basketbal spelen op je oprit, maar volledig stopt tijdens een echte wedstrijd.

ELIZAgemaakt door Joseph Weizenbaum in 1964, kon gesprekken voeren door trefwoorden te herkennen en te reageren met voorgeprogrammeerde zinnen.

Het was een geavanceerdere versie van het Magic 8-Ball speelgoed en mensen waren er dol op.

ELIZA werkte met patroonherkenning en substitutie. Als je zei "Ik ben verdrietig", zou het kunnen reageren met "Waarom ben je verdrietig?".

Het was eenvoudig maar effectief genoeg om sommige gebruikers te laten denken dat ze met een echte therapeut praatten. Weizenbaum was geschokt toen mensen zich emotioneel begonnen te hechten aan zijn programma.

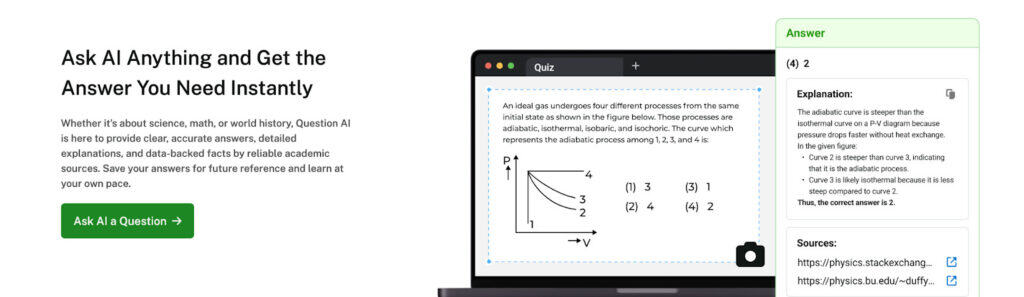

Niet-opspoorbare AI's Vraag AI werkt op een vergelijkbare manier. Je kunt het gebruiken om te simuleren of uit te leggen hoe vroege AI-modellen zoals ELIZA werkten in vergelijking met moderne taalmodellen.

Het verschil is echter onthutsend. ELIZA deed aan woordassociatie, terwijl de AI van vandaag de context kan begrijpen en samenhangende antwoorden kan genereren.

Ondertussen pakten onderzoekers ambitieuzere projecten aan. SHRDLU van Terry Winograd objecten kon begrijpen en manipuleren in een virtuele wereld gemaakt van blokken.

Het kan complexe instructies volgen zoals "Leg het rode blok bovenop het groene blok, maar haal eerst het blauwe blok uit de weg".

SHRDLU was indrukwekkend, maar het werkte alleen in zijn kleine blokkenwereld. Probeer het uit te breiden naar de echte wereld en het zou harder crashen dan je laptop tijdens de toetsweek.

Het probleem was niet alleen technisch. Onderzoekers ontdekten dat intelligentie veel ingewikkelder is dan ze dachten.

Dingen die mensen moeiteloos doen, zoals het herkennen van een gezicht of het begrijpen van sarcasme, bleken ontzettend moeilijk voor machines.

1980s: Expertsystemen en commerciële AI

Net toen iedereen dacht dat AI dood was, kwam het terug met een wraakactie. De jaren tachtig brachten expertsystemen en opeens verdiende AI echt geld.

Expertsystemen verschilden van eerdere AI-benaderingen. In plaats van te proberen algemene intelligentie na te bootsen, richtten ze zich op specifieke domeinen waar menselijke experts diepgaande kennis hadden.

Zie ze als hele slimme, hele gespecialiseerde consultants.

- MYCIN gediagnosticeerde bloedinfecties.

- DENDRAL geïdentificeerde chemische verbindingen.

- XCON geconfigureerde computersystemen.

Deze programma's legden de kennis van menselijke experts vast en maakten die beschikbaar voor anderen.

Het belangrijkste inzicht was dat je geen algemene intelligentie nodig hebt om nuttig te zijn.

Je moest gewoon heel goed zijn in één ding. Het is net als die persoon die alles weet over Marvel-films, maar niet meer weet waar hij zijn sleutels heeft gelaten.

Bedrijven begonnen op te letten. Expertsystemen konden echte problemen oplossen en echt geld besparen. Medische diagnose, financiële planning, probleemoplossing voor apparatuur - AI was niet langer slechts een academische nieuwsgierigheid.

De Japanse regering lanceerde de Computerproject van de vijfde generatievan plan om tegen de jaren 1990 intelligente computers te maken. Andere landen raakten in paniek en startten hun eigen AI-initiatieven.

De ruimterace was voorbij, dus waarom in plaats daarvan geen AI-race?

Expert systemen hadden echter hun beperkingen. Ze vereisten uitgebreide kennisontwikkeling, waarbij menselijke expertise handmatig werd gecodeerd in voor de computer leesbare regels.

Het was alsof je iemand probeerde te leren fietsen door alle mogelijke scenario's op te schrijven.

1990s: AI wordt (stilletjes) mainstream

De jaren 90 waren de ongemakkelijke tienerjaren van AI. Het vakgebied maakte veranderingen door, vond zijn identiteit en praatte zeker niet over zijn gevoelens.

De hausse in expertsystemen was afgekoeld. Deze systemen waren duur in onderhoud en konden zich niet aanpassen aan nieuwe situaties. Bedrijven gingen op zoek naar alternatieven.

Maar AI verdween niet. Het noemde zichzelf gewoon geen AI meer.

Machine-learningtechnieken die in academische laboratoria werden ontwikkeld, begonnen praktische toepassingen te vinden.

AI was overal aanwezig in de vorm van e-mailspamfilters, detectie van creditcardfraude en aanbevelingssystemen, maar niemand schepte erover op.

Dit was slimme marketing. De term "kunstmatige intelligentie" had te veel bagage uit vorige cycli. Mensen vonden het beter om te praten over "statistische analyse", "patroonherkenning" of "beslissingsondersteunende systemen".

De echte doorbraak kwam door een verandering in aanpak.

En niemand noemde het AI. Dat zou veel te voor de hand liggend zijn geweest.

2000s: Grondslagen van moderne AI

De jaren 2000 legden de basis voor alles wat er vandaag de dag gebeurt op het gebied van AI.

Het is net als de trainingsmontage in een sportfilm, alleen duurde het een decennium en kwam er veel meer wiskunde bij kijken.

Verschillende factoren creëerden samen de perfecte omstandigheden voor de ontwikkeling van AI. Rekenkracht werd steeds goedkoper en krachtiger.

Het internet had enorme datasets gecreëerd. En onderzoekers hadden uitgevonden hoe ze neurale netwerken effectief konden trainen.

Ondertussen waren techbedrijven stilletjes AI in alles inbouwen.

Het zoekalgoritme van Google gebruikte machine learning om webpagina's te rangschikken. De aanbevelingsmachine van Amazon zorgde voor miljardenomzetten. Het nieuwsfeed-algoritme van Facebook bepaalde wat miljoenen mensen elke dag te zien kregen.

De iPhone kwam in 2007 op de markt en bracht krachtige computers in ieders broekzak en genereerde ongekende hoeveelheden persoonlijke gegevens.

Elke tik, veeg en zoekactie werd een gegevenspunt dat betere AI-systemen kon trainen.

Tegen het einde van het decennium was AI ingebed in de digitale infrastructuur van het moderne leven.

De meeste mensen beseften het niet, maar ze hadden tientallen keren per dag contact met AI-systemen.

2010s: Deep Learning en Big Data

De jaren 2010 waren de jaren waarin AI veranderde van "leuke technische truc" in "holy crap, dit verandert alles".

Deep learning begon het decennium met een knal. In 2012 werd een neuraal netwerk genaamd AlexNet verpletterde de concurrentie in een beeldherkenningswedstrijd.

Het was niet alleen beter dan andere AI-systemen, het was ook beter dan menselijke experts.

Dit had nog niet mogen gebeuren.

De geheime ingrediënten waren grotere datasets, krachtigere computers en betere trainingstechnieken.

Grafische verwerkingseenheden (GPU's), oorspronkelijk ontworpen voor videogames, bleken perfect te zijn voor het trainen van neurale netwerken. Gamers creëerden per ongeluk de hardware die de AI-revolutie zou aandrijven.

De media konden er geen genoeg van krijgen. Elke AI-doorbraak haalde de krantenkoppen. Deep Blue verslaat Kasparov in schaken in de jaren 90 was indrukwekkend, maar AlphaGo die in 2016 de wereldkampioen Go versloeg was verbluffend.

Go zou te complex zijn voor computers om onder de knie te krijgen.

Ben je niet goed op de hoogte van deze geavanceerde technologieën? Moderne AI-tools zoals Niet-opspoorbare AI's AI chat kan complexe AI-concepten zoals convolutionele neurale netwerken of reinforcement learning uitleggen aan een niet-technisch publiek.

Dezelfde deep learning-technieken die beeldherkenning mogelijk maken, maken ook de huidige taalmodellen mogelijk.

Autonome voertuigen spraken tot ieders verbeelding. Zelfrijdende auto's gingen van sciencefiction naar "komt volgend jaar" (een belofte die nog steeds wordt gedaan, maar tegenwoordig met meer voorzichtigheid).

Virtuele assistenten werden mainstream. Siri, Alexa en Google Assistant brachten AI in miljoenen huishoudens.

Iedereen voerde nu gesprekken met zijn apparaat, zelfs als die gesprekken vooral bestonden uit "speel mijn muziek af" en "wat is het weer?".

Het decennium eindigde met de opkomst van transformatorarchitecturen en aandachtsmechanismen.

Deze innovaties zouden cruciaal blijken voor de volgende fase in de ontwikkeling van AI, ook al hadden de meeste mensen er nog nooit van gehoord.

2020s: Generatieve AI en grote taalmodellen

De jaren 2020 begonnen met een pandemie, maar AI-onderzoekers hadden het te druk met het veranderen van de wereld om het op te merken.

De GPT-modellen van OpenAI groeiden uit van interessante onderzoeksprojecten tot culturele fenomenen. GPT-3 werd gelanceerd in 2020 en verblindde iedereen met zijn vermogen om samenhangende tekst te schrijven over bijna elk onderwerp.

Dan ChatGPT ontstond eind 2022 en brak het internet. Binnen enkele dagen voerden miljoenen mensen voor het eerst gesprekken met AI.

Studenten gebruikten het voor hun huiswerk. Werknemers automatiseerden delen van hun werk. Contentmakers genereerden ideeën sneller dan ooit.

De reactie was onmiddellijk en intens. Sommige mensen waren verbaasd. Anderen waren doodsbang. De meesten zaten er ergens tussenin en probeerden te bedenken wat dit betekende voor hun carrière en de toekomst van hun kinderen.

Generatieve AI werd het grootste techverhaal sinds de iPhone.

Elk bedrijf begon AI-functies toe te voegen. Elke startup beweerde "AI-aangedreven" te zijn.

Elke conferentie had minstens twaalf panels over de toekomst van kunstmatige intelligentie.

Dit is waar tools zoals Undetectable AI's AI SEO Schrijver, AI Essay Schrijveren AI Humanizer passen in het verhaal.

Deze moderne toepassingen vertegenwoordigen de praktische evolutie van generatieve AI-technologie. Ze gebruiken dezelfde onderliggende modellen als ChatGPT en passen deze toe op specifieke toepassingen.

Het genereren van beelden volgde een vergelijkbaar traject. DALL-E, Midjourney en Stable Diffusion konden fotorealistische afbeeldingen maken van tekst beschrijvingen. Kunstenaars waren even opgewonden als bezorgd.

De technologie verbeterde razendsnel. Modellen werden groter, slimmer en capabeler. GPT-4 kon professionele examens afleggen en code schrijven.

Claude kon genuanceerde gesprekken voeren over complexe onderwerpen. Bard kon op het web zoeken en actuele informatie geven.

Belangrijke mijlpalen in de AI-geschiedenis

Sommige momenten in de geschiedenis van AI verdienen speciale erkenning.

Dit zijn niet alleen technische prestaties, maar ook culturele keerpunten die onze manier van denken over kunstmatige intelligentie hebben veranderd.

- De Dartmouth Conferentie (1956) was de officiële start van het vakgebied en gaf AI zijn naam. Zonder deze bijeenkomst zouden we het misschien "machine intelligentie" of "computational thinking" of iets dergelijks saais noemen.

- Deep Blue die Garry Kasparov versloeg met schaken (1997) was het eerste mainstreammoment van AI. Miljoenen mensen zagen hoe een computer een van de grootste strategische breinen van de mensheid te slim af was. De toekomst voelde opeens heel echt en een beetje eng.

- IBM Watson wint bij Jeopardy! (2011) liet zien dat AI overweg kon met natuurlijke taal en algemene kennis. Het was zowel indrukwekkend als verontrustend om een computer de Daily Double te zien doen.

- AlphaGo verslaat Lee Sedol met Go (2016) was een technisch meesterwerk. Go heeft meer mogelijke bordposities dan atomen in het waarneembare universum, maar toch vond het systeem van DeepMind winnende strategieën die menselijke experts nooit hadden overwogen.

- De doorbraak van ImageNet (2012) gaf het startschot voor de deep learning-revolutie. De overwinning van AlexNet in de beeldherkenningswedstrijd bewees dat neurale netwerken klaar waren voor prime time.

- De release van GPT-3 (2020) democratiseerde het genereren van AI-inhoud. Opeens had iedereen toegang tot krachtige taalmodellen via eenvoudige webinterfaces.

- De lancering van ChatGPT (2022) bracht AI naar de massa. Binnen twee maanden had het 100 miljoen gebruikers, waardoor het de snelst groeiende consumentenapplicatie in de geschiedenis werd.

Elke mijlpaal bouwde voort op eerder werk en opende nieuwe mogelijkheden.

Dat is hoe vooruitgang werkt: geleidelijke verbeteringen onderbroken door momenten van doorbraak die iedereen doen heroverwegen wat mogelijk is.

AI Winters en Comebacks

De geschiedenis van AI is geen rechte lijn van vooruitgang. Het lijkt meer op een achtbaan ontworpen door iemand met bindingsangst.

Het vakgebied heeft verschillende "AI-winters" gekend, periodes waarin de financiering opdroogde, onderzoekers van vakgebied veranderden en de media AI dood verklaarden.

Dit waren geen kleine tegenslagen, maar existentiële crises die het AI-onderzoek bijna de das omdeden.

Wat veroorzaakte de AI-winters?

De eerste AI-winter brak aan halverwege de jaren zeventig. Vroege onderzoekers hadden gedurfde voorspellingen gedaan over het bereiken van intelligentie op menselijk niveau binnen tientallen jaren. Toen die voorspellingen niet uitkwamen, kwam de teleurstelling.

Financieringsinstanties van de overheid begonnen ongemakkelijke vragen te stellen. Waar waren de denkmachines die hen beloofd waren?

Waarom waren AI-systemen nog steeds zo beperkt? Wat deden onderzoekers precies met al dat geld?

De Britse regering gaf opdracht voor de Lighthill-rapport in 1973die vond dat AI-onderzoek overhyped was en te weinig opleverde.

De financiering werd drastisch verlaagd. Vergelijkbare onderzoeken in andere landen kwamen tot vergelijkbare conclusies.

De tweede AI-winter brak aan het einde van de jaren 1980 aan nadat de zeepbel van expertsystemen uiteenspatte. Bedrijven hadden zwaar geïnvesteerd in AI-technologie, maar vonden het moeilijk om deze te onderhouden en op te schalen.

De markt stortte in en nam veel AI-startups met zich mee.

Beide winters hadden gemeenschappelijke thema's. Onrealistische verwachtingen leidden tot overdreven beloften. Toen de realiteit niet overeenkwam met de hype, was een reactie onvermijdelijk.

Onderzoekers leerden waardevolle lessen over het managen van verwachtingen en het focussen op praktische toepassingen.

De toekomst van AI: wat is de volgende stap?

De toekomst van AI voorspellen is als het weer proberen te voorspellen met een Magic 8-Ball. Mogelijk, maar je nauwkeurigheid zal waarschijnlijk op niemand indruk maken.

Toch lijkt het waarschijnlijk dat sommige trends zich zullen voortzetten. AI-systemen zullen capabeler en efficiënter worden en meer worden geïntegreerd in het dagelijks leven.

De vraag is niet of AI krachtiger zal worden - de vraag is hoe de maatschappij zich aan die kracht zal aanpassen.

- Generatieve AI zal waarschijnlijk steeds beter worden in het maken van content die niet te onderscheiden is van menselijk werk. Kunstenaars, schrijvers en contentmakers zullen moeten uitzoeken hoe ze kunnen concurreren met of samenwerken met AI-systemen.

- Autonome systemen zullen steeds gewoner worden. Zelfrijdende auto's kunnen eindelijk hun beloften waarmaken. Bezorgingsdrones zouden het luchtruim kunnen vullen. Robotarbeiders zouden gevaarlijke of repetitieve taken kunnen uitvoeren.

- Onderzoek naar AI-veiligheid zal steeds belangrijker worden naarmate systemen krachtiger worden. We hebben betere manieren nodig om ervoor te zorgen dat AI-systemen zich gedragen zoals bedoeld en geen onbedoelde schade veroorzaken.

- De economische gevolgen zijn duizelingwekkend. Sommige banen zullen verdwijnen. Er zullen nieuwe banen ontstaan. De overgang kan soepel of chaotisch verlopen, afhankelijk van hoe goed we ons voorbereiden.

- Regelgeving zal een grotere rol spelen. Regeringen werken al aan kaders voor AI-governance. De uitdaging is om regels op te stellen die mensen beschermen zonder innovatie in de kiem te smoren.

- De democratisering van AI zal doorgaan. Tools waarvoor ooit expertise op PhD-niveau nodig was, worden toegankelijk voor iedereen. Dit kan enorme creativiteit en innovatie ontketenen, maar het kan ook nieuwe problemen creëren die we nog niet hebben voorzien.

Vind hier meer handige tools of probeer onze AI Detector en Humanizer in de widget hieronder!

Dit verhaal schrijft zichzelf... bijna

De geschiedenis van AI is een bewijs van menselijke ambitie, waarbij onmogelijke dromen werkelijkheid worden.

Van de theorieën van Turing tot de generatieve modellen van vandaag, vooruitgang kwam van het aanpakken van onoplosbare problemen met volharding.

Elk tijdperk voelde revolutionair aan, maar het hoge tempo en de schaal van vandaag zijn ongekend.

AI is in feite tientallen jaren werk van briljante geesten. Het verhaal is nog lang niet afgelopen. De volgende doorbraak kan overal vandaan komen en de impact ervan zal afhangen van de keuzes die we nu maken.

We hebben ons duizenden jaren lang kunstmatige breinen voorgesteld en vandaag bouwen we ze.

Met Undetectable AI's AI SEO Writer, AI Chat, AI Essay Writer en AI Humanizer kun je hoogwaardige, natuurlijk klinkende content maken die geoptimaliseerd is, boeit en uniek is voor jou.

Probeer Niet detecteerbare AI en til je AI-gestuurd schrijven naar een hoger niveau.