Det finns en sak som har varit på allas läppar under de senaste åren: ChatGPT.

Lärare oroar sig för att det är att skriva studenternas läxor.

Författarna är rädda för att AI ska skriva böcker och berättelser i stället för dem.

Kodare är rädda för att den ska bygga webbplatser och appar bättre än vad människor kan.

Vissa förutspår till och med att miljontals jobb kan försvinna på grund av AI.

Vi har alla hört talas om det. Men har du någonsin undrat hur ChatGPT fungerar?

Hur skriver ChatGPT ett barns läxor? Vad händer bakom kulisserna när du skriver en fråga och den svarar som en riktig person?

Hur kan en maskin skriva dikter, berättelser och kod, trots att den inte förstår ord på samma sätt som vi gör?

I den här bloggen, vi kommer att titta in ChatGPT och förklara vad ChatGPT är och hur det fungerar, steg för steg.

Du får lära dig hur den kommer ihåg saker, vilka begränsningar den har och hur verktyg som det här överhuvudtaget byggs.

Låt oss komma igång!

Stiftelsen: GPT språkmodeller

ChatGPT är en AI som är skapad för att förstå och skriva som en människa.

Det kallas för en språkmodell eftersom det arbetar med språk - läser det, förutser det och genererar det.

Men den förstår inte som människor gör. Den tänker inte. Den känner inte till fakta. Den tittar bara på mönster.

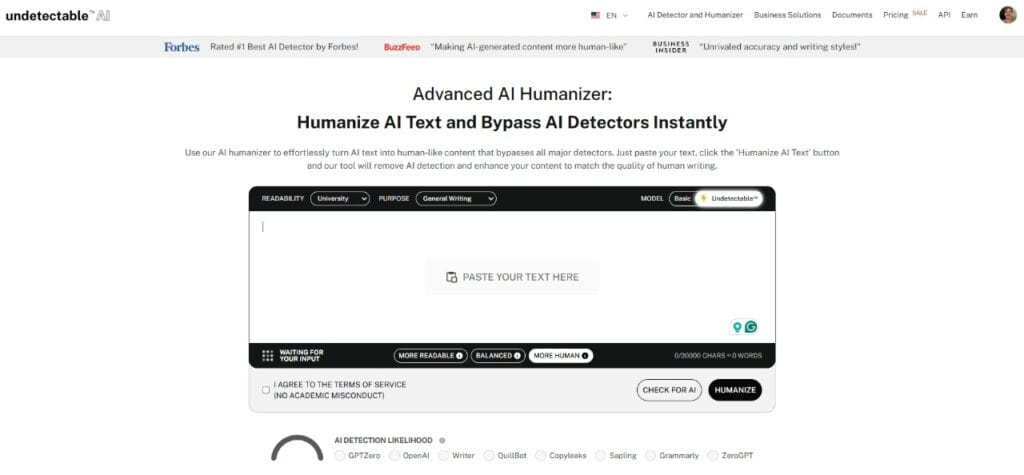

Oroa dig aldrig för att AI upptäcker dina texter igen. Undetectable AI Kan hjälpa dig:

- Få din AI-assisterade skrivning att synas människoliknande.

- Bypass alla större AI-detekteringsverktyg med bara ett klick.

- Användning AI säkert och självsäkert i skolan och på jobbet.

Till exempel,

- Om du skriver, "Himlen är..."

- Det kan stå "Blå."

Inte för att den vet att himlen är blå, utan för att den har sett den meningen miljontals gånger under utbildningen. Den har lärt sig att "blå" ofta kommer efter "himlen är".

Denna typ av AI kallas för en LLM, som står för Stor språkmodell.

Det använder sig av mängder av läroböcker, webbplatser och annat för att ta reda på hur människor använder ord. Men den läser inte efter betydelse. Den lär sig hur ord vanligtvis dyker upp bredvid varandra.

GPT är en särskild typ av LLM.

GPT står för "Generativ förtränad omvandlare."

- Generativ - den kan skapa ny text.

- Förutbildad - den lär sig innan den pratar med dig.

- Transformator - nyckeltekniken bakom hur ChatGPT fungerar som hjälper den att förstå hur ord relaterar till varandra i en mening, ett stycke eller till och med en konversation.

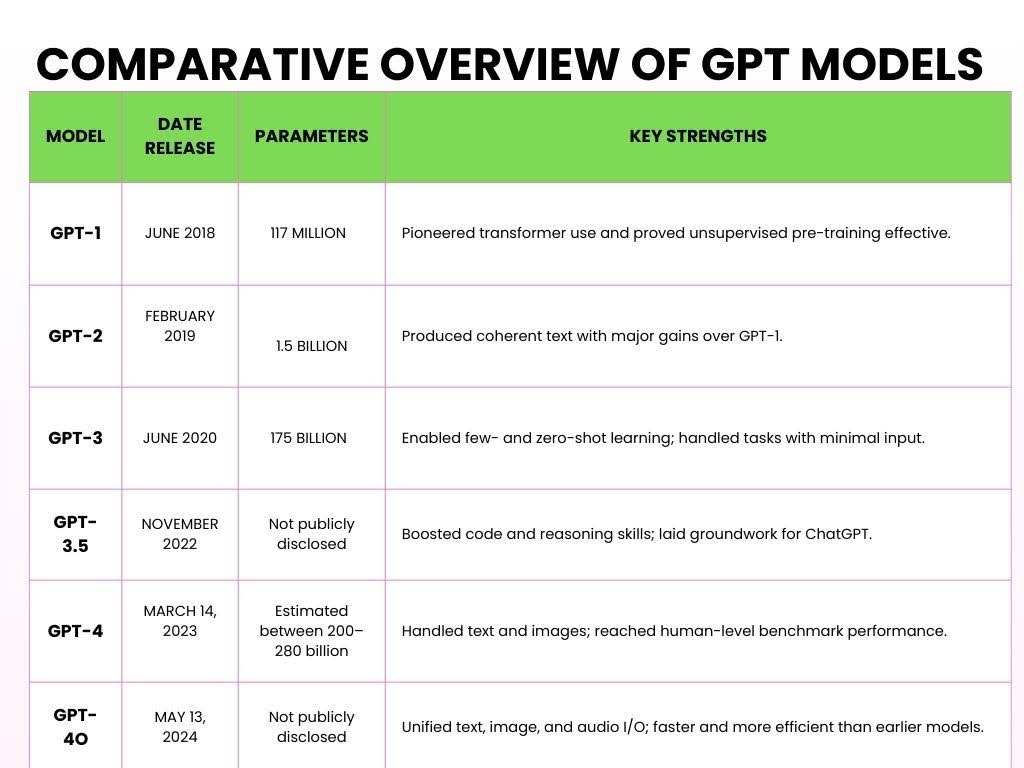

Här är de olika versionerna av GPT som har lanserats genom åren.

Hur ChatGPT fungerar

Här är en förenklad uppdelning av hur ChatGPT fungerar och behandlar din input i fem viktiga steg.

- Steg 1: Förträning på stora datamängder

Stora språkmodeller (LLM) som ChatGPT är förutbildade genom att bearbeta stora mängder text från internet för att lära sig språkmönster.

Under förutbildningen bearbetar modellen biljoner tokens (små bitar av text).

A symbol kan vara ett ord, en del av ett ord eller till och med skiljetecken, beroende på hur modellen tokeniserar indata.

Till exempel,

Du ställer ChatGPT en matematisk fråga, till exempel:

Problem:

- 2 + 3 = ?

Under sin träning läser ChatGPT hundratals miljarder ord från böcker, nyheter, artiklar, Wikipedia, berättelser, vetenskapliga artiklar och till och med Reddit-trådar.

Denna träning och läsning hjälper den att förstå hur addition fungerar.

Till exempel,

Det kan lära sig kommutativ egenskap (t.ex. 2 + 3 = 3 + 2) genom sådana kontexter.

ChatGPT ser många exempel som

- "2 + 3 = 5,"

- "7 + 8 = 15,"

- "9 + 4 = 13."

Den lär sig inte bara de här specifika exemplen, den lär sig additionsmönstret.

Den förstår hur siffror interagerar med "+"-symbolen och hur resultatet vanligtvis följer "="-symbolen.

- Steg 2: Transformatorns arkitektur

När ChatGPT hade sett en enorm mängd ord behövde den en hjärna som kunde förstå all denna information. Denna AI-hjärna kallas "Transformator."

Det som utmärker Transformer är dess förmåga att fokusera uppmärksamhet på de viktigaste delarna av inmatningen, ungefär som hur vi bearbetar språk.

Till exempel,

Låt oss tillämpa detta på ett matematiskt problem:

- "Vad är summan av 5 och 7?"

När Transformer bearbetar detta går den inte bara igenom ord för ord.

Istället tittar den på hela sammanhanget - "summa", "5" och "7" - på en och samma gång.

Det erkänner att "summa" avser "tillägg" och att "5" och "7" är de inblandade siffrorna.

Transformatorn ger sedan mer "uppmärksamhet" till de ord som direkt påverkar svaret, så den fokuserar på operationen ("summa") och siffrorna ("5" och "7").

Detta är en viktig del av hur ChatGPT fungerar - det inte bearbetar problemet linjärt, men på ett sätt som hjälper den att förstå förhållandet mellan elementen.

Det är denna förmåga att se allt i sitt sammanhang som gör Transformer så kraftfull.

I stället för att bara räkna ut vad som kommer härnäst förstår den meningen genom att koppla ihop de relevanta delarna av meningen.

Dessutom innebär det ofta att man måste lära sig ett helt nytt ordförråd när man går med i en ny online-community, men du behöver inte vänta i månader innan du kan börja prata språket.

Dessutom, om du vill att dina meddelanden ska smälta in sömlöst, kan Undetectable AI:s Generator för akronymer låter dig skapa anpassade förkortningar som efterliknar de komplexa mönster som AI-modeller använder för att bearbeta och generera strukturerade språkliga förkortningar.

- Steg 3: Tokenisering och språkbehandling

När du skriver text i ChatGPT delar den upp din uppmaning i små symboler.

Vissa tokens är hela ord, medan andra bara är delar av ord.

Till exempel,

När du matar in "ChatGPT är smart," ChatGPT delar upp det i följande tokens:

["Chat", "G", "PT", "är", "smart"]

Till och med namnet "ChatGPT" delas upp i olika tokens.

Denna process kallas tokenisering. Eftersom modellerna har tränats på tokens i stället för hela ord är det mycket mer flexibelt vad det kan hantera:

Flera språk (eftersom olika språk har olika ordstrukturer),

Slang och förkortningar (t.ex. "u" för "du" eller "idk" för "jag vet inte").

Även påhittade ord eller variationer (som att dela upp "otrolig" i "un", "believ", "able").

- Steg 4: Finjustering och säkerhetslager

När ChatGPT har tränats på en stor mängd data är den inte riktigt redo för prime time.

Den behöver fortfarande hjälp för att kunna svara på ett så användbart, artigt och säkert sätt som möjligt.

Genom övervakad finjusteringger mänskliga granskare ChatGPT exempel på vad som är ett bra svar. Till exempel,

- "Vad är 5 + 7?"

- Dåligt svar: Det är en enkel fråga. Varför vet du inte det här?

- Bra svar: Summan av 5 och 7 är 12.

Med tiden tränas ChatGPT med bättre exempel för att bli mer artig, tydlig och fokuserad.

När den har en solid grund får den mer avancerad hjälp genom Förstärkningsinlärning från mänsklig feedback (RLHF).

Denna process går till på följande sätt:

- ChatGPT svarar.

- Människor hastighet Det svaret baseras på hur bra det är - hur användbart, korrekt och säkert det är.

- ChattGPT lär sig av denna feedback och försöker ge bättre svar i framtiden.

Till exempel, Tänk dig att ChatGPT svarar på ett matematiskt problem, till exempel "Vad är 12 dividerat med 4?":

- ChatGPT svarar: "3."

- Mänsklig feedback: Det här svaret är bra.

- ChatGPT lär sig: Den fortsätter att ge denna typ av svar när liknande frågor kommer upp.

Målet är att ChatGPT ska fortsätta att bli bättre, precis som en student som lär sig av tidigare misstag.

Slutligen är ett viktigt syfte med finjustering av människor att överensstämmer med mänskliga värderingar.

Vi vill att den inte bara ska vara smart, utan också hjälpsam, ofarlig och ärlig.

Till exempel, om en användare ställer en komplex fråga som t.ex, "Vad är kvadratroten ur -1?"

Istället för att ge ett felaktigt svar som "i är svaret" utan något sammanhang, skulle det ge:

Säkert, anpassat svar: Kvadratroten ur -1 är ett imaginärt tal, vanligen representerat som "i". Detta begrepp används inom avancerad matematik.

- Steg 5: Prompt in, svar ut

Detta är det sista steget där ChatGPT är redo att svara på dina frågor.

En prompt är den text (t.ex. fråga, kommando eller uttalande) som du skriver in i ChatGPT för att starta konversationen och få ett svar.

Till exempel,

Du kommer till prompten "Vad är det för väder idag?"

Här är hur fungerar ChatGPT bakom kulisserna:

Du skriver in en fråga → ChatGPT delar upp den i symboler → Den letar efter mönster i symbolerna → Förutspår nästa ord → Formar ett svar → Justerar tonen baserat på din text → Får ditt slutliga svar

För uppmaningen "Vad är det för väder idag?", ChatGPT skulle sannolikt svara med något liknande:

"Jag kan inte ge väderuppdateringar i realtid, men du kan kolla en vädersajt eller app som Weather.com eller dina lokala nyheter för den mest exakta informationen."

Detta beror på att ChatGPT inte har tillgång till live-data om det inte är anslutet till ett verktyg som hämtar information i realtid.

Hur den "minns" konversationer

När du pratar med ChatGPT verkar det som om den kommer ihåg saker du sa tidigare.

Och det gör det - men bara så länge chatten är öppen. Föreställ dig ett stort anteckningsblock där allt du skriver skrivs ner:

Det säger du:

- Min hund heter Max.

Några rader senare säger du:

- Vilka knep kan Max lära sig?

ChatGPT kopplar ihop prickarna. Den kommer ihåg att Max är din hund, eftersom det fortfarande står på anteckningsblocket.

Detta anteckningsblock kallas för en kontextfönster, och den innehåller ett begränsat antal ord (s.k. tokens).

Vissa versioner rymmer cirka 8.000 tokens, medan de nyaste kan gå upp till 32.000 tokens.

Men när du når gränsen måste den börja radera de äldsta delarna för att ge plats åt ny text.

Så om du säger "Min hund heter Max" långt tillbaka i början av en lång chatt - och sedan 50 stycken senare fråga, "Vad är ett bra koppel för honom?" - kan det glömma vem "han" är.

För den informationen har redan raderats från anteckningsblocket.

Låt oss nu prata om minne mellan chattar.

När du stänger chatten raderas normalt anteckningsblocket.

Så nästa gång du öppnar ChatGPT börjar det på nytt.

Men om du aktiverar anpassat minne kan ChatGPT komma ihåg saker mellan olika sessioner. Till exempel,

- Det kan du berätta: Jag driver ett litet onlinebageri som heter Sweet Crumbs.

- En vecka senare säger du det: Skriv en produktbeskrivning till mig.

- Det kan svara: Visst! Här är en beskrivning av dina Sweet Crumbs-kakor...

Den kommer inte ihåg allt. Den kommer bara ihåg det du tillåter, och du får veta när något läggs till. Du kan se, redigera eller ta bort minnen när som helst.

Så den låga nedgången är ...

ChatGPT gör faktiskt inte "minns" som en person. Den tittar bara på det som finns framför den - det aktuella samtalet.

Om det ser ut som om den kommer ihåg något från tidigare beror det på att den informationen fortfarande finns i kontextfönstret.

Begränsningar av hur ChatGPT fungerar

ChatGPT är otroligt användbart, men det är viktigt att förstå dess begränsningar, särskilt om du använder det för något kundinriktat eller konverteringsdrivet.

1 - Ingen verklig förståelse eller medvetenhet

ChatGPT förstår inte innehåll som människor gör. Den "känner inte till" fakta - den förutspår helt enkelt nästa sannolika ord baserat på träningsdata.

Till exempel,

Om du frågar, "Vad betyder framgång?" kan det generera ett flytande svar, men det har inga övertygelser, värderingar eller medvetenhet. Den härmar mönster, inte skapar insikter.

2 - Felaktigheter från träningsdata

Eftersom ChatGPT tränas på stora, blandade källor från internet, böcker, forum och artiklar, kan det ärva fördomar som finns i dessa data.

Om internet lutar åt ett håll i ett ämne kan ChatGPT spegla det perspektivet - ibland subtilt, ibland inte - även när neutralitet krävs.

3 - Surfar inte på internet

ChatGPT kan inte hämta data i realtid. Fråga den om en produkt som lanserades förra veckan eller om aktiekursen idag, och den kommer inte att ha en aning.

Dess träningsdata har en gräns, och allt efter den punkten är utom räckhåll.

4 - Kan "hallucinera" fakta eller hänvisa till falska källor

En av de farligare konstigheterna: ChatGPT kan hitta på saker. Be den om en statistik eller ett citat, och den kan svara,

"Enligt Världshälsoorganisationen föredrar 80% av alla vuxna märke X framför märke Y."

Det låter officiellt - men den statistiken finns sannolikt inte.

Den återfanns inte, den uppfanns. Denna fråga är känd som hallucinationoch det är särskilt riskabelt i forskning, journalistik eller tekniskt innehåll.

Om du frågar ChatGPT hur det fungerar, kommer du att se att det inte alltid är faktamässigt korrekt.

Om du använder ChatGPT för att skriva skulle resultatet kännas stelt, robotaktigt eller sakna den där mänskliga känslan.

För sådana nyanser kan du använda AI Humanizer.

Den AI Humanizer skriver om ChatGPT-utdata för ton, nyans och känsla, vilket ger ditt innehåll en hjärtslag.

Den mjukar upp besvärliga fraseringar, tillför värme, och får tekniska eller torra texter att väcka genklang hos din publik.

När ditt innehåll låter mänskligt fungerar det bättre.

Oavsett om du skriver landningssidor, e-postmeddelanden eller LinkedIn-inlägg är det relaterbarhet som driver respons. Och känslor driver konvertering.

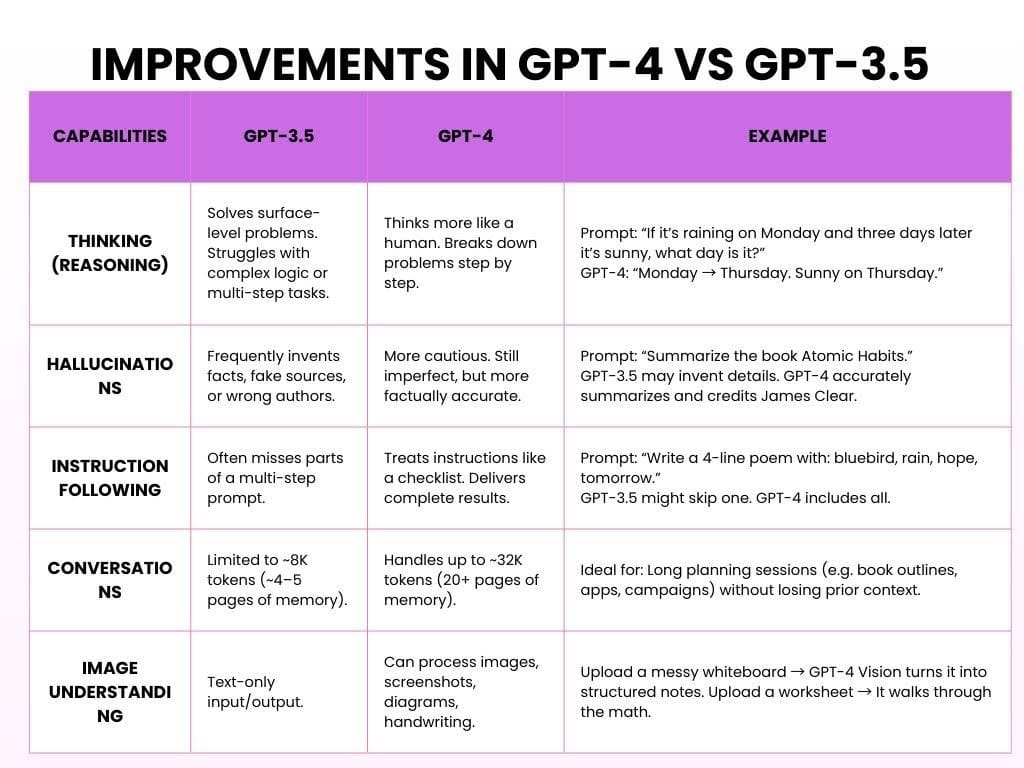

Förbättringar i GPT-4 jämfört med GPT-3.5

GPT-3.5 är gratisversionen, som är snabb, solid och perfekt för enkla uppgifter. GPT-4 är en betalversion av OpenAI som är smartare, kraftfullare och mycket mer användbar.

Så här fungerar ChatGPT med båda modellerna:

Slutsatsen är att GPT-3.5 var till stor hjälp. GPT-4 är pålitlig, genomtänkt och det känns som om den lyssnar.

Börja utforska - vår AI Detector och Humanizer väntar i widgeten nedan!

Hur AI-verktyg som ChatGPT är uppbyggda

Att skapa en AI som ChatGPT eller andra stora språkmodeller är ett flerårigt projekt som involverar massiva datamängder, expertteam och obeveklig iteration.

Så här går det vanligtvis till:

- Fas ett: Datainsamling (6-12 månader)

Målsättning: Lär ut modellens språkmönster.

Innan en AI kan svara på frågor måste den lära sig hur människor skriver och talar.

Det börjar med att vi samlar in hundratals miljarder ord från böcker, webbplatser, nyheter, artiklar, akademiska uppsatser med mera.

Den "läser" inte som människor. Istället identifierar den mönster, precis på det sätt som vi har förklarat i avsnitten ovan.

Tidsåtgång: 6-12 månader, beroende på omfattning och teamstorlek.

- Fas två: Förträning av modellen (6-9 månader)

Målsättning: Bygg upp hjärnan.

Förträning innebär att man matar modellen med stora textvolymer och låter den förutsäga ord som saknas om och om igen tills den börjar få rätt.

Denna fas kräver ofta kraftfulla GPU-kluster och hundratals miljoner dollar i beräkningsresurser.

Tidsåtgång: 6-9 månader av oavbruten GPU-träning.

3. Fas tre: Finjustering och mänsklig feedback (3-6 månader)

Målsättning: Gör AI användbar.

Nu kan den tala - men är det vettigt? Kanske eller kanske inte. Vid denna tidpunkt betygsätter mänskliga granskare utdata, korrigerar misstag och guidar modellen med hjälp av Reinforcement Learning from Human Feedback (RLHF).

Tidsåtgång: 3-6 månader, ofta parallellt med tidiga tester.

4. Fas fyra: Driftsättning och infrastruktur (fortlöpande)

Målsättning: Gör den skalbar.

När modellen har tränats distribueras den över webbplatser, appar, API:er och företagsplattformar. Detta kräver en seriös backend-infrastruktur: datacenter, API:er med automatisk skalning och lastbalanseringssystem för att hantera miljontals samtidiga användare.

Tidsram: Påbörjas efter utbildning, men fortsätter på obestämd tid.

5. Fas fem: Säkerhet, partiskhet och etik (Pågående, parallellt)

Målsättning: Håll det säkert, ärligt och icke-skadligt.

AI handlar inte bara om intelligens - det handlar också om ansvar. Etiska team arbetar parallellt med att flagga för potentiellt missbruk, minska fördomar, blockera skadligt innehåll och upprätthålla integritetsstandarder. De utvärderar ständigt hur modellen beter sig i den verkliga världen.

Tidsram: Livslång process; inbäddad i varje steg ovan.

Vanliga frågor om hur ChatGPT fungerar

Söker ChatGPT på internet efter svar?

Från och med oktober 2024 fick ChatGPT möjlighet att surfa på internet i realtid.

Denna funktion var ursprungligen exklusiv för betalande användare, men i december 2024 blev den tillgänglig för alla.

Är det som en chatbot eller något mer?

ChatGPT är en generativ AI-modell. Generativ AI genererar dynamiska, kontextmedvetna svar med hjälp av djupinlärning.

Utöver chattar kan generativ AI skriva uppsatser, generera bilder, komponera musik och till och med skapa videor, vilket visar på dess mångsidighet inom olika områden.

Tycker ChatGPT det?

Nej, ChatGPT tänker inte på samma sätt som människor gör. Den har inte medvetenhet, övertygelser, avsikter eller känslor.

Vad den gör är att statistiskt förutsäga nästa ord i en mening baserat på mönster från dess träningsdata. Det här kan se ut som tänkande, men det är det inte.

Avslutande tankar

Stora språkmodeller (LLM) har förändrat hur vi interagerar med teknik.

De kan skapa text som låter som om den är skriven av en människa och hjälpa till med uppgifter som att svara på frågor och skapa kreativt innehåll.

Men LLM:er gör det inte "förstå" saker eller tänka som människor. De fungerar genom att förutsäga mönster i data, inte genom verkliga mänskliga tankar.

I takt med att LLM blir bättre måste vi tänka på de problem som de kan orsaka, till exempel fördomar, integritetsfrågor och missbruk.

Det är viktigt att använda AI med försiktighet och se till att det är rättvist, transparent och inte sprider falsk information eller skadar den personliga integriteten.

Här är de riktlinjer för användning:

- Var medveten om att AI kan vara partiskt i sitt innehåll.

- Använd AI-verktyg på ett sätt som följer sekretessreglerna.

- Dubbelkolla viktig information från tillförlitliga källor.

- Förlita dig inte för mycket på AI. Det är ett verktyg, inte en ersättning för mänskligt tänkande.

I takt med att AI-tekniken blir allt mer kraftfull uppstår frågan: Hur kan vi se till att dess framsteg främjar mänsklig kreativitet och beslutsfattande, snarare än att ersätta just det som gör oss till unika människor?