As ferramentas de IA generativa transformaram as deepfakes de pesquisa científica em uma grande preocupação pública. As pessoas demonstram medo em relação à mídia sintética e, ao mesmo tempo, demonstram incapacidade de detectá-la, de acordo com os resultados da pesquisa de junho de 2025.

O FBI afirma que a tecnologia deepfake de IA permite atividades criminosas por meio de três métodos principais, que incluem mensagens de spam geradas por IA, personas de mídia social criadas por IA e sites de phishing codificados por IA.

O objetivo desses esquemas é atingir tanto organizações empresariais quanto consumidores individuais para exploração financeira. A combinação da tecnologia deepfake com IA resultou em mais de $200 milhões em perdas durante 2025.

A maioria dos americanos (85%) perdeu a confiança nas informações on-line durante o ano passado por causa de deepfakes e 81% temem danos pessoais causados por conteúdo falso de áudio e vídeo. Mais de 90% dos usuários não utilizam ferramentas de detecção. Os dados indicam uma "lacuna de confiança" crescente que exige intervenção imediata dos órgãos reguladores, operadores de plataformas e tecnólogos.

Principais conclusões

| Insight | Dados de apoio |

|---|---|

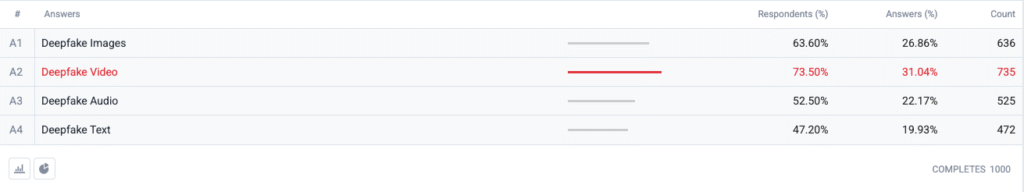

| O vídeo Deepfake está no topo do índice de medo. | 73,5 % dos entrevistados escolheram o vídeo deepfake como o formato com o qual estão "mais preocupados", seguido por imagens (63,6 %), áudio (52,5 %) e texto (47,2 %). |

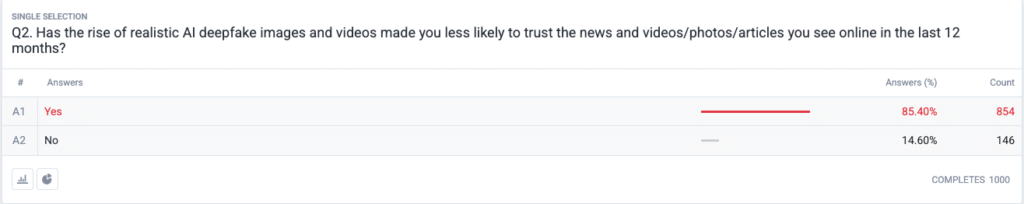

| Está ocorrendo uma crise de confiança total. | 85,4 % relatam que se tornaram menos propensos a confiar em notícias, fotos ou vídeos on-line nos últimos 12 meses devido a deepfakes realistas. |

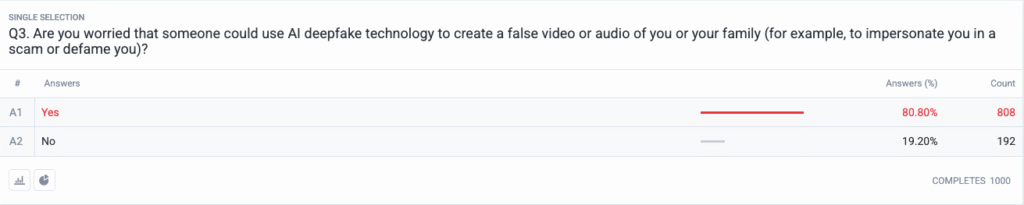

| As ameaças pessoais se tornaram comuns. | 80,8 % temem que golpistas ou agentes mal-intencionados possam usar conteúdo deepfake como arma contra eles ou suas famílias. |

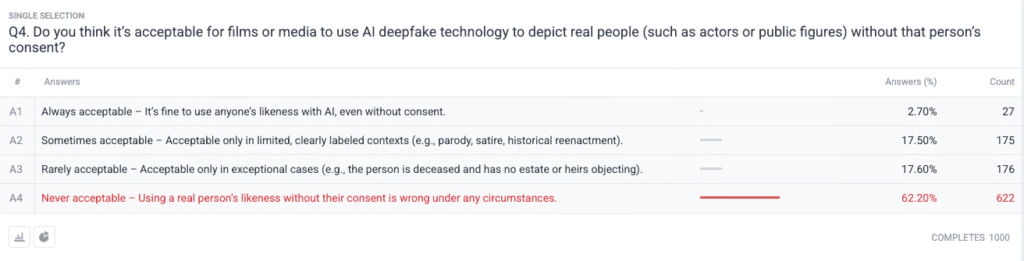

| Forte consenso moral sobre o consentimento. | 62,2 % afirma que usar a imagem de uma pessoa real sem permissão é nunca aceitável; apenas 2.7 % dizem que é sempre aceitável. |

Metodologia

- Amostra e trabalho de campo. Recrutamos 1.000 adultos dos EUA usando cotas de idade, gênero e regionais alinhadas com as referências do Censo dos EUA. O trabalho de campo foi concluído em 18 de junho de 2025.

- Design da pergunta. Cinco perguntas fechadas mediram a preocupação com diferentes formatos de deepfake, mudanças recentes na confiança, percepção de risco pessoal, visões éticas sobre consentimento e uso prévio de software de detecção.

- Margem de erro. ±3,1 pontos percentuais no nível de confiança de 95 %.

- Ponderação. A ponderação pós-estratificação corrigiu pequenos desvios dos dados demográficos nacionais.

Perguntas

Q1: Com qual forma de IA Deepfakes você está mais preocupado? (Escolha todas as opções aplicáveis)

P2: O surgimento de imagens e vídeos realistas com IA deepfake tornou menos provável que você confie nas notícias e nos vídeos/fotos/artigos que viu on-line nos últimos 12 meses?

P3: Você teme que alguém possa usar a tecnologia deepfake de IA para criar um vídeo ou áudio falso seu ou de sua família (por exemplo, para se passar por você em um golpe ou difamá-lo)?

P4: Você acha aceitável que filmes ou mídia usem a tecnologia deepfake de IA para retratar pessoas reais (como atores ou figuras públicas) sem o consentimento dessas pessoas?

Análise de tendências

- A ansiedade do vídeo supera a de outros formatos

No passado, o vídeo era uma mídia confiável na qual as pessoas acreditavam quando o viam. As preocupações com o vídeo sintético agora dominam as mentes dos americanos, pois o vídeo perdeu seu status de confiável. As pessoas temem o vídeo mais do que as imagens por uma margem de 10 pontos (73,5% vs. 63,6%) porque o movimento do vídeo combinado com a voz sincronizada e a aparência realista intensifica suas preocupações. As organizações de mídia devem implementar procedimentos rigorosos de autenticação para o conteúdo de vídeo antes de divulgá-lo ao público.

- Erosão da confiança nas informações

A queda maciça nos níveis de confiança entre o público demonstra uma dúvida generalizada sobre todo tipo de conteúdo digital, independentemente de sua óbvia falta de credibilidade. A teoria do "discurso barato" demonstra como a facilidade de fabricação fez com que a verificação da verdade se tornasse responsabilidade do consumidor. As figuras públicas e os jornalistas, juntamente com os formuladores de políticas, precisam se preparar para um maior monitoramento, investindo em métodos de verificação claros (como marcas d'água criptográficas e metadados assinados).

Nunca mais se preocupe com a detecção de seus textos pela IA. Undetectable AI Pode lhe ajudar:

- Faça sua escrita assistida por IA aparecer semelhante ao humano.

- Bypass todas as principais ferramentas de detecção de IA com apenas um clique.

- Uso IA com segurança e com confiança na escola e no trabalho.

- Deepfakes se tornam pessoais

A maioria dos entrevistados (85%) imagina que eles mesmos ou seus familiares serão vítimas de ataques de deepfake. A percepção de deepfakes como ferramentas de desinformação política com foco em eleições e celebridades mudou para incluir ameaças pessoais nos últimos ciclos. A disseminação de aplicativos de clonagem de voz e troca de rosto com IA tornou o roubo de identidade e os golpes financeiros ameaças plausíveis para as famílias comuns, o que desencadeou demandas por melhores mecanismos de recurso das vítimas e leis de proteção de identidade.

- Demanda quase universal por consentimento

A pergunta ética da pesquisa revela como a comunidade de Hollywood continua dividida em relação a atores sintéticos e apresentações póstumas. A forte posição pública contra a violação dos direitos individuais surgiu como a opção "nunca aceitável", que recebeu o apoio de 62,2% dos participantes. As autoridades públicas devem usar essas evidências para criar leis que exijam o consentimento explícito dos indivíduos antes de criar representações de semelhanças geradas por IA e garantir a divulgação adequada dos rótulos.

- Lacuna de prontidão e oportunidade de educação

Embora exista uma grande preocupação com o problema, 89,5% dos entrevistados não usaram ferramentas de detecção. O mercado mostra um potencial latente, pois os níveis de interesse excedem os recursos de uso atuais, o que indica problemas de usabilidade e conscientização e dúvidas sobre a eficácia. A IA indetectável, juntamente com outros participantes do setor, deve criar processos de integração simples e, ao mesmo tempo, adicionar ferramentas de detecção às plataformas dos consumidores e desenvolver programas educacionais que expliquem a tecnologia de IA ao público.

Implicações para as partes interessadas

| Partes interessadas | Conclusões práticas |

|---|---|

| Notícias e plataformas sociais | Implemente padrões de mídia autenticada (C2PA, proveniência W3C) e crachás de "origem verificada" para reconstruir a confiança do público. |

| Estúdios de entretenimento | Institua contratos explícitos de adesão para semelhanças sintéticas e adote divulgações na tela quando a recreação com IA for usada. |

| Reguladores | Avançar os projetos de lei sobre direito de publicidade e rotulagem de deepfake para alinhar-se às expectativas de consentimento público. |

| Empresas e marcas | Monitore proativamente as imagens da marca em busca de manipulações e instrua os funcionários sobre como identificar conteúdo suspeito. |

| Consumidores | Procure ferramentas de detecção confiáveis e pratique a higiene digital "pausar, verificar, compartilhar" antes de ampliar a mídia. |

Comentários

Coletamos respostas adicionais dos participantes da pesquisa relacionadas ao seu uso de ferramentas de detecção de falsificações profundas com IA, o que revelou que alguns já as estão usando e que uma grande parte dos indivíduos disse que não as conhecia, mas que está interessada em saber mais. Os dados completos da pesquisa estão disponíveis mediante solicitação.

Este relatório é um resumo de IA de nossas descobertas completas, que estão disponíveis mediante solicitação. Esta pesquisa foi realizada em colaboração com TruthScanuma solução de detecção de deepfake e antifraude de IA.

Conclusão

As preocupações com o Deepfake em 2025 são definidas por um paradoxo gritante: alarme público crescente que se cruza com uma ação protetora mínima. Com a confiança em declínio, as organizações enfrentam uma necessidade urgente de verificar, rotular e autenticar o conteúdo digital.

Uso justo

Fique à vontade para usar essas informações em um artigo ou postagem de blog, desde que nos forneça um link e uma citação. Para ter acesso ao conjunto completo de dados da pesquisa, não hesite em entrar em contato conosco diretamente.

Para consultas à imprensa ou acesso a crosstabs completas, entre em contato com [email protected] ou [email protected]