Con la indicador AI derechopuedes hacer básicamente cualquier cosa. Así de potentes son ya las herramientas de IA.

Las herramientas de IA han reconfigurado el funcionamiento de las empresas, permitiéndoles agilizar los procesos e impulsar la eficiencia como nunca antes.

Un área en la que la IA realmente destaca es la creación de contenidos. No estamos hablando sólo de redactar esquemas o generar publicaciones en las redes sociales.

La IA puede incluso ayudarte escribir libros y completar trabajos de investigación complejos.

Pero un gran poder conlleva una gran responsabilidad, y no siempre se puede confiar en que la IA haga lo correcto.

A veces, la IA produce lo que se conoce como "alucinaciones". Se trata de resultados incorrectos o extraños que pueden confundir a los usuarios.

Casi nueve de cada diez ingenieros de datos que trabajan con IA generativa afirman experimentar estas alucinaciones en sus modelos.

No es una bala de plata, pero la "conexión a tierra" pretende garantizar que los resultados de la IA se basen en información fiable.

Aunque pueda parecer complejo, la respuesta a la pregunta "¿Qué es el enraizamiento y las alucinaciones en la IA?" es crucial para cualquiera que utilice estas potentes herramientas.

Entremos en los detalles de la alucinación de la IA para que puedas maximizar con confianza tu rendimiento con la IA, asegurándote al mismo tiempo de que tu información sigue siendo exacta.

¿Qué es la conexión a tierra y las alucinaciones en la IA?

Cuando se trata de entender qué es la alucinación en la IA, saber cómo puede producirse es especialmente útil para las organizaciones que requieren una información lo más precisa posible.

Aprendiendo sobre la conexión a tierra y las alucinaciones de la inteligencia artificial, podrás entender mejor cómo funcionan las herramientas de IA y garantizar que tu Contenidos generados por IA sigue siendo creíble.

¿Qué son las alucinaciones en la IA?

Imagina que pides a un chatbot de IA información sobre una persona.

No vuelvas a preocuparte de que la IA detecte tus textos. Undetectable AI puede ayudarle:

- Haz que aparezca tu escritura asistida por IA de aspecto humano.

- Bypass las principales herramientas de detección de IA con un solo clic.

- Utilice AI de forma segura y con confianza en la escuela y el trabajo.

El modelo proporciona con precisión detalles mencionados con frecuencia en distintas fuentes online.

Pero entonces, al cotejar la información facilitada, te das cuenta de que la IA también adivina incorrectamente información menos conocida, como su edad y formación académica.

Estos detalles erróneos son lo que se conoce como "alucinaciones".

Tasas de alucinación puede variar entre modelos. ChatGPT tiene una tasa de alucinación de unos 3%, mientras que los sistemas de Google tienen tasas de hasta 27%.

Estos chatbots están dirigidos por un gran modelo lingüístico que aprende del análisis de cantidades masivas de texto.

Esto ocurre porque estos modelos están entrenados para predecir palabras basándose en patrones de los datos que han analizado, sin entender qué es cierto o no.

Las alucinaciones proceden sobre todo de datos de entrenamiento incompletos.

Recuerda que el modelo puede captar y reproducir errores en función de lo que se le alimente.

También existe el "sobreajuste", cuando el modelo identifica patrones o conexiones falsas en los datos.

Resolver las alucinaciones de la IA es un reto porque estos modelos, que operan sobre probabilidades y patrones, producirán inevitablemente resultados falsos.

Esto puede inducir a error a los usuarios, que podrían confiar en el contenido de la IA tal cual. Por eso es importante ser consciente de esta limitación al utilizar la IA para la creación de contenidos y la comprobación de hechos.

¿Qué es la conexión a tierra de la IA?

La conexión a tierra de la IA es un método eficaz para reducir las alucinaciones. Funciona anclando las respuestas de la IA a los datos del mundo real.

Por ejemplo, un sistema fundamentado utilizaría una base de datos fiable desde el principio para proporcionar respuestas basadas en hechos, reduciendo la probabilidad de que la IA se invente cosas.

En lugar de confiar sólo en predecir la siguiente palabra basándose en patrones, un sistema fundamentado recupera primero la información de una fuente creíble.

El modelo también es éticamente más aceptable porque admite que el contexto es insuficiente, por lo que no podrá proporcionar toda la información que necesitas, en lugar de limitarse a adivinar.

Para maximizar el valor de la IA al tiempo que se minimizan las imprecisiones, las organizaciones deben invertir tiempo por adelantado en recopilar datos de entrenamiento precisos, directrices y otra información básica necesaria.

Esta preparación ayuda a que los resultados de la IA se basen en la realidad y los usuarios puedan confiar en ellos.

Así que, aunque la conexión a tierra no es una solución infalible, puede mejorar significativamente la calidad de los resultados de la IA.

¿Cuál es el problema de la alucinación de la IA en la creación de contenidos?

En la creación de contenidos, las alucinaciones de la IA pueden adoptar distintas formas.

Al crear una entrada de blog o un artículo, la IA puede incluir hechos falsos, estadísticas incorrectas o citas inventadas.

La alucinación de la IA tampoco es un engaño intencionado. El modelo no puede mentir, ya que no tiene ninguna motivación para engañar, ni es consciente de que lo que dice es falso.

Simplemente carece de un sentido de la fiabilidad de sus resultados.

Las consecuencias de las alucinaciones de la IA en la creación de contenidos pueden ser graves.

- Difusión de información errónea: Más de dos de cada diez personas admiten que pueden haber compartido noticias falsas sin comprobarlo. Los contenidos de IA que incluyen alucinaciones pueden contribuir a esta propagación de la desinformación.

- Daño a la credibilidad: Si una persona o empresa publica contenidos con información engañosa, su reputación puede verse afectada. La confianza es crucial para los usuarios, y una vez perdida, puede ser difícil recuperarla de nuevo.

- Repercusiones jurídicas y financieras: Publicar información falsa puede acarrear posibles quebraderos de cabeza, incluso demandas judiciales. Es una batalla costosa con la que no querrás encontrarte.

- Impacto negativo en las decisiones empresariales: Las empresas que confían en la IA para elaborar informes y perspectivas para la toma de decisiones pueden tomar malas decisiones basadas en datos incorrectos.

La información falsa perjudica tanto a la audiencia como a la empresa o persona que utiliza la IA para la creación de contenidos.

Y las alucinaciones de la IA pueden agravar este problema al generar contenidos que parecen creíbles pero que en realidad son defectuosos.

Cómo evitar los problemas causados por las alucinaciones de la IA

Sabemos lo valiosas que son las herramientas de IA en la creación de contenidos. El uso de la IA se considera incluso una de las mejores formas de ganar dinero hoy y para seguir siendo competitivos en el sector.

También es la razón por la que abordar el problema de las alucinaciones de la IA es crucial para garantizar que el contenido que utilizas con la IA es preciso.

Comprender las limitaciones de la IA

Aunque ya sabemos lo poderosa que es la IA, tiene sus limitaciones.

En cuanto a la creación de contenidos, funciona muy bien en el reconocimiento de patrones y en la generación de texto basado en enormes conjuntos de datos, pero sigue careciendo de sentido de la realidad.

Ten en cuenta estas limitaciones cuando utilices la IA:

- Le cuesta entender el contexto o comprender las sutiles distinciones culturales

- Depende en gran medida de la calidad y cantidad de información disponible

- Tendencia a crear sesgos basados en los datos de entrenamiento

- Carece de creatividad y originalidad humanas

- Puede generar contenidos moralmente cuestionables

- Tiene problemas para resolver problemas fuera de lo que el sistema conoce

- Dificultad para adaptarse a situaciones cambiantes o para proporcionar información en tiempo real

- Vulnerable a los ataques y puede comprometer la privacidad de los datos

Conocer sus límites también evita las alucinaciones de la IA. Los límites ayudan a establecer expectativas realistas y facilitan la detección de imprecisiones antes de que se hagan públicas.

Utiliza modelos y herramientas fiables

En mejores herramientas de IA para la creación de contenidos facilitan las cosas. Estas herramientas no son perfectas, pero las que utilices deberían hacer bien el trabajo.

Para los chatbots de IA, ChatGPT sigue siendo el el más fuerte que existe. El GPT-4 tiene un alto índice de precisión de 97% y el menor índice de alucinaciones ChatGPT.

Sólo asegúrate de dar indicaciones claras y de comprobar los resultados con fuentes fiables.

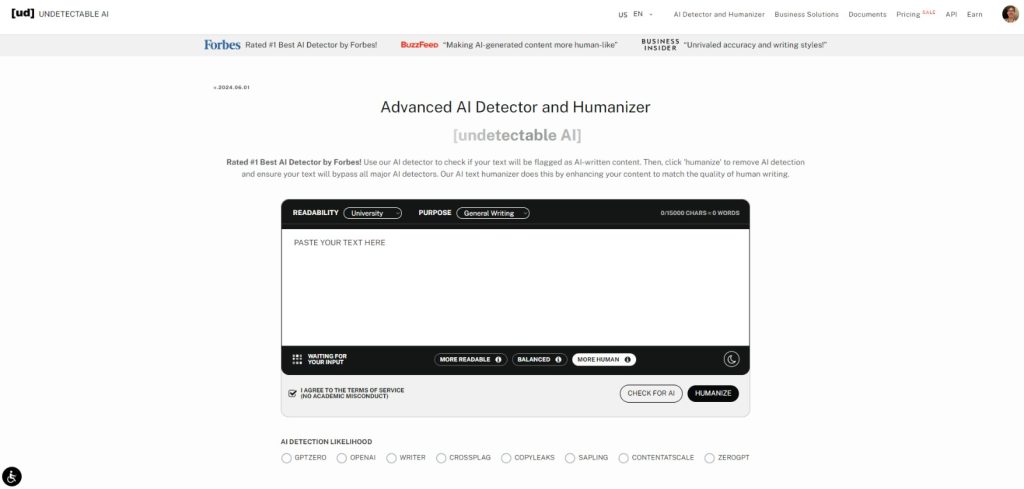

También deberías utilizar herramientas de detección de IA de confianza como IA indetectable.

Los detectores analizan el contenido con eficacia para detectar incluso los elementos de IA más sutiles, manteniendo la autenticidad en cualquier contenido que produzcas y conservando tu credibilidad.

Indetectable también tiene un Humanizador de IA que refina aún más el texto para que suene natural.

Con él, no sólo pasas la detección de IA, sino que también garantizas la calidad de tu contenido.

¡Prueba ahora el widget IA Indetectable! Sólo tienes que pegar tu texto y hacer clic en "Buscar IA": es rápido y fácil.

Verificar contenido

Independientemente de cómo utilices la IA en el proceso de creación de contenidos, siempre es importante verificar el contenido que has producido.

Estas son algunas formas habituales de verificar el contenido de la IA:

- Verificación cruzada comparando la información de varias fuentes fiables

- Utiliza herramientas de comprobación de hechos para agilizar la desinformación

- Busca opiniones de expertos en la materia o profesionales del sector

- Hacer que el contenido sea revisado por compañeros o colegas para ayudar a identificar posibles errores, prejuicios o inexactitudes

- Utiliza software de detección de IA para garantizar la originalidad y evitar plagio involuntario

- Ten en cuenta el contexto histórico cuando hagas referencia a acontecimientos o datos para que sean precisos

Tomar precauciones merece la pena. Verificar el contenido de la IA te da la confianza necesaria de que lo que produces es siempre digno de confianza.

Proporciona instrucciones claras

Una de las causas principales de la alucinación con IA son las instrucciones poco claras.

Si haces a la IA preguntas demasiado vagas sin contexto adicional, es más probable que genere respuestas sin mucho sentido.

Las indicaciones claras y específicas son las que mantienen a la IA en el buen camino.

Por tanto, sé específico y detallado en tus indicaciones.

En lugar de hacer preguntas demasiado amplias, como "¿Cuál es el mejor restaurante asiático?", prueba con algo más centrado, como "¿Cuáles son las tiendas de ramen mejor valoradas de Kioto?".

La especificidad ayuda a la IA a mantener el rumbo y producir resultados precisos que cumplan tus expectativas.

Mantente al día

La tecnología sigue avanzando, y a un ritmo vertiginoso, así que asegúrate de mantenerte al día.

La IA aprende esencialmente de los datos con los que se entrena, pero la información puede quedar obsoleta rápidamente.

Esto es especialmente cierto en campos que evolucionan rápidamente, como la investigación científica o la sanidad.

Puedes mantenerte informado siguiendo fuentes de confianza en las redes sociales, o puedes hacer cursos relacionados con tu sector y asistir a eventos del sector.

De este modo, tendrás una idea de que el contenido proporcionado por la IA sigue siendo creíble.

Las propias herramientas de IA también se actualizan con bastante frecuencia, así que mantente al tanto de los últimos avances para estar siempre seguro de que utilizas las mejores.

Experiencia humana

Experiencia humana es necesaria, por muy avanzadas que estén las cosas.

Al fin y al cabo, en última instancia somos nosotros quienes aportamos el pensamiento crítico, la creatividad y el juicio ético.

Combinando las capacidades de la IA con la supervisión humana, puedes verificar que el contenido no sólo es preciso, sino también contextualmente relevante, además de atractivo y acertado.

Los expertos humanos pueden detectar prejuicios, verificar la información y tomar decisiones que la IA por sí sola no sería capaz de comprender.

Los humanos y la IA, juntos, pueden crear contenidos fiables, perspicaces e impactantes.

Conclusión

Comprender qué es el enraizamiento y las alucinaciones en la IA es esencial para cualquiera que utilice herramientas de IA en su trabajo.

La conexión a tierra hace que la IA sea más precisa y mantiene la integridad de tu contenido al utilizar datos reales y verificados.

Ser consciente de las alucinaciones AI también te ayuda a conocer las formas correctas de evitarlas y a mantenerte alejado de posibles trampas.

Mantener la precisión del contenido de la IA es sólo una parte del proceso. Asegúrate de que tu contenido sigue siendo auténtico y de alta calidad utilizando la IA indetectable.

Esta herramienta actúa como detector de IA y como humanizador, asegurándose de que el contenido generado por IA se mezcle perfectamente con la escritura humana y pueda pasar las detecciones.

Elige las mejores opciones de verificación de contenido mediante IA para tus necesidades, y deja que Undetectable mantenga tu contenido siempre en plena forma.