Avec le invite à l'IA de droiteTu peux faire à peu près n'importe quoi. C'est dire à quel point les outils d'intelligence artificielle sont déjà puissants.

Les outils d'IA ont remodelé le fonctionnement des entreprises, leur permettant de rationaliser les processus et de favoriser l'efficacité comme jamais auparavant.

L'un des domaines où l'IA excelle véritablement est la création de contenu. Nous ne parlons pas seulement de rédiger des ébauches ou de générer des posts sur les médias sociaux.

L'IA peut même t'aider écris des livres et compléter des documents de recherche complexes.

Mais un grand pouvoir implique de grandes responsabilités, et on ne peut pas toujours faire confiance à l'IA pour faire ce qu'il faut.

Parfois, l'IA produit ce que l'on appelle des "hallucinations". Il s'agit de sorties incorrectes ou bizarres qui peuvent induire les utilisateurs en erreur.

Près de la moitié des organisations déclarent les défis liés à la qualité des données qui compromettent les initiatives en matière d'IA.

Ce n'est pas une solution miracle, mais le "grounding" vise à garantir que les résultats de l'IA sont basés sur des informations fiables.

Bien que cela puisse paraître complexe, la réponse à la question "Qu'est-ce que la mise à la terre et les hallucinations dans l'IA ?" est cruciale pour toute personne qui utilise ces outils puissants.

Entrons dans les détails de l'hallucination de l'IA pour que tu puisses en toute confiance maximiser ton rendement avec l'IA tout en t'assurant que tes informations restent exactes.

Principaux enseignements

- Les hallucinations de l'IA se produisent lorsque les modèles génèrent des informations fausses ou trompeuses en raison de lacunes dans les données ou d'un surajustement.

- La mise à la terre permet d'ancrer les résultats de l'IA à des données vérifiées et réelles afin de réduire les hallucinations et d'améliorer la fiabilité.

- Les hallucinations dans la création de contenu peuvent nuire à la crédibilité, répandre des informations erronées et entraîner des problèmes juridiques.

- Prévenir les problèmes en utilisant des outils fiables, en vérifiant le contenu et en fournissant des messages clairs et détaillés.

- La combinaison de la détection par l'IA et de la surveillance humaine - comme dans le cas de l'IA indétectable - garantit l'exactitude et l'authenticité.

Qu'est-ce que la mise à la terre et les hallucinations dans l'IA ?

Lorsqu'il s'agit de comprendre ce qu'est une hallucination en IA, savoir comment elle peut se produire est particulièrement utile pour les organisations qui ont besoin d'informations aussi précises que possible.

En te renseignant sur les hallucinations de la mise à la terre et de l'intelligence artificielle, tu pourras mieux comprendre le fonctionnement des outils d'IA et garantir que tes... Contenu généré par l'IA reste crédible.

Que sont les hallucinations dans l'IA ?

Imagine que tu demandes à un chatbot d'IA des informations sur une personne.

Ne vous inquiétez plus jamais de la détection de vos messages par l'IA. Undetectable AI peut vous aider :

- Faites apparaître votre écriture assistée par l'IA à l'image de l'homme.

- By-pass tous les principaux outils de détection de l'IA en un seul clic.

- Utilisation AI en toute sécurité et en toute confiance à l'école et au travail.

Le modèle fournit avec précision des détails fréquemment mentionnés dans différentes sources en ligne.

Mais ensuite, en recoupant les informations fournies, tu remarques que l'IA devine aussi à tort des informations moins connues comme leur âge et leur niveau d'études.

Ces détails erronés sont ce qu'on appelle des "hallucinations".

Taux d'hallucination peut varier d'un modèle à l'autre. ChatGPT a indiqué précédemment qu'environ 3%tandis que les systèmes de Google ont été estimés jusqu'à 27%.

Ces chatbots sont pilotés par un grand modèle de langage qui apprend en analysant des quantités massives de texte.

Cela se produit parce que ces modèles sont entraînés à prédire des mots en fonction de modèles dans les données qu'ils ont analysées sans comprendre ce qui est vrai ou non.

Les hallucinations proviennent le plus souvent de données d'entraînement incomplètes.

N'oublie pas que le modèle peut capter et reproduire des erreurs en fonction de ce qu'on lui donne à manger.

Il y a aussi le "surajustement", lorsque le modèle identifie de faux modèles ou de fausses connexions dans les données.

Résoudre les hallucinations de l'IA est un défi car ces modèles, fonctionnant sur des probabilités et des schémas, produiront inévitablement de faux résultats.

Cela peut induire en erreur les utilisateurs qui pourraient faire confiance au contenu de l'IA tel quel. C'est pourquoi il est important d'être conscient de cette limite lorsqu'on utilise l'IA pour la création de contenu et la vérification des faits.

Qu'est-ce que l'IA de mise à la terre ?

La mise à la terre de l'IA est une méthode efficace pour réduire les hallucinations. Elle fonctionne en ancrant les réponses de l'IA aux données du monde réel.

Par exemple, un système ancré utiliserait une base de données fiable dès le départ pour fournir des réponses factuelles, réduisant ainsi la probabilité que l'IA invente des choses.

Au lieu de s'appuyer uniquement sur la prédiction du mot suivant en se basant sur des modèles, un système ancré récupère d'abord des informations auprès d'une source crédible.

Le modèle est également plus acceptable d'un point de vue éthique car il admet que le contexte est insuffisant, il ne pourra donc pas fournir toutes les informations dont tu as besoin, au lieu de se contenter de deviner.

Pour maximiser la valeur de l'IA tout en minimisant les inexactitudes, les organisations doivent investir du temps en amont pour rassembler des données de formation précises, des directives et d'autres informations de base nécessaires.

Cette préparation aide les sorties d'IA à rester ancrées dans la réalité et à être fiables pour les utilisateurs.

Ainsi, même si la mise à la terre n'est pas une solution infaillible, elle peut améliorer considérablement la qualité des sorties AI.

Quel est le problème de l'hallucination de l'IA dans la création de contenu ?

Dans la création de contenu, les hallucinations de l'IA peuvent prendre différentes formes.

Lors de la création d'un billet de blog ou d'un article, l'IA peut inclure des faits erronés, des statistiques incorrectes ou des citations inventées.

L'hallucination de l'IA n'est pas non plus une tromperie intentionnelle. Le modèle ne peut pas mentir puisqu'il n'a pas de motivation pour tromper, ni conscience que ce qu'il dit est faux.

Il manque simplement une idée de la fiabilité de ses résultats.

Les conséquences des hallucinations de l'IA dans la création de contenu peuvent être graves.

- Propagation de la désinformation: Plus d'une personne sur cinq admettre qu'ils ont pu diffuser des "fake news" sans vérifier.

- Atteinte à la crédibilité: Si une personne ou une entreprise publie un contenu contenant des informations trompeuses, sa réputation peut en souffrir. La confiance est cruciale pour les utilisateurs, et une fois qu'elle est perdue, il peut être difficile de la regagner.

- Répercussions juridiques et financières: La publication de fausses informations peut entraîner des maux de tête potentiels, voire des poursuites judiciaires. C'est une bataille coûteuse que tu ne voudras pas rencontrer.

- Impact négatif sur les décisions commerciales: Les entreprises qui s'appuient sur l'IA pour produire des rapports et des informations utiles à la prise de décision peuvent être amenées à faire de mauvais choix sur la base de données erronées. Les fausses informations nuisent à la fois au public et à l'entreprise ou à la personne qui utilise l'IA pour la création de contenu. Et les hallucinations de l'IA peuvent en fait aggraver ce problème en générant un contenu qui semble crédible mais qui est en réalité erroné.

Comment prévenir les problèmes causés par les hallucinations de l'IA ?

Nous savons à quel point les outils d'IA sont précieux pour la création de contenu. L'utilisation de l'IA est même considérée comme l'une des Les meilleurs moyens de gagner de l'argent aujourd'hui et de rester compétitif dans l'industrie.

C'est aussi pourquoi il est crucial de s'attaquer au problème des hallucinations de l'IA pour s'assurer que le contenu que tu utilises avec l'IA est exact.

Comprendre les limites de l'IA

Bien que nous connaissions déjà la puissance de l'IA, elle a ses limites.

En ce qui concerne la création de contenu, elle fonctionne très bien pour la reconnaissance des formes et la génération de texte à partir d'énormes ensembles de données, mais il lui manque toujours le sens de la réalité.

Garde ces limites à l'esprit lorsque tu utilises l'IA :

- A du mal à saisir le contexte ou à comprendre les distinctions culturelles subtiles.

- dépend fortement de la qualité et de la quantité d'informations disponibles.

- Tendance à créer des préjugés basés sur les données d'entraînement.

- Manque de créativité et d'originalité à l'instar des humains

- Peut générer du contenu qui est moralement discutable.

- A du mal à résoudre des problèmes en dehors de ce que le système connaît.

- Difficulté à s'adapter à des situations changeantes ou à fournir des informations en temps réel.

- Vulnérable aux attaques et peut compromettre la confidentialité des données.

Connaître ses limites permet aussi d'éviter les hallucinations de l'IA. Les limites permettent de fixer des attentes réalistes et facilitent la détection des inexactitudes avant qu'elles ne soient rendues publiques.

Utilise des modèles et des outils fiables

Le Les meilleurs outils d'IA pour la création de contenu facilite les choses. Ces outils ne sont pas parfaits, mais ce que tu utilises devrait certainement faire le travail.

Pour les chatbots d'IA, ChatGPT est toujours la solution la plus efficace pour les chatbots d'IA. le plus fort sur le marché. Le GPT-4 a un taux de précision élevé de 97% et le taux le plus bas de ChatGPT hallucinations.

Assure-toi simplement de donner des messages-guides clairs et de vérifier les résultats par rapport à des sources fiables.

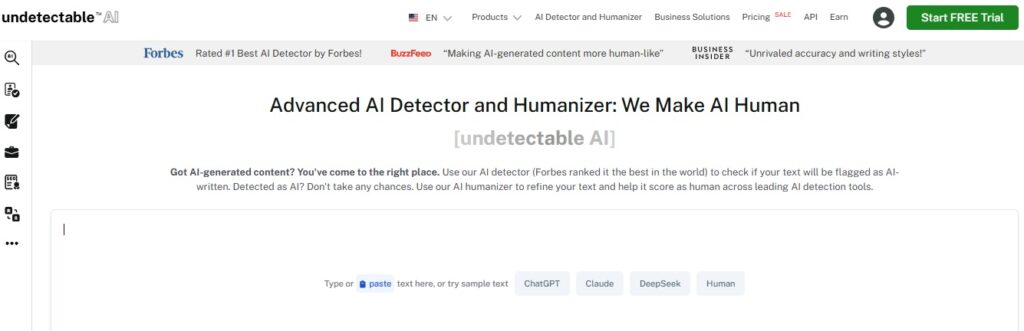

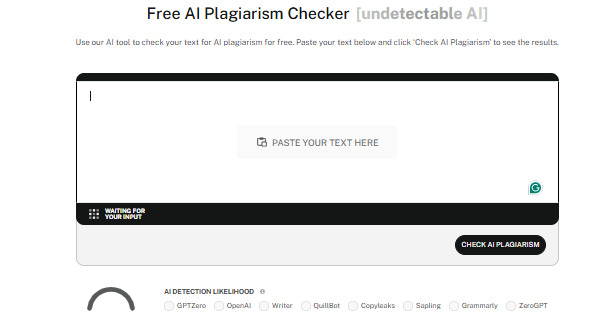

Tu devrais également utiliser des outils de détection de l'IA de confiance, comme par exemple. IA indétectable.

Les détecteurs analysent efficacement le contenu pour repérer les éléments d'IA les plus subtils, ce qui permet de maintenir l'authenticité de tout contenu que tu produis et de rester crédible.

Indétectable a également un AI Humanizer qui affine encore le texte pour qu'il ait l'air naturel.

Avec lui, tu ne te contentes pas de passer la détection de l'IA, tu garantis aussi la qualité de ton contenu.

Vérifier le contenu

Quelle que soit la façon dont tu utilises l'IA dans le processus de création de contenu, il est toujours important de vérifier le contenu que tu as produit.

Voici quelques moyens courants de vérifier le contenu de l'IA :

- Vérifie les informations en les comparant à plusieurs sources fiables.

- Utilise des outils de vérification des faits pour rationaliser le déboulonnage des fausses informations.

- Cherche des idées auprès d'experts en la matière ou de professionnels dans le domaine.

- Faire réviser le contenu par des pairs ou des collègues pour aider à identifier les erreurs potentielles, les préjugés ou les inexactitudes.

- Utilise un logiciel de détection de l'IA pour garantir l'originalité et éviter. plagiat involontaire

- Tiens compte du contexte historique lorsque tu fais référence à des événements ou à des données pour en assurer l'exactitude.

Prendre des précautions est payant. La vérification du contenu de l'IA te donne l'assurance, bien nécessaire, que ce que tu produis est toujours digne de confiance.

Donne des instructions claires

L'une des principales causes de l'hallucination de l'IA est le manque de clarté des instructions.

Si tu poses à l'IA des questions trop vagues sans contexte supplémentaire, il est plus probable qu'elle génère des réponses qui n'ont pas beaucoup de sens.

Des messages clairs et spécifiques permettent à l'IA de rester sur la bonne voie.

Alors, sois précis et détaillé dans tes messages-guides.

Au lieu de poser des questions trop générales, comme "Quel est le meilleur restaurant asiatique ?", essaie quelque chose de plus ciblé, comme "Quels sont les magasins de ramen les mieux notés à Kyoto ?".

La spécificité aide l'IA à rester sur la bonne voie et à produire des résultats précis qui répondent à tes attentes.

Restez informé

La technologie continue de progresser, et à un rythme rapide en plus, alors assure-toi de te tenir au courant.

L'IA apprend essentiellement à partir des données sur lesquelles elle est formée, mais les informations peuvent rapidement devenir obsolètes.

C'est particulièrement vrai dans les domaines qui évoluent rapidement comme la recherche scientifique ou les soins de santé.

Tu peux rester informé en suivant des sources fiables sur les médias sociaux, ou tu peux suivre des cours liés à ton secteur d'activité et assister à des événements du secteur.

De cette façon, tu as des indications sur le contenu fourni par l'IA qui reste crédible.

Les outils d'IA eux-mêmes se mettent à jour assez souvent aussi, alors reste au courant des derniers développements pour être toujours sûr d'utiliser les meilleurs.

Expertise humaine

Les humains et l'IA doivent travailler ensemble pour garantir la qualité, l'exactitude et l'authenticité de la création de contenu

Après tout, c'est nous qui apportons la pensée critique, la créativité et le jugement éthique.

En combinant les capacités de l'IA avec la supervision humaine, tu peux vérifier que le contenu est non seulement exact, mais aussi contextuellement pertinent - ainsi qu'engageant et frappant les bonnes notes.

Les experts humains peuvent repérer les préjugés, revérifier les informations et prendre des décisions que l'IA seule pourrait ne pas être en mesure d'appréhender.

Les humains et l'IA, ensemble, peuvent créer du contenu fiable, perspicace et percutant.

Découvrez notre détecteur d'IA et notre humanisateur dans le widget ci-dessous !

Conclusion

Comprendre ce que sont la mise à la terre et les hallucinations en matière d'IA est essentiel pour toute personne qui utilise des outils d'IA dans son travail.

La mise à la terre rend l'IA plus précise et maintient l'intégrité de ton contenu en utilisant des données réelles et vérifiées.

Être conscient des hallucinations de l'IA te permet aussi de connaître les bons moyens de les éviter et de te tenir à l'écart des pièges potentiels.

Garder le contenu de l'IA précis n'est qu'un aspect du processus. Assure-toi que ton contenu reste authentique et de haute qualité en utilisant l'IA indétectable.

Cet outil agit à la fois comme un détecteur d'IA et un humanisateur, en s'assurant que le contenu généré par l'IA se marie parfaitement avec l'écriture humaine et peut passer les détections.

Choisissez les options de vérification de contenu par IA les mieux adaptées à vos besoins, et laissez IA indétectable permet d'assurer la fiabilité, l'originalité et l'humanité de votre contenu. Commencez à l'utiliser dès aujourd'hui.