Met de rechter AI-promptkun je in principe alles doen. Zo krachtig zijn AI-tools nu al.

AI-tools hebben de manier waarop bedrijven werken veranderd, waardoor ze processen kunnen stroomlijnen en efficiënter kunnen werken dan ooit tevoren.

Een gebied waar AI echt in uitblinkt is contentcreatie. We hebben het dan niet alleen over het opstellen van outlines of het genereren van social media posts.

AI kan je zelfs helpen boeken schrijven en complexe onderzoekspapers voltooien.

Maar met grote macht komt grote verantwoordelijkheid en je kunt er niet altijd op vertrouwen dat AI het juiste doet.

Soms produceert AI zogenaamde "hallucinaties". Dit zijn onjuiste of bizarre outputs die gebruikers kunnen misleiden.

Bijna de helft van de organisaties meldt Uitdagingen op het gebied van gegevenskwaliteit die AI-initiatieven in gevaar brengen.

Het is geen wondermiddel, maar "aarding" moet ervoor zorgen dat AI-uitvoer gebaseerd is op betrouwbare informatie.

Het klinkt misschien ingewikkeld, maar het antwoord op de vraag "Wat zijn aarding en hallucinaties in AI?" is cruciaal voor iedereen die deze krachtige hulpmiddelen gebruikt.

Laten we ons verdiepen in de details van AI-hallucinatie, zodat je vol vertrouwen je output met AI kunt maximaliseren en er tegelijkertijd voor kunt zorgen dat je informatie accuraat blijft.

Belangrijkste opmerkingen

- AI-hallucinaties treden op wanneer modellen valse of misleidende informatie genereren als gevolg van hiaten in de gegevens of overfitting.

- Aarding verankert AI-uitvoer aan geverifieerde gegevens uit de echte wereld om hallucinaties te verminderen en de betrouwbaarheid te verbeteren.

- Hallucinaties bij het maken van inhoud kunnen de geloofwaardigheid schaden, verkeerde informatie verspreiden en juridische problemen veroorzaken.

- Voorkom problemen door betrouwbare tools te gebruiken, inhoud te verifiëren en duidelijke, gedetailleerde aanwijzingen te geven.

- De combinatie van AI-detectie en menselijk toezicht - zoals bij Undetectable AI - zorgt voor nauwkeurigheid en authenticiteit.

Wat zijn aarding en hallucinaties in AI?

Als het gaat om begrijpen wat hallucinatie in AI is, is weten hoe het kan gebeuren vooral nuttig voor organisaties die zo nauwkeurig mogelijke informatie nodig hebben.

Door te leren over aarding en kunstmatige intelligentie hallucinaties, zul je beter begrijpen hoe AI tools werken en kun je garanderen dat je AI-gegenereerde inhoud blijft geloofwaardig.

Wat zijn hallucinaties bij AI?

Stel je voor dat je een AI chatbot om informatie vraagt over een persoon.

Maak je nooit meer zorgen dat AI je sms'jes herkent. Undetectable AI Kan je helpen:

- Laat je AI-ondersteund schrijven verschijnen mensachtig.

- Omleiding alle grote AI-detectietools met slechts één klik.

- Gebruik AI veilig en vol vertrouwen op school en op het werk.

Het model geeft nauwkeurig details die vaak in verschillende online bronnen worden genoemd.

Maar als je dan de verstrekte informatie controleert, merk je dat de AI ook minder bekende informatie zoals hun leeftijd en opleiding verkeerd inschat.

Deze foute details staan bekend als "hallucinaties".

Hallucinaties kan variëren tussen modellen. ChatGPT meldde eerder rond 3%terwijl de systemen van Google werden geschat op maximaal 27%.

Deze chatbots worden aangestuurd door een groot taalmodel dat leert van het analyseren van enorme hoeveelheden tekst.

Dit gebeurt omdat deze modellen zijn getraind om woorden te voorspellen op basis van patronen in de gegevens die ze hebben geanalyseerd, zonder te begrijpen wat waar is of niet.

Hallucinaties komen meestal door onvolledige trainingsgegevens.

Onthoud dat het model fouten kan oppikken en reproduceren, afhankelijk van wat het te verwerken krijgt.

Er is ook "overfitting", waarbij het model valse patronen of verbanden in de gegevens identificeert.

Het oplossen van AI-hallucinaties is een uitdaging omdat deze modellen, die werken op basis van waarschijnlijkheden en patronen, onvermijdelijk foute resultaten zullen opleveren.

Dit kan misleidend zijn voor gebruikers die de AI-inhoud zouden kunnen vertrouwen zoals die is. Daarom is het belangrijk om je bewust te zijn van deze beperking als je AI gebruikt voor het maken van content en het controleren van feiten.

Wat is AI aarden?

AI's aarden is een effectieve methode om hallucinaties te verminderen. Het werkt door de reacties van de AI te verankeren aan gegevens uit de echte wereld.

Een geaard systeem zou bijvoorbeeld vanaf het begin een betrouwbare database gebruiken om feitelijke antwoorden te geven, waardoor de kans kleiner wordt dat de AI dingen verzint.

In plaats van alleen te vertrouwen op het voorspellen van het volgende woord op basis van patronen, haalt een geaard systeem eerst informatie op uit een geloofwaardige bron.

Het model is ook ethisch aanvaardbaarder omdat het toegeeft dat de context onvoldoende is, dus het zal niet alle informatie kunnen geven die je nodig hebt, in plaats van alleen maar te gissen.

Om de waarde van AI te maximaliseren en tegelijkertijd onnauwkeurigheden te minimaliseren, moeten organisaties vooraf tijd investeren in het verzamelen van nauwkeurige trainingsgegevens, richtlijnen en andere noodzakelijke achtergrondinformatie.

Deze voorbereiding helpt AI-uitvoer geaard te blijven in de werkelijkheid en kan worden vertrouwd door gebruikers.

Hoewel aarding dus geen waterdichte oplossing is, kan het de kwaliteit van AI-uitvoer aanzienlijk verbeteren.

Wat is het AI-hallucinatieprobleem bij het maken van content?

Bij het maken van content kunnen AI-hallucinaties verschillende vormen aannemen.

Bij het maken van een blogpost of artikel kan de AI foute feiten, onjuiste statistieken of verzonnen citaten gebruiken.

AI-hallucinatie is ook geen opzettelijke misleiding. Het model kan niet liegen omdat het geen motivatie heeft om te misleiden en zich er ook niet van bewust is dat wat het zegt onwaar is.

Het heeft gewoon geen idee hoe betrouwbaar de resultaten zijn.

De gevolgen van AI-hallucinaties bij het maken van content kunnen ernstig zijn.

- Verspreiding van verkeerde informatie: Meer dan één op de vijf mensen toegeven dat ze misschien nepnieuws hebben gedeeld zonder het te controleren.

- Schade aan geloofwaardigheid: Als een individu of een bedrijf inhoud met misleidende informatie publiceert, kan dit ten koste gaan van hun reputatie. Vertrouwen is cruciaal voor gebruikers en als het eenmaal verloren is, kan het een uitdaging zijn om het weer terug te winnen.

- Juridische en financiële gevolgen: Het publiceren van onjuiste informatie kan leiden tot mogelijke hoofdpijn en zelfs rechtszaken. Het is een kostbare strijd die je niet wilt voeren.

- Negatieve invloed op zakelijke beslissingen: Bedrijven die vertrouwen op AI om rapporten en inzichten te produceren voor besluitvorming kunnen leiden tot het maken van slechte keuzes op basis van onjuiste gegevens. Valse informatie brengt schade toe aan zowel het publiek als het bedrijf of individu dat AI gebruikt voor het maken van content. En AI-hallucinaties kunnen dit probleem zelfs verergeren door inhoud te genereren die er geloofwaardig uitziet maar in werkelijkheid onjuist is.

Hoe je problemen door AI-hallucinaties kunt voorkomen

We weten hoe waardevol AI-tools zijn bij het maken van content. Het gebruik van AI wordt zelfs beschouwd als een van de beste manieren om geld te verdienen vandaag en om concurrerend te blijven in de branche.

Het is ook de reden waarom het aanpakken van het AI-hallucinatieprobleem cruciaal is om ervoor te zorgen dat de inhoud die je met AI gebruikt accuraat is.

AI-beperkingen begrijpen

Hoewel we al weten hoe krachtig AI is, heeft het ook zijn beperkingen.

Als het gaat om het maken van inhoud, werkt het heel goed als het gaat om patroonherkenning en het genereren van tekst op basis van enorme datasets, maar het mist nog elke realiteitszin.

Houd deze beperkingen in gedachten als je AI gebruikt:

- Heeft moeite om context te begrijpen of subtiele culturele verschillen te doorgronden

- Hangt sterk af van de kwaliteit en kwantiteit van de beschikbare informatie

- De neiging om vooroordelen te creëren op basis van de trainingsgegevens

- Mist mensachtige creativiteit en originaliteit

- Kan inhoud genereren die moreel twijfelachtig is

- Heeft moeite met het oplossen van problemen buiten wat het systeem weet

- Moeite om zich aan te passen aan veranderende situaties of om real-time input te geven

- Kwetsbaar voor aanvallen en kan de privacy van gegevens in gevaar brengen

De grenzen kennen voorkomt ook AI-hallucinaties. Grenzen helpen bij het stellen van realistische verwachtingen en maken het gemakkelijker om onnauwkeurigheden te ontdekken voordat ze openbaar worden.

Gebruik betrouwbare modellen en tools

De Beste AI-tools voor het maken van content dingen gemakkelijk maken. Deze hulpmiddelen zijn niet perfect, maar wat je gebruikt moet zeker de klus klaren.

Voor AI-chatbots is ChatGPT nog steeds de sterkste die er zijn. GPT-4 heeft een hoge nauwkeurigheid van 97% en het laagste percentage ChatGPT hallucinaties.

Zorg ervoor dat je duidelijke aanwijzingen geeft en controleer de resultaten aan de hand van betrouwbare bronnen.

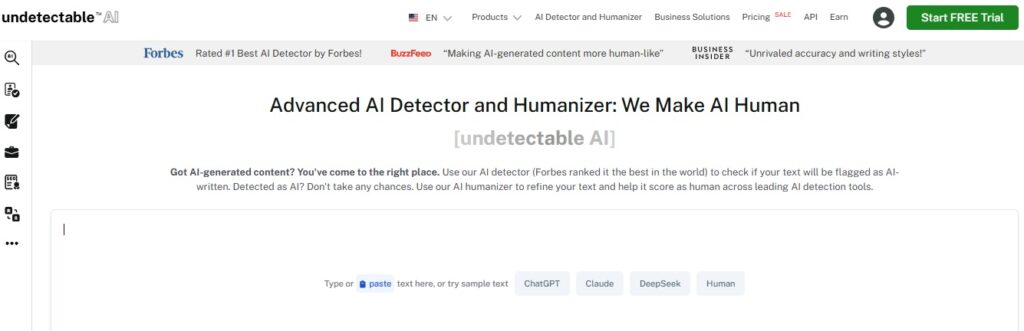

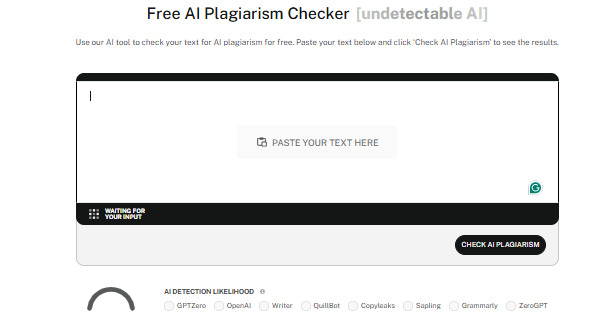

Je moet ook betrouwbare AI-detectietools gebruiken zoals Niet detecteerbare AI.

Detectors analyseren inhoud effectief om zelfs de meest subtiele AI-elementen te herkennen, waardoor de authenticiteit van alle inhoud die je produceert behouden blijft en je geloofwaardig blijft.

Undetectable heeft ook een AI Humanizer die tekst verder verfijnt zodat het natuurlijk klinkt.

Hiermee passeer je niet alleen de AI-detectie, maar garandeer je ook de kwaliteit van je inhoud.

Inhoud verifiëren

Hoe je AI ook gebruikt bij het maken van content, het is altijd belangrijk om de content die je hebt geproduceerd te verifiëren.

Dit zijn enkele veelgebruikte manieren om AI-inhoud te verifiëren:

- Kruisverificatie door informatie uit meerdere betrouwbare bronnen te vergelijken

- Gebruik hulpmiddelen voor feitencontrole om het ontkrachten van verkeerde informatie te stroomlijnen

- Zoek inzichten bij materiedeskundigen of professionals in het veld

- Inhoud laten beoordelen door collega's om mogelijke fouten, vooroordelen of onnauwkeurigheden op te sporen

- Gebruik AI-detectiesoftware om originaliteit te garanderen en te voorkomen dat onbedoeld plagiaat

- Houd rekening met de historische context wanneer je voor de nauwkeurigheid naar gebeurtenissen of gegevens verwijst

Voorzorgsmaatregelen nemen loont. Het verifiëren van AI-inhoud geeft je het broodnodige vertrouwen dat wat je produceert altijd betrouwbaar is.

Geef duidelijke instructies

Een van de belangrijkste oorzaken van AI-hallucinatie zijn onduidelijke instructies.

Als je AI vragen stelt die te vaag zijn zonder extra context, is de kans groter dat het antwoorden genereert die niet veel zin hebben.

Duidelijke en specifieke aanwijzingen houden AI op koers.

Wees dus specifiek en gedetailleerd in je aanwijzingen.

Probeer in plaats van al te brede vragen te stellen, zoals "Wat is het beste Aziatische restaurant?" iets gerichters, zoals "Wat zijn de best beoordeelde ramenwinkels in Kyoto?".

Specificiteit helpt AI om op koers te blijven en nauwkeurige resultaten te produceren die aan je verwachtingen voldoen.

Blijf op de hoogte

Technologie blijft zich ontwikkelen, en in een snel tempo ook, dus zorg ervoor dat je up-to-date blijft.

AI leert in wezen van de gegevens waarop het is getraind, maar informatie kan snel verouderd raken.

Dit geldt vooral voor snel veranderende gebieden zoals wetenschappelijk onderzoek of gezondheidszorg.

Je kunt op de hoogte blijven door betrouwbare bronnen op sociale media te volgen, of je kunt cursussen volgen die te maken hebben met jouw branche en evenementen in de branche bijwonen.

Op deze manier heb je inzicht in de content die door AI wordt geleverd en die geloofwaardig blijft.

AI tools zelf updaten zichzelf ook vrij vaak, dus blijf op de hoogte van de laatste ontwikkelingen zodat je er altijd zeker van bent dat je de beste gebruikt.

Menselijke expertise

Mensen en AI moeten samenwerken om kwaliteit, nauwkeurigheid en authenticiteit te garanderen bij het maken van content

Uiteindelijk zijn wij degenen die kritisch denken, creativiteit en een ethisch oordeel inbrengen.

Door de mogelijkheden van AI te combineren met menselijk toezicht kun je controleren of content niet alleen accuraat is, maar ook contextueel relevant - en ook boeiend en raak.

Menselijke experts kunnen vooroordelen herkennen, informatie dubbelchecken en beslissingen nemen die AI alleen misschien niet kan bevatten.

Mensen en AI kunnen samen content creëren die betrouwbaar, inzichtelijk en impactvol is.

Bekijk onze AI Detector en Humanizer in de widget hieronder!

Conclusie

Begrijpen wat aarding en hallucinaties zijn in AI is essentieel voor iedereen die AI-tools gebruikt in zijn werk.

Aarding maakt AI nauwkeuriger en behoudt de integriteit van je content door echte, geverifieerde gegevens te gebruiken.

Als je je bewust bent van AI-hallucinaties, weet je ook hoe je ze kunt vermijden en hoe je mogelijke valkuilen kunt vermijden.

AI-inhoud accuraat houden is maar één kant van het proces. Zorg ervoor dat je content authentiek en van hoge kwaliteit blijft door Undetectable AI te gebruiken.

Deze tool werkt zowel als AI-detector als humanizer en zorgt ervoor dat AI-gegenereerde inhoud naadloos overgaat in menselijk schrijven en detecties kan doorstaan.

Kies de beste opties voor AI-inhoudverificatie voor jouw behoeften en laat Niet detecteerbare AI houd je inhoud consistent betrouwbaar, origineel en menselijk. Begin er vandaag nog mee.