AI-detectoren zijn als de Voight-Kampff-test uit Blade Runner, een hulpmiddel om onderscheid te maken tussen echte en kunstmatige mensen.

Maar in plaats van emotionele vragen te stellen en oogbewegingen te scannen, vertrouwen AI-detectors op machinaal leren (ML) en natuurlijke taalverwerking (NLP) om AI-gegenereerde inhoud te identificeren.

Ironisch, toch?

ChatGPT en andere bekende AI-tools gebruiken ook ML's en NLP's om inhoud te genereren.

Het is alsof je dezelfde blauwdruk gebruikt om een huis te bouwen en het beschuldigt van kopiëren.

Hoe werken AI-detectors eigenlijk? En wat betekenen ze voor schrijvers zoals jij? Dat gaan we uitzoeken.

Belangrijkste opmerkingen

Voordat we dit konijnenhol ingaan, zijn hier de essentiële punten die je moet onthouden:

- Detectie is niet perfect. Zelfs de beste AI-contentdetectors kunnen dingen fout doen. Fout-positieven en fout-negatieven komen regelmatig voor.

- De nauwkeurigheid varieert enorm. Sommige detectoren presteren nauwelijks beter dan willekeurig gokken. Andere halen behoorlijke resultaten, maar maken nog steeds significante fouten.

- Context is belangrijker dan je denkt. Schrijfstijl, complexiteit van het onderwerp en lengte van de inhoud hebben allemaal invloed op de detectienauwkeurigheid.

- Hybride benaderingen werken beter. Tools die detectie combineren met het herschrijven van inhoud bieden meer praktische oplossingen dan detectie alleen.

- Transparantie is zeldzaam. De meeste bedrijven publiceren geen echte nauwkeurigheidscijfers. Als ze dat wel doen, zijn de cijfers vaak misleidend.

Hoe werken AI-inhouddetectors?

AI-inhouddetectors zijn net patroonherkenningssystemen. Ze worden getraind op enorme datasets van door mensen geschreven en door AI gegenereerde tekst.

Het doel is eenvoudig: leer de verschillen te zien.

Maar hier wordt het ingewikkeld.

Maak je nooit meer zorgen dat AI je sms'jes herkent. Undetectable AI Kan je helpen:

- Laat je AI-ondersteund schrijven verschijnen mensachtig.

- Omleiding alle grote AI-detectietools met slechts één klik.

- Gebruik AI veilig en vol vertrouwen op school en op het werk.

Deze hulpmiddelen zoeken naar specifieke patronen in het schrijven. Dingen zoals zinsbouw, woordkeus en alineaverloop. Ze kennen waarschijnlijkheidsscores toe op basis van hoe "AI-achtig" de tekst lijkt.

Het probleem? Menselijk schrijven en AI-schrijven zijn steeds moeilijker te onderscheiden. Modern AI-modellen zoals GPT-4o kan tekst produceren die opmerkelijk menselijk is.

Dit creëert een fundamentele uitdaging voor detectiesystemen.

De meeste detectoren gebruiken een van twee benaderingen. De eerste is perplexiteitsanalyse. Deze meet hoe "verrast" de detector is door woordkeuzes.

AI heeft de neiging om meer voorspelbare woorden te kiezen, terwijl mensen willekeuriger zijn.

De tweede benadering is burstiness detection. Hierbij wordt gekeken naar variatie in zinslengte en complexiteit. Mensen hebben de neiging om met meer variatie te schrijven. AI produceert vaak meer consistente patronen.

Geen van beide benaderingen is waterdicht. Goede AI kan menselijke willekeur nabootsen.

Menselijk schrijven kan soms erg systematisch overkomen.

Wat moet worden beschouwd als AI-inhoud?

Deze vraag is lastiger dan hij lijkt.

Wordt inhoud die 50% AI-gegenereerd is beschouwd als AI-inhoud? Hoe zit het met door mensen geschreven inhoud die is bewerkt door AI?

De industrie heeft nog geen duidelijke definities. Sommige detectors markeren elke inhoud met AI-hulp. Andere markeren alleen volledig door AI gegenereerde tekst.

Deze inconsistentie maakt nauwkeurigheidsvergelijkingen bijna onmogelijk.

Overweeg deze scenario's:

- Een mens schrijft een concept en gebruikt vervolgens AI om de grammatica en de flow te verbeteren. Is dit AI-inhoud?

- Iemand gebruikt AI om ideeën te genereren en schrijft vervolgens alles vanaf nul. AI-inhoud of niet?

- Een schrijver gebruikt AI om een schets te maken en schrijft dan originele inhoud volgens die structuur.

Deze randgevallen laten zien waarom nauwkeurigheidsmetingen misleidend kunnen zijn. Verschillende tools definiëren "AI-inhoud" anders.

Dit beïnvloedt hun gerapporteerde nauwkeurigheidspercentages.

Voor praktische doeleinden richten de meeste tools zich op het detecteren van inhoud die voornamelijk door AI is gegenereerd. Maar de grenzen blijven vaag.

Wat maakt een AI-inhouddetector "nauwkeurig"?

Nauwkeurigheid in AI-detectie gaat niet alleen over het krijgen van het juiste antwoord. Het gaat erom consistent het juiste antwoord te krijgen, voor verschillende soorten inhoud en gebruikssituaties.

Daarom zijn sommigen deze hulpmiddelen verwerpen.

Sommigen beweren dat deze detectoren net zo inconsistent kunnen zijn als de voorspellingen van een gelukskoekje, wat belangrijke vragen oproept over betrouwbaarheid en vertrouwen.

Maar voor echte nauwkeurigheid moeten twee soorten fouten tegen elkaar worden afgewogen. Valse positieven gebeuren wanneer menselijke inhoud wordt gemarkeerd als AI.

Valse negatieven ontstaan wanneer AI-inhoud doorgaat voor menselijk geschreven.

De kosten van deze fouten variëren per context. Voor academische integriteit kunnen fout-positieven het vertrouwen van studenten vernietigen.

Voor contentmarketing kunnen valse negatieven leiden tot straffen van zoekmachines.

De nauwkeurigheid hangt ook af van de kwaliteit van de trainingsgegevens. Detectoren die zijn getraind met oudere AI-modellen kunnen moeite hebben met nieuwere, geavanceerdere AI-schrijvingen.

Dit creëert een constante wapenwedloop tussen detectie en generatie.

De beste detectoren houden rekening met meerdere factoren:

- Statistische patronen in woordgebruik en zinsbouw

- Semantische samenhang en logische stroom

- Consistentie schrijfstijl door de hele inhoud

- Domeinspecifieke kennis en demonstratie van expertise

Maar zelfs uitgebreide benaderingen hebben beperkingen. Menselijk schrijven varieert enorm. Sommige mensen schrijven van nature in patronen die AI-detectors triggeren.

Anderen kunnen AI-achtige consistentie nabootsen.

Het doel is niet perfecte nauwkeurigheid. Het is betrouwbare nauwkeurigheid die voldoet aan jouw specifieke behoeften.

En hoewel geen enkele detector foutloos is, kan de juiste tool het verschil maken tussen een betrouwbare indiening en een gemarkeerd document.

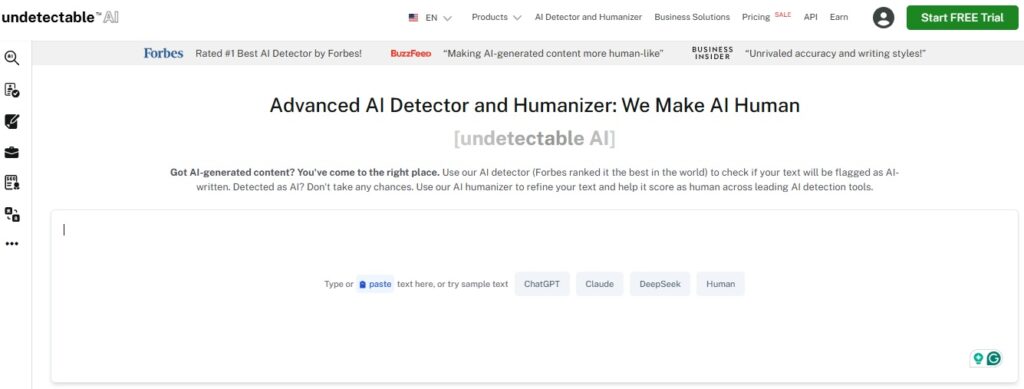

Onzichtbare AI's Detector en Humanizer werken samen in één workflow en bieden een gebalanceerde aanpak die niet alleen AI-gegenereerde tekst identificeert, maar deze ook op natuurlijke wijze herschrijft.

Met deze geïntegreerde oplossing krijg je zowel detectienauwkeurigheid als praktische oplossingen in één naadloze ervaring.

Probeer de Undetectable AI Detector and Humanizer vandaag nog en ervaar het vertrouwen van AI-vrije, authentieke content die klaar is voor elke uitdaging.

Hoe we de nauwkeurigheid van onze AI-detector meten

De meeste bedrijven gooien met nauwkeurigheidspercentages zonder uit te leggen hoe ze die hebben berekend. Wij geloven in transparantie.

Onze nauwkeurigheidstests zijn als volgt rigoureuze methodologie.

We gebruiken diverse datasets met inhoud van meerdere AI-modellen, menselijke schrijvers van verschillende vaardigheidsniveaus en verschillende soorten inhoud.

Dit is ons testproces:

- Creatie dataset: Duizenden tekstvoorbeelden, door AI gegenereerd. Van academische essays tot marketingteksten, creatief schrijven en technische documentatie. We hebben AI-inhoud rechtstreeks uit toonaangevende modellen gehaald en menselijke tekst gecureerd voor een brede representatie.

- Blind testen: Onze detector analyseert elk monster zonder de bron te kennen en geeft vertrouwensscores en classificaties (AI vs. mens).

- Statistische analyse: Van daaruit berekenen we:

- True Positives / False Positives / True Negatives / False Negatives

- Precisie, recall en F1-score, die standaard meetmethoden zijn bij de evaluatie van machinaal leren.

- Kruisvalidatie: We testen verschillende inhoudstypen en lengtes om de prestaties te meten in echte gebruiksgevallen: academisch, marketing, technisch en creatief. Studies tonen aan dat creatief schrijven het moeilijkst nauwkeurig te detecteren is, dus besteden we hier extra aandacht aan.

- Continue bewaking: AI-modellen evolueren snel. Detectors die zijn getraind op oudere gegevens presteren minder goed op nieuwere output. We houden de prestaties na verloop van tijd bij en trainen waar nodig bij om de nauwkeurigheid te behouden.

Onze huidige tests laten een aanzienlijke variatie zien op basis van het type inhoud.

Academisch schrijven is het makkelijkst om nauwkeurig te detecteren. Creatief schrijven vormt de grootste uitdaging.

Huidige nauwkeurigheid van onze AI-inhouddetector

Bij Undetectable AI vertrouwen we niet op geruchten. We zetten onze detector zelf in de schijnwerpers:

- Toonaangevende externe validatie: Onafhankelijke tests tonen aan dat de detector van Undetectable AI een nauwkeurigheid van 85 tot 95% haalt op gemengde menselijke en AI-inhoud, waarmee hij zich kan meten met de beste tools op dit gebied.

- Parafrase opsporen: Onderzoek toont aan dat Undetectable AI nauwkeurig geparafraseerde AI-tekst 100% van de tijd herkent in meerdere toolvergelijkingen, inclusief gratis tools zoals Sapling en QuillBot.

- Zelfreflecterend testen: Undetectable's eigen GPTZero-vergelijkingstest markeerde 99% van AI-gegenereerde inhoud correct, terwijl GPTZero slechts 85% markeerde.

- Voortdurende verbetering door blinde verwisseling: Wanneer gebruikers AI-tekst vermenselijken via Undetectable AI, dalen traditionele detectors (zoals Originality.ai) van detectiepercentages van meer dan 90% naar minder dan 30%, wat de kracht van ons herschrijvingsmodel bewijst.

- Gesteund door miljoenen: Nummer één AI-detector door Forbes, met meer dan 4 miljoen gebruikers en gratis gebruik op verschillende platforms.

In de praktijk betekent dit dat Undetectable AI eersteklas detectienauwkeurigheid levert en deze koppelt aan een geavanceerde humanizer voor naadloos herschrijven.

Test je inhoud nu - gratis scan met onze AI Detector. Begin met vertrouwen: controleer je schrijven, krijg direct inzichten en onderneem actie.

Waarom we AI Detector + Humanizer koppelen

Detectie alleen is niet genoeg. Weten dat inhoud mogelijk AI-gegenereerd is, lost het onderliggende probleem niet op.

Je hebt bruikbare oplossingen nodig.

Daarom hebben we ons platform gebouwd rond de detector-humanizer workflow. In plaats van alleen maar potentiële AI-inhoud te signaleren, helpen wij je deze aan te pakken.

Dit is hoe de gekoppelde aanpak werkt:

- Detectie eerst: Onze AI-detector analyseert je inhoud en identificeert paragrafen die mogelijk door AI zijn gegenereerd. Je krijgt specifieke vertrouwensscores voor verschillende alinea's.

- Gericht herschrijven: Onze humanizer richt zich op de gemarkeerde gedeelten. In plaats van alles te herschrijven, worden alleen de delen die verbetering behoeven op intelligente wijze aangepast.

- Verificatielus: Na het vermenselijken voeren we de detectie opnieuw uit om te bevestigen dat de inhoud nu als door mensen geschreven wordt gelezen.

- Behoud van kwaliteit: Het proces behoudt je originele betekenis en stijl terwijl het de AI-detectiehandtekeningen vermindert.

Deze workflow lost echte problemen op. Makers van inhoud kunnen ervoor zorgen dat hun werk geen valse positieven veroorzaakt. Studenten kunnen verifiëren of hun schrijfwerk authentiek menselijk overkomt.

Marketeers kunnen inhoud produceren die door de detectie komt terwijl de kwaliteit behouden blijft.

Het alternatief is pure detectie, waardoor je wel problemen hebt maar geen oplossingen.

Weten dat inhoud mogelijk door AI is gegenereerd, helpt niet als je het niet kunt oplossen.

Hoe we ons vergelijken met andere AI-inhouddetectors

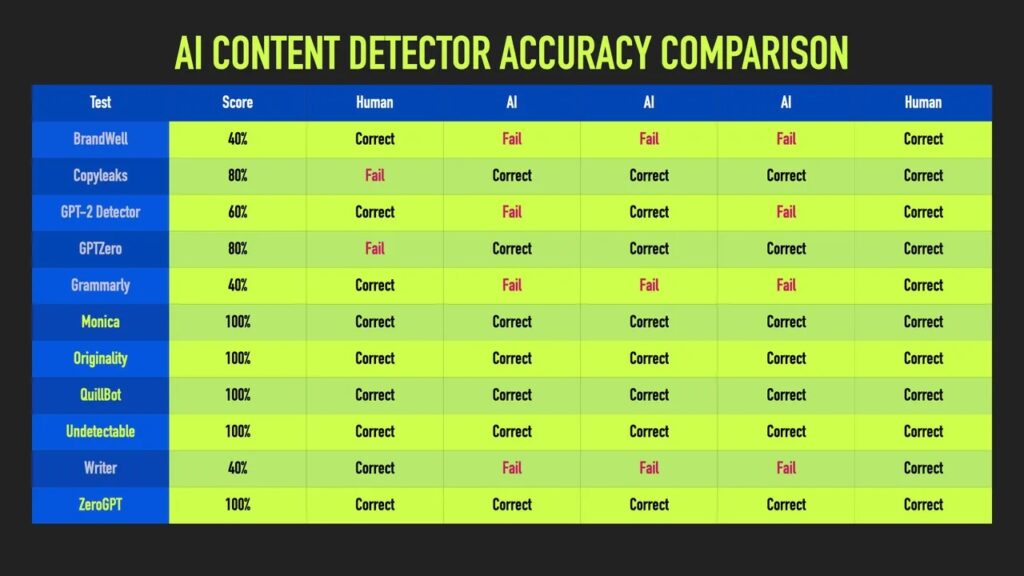

Het landschap van AI-detectie is bezaaid met tools die ambitieuze nauwkeurigheidseisen stellen. Onafhankelijke tests werpen een duidelijker licht op wat echt werkt.

ZDNet's diepe duik in 10 belangrijke AI-contentdetectors bestond uit het voorleggen van dezelfde door AI gegenereerde voorbeelden aan elk hulpmiddel en het controleren welke consequent door AI geschreven tekst herkende.

Veel detectors schoten tekort. Sommige detectors die een bijna perfecte nauwkeurigheid claimden, scoorden nauwelijks beter dan toeval toen ze werden getest op echte inhoud.

Niet-opspoorbare AI viel echter op en belandde in de top vijf voor consistente detectie van AI-tekst in alle monsters.

ZDNet testte 10 AI-detectors met identieke AI-gegenereerde monsters.

Daarvan markeerden slechts drie tools AI-tekst 100% van de tijd in alle geteste monsters.

Met name onze prestaties bleven goed, ongeacht het type inhoud, en niet alleen op gecureerde, eenvoudige voorbeelden.

- Consistente prestaties over een breed scala aan AI-modellen en inhoudstypen. Terwijl concurrenten vaak uitblinken in beperkte omstandigheden, behouden wij over de hele linie onze nauwkeurigheid.

- Duidelijke methodologie. We leggen onze testprocedures uit en werken de prestatiecijfers regelmatig bij zonder vage beweringen.

- Geïntegreerde oplossingen. We koppelen detectie aan herschrijven via onze Humanizer. Puur op detectie gerichte tools laten je achter met problemen, maar zonder oplossingen.

- Frequente herscholing. We trainen onze modellen voortdurend bij terwijl de AI-generatie zich ontwikkelt. Statische detectors verliezen snel hun relevantie.

- Eerlijke beperkingen. We communiceren uitdagingen en randgevallen duidelijk. Te veel beloven leidt tot frustratie bij gebruikers en slechte beslissingen.

Het onderzoek van ZDNet benadrukte een belangrijk punt: consistentie overtroeft flitsende pieken. Een detector die 95% van de tijd betrouwbaar is, verslaat een detector die af en toe 99% haalt maar in andere contexten crasht tot 60%.

Test je inhoud nu | Gratis scan met onze AI Detector.

Zie uit eerste hand waar je staat. Scan je schrijven, krijg betrouwbare resultaten en onderneem actie.

Bekijk onze AI Detector en Humanizer in actie - gebruik de widget hieronder!

Vertrouwen, transparantie en hulpmiddelen die resultaten opleveren

De nauwkeurigheid van AI-contentdetectors is meer dan alleen cijfers. Het gaat erom te begrijpen wat deze tools wel en niet betrouwbaar kunnen doen.

Detectietechnologie is veelbelovend maar onvolmaakt. Zelfs de beste hulpmiddelen maken fouten. Als je deze beperkingen kent, kun je ze verstandiger gebruiken.

De toekomst van AI-detectie kijkt naar multimodale analyse, gedragspatronen en gezamenlijke verificatie.

Voorlopig moeten detectietools zoals Undetectable AI worden gezien als behulpzame assistenten, niet als eindbeoordelaars. Combineer ze met menselijk oordeel en kies oplossingen die aan uw behoeften voldoen.

Pure detectie lost zelden echte problemen op. Daarom biedt Undetectable AI een geïntegreerde workflow die detectie in evenwicht brengt met contentverbetering.

Het doel is niet om AI uit het schrijven te bannen, maar om transparantie, kwaliteit en vertrouwen te behouden.

Inzicht in de nauwkeurigheid van de detector, vooral met Niet detecteerbare AIgeeft je de controle over het proces.