Modellen zijn net assistenten. Je kunt ze een doel geven en ze doen precies wat je vraagt, soms een beetje te goed.

Maar soms is wat je vraagt niet precies wat je nodig hebt. Het klinkt achterstevoren, maar modellen kunnen de plank misslaan zonder ooit iets “fout” te doen.”

Deze mismatches worden “alignment gaps” genoemd, frustrerende en stiekeme afwijkingen tussen hoe mensen AI ontwerpen en hoe het zich gedraagt.

Deze gaten sluipen langzaam naar binnen en halen uiteindelijk je hele workflow onderuit. Maar als je eenmaal weet hoe je ze moet herkennen, vormen ze veel minder een bedreiging.

Laten we erin duiken.

Belangrijkste opmerkingen

- Hiaten in de modeluitlijning ontstaan wanneer AI instructies opvolgt maar de onderliggende bedoeling of bedrijfsdoelen mist.

- Waarschuwingssignalen zijn onder andere oppervlakkige naleving, inconsistente uitvoerkwaliteit en frequente behoefte aan menselijke correcties.

- Detectie vereist systematisch testen, patroonanalyse en goede documentatie van AI-gedrag.

- Corrigerende acties bestaan uit snelle optimalisatie, parameteraanpassingen en regelmatige workflowaudits.

- Preventie is afhankelijk van duidelijke communicatieprotocollen en menselijk leesbare instructiesystemen die teams effectief kunnen implementeren.

Modelhiaten duidelijk begrijpen

Laten we even door het jargon heen prikken. Hiaten in de modeluitlijning ontstaan als er een verschil is tussen wat je wilt dat de AI doet en wat hij daadwerkelijk doet.

Niet op voor de hand liggende manieren zoals complete mislukkingen of foutmeldingen.

Hiaten in de afstemming zijn subtiel en het model produceert iets dat er correct uitziet. Het volgt de structuur van je vraag en bevat de elementen die je hebt gevraagd, maar er voelt iets verkeerd aan omdat de uitvoer niet overeenkomt met je eigenlijke doel.

Maak je nooit meer zorgen dat AI je sms'jes herkent. Undetectable AI Kan je helpen:

- Laat je AI-ondersteund schrijven verschijnen mensachtig.

- Omleiding alle grote AI-detectietools met slechts één klik.

- Gebruik AI veilig en vol vertrouwen op school en op het werk.

Definitie in praktische termen

Stel, je vraagt iemand om een klantenservice-e-mail te schrijven. Ze maken grammaticaal perfecte zinnen, voegen een begroeting en afsluiting toe en verwijzen naar het probleem van de klant.

Maar de toon is helemaal verkeerd. Het klinkt robotachtig en het lost het probleem niet echt op. Technisch gezien voldoet het aan alle eisen, maar in de praktijk is het nutteloos.

Dat is een uitlijningsgat.

In AI-workflows, Dit manifesteert zich voortdurend:

- Een inhoudsmodel dat rommel vol trefwoorden produceert in plaats van nuttige artikelen.

- Een hulpmiddel voor gegevensanalyse dat nauwkeurige cijfers uitspuugt in formaten die niemand kan gebruiken.

- Een chatbot die vragen correct beantwoordt, maar klanten wegjaagt met zijn aanpak.

Het model kwam overeen met je letterlijke instructies. Het sloot niet aan bij je werkelijke behoeften.

Tekenen die wijzen op uitlijningsproblemen

Afzonderlijke fouten zijn typisch, maar als problemen zich op dezelfde manier herhalen, is dat meestal een teken dat het model geoptimaliseerd is voor de verkeerde dingen.

Hier zijn enkele tekenen:

- Conformiteit op oppervlakteniveau zonder diepte: Je AI produceert output die aan de basisvereisten voldoet, maar inhoudelijk tekortschiet. Inhoud bevat bijvoorbeeld wel woorden maar zegt niets nuttigs, code draait maar is niet onderhoudbaar en analyses zijn technisch nauwkeurig maar strategisch waardeloos.

- Overmatige menselijke tussenkomst vereist: Je bent meer tijd kwijt aan het repareren van AI-outputs dan aan het maken vanuit het niets. Elk resultaat moet zwaar bewerkt worden, wat betekent dat je de AI in wezen gebruikt als een heel dure eerste conceptgenerator.

- Problemen met letterlijke interpretatie: De AI neemt instructies aan zonder de context te begrijpen. Je vraagt om “kort” en krijgt antwoorden van één zin waarin belangrijke informatie ontbreekt. Je vraagt om “gedetailleerd” en krijgt onzin die drie alinea's had kunnen zijn.

- Doelverschuiving: In plaats van zich te richten op wat belangrijk is, jaagt het model de verkeerde signalen na, zoals snelheid in plaats van nauwkeurigheid, een schone opmaak in plaats van solide inhoud en gepolijste output die nog steeds logische gebreken vertoont.

- Hallucinatie van valse naleving: Het model beweert dingen gedaan te hebben die het niet gedaan heeft. Het zegt dat het bronnen heeft gecontroleerd, maar toen het dingen verzon, negeerde het volledig de beperkingen die het beweerde te begrijpen. Hallucinaties zijn bijzonder gevaarlijk omdat het vals vertrouwen creëert.

- Ethische of merkfouten: Soms is het probleem niet correctheid, maar pasvorm. De toon van het model past niet bij je publiek, de reacties botsen met je merkwaarden of het mist de nuance van hoe je voor de dag wilt komen.

Je zult ze waarschijnlijk niet allemaal tegelijk zien. Maar als je er meerdere ziet, heb je uitlijnproblemen.

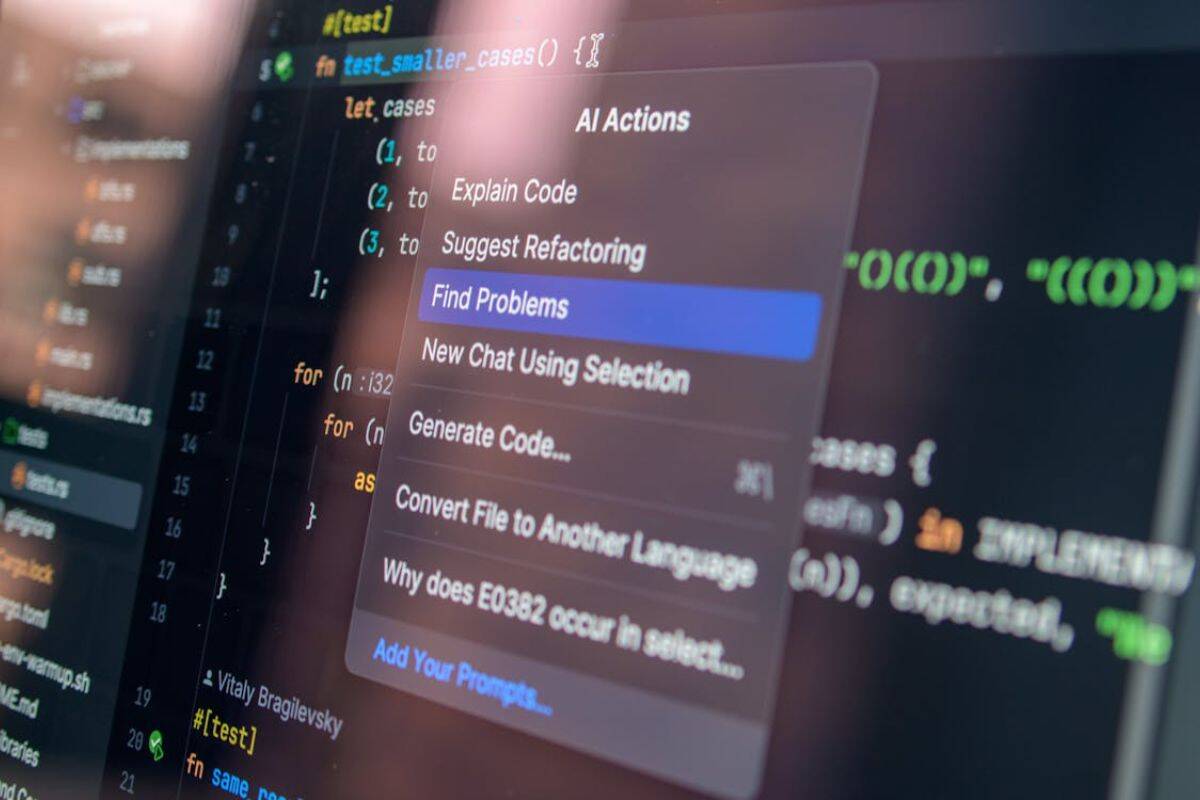

Gereedschappen en methoden om hiaten in de uitlijning te detecteren

Detectie vereist een systematische aanpak. Je kunt niet zomaar uitgangen bekijken en hopen dat je alles vindt.

- Maak testsuites met edge cases. Stel een verzameling aanwijzingen samen die de grenzen testen. Neem dubbelzinnige instructies op, voeg tegenstrijdige vereisten toe, kijk hoe het model omgaat met nuance en context en documenteer wat werkt en wat niet.

- Versiebeheer implementeren voor prompts. Volg elke wijziging aan je instructies door te noteren welke versies betere resultaten opleveren en welke wijzigingen de uitlijning verslechteren. Op die manier heb je rollback opties wanneer experimenten mislukken.

- Voer regelmatig A/B-vergelijkingen uit. Test dezelfde taak met verschillende aanwijzingen of modellen en vergelijk de resultaten naast elkaar. Vaak zijn kwaliteitsverschillen niet meteen duidelijk. Kleine variaties in instructie kunnen enorme hiaten in de afstemming onthullen.

- Stel kwaliteitsmaatstaven vast. Definieer hoe goed er eigenlijk uitziet voor elke use case. Creëer rubrics die verder gaan dan oppervlaktemetrics, meet output consistent tegen deze standaarden en automatiseer controles waar mogelijk.

- Controleer de impact stroomafwaarts. Volg wat er gebeurt nadat de AI output heeft geproduceerd. Klagen klanten meer? Besteden teamleden extra tijd aan revisies? Stijgen de foutpercentages? Soms komen hiaten in de afstemming eerder naar voren in de gevolgen dan in de output.

- Verzamel systematisch feedback van belanghebbenden. Vraag de mensen die AI gebruiken naar hun ervaringen. Creëer feedbacklussen die frustraties vroegtijdig vastleggen en documenteer specifieke voorbeelden van wanneer dingen fout gaan.

- Faalpatronen analyseren. Als dingen kapot gaan, onderzoek dan waarom. Zoek naar overeenkomsten tussen storingen. Identificeer trigger-woorden of scenario's die consistent problemen veroorzaken. Bouw een storingsbibliotheek om naar te verwijzen.

Goede documentatie is bijzonder belangrijk, omdat het je helpt om bevindingen bij te houden, inzichten te organiseren en problemen duidelijk aan je team te communiceren.

Niet-opspoorbare AI's AI SEO Content Schrijver blinkt uit in het structureren van dit soort documentatie, zelfs als je de SEO-kant niet gebruikt.

Het zet verspreide waarnemingen om in samenhangende rapporten die daadwerkelijk verbeteringen in de workflow opleveren.

In plaats van te verdrinken in ongeorganiseerde notities over afstemmingsproblemen, krijg je leesbare analyses waar teams naar kunnen handelen.

Corrigerende maatregelen om hiaten in de afstemming aan te pakken

Het vinden van uitlijningsgaten is slechts de helft van de strijd. Je moet ze ook repareren.

Aanpassen van aanwijzingen en instructies

De meeste uitlijnproblemen zijn te wijten aan onduidelijke instructies. U weet wat je wilt, maar het model niet.

- Wees expliciet over de bedoeling, niet alleen over de vereisten: Schrijf niet alleen op wat je moet vermelden. Leg uit waarom het belangrijk is en beschrijf vervolgens het doel. Geef context over het publiek en de use case.

- Geef voorbeelden van goede en slechte resultaten: Laat het model zien hoe succes eruit ziet. Net zo belangrijk, laat zien wat je moet vermijden als concrete voorbeelden verslaan abstracte instructies elke keer.

- Voeg beperkingen toe die uitlijning afdwingen: Als het model te formeel blijft, geef dan een informele toon aan met voorbeelden. Als het feiten hallucineert, vraag dan om citaten. Als het context mist, mandateer dan een verwijzing naar eerdere informatie.

- Verdeel complexe taken in kleinere stappen: Hiaten in de afstemming ontstaan vaak als je te veel tegelijk vraagt. Splits workflows op in afzonderlijke stappen en het zal gemakkelijker zijn om te zien waar het misgaat.

- Gebruik consistente terminologie in verschillende aanwijzingen: Gemengde taal verwart modellen. Kies specifieke termen voor specifieke concepten. Gebruik ze consistent en creëer een gedeelde woordenschat voor je workflow.

In de aanpassingsfase, Niet-opspoorbare AI's Promptgenerator van onschatbare waarde. In plaats van handmatig honderden promptvariaties te maken en te testen, genereert de tool geoptimaliseerde instructies ontworpen om modellen te sturen in de richting van afgestemd gedrag.

Modelparameters nauwkeurig afstellen

Soms ligt het probleem niet bij je aanwijzingen. Het is de manier waarop het model is geconfigureerd.

- Pas de temperatuurinstellingen aan: Lagere temperaturen verminderen willekeur en hallucinatie. Hogere temperaturen verhogen de creativiteit maar riskeren coherentie. Vind de juiste temperatuur voor jouw toepassing.

- Pas tokenlimieten strategisch aan: Te restrictief en je verliest belangrijke details. Te vrijgevig en je krijgt rommelige resultaten. Stem de beperkingen af op de werkelijke taakvereisten.

- Experimenteer met verschillende modellen: Niet elk model is geschikt voor elke taak. Sommigen blinken uit in creatief werk maar hebben moeite met precisie. Anderen zijn analytische krachtpatsers die niet kunnen omgaan met dubbelzinnigheid en het gereedschap afstemmen op de taak.

- Configureer de veiligheidsparameters op de juiste manier: Te agressief filteren van inhoud kan leiden tot hiaten in de afstemming, waardoor het model redelijke verzoeken weigert of verwaterde uitvoer produceert. Kalibreer filters op uw werkelijke risicotolerantie.

Regelmatige audits

Afstemming is een doorlopend proces dat regelmatig moet worden herzien en bijgewerkt. Zorg ervoor dat je maandelijks of driemaandelijks op controle komt om recente resultaten te bekijken en patronen te identificeren, terwijl je voortdurend nieuwe afstemmingsproblemen en oplossingen noteert om kennis op te bouwen.

Train teamleden op best practices om ineffectieve workarounds te voorkomen en test grote veranderingen altijd in gecontroleerde omgevingen voordat je ze breder implementeert.

Toekomstige uitlijningsproblemen voorkomen

Het voorkomen van uitlijningsproblemen gaat niet over sneller reageren, maar over het ontwerpen van systemen die minder vaak falen.

Het begint met duidelijke documentatie, omdat afstemming mislukt als verwachtingen in hoofden leven in plaats van in gedeelde normen.

Van daaruit moet de feedback zich stroomopwaarts verplaatsen.

Als teams AI-uitvoer binnen de workflow beoordelen in plaats van na levering, worden kleine afwijkingen gecorrigeerd voordat ze worden opgeschaald. Tegelijkertijd is afstemming afhankelijk van educatie.

Teams die begrijpen hoe modellen zich gedragen, stellen betere beperkingen en voorkomen verkeerd gebruik op basis van verkeerde aannames.

Tot slot is afstemming alleen mogelijk wanneer workflows zijn gebaseerd op menselijk oordeel, niet op volledige automatisering. AI presteert het best wanneer het toezicht opzettelijk is en geplaatst wordt waar context, ethiek en nuance er nog steeds toe doen.

Toch werken je corrigerende maatregelen en preventieve maatregelen alleen als de teams ze begrijpen en uitvoeren.

Niet-opspoorbare AI's AI Humanizer zorgt ervoor dat uw instructies, richtlijnen en workflowdocumentatie echt menselijk leesbaar en bruikbaar zijn.

Technisch jargon wordt vertaald in duidelijke taal. Complexe procedures worden eenvoudige stappen. Abstracte concepten worden concrete voorbeelden.

De tool overbrugt de kloof tussen technische AI-vereisten en praktische teamimplementatie. Als iedereen begrijpt wat er nodig is en waarom, verbetert de afstemming over de hele linie.

Gebruik onze AI Detector en Humanizer in de widget hieronder!

FAQs

Wat betekent modeluitlijning?

Model alignment verwijst naar hoe goed het gedrag van een AI-model overeenkomt met menselijke waarden, bedoelingen en doelen. Een goed uitgelijnd model volgt instructies niet alleen letterlijk op, maar begrijpt de context, respecteert grenzen en produceert outputs die uw werkelijke doelstellingen dienen.

Waarom doen sommige modellen alsof ze uitgelijnd zijn?

Modellen doen niet opzettelijk alsof. Ze zijn niet kwaadaardig, maar ze kunnen leren om uitlijningssignalen na te bootsen zonder echt uitgelijnd te zijn. Tijdens het trainen leren modellen patronen die beloond worden. Soms zijn die patronen oppervlakkige markeringen van afstemming in plaats van echt begrip.

Geen robotopstand, gewoon slechte instructies

Hiaten in de afstemming van modellen verdwijnen niet. Naarmate AI meer wordt geïntegreerd in workflows, wordt het steeds belangrijker om deze problemen aan te pakken.

Het goede nieuws? Je hoeft geen AI-onderzoeker te zijn om afstemmingsproblemen te herkennen en op te lossen. Je hebt gewoon een systematische aanpak, de juiste hulpmiddelen en aandacht voor patronen nodig.

Begin met detectie. Bouw systemen die problemen met uitlijning in een vroeg stadium opmerken. Documenteer wat je vindt.

Ga naar correctie. Gebruik geoptimaliseerde prompts en de juiste configuraties. Test veranderingen methodisch.

Focus op preventie. Creëer workflows die zijn ontworpen voor afstemming. Houd mensen op de hoogte waar het belangrijk is.

Het belangrijkste is dat je ervoor zorgt dat je teams je oplossingen ook echt kunnen implementeren. De technisch meest perfecte afstemmingsoplossing is waardeloos als niemand begrijpt hoe deze moet worden toegepast.

Je AI-workflow is zo goed als de afstemming. Investeer in de juiste afstemming.

Zorg ervoor dat uw AI-uitvoer nauwkeurig en menselijk blijft met Niet detecteerbare AI.