Z Prawy monit AImożesz zrobić w zasadzie wszystko. Tak potężne są już narzędzia sztucznej inteligencji.

Narzędzia sztucznej inteligencji zmieniły sposób działania firm, umożliwiając im usprawnienie procesów i zwiększenie wydajności, jak nigdy dotąd.

Jednym z obszarów, w którym sztuczna inteligencja naprawdę się wyróżnia, jest tworzenie treści. Nie mówimy tu tylko o tworzeniu konspektów czy generowaniu postów w mediach społecznościowych.

Sztuczna inteligencja może Ci nawet pomóc pisać książki i ukończ złożone prace badawcze.

Ale z wielką mocą wiąże się wielka odpowiedzialność, a sztucznej inteligencji nie zawsze można ufać, że postąpi właściwie.

Czasami sztuczna inteligencja wytwarza tak zwane "halucynacje". Są to nieprawidłowe lub dziwaczne wyniki, które mogą wprowadzać użytkowników w błąd.

Prawie połowa organizacji zgłasza wyzwania związane z jakością danych, które zagrażają inicjatywom AI.

Nie jest to złoty środek, ale "uziemienie" ma na celu zapewnienie, że wyniki AI są oparte na wiarygodnych informacjach.

Choć może się to wydawać skomplikowane, odpowiedź na pytanie "Czym jest uziemienie i halucynacje w sztucznej inteligencji?" jest kluczowa dla każdego, kto korzysta z tych potężnych narzędzi.

Przejdźmy do szczegółów halucynacji AI, abyś mógł z pewnością zmaksymalizować swoją wydajność dzięki AI, jednocześnie upewniając się, że Twoje informacje pozostają dokładne.

Kluczowe wnioski

- Halucynacje AI występują, gdy modele generują fałszywe lub wprowadzające w błąd informacje z powodu luk w danych lub nadmiernego dopasowania.

- Uziemienie kotwiczy wyjścia AI do zweryfikowanych, rzeczywistych danych, aby zmniejszyć halucynacje i poprawić niezawodność.

- Halucynacje w tworzeniu treści mogą zaszkodzić wiarygodności, szerzyć dezinformację i powodować problemy prawne.

- Zapobiegaj problemom, korzystając z niezawodnych narzędzi, weryfikując zawartość i zapewniając jasne, szczegółowe podpowiedzi.

- Połączenie wykrywania AI i ludzkiego nadzoru - jak w przypadku Undetectable AI - zapewnia dokładność i autentyczność.

Czym jest uziemienie i halucynacje w sztucznej inteligencji?

Jeśli chodzi o zrozumienie, czym jest halucynacja w sztucznej inteligencji, wiedza o tym, jak może ona wystąpić, jest szczególnie pomocna dla organizacji, które wymagają jak najdokładniejszych informacji.

Ucząc się o uziemieniu i halucynacjach sztucznej inteligencji, będziesz w stanie lepiej zrozumieć, jak działają narzędzia AI i zagwarantować, że twoje Treści generowane przez sztuczną inteligencję pozostaje wiarygodny.

Czym są halucynacje w sztucznej inteligencji?

Wyobraź sobie, że poprosiłeś chatbota AI o informacje na temat danej osoby.

Nigdy więcej nie martw się, że sztuczna inteligencja wykryje twoje teksty. Undetectable AI Może ci pomóc:

- Spraw, by pisanie wspomagane przez sztuczną inteligencję wyglądało podobny do człowieka.

- Obejście wszystkie główne narzędzia do wykrywania AI za pomocą jednego kliknięcia.

- Użycie AI bezpiecznie i pewnie w szkole i pracy.

Model dokładnie przedstawia szczegóły często wymieniane w różnych źródłach internetowych.

Ale potem, gdy sprawdzasz podane informacje, zauważasz, że sztuczna inteligencja również błędnie odgaduje mniej znane informacje, takie jak wiek i wykształcenie.

Te błędne szczegóły są znane jako "halucynacje".

Wskaźniki halucynacji może się różnić w zależności od modelu. ChatGPT wcześniej informował o 3%podczas gdy systemy Google szacowano nawet na 27%.

Te chatboty są napędzane przez duży model językowy, który uczy się na podstawie analizy ogromnych ilości tekstu.

Dzieje się tak, ponieważ modele te są szkolone do przewidywania słów na podstawie wzorców w analizowanych danych bez zrozumienia, co jest prawdą, a co nie.

Halucynacje wynikają głównie z niekompletnych danych treningowych.

Pamiętaj, że model może wychwytywać i powielać błędy w zależności od tego, czym jest zasilany.

Istnieje również "nadmierne dopasowanie", w którym model identyfikuje fałszywe wzorce lub powiązania w danych.

Rozwiązywanie halucynacji AI jest wyzwaniem, ponieważ modele te, działające na prawdopodobieństwach i wzorcach, nieuchronnie dają fałszywe wyniki.

Może to wprowadzać w błąd użytkowników, którzy mogą ufać treściom AI. Dlatego ważne jest, aby zdawać sobie sprawę z tego ograniczenia podczas korzystania ze sztucznej inteligencji do tworzenia treści i sprawdzania faktów.

Czym jest uziemienie AI?

Uziemienie AI jest skuteczną metodą redukcji halucynacji. Działa ona poprzez zakotwiczenie odpowiedzi AI w rzeczywistych danych.

Na przykład, system oparty na uziemieniu korzystałby z wiarygodnej bazy danych od samego początku, aby zapewnić faktyczne odpowiedzi, zmniejszając prawdopodobieństwo, że sztuczna inteligencja coś zmyśli.

Zamiast polegać wyłącznie na przewidywaniu następnego słowa na podstawie wzorców, system uziemiony najpierw pobiera informacje z wiarygodnego źródła.

Model ten jest również bardziej etycznie akceptowalny, ponieważ przyznaje, że kontekst jest niewystarczający, więc nie będzie w stanie dostarczyć wszystkich potrzebnych informacji, zamiast tylko zgadywać.

Aby zmaksymalizować wartość sztucznej inteligencji przy jednoczesnym zminimalizowaniu nieścisłości, organizacje powinny z wyprzedzeniem zainwestować czas w gromadzenie dokładnych danych szkoleniowych, wytycznych i innych niezbędnych informacji ogólnych.

Takie przygotowanie pomaga sztucznej inteligencji pozostać zakorzenioną w rzeczywistości i może być zaufana przez użytkowników.

Tak więc, chociaż uziemienie nie jest niezawodnym rozwiązaniem, może znacznie poprawić jakość wyjść AI.

Na czym polega problem halucynacji AI w tworzeniu treści?

W tworzeniu treści halucynacje AI mogą przybierać różne formy.

Podczas tworzenia wpisu na blogu lub artykułu sztuczna inteligencja może zawierać fałszywe fakty, nieprawidłowe statystyki lub zmyślone cytaty.

Halucynacja AI nie jest również celowym oszustwem. Model nie może kłamać, ponieważ nie ma motywacji do oszukiwania, ani nie jest świadomy, że to, co mówi, jest fałszywe.

Po prostu brakuje mu poczucia, jak wiarygodne są jego wyniki.

Konsekwencje halucynacji AI w tworzeniu treści mogą być poważne.

- Rozprzestrzenianie się dezinformacji: Więcej niż jedna na pięć osób przyznają, że mogli udostępnić fałszywe wiadomości bez sprawdzenia.

- Uszkodzenie wiarygodności: Jeśli dana osoba lub firma publikuje treści zawierające wprowadzające w błąd informacje, jej reputacja może na tym ucierpieć. Zaufanie ma kluczowe znaczenie dla użytkowników, a raz utracone zaufanie może być trudne do odzyskania.

- Konsekwencje prawne i finansowe: Publikowanie fałszywych informacji może prowadzić do potencjalnych bólów głowy, a nawet procesów sądowych. To kosztowna bitwa, której nie chcesz doświadczyć.

- Negatywny wpływ na decyzje biznesowe: Firmy polegające na sztucznej inteligencji do tworzenia raportów i spostrzeżeń do podejmowania decyzji mogą prowadzić do dokonywania złych wyborów w oparciu o nieprawidłowe dane. Fałszywe informacje szkodzą zarówno odbiorcom, jak i firmie lub osobie wykorzystującej sztuczną inteligencję do tworzenia treści. A halucynacje AI mogą w rzeczywistości pogorszyć ten problem, generując treści, które wyglądają na wiarygodne, ale w rzeczywistości są wadliwe.

Jak zapobiegać problemom powodowanym przez halucynacje AI?

Wiemy, jak cenne są narzędzia AI w tworzeniu treści. Korzystanie ze sztucznej inteligencji jest nawet uważane za jeden z najlepsze sposoby na zarabianie pieniędzy i pozostać konkurencyjnym w branży.

Jest to również powód, dla którego rozwiązanie problemu halucynacji AI ma kluczowe znaczenie dla zapewnienia, że treści, których używasz z AI, są dokładne.

Zrozum ograniczenia sztucznej inteligencji

Chociaż wiemy już, jak potężna jest sztuczna inteligencja, ma ona swoje ograniczenia.

Jeśli chodzi o tworzenie treści, działa naprawdę dobrze w rozpoznawaniu wzorców i generowaniu tekstu na podstawie ogromnych zbiorów danych, ale wciąż brakuje mu poczucia rzeczywistości.

Pamiętaj o tych ograniczeniach podczas korzystania ze sztucznej inteligencji:

- Ma trudności z uchwyceniem kontekstu lub zrozumieniem subtelnych różnic kulturowych.

- W dużej mierze zależy od jakości i ilości dostępnych informacji.

- Tendencja do tworzenia uprzedzeń na podstawie danych treningowych

- Brak ludzkiej kreatywności i oryginalności

- Może generować treści, które są moralnie wątpliwe

- Ma problemy z rozwiązywaniem problemów wykraczających poza to, co wie system.

- Trudności w dostosowywaniu się do zmieniających się sytuacji lub dostarczaniu informacji w czasie rzeczywistym.

- Podatność na ataki i możliwość naruszenia prywatności danych

Znajomość jego granic zapobiega również halucynacjom AI. Granice pomagają ustalić realistyczne oczekiwania i ułatwiają wychwycenie nieścisłości, zanim zostaną upublicznione.

Korzystaj z niezawodnych modeli i narzędzi

The Najlepsze narzędzia AI do tworzenia treści ułatwiają pracę. Narzędzia te nie są idealne, ale to, czego używasz, powinno zdecydowanie wykonać swoją pracę.

W przypadku chatbotów AI, ChatGPT jest nadal najsilniejszy z nich. GPT-4 może pochwalić się wysokim wskaźnikiem dokładności 97% i najniższym wskaźnikiem halucynacji ChatGPT.

Upewnij się tylko, że podajesz jasne podpowiedzi i sprawdzasz wyniki w wiarygodnych źródłach.

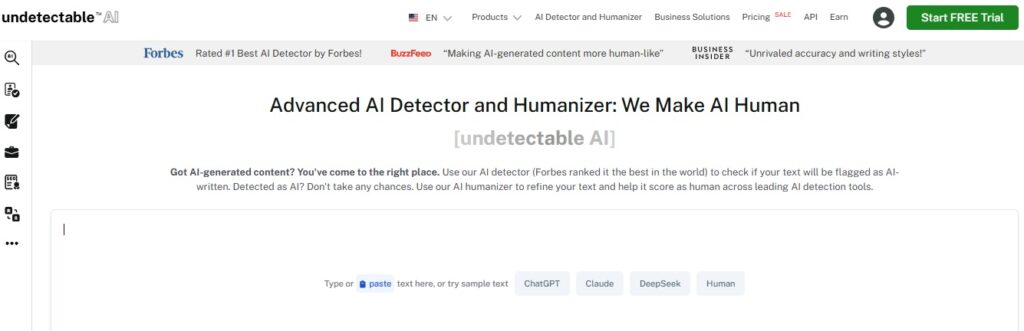

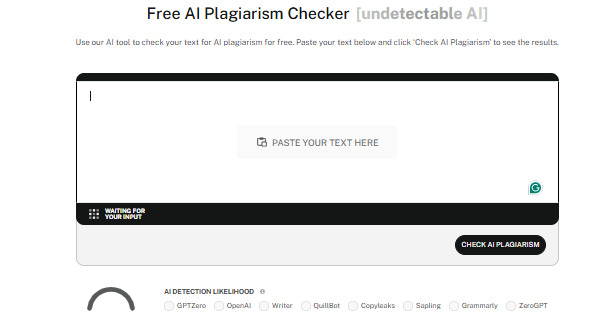

Powinieneś także korzystać z zaufanych narzędzi do wykrywania sztucznej inteligencji, takich jak Niewykrywalna sztuczna inteligencja.

Detektory skutecznie analizują treści, aby wykryć nawet najbardziej subtelne elementy sztucznej inteligencji, zachowując autentyczność we wszystkich produkowanych przez Ciebie treściach i zapewniając Ci wiarygodność.

Undetectable ma również AI Humanizer która jeszcze bardziej udoskonala tekst, aby brzmiał naturalnie.

Dzięki niemu nie tylko przejdziesz wykrywanie AI, ale także zagwarantujesz jakość swoich treści.

Zweryfikuj zawartość

Bez względu na to, w jaki sposób wykorzystujesz sztuczną inteligencję w procesie tworzenia treści, zawsze ważne jest, aby zweryfikować wyprodukowane treści.

Oto kilka popularnych sposobów weryfikacji treści AI:

- Dokonaj weryfikacji krzyżowej, porównując informacje z wielu wiarygodnych źródeł.

- Korzystaj z narzędzi do weryfikacji faktów, aby usprawnić obalanie dezinformacji.

- Szukaj spostrzeżeń u ekspertów lub specjalistów w danej dziedzinie.

- Poproś o sprawdzenie treści przez współpracowników lub kolegów, aby pomóc zidentyfikować potencjalne błędy, uprzedzenia lub nieścisłości.

- Użyj oprogramowania do wykrywania sztucznej inteligencji, aby zapewnić oryginalność i uniknąć niezamierzony plagiat

- Uwzględniaj kontekst historyczny podczas odwoływania się do wydarzeń lub danych w celu zapewnienia dokładności.

Podejmowanie środków ostrożności się opłaca. Weryfikacja treści AI daje Ci pewność, że to, co tworzysz, jest zawsze godne zaufania.

Zapewnij jasne instrukcje

Jedną z głównych przyczyn halucynacji AI są niejasne instrukcje.

Jeśli zadasz sztucznej inteligencji zbyt niejasne pytania bez dodatkowego kontekstu, jest bardziej prawdopodobne, że wygeneruje ona odpowiedzi, które nie mają większego sensu.

Jasne i konkretne podpowiedzi utrzymują sztuczną inteligencję na właściwym torze.

Bądź więc konkretny i szczegółowy w swoich podpowiedziach.

Zamiast zadawać zbyt ogólne pytania, takie jak "Jaka jest najlepsza azjatycka restauracja?", spróbuj czegoś bardziej ukierunkowanego, na przykład "Jakie są najwyżej oceniane sklepy z ramenem w Kioto?".

Konkretność pomaga sztucznej inteligencji pozostać na właściwym torze i uzyskiwać dokładne wyniki, które spełniają Twoje oczekiwania.

Bądź na bieżąco

Technologia wciąż się rozwija i to w szybkim tempie, więc upewnij się, że jesteś na bieżąco.

Sztuczna inteligencja zasadniczo uczy się na podstawie danych, na których jest szkolona, ale informacje mogą szybko stać się nieaktualne.

Jest to szczególnie prawdziwe w szybko zmieniających się dziedzinach, takich jak badania naukowe czy opieka zdrowotna.

Możesz być na bieżąco, śledząc zaufane źródła w mediach społecznościowych, lub brać udział w kursach związanych z Twoją branżą i uczestniczyć w wydarzeniach branżowych.

W ten sposób masz wgląd w to, czy treści dostarczane przez AI pozostają wiarygodne.

Same narzędzia AI również często się aktualizują, więc bądź na bieżąco z najnowszymi osiągnięciami, aby zawsze mieć pewność, że korzystasz z najlepszych z nich.

Ludzka wiedza

Ludzie i sztuczna inteligencja muszą współpracować, aby zapewnić jakość, dokładność i autentyczność w tworzeniu treści.

W końcu to my wnosimy krytyczne myślenie, kreatywność i etyczną ocenę sytuacji.

Łącząc możliwości sztucznej inteligencji z ludzkim nadzorem, możesz sprawdzić, czy treści są nie tylko dokładne, ale także kontekstowo istotne - a także angażujące i trafiające we właściwe nuty.

Ludzcy eksperci mogą dostrzec uprzedzenia, dwukrotnie sprawdzić informacje i podejmować decyzje, których sama sztuczna inteligencja może nie być w stanie pojąć.

Ludzie i sztuczna inteligencja mogą wspólnie tworzyć treści, które są wiarygodne, wnikliwe i skuteczne.

Sprawdź nasz AI Detector i Humanizer w widżecie poniżej!

Wnioski

Zrozumienie, czym jest uziemienie i halucynacje w sztucznej inteligencji, jest niezbędne dla każdego, kto używa narzędzi AI w swojej pracy.

Uziemienie sprawia, że sztuczna inteligencja jest dokładniejsza i zachowuje integralność twoich treści dzięki wykorzystaniu prawdziwych, zweryfikowanych danych.

Świadomość halucynacji związanych ze sztuczną inteligencją pomoże ci również poznać właściwe sposoby ich uniknięcia i ustrzec się przed potencjalnymi pułapkami.

Utrzymanie dokładności treści AI to tylko jedna strona procesu. Upewnij się, że Twoje treści pozostają autentyczne i wysokiej jakości, korzystając z niewykrywalnej sztucznej inteligencji.

Narzędzie to działa zarówno jako wykrywacz AI, jak i humanizator, upewniając się, że treści generowane przez AI płynnie łączą się z ludzkim pismem i mogą przejść wykrywanie.

Wybierz najlepsze opcje weryfikacji treści AI dla swoich potrzeb i pozwól Niewykrywalna sztuczna inteligencja konsekwentnie dbaj o to, by Twoje treści były wiarygodne, oryginalne i ludzkie. Zacznij z niego korzystać już dziś.