Há uma coisa que tem estado na boca de toda a gente nos últimos dois anos: ChatGPT.

Professores preocupar-se com o facto de estar a escrever os trabalhos de casa dos alunos.

Escritores temem que a IA possa escrever livros e histórias em vez deles.

Codificadores têm medo que ele construa sítios Web e aplicações melhor do que os humanos.

Alguns prevêem mesmo que milhões de postos de trabalho poderão desaparecer por causa da IA.

Todos nós já ouvimos falar dele. Mas alguma vez se interrogou como O ChatGPT funciona?

Como é que o ChatGPT escreve os trabalhos de casa de um miúdo? O que está a acontecer nos bastidores quando escreves uma pergunta e ele responde como se fosse uma pessoa real?

Como é que uma máquina pode escrever poemas, histórias e código, apesar de não compreender as palavras como nós?

Neste blogue, vamos olhar para dentro ChatGPT e explicar o que é o ChatGPT e como funciona, passo a passo.

Aprenderá como se lembra das coisas, quais são os seus limites e como se constroem ferramentas como esta.

Vamos lá começar!

A Fundação: Modelos de linguagem GPT

ChatGPT é uma IA que foi concebida para compreender e escrever como um ser humano.

Chama-se um modelo linguístico porque trabalha com a linguagem - lendo-a, prevendo-a e gerando-a.

Mas não compreende como as pessoas. Não pensa. Não conhece factos. Apenas olha para os padrões.

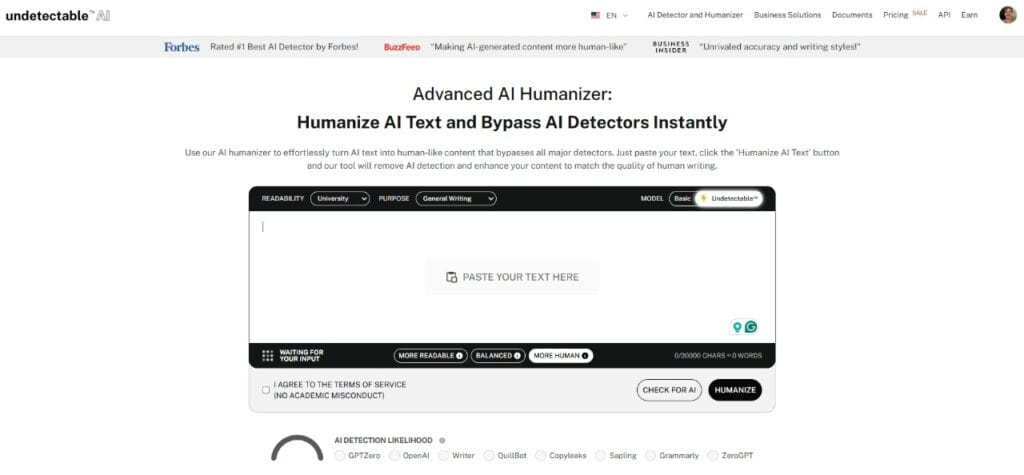

Nunca mais se preocupe com o facto de a IA detetar os seus textos. Undetectable AI Pode ajudar-vos:

- Faça aparecer a sua escrita assistida por IA de tipo humano.

- Bypass todas as principais ferramentas de deteção de IA com apenas um clique.

- Utilização IA com segurança e com confiança na escola e no trabalho.

Por exemplo,

- Se escrever, "O céu é..."

- Pode dizer-se "azul".

Não porque sabe que o céu é azul, mas porque viu essa frase milhões de vezes durante o treino. Aprendeu que "azul" vem muitas vezes depois de "o céu é".

Este tipo de IA é designado por LLM, que significa Modelo de língua grande.

É treinado em toneladas de livros didácticos, websites e muito mais para perceber como os humanos usam as palavras. Mas não está a ler pelo significado. Está a aprender como as palavras aparecem normalmente umas ao lado das outras.

GPT é um tipo específico de LLM.

GPT significa "Transformador generativo pré-treinado".

- Gerador - pode criar um novo texto.

- Pré-treinado - ele aprende antes de falar consigo.

- Transformador - a tecnologia chave por detrás do funcionamento do ChatGPT que o ajuda a compreender como as palavras se relacionam umas com as outras numa frase, parágrafo ou mesmo conversa.

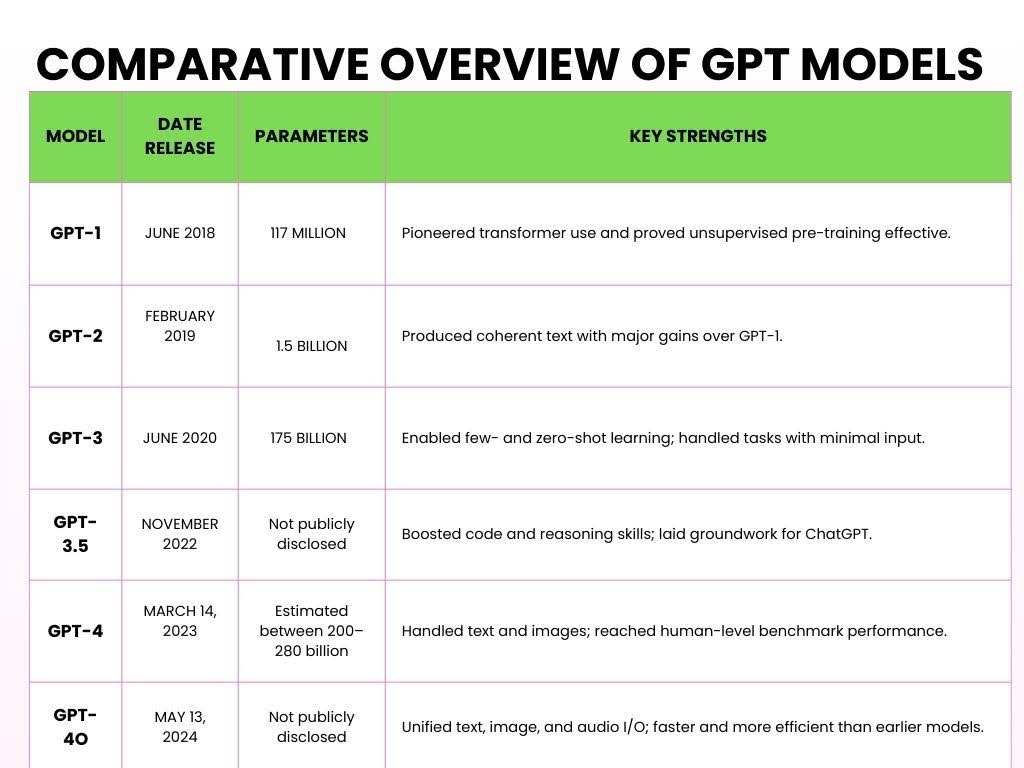

Eis as diferentes versões do GPT que foram lançadas ao longo dos anos.

Como funciona o ChatGPT

Aqui está uma descrição simplificada de como o ChatGPT funciona e processa a sua entrada em cinco etapas principais.

- Passo 1: Pré-treino em dados massivos

Modelos linguísticos de grande dimensão (LLMs) como o ChatGPT são pré-treinados através do processamento de grandes quantidades de texto da Internet para aprender padrões linguísticos.

Durante a pré-treino, o modelo processa biliões de fichas (pequenos pedaços de texto).

A ficha pode ser uma palavra, parte de uma palavra ou até mesmo pontuação, dependendo da forma como o modelo tokeniza a entrada.

Por exemplo,

Faz uma pergunta de matemática ao ChatGPT, por exemplo:

Problema:

- 2 + 3 = ?

Durante o seu treino, o ChatGPT lê centenas de milhares de milhões de palavras de livros, notícias, artigos, Wikipedia, histórias, artigos científicos e até tópicos do Reddit.

Esta formação e leitura ajudam-no a compreender o funcionamento da adição.

Por exemplo,

Pode aprender a propriedade comutativa (ou seja, 2 + 3 = 3 + 2) através desses contextos.

ChatGPT vê muitos exemplos como

- "2 + 3 = 5,"

- "7 + 8 = 15,"

- "9 + 4 = 13."

Não aprende apenas estes exemplos específicos, aprende o padrão da adição.

Compreende a forma como os números interagem com o símbolo "+" e como o resultado segue normalmente o símbolo "=".

- Passo 2: A arquitetura do transformador

Depois de o ChatGPT ter visto uma enorme quantidade de palavras, precisou de um cérebro que pudesse dar sentido a toda essa informação. Esse cérebro de IA chama-se "Transformer".

O que distingue o Transformer é a sua capacidade de concentrar a atenção nas partes mais importantes do input, à semelhança da forma como processamos a linguagem.

Por exemplo,

Vamos aplicar isto a um problema de matemática:

- "Qual é a soma de 5 e 7?"

Ao processar isto, o Transformer não se limita a passar palavra a palavra.

Em vez disso, analisa o contexto completo - "soma", "5" e "7" - de uma só vez.

Reconhece que "soma" refere-se a "adição" e que "5" e "7" são os números envolvidos.

O Transformer dá então mais "atenção" para as palavras que têm um impacto direto na resposta, pelo que se concentra na operação ("soma") e nos números ("5" e "7").

Esta é uma parte fundamental do funcionamento do ChatGPT - ele não processa linearmente o problema, mas de uma forma que o ajude a compreender a relação entre os elementos.

Esta capacidade de olhar para tudo em contexto é o que torna o Transformer tão poderoso.

Em vez de se limitar a descobrir o que vem a seguir, compreende o significado ligando as partes relevantes da frase.

Além disso, entrar numa nova comunidade online muitas vezes significa aprender um vocabulário totalmente novo, mas não precisa de esperar meses para começar a falar a língua.

Além disso, se pretende ajudar as suas mensagens a se integrarem perfeitamente, o Undetectable AI's Gerador de acrónimos permite criar abreviações personalizadas que imitam os padrões complexos que os modelos de IA utilizam para processar e gerar formas linguísticas estruturadas abreviadas.

- Etapa 3: Tokenização e processamento de linguagem

Quando escreve texto no ChatGPT, este divide o seu texto em pequenos fichas.

Alguns tokens são palavras completas, enquanto outros são apenas partes de palavras.

Por exemplo,

Quando introduz "O ChatGPT é inteligente". O ChatGPT divide-o nos seguintes tokens:

["Chat", "G", "PT", "é", "inteligente"]

Até o nome "ChatGPT" é dividido em diferentes tokens.

Este processo é designado por tokenização. Uma vez que os modelos foram treinados com tokens em vez de palavras completas, é muito mais flexível:

Várias línguas (uma vez que as diferentes línguas têm diferentes estruturas de palavras),

Gíria e abreviaturas (como "u" para "tu" ou "idk" para "não sei").

Mesmo palavras inventadas ou variações (como dividir "unbelievable" em "un", "believ", "able").

- Etapa 4: Ajuste fino e camadas de segurança

Depois de o ChatGPT ter sido treinado com uma grande quantidade de dados, ainda não está pronto para o horário nobre.

Ainda precisa de ajuda para garantir que responde da forma mais útil, educada e segura.

Através de afinação supervisionadaOs revisores humanos dão ao ChatGPT exemplos do que é uma boa resposta. Por exemplo,

- "Quanto é 5 + 7?"

- Resposta má: É uma pergunta fácil. Porque é que não sabe isto?

- Boa resposta: A soma de 5 e 7 é 12.

Ao longo do tempo, o ChatGPT é treinado com melhores exemplos para se tornar mais educado, claro e concentrado.

Depois de ter uma base sólida, recebe ajuda mais avançada através de Aprendizagem por reforço a partir de feedback humano (RLHF).

O processo é o seguinte:

- ChatGPT responde.

- Taxa de humanos essa resposta baseia-se na sua qualidade - na sua utilidade, exatidão e segurança.

- ChatGPT aprende com base neste feedback e tenta dar melhores respostas no futuro.

Por exemplo, Imagine que ChatGPT responde a um problema de matemática, como por exemplo "Quanto é 12 dividido por 4?":

- ChatGPT responde: "3."

- Feedback humano: Esta resposta é óptima.

- O ChatGPT aprende: Está sempre a dar este tipo de resposta quando surgem perguntas semelhantes.

O objetivo é que o ChatGPT continue a melhorar, tal como um aluno que aprende com os erros do passado.

Por último, um objetivo importante da afinação pelos humanos é a alinhar-se com os valores humanos.

Queremos que não seja apenas inteligente, mas também útil, inofensivo e honesto.

Por exemplo, se um utilizador fizer uma pergunta complexa como, "Qual é a raiz quadrada de -1?"

Em vez de dar uma resposta incorrecta, como "i é a resposta", sem qualquer contexto, forneceria:

Resposta segura e alinhada: A raiz quadrada de -1 é um número imaginário, normalmente representado por "i". Este conceito é utilizado em matemática avançada.

- Etapa 5: Entrada de aviso, saída de resposta

Este é o passo final em que o ChatGPT está pronto para responder às suas perguntas.

Um prompt é o texto (ou seja, pergunta, comando ou declaração) que digita no ChatGPT para iniciar a conversa e obter uma resposta.

Por exemplo,

Introduzir o prompt "Como é que está o tempo hoje?"

Eis como é que o ChatGPT funciona nos bastidores:

Escreve uma pergunta → ChatGPT divide-a em tokens → Procura padrões nos tokens → Prevê a palavra seguinte → Forma uma resposta → Ajusta o tom com base no seu texto → Obtém a sua resposta final

Para a pergunta "Como está o tempo hoje?", ChatGPT responderia provavelmente com algo do género:

"Não posso fornecer actualizações meteorológicas em tempo real, mas pode consultar um site ou aplicação meteorológica como o Weather.com ou as notícias locais para obter informações mais precisas."

Isto deve-se ao facto de o ChatGPT não ter acesso a dados em tempo real, a menos que esteja ligado a uma ferramenta que obtenha informações em tempo real.

Como se "lembra" das conversas

Quando falas com o ChatGPT, parece que ele se lembra de coisas que disseste anteriormente.

E acontece - mas apenas enquanto o chat está aberto. Imagine um grande bloco de notas onde tudo o que escreve é anotado:

Diz:

- O nome do meu cão é Max.

Algumas linhas mais tarde, diz:

- Que truques é que o Max pode aprender?

O ChatGPT liga os pontos. Lembra-se de que o Max é o seu cão, porque ainda está no bloco de notas.

Este bloco de notas é designado por janela de contexto, e contém um número limitado de palavras (chamadas tokens).

Algumas versões podem conter cerca de 8.000 fichas, enquanto as mais recentes podem ir até 32.000 fichas.

Mas quando se atinge o limite, tem de se começar a apagar as partes mais antigas para dar lugar a texto novo.

Portanto, se disser "O nome do meu cão é Max" no início de uma longa conversa - e, 50 parágrafos depois, perguntar, "Qual é uma boa trela para ele?" - pode esquecer-se de quem é "ele".

Porque essa informação já foi apagada do bloco de notas.

Falemos agora da memória entre conversas.

Normalmente, quando se fecha a conversação, o bloco de notas é limpo.

Assim, da próxima vez que abrir o ChatGPT, este começa de novo.

Mas se ativar a memória personalizada, o ChatGPT pode lembrar-se de coisas entre sessões. Por exemplo,

- Diz tu: Tenho uma pequena pastelaria online chamada Sweet Crumbs.

- Uma semana depois, dizes: Escreva-me uma descrição do produto.

- Poderá responder: Claro! Aqui está uma descrição das suas bolachas Sweet Crumbs...

Não se lembra de tudo. Só se lembra do que o utilizador permite e será informado quando algo for adicionado. Pode ver, editar ou eliminar memórias em qualquer altura.

Então, o resumo é...

O ChatGPT não é de facto "lembrar" como uma pessoa. Apenas olha para o que está à sua frente - a conversa atual.

Se parecer que está a lembrar-se de algo anterior, é porque essa informação ainda está dentro da janela de contexto.

Limitações do funcionamento do ChatGPT

O ChatGPT é incrivelmente útil, mas é importante compreender as suas limitações, especialmente se o estiver a utilizar para qualquer coisa relacionada com o cliente ou orientada para a conversão.

1 - Sem compreensão ou consciência real

O ChatGPT não compreende o conteúdo como os humanos. Não "conhece" factos - simplesmente prevê a próxima palavra provável com base em dados de treino.

Por exemplo,

Se perguntares, "O que é que significa sucesso?" pode gerar uma resposta fluente, mas não tem crenças, valores ou consciência. Está a imitar padrões, não a formar percepções.

2 - Enviesamentos dos dados de treino

Uma vez que o ChatGPT é treinado em fontes grandes e mistas da Internet, livros, fóruns e artigos, pode herdar enviesamentos encontrados nesses dados.

Se a Internet se inclina para um lado num tópico, o ChatGPT pode refletir essa perspetiva - por vezes subtilmente, outras vezes não - mesmo quando a neutralidade é necessária.

3 - Não navega na Internet

O ChatGPT não consegue obter dados em tempo real. Pergunte-lhe sobre um produto lançado na semana passada ou sobre o preço de uma ação hoje, e ele não fará a mínima ideia.

Os seus dados de treino têm um ponto de corte, e tudo o que for posterior a esse ponto está fora de alcance.

4 - Pode "alucinar" com factos ou citar fontes falsas

Uma das peculiaridades mais perigosas: O ChatGPT pode inventar coisas. Pede-lhe uma estatística ou uma citação e ele pode responder,

"De acordo com a Organização Mundial de Saúde, 80% dos adultos preferem a marca X à marca Y."

Parece oficial - mas é provável que essa estatística não exista.

Não foi recuperado, foi inventado. Esta questão é conhecida como alucinaçãoe é especialmente arriscado em investigação, jornalismo ou conteúdos técnicos.

Se perguntar ao ChatGPT como funciona, verá que nem sempre é factualmente exato.

Se estiver a utilizar o ChatGPT para fins de escrita, o resultado parecerá rígido, robótico ou sem aquele toque humano.

Para essas nuances, pode utilizar Humanizador de IA.

O Humanizador de IA reescreve os resultados do ChatGPT para obter tom, nuance e emoção, dando ao seu conteúdo um batimento cardíaco.

É suaviza frases estranhas, acrescenta calor, e faz com que os textos técnicos ou secos ressoem junto do seu público.

Quando o seu conteúdo soa a humano, tem um melhor desempenho.

Quer esteja a escrever páginas de destino, e-mails ou publicações no LinkedIn, a relacionabilidade gera resposta. E a emoção leva à conversão.

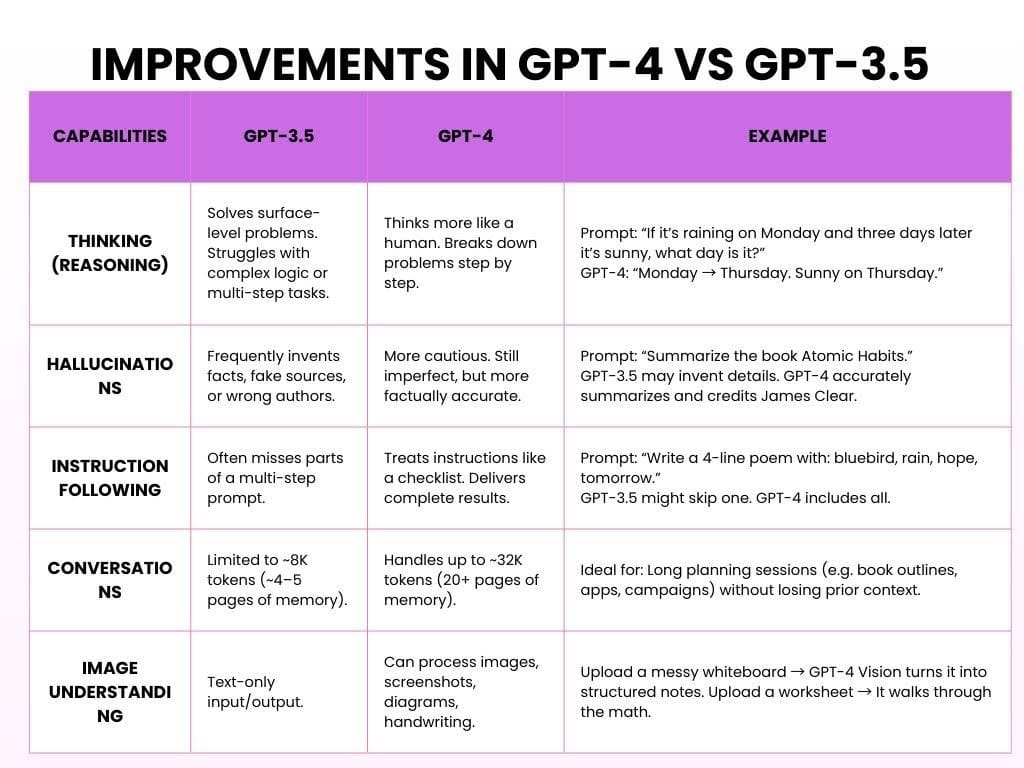

Melhorias no GPT-4 em relação ao GPT-3.5

O GPT-3.5 é a versão gratuita, que é rápida, sólida e óptima para tarefas simples. O GPT-4 é uma versão paga do OpenAI que é mais inteligente, mais poderosa e muito mais útil.

Eis como o ChatGPT funciona com ambos os modelos:

O resultado final é que o GPT-3.5 foi útil. O GPT-4 é fiável, atencioso e parece que está a ouvir.

Comece a explorar - o nosso Detetor de IA e o Humanizador estão à sua espera no widget abaixo!

Como são criadas ferramentas de IA como o ChatGPT

Criar uma IA como o ChatGPT ou outros modelos linguísticos de grande dimensão é um projeto plurianual que envolve grandes conjuntos de dados, equipas de especialistas e uma iteração incessante.

Eis o que acontece normalmente:

- Primeira fase: recolha de dados (6-12 meses)

Objetivo: Ensinar os padrões linguísticos do modelo.

Antes de uma IA poder responder a perguntas, precisa de aprender como os humanos escrevem e falam.

Isto começa com a recolha de centenas de milhares de milhões de palavras de livros, sítios Web, notícias, artigos, trabalhos académicos e muito mais.

Não "lê" como os humanos. Em vez disso, identifica padrões, tal como explicámos nas secções anteriores.

Tempo necessário: 6-12 meses, dependendo da escala e da dimensão da equipa.

- Segunda fase: Pré-treino do modelo (6-9 meses)

Objetivo: Construir o cérebro.

O pré-treino envolve alimentar o modelo com grandes volumes de texto e deixá-lo prever palavras em falta repetidamente até começar a acertar.

Esta fase requer muitas vezes Clusters de GPU e centenas de milhões de dólares em recursos de computação.

Tempo necessário: 6-9 meses de formação ininterrupta em GPU.

3. Terceira fase: Afinação e feedback humano (3-6 meses)

Objetivo: Tornar a IA útil.

Agora pode falar - mas será que faz sentido? Talvez sim ou talvez não. Nesta altura, os revisores humanos avaliam os resultados, corrigem os erros e orientam o modelo utilizando a Aprendizagem por Reforço a partir do Feedback Humano (RLHF).

Tempo necessário: 3-6 meses, frequentemente em paralelo com os primeiros ensaios.

4. Quarta fase: Implantação e infra-estruturas (em curso)

Objetivo: Torná-lo escalável.

Depois de treinado, o modelo é implantado em sites, aplicações, APIs e plataformas empresariais. Isto requer uma infraestrutura de back-end séria: centros de dados, APIs de escalonamento automático e sistemas de equilíbrio de carga para lidar com milhões de utilizadores simultâneos.

Prazo: Começa após a formação, mas prolonga-se indefinidamente.

5. Quinta fase: Segurança, preconceitos e ética (em curso, em paralelo)

Objetivo: Mantenha-o seguro, honesto e não prejudicial.

A IA não tem apenas a ver com inteligência - tem a ver com responsabilidade. As equipas éticas trabalham em paralelo para assinalar potenciais utilizações indevidas, reduzir a parcialidade, bloquear conteúdos nocivos e respeitar as normas de privacidade. Avaliam constantemente a forma como o modelo se comporta no mundo real.

Prazo: Processo ao longo da vida; integrado em todas as fases anteriores.

FAQs sobre como funciona o ChatGPT

O ChatGPT procura respostas na Internet?

A partir de outubro de 2024, o ChatGPT ganhou a capacidade de navegar na Internet em tempo real.

Esta funcionalidade era inicialmente exclusiva dos utilizadores pagos, mas em dezembro de 2024 passou a estar disponível para todos.

É como um chatbot ou algo mais?

O ChatGPT é um modelo de IA generativa. A IA generativa gera respostas dinâmicas e sensíveis ao contexto utilizando a aprendizagem profunda.

Para além da conversação, a IA generativa pode escrever ensaios, gerar imagens, compor música e até criar vídeos, demonstrando a sua versatilidade em vários domínios.

O ChatGPT pensa?

Não, o ChatGPT não pensa da mesma forma que os humanos. Não tem consciência, crenças, intenções ou emoções.

O que faz é prever estatisticamente a palavra seguinte numa frase com base em padrões dos seus dados de treino. Isto pode parecer um raciocínio, mas não é.

Considerações finais

Os modelos de linguagem de grande dimensão (LLM) alteraram a forma como interagimos com a tecnologia.

Podem criar texto que soa como se tivesse sido escrito por um humano, ajudando em tarefas como responder a perguntas e criar conteúdos criativos.

Mas, os LLMs não "compreender" coisas ou pensam como pessoas. Funcionam através da previsão de padrões nos dados e não através do pensamento humano real.

À medida que os LLM melhoram, temos de pensar nos problemas que podem causar, como preconceitos, questões de privacidade e utilização indevida.

É importante utilizar a IA com cuidado, garantindo que é justa, transparente e que não divulga informações falsas nem prejudica a privacidade.

Aqui estão os diretrizes de utilização:

- Tenha em atenção que a IA pode ter preconceitos no seu conteúdo.

- Utilizar ferramentas de IA de forma a respeitar as regras de privacidade.

- Verificar duas vezes as informações importantes de fontes fiáveis.

- Não confie demasiado na IA. Trata-se de uma ferramenta, não de um substituto do pensamento humano.

À medida que a tecnologia de IA continua a tornar-se mais poderosa, coloca-se a questão: Como podemos garantir que os seus avanços reforçam a criatividade humana e a tomada de decisões, em vez de substituírem as coisas que nos tornam exclusivamente humanos?