Mit dem KI-Prompt rechtskannst du im Grunde alles machen. So mächtig sind die KI-Werkzeuge bereits.

KI-Tools haben die Arbeitsweise von Unternehmen verändert und ermöglichen es ihnen, Prozesse zu rationalisieren und die Effizienz zu steigern wie nie zuvor.

Ein Bereich, in dem sich KI wirklich auszeichnet, ist die Erstellung von Inhalten. Dabei geht es nicht nur um das Verfassen von Entwürfen oder das Erstellen von Social Media Posts.

KI kann dir sogar helfen Bücher schreiben und komplexe Forschungsarbeiten abschließen.

Aber mit großer Macht kommt auch große Verantwortung, und man kann sich nicht immer darauf verlassen, dass die KI das Richtige tut.

Manchmal erzeugt die KI sogenannte "Halluzinationen". Das sind falsche oder bizarre Ausgaben, die den Nutzer in die Irre führen können.

Fast die Hälfte der Unternehmen berichtet Probleme mit der Datenqualität, die KI-Initiativen gefährden.

Es ist kein Allheilmittel, aber das "Grounding" soll sicherstellen, dass die KI-Ergebnisse auf verlässlichen Informationen beruhen.

Die Antwort auf die Frage "Was sind Erdung und Halluzinationen in der KI?" mag zwar kompliziert klingen, ist aber entscheidend für alle, die diese mächtigen Werkzeuge nutzen.

Lass uns in die Details der KI-Halluzination einsteigen, damit du deinen Output mit KI selbstbewusst maximieren und gleichzeitig sicherstellen kannst, dass deine Informationen korrekt bleiben.

Wichtigste Erkenntnisse

- KI-Halluzinationen treten auf, wenn Modelle aufgrund von Datenlücken oder Überanpassung falsche oder irreführende Informationen erzeugen.

- Die Erdung verankert die KI-Ausgaben in verifizierten, realen Daten, um Halluzinationen zu reduzieren und die Zuverlässigkeit zu verbessern.

- Halluzinationen bei der Erstellung von Inhalten können der Glaubwürdigkeit schaden, Fehlinformationen verbreiten und rechtliche Probleme verursachen.

- Beugen Sie Problemen vor, indem Sie zuverlässige Tools verwenden, den Inhalt überprüfen und klare, detaillierte Anweisungen geben.

- Die Kombination von KI-Erkennung und menschlicher Aufsicht - wie bei Undetectable AI - gewährleistet Genauigkeit und Authentizität.

Was sind Grounding und Halluzinationen in der KI?

Wenn es darum geht, zu verstehen, was Halluzinationen in der KI sind, ist das Wissen darüber, wie sie auftreten können, besonders hilfreich für Organisationen, die möglichst genaue Informationen benötigen.

Wenn du etwas über Erdung und künstliche Intelligenz lernst, kannst du besser verstehen, wie KI-Tools funktionieren, und sicherstellen, dass deine KI-generierte Inhalte bleibt glaubwürdig.

Was sind Halluzinationen bei KI?

Stell dir vor, du fragst einen KI-Chatbot nach Informationen über eine Person.

Machen Sie sich nie wieder Sorgen, dass KI Ihre Texte erkennt. Undetectable AI Kann Ihnen helfen:

- Lassen Sie Ihr AI-unterstütztes Schreiben erscheinen menschenähnlich.

- Bypass alle wichtigen KI-Erkennungstools mit nur einem Klick.

- Verwenden Sie AI sicher und zuversichtlich in Schule und Beruf.

Das Modell liefert präzise Details, die häufig in verschiedenen Online-Quellen erwähnt werden.

Aber wenn du die Informationen überprüfst, stellst du fest, dass die KI auch weniger bekannte Informationen wie das Alter und den Bildungshintergrund falsch einschätzt.

Diese falschen Details werden als "Halluzinationen" bezeichnet.

Halluzinationsraten kann von Modell zu Modell variieren. ChatGPT berichtete zuvor über 3%während die Systeme von Google auf bis zu 50 Millionen Euro geschätzt wurden. 27%.

Diese Chatbots werden von einem großen Sprachmodell gesteuert, das aus der Analyse großer Textmengen lernt.

Das passiert, weil diese Modelle darauf trainiert sind, Wörter auf der Grundlage von Mustern in den analysierten Daten vorherzusagen, ohne zu verstehen, was wahr ist und was nicht.

Halluzinationen entstehen meist durch unvollständige Trainingsdaten.

Denke daran, dass das Modell Fehler aufnehmen und reproduzieren kann, je nachdem, womit es gefüttert wird.

Es gibt auch eine "Überanpassung", bei der das Modell falsche Muster oder Verbindungen in den Daten identifiziert.

Das Lösen von KI-Halluzinationen ist eine Herausforderung, weil diese Modelle, die mit Wahrscheinlichkeiten und Mustern arbeiten, unvermeidlich falsche Ergebnisse liefern werden.

Das kann Nutzerinnen und Nutzer in die Irre führen, die den KI-Inhalten so vertrauen, wie sie sind. Deshalb ist es wichtig, sich dieser Einschränkung bewusst zu sein, wenn du KI für die Erstellung von Inhalten und die Überprüfung von Fakten einsetzt.

Was ist Grounding AI?

KI zu erden ist eine effektive Methode, um Halluzinationen zu reduzieren. Sie funktioniert, indem sie die Antworten der KI mit Daten aus der realen Welt verknüpft.

Ein geerdetes System würde zum Beispiel von Anfang an eine verlässliche Datenbank nutzen, um sachliche Antworten zu geben und so die Wahrscheinlichkeit zu verringern, dass die KI etwas erfindet.

Anstatt sich nur auf die Vorhersage des nächsten Wortes auf der Grundlage von Mustern zu verlassen, holt sich ein geerdetes System zunächst Informationen aus einer glaubwürdigen Quelle.

Das Modell ist auch ethisch vertretbarer, weil es zugibt, dass der Kontext unzureichend ist und es daher nicht alle Informationen liefern kann, die du brauchst, anstatt nur zu raten.

Um den Wert der KI zu maximieren und gleichzeitig Ungenauigkeiten zu minimieren, sollten Unternehmen im Vorfeld Zeit investieren, um genaue Trainingsdaten, Richtlinien und andere notwendige Hintergrundinformationen zu sammeln.

Diese Vorbereitung trägt dazu bei, dass die KI-Ausgaben in der Realität verankert bleiben und die Nutzer/innen ihnen vertrauen können.

Erdung ist zwar keine narrensichere Lösung, aber sie kann die Qualität der KI-Ergebnisse erheblich verbessern.

Was ist das Problem der KI-Halluzination bei der Erstellung von Inhalten?

Bei der Erstellung von Inhalten können KI-Halluzinationen verschiedene Formen annehmen.

Bei der Erstellung eines Blogposts oder Artikels kann die KI falsche Fakten, falsche Statistiken oder erfundene Zitate einbauen.

KI-Halluzination ist auch keine absichtliche Täuschung. Das Modell kann nicht lügen, denn es hat weder eine Motivation zu täuschen, noch ist es sich bewusst, dass das, was es sagt, falsch ist.

Es fehlt einfach das Gefühl dafür, wie zuverlässig die Ergebnisse sind.

Die Folgen von KI-Halluzinationen bei der Erstellung von Inhalten können schwerwiegend sein.

- Verbreitung von Fehlinformationen: Mehr als eine von fünf Personen zugeben, dass sie möglicherweise Fake News ungeprüft weitergegeben haben.

- Schaden für die Glaubwürdigkeit: Wenn eine Person oder ein Unternehmen Inhalte mit irreführenden Informationen veröffentlicht, kann ihr Ruf darunter leiden. Vertrauen ist für die Nutzer/innen wichtig, und wenn es einmal verloren ist, kann es schwierig sein, es wiederzugewinnen.

- Rechtliche und finanzielle Auswirkungen: Die Veröffentlichung falscher Informationen kann zu Kopfschmerzen und sogar zu Klagen führen. Das ist ein kostspieliger Kampf, den du nicht führen willst.

- Negative Auswirkungen auf Geschäftsentscheidungen: Unternehmen, die sich bei der Erstellung von Berichten und Erkenntnissen zur Entscheidungsfindung auf KI verlassen, können auf der Grundlage falscher Daten schlechte Entscheidungen treffen. Falsche Informationen schaden sowohl dem Publikum als auch dem Unternehmen oder der Person, die KI für die Erstellung von Inhalten einsetzt. Und KI-Halluzinationen können dieses Problem sogar noch verschlimmern, indem sie Inhalte erzeugen, die glaubwürdig erscheinen, aber in Wirklichkeit fehlerhaft sind.

Wie du Probleme durch KI-Halluzinationen verhinderst

Wir wissen, wie wertvoll KI-Tools bei der Erstellung von Inhalten sind. Der Einsatz von KI wird sogar als eine der Die besten Wege, Geld zu verdienen heute und um in der Branche wettbewerbsfähig zu bleiben.

Das ist auch der Grund, warum es so wichtig ist, das Problem der KI-Halluzinationen anzugehen, um sicherzustellen, dass die Inhalte, die du mit KI verwendest, korrekt sind.

Die Grenzen der KI verstehen

Auch wenn wir bereits wissen, wie leistungsfähig KI ist, hat sie ihre Grenzen.

Wenn es um die Erstellung von Inhalten geht, funktioniert die Mustererkennung und die Generierung von Text auf der Grundlage riesiger Datensätze sehr gut, aber es fehlt noch immer der Sinn für die Realität.

Behalte diese Einschränkungen im Hinterkopf, wenn du KI einsetzt:

- Schwierigkeiten, Zusammenhänge zu erfassen oder subtile kulturelle Unterschiede zu verstehen

- Hängt stark von der Qualität und Quantität der verfügbaren Informationen ab

- Tendenz zur Bildung von Vorurteilen auf der Grundlage der Trainingsdaten

- Es fehlt an menschenähnlicher Kreativität und Originalität

- Kann Inhalte erzeugen, die moralisch fragwürdig sind

- Hat Schwierigkeiten, Probleme außerhalb dessen zu lösen, was das System weiß

- Schwierigkeiten bei der Anpassung an sich ändernde Situationen oder bei der Bereitstellung von Echtzeit-Input

- Anfällig für Angriffe und kann den Datenschutz gefährden

Wer seine Grenzen kennt, verhindert auch KI-Halluzinationen. Grenzen helfen dabei, realistische Erwartungen zu setzen und machen es einfacher, Ungenauigkeiten zu erkennen, bevor sie öffentlich werden.

Verlässliche Modelle und Werkzeuge verwenden

Die Die besten KI-Tools für die Erstellung von Inhalten machen die Dinge einfach. Diese Werkzeuge sind nicht perfekt, aber das, was du verwendest, sollte die Arbeit auf jeden Fall erledigen.

Für KI-Chatbots ist ChatGPT immer noch die Der Stärkste da draußen. GPT-4 hat eine hohe Genauigkeitsrate von 97% und die niedrigste Rate an ChatGPT-Halluzinationen.

Achte nur darauf, dass du klare Anweisungen gibst und die Ergebnisse mit zuverlässigen Quellen vergleichst.

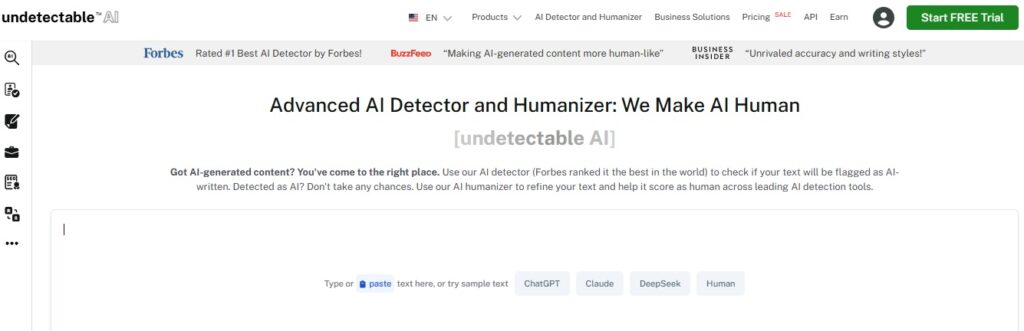

Du solltest auch vertrauenswürdige KI-Erkennungstools verwenden wie Nicht nachweisbare AI.

Die Detektoren analysieren Inhalte effektiv, um selbst die subtilsten KI-Elemente zu erkennen. So bleiben deine Inhalte authentisch und du bleibst glaubwürdig.

Unauffindbar hat auch eine AI Humanizer die den Text weiter verfeinert, damit er natürlich klingt.

Damit bestehst du nicht nur die KI-Erkennung, sondern garantierst auch die Qualität deiner Inhalte.

Inhalt prüfen

Unabhängig davon, wie du KI bei der Erstellung von Inhalten einsetzt, ist es immer wichtig, die von dir erstellten Inhalte zu überprüfen.

Dies sind einige gängige Methoden zur Überprüfung von KI-Inhalten:

- Vergleiche Informationen aus mehreren zuverlässigen Quellen

- Nutze Tools zur Faktenüberprüfung, um Fehlinformationen schneller zu entlarven

- Erkundige dich bei Fachleuten oder Experten auf dem Gebiet

- Lasse den Inhalt von Gleichaltrigen oder Kollegen überprüfen, um mögliche Fehler, Vorurteile oder Ungenauigkeiten zu erkennen

- Verwende KI-Erkennungssoftware, um Originalität sicherzustellen und zu vermeiden ungewolltes Plagiat

- Berücksichtige den historischen Kontext, wenn du dich auf Ereignisse oder Daten beziehst, um Genauigkeit zu gewährleisten.

Vorsichtsmaßnahmen zu treffen, zahlt sich aus. Die Überprüfung von KI-Inhalten gibt dir die dringend benötigte Sicherheit, dass das, was du produzierst, immer vertrauenswürdig ist.

Klare Anweisungen erteilen

Eine der Hauptursachen für KI-Halluzinationen sind unklare Anweisungen.

Wenn du der KI Fragen stellst, die zu vage sind und keinen zusätzlichen Kontext enthalten, ist die Wahrscheinlichkeit größer, dass sie Antworten gibt, die nicht viel Sinn ergeben.

KI wird durch klare und spezifische Aufforderungen auf Kurs gehalten.

Sei also spezifisch und detailliert in deinen Aufforderungen.

Anstatt allzu allgemeine Fragen zu stellen wie "Welches ist das beste asiatische Restaurant?", solltest du lieber etwas gezielter nachfragen, z.B. "Welches sind die besten Ramen-Läden in Kyoto?"

Spezifität hilft der KI, auf Kurs zu bleiben und genaue Ergebnisse zu erzielen, die deinen Erwartungen entsprechen.

Bleiben Sie auf dem Laufenden

Die Technologie entwickelt sich immer weiter, und zwar in rasantem Tempo, deshalb solltest du dich auf dem Laufenden halten.

KI lernt im Wesentlichen aus den Daten, auf die sie trainiert wurde, aber die Informationen können schnell veraltet sein.

Das gilt besonders in schnelllebigen Bereichen wie der wissenschaftlichen Forschung oder dem Gesundheitswesen.

Du kannst dich auf dem Laufenden halten, indem du vertrauenswürdigen Quellen in den sozialen Medien folgst, oder du kannst Kurse besuchen, die mit deiner Branche zu tun haben, und an Branchenveranstaltungen teilnehmen.

Auf diese Weise hast du Einblicke in die von der KI bereitgestellten Inhalte und bleibst glaubwürdig.

Auch die KI-Tools selbst werden häufig aktualisiert. Halte dich also über die neuesten Entwicklungen auf dem Laufenden, damit du sicher sein kannst, dass du immer die besten Tools verwendest.

Menschliche Kompetenz

Menschen und KI müssen zusammenarbeiten, um Qualität, Genauigkeit und Authentizität bei der Erstellung von Inhalten zu gewährleisten

Schließlich sind wir diejenigen, die kritisches Denken, Kreativität und ethisches Urteilsvermögen mitbringen.

Durch die Kombination der KI-Fähigkeiten mit menschlicher Aufsicht kannst du sicherstellen, dass die Inhalte nicht nur korrekt, sondern auch kontextbezogen relevant sind - und dass sie ansprechend sind und den richtigen Ton treffen.

Menschliche Expertinnen und Experten können Vorurteile erkennen, Informationen doppelt überprüfen und Entscheidungen treffen, die KI allein vielleicht nicht erfassen kann.

Menschen und KI können gemeinsam Inhalte erstellen, die zuverlässig, aufschlussreich und wirkungsvoll sind.

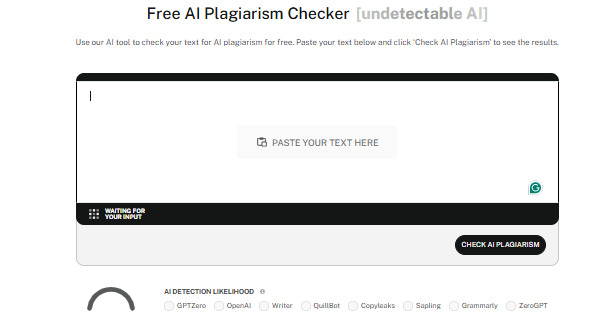

Sehen Sie sich unseren AI-Detektor und Humanizer im Widget unten an!

Schlussfolgerung

Zu verstehen, was Erdung und Halluzinationen in der KI sind, ist für jeden, der KI-Tools bei seiner Arbeit einsetzt, unerlässlich.

Grounding macht KI genauer und bewahrt die Integrität deiner Inhalte, indem es echte, verifizierte Daten verwendet.

Wenn du dir über KI-Halluzinationen im Klaren bist, kannst du auch die richtigen Wege finden, um sie zu vermeiden und möglichen Fallstricken aus dem Weg zu gehen.

Die Genauigkeit von KI-Inhalten ist nur eine Seite des Prozesses. Stelle sicher, dass deine Inhalte authentisch und hochwertig bleiben, indem du Undetectable AI einsetzt.

Dieses Tool fungiert sowohl als KI-Detektor als auch als Humanizer. Es stellt sicher, dass KI-generierte Inhalte nahtlos mit menschlichen Texten verschmelzen und die Erkennungen bestehen können.

Wählen Sie die besten KI-Inhaltsprüfungsoptionen für Ihre Bedürfnisse und lassen Sie Nicht nachweisbare AI sorgen Sie dafür, dass Ihre Inhalte stets zuverlässig, originell und menschlich sind. Beginnen Sie noch heute damit.