Models sind wie Assistenten. Man kann ihnen ein Ziel vorgeben, und sie tun genau das, was man von ihnen verlangt, manchmal ein bisschen zu gut.

Doch manchmal ist das, was man sich wünscht, nicht genau das, was man braucht. Es klingt rückwärtsgewandt, aber Modelle können das Ziel verfehlen, ohne jemals etwas “falsch” zu machen.”

Diese Diskrepanzen werden als “Alignment Gaps” bezeichnet, d. h. als frustrierende und heimtückische Divergenzen zwischen dem, was der Mensch mit KI vorhat, und dem, wie sie sich verhält.

Diese Lücken schleichen sich in der Regel langsam ein und beeinträchtigen schließlich Ihren gesamten Arbeitsablauf. Aber wenn man weiß, wie man sie erkennt, sind sie viel weniger bedrohlich.

Lassen Sie uns eintauchen.

Wichtigste Erkenntnisse

- Lücken in der Modellanpassung entstehen, wenn die KI zwar den Anweisungen folgt, aber die zugrundeliegenden Absichten oder Geschäftsziele nicht beachtet.

- Zu den Warnzeichen gehören die oberflächliche Einhaltung der Vorschriften, eine uneinheitliche Ausgabequalität und die Notwendigkeit häufiger menschlicher Korrekturen.

- Die Erkennung erfordert systematische Tests, Musteranalysen und eine angemessene Dokumentation des KI-Verhaltens.

- Zu den Korrekturmaßnahmen gehören eine zeitnahe Optimierung, Parameteranpassungen und regelmäßige Audits der Arbeitsabläufe.

- Die Vorbeugung hängt von klaren Kommunikationsprotokollen und menschenlesbaren Anweisungssystemen ab, die von den Teams wirksam umgesetzt werden können.

Lücken in der Modellanpassung klar verstehen

Lassen wir den Fachjargon beiseite. Modellanpassungslücken entstehen, wenn es eine Diskrepanz zwischen dem gibt, was die KI tun soll, und dem, was sie tatsächlich tut.

Nicht in offensichtlichen Formen wie Komplettausfällen oder Fehlermeldungen.

Ausrichtungslücken sind subtil, und das Modell erzeugt etwas, das korrekt aussieht. Es folgt der Struktur Ihrer Eingabeaufforderung und enthält die von Ihnen gewünschten Elemente, aber irgendetwas fühlt sich falsch an, weil die Ausgabe Ihr eigentliches Ziel verfehlt.

Machen Sie sich nie wieder Sorgen, dass KI Ihre Texte erkennt. Undetectable AI Kann Ihnen helfen:

- Lassen Sie Ihr AI-unterstütztes Schreiben erscheinen menschenähnlich.

- Bypass alle wichtigen KI-Erkennungstools mit nur einem Klick.

- Verwenden Sie AI sicher und zuversichtlich in Schule und Beruf.

Definition in praktischen Begriffen

Angenommen, Sie bitten jemanden, eine E-Mail an den Kundendienst zu schreiben. Sie verfassen grammatikalisch perfekte Sätze, enthalten eine Begrüßung und ein Schlusswort und verweisen auf das Problem des Kunden.

Aber der Ton ist völlig daneben. Er klingt roboterhaft, und er löst das Problem nicht wirklich. Technisch gesehen erfüllt es alle Kriterien, aber in der Praxis ist es nutzlos.

Das ist eine Ausrichtungslücke.

Unter KI-Workflows, Dies zeigt sich ständig:

- Ein Inhaltsmodell, das mit Schlüsselwörtern vollgestopften Müll anstelle von hilfreichen Artikeln produziert.

- Ein Datenanalysetool, das genaue Zahlen in Formaten ausspuckt, die niemand nutzen kann.

- Ein Chatbot, der Fragen korrekt beantwortet, aber die Kunden mit seiner Vorgehensweise vergrault.

Das Modell entsprach Ihren wörtlichen Anweisungen. Es entsprach nicht Ihren tatsächlichen Bedürfnissen.

Anzeichen, die auf Ausrichtungsprobleme hinweisen

Einzelne Fehler sind typisch, aber wenn sich Probleme auf dieselbe Weise wiederholen, ist das in der Regel ein Zeichen dafür, dass das Modell für die falsche Sache optimiert wurde.

Hier sind einige Anzeichen:

- Einhaltung der Vorschriften an der Oberfläche ohne Tiefe: Ihre KI produziert Ergebnisse, die zwar die grundlegenden Anforderungen erfüllen, aber keine Substanz haben. Der Inhalt ist zwar wortreich, sagt aber nichts Nützliches aus, der Code läuft, ist aber nicht wartbar, und die Analyse ist technisch korrekt, aber strategisch wertlos.

- Übermäßiges menschliches Eingreifen erforderlich: Sie verbringen mehr Zeit mit der Korrektur von KI-Ergebnissen als mit der Erstellung von Neuem. Jedes Ergebnis muss gründlich überarbeitet werden, was bedeutet, dass Sie die KI im Wesentlichen als einen sehr teuren ersten Entwurfsgenerator verwenden.

- Probleme bei der wörtlichen Auslegung: Die KI nimmt Anweisungen für bare Münze, ohne den Kontext zu verstehen. Sie fragen nach “kurz” und erhalten Ein-Satz-Antworten, die wichtige Informationen auslassen. Sie bitten um “ausführlich” und erhalten aufsatzlangen Unsinn, der auch drei Absätze lang hätte sein können.

- Zielverschiebung: Anstatt sich auf das Wesentliche zu konzentrieren, jagt das Modell den falschen Signalen hinterher, wie Geschwindigkeit statt Genauigkeit, saubere Formatierung statt solider Inhalte und ausgefeilte Ergebnisse, die dennoch logische Mängel aufweisen.

- Halluzination der falschen Compliance: Das Modell behauptet, Dinge getan zu haben, die es nicht getan hat. Es behauptet, Quellen überprüft zu haben, aber wenn es etwas erfunden hat, hat es die Zwänge, die es zu verstehen vorgab, völlig ignoriert. Halluzinationen sind besonders gefährlich, weil sie falsches Vertrauen schaffen.

- Ethische oder markenbezogene Unausgewogenheit: Manchmal ist das Problem nicht die Korrektheit, sondern die Passgenauigkeit. Der Ton des Modells passt nicht zu Ihrer Zielgruppe, seine Antworten stehen im Widerspruch zu Ihren Markenwerten, oder es trifft nicht die Nuance, wie Sie sich zeigen wollen.

Sie werden wahrscheinlich nicht alle auf einmal sehen. Aber wenn Sie mehrere bemerken, haben Sie Probleme mit der Ausrichtung.

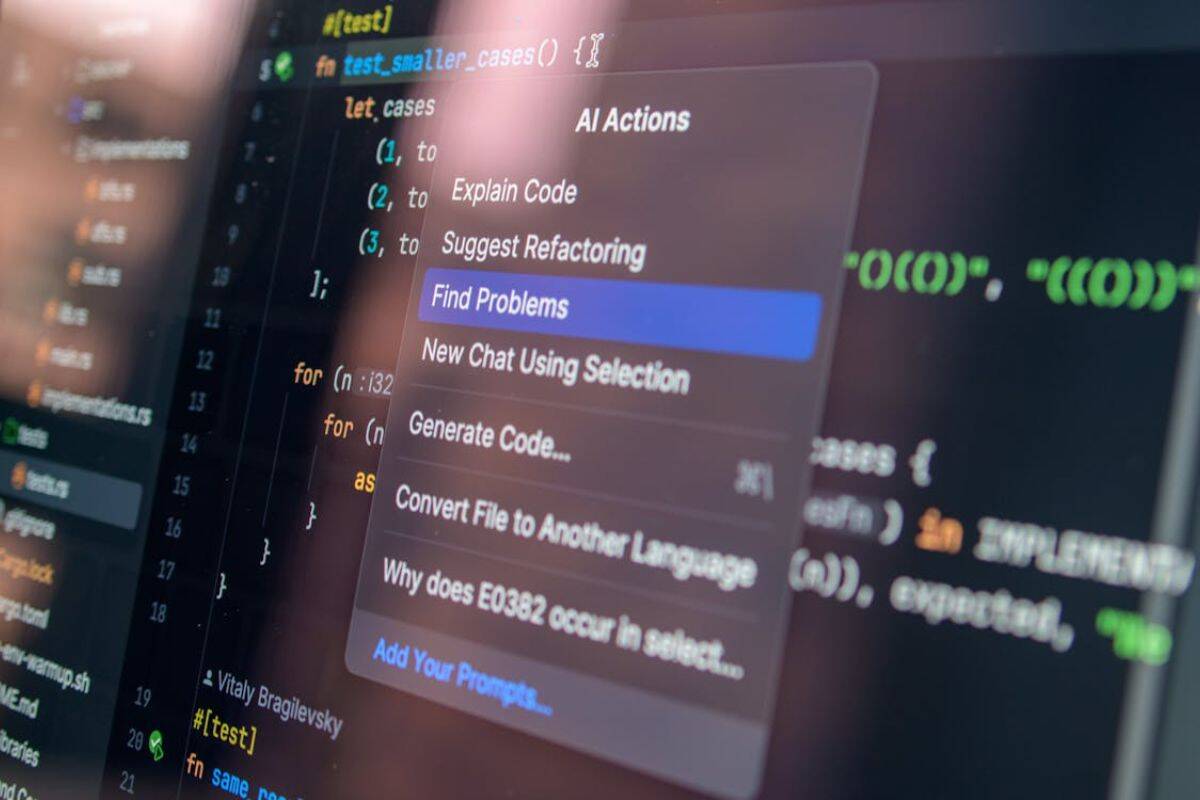

Werkzeuge und Methoden zur Erkennung von Ausrichtungslücken

Die Erkennung erfordert ein systematisches Vorgehen. Man kann nicht einfach die Ausgaben mit den Augen betrachten und hoffen, dass man alles erwischt.

- Erstellen Sie Testsuiten mit Randfällen. Erstellen Sie eine Sammlung von Aufforderungen, die die Grenzen testen. Fügen Sie zweideutige Anweisungen ein, fügen Sie widersprüchliche Anforderungen hinzu, sehen Sie, wie das Modell mit Nuancen und Kontext umgeht, und dokumentieren Sie, was funktioniert und was nicht.

- Einführung einer Versionskontrolle für Prompts. Verfolgen Sie jede Änderung an Ihren Anweisungen, indem Sie notieren, welche Versionen zu besseren Ergebnissen führen und feststellen, welche Änderungen eine Verschlechterung der Ausrichtung bewirken. Auf diese Weise haben Sie die Möglichkeit, Experimente rückgängig zu machen, wenn sie fehlschlagen.

- Führen Sie regelmäßig A/B-Vergleiche durch. Testen Sie dieselbe Aufgabe mit verschiedenen Eingabeaufforderungen oder Modellen und vergleichen Sie die Ergebnisse nebeneinander. Oft sind die Qualitätsunterschiede nicht sofort ersichtlich. Kleine Variationen in den Anweisungen können große Lücken in der Abstimmung offenbaren.

- Festlegung von Qualitätsmaßstäben. Definieren Sie für jeden Anwendungsfall, wie gut die Ergebnisse tatsächlich aussehen. Erstellen Sie Rubriken, die über oberflächliche Metriken hinausgehen, messen Sie die Ergebnisse konsequent an diesen Standards und automatisieren Sie Prüfungen, wo dies möglich ist.

- Überwachung der nachgelagerten Auswirkungen. Verfolgen Sie, was passiert, nachdem die KI Output produziert hat. Gibt es mehr Kundenbeschwerden? Verbringen Teammitglieder mehr Zeit mit Überarbeitungen? Steigen die Fehlerquoten? Manchmal zeigen sich Anpassungslücken eher in den Konsequenzen als in den Ergebnissen.

- Sammeln Sie systematisch das Feedback der Interessengruppen. Befragen Sie die Menschen, die KI-Outputs verwenden, nach ihren Erfahrungen. Schaffen Sie Feedbackschleifen, die Frustrationen frühzeitig auffangen und dokumentieren Sie konkrete Beispiele, wenn etwas schief läuft.

- Analysieren Sie Fehlermuster. Wenn etwas kaputt geht, untersuchen Sie die Gründe dafür. Suchen Sie nach Gemeinsamkeiten bei Fehlern. Identifizieren Sie auslösende Wörter oder Szenarien, die immer wieder Probleme verursachen. Erstellen Sie eine Fehlersammlung zum Nachschlagen.

Eine ordnungsgemäße Dokumentation ist besonders wichtig, da sie Ihnen hilft, die Ergebnisse nachzuvollziehen, die Erkenntnisse zu organisieren und Ihrem Team Probleme klar zu vermitteln.

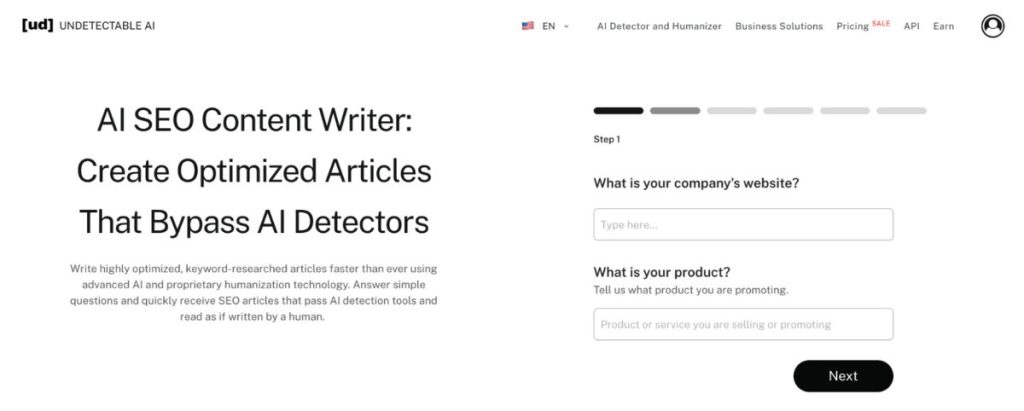

Nicht nachweisbare AI's AI SEO Inhaltsverfasser eignet sich hervorragend für die Strukturierung dieser Art von Dokumentation, auch wenn Sie die SEO-Seite nicht nutzen.

Es verwandelt verstreute Beobachtungen in kohärente Berichte, die den Arbeitsablauf tatsächlich verbessern.

Anstatt in unorganisierten Notizen über Ausrichtungsprobleme zu ertrinken, erhalten Sie lesbare Analysen, auf deren Grundlage die Teams handeln können.

Abhilfemaßnahmen zur Beseitigung von Ausrichtungslücken

Das Auffinden von Ausrichtungslücken ist nur die halbe Miete. Man muss sie auch beheben.

Prompts und Anweisungen anpassen

Die meisten Ausrichtungsprobleme sind auf unklare Anweisungen zurückzuführen. Sie Sie wissen, was Sie wollen, aber das Modell weiß es nicht.

- Geben Sie nicht nur die Anforderungen, sondern auch die Absicht an: Listen Sie nicht einfach nur auf, was alles enthalten sein soll. Erklären Sie, warum es wichtig ist, und beschreiben Sie dann das Ziel. Geben Sie einen Überblick über die Zielgruppe und den Anwendungsfall.

- Nennen Sie Beispiele für gute und schlechte Ergebnisse: Zeigen Sie dem Modell, wie Erfolg aussieht. Ebenso wichtig ist es, zu zeigen, was zu vermeiden ist, wenn konkrete Beispiele schlagen abstrakte Anweisungen jedes Mal.

- Fügen Sie Beschränkungen hinzu, die die Ausrichtung erzwingen: Wenn das Modell weiterhin zu förmlich ist, geben Sie einen lockeren Ton an und nennen Sie Beispiele. Wenn es Fakten vorgaukelt, bitten Sie um Zitate. Wenn es den Kontext vermissen lässt, fordern Sie einen Verweis auf frühere Informationen.

- Unterteilen Sie komplexe Aufgaben in kleinere Schritte: Lücken in der Abstimmung entstehen oft, wenn man zu viel auf einmal verlangt. Zerlegen Sie Arbeitsabläufe in einzelne Phasen, und Sie werden leichter erkennen können, wo etwas schief läuft.

- Verwenden Sie eine einheitliche Terminologie für alle Aufforderungen: Eine uneinheitliche Sprache verwirrt die Modelle. Wählen Sie spezifische Begriffe für spezifische Konzepte. Verwenden Sie diese einheitlich und schaffen Sie ein gemeinsames Vokabular für Ihren Arbeitsablauf.

In der Anpassungsphase, nicht nachweisbare AI Prompt-Generator ist von unschätzbarem Wert. Anstatt Hunderte von Prompt-Variationen manuell zu erstellen und zu testen, generiert das Tool optimierte Anweisungen die darauf abzielen, Modelle zu einem angepassten Verhalten anzuleiten.

Feinabstimmung der Modellparameter

Manchmal liegt das Problem nicht an den Eingabeaufforderungen. Es liegt daran, wie das Modell konfiguriert ist.

- Temperatureinstellungen anpassen: Niedrigere Temperaturen verringern Zufälligkeit und Halluzination. Höhere Temperaturen steigern die Kreativität, gefährden aber die Kohärenz. Finden Sie den optimalen Punkt für Ihren Anwendungsfall.

- Strategische Änderung der Token-Grenzen: Ist man zu restriktiv, gehen wichtige Details verloren. Zu großzügig und Sie erhalten weitschweifige Ergebnisse. Passen Sie die Grenzen an die tatsächlichen Anforderungen der Aufgabe an.

- Experimentieren Sie mit verschiedenen Modellen: Nicht jedes Modell eignet sich für jede Aufgabe. Manche zeichnen sich durch kreative Arbeit aus, haben aber Schwierigkeiten mit der Präzision. Andere sind analytische Kraftpakete, die mit Mehrdeutigkeit nicht umgehen können und Anpassung des Werkzeugs an die Aufgabe.

- Konfigurieren Sie die Sicherheitsparameter in geeigneter Weise: Eine zu aggressive Inhaltsfilterung kann zu Anpassungslücken führen, so dass das Modell sinnvolle Anfragen ablehnt oder verwässerte Ergebnisse liefert. Kalibrieren Sie die Filter auf Ihre tatsächliche Risikotoleranz.

Regelmäßige Audits

Die Angleichung ist ein fortlaufender Prozess, der regelmäßige Überprüfungen und Aktualisierungen erfordert. Achten Sie darauf, dass Sie monatlich oder vierteljährlich vorbeischauen, um die jüngsten Ergebnisse zu beobachten und Muster zu erkennen, während Sie kontinuierlich neue Ausrichtungsprobleme und -lösungen notieren, um Wissen aufzubauen.

Schulen Sie Ihre Teammitglieder in bewährten Verfahren, um ineffektive Umgehungslösungen zu vermeiden, und testen Sie große Änderungen immer in kontrollierten Umgebungen, bevor Sie sie in größerem Umfang implementieren.

Vorbeugung künftiger Ausrichtungsprobleme

Bei der Vermeidung von Ausrichtungsproblemen geht es nicht darum, schneller zu reagieren, sondern darum, Systeme zu entwickeln, die seltener ausfallen.

Am Anfang steht eine klare Dokumentation, denn die Angleichung scheitert, wenn die Erwartungen in den Köpfen der Menschen leben und nicht in gemeinsamen Standards.

Von dort aus muss sich das Feedback stromaufwärts bewegen.

Wenn Teams KI-Outputs innerhalb des Arbeitsablaufs und nicht erst nach der Auslieferung überprüfen, können kleine Abweichungen korrigiert werden, bevor sie sich ausweiten. Gleichzeitig hängt die Anpassung von der Ausbildung ab.

Teams, die verstehen, wie sich Modelle verhalten, legen bessere Grenzen fest und vermeiden einen durch falsche Annahmen bedingten Missbrauch.

Und schließlich ist eine Anpassung nur möglich, wenn die Arbeitsabläufe auf menschlichem Urteilsvermögen und nicht auf vollständiger Automatisierung beruhen. KI funktioniert dann am besten, wenn die Überwachung bewusst erfolgt und dort platziert wird, wo Kontext, Ethik und Nuancen noch eine Rolle spielen.

Ihre Korrektur- und Präventivmaßnahmen funktionieren jedoch nur, wenn die Teams sie verstehen und umsetzen.

Nicht nachweisbare AI's AI Humanizer stellt sicher, dass Ihre Anweisungen, Richtlinien und Arbeitsablaufdokumente wirklich von Menschen gelesen werden können und umsetzbar sind.

Fachjargon wird in eine klare Sprache übersetzt. Komplexe Verfahren werden zu einfachen Schritten. Abstrakte Konzepte werden zu konkreten Beispielen.

Das Tool überbrückt die Kluft zwischen den technischen KI-Anforderungen und der praktischen Umsetzung im Team. Wenn jeder versteht, was gebraucht wird und warum, verbessert sich die Abstimmung auf breiter Front.

Starten Sie mit unserem AI Detector und Humanizer im Widget unten!

FAQs

Was bedeutet die Modellanpassung?

Die Ausrichtung eines Modells bezieht sich darauf, wie gut das Verhalten eines KI-Modells mit menschlichen Werten, Absichten und Zielen übereinstimmt. Ein gut abgestimmtes Modell folgt nicht nur wortwörtlich den Anweisungen, sondern versteht den Kontext, respektiert die Grenzen und produziert Ergebnisse, die Ihren tatsächlichen Zielen dienen.

Warum täuschen manche Modelle die Ausrichtung vor?

Modelle täuschen nicht absichtlich etwas vor. Sie sind nicht bösartig, aber sie können lernen, Ausrichtungssignale zu imitieren, ohne tatsächlich ausgerichtet zu sein. Während des Trainings lernen die Modelle Muster, die belohnt werden. Manchmal handelt es sich bei diesen Mustern um oberflächliche Anhaltspunkte für eine Übereinstimmung und nicht um echtes Verständnis.

Kein Roboteraufstand, nur schlechte Anweisungen

Die Lücken in der Modellanpassung werden nicht verschwinden. Je mehr KI in die Arbeitsabläufe integriert wird, desto wichtiger wird es, diese Probleme anzugehen.

Die gute Nachricht? Sie müssen kein KI-Forscher sein, um Ausrichtungsprobleme zu erkennen und zu beheben. Sie brauchen lediglich einen systematischen Ansatz, die richtigen Werkzeuge und Aufmerksamkeit für Muster.

Beginnen Sie mit der Erkennung. Entwickeln Sie Systeme, die Ausrichtungsprobleme frühzeitig erkennen. Dokumentieren Sie, was Sie finden.

Gehen Sie zur Korrektur über. Verwenden Sie optimierte Eingabeaufforderungen und geeignete Konfigurationen. Testen Sie Änderungen systematisch.

Konzentrieren Sie sich auf Prävention. Schaffen Sie Arbeitsabläufe, die auf die Anpassung ausgerichtet sind. Halten Sie die Menschen dort auf dem Laufenden, wo es wichtig ist.

Am wichtigsten ist, dass Sie sicherstellen, dass Ihre Teams Ihre Lösungen tatsächlich umsetzen können. Die technisch perfekteste Lösung für die Anpassung ist wertlos, wenn niemand weiß, wie sie anzuwenden ist.

Ihr KI-Workflow ist nur so gut wie seine Ausrichtung. Investieren Sie in die richtige Ausrichtung.

Stellen Sie sicher, dass Ihre KI-Ausgaben präzise und menschenähnlich bleiben mit Nicht nachweisbare AI.