Ο όρος deepfake εμφανίστηκε για πρώτη φορά στο Reddit το 2017, όταν ένας χρήστης με το ίδιο όνομα οθόνης άρχισε να μοιράζεται αλλοιωμένα βίντεο που χρησιμοποιούσαν τεχνητή νοημοσύνη για να ανταλλάσσουν πρόσωπα, αρχικά σε περιεχόμενο για ενήλικες.

Ενώ το Reddit απαγόρευσε το αρχικό subreddit, η ιδέα είχε ήδη απογειωθεί.

Αλλά οι ρίζες αυτής της τεχνολογίας πηγαίνουν ακόμη πιο πίσω.

Το 1997, οι ερευνητές είχαν ήδη αρχίσει να πειραματίζονται με την επεξεργασία βίντεο μέσω μηχανικής μάθησης.

Το πρώιμο εργαλείο τους για τον συγχρονισμό των χειλιών, που ονομάζεται Επανεγγραφή βίντεο θα μπορούσε να κάνει κάποιον να φαίνεται ότι είπε κάτι που δεν είχε πει.

Δεν ήταν τεχνικά ένα deepfake με τα σημερινά δεδομένα, αλλά έθεσε τις βάσεις για το τι θα ακολουθούσε στη συνέχεια.

Το σημερινό ιστολόγιο αναφέρεται στο πώς λειτουργεί αυτή η εξελισσόμενη τεχνολογία, πού εμφανίζεται στην καθημερινή ζωή και ποιους κινδύνους και ποια οφέλη συνεπάγεται.

Ας ξεκινήσουμε με την κατανόηση του τι είναι ένα deepfake στην πραγματικότητα.

Βασικά συμπεράσματα:

- Τα Deepfakes είναι μέσα που δημιουργούνται από τεχνητή νοημοσύνη και κάνουν τους ανθρώπους να φαίνονται ότι λένε ή κάνουν πράγματα που στην πραγματικότητα δεν έκαναν ποτέ.

- Με δωρεάν εργαλεία και βασικές δεξιότητες, σχεδόν οποιοσδήποτε μπορεί πλέον να δημιουργήσει πειστικά βίντεο, εικόνες ή κλιπ ήχου.

- Ενώ τα deepfakes μπορεί να είναι δημιουργικά ή διασκεδαστικά, ενέχουν επίσης σοβαρούς κινδύνους όπως απάτες, δυσφήμιση και παραπληροφόρηση.

- Μπορείτε να εντοπίσετε τα περισσότερα deepfakes χρησιμοποιώντας εργαλεία ανίχνευσης ή παρατηρώντας προσεκτικά για οπτικές και συμπεριφορικές ασυνέπειες.

Τι είναι ένα Deepfake;

Ένα deepfake είναι ψεύτικο μέσο, συνήθως ένα βίντεο, ένα ηχητικό κλιπ ή μια εικόνα, που έχει τροποποιηθεί με τη χρήση τεχνητής νοημοσύνης για να κάνει κάποιον να φαίνεται ή να ακούγεται σαν να κάνει ή να λέει κάτι που στην πραγματικότητα δεν έκανε ποτέ.

Τώρα, μην το εκλαμβάνετε αυτό ως μια κακή δουλειά στο Photoshop ή ως ένα πρόχειρο voiceover.

Μιλάμε για χειρισμούς υψηλού επιπέδου με τη χρήση μιας τεχνολογίας που ονομάζεται βαθιά μάθηση, η οποία αποτελεί υποσύνολο της τεχνητής νοημοσύνης.

Μην ανησυχείτε ποτέ ξανά για την τεχνητή νοημοσύνη που ανιχνεύει τα κείμενά σας. Undetectable AI Μπορεί να σας βοηθήσει:

- Κάντε το γραπτό σας με υποστήριξη AI να εμφανιστεί ανθρωποειδής.

- Παράκαμψη όλα τα κύρια εργαλεία ανίχνευσης AI με ένα μόνο κλικ.

- Χρήση AI με ασφάλεια και με αυτοπεποίθηση στο σχολείο και στην εργασία.

Αυτό υπονοεί ο όρος "deepfake": βαθιά μάθηση και ψεύτικο περιεχόμενο.

Ο στόχος ενός deepfake είναι συνήθως να δημιουργήσει κάτι που μοιάζει αρκετά αληθινό ώστε να ξεγελάσει τους ανθρώπους.

Ίσως έχετε δει εκείνα τα viral βίντεο με διασημότητες να κάνουν παράξενα πράγματα ή πολιτικούς να κάνουν εξωφρενικές δηλώσεις που στην πραγματικότητα δεν θα έλεγαν ποτέ.

Αυτές είναι κλασικές περιπτώσεις χρήσης deepfake. Αυτό που βλέπετε δεν είναι αληθινό, αλλά η τεχνολογία πίσω από αυτό έχει γίνει αρκετά καλή ώστε ο εγκέφαλός σας να μην αντιλαμβάνεται αμέσως την πλαστογράφηση, εκτός αν ψάχνετε πραγματικά.

Εδώ είναι που εργαλεία όπως το TruthScan μπείτε μέσα.

Το TruthScan έχει κατασκευαστεί για οργανισμούς που πρέπει να επαληθεύουν μέσα ενημέρωσης σε κλίμακα - εταιρείες, αίθουσες σύνταξης, πανεπιστήμια και δημόσιες υπηρεσίες. Βοηθά τις ομάδες να εντοπίζουν τη χειραγώγηση πριν το ψευδές περιεχόμενο βλάψει την εμπιστοσύνη ή τη φήμη.

Στην πραγματικότητα, σύμφωνα με την ερευνητική ομάδα της Undetectable AI, 85 % των Αμερικανών λένε ότι τα deepfakes έχουν υπονομεύσει την εμπιστοσύνη τους στις διαδικτυακές πληροφορίες.

Μόλις μάθατε τι είναι στην πραγματικότητα ένα deepfake βίντεο ή μέσο, τώρα πώς τα φτιάχνουν οι άνθρωποι.

Πώς γίνονται τα Deepfakes

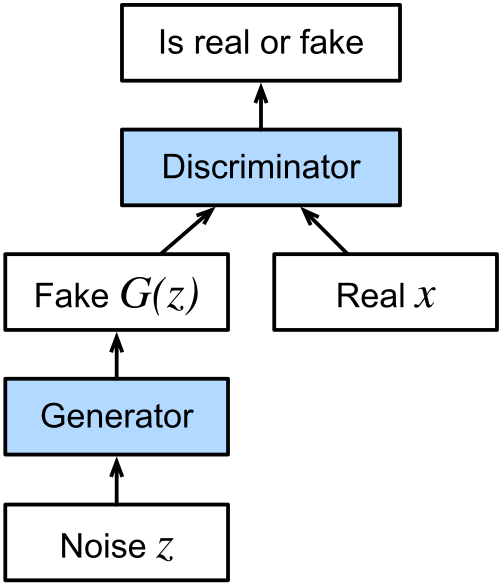

Η τεχνολογία πίσω από τα περισσότερα deepfakes είναι μια κατηγορία αλγορίθμων μηχανικής μάθησης που ονομάζονται generative adversarial networks, ή GANs.

Οι GAN αποτελούνται από δύο μέρη: μια γεννήτρια και έναν διαχωριστή.

Η γεννήτρια δημιουργεί ψεύτικα μέσα ενημέρωσης με βάση αυτά που έχει εκπαιδευτεί να αναπαράγει, και η δουλειά του διαχωριστή είναι να αναδεικνύει ό,τι φαίνεται ψεύτικο.

Συνεχίζουν να πηγαίνουν μπρος-πίσω μέχρι η γεννήτρια να βελτιωθεί στην παραγωγή ψεύτικου περιεχομένου που μπορεί να περάσει το τεστ του διαχωριστή.

Με την πάροδο του χρόνου, αυτό το πηγαινέλα οδηγεί σε μέσα ενημέρωσης που μοιάζουν σοκαριστικά ρεαλιστικά.

Τι είναι η διαδικασία δημιουργίας βίντεο Deepfake;

Κατά τη δημιουργία ενός deepfake βίντεο, το σύστημα αναλύει βίντεο από πολλαπλές γωνίες, μελετά τον τρόπο με τον οποίο το άτομο μιλάει, τον τρόπο με τον οποίο κινείται το πρόσωπό του, τον τρόπο με τον οποίο μετατοπίζεται το σώμα του.

Όλες αυτές οι πληροφορίες τροφοδοτούνται στη γεννήτρια, ώστε να μπορεί να δημιουργήσει περιεχόμενο που μιμείται αυτές τις συμπεριφορές.

Στη συνέχεια, ο διαχωριστής βοηθάει στη λεπτομερή ρύθμιση, υποδεικνύοντας τι είναι λάθος, μέχρι το τελικό αποτέλεσμα να φαίνεται ακριβώς σωστό.

Γι' αυτό η ψευδαίσθηση διατηρείται τόσο καλά σε κίνηση.

Υπάρχουν μερικές διαφορετικές τεχνικές που χρησιμοποιούνται ανάλογα με το σκοπό του βίντεο deepfake.

Αν η ιδέα είναι να φανεί ότι κάποιος λέει ή κάνει κάτι σε ένα βίντεο που ποτέ δεν είπε ή έκανε, τότε έχουμε να κάνουμε με αυτό που ονομάζεται deepfake βίντεο πηγής.

Ένας αυτόματος κωδικοποιητής deepfake, που αποτελείται από έναν κωδικοποιητή και έναν αποκωδικοποιητή, μελετά το αρχικό υλικό και εφαρμόζει τις εκφράσεις, τις χειρονομίες και τις λεπτές κινήσεις του κεφαλιού του στόχου.

Ήχος Deepfakes

Ένα ηχητικό deepfake λειτουργεί με την κλωνοποίηση της φωνής κάποιου, πάλι με τη χρήση GANs, με βάση ηχογραφήσεις του φυσικού τρόπου ομιλίας του.

Αφού εκπαιδευτεί, το μοντέλο μπορεί να παράγει νέα ομιλία με αυτή τη φωνή, ακόμη και αν το άτομο δεν είπε ποτέ αυτές τις λέξεις.

Ένα άλλο επίπεδο που προστίθεται συχνά είναι ο συγχρονισμός χειλιών.

Εδώ, το σύστημα αντιστοιχίζει τον παραγόμενο ή προηχογραφημένο ήχο σε ένα βίντεο.

Ο στόχος είναι να κάνετε τα χείλη στο βίντεο να ταιριάζουν με τις λέξεις στον ήχο.

Παραδείγματα Deepfakes στον πραγματικό κόσμο

Τα deepfakes εμφανίζονται παντού αυτές τις μέρες.

Ας σας παρουσιάσουμε μερικά δημοφιλή deepfakes που δείχνουν πόσο μακριά έχει φτάσει η τεχνολογία.

Το Deepfake του Προέδρου Zelenskyy που ζητά από τα ουκρανικά στρατεύματα να παραδοθούν

Τον Μάρτιο του 2022, κατά τα πρώτα στάδια του πολέμου Ρωσίας-Ουκρανίας, ένα βίντεο εμφανίστηκε στο διαδίκτυο που δείχνει τον Ουκρανό πρόεδρο Volodymyr Zelenskyy προτρέποντας τους στρατιώτες του να παραδοθούν.

Έμοιαζε με εθνικό διάγγελμα, με τη φωνή και τους τρόπους του Zelenskyy.

Το βίντεο εξαπλώθηκε σε όλες τις πλατφόρμες κοινωνικής δικτύωσης και δημοσιεύτηκε ακόμη και σε έναν παραβιασμένο ουκρανικό ειδησεογραφικό ιστότοπο.

Ο πρόεδρος έδρασε γρήγορα και εξέδωσε επίσημη δήλωση μέσω των επαληθευμένων καναλιών του για να διαψεύσει το υλικό.

Η Viral Deepfake εικόνα του Πάπα Φραγκίσκου με ένα σχεδιαστικό μπουφάν Puffer

Μερικές φορές, μια εικόνα deepfake δεν χρειάζεται να είναι κακόβουλη για να προκαλέσει σύγχυση.

Το 2023, μια viral φωτογραφία του Ο Πάπας Φραγκίσκος κυκλοφορεί με ένα κομψό λευκό μπουφάν Balenciaga κατέκτησε το διαδίκτυο με καταιγίδα.

Το βίντεο συγκέντρωσε δεκάδες εκατομμύρια προβολές και κοινοποιήθηκε ευρέως σε όλες τις πλατφόρμες.

Η εικόνα δημιουργήθηκε με τη χρήση ενός εργαλείου τεχνητής νοημοσύνης που ονομάζεται Midjourney από έναν ανώνυμο χρήστη στο Σικάγο.

Ο Elon Musk Deepfakes χρησιμοποιείται σε διαδικτυακές απάτες

Το 2024, deepfakes με τον Elon Musk αποτέλεσε κεντρικό μέρος πολλών μεγάλης κλίμακας διαδικτυακών απατών.

Βίντεο του Musk που δημιουργήθηκαν από τεχνητή νοημοσύνη άρχισαν να εμφανίζονται στο Facebook, το TikTok και άλλες πλατφόρμες, προωθώντας ψεύτικα κρυπτονομίσματα και επενδυτικά προγράμματα.

Αυτά τα αποσπάσματα φαίνονταν και ακούγονταν εξαιρετικά αληθινά.

Η ζημιά δεν ήταν μόνο θεωρητική. Ένας ηλικιωμένος συνταξιούχος φέρεται να έχασε σχεδόν $700.000 αφού πείστηκε από ένα από αυτά τα βίντεο.

Το Robocall του Joe Biden Deepfake που στόχευσε τους ψηφοφόρους των ΗΠΑ

Στις αρχές του 2024, λίγο πριν από τις προκριματικές εκλογές του Νιου Χάμσαϊρ, οι ψηφοφόροι έλαβαν ρομποτικές κλήσεις που ακουγόταν ακριβώς όπως ο πρόεδρος των ΗΠΑ Τζο Μπάιντεν.

Στο τηλεφώνημα, ο Τζο Μπάιντεν προέτρεπε τους ψηφοφόρους να μείνουν στο σπίτι τους και να κρατήσουν την ψήφο τους για τις γενικές εκλογές του Νοεμβρίου. Η πρόθεση ήταν να προκαλέσει σύγχυση και να παραπλανήσει τους ψηφοφόρους ώστε να παραλείψουν τις προκριματικές εκλογές.

Το περιστατικό προκάλεσε εκκλήσεις για ρύθμιση. Ομάδες υπεράσπισης παρότρυναν την Ομοσπονδιακή Εκλογική Επιτροπή των ΗΠΑ να παρέμβει, αλλά η FEC τελικά αρνήθηκε, επικαλούμενη περιορισμούς στις αρμοδιότητές της.

Εν τω μεταξύ, η εταιρεία τηλεπικοινωνιών που είναι υπεύθυνη για τη διανομή του ρομποτικού τηλεφωνήματος συμφώνησε να καταβάλει πρόστιμο $1 εκατομμυρίου.

Πολιτική χρήση Deepfake στις εκλογές του 2020 στην Ινδία

Δεν είναι όλες οι χρήσεις της τεχνολογίας deepfake επιβλαβείς ή παραπλανητικές (περισσότερα σχετικά με αυτό αργότερα στο ιστολόγιο).

Κατά τη διάρκεια των εκλογών της Νομοθετικής Συνέλευσης του Δελχί το 2020, η Το κόμμα Bharatiya Janata χρησιμοποίησε τεχνητή νοημοσύνη για να προσαρμόσει μια διαφήμιση προεκλογικής εκστρατείας για διαφορετικά γλωσσικά ακροατήρια.

Το κόμμα πήρε ένα βίντεο με τον ηγέτη του Manoj Tiwari να μιλάει στα αγγλικά και χρησιμοποίησε deepfake lip-syncing για να δημιουργήσει μια εκδοχή στα Haryanvi, μια περιφερειακή διάλεκτο.

Ενώ η φωνή προερχόταν από έναν ηθοποιό, οι εικόνες τροποποιήθηκαν ώστε να ταιριάζουν με τον νέο ήχο χρησιμοποιώντας τεχνητή νοημοσύνη που εκπαιδεύτηκε σε πραγματικό υλικό του Tiwari.

Τα μέλη του κόμματος το είδαν ως μια θετική εφαρμογή της τεχνολογίας που τους επέτρεψε να συνδεθούν με τους ψηφοφόρους σε μια γλώσσα που κατανοούσαν, ακόμη και αν ο υποψήφιος δεν τη μιλούσε άπταιστα.

Πώς να επαληθεύσετε τα Deepfakes στον πραγματικό κόσμο

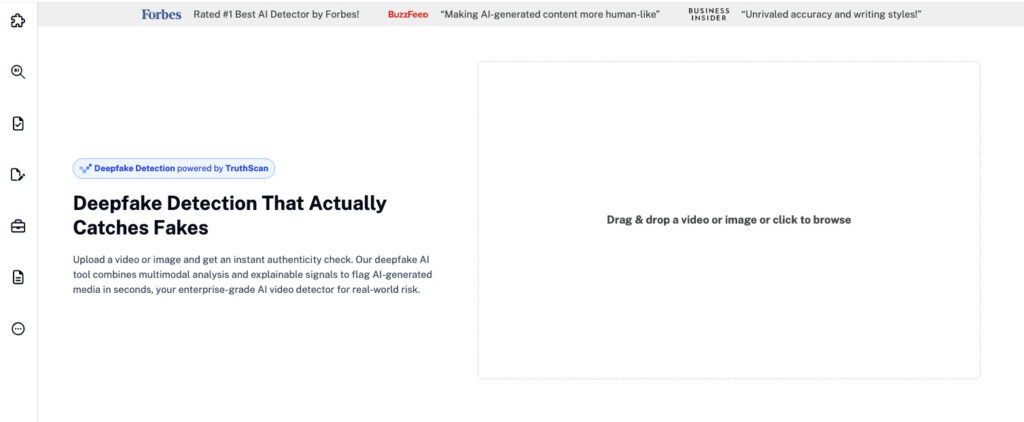

Με τα deepfakes να εξαπλώνονται στην πολιτική, την ψυχαγωγία και την καθημερινή επικοινωνία, η γνώση του τρόπου επιβεβαίωσης του τι είναι αληθινό δεν ήταν ποτέ πιο σημαντική. Σε αυτό το σημείο, η τεχνολογία Undetectable AI Ανίχνευση Deepfake μπαίνει μέσα.

Έχει σχεδιαστεί για να ελέγχει αν το περιεχόμενο ήχου ή βίντεο έχει παραχθεί τεχνητά, χρησιμοποιώντας προηγμένα εγκληματολογικά μοντέλα που αναλύουν την κίνηση καρέ-προς-καρέ, τη συνοχή σε επίπεδο εικονοστοιχείου και το φωνητικό αποτύπωμα.

Μέσα σε δευτερόλεπτα, οι χρήστες μπορούν να δουν αν ένα βίντεο έχει αλλοιωθεί ψηφιακά ή αν μια φωνή έχει κλωνοποιηθεί από τεχνητή νοημοσύνη.

Απλώς ανεβάστε το αρχείο και το εργαλείο παρέχει μια λεπτομερή αναφορά αυθεντικότητας με οπτική ανάλυση και βαθμολογία εμπιστοσύνης.

Είτε πρόκειται για ένα viral κλιπ, μια ύποπτη συνέντευξη ή μια κοινή εγγραφή, το Deepfake Detection βοηθά τους δημοσιογράφους, τους εκπαιδευτικούς και τους καθημερινούς χρήστες να αποκαλύψουν την αλήθεια πίσω από αυτά που βλέπουν και ακούνε.

Είναι επικίνδυνα τα Deepfakes; Κίνδυνοι και ανησυχίες

Μέχρι στιγμής, εξετάσαμε τι είναι ένα deepfake, πώς δημιουργείται και πού έχει ήδη εμφανιστεί στον πραγματικό κόσμο.

Η τεχνολογία είναι αναμφισβήτητα εντυπωσιακή, αλλά οι κίνδυνοι που συνδέονται με αυτήν είναι σοβαροί και αυξάνονται γρήγορα.

Τα deepfakes μπορούν να χρησιμοποιηθούν ως όπλα με πολλαπλούς τρόπους. Ακολουθούν μερικές κύριες ανησυχίες.

Συκοφαντική δυσφήμιση

Όταν η ομοιότητα ή η φωνή κάποιου χρησιμοποιείται για τη δημιουργία ψεύτικων σχολίων, δηλώσεων ή βίντεο, ιδίως εκείνων που είναι προσβλητικά ή αμφιλεγόμενα, μπορεί να καταστρέψει τη φήμη σχεδόν αμέσως.

Και σε αντίθεση με τις παλαιότερες φάρσες ή τα ψεύτικα αποσπάσματα, ένα πειστικό deepfake δεν αφήνει πολλά περιθώρια αμφιβολίας στο μυαλό του θεατή.

Από αυτή την άποψη, τα deepfakes μπορούν να προκαλέσουν οργή, να καταστρέψουν σχέσεις ή απλώς να προωθήσουν μια επιζήμια αφήγηση.

Αυτό που είναι ιδιαίτερα ανησυχητικό είναι ότι το deepfake δεν χρειάζεται καν να είναι τέλειο.

Εφόσον το πρόσωπο είναι αναγνωρίσιμο και το περιεχόμενο αρκετά πιστευτό, μπορεί να αφήσει μόνιμο αντίκτυπο στην κοινή γνώμη.

Αξιοπιστία των πληροφοριών

Μια άλλη σημαντική ανησυχία είναι το πώς τα deepfakes υπονομεύουν την ίδια την ιδέα της αλήθειας.

Καθώς τα deepfakes γίνονται όλο και πιο συχνά, γίνεται όλο και πιο δύσκολο να ξέρουμε αν αυτό που βλέπουμε ή ακούμε είναι αληθινό. Με την πάροδο του χρόνου, αυτό θα μπορούσε να οδηγήσει σε μια ευρύτερη διάβρωση της εμπιστοσύνης σε κάθε μορφή ψηφιακής επικοινωνίας.

Αυτή η κρίση αξιοπιστίας υπερβαίνει τα μεμονωμένα περιστατικά.

Στις δημοκρατικές κοινωνίες, οι άνθρωποι βασίζονται σε κοινά γεγονότα για να λαμβάνουν αποφάσεις, να συζητούν θέματα και να επιλύουν συλλογικά προβλήματα.

Αλλά αν οι ψηφοφόροι, οι τηλεθεατές ή οι πολίτες αρχίσουν να αμφισβητούν τα πάντα, γίνεται πολύ πιο εύκολο να χειραγωγηθεί η κοινή γνώμη ή να απορριφθούν οι άβολες αλήθειες ως "άλλη μια βαθιά απάτη".

Εκβιασμός

Τα μέσα ενημέρωσης που δημιουργούνται από την τεχνητή νοημοσύνη μπορούν να χρησιμοποιηθούν για την ψευδή ενοχοποίηση ατόμων, κάνοντας τα να φαίνονται ότι έχουν κάνει κάτι παράνομο, ανήθικο ή ενοχλητικό.

Αυτού του είδους τα κατασκευασμένα στοιχεία μπορούν στη συνέχεια να χρησιμοποιηθούν για να τους απειλήσουν ή να τους ελέγξουν.

Και αυτό ισχύει και για τις δύο πλευρές. Επειδή τα deepfakes είναι πλέον τόσο ρεαλιστικά, κάποιος που αντιμετωπίζει πραγματικό εκβιασμό μπορεί να ισχυριστεί ότι τα στοιχεία είναι ψεύτικα, ακόμη και αν δεν είναι.

Αυτό αναφέρεται μερικές φορές ως πληθωρισμός εκβιασμού, όπου ο όγκος των πιστευτών απομιμήσεων μειώνει την αξία του πραγματικού ενοχοποιητικού υλικού.

Η αξιοπιστία των πραγματικών αποδεικτικών στοιχείων χάνεται στην ομίχλη, και αυτό προσθέτει ένα ακόμη επίπεδο πολυπλοκότητας όταν προσπαθείς να αποκαλύψεις παρανομίες.

Απάτες και απάτες

Χρησιμοποιώντας βίντεο που δημιουργούνται με τεχνητή νοημοσύνη ή φωνές αξιόπιστων δημόσιων προσώπων, οι απατεώνες δημιουργούν απίστευτα πειστικά συστήματα.

Σε ορισμένες περιπτώσεις, τα deepfakes διασημοτήτων όπως ο Elon Musk, ο Tom Hanks ή η Oprah Winfrey χρησιμοποιούνται για να υποστηρίξουν προϊόντα ή υπηρεσίες που δεν έχουν ακούσει ποτέ.

Αυτά τα βίντεο στη συνέχεια προωθούνται σε όλες τις κοινωνικές πλατφόρμες, όπου φτάνουν σε εκατομμύρια χρήστες.

Ακόμα και οι ιδιώτες κινδυνεύουν, ιδίως σε εκστρατείες spearphishing που στοχεύουν σε συγκεκριμένα άτομα με εξατομικευμένο περιεχόμενο σχεδιασμένο για να χειραγωγήσουν ή να εξαπατήσουν.

Σύμφωνα με μια 2024 έκθεση του Forbes, η απάτη με βάση το deepfake έχει ήδη προκαλέσει παγκόσμιες απώλειες ύψους $12 δισεκατομμυρίων, και το ποσό αυτό αναμένεται να υπερτριπλασιαστεί τα επόμενα χρόνια.

Αυτός είναι ο λόγος για τον οποίο η ανίχνευση δεν είναι μόνο για άτομα. Είναι απαραίτητη για τις εταιρείες που διαχειρίζονται ευαίσθητα δεδομένα, επικοινωνίες ή δημόσιο περιεχόμενο. Το TruthScan βοηθά αυτούς τους οργανισμούς να εντοπίσουν τα τροποποιημένα βίντεο πριν εξαπλωθεί η παραπληροφόρηση.

Θετικές και δημιουργικές χρήσεις των Deepfakes

Αξίζει να σημειωθεί ότι δεν είναι αρνητική κάθε εφαρμογή της τεχνολογίας.

Ενώ πολλά ιστολόγια που εξηγούν τι είναι ένα deepfake εστιάζουν στην κατάχρηση, υπάρχει ένας αυξανόμενος κατάλογος δημιουργικών και παραγωγικών τρόπων χρήσης των deepfakes.

Παρόλα αυτά, για τις επιχειρήσεις, ακόμη και οι καλλιτεχνικές ή εμπορικές χρήσεις των deepfakes θα πρέπει να ελέγχονται για την αυθεντικότητα πριν από την κυκλοφορία.

Εργαλεία όπως το TruthScan μπορούν να επιβεβαιώσουν ότι στην τελική έκδοση δεν υπάρχουν ανεπιθύμητοι χειρισμοί.

Ακολουθούν ορισμένα αξιοσημείωτα παραδείγματα.

Κινηματογραφικές και υποκριτικές παραστάσεις

Τα στούντιο αρχίζουν να βασίζονται στην τεχνολογία deepfake για πράγματα όπως:

- Βελτίωση οπτικών εφέ

- Μείωση του κόστους παραγωγής

- Επαναφορά χαρακτήρων που δεν υπάρχουν πια

Disney, για παράδειγμα, έχει βελτιώσει μοντέλα υψηλής ανάλυσης deepfake που επιτρέπουν την ανταλλαγή προσώπων και την απο-γήρανση ηθοποιών με εντυπωσιακό ρεαλισμό.

Η τεχνολογία τους λειτουργεί σε ανάλυση 1024 x 1024 και μπορεί να παρακολουθεί με ακρίβεια τις εκφράσεις του προσώπου για να κάνει τους χαρακτήρες να φαίνονται νεότεροι ή πιο εκφραστικοί.

Πέρα από το Χόλιγουντ, τα deepfakes επέτρεψαν τη διεξαγωγή παγκόσμιων εκστρατειών, όπως όταν Ο Ντέιβιντ Μπέκαμ κλωνοποιήθηκε ψηφιακά να μεταδίδουν ένα μήνυμα υγείας σε πολλές γλώσσες.

Τέχνη

Το 2018, ο καλλιτέχνης πολυμέσων Joseph Ayerle χρησιμοποίησε την τεχνολογία deepfake για να δημιουργήσει έναν ηθοποιό τεχνητής νοημοσύνης που ανακάτευε το πρόσωπο της Ιταλίδας σταρ του κινηματογράφου Ornella Muti με το σώμα της Kendall Jenner.

Το αποτέλεσμα ήταν μια σουρεαλιστική εξερεύνηση της ταυτότητας των γενεών και της καλλιτεχνικής πρόκλησης, μέρος ενός έργου βίντεο με τίτλο Un'emozione per sempre 2.0.

Τα deepfakes έχουν επίσης εμφανιστεί στη σάτιρα και την παρωδία.

Η διαδικτυακή σειρά Sassy Justice του 2020, που δημιουργήθηκε από τους δημιουργούς του South Park, Trey Parker και Matt Stone, είναι ένα χαρακτηριστικό παράδειγμα.

Χρησιμοποίησε δημόσια πρόσωπα που έκαναν deepfake για να διακωμωδήσει τα τρέχοντα γεγονότα και παράλληλα να ευαισθητοποιήσει την ίδια την τεχνολογία.

Εξυπηρέτηση πελατών

Εκτός από τις δημιουργικές βιομηχανίες, οι επιχειρήσεις βρίσκουν χρησιμότητα στα deepfakes για υπηρεσίες που απευθύνονται στους πελάτες.

Ορισμένα τηλεφωνικά κέντρα χρησιμοποιούν πλέον συνθετικές φωνές που τροφοδοτούνται από τεχνολογία deepfake για την αυτοματοποίηση βασικών αιτημάτων, όπως ερωτήσεις λογαριασμού ή καταγραφή παραπόνων.

Σε αυτές τις περιπτώσεις, η πρόθεση δεν είναι κακόβουλη, αλλά απλώς να εξορθολογιστεί.

Τα συστήματα απάντησης κλήσεων μπορούν να εξατομικευτούν με τη χρήση φωνών που δημιουργούνται από τεχνητή νοημοσύνη, ώστε οι αυτοματοποιημένες υπηρεσίες να ακούγονται πιο φυσικές και ελκυστικές.

Δεδομένου ότι οι εργασίες που διεκπεραιώνονται είναι συνήθως χαμηλού κινδύνου και επαναλαμβανόμενες, τα deepfakes σε αυτό το πλαίσιο συμβάλλουν στη μείωση του κόστους και απελευθερώνουν ανθρώπινους πράκτορες για πιο σύνθετα ζητήματα.

Εκπαίδευση

Οι εκπαιδευτικές πλατφόρμες έχουν επίσης αρχίσει να ενσωματώνουν διδάσκοντες που λειτουργούν με deepfake για να βοηθούν τους μαθητές με πιο διαδραστικούς τρόπους.

Αυτοί οι καθηγητές με τεχνητή νοημοσύνη μπορούν να παραδίδουν μαθήματα χρησιμοποιώντας συνθετικές φωνές και εξατομικευμένη καθοδήγηση.

Εργαλεία και τεχνικές ανίχνευσης Deepfake

Καθώς τα deepfakes γίνονται όλο και πιο προηγμένα και προσβάσιμα, αυξάνεται και η ανάγκη εντοπισμού τους πριν προκαλέσουν ζημιά.

Οι άνθρωποι και οι οργανισμοί χρειάζονται επίσης τα κατάλληλα εργαλεία και τεχνικές για να παραμείνουν ένα βήμα μπροστά. Ακολουθούν λοιπόν μερικά εργαλεία και τεχνικές.

Για επαλήθευση με εστίαση στην εικόνα, Ανιχνευτής εικόνας AI της TruthScan αναλύει το φωτισμό, τα μοτίβα εικονοστοιχείων και τα συνθετικά στοιχεία για να επισημάνει οπτικά στοιχεία που έχουν δημιουργηθεί ή επεξεργαστεί με τεχνητή νοημοσύνη σε πραγματικό χρόνο.

Βοηθά τις ομάδες να επιβεβαιώνουν γρήγορα τη γνησιότητα σε εικόνες και βίντεο πριν από τη δημοσίευση ή την κοινοποίηση του περιεχομένου.

TruthScan: Ανίχνευση Deepfake Enterprise-Grade

TruthScan έχει σχεδιαστεί για επιχειρήσεις, πανεπιστήμια και οργανισμούς μέσων ενημέρωσης που χρειάζονται επαλήθευση οπτικού και ακουστικού περιεχομένου μεγάλης κλίμακας.

Αναλύει την αυθεντικότητα του βίντεο σε πολλαπλές διαστάσεις:

- Ανίχνευση εναλλαγής προσώπου: Προσδιορίζει τα χειραγωγημένα χαρακτηριστικά του προσώπου καρέ-καρέ.

- Δακτυλικό αποτύπωμα συμπεριφοράς: Ανιχνεύει λεπτά μοτίβα έκφρασης και μικροκινήσεις που δεν συνάδουν με τη φυσική ανθρώπινη συμπεριφορά.

- Εγκληματολογία βίντεο: Εξετάζει τη συμπίεση καρέ, το θόρυβο εικονοστοιχείων και την αλλοίωση φωνής.

- Ανίχνευση σε πραγματικό χρόνο: Επιτρέπει τη ζωντανή επαλήθευση κατά τη διάρκεια βιντεοκλήσεων, δελτίων τύπου ή ροών μετάδοσης.

Με το TruthScan, οι ομάδες μπορούν να πιστοποιούν την αυθεντικότητα των βίντεο πριν από τη δημοσίευση ή τη δημόσια διανομή, αποτρέποντας έτσι ζημιές στη φήμη και οικονομικές ζημιές.

Για τους καθημερινούς χρήστες, τα εργαλεία της Undetectable AI προσφέρουν παρόμοια προστασία σε ατομικό επίπεδο.

Ανιχνευτής εικόνας AI από την Undetectable AI

Ο ανιχνευτής εικόνων AI της Undetectable AI κάνει την ανίχνευση ψεύτικων εικόνων πιο εύκολη, ακόμη και για όσους δεν έχουν τεχνικό υπόβαθρο.

Ο ανιχνευτής λειτουργεί αναλύοντας διάφορα στοιχεία σε μια ανεβασμένη εικόνα, όπως χρωματικά μοτίβα, υφές, χαρακτηριστικά του προσώπου και δομικές ασυνέπειες.

Υποστηρίζει την ανίχνευση μέσων που δημιουργήθηκαν με τις πιο γνωστές γεννήτριες εικόνων AI, όπως

- MidJourney

- DALL-E

- Σταθερή διάχυση

- Ιδεόγραμμα

- Μοντέλα με βάση το GAN

Για να το χρησιμοποιήσετε, απλά ανεβάστε μια εικόνα, αφήστε το εργαλείο να την αναλύσει και λάβετε μια σαφή ετυμηγορία με βαθμολογία εμπιστοσύνης.

Αν δεν είστε σίγουροι αν μια εικόνα που συναντήσατε είναι γνήσια, δοκιμάστε το Ανιχνευτής εικόνας AI για να ελέγξετε για τυχόν σημάδια αλλοίωσης της ΤΝ.

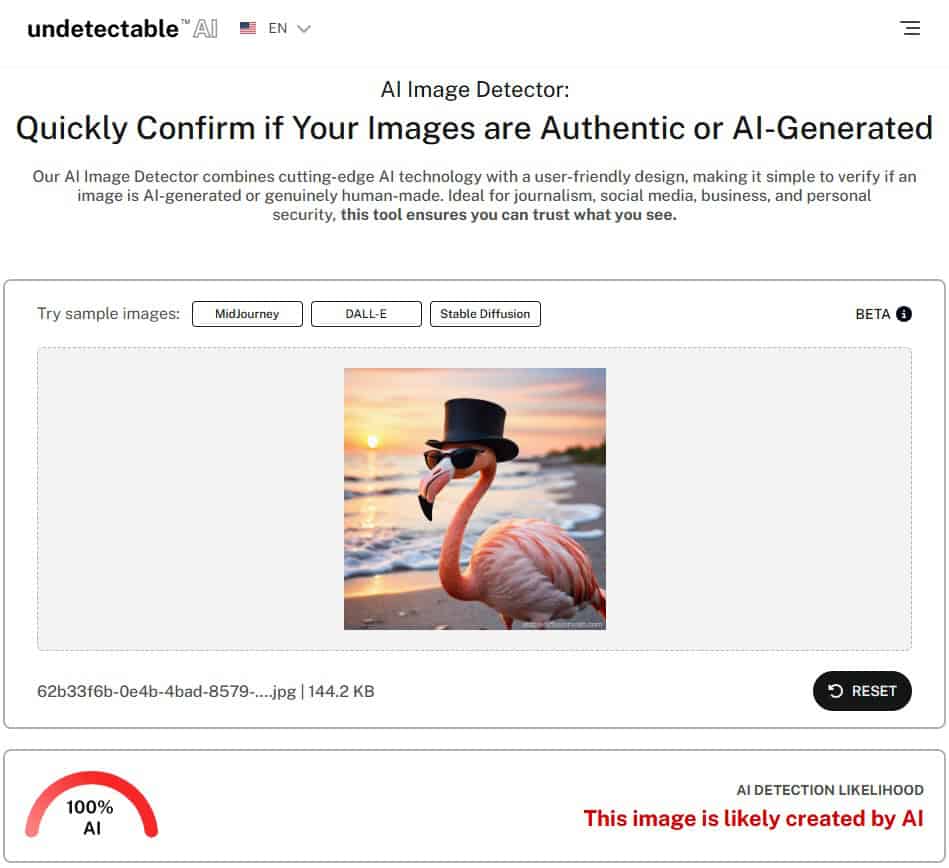

Τώρα, ας βάλουμε Ανιχνευτής AI του Undetectable στο τεστ και να δούμε αν μπορεί να διακρίνει με ακρίβεια ότι η εικόνα έχει δημιουργηθεί με τεχνητή νοημοσύνη.

Όπως μπορείτε να δείτε, ο ανιχνευτής τεχνητής νοημοσύνης εικόνας από την Undetectable AI έχει επισημάνει αυτή την εικόνα ως 100% AI-generated.

Οπτικές και συμπεριφορικές τεχνικές για χειροκίνητη ανίχνευση

Υπάρχουν επίσης πρακτικές τεχνικές που μπορούν να χρησιμοποιήσουν οι ιδιώτες για να εντοπίσουν χειροκίνητα τα deepfakes, ειδικά σε περιπτώσεις όπου απαιτείται άμεση ανάλυση.

Ορισμένες οπτικές κόκκινες σημαίες περιλαμβάνουν:

- Αμήχανη τοποθέτηση του προσώπου ή περίεργες εκφράσεις.

- Ασυνεπής φωτισμός ή χρωματισμός σε διαφορετικά σημεία της εικόνας ή του βίντεο.

- Τρεμούλιασμα γύρω από το πρόσωπο ή τη γραμμή των μαλλιών, ιδιαίτερα κατά τη διάρκεια της κίνησης.

- Έλλειψη φυσικών βλεφαρισμών ή ακανόνιστη κίνηση των ματιών.

- Διαφορές στο συγχρονισμό των χειλιών όταν ο ήχος δεν ταιριάζει με την ομιλία.

Από την άποψη της συμπεριφοράς, τα deepfakes συχνά δυσκολεύονται να μιμηθούν λεπτά ανθρώπινα χαρακτηριστικά. Δώστε προσοχή στη γλώσσα του σώματος, στις συναισθηματικές εκφράσεις και στις συνηθισμένες χειρονομίες.

Και σε συνομιλίες σε πραγματικό χρόνο, ειδικά σε ζωντανά βίντεο, ζητήστε μια προβολή του πλευρικού προφίλ.

Πολλά μοντέλα deepfake εξακολουθούν να δυσκολεύονται να αποδώσουν με ακρίβεια μια γωνία προσώπου 90 μοιρών ή πολύπλοκες κινήσεις όπως η στροφή του κεφαλιού, διατηρώντας παράλληλα φυσικές εκφράσεις.

Εντοπισμός απομιμήσεων σε κείμενο και πλαίσιο

Τα deepfakes δεν περιορίζονται στα οπτικά μέσα. Ορισμένες εκδοχές περιλαμβάνουν συνθετικό κείμενο, φωνή ή συμπεριφορά που μιμείται το στυλ επικοινωνίας κάποιου.

Όταν αναλύετε περιεχόμενο κειμένου ή διάλογο, προσέξτε για:

- Ορθογραφικά λάθη και περίεργη γραμματική.

- Προτάσεις που μοιάζουν επιβεβλημένες ή δεν ρέουν φυσικά.

- Ασυνήθιστες διευθύνσεις ηλεκτρονικού ταχυδρομείου ή ασυνεπής διατύπωση.

- Μηνύματα που μοιάζουν εκτός πλαισίου ή άσχετα με την κατάσταση.

Το πλαίσιο έχει επίσης σημασία. Εάν ένα βίντεο ή μήνυμα εμφανίζεται σε ένα περιβάλλον που δεν βγάζει νόημα, όπως ένας πολιτικός που ανακοινώνει τυχαία μια σημαντική απόφαση σε ένα κλιπ χαμηλής ποιότητας, αξίζει να αμφισβητήσετε την αυθεντικότητά του.

Είστε περίεργοι για τον ανιχνευτή AI και τον Humanizer; Δοκιμάστε τα στο widget παρακάτω!

Συχνές ερωτήσεις σχετικά με τα Deepfakes

Είναι τα deepfakes παράνομα;

Τα deepfakes δεν είναι εξ ορισμού παράνομα, αλλά μπορεί να είναι, αν παραβιάζουν υφιστάμενους νόμους, όπως αυτούς που καλύπτουν τη δυσφήμιση, την παιδική πορνογραφία ή το μη συναινετικό ρητό περιεχόμενο.

Ορισμένες πολιτείες των ΗΠΑ έχουν ψηφίσει νόμους που στοχεύουν τα deepfakes που επηρεάζουν τις εκλογές ή αφορούν πορνό εκδίκησης.

Ομοσπονδιακά νομοσχέδια όπως ο νόμος DEFIANCE και η Πράξη NO FAKES βρίσκονται επίσης σε εξέλιξη για τη ρύθμιση των κακόβουλων χρήσεων της τεχνολογίας deepfake.

Μπορεί κάποιος να κάνει ένα deepfake;

Ναι, σχεδόν οποιοσδήποτε μπορεί να δημιουργήσει ένα deepfake χρησιμοποιώντας δωρεάν ή χαμηλού κόστους λογισμικό και εργαλεία τεχνητής νοημοσύνης.

Πολλές πλατφόρμες προσφέρουν πλέον φιλικές προς το χρήστη διεπαφές, οπότε δεν απαιτούνται προηγμένες τεχνικές δεξιότητες για να ξεκινήσετε.

Πώς μπορώ να προστατευτώ από τα deepfakes;

Περιορίστε την έκθεσή σας αποφεύγοντας να δημοσιεύετε εικόνες ή βίντεο υψηλής ανάλυσης στο διαδίκτυο. Χρησιμοποιήστε ρυθμίσεις απορρήτου και εργαλεία ανίχνευσης όπως Μη ανιχνεύσιμο AI ή TruthScan για να ελέγξετε ξανά οτιδήποτε ύποπτο.

Υπάρχουν εφαρμογές ανίχνευσης deepfake;

Ναι, το TruthScan έχει σχεδιαστεί για επιχειρηματικούς χρήστες που πρέπει να αναλύουν περιεχόμενο βίντεο σε κλίμακα, ενώ οι ανιχνευτές της Undetectable AI εξυπηρετούν ιδιώτες και δημιουργούς που επιθυμούν να επαληθεύσουν μικρότερους όγκους περιεχομένου.

Τελικές σκέψεις

Τα deepfakes αναδιαμορφώνουν τον τρόπο με τον οποίο βλέπουμε την αλήθεια στο διαδίκτυο. Είτε προστατεύετε την επωνυμία σας, είτε διαχειρίζεστε δημόσιες επικοινωνίες, είτε απλώς περιηγείστε με ασφάλεια, η χρήση των σωστών εργαλείων ανίχνευσης κάνει τη διαφορά.

Για επιχειρήσεις και ιδρύματα, TruthScan παρέχει προστασία σε επίπεδο επιχείρησης από την παραπληροφόρηση με βάση την τεχνητή νοημοσύνη.

Για τα άτομα, μη ανιχνεύσιμη ΑΙ Ανιχνευτής εικόνας AI προσφέρει έναν απλό και γρήγορο τρόπο για να ελέγχετε τις εικόνες και να ενημερώνεστε.

Μαζί, βοηθούν να διασφαλιστεί ότι αυτό που βλέπετε και μοιράζεστε παραμένει αληθινό.