W miarę jak narzędzia sztucznej inteligencji, takie jak ChatGPT, stają się coraz bardziej wyrafinowane i dostępne, w sektorze edukacji pojawił się palący problem:

Czy uczelnie i uniwersytety mogą niezawodnie wykrywać treści generowane przez ChatGPT?

W tym artykule badamy, w jaki sposób instytucje reagują na rozwój generatywnej sztucznej inteligencji, jakie metody wykrywania są stosowane w 2025 roku.

Wyzwania, przed którymi stoją, oraz sposób, w jaki studenci mogą odpowiedzialnie korzystać ze sztucznej inteligencji bez narażania uczciwości akademickiej.

Kluczowe wnioski

- Uczelnie mogą wykrywać ChatGPT - ale nie z idealną dokładnością. Narzędzia takie jak Turnitin i Copyleaks są powszechnie używane, ale nadal generują fałszywie pozytywne i negatywne wyniki.

- Ludzka recenzja i analiza stylometryczna są kluczowe w ocenie niespójności między wcześniejszymi pracami studenta a nowymi zgłoszeniami.

- Wykrywanie opiera się na wzorcach językowych, statystycznych i kontekstowych, ale zaawansowane wyniki sztucznej inteligencji często mogą ominąć powierzchowną analizę.

- Nauczyciele aktualizują zasady i przyjmują egzaminy ustne, zadania pisemne w czasie rzeczywistym i oceny oparte na sztucznej inteligencji, aby zmniejszyć zależność od samych narzędzi wykrywających.

- Etyczne wykorzystanie sztucznej inteligencji jest możliwe, zwłaszcza gdy kierujemy się przejrzystością, uczciwością akademicką i narzędziami takimi jak Undetectable AI.

Czy ChatGPT będzie wykrywalny w 2025 roku?

ChatGPT i inne duże modele językowe znacznie poprawiły swoją zdolność do generowania naturalnego, spójnego i podobnego do ludzkiego tekstu.

Podczas gdy ten postęp uwalnia potężny potencjał edukacyjny, stawia również nowe wyzwania przed instytucjami akademickimi, które chcą zachować integralność pracy studentów.

Większość detektorów AI wykorzystujed przez uczelnie-w tym funkcja wykrywania sztucznej inteligencji Turnitin - polegają na wzorce językowe, zakłopotanieoraz wybuchowość aby oznaczyć pismo wygenerowane przez sztuczną inteligencję.

Nigdy więcej nie martw się, że sztuczna inteligencja wykryje twoje teksty. Undetectable AI Może ci pomóc:

- Spraw, by pisanie wspomagane przez sztuczną inteligencję wyglądało podobny do człowieka.

- Obejście wszystkie główne narzędzia do wykrywania AI za pomocą jednego kliknięcia.

- Użycie AI bezpiecznie i pewnie w szkole i pracy.

Systemy te nie są jednak nieomylne. Wielu studentów edytuje wyniki AI lub humanizuje je za pomocą zaawansowanych narzędzi, aby ominąć wykrywanie.

Ten wyścig zbrojeń między generatywną sztuczną inteligencją a detektorami sztucznej inteligencji sprawił, że uniwersytety balansują na krawędzi sprawiedliwości, uczciwości akademickiej i zmieniających się potrzeb studentów.

Powszechne metody wykrywania w szkolnictwie wyższym

1. Stylometria

Stylometria bada unikalny styl pisania ucznia w poprzednich zgłoszeniach - analizując gramatykę, interpunkcję, strukturę zdań i słownictwo.

Ostre odchylenie w tonie lub złożoności często sygnalizuje użycie sztucznej inteligencji. Metoda ta jest szczególnie skuteczna, gdy nauczyciele mają portfolio wcześniejszych prac ucznia do porównania.

2. Statystyczna analiza wzorców

Treści generowane przez sztuczną inteligencję często wykazują nienaturalną spójność w długości zdań, formalności lub strukturze.

Detektory takie jak Turnitin skanują w poszukiwaniu anomalii w oparciu o znane wzorce w ludzkim piśmie. Jednak wysoce edytowane treści AI mogą ominąć taką analizę.

3. Analiza kontekstowa i semantyczna

Zamiast tylko powierzchownej gramatyki, analiza kontekstowa ocenia głębia, trafność i spójność.

Narzędzia AI mogą tworzyć treści, które "brzmią dobrze", ale brakuje im wnikliwej analizy lub powiązania z materiałem kursu.

4. Wykrywanie za pomocą uczenia maszynowego

Niektóre instytucje wykorzystują sztuczną inteligencję do walki ze sztuczną inteligencją - trenując modele uczenia maszynowego w celu odróżnienia tekstu wygenerowanego przez człowieka od tekstu wygenerowanego maszynowo na podstawie tysięcy przykładowych esejów.

5. Przegląd człowieka

Pomimo automatyzacji, doświadczeni nauczyciele pozostają najdokładniejszymi detektorami AIZwłaszcza gdy znają głosy swoich uczniów.

W rzeczywistości 2025 Badanie arXiv odkryli, że doświadczeni instruktorzy osiągali lepsze wyniki niż detektory AI w wykrywaniu subtelnych zadań generowanych przez AI.

Ograniczenia wykrywania sztucznej inteligencji w środowisku akademickim

Podczas gdy systemy wykrywania uległy poprawie, kilka ograniczenia krytyczne pozostać:

- Fałszywe alarmy mogą niesłusznie oskarżać uczniów, zwłaszcza tych, których pismo odbiega od normy (np. osoby uczące się języka angielskiego lub uczniowie z zaburzeniami nerwicowymi).

- Koszt i dostępność ograniczają uniwersytetom z mniejszymi budżetami możliwość nabycia najbardziej zaawansowanych narzędzi do wykrywania sztucznej inteligencji.

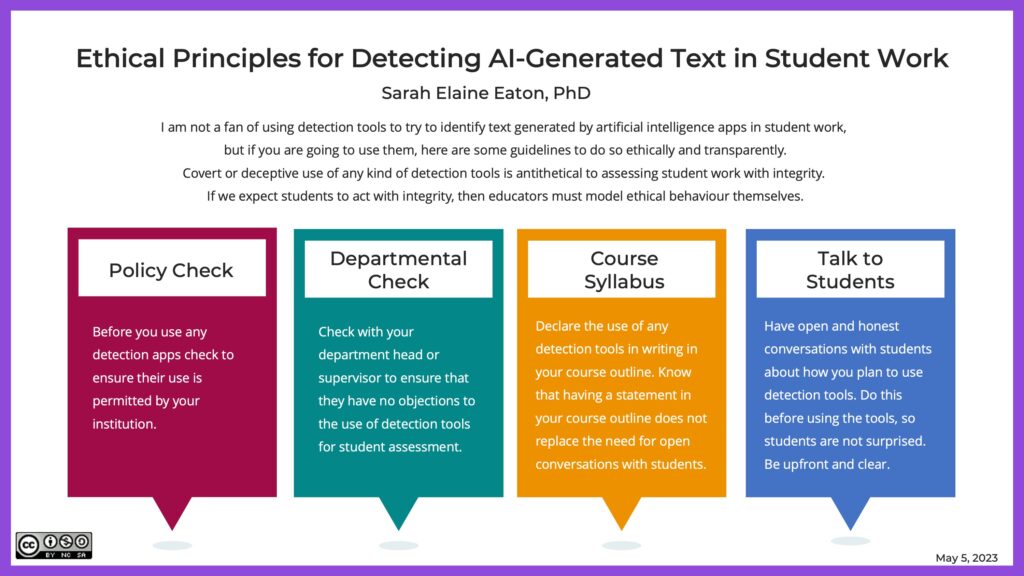

- Kwestie etyczne pojawiają się, gdy inwazyjne praktyki wykrywania naruszają prywatność uczniów lub zwiększają nieufność.

- Nierówności w korzystaniu ze sztucznej inteligencji może jeszcze bardziej pogłębić różnice w osiągnięciach między uczniami o różnych poziomach dostępu do umiejętności i narzędzi AI.

Obawy te skłoniły wiele instytucji do ponownej oceny nie tylko tego, jak wykrywają sztuczną inteligencję, ale także tego, jak to robią. przemyśl ocenę łącznie.

Implikacje korzystania z ChatGPT dla studentów i uczelni

Uczciwość akademicka: Zgłoszenia generowane przez sztuczną inteligencję mogą zaciemniać prawdziwe zrozumienie ucznia.

W przypadku nieetycznego użycia, ChatGPT podważa dokładność oceny akademickiej i podważa wartość ocen i referencji.

Dylematy etyczne: Od uczciwości po prywatność danych, uniwersytety zmagają się z tym, gdzie wyznaczyć granicę korzystania ze sztucznej inteligencji. Czy sztuczna inteligencja powinna być całkowicie zakazana, czy też powinna być zintegrowana w przemyślany sposób?

Długoterminowy wpływ: Nadmierne poleganie na sztucznej inteligencji może osłabić podstawowe umiejętności, takie jak krytyczne myślenie, argumentacja i kreatywność.

Jeśli wyniki akademickie będą postrzegane jako wspomagane przez sztuczną inteligencję, wiarygodność stopni naukowych może spaść w oczach pracodawców i programów studiów.

Sposoby bezpiecznego korzystania z narzędzi AI (z niewykrywalną AI)

Sztuczna inteligencja nie musi być wrogiem uczciwości akademickiej - jeśli jest używana prawidłowo, może poprawić zrozumienie, nie zastępując oryginalnej myśli.

Oto, jak uczniowie mogą bezpiecznie i przejrzyście korzystać ze sztucznej inteligencji:

- Używaj AI do burzy mózgów, a nie pisania pełnych esejów.

- Przytocz źródła, jeśli sztuczna inteligencja pomogła wygenerować spostrzeżenia.

- Edytuj mocno, aby nadać pracy własny charakter.

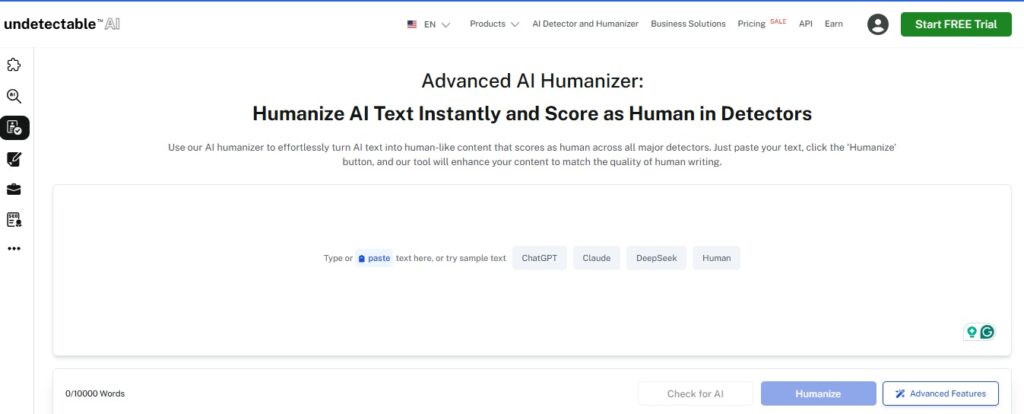

- Użyj narzędzi humanizujących, aby upewnić się, że Twoje teksty odzwierciedlają Twój osobisty głos.

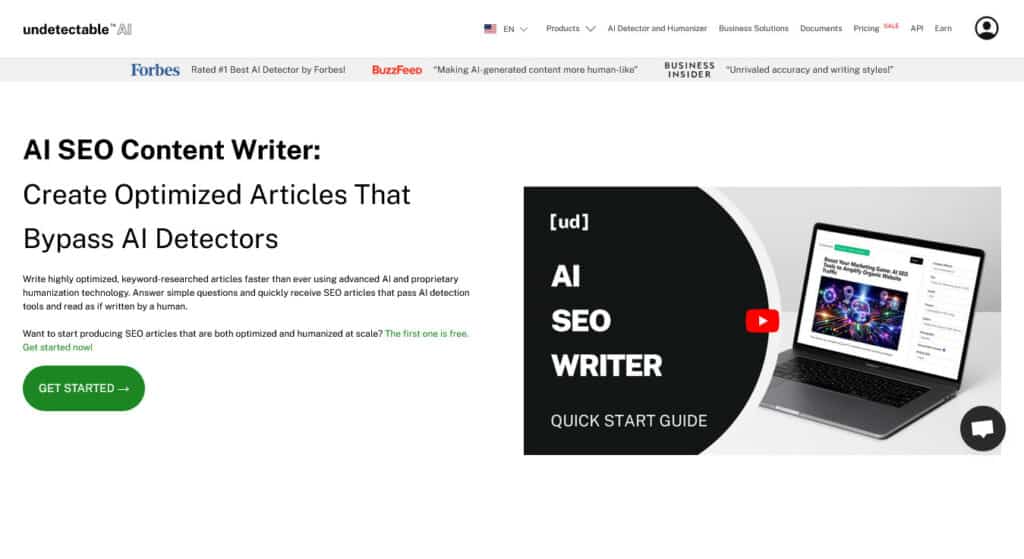

Polecane narzędzia od Undetectable AI

- AI Humanizer - Konwertuje dane wyjściowe robotycznej sztucznej inteligencji na ludzkie pismo, które jest zgodne z unikalnym głosem użytkownika.

- AI SEO Content Writer - Idealny dla studentów zarządzających blogami lub osobistymi portfolio, którzy potrzebują etycznie zoptymalizowanych treści.

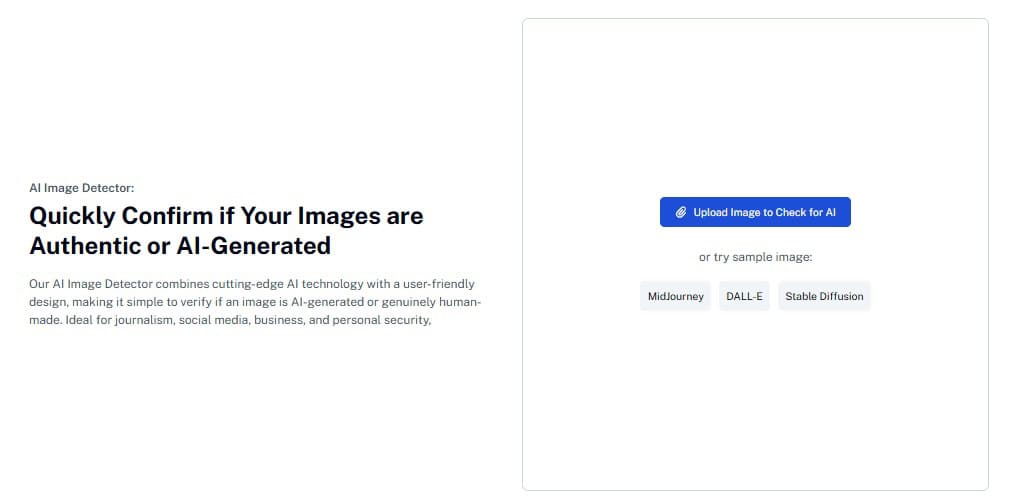

- AI Image Detector - Zaprojektowany z myślą o projektach wizualnych i zgłoszeniach multimedialnych, pomagając zapewnić oryginalność i zgodność.

Korzystając z narzędzi Undetectable AI w sposób odpowiedzialny, uczniowie mogą korzystać ze sztucznej inteligencji bez naruszania oczekiwań akademickich - a nauczyciele mogą budować zaufanie poprzez przejrzystość.

Upewnij się, że Twoje teksty są zgodne ze standardami platformy - zacznij od poniższego widżetu.

Często zadawane pytania (FAQ)

Czy uczelnie mogą wykrywać treści generowane przez ChatGPT?

Tak, ale nie zawsze. Narzędzia wykrywające mogą oznaczać prawdopodobne użycie sztucznej inteligencji, ale często pomijają lub fałszywie identyfikują treści. Weryfikacja przez człowieka pozostaje niezbędna.

Czy używanie ChatGPT do pomocy jest oszustwem?

To zależy. Używanie ChatGPT do burzy mózgów lub wyjaśnienia tematu może być w porządku, jeśli zostanie zatwierdzone przez instruktora. Przekazywanie pracy wygenerowanej przez AI jako własnej jest powszechnie uważane za nieuczciwość akademicką.

Co się stanie, jeśli student jest fałszywie oskarżony o korzystanie z AI?

Zdarzają się fałszywe alarmy. Dlatego też zachęca się instytucje do łączenia narzędzi sztucznej inteligencji z oceną nauczyciela przed podjęciem działań dyscyplinarnych.

Czy niewykrywalne narzędzia AI mogą ominąć wykrywanie?

Niewykrywalna sztuczna inteligencja pomaga humanizować treści i przywracać naturalny przepływ, ale jej głównym celem jest zapewnienie przejrzystości i oryginalności - a nie oszukiwanie systemów wykrywania.

Czy uczelnie będą nadal rozwijać swoje polityki dotyczące sztucznej inteligencji?

Jak najbardziej. Większość instytucji aktywnie zmienia zasady, opracowuje nowe oceny i bada, jak odpowiedzialnie włączyć sztuczną inteligencję do edukacji.

Wnioski

Przyszłość edukacji nie leży w unikaniu sztucznej inteligencji, ale w nauce mądrego korzystania z niej.

Uczelnie w 2025 r. coraz częściej stosują metody wykrywania, ale prawdziwa uczciwość akademicka wynika ze zrozumienia, przejrzystości i zaufania studentów.

Niezależnie od tego, czy jesteś studentem szukającym etyczne sposoby wykorzystania sztucznej inteligencjilub nauczyciel dostosowujący się do nowego krajobrazu uczenia się - niewykrywalna sztuczna inteligencja zapewnia narzędzia wspierające twoją podróż w sposób uczciwy.

Poznaj niewykrywalną sztuczną inteligencję i odblokować etyczne, skuteczne sposoby pracy ze sztuczną inteligencją w dzisiejszych klasach.