Com o prompt de IA corretopodes fazer basicamente qualquer coisa. É assim que as ferramentas de IA já são poderosas.

As ferramentas de IA remodelaram a forma como as empresas funcionam, permitindo-lhes simplificar os processos e aumentar a eficiência como nunca antes.

Uma área em que a IA se destaca verdadeiramente é a criação de conteúdos. Não nos referimos apenas à elaboração de esboços ou à criação de publicações nas redes sociais.

A IA pode até ajudar-te escreve livros e completa trabalhos de investigação complexos.

Mas com um grande poder vem uma grande responsabilidade, e nem sempre se pode confiar na IA para fazer o que está certo.

Por vezes, a IA produz o que se designa por "alucinações". Trata-se de resultados incorrectos ou bizarros que podem induzir os utilizadores em erro.

Quase metade das organizações relatam desafios à qualidade dos dados que põem em causa as iniciativas de IA.

Não é uma solução milagrosa, mas a "fundamentação" visa garantir que os resultados da IA se baseiam em informações fiáveis.

Embora possa parecer complexo, a resposta à pergunta "O que é a ligação à terra e as alucinações na IA?" é crucial para quem utiliza estas ferramentas poderosas.

Vamos entrar nos pormenores da alucinação da IA para que possas maximizar com confiança o teu rendimento com a IA, assegurando ao mesmo tempo que as tuas informações permanecem precisas.

Principais conclusões

- As alucinações da IA ocorrem quando os modelos geram informações falsas ou enganosas devido a lacunas nos dados ou a um sobreajuste.

- A ligação à terra ancora os resultados da IA a dados verificados do mundo real para reduzir as alucinações e melhorar a fiabilidade.

- As alucinações na criação de conteúdos podem prejudicar a credibilidade, espalhar desinformação e causar problemas legais.

- Evite problemas utilizando ferramentas fiáveis, verificando o conteúdo e fornecendo avisos claros e pormenorizados.

- A combinação da deteção de IA e da supervisão humana - como acontece com a IA indetetável - garante a exatidão e a autenticidade.

O que é o grounding e as alucinações na IA?

Quando se trata de compreender o que é alucinação na IA, saber como pode ocorrer é especialmente útil para as organizações que exigem informações tão precisas quanto possível.

Ao aprenderes sobre a ligação à terra e as alucinações da inteligência artificial, poderás compreender melhor o funcionamento das ferramentas de IA e garantir que o teu Conteúdo gerado por IA mantém-se credível.

O que são alucinações na IA?

Imagina que pedes a um chatbot de IA informações sobre uma pessoa.

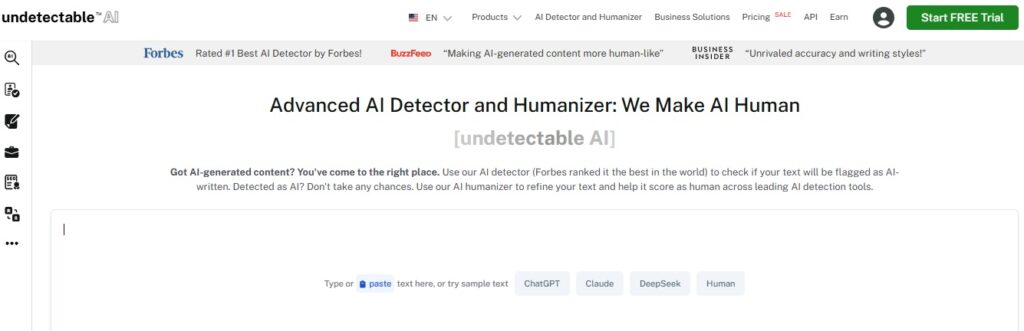

Nunca mais se preocupe com o facto de a IA detetar os seus textos. Undetectable AI Pode ajudar-vos:

- Faça aparecer a sua escrita assistida por IA de tipo humano.

- Bypass todas as principais ferramentas de deteção de IA com apenas um clique.

- Utilização IA com segurança e com confiança na escola e no trabalho.

O modelo fornece com precisão os detalhes frequentemente mencionados em diferentes fontes online.

Mas depois, ao verificares as informações fornecidas, reparas que a IA também adivinha incorretamente informações menos conhecidas, como a idade e a formação académica.

Estes detalhes errados são o que se chama de "alucinações".

Taxas de alucinação pode variar consoante os modelos. O ChatGPT informou anteriormente que cerca de 3%enquanto os sistemas da Google foram estimados em até 27%.

Estes chatbots são conduzidos por um grande modelo de linguagem que aprende com a análise de grandes quantidades de texto.

Isto acontece porque estes modelos são treinados para prever palavras com base em padrões nos dados que analisaram sem compreenderem o que é verdade ou não.

As alucinações resultam sobretudo de dados de treino incompletos.

Lembra-te de que o modelo pode captar e reproduzir erros em função do que lhe é transmitido.

Há também o "sobreajuste", em que o modelo identifica falsos padrões ou ligações nos dados.

Resolver as alucinações da IA é um desafio porque estes modelos, que funcionam com base em probabilidades e padrões, produzirão inevitavelmente resultados falsos.

Isto pode induzir em erro os utilizadores que podem confiar no conteúdo da IA tal como está. É por isso que é importante estar ciente desta limitação ao utilizar a IA para a criação de conteúdos e a verificação de factos.

O que é a IA de ligação à terra?

A IA de ligação à terra é um método eficaz para reduzir as alucinações. Funciona ancorando as respostas da IA a dados do mundo real.

Por exemplo, um sistema fundamentado utilizaria uma base de dados fiável desde o início para fornecer respostas factuais, reduzindo a probabilidade de a IA inventar coisas.

Em vez de se basear apenas na previsão da palavra seguinte com base em padrões, um sistema fundamentado começa por obter informações de uma fonte credível.

O modelo é também eticamente mais aceitável porque admite que o contexto é insuficiente, pelo que não será capaz de fornecer toda a informação de que necessitas, em vez de se limitar a adivinhar.

Para maximizar o valor da IA e minimizar as imprecisões, as organizações devem investir tempo antecipadamente na recolha de dados de formação precisos, directrizes e outras informações de base necessárias.

Esta preparação ajuda os resultados da IA a manterem-se baseados na realidade e a merecerem a confiança dos utilizadores.

Assim, embora a ligação à terra não seja uma solução infalível, pode melhorar significativamente a qualidade das saídas de IA.

O que é o problema da alucinação da IA na criação de conteúdos?

Na criação de conteúdos, as alucinações da IA podem assumir diferentes formas.

Ao criar uma publicação de blogue ou um artigo, a IA pode incluir factos falsos, estatísticas incorrectas ou citações inventadas.

A alucinação da IA também não é um engano intencional. O modelo não pode mentir, uma vez que não tem motivação para enganar, nem tem consciência de que o que está a dizer é falso.

Simplesmente não tem noção da fiabilidade dos seus resultados.

As consequências das alucinações da IA na criação de conteúdos podem ser graves.

- Difusão de desinformação: Mais de uma em cada cinco pessoas admitem que podem ter partilhado notícias falsas sem verificar.

- Danos à credibilidade: Se um indivíduo ou empresa publicar conteúdo com informações enganosas, a sua reputação pode ser afetada. A confiança é crucial para os utilizadores e, uma vez perdida, pode ser difícil recuperá-la.

- Repercussões jurídicas e financeiras: A publicação de informações falsas pode dar origem a potenciais dores de cabeça e até a processos judiciais. É uma batalha dispendiosa que não vais querer enfrentar.

- Impacto negativo nas decisões empresariais: As empresas que dependem da IA para produzir relatórios e informações para a tomada de decisões podem fazer más escolhas com base em dados incorrectos. As informações falsas prejudicam tanto o público como a empresa ou o indivíduo que utiliza a IA para a criação de conteúdos. E as alucinações da IA podem, de facto, agravar este problema, gerando conteúdos que parecem credíveis mas que, na realidade, têm falhas.

Como evitar problemas causados por alucinações de IA

Sabemos como as ferramentas de IA são valiosas para a criação de conteúdos. A utilização da IA é mesmo considerada uma das as melhores formas de ganhar dinheiro hoje em dia e para te manteres competitivo na indústria.

É também por isso que é crucial resolver o problema das alucinações da IA para garantir que o conteúdo que utilizas com a IA é exato.

Compreende as limitações da IA

Embora já saibamos o quão poderosa é a IA, ela tem as suas limitações.

Quando se trata de criação de conteúdos, funciona muito bem no reconhecimento de padrões e na geração de texto com base em enormes conjuntos de dados, mas continua a não ter qualquer sentido de realidade.

Tem em conta estas limitações quando utilizares a IA:

- Tem dificuldade em compreender o contexto ou em entender distinções culturais subtis

- Depende fortemente da qualidade e da quantidade de informação disponível

- Tendência para criar preconceitos com base nos dados de formação

- Não tem criatividade e originalidade semelhantes às do ser humano

- Pode gerar conteúdos moralmente questionáveis

- Tem dificuldade em resolver problemas fora do que o sistema conhece

- Dificuldade em adaptar-se a situações em mudança ou em fornecer informações em tempo real

- Vulnerável a ataques e pode comprometer a privacidade dos dados

Conhecer os seus limites também evita alucinações de IA. Os limites ajudam a definir expectativas realistas e facilitam a deteção de imprecisões antes de se tornarem públicas.

Utiliza modelos e ferramentas fiáveis

O as melhores ferramentas de IA para a criação de conteúdos torna as coisas mais fáceis. Estas ferramentas não são perfeitas, mas o que utilizares deve dar conta do recado.

Para chatbots com IA, o ChatGPT continua a ser o o mais forte que existe. O GPT-4 apresenta uma taxa de precisão elevada de 97% e a taxa mais baixa de alucinações ChatGPT.

Certifica-te apenas de que dás instruções claras e verificas os resultados em fontes fiáveis.

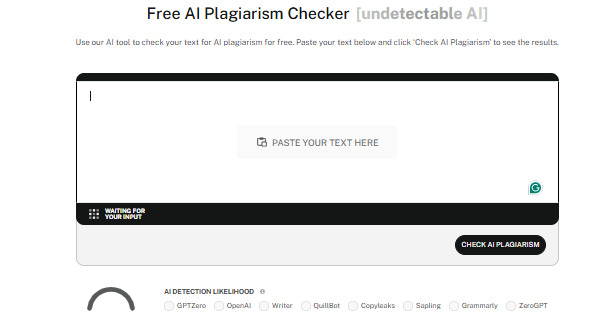

Deves também utilizar ferramentas de deteção de IA fiáveis, como IA indetetável.

Os detectores analisam o conteúdo de forma eficaz para detetar até os elementos de IA mais subtis, mantendo a autenticidade em qualquer conteúdo que produza e mantendo a sua credibilidade.

Undetectable também tem um Humanizador de IA que aperfeiçoa ainda mais o texto para que soe natural.

Com ele, não só passas na deteção de IA, como também garantes a qualidade do teu conteúdo.

Verifica o conteúdo

Independentemente da forma como utilizas a IA no processo de criação de conteúdos, é sempre importante verificar os conteúdos que produziste.

Estas são algumas formas comuns de verificar o conteúdo da IA:

- Faz uma verificação cruzada, comparando informações de várias fontes fiáveis

- Utiliza ferramentas de verificação de factos para simplificar a desinformação

- Procura informações junto de especialistas na matéria ou de profissionais da área

- Pede que o conteúdo seja revisto por pares ou colegas para ajudar a identificar potenciais erros, preconceitos ou imprecisões

- Utiliza software de deteção de IA para garantir a originalidade e evitar plágio não intencional

- Considera o contexto histórico ao fazer referência a eventos ou dados para garantir a sua exatidão

Tomar precauções compensa. Verificar o conteúdo da IA dá-te a tão necessária confiança de que o que produzes é sempre fiável.

Fornece instruções claras

Uma das principais causas da alucinação por IA são as instruções pouco claras.

Se fizeres perguntas demasiado vagas à IA, sem contexto adicional, é mais provável que esta gere respostas que não fazem muito sentido.

São os avisos claros e específicos que mantêm a IA no caminho certo.

Por isso, sê específico e detalhado nas tuas sugestões.

Em vez de fazeres perguntas demasiado amplas, como "Qual é o melhor restaurante asiático?", tenta algo mais focado, como "Quais são as lojas de ramen mais bem cotadas em Quioto?".

A especificidade ajuda a IA a manter-se no caminho certo e a produzir resultados precisos que satisfazem as tuas expectativas.

Manter-se atualizado

A tecnologia continua a avançar, e a um ritmo acelerado, por isso, certifica-te de que te manténs atualizado.

A IA aprende essencialmente com os dados com que é treinada, mas a informação pode ficar rapidamente desactualizada.

Isto é especialmente verdade em domínios em rápida evolução, como a investigação científica ou os cuidados de saúde.

Podes manter-te informado seguindo fontes de confiança nas redes sociais, ou podes fazer cursos relacionados com o teu sector e participar em eventos do sector.

Desta forma, tens a certeza de que o conteúdo fornecido pela IA continua a ser credível.

As próprias ferramentas de IA também se actualizam com frequência, por isso, mantém-te a par dos últimos desenvolvimentos para teres sempre a certeza de que utilizas as melhores.

Conhecimento humano

Humanos e IA devem trabalhar em conjunto para garantir a qualidade, a exatidão e a autenticidade na criação de conteúdos

Afinal de contas, somos nós que trazemos para a mesa o pensamento crítico, a criatividade e o discernimento ético.

Combinando as capacidades da IA com a supervisão humana, podes verificar se o conteúdo não só é exato, mas também contextualmente relevante - bem como cativante e acertando nas notas certas.

Os especialistas humanos podem detetar preconceitos, verificar a informação e tomar decisões que a IA, por si só, pode não ser capaz de compreender.

Os seres humanos e a IA, em conjunto, podem criar conteúdos fiáveis, perspicazes e com impacto.

Veja o nosso Detetor de IA e Humanizador no widget abaixo!

Conclusão

Compreender o que é o grounding e as alucinações na IA é essencial para quem utiliza ferramentas de IA no seu trabalho.

O grounding torna a IA mais precisa e mantém a integridade do teu conteúdo, utilizando dados reais e verificados.

Estar consciente das alucinações provocadas pela IA também te ajuda a conhecer as formas correctas de as evitar e a afastares-te de potenciais armadilhas.

Manter a exatidão do conteúdo da IA é apenas uma parte do processo. Certifica-te de que o teu conteúdo permanece autêntico e de alta qualidade, utilizando a IA indetetável.

Esta ferramenta funciona como detetor de IA e humanizador, garantindo que o conteúdo gerado por IA se mistura perfeitamente com a escrita humana e pode passar nas detecções.

Escolha as melhores opções de verificação de conteúdos com IA para as suas necessidades e deixe que a IA indetetável mantém consistentemente o seu conteúdo fiável, original e humano. Comece a utilizá-lo hoje mesmo.