Термін "глибокий фейк вперше з'явився на Reddit у 2017 роціколи користувач з таким самим іменем почав ділитися зміненими відео, в яких ШІ змінював обличчя, спочатку в контентах для дорослих.

Хоча Reddit заборонив оригінальний сабреддіт, ідея вже злетіла.

Але коріння цієї технології сягає ще глибше.

У 1997 році дослідники вже почали експериментувати з редагуванням відео за допомогою машинного навчання.

Їхній ранній інструмент для синхронізації губ, який називався Перезапис відео може змусити когось сказати те, чого він не говорив.

За сьогоднішніми мірками, це не була глибока фальсифікація, але вона заклала підґрунтя для того, що буде далі.

Сьогоднішній блог про те, як працює ця технологія, де вона з'являється в повсякденному житті, які ризики та переваги вона несе з собою.

Давайте почнемо з розуміння того, що таке глибокий фейк.

Основні висновки:

- Діпфейки - це створені штучним інтелектом медіа, які створюють враження, що люди говорять або роблять те, чого насправді не робили.

- За допомогою безкоштовних інструментів і базових навичок майже будь-хто може створювати переконливі фейкові відео, зображення або аудіокліпи.

- Хоча глибокі фейки можуть бути креативними або розважальними, вони також несуть серйозні ризики, такі як шахрайство, наклеп і дезінформація.

- Ви можете виявити більшість глибоких фейків, використовуючи інструменти виявлення або уважно спостерігаючи за візуальними та поведінковими невідповідностями.

Що таке діпфейк?

Deepfake - це підроблені медіа, як правило, відео, аудіокліпи або зображення, які були змінені за допомогою штучного інтелекту, щоб змусити когось виглядати або звучати так, ніби він робить або говорить те, чого насправді не робив.

Не думайте, що це просто невдала робота в фотошопі або недбалий голос за кадром.

Ми говоримо про високорівневі маніпуляції з використанням технології глибокого навчання, яка є підмножиною штучного інтелекту.

Більше ніколи не турбуйтеся про те, що ШІ виявить ваші тексти. Undetectable AI Може допомогти тобі:

- Зробіть так, щоб ваше письмо з допомогою штучного інтелекту з'являлося на екрані схожий на людину.

- Обхід всі основні інструменти виявлення ШІ лише одним кліком.

- Використання ШІ безпечно і впевнено у школі та на роботі.

Саме це має на увазі термін "deepfake": глибоке навчання та підроблений контент.

Метою глибинного фейку зазвичай є створення чогось, що виглядає достатньо реальним, щоб обдурити людей.

Можливо, ви бачили ці вірусні відео, де знаменитості роблять дивні речі або політики роблять обурливі заяви, які вони ніколи б не сказали насправді.

Це класичні випадки використання глибокого фейку. Те, що ви бачите, не є справжнім, але технології, які стоять за цим, стали настільки досконалими, що ваш мозок не відразу вловлює підробку, якщо тільки ви не дивитеся на неї уважно.

Ось де такі інструменти, як TruthScan втручайтеся.

Розроблений для виявлення навіть найреалістичніших синтетичних відео, він аналізує кадр за кадром поведінку та шаблони облич, які часто вислизають від людського ока, надаючи користувачам швидкий і точний спосіб виявити глибокі фейки до того, як вони поширяться.

Насправді, за даними дослідницької групи Undetectable AI, 85 % американців кажуть, що "глибокі фейки" підірвали їхню довіру до інформації в Інтернеті.

Ви щойно дізналися, що таке фейкове відео чи медіа, а тепер перейдемо до того, як люди їх створюють.

Як створюються діпфейки

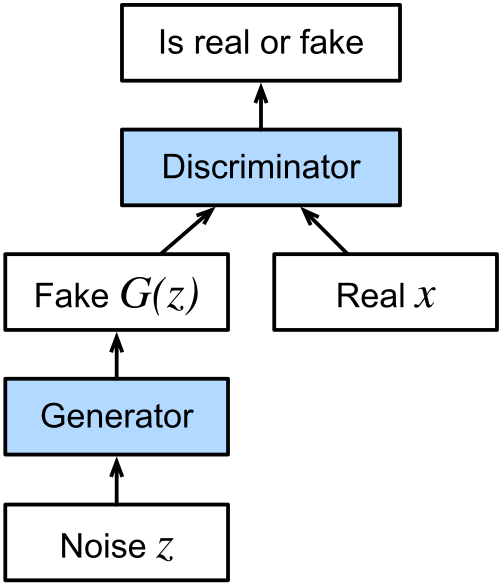

Технологія, що стоїть за більшістю глибоких фейків, - це категорія алгоритмів машинного навчання, які називаються генеративними суперницькими мережами, або GANs (generative adversarial networks).

GAN складаються з двох частин: генератора і дискримінатора.

Генератор створює фейкові медіа на основі того, що він навчений відтворювати, а робота дискримінатора полягає в тому, щоб виявити те, що виглядає як фейк.

Вони повертаються туди-сюди, поки генератор не навчиться створювати фейковий контент, який зможе пройти перевірку дискримінатора.

Згодом цей рух туди-сюди призводить до того, що медіа виглядають шокуюче реалістично.

Що таке процес створення підробленого відео?

При створенні глибокого фейку система аналізує відео з різних ракурсів, вивчає, як людина розмовляє, як рухається її обличчя, як зміщується тіло.

Уся ця інформація потрапляє до генератора, щоб він міг створити контент, який імітує цю поведінку.

Потім дискримінатор допомагає доопрацювати його, вказуючи на те, що не так, доки кінцевий результат не буде виглядати ідеально.

Ось чому ілюзія так добре тримається в русі.

Існує кілька різних методів, які використовуються залежно від мети підробленого відео.

Якщо ідея полягає в тому, щоб змусити когось сказати або зробити щось на відео, чого він насправді не говорив і не робив, то ми маємо справу з так званою "глибокою підробкою" вихідного відео.

Автокодер глибокої підробки, що складається з кодера та декодера, вивчає оригінальний відеоматеріал і накладає на нього вираз обличчя, жести та ледь помітні рухи голови об'єкта зйомки.

Audio Deepfakes

Аудіопідробка працює шляхом клонування чийогось голосу, знову ж таки за допомогою GAN, на основі записів природної мови.

Після навчання модель може генерувати нову мову цим голосом, навіть якщо людина ніколи не вимовляла цих слів.

Ще один шар, який часто додають, - це синхронізація губ.

Тут система накладає згенерований або попередньо записаний звук на відео.

Мета полягає в тому, щоб губи на відео збігалися зі словами в аудіо.

Реальні приклади "глибоких фейків

У наші дні діпфейки з'являються повсюди.

Пропонуємо вам ознайомитися з деякими популярними діпфейками, які демонструють, наскільки далеко зайшла технологія.

Фейк про те, що президент Зеленський просить українських військових здатися

У березні 2022 року, на початковому етапі російсько-української війни, в мережі з'явилося відео із зображенням президента України Володимира Зеленського закликаючи своїх солдатів здатися.

Це було схоже на загальнонаціональне звернення, доповнене голосом і манерами Зеленського.

Відео поширилося соціальними мережами і навіть було розміщене на скомпрометованому українському новинному сайті.

Президент діяв швидко і випустив офіційну заяву через свої перевірені канали, щоб спростувати ці кадри.

Вірусне підроблене зображення Папи Франциска в дизайнерській куртці-пуховику

Іноді підроблене зображення не обов'язково має бути зловмисним, щоб викликати плутанину.

У 2023 році вірусне фото Папа Франциск розгулює в стильній білій куртці-пуховику від Balenciaga взяла інтернет штурмом.

Він зібрав десятки мільйонів переглядів і був широко поширений на різних платформах.

Зображення було створено за допомогою інструменту штучного інтелекту під назвою Midjourney анонімним користувачем з Чикаго.

Підробки Ілона Маска використовуються в онлайн-шахрайстві

У 2024 році, глибокі фейки за участю Ілона Маска став центральним елементом кількох масштабних онлайн-шахрайств.

На Facebook, TikTok та інших платформах почали з'являтися згенеровані штучним інтелектом відеоролики Маска, в яких він рекламує фальшиві роздачі криптовалюти та інвестиційні схеми.

Ці кліпи виглядали і звучали напрочуд реалістично.

Збиток був не лише теоретичним. Як повідомляється, літній пенсіонер втратив майже $700,000 після того, як його переконав один з таких відеороликів.

Фальшивий рободзвінок Джо Байдена, спрямований на виборців США

На початку 2024 року, якраз перед праймеріз у Нью-Гемпширі, виборців отримали рободзвінки це звучало точнісінько як президент США Джо Байден.

У заклику Джо Байден закликав виборців залишитися вдома і приберегти свій голос для загальних виборів у листопаді. Це мало на меті заплутати і ввести в оману виборців, щоб вони пропустили праймеріз.

Інцидент викликав заклики до регулювання. Правозахисні групи закликали Федеральну виборчу комісію США втрутитися в ситуацію, але вона відмовилася, пославшись на обмеження своїх повноважень.

Тим часом, телекомунікаційна компанія, відповідальна за розповсюдження рободзвінка погодився сплатити штраф у розмірі $1 млн.

Використання політичних фейків на виборах в Індії 2020 року

Не всі випадки використання технології deepfake є шкідливими або оманливими за своїм наміром (про це далі в блозі).

Під час виборів до Законодавчої асамблеї Делі у 2020 році Партія "Бхаратія Джаната" використала ШІ для створення передвиборчої реклами для різних мовних аудиторій.

Партія взяла відео, на якому її лідер Манодж Тіварі виступає англійською мовою, і використала глибоку фальшиву синхронізацію губ, щоб створити версію на хар'янві, регіональному діалекті.

У той час як голос за кадром озвучував актор, візуальні ефекти були змінені відповідно до нового звуку за допомогою штучного інтелекту, навченого на реальних кадрах Tiwari.

Члени партії вбачали в цьому позитивне застосування технології, яка дозволила їм спілкуватися з виборцями зрозумілою для них мовою, навіть якщо кандидат не володів нею вільно.

Чи небезпечні діпфейки? Ризики та занепокоєння

Досі ми розглянули, що таке глибокий фейк, як його створюють і де він вже з'явився в реальному світі.

Технологія, безперечно, вражає, але ризики, пов'язані з нею, серйозні і швидко зростають.

Діпфейки можуть бути використані у кілька способів. Ось кілька основних проблем, які викликають занепокоєння.

Наклеп

Коли чиюсь подобу або голос використовують для створення фейкових коментарів, заяв або відео, особливо образливих або суперечливих, це може майже миттєво зруйнувати репутацію.

І на відміну від старих містифікацій або фальшивих цитат, переконливий глибокий фейк не залишає місця для сумнівів у свідомості глядача.

У зв'язку з цим "глибокі фейки" можуть викликати обурення, зруйнувати відносини або просто проштовхнути шкідливий наратив.

Що особливо турбує, так це те, що підробка навіть не обов'язково має бути ідеальною.

Якщо людина є впізнаваною, а зміст достатньо правдоподібним, це може мати тривалий вплив на громадську думку.

Достовірність інформації

Ще одне серйозне занепокоєння викликає те, як глибокі фейки підривають саму ідею правди.

З поширенням фейків стає дедалі важче зрозуміти, чи є те, що ми бачимо або чуємо, справжнім. З часом це може призвести до більш широкої ерозії довіри до будь-якої форми цифрової комунікації.

Ця криза довіри виходить за рамки окремих інцидентів.

У демократичних суспільствах люди покладаються на спільні факти при прийнятті рішень, обговоренні питань та вирішенні колективних проблем.

Але якщо виборці, глядачі чи громадяни починають все ставити під сумнів, стає набагато легше маніпулювати громадською думкою або відкидати незручну правду як "черговий глибокий фейк".

Шантажувати.

Медіа, створені штучним інтелектом, можуть бути використані для неправдивого звинувачення людей, створюючи враження, що вони вчинили щось незаконне, неетичне або ганебне.

Такі сфабриковані докази можуть бути використані для залякування або контролю.

І це стосується обох сторін. Оскільки глибокі фейки зараз настільки реалістичні, що людина, яка стикається зі справжнім шантажем, може стверджувати, що докази фальшиві, навіть якщо це не так.

Іноді це називають інфляцією шантажу, коли величезна кількість правдоподібних фейків знижує цінність справжніх викривальних матеріалів.

Достовірність реальних доказів губиться в тумані, і це лише додає ще один рівень складності при спробі викрити правопорушення.

Шахрайство та афери

Використовуючи відео, згенеровані штучним інтелектом, або голоси публічних осіб, яким довіряють, шахраї створюють неймовірно переконливі схеми.

У деяких випадках підробки знаменитостей, таких як Ілон Маск, Том Хенкс або Опра Вінфрі, використовуються для просування продуктів або послуг, про які вони ніколи не чули.

Потім ці відео поширюються на соціальних платформах, де їх бачать мільйони.

Навіть приватні особи піддаються ризику, особливо в кампаніях спам-фішингу, які націлені на конкретних людей з персоналізованим контентом, призначеним для маніпулювання або обману.

За даними Звіт Forbes за 2024 рікЗа оцінками експертів, шахрайство з використанням глибоких фейків вже призвело до глобальних збитків у розмірі 1 трлн. 7 трлн. 12 млрд. доларів, і очікується, що ця цифра зросте більш ніж утричі протягом наступних кількох років.

Позитивне та креативне використання діпфейків

Варто зазначити, що не кожне застосування технології є негативним.

Хоча багато блогів, які пояснюють, що таке "глибокий фейк", зосереджені на зловживаннях, зростає список креативних і продуктивних способів використання "глибоких фейків".

Нижче наведено кілька яскравих прикладів.

Кіно та акторська майстерність

Студії починають покладатися на технологію глибокої підробки для таких речей, як:

- Посилення візуальних ефектів

- Зниження виробничих витрат

- Повертаємо до життя персонажів, яких більше немає поруч

Діснейнаприклад, вдосконалює моделі глибоких фейків з високою роздільною здатністю, які дозволяють міняти обличчя та омолоджувати акторів з вражаючою реалістичністю.

Їх технологія працює з роздільною здатністю 1024 x 1024 і може точно відстежувати вираз обличчя, щоб зробити персонажів молодшими або виразнішими.

За межами Голлівуду "глибокі фейки" уможливили проведення глобальних кампаній, наприклад, коли Девіда Бекхема клонували в цифровому вигляді донести повідомлення про здоров'я кількома мовами.

Мистецтво

У 2018 році мультимедійний художник Джозеф Айерл використав технологію deepfake, щоб створити актора зі штучним інтелектом, який поєднав обличчя італійської кінозірки Орнелли Муті з тілом Кендалл Дженнер.

Результатом стало сюрреалістичне дослідження ідентичності поколінь та мистецька провокація, що стала частиною відео-арту під назвою Un'emozione per sempre 2.0.

Діпфейки також з'явилися в сатирі та пародії.

Яскравим прикладом є веб-серіал 2020 року "Нахабне правосуддя", створений творцями "Південного парку" Треєм Паркером і Меттом Стоуном.

Вона використовувала підроблених публічних осіб, щоб висміювати поточні події, одночасно підвищуючи обізнаність про саму технологію.

Обслуговування клієнтів

За межами креативних індустрій бізнес знаходить користь у глибоких підробках для обслуговування клієнтів.

Деякі колл-центри зараз використовують синтетичні голоси на основі технології глибокої підробки для автоматизації основних запитів, таких як запити щодо облікових записів або реєстрація скарг.

У цих випадках наміри не зловмисні, а просто для оптимізації.

Системи реагування на дзвінки можна персоналізувати, використовуючи голоси, згенеровані штучним інтелектом, щоб автоматизовані сервіси звучали більш природно і привабливо.

Оскільки завдання, які вирішуються, зазвичай є низькоризиковими та повторюваними, глибокі фейки в цьому контексті допомагають знизити витрати і звільнити людських агентів для вирішення більш складних питань.

Освіта

Освітні платформи також почали включати в себе репетиторів з глибокими знаннями, які допомагають учням у більш інтерактивний спосіб.

Ці репетитори, керовані штучним інтелектом, можуть проводити уроки, використовуючи синтетичні голоси та персоналізовані вказівки.

Інструменти та методи виявлення підробок

З ростом популярності та доступності "глибоких фейків" зростає потреба в їхньому виявленні до того, як вони завдадуть шкоди.

Людям та організаціям також потрібні правильні інструменти та методи, щоб бути на крок попереду. Тож ось кілька інструментів і методів.

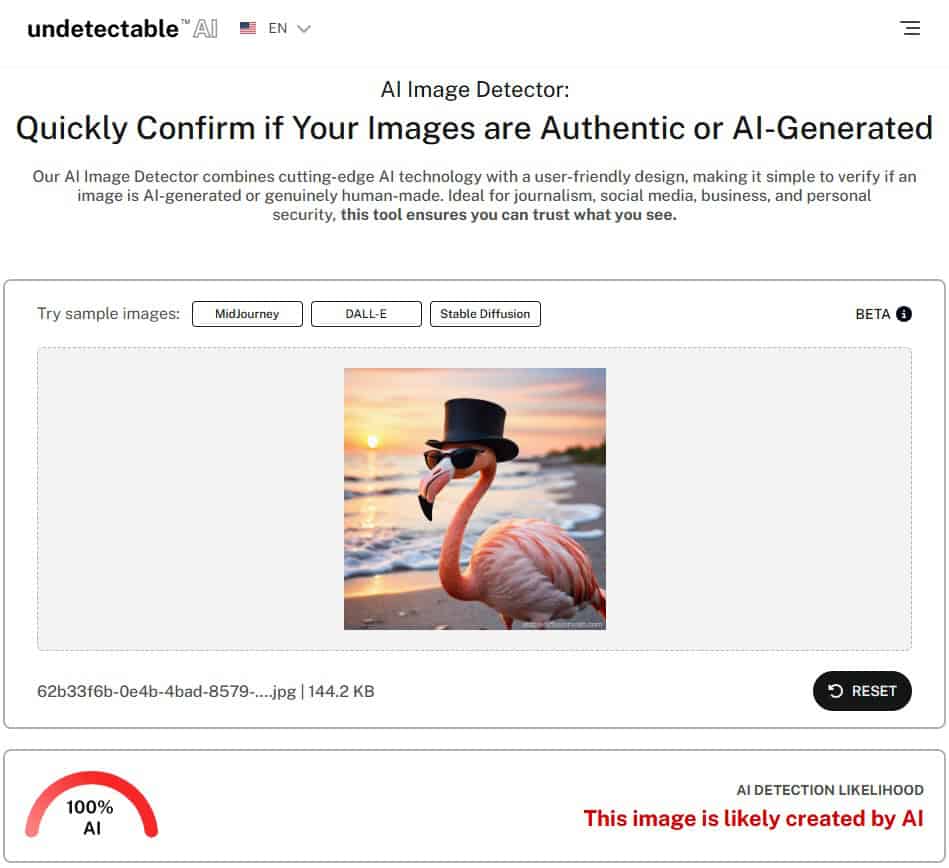

АІ-детектор зображень від Undetectable AI

Детектор зображень Undetectable AI робить виявлення глибоких підробок простішим навіть для тих, хто не має технічної освіти.

Детектор працює, аналізуючи різні елементи на завантаженому зображенні, такі як кольорові патерни, текстури, риси обличчя та структурні невідповідності.

Він підтримує виявлення медіа, створених за допомогою найвідоміших ШІ-генераторів зображень, як-от

- MidJourney

- ДАЛ-І

- Стабільна дифузія

- Ідеограма

- Моделі на основі GAN

Щоб скористатися ним, просто завантажте зображення, дозвольте інструменту проаналізувати його та отримайте чіткий вердикт з оцінкою достовірності.

Якщо ви не впевнені, чи є зображення, на яке ви натрапили, справжнім, спробуйте наш детектор зображень зі штучним інтелектом щоб перевірити наявність ознак втручання ШІ.

Наприклад, ось зображення фламінго, згенероване ШІ за допомогою Stable Diffusion.

Тепер, давайте покладемо ШІ-детектор від Undetectable і перевірити, чи зможе він точно визначити, що зображення згенероване штучним інтелектом.

Як бачите, ШІ-детектор зображень від Undetectable AI позначив це зображення як створене ШІ 100%.

TruthScan

Хоча виявлення зображень є потужним інструментом, відеопідробки потребують зовсім іншого рівня перевірки, особливо в таких чутливих галузях, як політика, фінанси чи медіа.

Це там, де Детектор фейків TruthScan приходить.

TruthScan - це просунута система перевірки автентичності відео від Undetectable AI. Він сканує носії на наявність ознак фальсифікації:

- Виявлення підміни обличчя: Виявляє змінені риси обличчя або відтворення за допомогою покадрової розбивки.

- Поведінковий дактилоскопічний аналіз: Позначає синтетичні вирази, які порушують природну симетрію або ритм обличчя.

- Відео-криміналістика: Перевіряє стиснення кадрів, цифрові відбитки пальців і невідповідності звуку.

- Виявлення в реальному часі: Виявлення глибоких підробок під час прямі трансляції та відеодзвінки.

Незалежно від того, чи перевіряєте ви вірусні кліпи, чи перевіряєте відео кампанії, TruthScan - це ваш найкращий захист від відео-обману.

Спробуй TruthScan сьогодні, щоб протестувати власний відзнятий матеріал.

Візуальні та поведінкові методи для ручного виявлення

Існують також практичні методи, які можна використовувати для виявлення глибоких фейків вручну, особливо в ситуаціях, коли потрібен негайний аналіз.

Деякі візуальні червоні прапорці включають:

- Незручне положення обличчя або дивні вирази.

- Непослідовне освітлення або забарвлення різних частин зображення чи відео.

- Мерехтіння навколо обличчя або лінії волосся, особливо під час руху.

- Відсутність природного моргання або нерегулярний рух очей.

- Розбіжності в синхронізації губ, коли звук не збігається з промовою.

З точки зору поведінки, глибокі фейки часто намагаються імітувати тонкі людські риси. Звертайте увагу на мову тіла, емоційний вираз обличчя та звичні жести.

А в розмовах у реальному часі, особливо під час прямого ефіру, просіть, щоб ви дивилися на вас збоку.

Багато фейкових моделей все ще намагаються точно відтворити 90-градусний кут обличчя або складні рухи, такі як поворот голови, зберігаючи при цьому природний вираз обличчя.

Виявлення глибоких фейків у тексті та контексті

Діпфейки не обмежуються візуальними ефектами. Деякі версії включають синтетичний текст, голос або поведінку, що імітує чийсь стиль спілкування.

Аналізуючи текстовий контент або діалог, слідкуйте за тим, на що слід звернути увагу:

- Орфографічні помилки та дивна граматика.

- Речення, які здаються вимушеними або не випливають природно.

- Незвичайні адреси електронної пошти або непослідовні формулювання.

- Повідомлення, які здаються вирваними з контексту або не пов'язані з ситуацією.

Контекст також має значення. Якщо відео або повідомлення з'являється в умовах, які не мають сенсу, наприклад, коли політик недбало оголошує важливе рішення в низькоякісному кліпі, варто поставити під сумнів його достовірність.

Зацікавилися нашими AI-детектором і гуманізатором? Спробуйте їх у віджеті нижче!

Поширені запитання про Deepfakes

Чи є депфейки незаконними?

Діпфейки не є незаконними за замовчуванням, але вони можуть бути такими, якщо порушують чинні закони, наприклад, про наклеп, дитячу порнографію або відвертий контент без згоди сторін.

Деякі штати США ухвалили закони, спрямовані на боротьбу з глибокими фейками, які впливають на вибори або пов'язані з порнопомстою.

Федеральні законопроекти, такі як DEFIANCE Act та Закон про відсутність фальсифікацій також ведуться роботи з регулювання зловмисного використання технологій глибокого підроблення.

Чи може хтось зробити глибоку підробку?

Так, майже будь-хто може зробити глибоку підробку, використовуючи безкоштовне або недороге програмне забезпечення та інструменти штучного інтелекту.

Багато платформ зараз пропонують зручні інтерфейси, тому для початку роботи не потрібні складні технічні навички.

Як я можу захиститися від глибоких фейків?

Обмежте свій вплив, уникаючи публікації зображень і відео високої роздільної здатності в Інтернеті. Використовуйте налаштування конфіденційності та інструменти виявлення, такі як ШІ, який неможливо виявити або TruthScan щоб перевірити все підозріле.

Чи існують програми для виявлення глибоких підробок?

Так, невидимий ШІ ШІ-детектор зображень та TruthScan's Deepfake Detector доступні онлайн і оптимізовані для швидкого використання.

Заключні думки

Тепер ви знаєте, що таке глибокий фейк, як його створюють, а також ризики та можливості, які з ним пов'язані.

Загроза реальна, як і інструменти, покликані їй протистояти. Детектор зображень Undetectable AI та сканер відеопідробок TruthScan допоможуть вам залишатися в курсі подій, бути захищеними та випереджати конкурентів.

Готові перевірити зображення або відео? Спробуйте AI Image Detector або TruthScan сьогодні.

Хочете отримати повний захист від контенту, створеного штучним інтелектом, незалежно від того, скануєте ви його, пишете чи перевіряєте?

Дослідити весь ШІ, який неможливо виявити платформа для гуманізації написання ШІ, виявлення підробок зображень і відео та контролю вашої цифрової ідентичності.