Generativní nástroje umělé inteligence přerostly z vědeckého výzkumu v závažný veřejný problém. Podle výsledků průzkumu z června 2025 lidé projevují strach ze syntetických médií a zároveň neschopnost je odhalit.

FBI uvádí, že technologie deepfake s umělou inteligencí umožňuje páchat trestnou činnost třemi hlavními způsoby, mezi něž patří spamové zprávy generované umělou inteligencí, osoby vytvořené umělou inteligencí na sociálních sítích a podvodné webové stránky kódované umělou inteligencí.

Cílem těchto systémů je finanční zneužití jak obchodních organizací, tak jednotlivých spotřebitelů. Kombinace technologie deepfake s umělou inteligencí vedla k více než $200 milionů ztrát během roku 2025.

Většina Američanů (85%) ztratila v uplynulém roce důvěru v online informace kvůli deepfakes a 81% se obává osobní újmy způsobené falešným audio a video obsahem. Více než 90% uživatelů nevyužívá detekční nástroje. Údaje naznačují rostoucí "mezeru v důvěře", která vyžaduje okamžitý zásah regulačních orgánů a provozovatelů platforem a technologů.

Klíčová zjištění

| Insight | Podpůrné údaje |

|---|---|

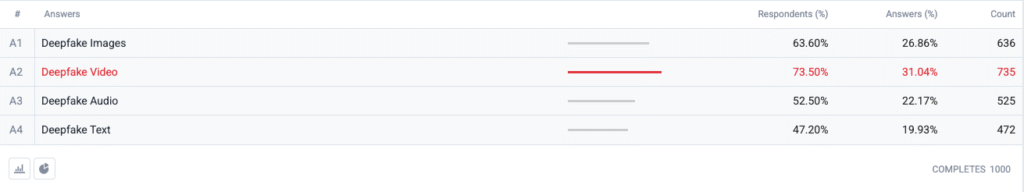

| Video Deepfake je na vrcholu indexu strachu. | 73,5 % respondentů zvolilo deepfake video jako formát, kterého se "nejvíce obávají", následovaný obrázky (63,6 %), zvukem (52,5 %) a textem (47,2 %). |

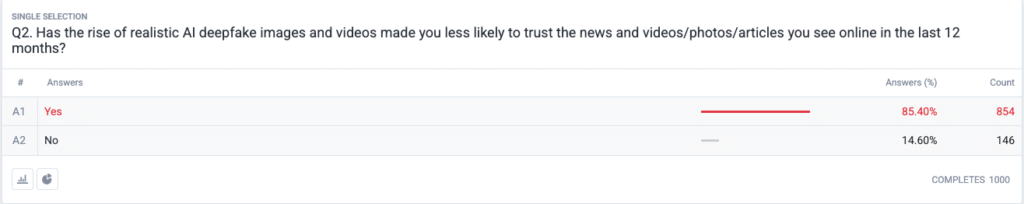

| Rozvíjí se plnohodnotná krize důvěry. | 85,4 % uvádí, že v posledních 12 měsících méně důvěřují zprávám, fotografiím nebo videím na internetu kvůli realistickým falešným informacím. |

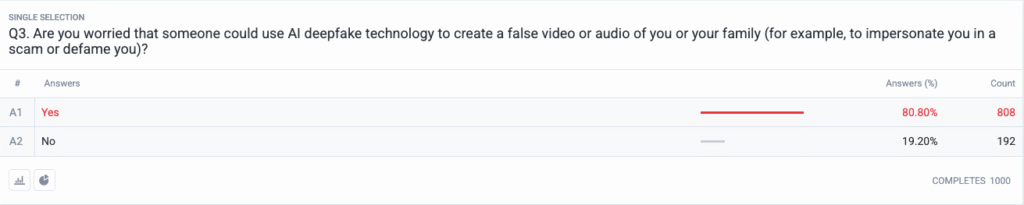

| Osobní ohrožení se stalo hlavním proudem. | 80,8 % se obává, že by podvodníci nebo špatní aktéři mohli deepfake obsah použít proti nim nebo jejich rodině. |

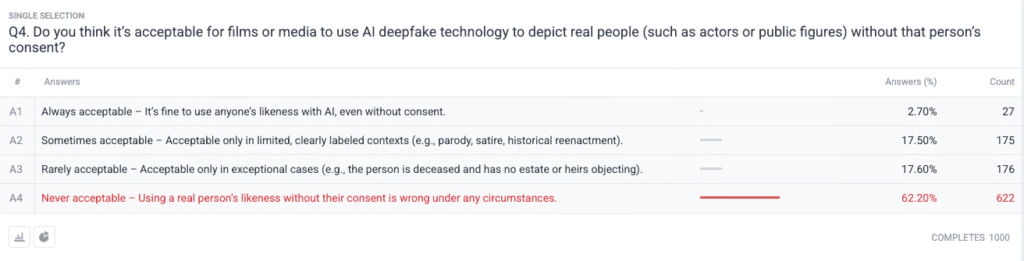

| Silná morální shoda ohledně souhlasu. | 62.2 % říká, že použití podobizny skutečné osoby bez povolení je nikdy přijatelné; jen 2.7 % říká, že je to vždy přijatelné. |

Metodika

- Vzorek a terénní práce. Provedli jsme nábor 1 000 dospělých Američanů s využitím kvót podle věku, pohlaví a regionů v souladu s kritérii sčítání lidu v USA. Práce v terénu byla dokončena 18. června 2025.

- Návrh otázky. Pět uzavřených otázek zjišťovalo obavy z různých formátů deepfake, nedávné změny v důvěře, vnímané osobní riziko, etické názory na souhlas a předchozí použití detekčního softwaru.

- Rozsah chyby. ±3,1 procentního bodu na hladině spolehlivosti 95 %.

- Vážení. Poststratifikační vážení korigovalo drobné odchylky od národních demografických údajů.

Otázky

Otázka 1: Které formy podvodů s umělou inteligencí se obáváte nejvíce? (Vyberte všechny, které se vztahují)

Otázka č. 2: Snížila se kvůli nárůstu realistických deepfake obrázků a videí s umělou inteligencí pravděpodobnost, že budete důvěřovat zprávám a videím/fotografiím/článkům, které jste v posledních 12 měsících viděli na internetu?

Otázka 3: Obáváte se, že by někdo mohl pomocí technologie AI deepfake vytvořit falešné video nebo zvukový záznam vás nebo vaší rodiny (například aby se za vás vydával při podvodu nebo vás očernil)?

Otázka 4: Myslíte si, že je přijatelné, aby filmy nebo média používaly technologii deepfake s umělou inteligencí k zobrazování skutečných osob (například herců nebo veřejných činitelů) bez jejich souhlasu?

Analýza trendů

- Úzkost z videa předčí ostatní formáty

V minulosti bylo video důvěryhodným médiem, kterému lidé věřili, když ho viděli. Od doby, kdy video ztratilo status důvěryhodného média, dominují v americkém myšlení syntetické videoklipy. Lidé se obávají videa více než obrázků s desetibodovým rozdílem (73,5% oproti 63,6%), protože pohyb videa v kombinaci se synchronizovaným hlasem a realistickým vzhledem jejich obavy zesiluje. Mediální organizace by měly zavést přísné postupy ověřování pravosti videoobsahu před jeho zveřejněním.

- Narušení důvěry v informace

Masivní 85% pokles důvěryhodnosti mezi veřejností ukazuje na rozšířené pochybnosti o každém typu digitálního obsahu bez ohledu na jeho zjevnou nedůvěryhodnost. Teorie "laciné řeči" ukazuje, jak snadno se díky falšování stalo ověřování pravdy odpovědností spotřebitele. Veřejné osobnosti a novináři spolu s tvůrci politik se musí připravit na zvýšené monitorování tím, že budou investovat do jasných metod ověřování (jako jsou kryptografické vodoznaky a podepsaná metadata).

Už nikdy se nemusíte obávat, že umělá inteligence rozpozná vaše texty. Undetectable AI Může vám pomoci:

- Zpřístupněte psaní s asistencí umělé inteligence podobný člověku.

- Bypass všechny hlavní nástroje pro detekci umělé inteligence jediným kliknutím.

- Použijte AI bezpečně a sebevědomě ve škole a v práci.

- Deepfakes se stávají osobními

Většina respondentů (85%) si dokáže představit, že by se oni sami nebo jejich rodinní příslušníci stali obětí deepfake útoků. Vnímání deepfakes jako nástrojů politické dezinformace zaměřené na volby a celebrity se v posledních cyklech posunulo k osobním hrozbám. Rozšíření aplikací pro klonování hlasu a výměnu tváře pomocí umělé inteligence učinilo z krádeží identity a finančních podvodů věrohodné hrozby pro běžné domácnosti, což vyvolalo požadavky na zlepšení mechanismů pro odvolání obětí a zákonů na ochranu identity.

- Téměř všeobecná poptávka po souhlasu

Etická otázka průzkumu ukazuje, jak je hollywoodská komunita stále rozdělená, pokud jde o syntetické herce a posmrtná vystoupení. Jako "nikdy nepřijatelná" volba se ukázal silný postoj veřejnosti proti porušování individuálních práv, který získal podporu 62,2 % účastníků. Veřejní činitelé by měli využít těchto důkazů k vytvoření zákonů, které vyžadují výslovný souhlas jednotlivců před vytvořením podobizen generovaných umělou inteligencí a zajišťují řádné zveřejnění označení.

- Rozdíl v připravenosti a příležitosti ke vzdělávání

Přestože je tento problém velmi znepokojující, 89,5 % respondentů detekční nástroje nepoužilo. Trh vykazuje latentní potenciál, protože míra zájmu převyšuje současné možnosti využití, což naznačuje problémy s použitelností a informovaností a pochybnosti o účinnosti. Nedetekovatelná umělá inteligence musí spolu s dalšími hráči v oboru vytvořit jednoduché procesy nástupu a zároveň přidat detekční nástroje do spotřebitelských platforem a vyvinout vzdělávací programy, které vysvětlí technologii umělé inteligence veřejnosti.

Důsledky pro zúčastněné strany

| Zúčastněné strany | Praktický závěr |

|---|---|

| Zprávy a sociální platformy | Zavedení standardů ověřených médií (C2PA, W3C provenance) a zavedení odznaků "ověřeného původu", aby se obnovila důvěra publika. |

| Zábavní studia | Zavedení výslovných smluv o souhlasu s použitím syntetických podobizen a přijetí informací na obrazovce v případě použití umělé inteligence. |

| Regulátory | Prosadit zákony o právu na publicitu a označování deepfake, aby byly v souladu s očekáváním souhlasu veřejnosti. |

| Podniky a značky | Proaktivně sledujte, zda nedochází k manipulaci s obrázky značky, a vzdělávejte zaměstnance v oblasti rozpoznávání podezřelého obsahu. |

| Spotřebitelé | Vyhledejte renomované detekční nástroje a před šířením médií dodržujte digitální hygienu "pozastavit, ověřit, sdílet". |

Komentáře

Od účastníků průzkumu jsme získali další odpovědi týkající se používání nástrojů pro detekci falešných informací s umělou inteligencí, z nichž vyplynulo, že někteří je již používají a velká část osob uvedla, že o nich nevěděla, ale má zájem se o nich dozvědět více. Úplné údaje z průzkumu jsou k dispozici na vyžádání.

Tato zpráva je shrnutím našich úplných zjištění, která jsou k dispozici na vyžádání. Tento výzkum byl proveden ve spolupráci s TruthScan, řešení pro hloubkovou detekci padělků a ochranu proti podvodům.

Závěr

Obavy z hlubokých falzifikátů v roce 2025 jsou definovány výrazným paradoxem: stoupající znepokojení veřejnosti se kříží s minimálními ochrannými opatřeními.. Vzhledem k poklesu důvěryhodnosti čelí organizace naléhavému požadavku na ověřování, označování a autentizaci digitálního obsahu.

Spravedlivé použití

Neváhejte tyto informace použít v článku nebo příspěvku na blogu, pokud nám poskytnete odkaz a citaci. Pro přístup ke kompletnímu souboru dat z průzkumu nás neváhejte kontaktovat přímo.

Pro dotazy pro tisk nebo přístup k úplným křížovým tabulkám kontaktujte [email protected]. nebo [email protected]