Generative AI-værktøjer har udviklet deepfakes fra videnskabelig forskning til en stor offentlig bekymring. Folk viser frygt for syntetiske medier, samtidig med at de viser manglende evne til at opdage dem ifølge resultaterne af undersøgelsen fra juni 2025.

FBI siger, at AI-deepfake-teknologi muliggør kriminelle aktiviteter gennem tre hovedmetoder, som omfatter AI-genererede spam-beskeder og AI-skabte personaer på sociale medier og AI-kodede phishing-hjemmesider.

Målet med disse svindelnumre er at udnytte både virksomheder og individuelle forbrugere økonomisk. Kombinationen af deepfake-teknologi med AI resulterede i mere end $200 millioner i tab i løbet af 2025.

Størstedelen af amerikanerne (85%) har mistet deres tillid til onlineinformation i løbet af det seneste år på grund af deepfakes, og 81% frygter personlig skade fra falsk lyd- og videoindhold. Mere end 90% af brugerne undlader at bruge detektionsværktøjer. Dataene indikerer en stigende "tillidskløft", som kræver øjeblikkelig indgriben fra lovgivere, platformsoperatører og teknologer.

Vigtige resultater

| Indsigt | Understøttende data |

|---|---|

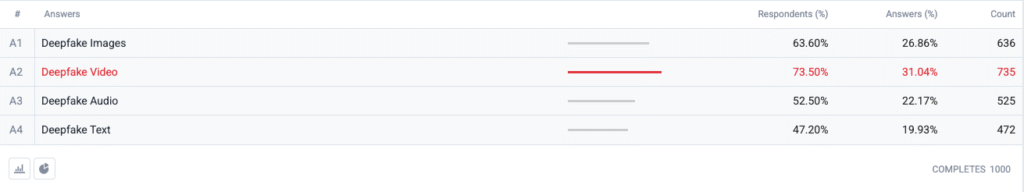

| Deepfake-videoen topper frygtindekset. | 73,5 % af respondenterne valgte deepfake-video som et format, de er "mest bekymrede for", efterfulgt af billeder (63,6 %), lyd (52,5 %) og tekst (47,2 %). |

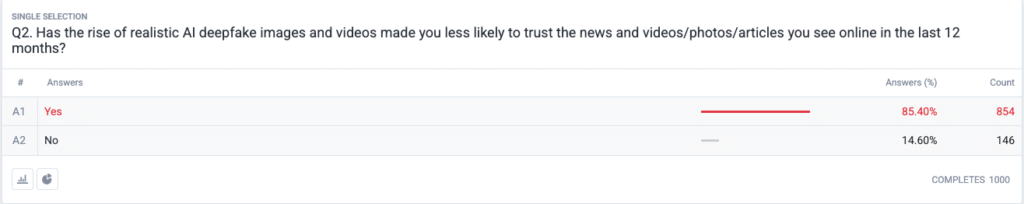

| En regulær tillidskrise er under opsejling. | 85,4 % rapporterer, at de er blevet mindre tilbøjelige til at stole på nyheder, fotos eller videoer online inden for de seneste 12 måneder på grund af realistiske deepfakes. |

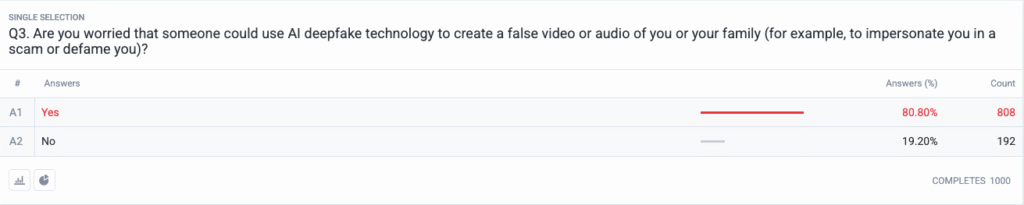

| Personlige trusler er blevet mainstream. | 80,8 % er bekymrede for, at svindlere eller dårlige aktører kan bruge deepfake-indhold som våben mod dem eller deres familie. |

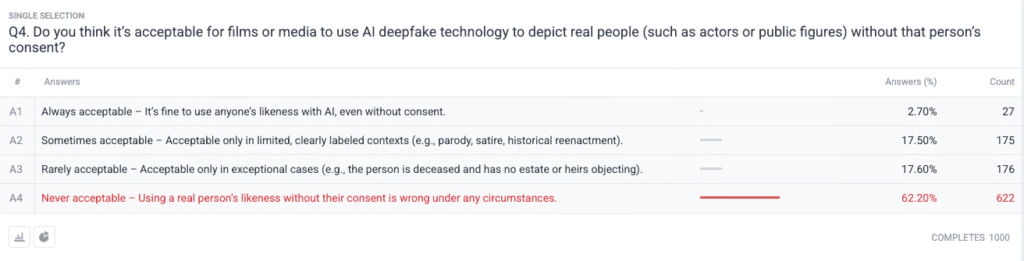

| Stærk moralsk konsensus om samtykke. | 62.2 % siger, at det at bruge en virkelig persons billede uden tilladelse er aldrig acceptabelt; kun 2,7 % siger, at det altid er acceptabelt. |

Metodologi

- Prøve og feltarbejde. Vi rekrutterede 1.000 voksne i USA ved hjælp af alders-, køns- og regionskvoter i overensstemmelse med U.S. Census-benchmarks. Feltarbejdet blev afsluttet den 18. juni 2025.

- Spørgsmålsdesign. Fem lukkede spørgsmål målte bekymring for forskellige deepfake-formater, nylige ændringer i tillid, opfattet personlig risiko, etiske synspunkter på samtykke og tidligere brug af detektionssoftware.

- Fejlmargen. ±3,1 procentpoint ved 95 % konfidensniveau.

- Vægtning. Vægtning efter stratificering korrigerede mindre afvigelser fra den nationale demografi.

Spørgsmål

Q1: Hvilken form for AI-deepfakes er du mest bekymret for? (Vælg alt, hvad der gælder)

Q2: Har stigningen i realistiske AI deepfake-billeder og -videoer gjort dig mindre tilbøjelig til at stole på de nyheder og videoer/fotos/artikler, du har set online i de seneste 12 måneder?

Q3: Er du bekymret for, at nogen kunne bruge AI deepfake-teknologi til at lave en falsk video eller lyd af dig eller din familie (f.eks. for at udgive sig for at være dig i et svindelnummer eller ærekrænke dig)?

Q4: Synes du, det er acceptabelt, at film eller medier bruger AI-deepfake-teknologi til at afbilde rigtige mennesker (f.eks. skuespillere eller offentlige personer) uden den pågældende persons samtykke?

Analyse af tendenser

- Videoangst overgår andre formater

Før i tiden var video et pålideligt medie, som folk troede på, når de så det. Syntetiske videobekymringer dominerer nu amerikanernes bevidsthed, da video har mistet sin troværdige status. Folk frygter video mere end billeder med en 10-punkts margin (73,5% vs. 63,6%), fordi videos bevægelse kombineret med synkroniseret stemme og realistisk udseende intensiverer deres bekymringer. Medieorganisationer bør implementere strenge godkendelsesprocedurer for videoindhold, før de frigiver det til offentligheden.

- Erosion af informationstillid

Det massive 85% fald i tillidsniveauet blandt befolkningen viser, at der er udbredt tvivl om alle typer digitalt indhold, uanset dets åbenlyse mangel på troværdighed. Teorien om "billig tale" viser, hvor let fabrikation har gjort, at verificering af sandheden er blevet forbrugerens ansvar. Offentlige personer og journalister skal sammen med beslutningstagere forberede sig på øget overvågning ved at investere i klare verifikationsmetoder (såsom kryptografiske vandmærker og signerede metadata).

Du skal aldrig bekymre dig om, at AI opdager dine tekster igen. Undetectable AI Kan hjælpe dig:

- Få din AI-assisterede skrivning til at fremstå Menneskelignende.

- Bypass alle større AI-detektionsværktøjer med bare ét klik.

- Brug AI sikkert og selvsikkert i skolen og på arbejdet.

- Deepfakes bliver personlige

Størstedelen af de adspurgte (85%) forestiller sig, at de selv eller deres familiemedlemmer bliver ofre for deepfake-angreb. Opfattelsen af deepfakes som valg- og kendisfokuserede politiske desinformationsværktøjer har ændret sig til at omfatte personlige trusler i de seneste cyklusser. Spredningen af AI-stemmekloning og face-swap-apps har gjort identitetstyveri og økonomisk svindel til plausible trusler for almindelige husholdninger, hvilket har udløst krav om forbedrede regresmekanismer for ofre og love om identitetsbeskyttelse.

- Næsten universelt krav om samtykke

Undersøgelsens etiske spørgsmål afslører, hvordan Hollywood-samfundet stadig er splittet i forhold til syntetiske skuespillere og posthume optrædener. Den stærke offentlige holdning mod krænkelse af individuelle rettigheder viste sig at være det "aldrig acceptable" valg, som fik støtte fra 62,2 procent af deltagerne. Offentlige embedsmænd bør bruge dette bevis til at skabe love, der kræver udtrykkeligt samtykke fra enkeltpersoner, før de skaber AI-genererede repræsentationer og sikrer korrekt mærkning.

- Parathedskløft og uddannelsesmuligheder

Selv om der er stor bekymring over problemet, har 89,5 procent af respondenterne ikke brugt detektionsværktøjer. Markedet har et latent potentiale, da interessen overstiger den nuværende brugskapacitet, hvilket indikerer problemer med brugervenlighed og bevidsthed samt tvivl om effektiviteten. Undetectable AI skal sammen med andre brancheaktører skabe enkle onboarding-processer, mens de tilføjer detektionsværktøjer til forbrugerplatforme og udvikler uddannelsesprogrammer, der forklarer AI-teknologi for offentligheden.

Konsekvenser for interessenter

| Interessent | Brugbar takeaway |

|---|---|

| Nyheder og sociale platforme | Implementer standarder for autentificerede medier (C2PA, W3C-proveniens) og fremhæv "origin verified"-badges for at genopbygge publikums tillid. |

| Underholdningsstudier | Indfør eksplicitte opt-in-kontrakter for syntetiske billeder, og indfør oplysninger på skærmen, når der bruges AI-rekreation. |

| Regulatorer | Fremskynde lovforslag om ret til offentlighed og deepfake-mærkning, så de stemmer overens med forventningerne til offentlighedens samtykke. |

| Virksomheder og brands | Overvåg proaktivt brandbilleder for manipulationer, og uddan medarbejderne i at spotte mistænkeligt indhold. |

| Forbrugere | Find velrenommerede detektionsværktøjer og praktiser "pause, verificer, del" digital hygiejne, før du forstærker medier. |

Kommentarer

Vi indsamlede yderligere svar fra deltagerne i undersøgelsen om deres brug af AI-værktøjer til detektering af dyb falskhed, hvilket afslørede, at nogle allerede bruger dem, og en stor del af personerne siger, at de ikke kendte til dem, men er interesserede i at lære mere. De fulde undersøgelsesdata er tilgængelige efter anmodning.

Denne rapport er et AI-sammendrag af vores fulde resultater, som er tilgængelige efter anmodning. Denne forskning blev udført i samarbejde med TruthScanen løsning til deepfake-detektion og anti-ai-svindel.

Konklusion

Deepfake-problemer i 2025 er defineret af et stærkt paradoks: Skyhøj offentlig alarm krydser med minimal beskyttelsesindsats. Da tilliden er i bund, står organisationer over for et presserende mandat til at verificere, mærke og autentificere digitalt indhold.

Fair brug

Du er velkommen til at bruge disse oplysninger i en artikel eller et blogindlæg, så længe du giver os et link og en henvisning. Hvis du vil have adgang til hele undersøgelsens datasæt, er du velkommen til at kontakte os direkte.

For pressehenvendelser eller adgang til fulde krydstabeller, kontakt [email protected] eller [email protected]