A generatív mesterséges intelligencia eszközök a tudományos kutatásból a közvélemény számára komoly aggodalomra okot adóvá tették a mélyhamisításokat. A 2025 júniusi felmérés eredményei szerint az emberek félelmet mutatnak a szintetikus médiával szemben, ugyanakkor képtelenek felismerni azt.

Az FBI szerint az AI deepfake technológia három fő módszerrel teszi lehetővé a bűncselekményeket, amelyek közé tartoznak az AI által generált spam üzenetek, az AI által létrehozott közösségi média személyiségek és az AI által kódolt adathalász weboldalak.

E rendszerek célja mind az üzleti szervezetek, mind az egyéni fogyasztók pénzügyi kizsákmányolása. A deepfake technológia és a mesterséges intelligencia kombinációja több mint $200 millió veszteség 2025-ben.

Az amerikaiak többsége (85%) az elmúlt év során a deepfakes miatt elvesztette bizalmát az online információkban, és 81% személyes károktól tart a hamisított hang- és videotartalmak miatt. A felhasználók több mint 90%-je nem használja a felismerő eszközöket. Az adatok növekvő "bizalmi szakadékot" jeleznek, amely azonnali beavatkozást igényel a szabályozó hatóságok, valamint a platformok üzemeltetői és technológusai részéről.

Főbb megállapítások

| Betekintés | Támogató adatok |

|---|---|

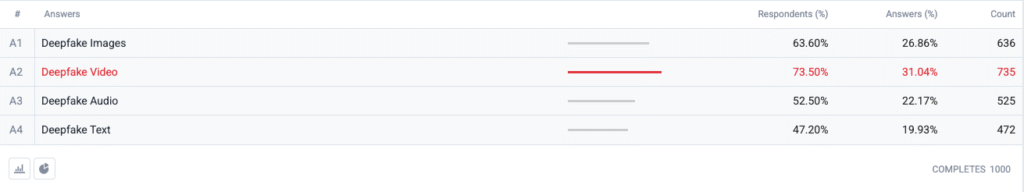

| A Deepfake videó vezeti a félelemindexet. | A válaszadók 73,5 %-je választotta a deepfake videót, mint olyan formátumot, amely miatt "a leginkább aggódik", ezt követik a képek (63,6 %), a hang (52,5 %) és a szöveg (47,2 %). |

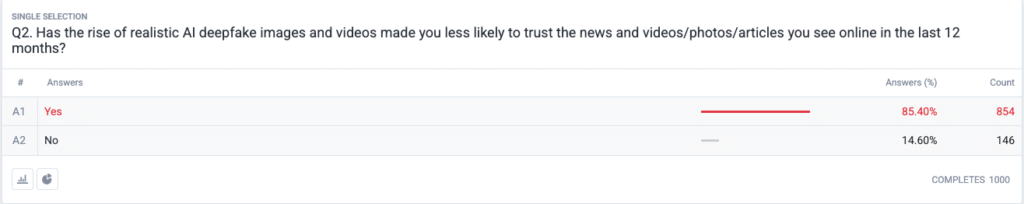

| Teljes körű bizalmi válság van kibontakozóban. | 85,4 % jelentette, hogy az elmúlt 12 hónapban a reális mélyhamisítások miatt kevésbé bízik az online hírekben, fotókban vagy videókban. |

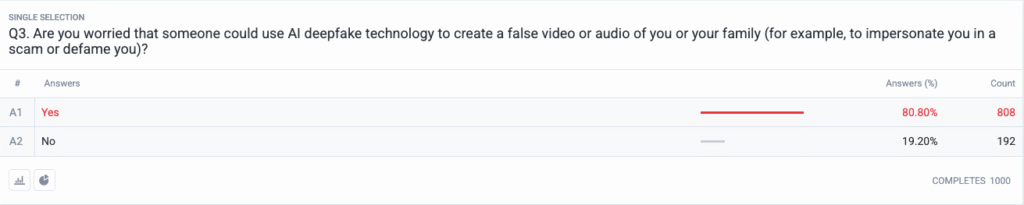

| A személyes fenyegetés főáramba került. | 80,8 % aggódnak amiatt, hogy csalók vagy rossz szereplők fegyverként használhatják fel a hamisított tartalmakat ellenük vagy családjuk ellen. |

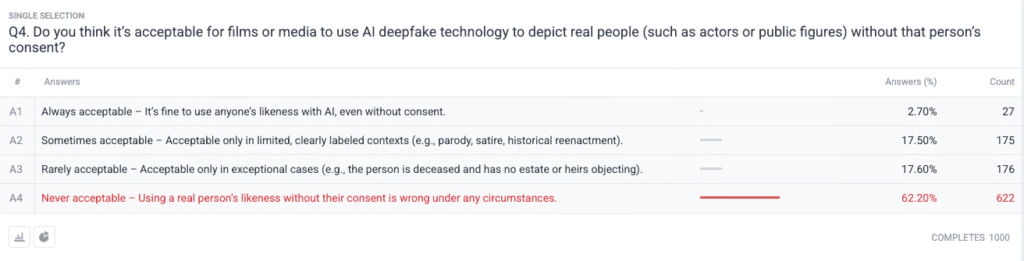

| Erős erkölcsi konszenzus a beleegyezésről. | 62.2 % szerint egy valós személy képmásának engedély nélküli felhasználása soha elfogadható; csak 2.7 % azt mondják, hogy mindig elfogadható. |

Módszertan

- Minta és terepmunka. Toboroztunk 1000 amerikai felnőtt az amerikai népszámlálási referenciaértékekhez igazodó életkori, nemi és regionális kvóták alkalmazásával. A terepmunka a következő napokon fejeződött be 2025. június 18..

- Kérdések kialakítása. Öt zárt végű kérdés mérte a különböző deepfake formátumokkal kapcsolatos aggodalmakat, a bizalomban bekövetkezett közelmúltbeli változásokat, az észlelt személyes kockázatot, a beleegyezéssel kapcsolatos etikai nézeteket és a felderítő szoftverek korábbi használatát.

- Hibahatár. ±3,1 százalékpont a 95 % megbízhatósági szinten.

- Súlyozás. A rétegzés utáni súlyozás korrigálta a nemzeti demográfiai adatoktól való kisebb eltéréseket.

Kérdések

1. kérdés: Az AI Deepfakes melyik formája miatt aggódik a legjobban? (Válassza ki az összeset)

2. kérdés: A reális mesterséges intelligenciával készült hamisított képek és videók térhódítása miatt kevésbé bízik az elmúlt 12 hónapban online látott hírekben, videókban, fotókban és cikkekben?

3. kérdés: Aggódik-e amiatt, hogy valaki a mesterséges intelligencia deepfake technológiáját arra használhatja, hogy hamis videót vagy hangfelvételt készítsen Önről vagy családjáról (például, hogy Önt átverje vagy rágalmazza)?

4. kérdés: Ön szerint elfogadható, hogy a filmek vagy a média az AI deepfake technológiát valós személyek (például színészek vagy közszereplők) ábrázolására használja az adott személy beleegyezése nélkül?

Trendelemzés

- A videó szorongás megelőzi a többi formátumot

A múltban a videó olyan megbízható médium volt, amelyet az emberek elhittek, amikor meglátták. A szintetikus videókkal kapcsolatos aggodalmak ma már uralják az amerikai elméket, mivel a videó elvesztette megbízható státuszát. Az emberek 10 százalékpontos különbséggel jobban félnek a videótól, mint a képtől (73,5% vs. 63,6%), mivel a videó mozgása a szinkronizált hanggal és a valósághű megjelenéssel kombinálva felerősíti az aggodalmakat. A médiaszervezeteknek szigorú hitelesítési eljárásokat kellene bevezetniük a videotartalmakra, mielőtt nyilvánosságra hoznák azokat.

- Az információs bizalom eróziója

A lakosság bizalmi szintjének 85% masszív csökkenése azt mutatja, hogy a digitális tartalmak minden típusával szemben széles körben kétségek merülnek fel, függetlenül azok nyilvánvaló hiteltelenségétől. Az "olcsó beszéd" elmélete azt mutatja, hogy a hamisítás mennyire egyszerűvé tette a fogyasztók felelősségévé az igazság ellenőrzését. A közszereplőknek és az újságíróknak, valamint a politikai döntéshozóknak fel kell készülniük a fokozott ellenőrzésre azáltal, hogy egyértelmű ellenőrzési módszerekbe (például kriptográfiai vízjelekbe és aláírt metaadatokba) fektetnek be.

Soha többé ne aggódj amiatt, hogy a mesterséges intelligencia felismeri a szövegeidet. Undetectable AI Segíthet:

- Tegye láthatóvá az AI-asszisztált írást ember-szerű.

- Bypass az összes főbb AI-érzékelő eszköz egyetlen kattintással.

- Használja a címet. AI biztonságosan és magabiztosan az iskolában és a munkahelyen.

- A Deepfakes személyessé válik

A válaszadók többsége (85%) elképzelhetőnek tartja, hogy ők maguk vagy családtagjaik deepfake támadások áldozatai lesznek. A deepfake-ek választási és hírességekre összpontosító politikai dezinformációs eszközként való megítélése az utóbbi ciklusokban a személyes fenyegetések felé tolódott el. A mesterséges intelligenciával működő hangklónozó és arccserélő alkalmazások elterjedése a személyazonosság-lopást és a pénzügyi csalásokat a hétköznapi háztartások számára is hihető fenyegetéssé tette, ami az áldozatvédelmi mechanizmusok és a személyazonosság-védelmi törvények javítására irányuló igényeket váltott ki.

- Szinte általános igény a beleegyezésre

A felmérés etikai kérdéséből kiderül, hogy a hollywoodi közösség továbbra is megosztott a szintetikus színészekkel és a posztumusz előadásokkal kapcsolatban. Az egyéni jogok megsértése elleni határozott közvéleményi állásfoglalás a "soha nem elfogadható" választásként jelent meg, amely a résztvevők 62,2 százalékának támogatását kapta. A közhivatalnokoknak ezt a bizonyítékot arra kellene felhasználniuk, hogy olyan törvényeket alkossanak, amelyek az egyének kifejezett beleegyezését követelik meg a mesterséges intelligenciával létrehozott hasonmás-ábrázolások létrehozása előtt, és biztosítják a megfelelő címkézés nyilvánosságra hozatalát.

- Felkészültségi szakadék és oktatási lehetőség

Annak ellenére, hogy a kérdés mély aggodalomra ad okot, a válaszadók 89,5 százaléka nem használt felderítő eszközöket. A piac látens potenciált mutat, mivel az érdeklődés meghaladja a jelenlegi felhasználási lehetőségeket, ami a használhatóság és a tudatosság problémáira, valamint a hatékonysággal kapcsolatos kételyekre utal. A felderíthetetlen AI-nak a többi iparági szereplővel együtt egyszerű belépési folyamatokat kell létrehoznia, miközben a fogyasztói platformokhoz észlelési eszközöket kell hozzáadni, és olyan oktatási programokat kell kidolgoznia, amelyek elmagyarázzák a nyilvánosságnak a mesterséges intelligencia technológiát.

Következmények az érdekeltek számára

| Érdekelt felek | Megvalósítható tanulságok |

|---|---|

| Hírek és közösségi platformok | A hitelesített médiaszabványok (C2PA, W3C provenance) és a "származási hely ellenőrzött" jelvények alkalmazása a közönség bizalmának helyreállítása érdekében. |

| Szórakoztató stúdiók | Kifejezett opt-in szerződéseket kell kötni a szintetikus képmásokról, és a mesterséges intelligenciával történő rekonstrukció esetén a képernyőn történő közzétételt kell elfogadni. |

| Szabályozók | A nyilvánossághoz való jog és a hamisítványok címkézéséről szóló törvényjavaslatok előmozdítása a nyilvános hozzájárulással kapcsolatos elvárásokhoz való igazodás érdekében. |

| Vállalkozások és márkák | Figyelje proaktívan a márkaképek manipulációit, és oktassa az alkalmazottakat a gyanús tartalmak kiszűrésére. |

| Fogyasztók | Keressen jó hírű felderítő eszközöket, és gyakorolja a "szünet, ellenőrzés, megosztás" digitális higiéniát a média felerősítése előtt. |

Megjegyzések

A felmérés résztvevőitől további válaszokat gyűjtöttünk a mesterséges intelligencia mély hamisítványok felderítésére szolgáló eszközök használatával kapcsolatban, amelyekből kiderült, hogy néhányan már használják őket, és az egyének nagy része azt állítja, hogy nem ismeri őket, de érdeklődik a további ismeretek iránt. A teljes felmérés adatai kérésre rendelkezésre állnak.

Ez a jelentés az AI összefoglalója a teljes megállapításainknak, amelyek kérésre rendelkezésre állnak. A kutatást a következőkkel együttműködve végeztük TruthScan, egy deepfake felismerő és anti-ai csalás megoldás.

Következtetés

A 2025-ös mélyhamisítással kapcsolatos aggodalmakat egy erős paradoxon határozza meg: a közvélemény riadalmának növekedése és a minimális védelmi intézkedések keresztezése. Mivel a bizalom alapvetően csökken, a szervezeteknek sürgősen ellenőrizniük, címkézniük és hitelesíteniük kell a digitális tartalmakat.

Tisztességes használat

Kérjük, nyugodtan használja fel ezt az információt egy cikkben vagy blogbejegyzésben, amennyiben megadja nekünk a linket és a hivatkozást. A teljes felmérési adatsorhoz való hozzáférésért ne habozzon közvetlenül kapcsolatba lépni velünk.

Sajtóértesülésekért vagy a teljes keresztmetszethez való hozzáférésért forduljon a [email protected] címre. vagy [email protected]