Gli strumenti di IA generativa hanno fatto evolvere i deepfakes dalla ricerca scientifica a una grande preoccupazione pubblica. Secondo i risultati del sondaggio di giugno 2025, le persone mostrano paura nei confronti dei media sintetici e allo stesso tempo dimostrano incapacità di individuarli.

L'FBI afferma che la tecnologia AI deepfake consente di svolgere attività criminali attraverso tre metodi principali, tra cui messaggi di spam generati dall'AI, personaggi dei social media creati dall'AI e siti web di phishing codificati dall'AI.

L'obiettivo di questi schemi è quello di sfruttare finanziariamente sia le organizzazioni commerciali sia i singoli consumatori. La combinazione della tecnologia deepfake con l'intelligenza artificiale ha portato a più di $200 milioni di perdite nel corso del 2025.

La maggioranza degli americani (85%) ha perso la fiducia nelle informazioni online nel corso dell'ultimo anno a causa dei deepfakes e 81% teme di subire danni personali da contenuti audio e video falsi. Oltre 90% di utenti non utilizzano strumenti di rilevamento. I dati indicano un crescente "gap di fiducia" che richiede un intervento immediato da parte delle autorità di regolamentazione e degli operatori e tecnologi delle piattaforme.

Risultati principali

| Approfondimento | Dati di supporto |

|---|---|

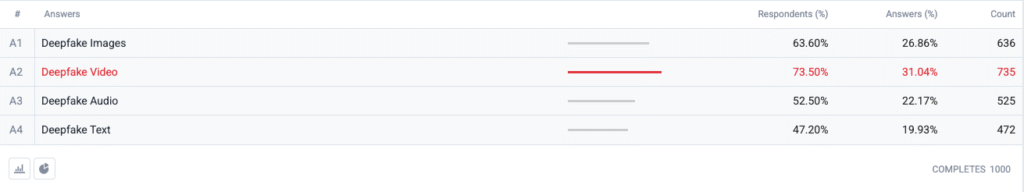

| Il video Deepfake è in cima all'indice di paura. | Il 73,5 % degli intervistati ha scelto i video deepfake come formato di cui è "più preoccupato", seguito da immagini (63,6 %), audio (52,5 %) e testo (47,2 %). |

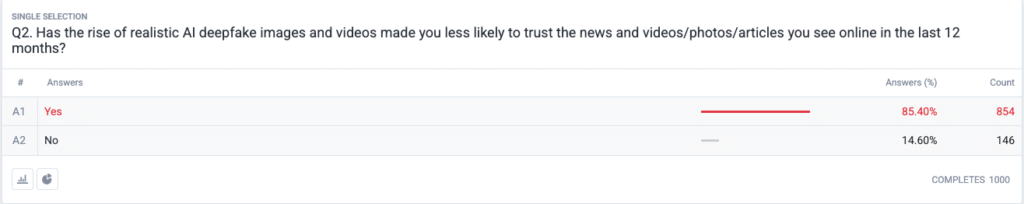

| È in atto una vera e propria crisi di fiducia. | L'85,4 % riferisce di aver diminuito la probabilità di fidarsi di notizie, foto o video online negli ultimi 12 mesi a causa di deepfake realistici. |

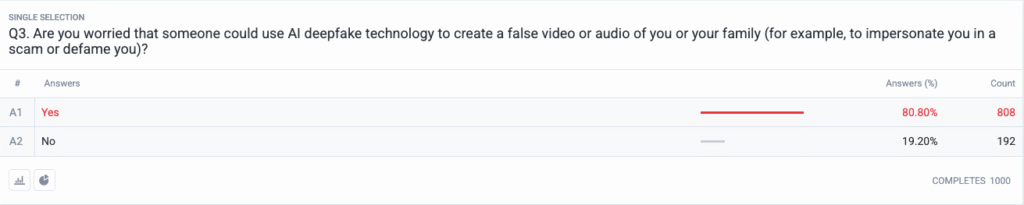

| La minaccia personale è diventata mainstream. | 80,8 % temono che truffatori o malintenzionati possano usare come arma i contenuti deepfake contro di loro o la loro famiglia. |

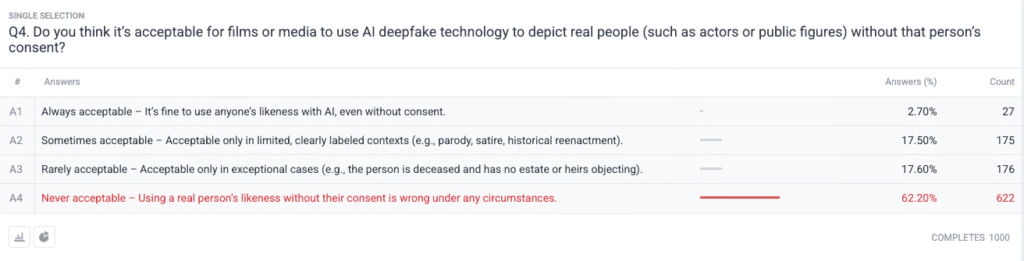

| Forte consenso morale sul consenso. | 62,2 % dicono che usare le sembianze di una persona reale senza autorizzazione è mai accettabile; solo 2.7 % dicono che è sempre accettabile. |

Metodologia

- Campione e lavoro sul campo. Abbiamo reclutato 1.000 adulti statunitensi utilizzando quote di età, genere e regione allineate ai parametri del censimento degli Stati Uniti. Il lavoro sul campo è stato completato su 18 giugno 2025.

- Domanda Design. Cinque domande a risposta chiusa hanno misurato la preoccupazione per i diversi formati di deepfake, i recenti cambiamenti nella fiducia, il rischio personale percepito, le opinioni etiche sul consenso e l'uso precedente del software di rilevamento.

- Margine di errore. ±3,1 punti percentuali al livello di confidenza del 95 %.

- Ponderazione. La ponderazione post-stratificazione ha corretto le piccole deviazioni dai dati demografici nazionali.

Domande

D1: Quale forma di AI Deepfakes vi preoccupa di più? (Scegliere tutto ciò che si applica)

D2: L'aumento delle immagini e dei video deepfake realistici dell'intelligenza artificiale vi ha reso meno propensi a fidarvi delle notizie e dei video/foto/articoli che avete visto online negli ultimi 12 mesi?

D3: Siete preoccupati che qualcuno possa utilizzare la tecnologia AI deepfake per creare un video o un audio falso di voi o della vostra famiglia (ad esempio, per impersonarvi in una truffa o diffamarvi)?

D4: Ritenete accettabile che i film o i media utilizzino la tecnologia AI deepfake per rappresentare persone reali (come attori o personaggi pubblici) senza il loro consenso?

Analisi delle tendenze

- L'ansia da video supera quella di altri formati

In passato il video era un mezzo di comunicazione affidabile, a cui si credeva quando lo si vedeva. Le preoccupazioni per i video sintetici dominano ora le menti degli americani, da quando il video ha perso il suo status di affidabilità. Le persone temono i video più delle immagini con un margine di 10 punti (73,5% vs 63,6%) perché il movimento del video combinato con la voce sincronizzata e l'aspetto realistico intensifica le loro preoccupazioni. Le organizzazioni dei media dovrebbero implementare procedure di autenticazione rigorose per i contenuti video prima di rilasciarli al pubblico.

- Erosione della fiducia nelle informazioni

Il massiccio calo dei livelli di fiducia del pubblico dimostra un dubbio diffuso su ogni tipo di contenuto digitale, indipendentemente dalla sua evidente mancanza di credibilità. La teoria del "discorso a buon mercato" dimostra come la facilità di fabbricazione abbia reso la verifica della verità una responsabilità del consumatore. I personaggi pubblici e i giornalisti, così come i politici, devono prepararsi a un maggiore monitoraggio investendo in metodi di verifica chiari (come filigrane crittografiche e metadati firmati).

Non preoccupatevi più che l'intelligenza artificiale rilevi i vostri messaggi. Undetectable AI Può aiutarvi:

- Fate apparire la vostra scrittura assistita dall'intelligenza artificiale simile all'uomo.

- Bypass tutti i principali strumenti di rilevamento dell'intelligenza artificiale con un solo clic.

- Utilizzo AI in modo sicuro e con fiducia a scuola e al lavoro.

- I deepfake diventano personali

La maggioranza degli intervistati (85%) immagina che se stessi o i propri familiari saranno vittime di attacchi deepfake. La percezione dei deepfake come strumenti di disinformazione politica incentrati sulle elezioni e sulle celebrità si è spostata negli ultimi cicli verso le minacce personali. La diffusione di applicazioni per la clonazione vocale e lo scambio di volti ha reso il furto d'identità e le truffe finanziarie una minaccia plausibile per le famiglie comuni e ha innescato la richiesta di migliorare i meccanismi di ricorso alle vittime e le leggi sulla protezione dell'identità.

- Richiesta quasi universale di consenso

La domanda etica del sondaggio rivela come la comunità hollywoodiana sia ancora divisa riguardo agli attori sintetici e alle performance postume. La forte posizione pubblica contro la violazione dei diritti individuali è emersa come la scelta "mai accettabile" che ha ricevuto il sostegno del 62,2% dei partecipanti. I funzionari pubblici dovrebbero utilizzare questa evidenza per creare leggi che richiedano il consenso esplicito degli individui prima di creare rappresentazioni di sembianze generate dall'IA e garantire una corretta divulgazione delle etichette.

- Divario di preparazione e opportunità di istruzione

Nonostante la forte preoccupazione per il problema, l'89,5% degli intervistati non ha utilizzato strumenti di rilevamento. Il mercato mostra un potenziale latente, poiché i livelli di interesse superano le attuali capacità di utilizzo, il che indica problemi di usabilità e consapevolezza e dubbi sull'efficacia. Undetectable AI, insieme ad altri operatori del settore, deve creare semplici processi di onboarding, aggiungendo strumenti di rilevamento alle piattaforme dei consumatori e sviluppando programmi educativi che spieghino la tecnologia AI al pubblico.

Implicazioni per le parti interessate

| Soggetto interessato | Un risultato utile per l'azione |

|---|---|

| Notizie e piattaforme sociali | Implementare gli standard per i media autenticati (C2PA, W3C provenance) e introdurre badge di "origine verificata" per ricostruire la fiducia del pubblico. |

| Studi di intrattenimento | Istituire contratti espliciti di opt-in per le sembianze sintetiche e adottare informazioni sullo schermo quando viene utilizzata la ricreazione dell'intelligenza artificiale. |

| Regolatori | Avanzare le proposte di legge sul diritto di pubblicità e sull'etichettatura deepfake per allinearle alle aspettative di consenso pubblico. |

| Aziende e marchi | Monitorare in modo proattivo le immagini del marchio per individuare eventuali manipolazioni e istruire i dipendenti sull'individuazione di contenuti sospetti. |

| Consumatori | Cercate strumenti di rilevamento affidabili e praticate l'igiene digitale "pausa, verifica, condivisione" prima di amplificare i media. |

Commenti

Abbiamo raccolto ulteriori risposte dai partecipanti al sondaggio in merito al loro utilizzo di strumenti di rilevamento di fake AI, che hanno rivelato che alcuni li stanno già utilizzando e che un'ampia porzione di individui dichiara di non conoscerli ma di essere interessata a saperne di più. I dati completi del sondaggio sono disponibili su richiesta.

Il presente rapporto è una sintesi dei risultati completi, disponibili su richiesta. Questa ricerca è stata condotta in collaborazione con TruthScan, una soluzione di rilevamento deepfake e anti-frode.

Conclusione

Le preoccupazioni per i deepfake nel 2025 sono definite da un forte paradosso: l'aumento dell'allarme pubblico che si interseca con un'azione protettiva minima. Con il declino della fiducia, le organizzazioni si trovano ad affrontare un mandato urgente per verificare, etichettare e autenticare i contenuti digitali.

Uso corretto

Sentitevi liberi di utilizzare queste informazioni in un articolo o in un post del blog, purché ci forniate un link e una citazione. Per accedere alla serie completa di dati dell'indagine, non esitate a contattarci direttamente.

Per richieste di informazioni alla stampa o per accedere alle tabelle incrociate complete, contattare [email protected] o [email protected]