Generative AI-verktøy har utviklet deepfakes fra å være vitenskapelig forskning til å bli en stor offentlig bekymring. Folk viser frykt for syntetiske medier, samtidig som de viser manglende evne til å oppdage dem, ifølge resultatene av undersøkelsen fra juni 2025.

FBI opplyser at AI deepfake-teknologi muliggjør kriminelle aktiviteter gjennom tre hovedmetoder, blant annet AI-genererte spam-meldinger, AI-skapte personas i sosiale medier og AI-kodede phishing-nettsteder.

Målet med disse svindelforsøkene er å utnytte både bedrifter og privatpersoner økonomisk. Kombinasjonen av deepfake-teknologi og kunstig intelligens resulterte i mer enn $200 millioner i tap i løpet av 2025.

Flertallet av amerikanerne (85%) har mistet tilliten til informasjon på nettet i løpet av det siste året på grunn av deepfakes, og 81% frykter personlig skade fra falskt lyd- og videoinnhold. Mer enn 90% av brukerne unnlater å bruke deteksjonsverktøy. Dataene indikerer et økende "tillitsgap" som krever umiddelbar inngripen fra myndigheter, plattformoperatører og teknologer.

Viktige funn

| Innsikt | Understøttende data |

|---|---|

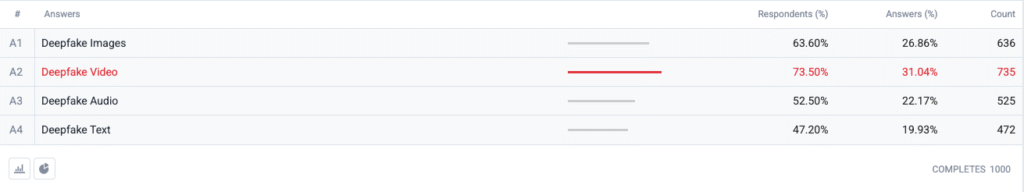

| Deepfake-videoen topper fryktindeksen. | 73,5 % av respondentene valgte deepfake-video som et format de er "mest bekymret for", etterfulgt av bilder (63,6 %), lyd (52,5 %) og tekst (47,2 %). |

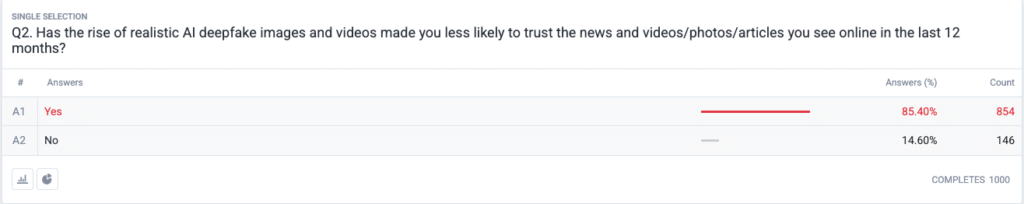

| En fullverdig tillitskrise er under oppseiling. | 85,4 % oppgir at de har blitt mindre tilbøyelige til å stole på nyheter, bilder eller videoer på nettet i løpet av de siste 12 månedene på grunn av realistiske deepfakes. |

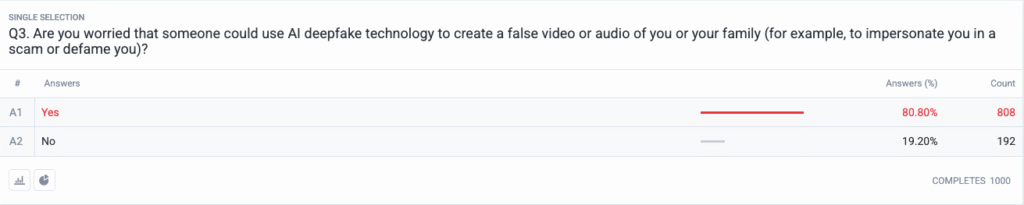

| Personlige trusler har blitt mainstream. | 80,8 % er bekymret for at svindlere eller ondsinnede aktører kan bruke deepfake-innhold som våpen mot dem eller familien deres. |

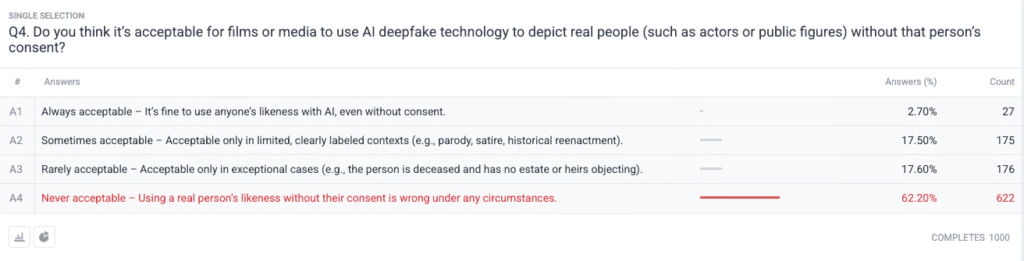

| Sterk moralsk konsensus om samtykke. | 62.2 % sier at det å bruke en ekte persons bilde uten tillatelse er aldri akseptabelt; bare 2,7 % sier at det alltid er akseptabelt. |

Metodikk

- Utvalg og feltarbeid. Vi rekrutterte 1 000 voksne amerikanere ved hjelp av alders-, kjønns- og regionkvoter i tråd med amerikanske folketellingsreferanser. Feltarbeidet ble fullført på 18. juni 2025.

- Spørsmålsutforming. Fem lukkede spørsmål målte bekymring for ulike deepfake-formater, nylige endringer i tillit, opplevd personlig risiko, etisk syn på samtykke og tidligere bruk av deteksjonsprogramvare.

- Feilmargin. ±3,1 prosentpoeng ved 95 % konfidensnivå.

- Vekting. Vekting etter stratifisering korrigerte mindre avvik fra nasjonal demografi.

Spørsmål

Spm. 1: Hvilken form for AI Deepfakes er du mest bekymret for? (Velg alle som gjelder)

Spm. 2: Har fremveksten av realistiske AI deepfake-bilder og -videoer gjort deg mindre tilbøyelig til å stole på nyheter og videoer/bilder/artikler du har sett på nettet i løpet av de siste 12 månedene?

Spm. 3: Er du bekymret for at noen kan bruke AI deepfake-teknologi til å lage en falsk video eller lyd av deg eller familien din (for eksempel for å utgi seg for å være deg i et svindelforsøk eller sverte deg)?

Spm. 4: Mener du at det er akseptabelt at filmer eller medier bruker AI deepfake-teknologi til å avbilde virkelige personer (for eksempel skuespillere eller offentlige personer) uten deres samtykke?

Trendanalyse

- Videoangst overgår andre formater

Tidligere var video et medium som folk trodde på når de så det. Nå er det bekymringer for syntetisk video som dominerer amerikanernes bevissthet, siden video har mistet sin status som et medium man kan stole på. Folk frykter video mer enn bilder, med en margin på 10 prosentpoeng (73,5% mot 63,6%), fordi videoens bevegelser kombinert med synkronisert stemme og realistisk utseende forsterker bekymringene deres. Medieorganisasjoner bør innføre strenge autentiseringsprosedyrer for videoinnhold før de slipper det ut til publikum.

- Svekket tillit til informasjon

Det massive 85% fallet i tillitsnivået i befolkningen viser at det er utbredt tvil om alle typer digitalt innhold, uavhengig av dets åpenbare mangel på troverdighet. Teorien om "billig tale" viser hvor lett fabrikkering har gjort det å verifisere sannheten til forbrukerens ansvar. Offentlige personer, journalister og beslutningstakere må forberede seg på økt overvåking ved å investere i tydelige verifiseringsmetoder (for eksempel kryptografiske vannmerker og signerte metadata).

Aldri bekymre deg for at AI oppdager tekstene dine igjen. Undetectable AI Kan hjelpe deg:

- Få AI-assistert skriving til å vises ...menneskelignende.

- Bypass alle de viktigste AI-deteksjonsverktøyene med bare ett klikk.

- Bruk AI trygt og selvsikkert i skole og arbeid.

- Deepfakes blir personlige

Flertallet av respondentene (85%) ser for seg at de selv eller deres familiemedlemmer kan bli ofre for deepfake-angrep. Oppfatningen av deepfakes som valg- og kjendisfokuserte politiske desinformasjonsverktøy har endret seg til å omfatte personlige trusler i de siste syklusene. Spredningen av AI-stemmekloning og ansiktsbytte-apper har gjort identitetstyveri og økonomisk svindel til plausible trusler for vanlige husholdninger, noe som har utløst krav om bedre regressmekanismer for ofre og identitetsbeskyttelseslover.

- Nesten universelt krav om samtykke

Undersøkelsens etiske spørsmål avslører hvordan Hollywood-miljøet fortsatt er delt i synet på syntetiske skuespillere og posthume opptredener. Den sterke offentlige holdningen mot krenkelse av individuelle rettigheter kom ut som det "aldri akseptable" valget, som fikk støtte fra 62,2 prosent av deltakerne. Offentlige myndigheter bør bruke dette beviset til å lage lover som krever eksplisitt samtykke fra enkeltpersoner før det skapes AI-genererte avbildninger, og som sikrer korrekt merking og offentliggjøring.

- Gap i beredskap og utdanningsmuligheter

Selv om det er stor bekymring for problemet, har 89,5 prosent av respondentene ikke brukt deteksjonsverktøy. Markedet har et latent potensial, siden interessen er større enn den nåværende bruken, noe som tyder på problemer med brukervennlighet og bevissthet og tvil om effektiviteten. Sammen med andre aktører i bransjen må Undetectable AI skape enkle innføringsprosesser, legge til deteksjonsverktøy på forbrukerplattformer og utvikle opplæringsprogrammer som forklarer AI-teknologi for allmennheten.

Konsekvenser for interessenter

| Interessent | Det du kan ta med deg videre |

|---|---|

| Nyheter og sosiale plattformer | Ta i bruk standarder for autentiserte medier (C2PA, W3C-proveniens) og "opprinnelsesverifiserte" merker for å gjenoppbygge publikums tillit. |

| Underholdning Studios | Innfør eksplisitte opt-in-kontrakter for syntetiske avbildninger, og innfør informasjon på skjermen når AI-rekreasjon brukes. |

| Regulatorer | Fremskynde lovforslag om rett til publisitet og deepfake-merking for å tilpasse dem til forventningene om offentlig samtykke. |

| Virksomheter og merkevarer | Overvåk merkevarebilder proaktivt for å avdekke manipulasjoner, og lær opp de ansatte i å oppdage mistenkelig innhold. |

| Forbrukere | Oppsøk anerkjente verktøy for å oppdage og praktisere "pause, verifiser, del" digital hygiene før du forsterker medier. |

Kommentarer

Vi samlet inn ytterligere svar fra deltakerne i undersøkelsen om deres bruk av AI-verktøy for å oppdage falske data, og det viste seg at noen allerede bruker dem, og at en stor andel av deltakerne sier at de ikke kjente til dem, men er interessert i å lære mer. Fullstendige data fra undersøkelsen er tilgjengelig på forespørsel.

Denne rapporten er et sammendrag av de fullstendige funnene våre, som er tilgjengelige på forespørsel. Denne undersøkelsen ble gjennomført i samarbeid med TruthScan, en løsning for deepfake-deteksjon og anti-ai-svindel.

Konklusjon

Deepfake-problematikken i 2025 er preget av et sterkt paradoks: skyhøye offentlige alarmer som krysser hverandre med minimale beskyttelsestiltak. Tilliten er i ferd med å svekkes, og det haster derfor med å verifisere, merke og autentisere digitalt innhold.

Rettferdig bruk

Du er velkommen til å bruke denne informasjonen i en artikkel eller et blogginnlegg, så lenge du gir oss en lenke og kildehenvisning. Hvis du vil ha tilgang til hele datasettet fra undersøkelsen, kan du ta direkte kontakt med oss.

For pressehenvendelser eller tilgang til fullstendige krysstabeller, kontakt [email protected] eller [email protected]