Instrumentele de inteligență artificială generativă au transformat deepfakes din cercetare științifică într-o preocupare publică majoră. Conform rezultatelor sondajului din iunie 2025, oamenii manifestă teamă față de mediile sintetice, demonstrând în același timp incapacitatea de a le detecta.

FBI afirmă că tehnologia AI deepfake permite desfășurarea de activități infracționale prin trei metode principale, care includ mesaje spam generate de AI, persoane create de AI în rețelele sociale și site-uri de phishing codate de AI.

Scopul acestor scheme vizează atât organizațiile de afaceri, cât și consumatorii individuali în vederea exploatării financiare. Combinația dintre tehnologia deepfake și inteligența artificială a dus la apariția a mai mult de Pierderi de $200 de milioane în cursul anului 2025.

Majoritatea americanilor (85%) și-au pierdut încrederea în informațiile online în cursul anului trecut din cauza deepfakes, iar 81% se tem de daune personale cauzate de conținutul audio și video fals. Mai mult de 90% dintre utilizatori nu utilizează instrumentele de detectare. Datele indică un "deficit de încredere" în creștere, care necesită intervenția imediată a autorităților de reglementare și a operatorilor de platforme și a tehnologilor.

Principalele constatări

| Insight | Date justificative |

|---|---|

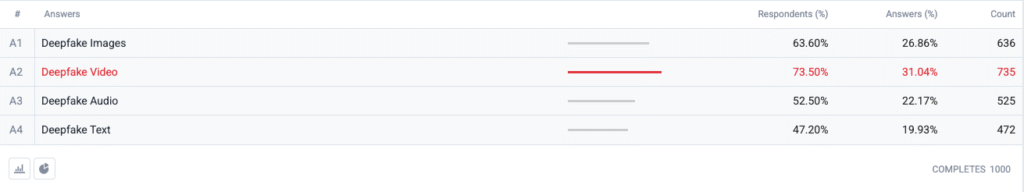

| Clipul Deepfake se află în fruntea indicelui de frică. | 73,5 % dintre respondenți au ales deepfake video ca format de care sunt "cel mai îngrijorați", urmat de imagini (63,6 %), audio (52,5 %) și text (47,2 %). |

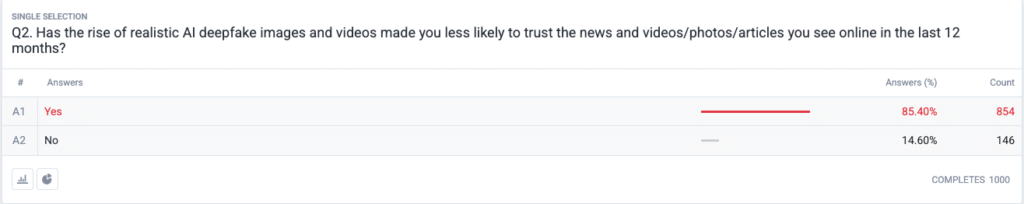

| Este în curs de desfășurare o criză de încredere în toată regula. | 85,4 % raportează că au devenit mai puțin predispuși să aibă încredere în știri, fotografii sau videoclipuri online în ultimele 12 luni din cauza falsurilor realiste. |

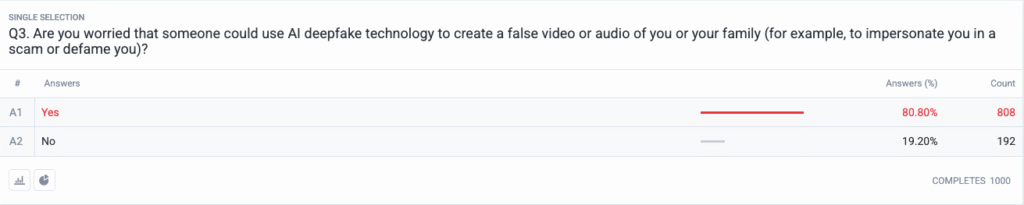

| Amenințarea personală a devenit mainstream. | 80,8 % se tem că escrocii sau actorii răi ar putea folosi conținutul deepfake împotriva lor sau a familiei lor. |

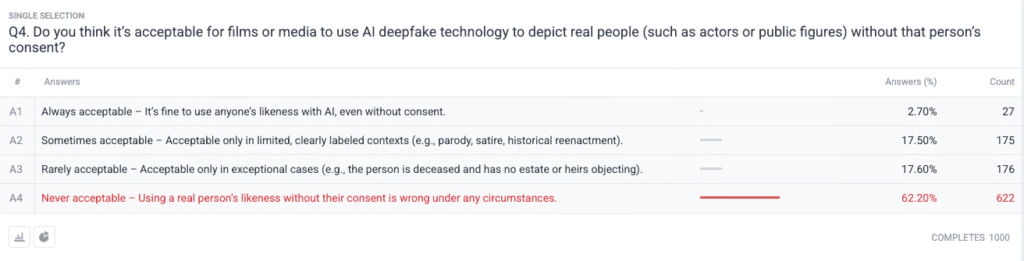

| Consens moral puternic privind consimțământul. | 62.2 % spun că utilizarea imaginii unei persoane reale fără permisiune este niciodată acceptabil; doar 2.7 % spun că este întotdeauna acceptabil. |

Metodologie

- Eșantionul și munca de teren. Am recrutat 1.000 de adulți din S.U.A. utilizând cote de vârstă, de gen și regionale aliniate criteriilor de referință ale recensământului SUA. Munca pe teren a fost finalizată la 18 iunie 2025.

- Proiectarea întrebării. Cinci întrebări închise au evaluat îngrijorarea cu privire la diferite formate deepfake, schimbările recente în ceea ce privește încrederea, riscul personal perceput, opiniile etice privind consimțământul și utilizarea anterioară a software-ului de detectare.

- Marja de eroare. ±3,1 puncte procentuale la un nivel de încredere de 95 %.

- Pondere. Ponderarea post-stratificare a corectat abaterile minore de la datele demografice naționale.

Întrebări

Q1: Care formă de AI Deepfakes vă îngrijorează cel mai mult? (Alegeți toate variantele care se aplică)

Q2: Creșterea numărului de imagini și videoclipuri deepfake realiste cu AI v-a făcut să aveți mai puțină încredere în știrile și videoclipurile/fotografiile/articolele pe care le vedeți online în ultimele 12 luni?

Q3: Sunteți îngrijorat de faptul că cineva ar putea utiliza tehnologia AI deepfake pentru a crea o înregistrare video sau audio falsă cu dvs. sau cu familia dvs. (de exemplu, pentru a vă imita într-o înșelătorie sau pentru a vă defăima)?

Q4: Credeți că este acceptabil ca filmele sau mass-media să utilizeze tehnologia AI deepfake pentru a reprezenta persoane reale (cum ar fi actori sau personalități publice) fără consimțământul acestora?

Analiza tendințelor

- Anxietatea video depășește alte formate

În trecut, videoclipul era un mediu de încredere pe care oamenii îl credeau atunci când îl vedeau. În prezent, preocupările legate de imaginile video sintetice domină mințile americanilor, deoarece imaginile video și-au pierdut statutul de încredere. Oamenii se tem mai mult de materialele video decât de imagini, cu o marjă de 10 puncte (73,5% față de 63,6%), deoarece mișcarea video combinată cu vocea sincronizată și aspectul realist le intensifică îngrijorarea. Organizațiile media ar trebui să pună în aplicare proceduri stricte de autentificare a conținutului video înainte de a-l face public.

- Erodarea încrederii în informații

Scăderea masivă 85% a nivelului de încredere în rândul publicului demonstrează îndoiala generalizată cu privire la orice tip de conținut digital, indiferent de lipsa sa evidentă de credibilitate. Teoria "discursului ieftin" demonstrează cât de ușor de fabricat a făcut ca verificarea adevărului să devină responsabilitatea consumatorului. Personalitățile publice și jurnaliștii, împreună cu factorii de decizie politică, trebuie să se pregătească pentru o monitorizare sporită investind în metode clare de verificare (cum ar fi filigranele criptografice și metadatele semnate).

Nu vă mai îngrijorați niciodată că AI vă detectează textele. Undetectable AI Vă poate ajuta:

- Faceți să apară scrisul dvs. asistat de AI asemănătoare omului.

- Bypass toate instrumentele majore de detectare AI cu un singur clic.

- Utilizați AI în siguranță și cu încredere în școală și la locul de muncă.

- Deepfakes devin personale

Majoritatea respondenților (85%) își imaginează că ei înșiși sau membrii familiilor lor vor deveni victime ale atacurilor deepfake. Percepția deepfake-urilor ca instrumente de dezinformare politică axate pe alegeri și celebrități s-a schimbat în ultimele cicluri pentru a include amenințări personale. Răspândirea aplicațiilor de clonare a vocii și de înlocuire a feței prin inteligență artificială a făcut ca furtul de identitate și escrocheriile financiare să devină amenințări plauzibile pentru gospodăriile obișnuite, ceea ce a declanșat cereri de îmbunătățire a mecanismelor de recurs al victimelor și a legislației privind protecția identității.

- Cerere aproape universală de consimțământ

Întrebarea etică a sondajului relevă modul în care comunitatea de la Hollywood rămâne divizată în ceea ce privește actorii sintetici și performanțele postume. Poziția publică fermă împotriva încălcării drepturilor individuale a apărut ca alegerea "niciodată acceptabilă", care a primit sprijinul a 62,2 % dintre participanți. Funcționarii publici ar trebui să utilizeze aceste dovezi pentru a crea legi care să solicite consimțământul explicit al persoanelor înainte de a crea reprezentări ale asemănărilor generate de inteligența artificială și să asigure divulgarea corespunzătoare a etichetelor.

- Decalajul de pregătire și oportunitatea educației

Chiar dacă există o preocupare profundă cu privire la această problemă, 89,5 % dintre respondenți nu au utilizat instrumente de detectare. Piața prezintă un potențial latent, deoarece nivelurile de interes depășesc capacitățile actuale de utilizare, ceea ce indică probleme de utilizare și conștientizare și îndoieli cu privire la eficacitate. Undetectable AI, alături de alți actori din industrie, trebuie să creeze procese simple de integrare în timp ce adaugă instrumente de detectare la platformele destinate consumatorilor și să dezvolte programe educaționale care să explice publicului tehnologia AI.

Implicații pentru părțile interesate

| Parte interesată | Acțiune de urmat |

|---|---|

| Știri și platforme sociale | Implementați standarde media autentificate (C2PA, W3C provenance) și afișați ecusoane "origine verificată" pentru a restabili încrederea publicului. |

| Studiouri de divertisment | Instituirea de contracte explicite de acceptare voluntară pentru asemănările sintetice și adoptarea de dezvăluiri pe ecran atunci când se utilizează recreerea AI. |

| Autoritățile de reglementare | Avansarea proiectelor de lege privind dreptul la publicitate și etichetarea deepfake pentru a se alinia la așteptările privind consimțământul public. |

| Întreprinderi și mărci | Monitorizați în mod proactiv imaginile de marcă pentru manipulări și instruiți angajații cu privire la identificarea conținutului suspect. |

| Consumatori | Căutați instrumente de detectare de renume și practicați igiena digitală "pauză, verificare, partajare" înainte de a amplifica media. |

Observații

Am colectat răspunsuri suplimentare de la participanții la sondaj cu privire la utilizarea de către aceștia a instrumentelor de detectare profundă a falsurilor cu inteligență artificială, care au arătat că unii le utilizează deja, iar o mare parte dintre persoane au declarat că nu le cunoșteau, dar sunt interesate să afle mai multe. Datele complete ale sondajului sunt disponibile la cerere.

Acest raport este un rezumat AI al constatărilor noastre complete, care sunt disponibile la cerere. Această cercetare a fost realizată în colaborare cu TruthScan, o soluție de detectare a deepfake-urilor și de combatere a fraudei.

Concluzie

Preocupările legate de Deepfake în 2025 sunt definite de un paradox crud: alarmă publică crescândă care se intersectează cu acțiuni de protecție minime. Având în vedere că încrederea este în declin, organizațiile se confruntă cu un mandat urgent de a verifica, eticheta și autentifica conținutul digital.

Utilizare corectă

Vă rugăm să nu ezitați să utilizați aceste informații într-un articol sau într-o postare pe blog, atât timp cât ne furnizați un link și o citație. Pentru acces la setul complet de date al sondajului, nu ezitați să ne contactați direct.

Pentru întrebări de presă sau acces la tabelele transversale complete, contactați [email protected] sau [email protected]