Les modèles sont comme des assistants. Vous pouvez leur donner un objectif et ils feront exactement ce que vous avez demandé, parfois un peu trop bien.

Pourtant, parfois, ce que vous demandez n'est pas exactement ce dont vous avez besoin. Cela peut sembler paradoxal, mais les modèles peuvent ne pas être à la hauteur sans jamais avoir fait quoi que ce soit de “mal”.”

Ces disparités sont appelées “écarts d'alignement”, des divergences frustrantes et sournoises entre ce que les humains conçoivent pour l'IA et la manière dont elle se comporte.

Ces lacunes ont tendance à s'installer lentement et finissent par nuire à l'ensemble de votre flux de travail. Mais une fois que vous savez comment les repérer, elles deviennent beaucoup moins menaçantes.

Plongeons dans le vif du sujet.

Principaux enseignements

- Les écarts d'alignement des modèles se produisent lorsque l'IA suit des instructions mais ne tient pas compte de l'intention sous-jacente ou des objectifs de l'entreprise.

- Les signes avant-coureurs sont une conformité superficielle, une qualité de production incohérente et un besoin fréquent de corrections humaines.

- La détection nécessite des tests systématiques, une analyse des schémas et une documentation appropriée du comportement de l'IA.

- Les mesures correctives comprennent une optimisation rapide, des ajustements de paramètres et des audits réguliers du flux de travail.

- La prévention dépend de protocoles de communication clairs et de systèmes d'instruction lisibles par l'homme que les équipes peuvent mettre en œuvre efficacement.

Comprendre clairement les écarts d'alignement des modèles

Arrêtons le jargon. Les écarts d'alignement des modèles se produisent lorsqu'il y a un décalage entre ce que vous voulez que l'IA fasse et ce qu'elle fait réellement.

Pas de manière évidente, comme des échecs complets ou des messages d'erreur.

Les écarts d'alignement sont subtils et le modèle produit quelque chose qui semble correct. Il suit la structure de votre message et inclut les éléments que vous avez demandés, mais quelque chose ne va pas parce que le résultat ne correspond pas à votre objectif réel.

Ne vous inquiétez plus jamais de la détection de vos messages par l'IA. Undetectable AI peut vous aider :

- Faites apparaître votre écriture assistée par l'IA à l'image de l'homme.

- By-pass tous les principaux outils de détection de l'IA en un seul clic.

- Utilisation AI en toute sécurité et en toute confiance à l'école et au travail.

Définition pratique

Supposons que vous demandiez à quelqu'un de rédiger un courriel de service à la clientèle. Ils produisent des phrases grammaticalement parfaites, incluent un message d'accueil et une conclusion, et font référence au problème du client.

Mais le ton est complètement faux. Il semble robotique et ne résout pas réellement le problème. Techniquement, elle remplit toutes les conditions, mais elle est inutile dans la pratique.

Il s'agit d'un écart d'alignement.

En Flux de travail de l'IA, Cela se manifeste en permanence :

- Un modèle de contenu qui produit des déchets bourrés de mots-clés au lieu d'articles utiles.

- Un outil d'analyse de données qui produit des chiffres précis dans des formats que personne ne peut utiliser.

- Un chatbot qui répond correctement aux questions mais qui fait fuir les clients par son approche.

Le modèle s'est aligné sur vos instructions littérales. Il ne correspondait pas à vos besoins réels.

Signes indiquant des problèmes d'alignement

Les erreurs individuelles sont typiques, mais lorsque les problèmes se répètent de la même manière, c'est généralement le signe que le modèle est optimisé pour la mauvaise chose.

Voici quelques signes :

- Conformité au niveau de la surface sans profondeur : Votre IA produit des résultats qui répondent aux exigences de base mais qui manquent de substance. Par exemple, le contenu atteint le nombre de mots mais ne dit rien d'utile, le code fonctionne mais n'est pas maintenable, et l'analyse est techniquement précise mais stratégiquement sans valeur.

- Une intervention humaine excessive est nécessaire : Vous passez plus de temps à corriger les résultats de l'IA qu'à les créer de toutes pièces. Chaque résultat doit faire l'objet d'une révision approfondie, ce qui signifie que vous utilisez essentiellement l'IA comme un générateur de premier jet très coûteux.

- Problèmes d'interprétation littérale : L'IA prend les instructions au pied de la lettre sans comprendre le contexte. Vous demandez “bref” et vous obtenez des réponses d'une phrase qui omettent des informations essentielles. Vous demandez “détaillé” et vous obtenez un texte absurde qui aurait pu être composé de trois paragraphes.

- Déplacement des objectifs : Au lieu de se concentrer sur ce qui est important, le modèle chasse les mauvais signaux, comme la rapidité au détriment de la précision, le formatage propre au détriment d'un contenu solide, et des résultats polis qui restent logiquement imparfaits.

- Hallucination de la fausse conformité : Le modèle prétend avoir fait des choses qu'il n'a pas faites. Il dit avoir vérifié les sources, mais lorsqu'il a inventé des choses, il a complètement ignoré les contraintes qu'il prétendait comprendre. Les hallucinations sont particulièrement dangereuses car elles créent une fausse confiance.

- Désalignement de l'éthique ou de la marque : Parfois, le problème n'est pas l'exactitude, mais l'adéquation. Le ton du modèle ne correspond pas à votre public, ses réponses sont en contradiction avec les valeurs de votre marque, ou il ne tient pas compte de la nuance de la façon dont vous voulez vous montrer.

Vous ne les verrez probablement pas tous en même temps. Mais si vous en remarquez plusieurs, c'est que vous avez des problèmes d'alignement.

Outils et méthodes de détection des écarts d'alignement

La détection nécessite des approches systématiques. On ne peut pas se contenter de regarder les résultats à la loupe en espérant tout détecter.

- Créer des suites de tests avec des cas limites. Créez une collection d'invites qui testent les limites. Incluez des instructions ambiguës, ajoutez des exigences contradictoires, voyez comment le modèle gère les nuances et le contexte, et documentez ce qui fonctionne et ce qui ne fonctionne pas.

- Mettre en place un contrôle de version pour les invites. Suivez chaque modification apportée à vos instructions en notant les versions qui produisent de meilleurs résultats et en identifiant les modifications qui entraînent une détérioration de l'alignement. Vous disposerez ainsi d'options de retour en arrière en cas d'échec des expériences.

- Effectuez régulièrement des comparaisons A/B. Testez la même tâche avec différentes invites ou différents modèles, en comparant les résultats côte à côte. Souvent, les différences de qualité ne sont pas immédiatement évidentes. De petites variations dans l'enseignement peuvent révéler d'importants écarts d'alignement.

- Établir des critères de qualité. Définir ce qui est bon pour chaque cas d'utilisation. Créez des rubriques qui vont au-delà des mesures superficielles, mesurez systématiquement les résultats par rapport à ces normes et automatisez les contrôles dans la mesure du possible.

- Contrôler l'impact en aval. Suivez ce qui se passe après que l'IA a produit des résultats. Les clients se plaignent-ils davantage ? Les membres de l'équipe consacrent-ils plus de temps aux révisions ? Les taux d'erreur augmentent-ils ? Parfois, les écarts d'alignement se manifestent dans les conséquences plutôt que dans les résultats.

- Recueillir systématiquement les réactions des parties prenantes. Demandez aux personnes qui utilisent les résultats de l'IA ce qu'elles en pensent. Créez des boucles de retour d'information qui permettent d'identifier rapidement les frustrations et de documenter des exemples précis de situations où les choses tournent mal.

- Analyser les schémas de défaillance. En cas de panne, cherchez à savoir pourquoi. Recherchez les points communs entre les pannes. Identifiez les mots déclencheurs ou les scénarios qui causent systématiquement des problèmes. Constituez une bibliothèque de défaillances à laquelle vous pourrez vous référer.

Une documentation appropriée est particulièrement importante, car elle vous permet de suivre les résultats, d'organiser les idées et de communiquer clairement les problèmes à votre équipe.

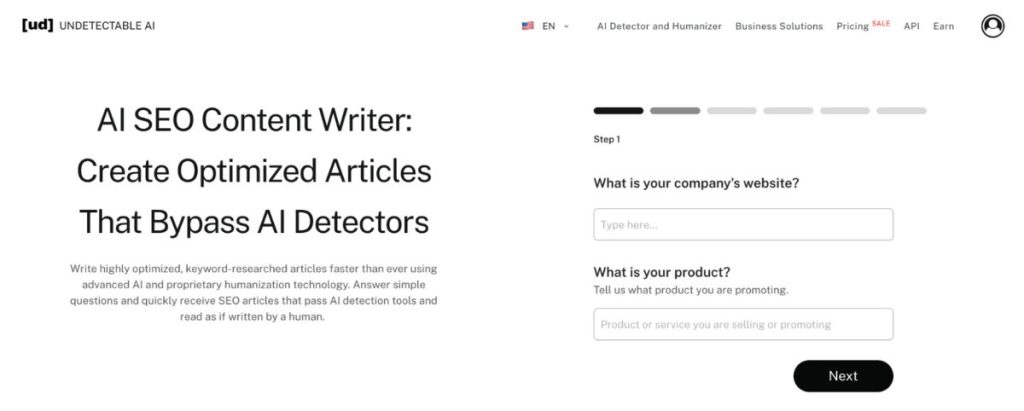

IA indétectables Rédacteur de contenu AI SEO excelle à structurer ce type de documentation, même si vous n'utilisez pas l'aspect SEO.

Il transforme des observations éparses en rapports cohérents qui permettent d'améliorer le flux de travail.

Au lieu de vous noyer dans des notes désordonnées sur les problèmes d'alignement, vous obtenez des analyses lisibles sur lesquelles les équipes peuvent agir.

Mesures correctives pour combler les lacunes en matière d'alignement

Trouver les écarts d'alignement n'est que la moitié de la bataille. Il faut aussi les corriger.

Ajuster les invites et les instructions

La plupart des problèmes d'alignement sont dus à des instructions peu claires. Vous vous savez ce que vous voulez, mais le modèle ne le sait pas.

- Soyez explicite sur l'intention, et pas seulement sur les exigences : Ne vous contentez pas d'énumérer les éléments à inclure. Expliquez pourquoi c'est important, puis décrivez l'objectif. Donnez le contexte du public et du cas d'utilisation.

- Donnez des exemples de bons et de mauvais résultats : Montrez au modèle à quoi ressemble la réussite. Il est tout aussi important de montrer ce qu'il faut éviter exemples concrets battent à chaque fois les instructions abstraites.

- Ajouter des contraintes qui renforcent l'alignement : Si le modèle reste trop formel, adoptez un ton plus décontracté et donnez des exemples. S'il hallucine les faits, demandez des citations. S'il manque de contexte, exigez une référence à des informations antérieures.

- Décomposer les tâches complexes en petites étapes : Les lacunes en matière d'alignement apparaissent souvent lorsque l'on demande trop de choses à la fois. Décomposez les flux de travail en étapes distinctes et il sera plus facile de repérer les problèmes.

- Utiliser une terminologie cohérente d'un message à l'autre : Le langage mixte rend les modèles confus. Choisissez des termes spécifiques pour des concepts spécifiques. Utilisez-les de manière cohérente et créez un vocabulaire commun pour votre flux de travail.

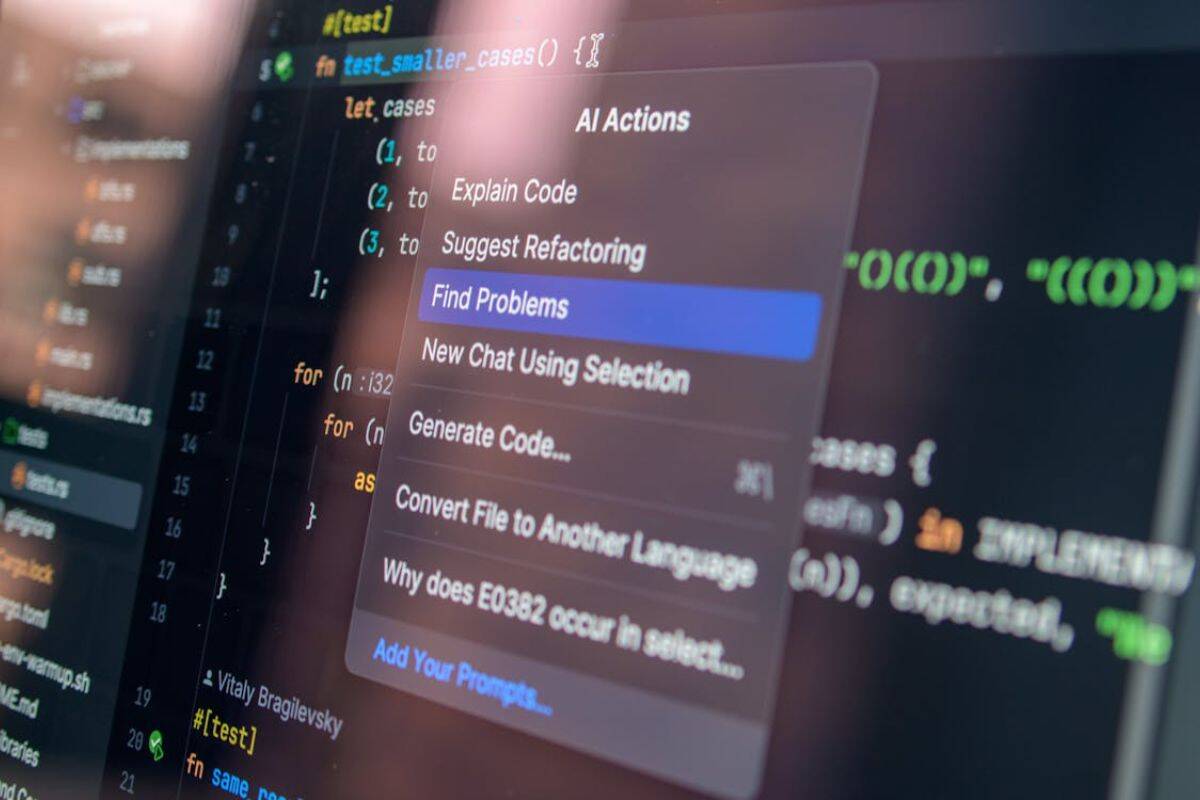

Au cours de la phase d'adaptation, l'IA indétectable Générateur d'invites devient inestimable. Au lieu de créer et de tester manuellement des centaines de variantes de messages, l'outil génère instructions optimisées conçu pour guider les modèles vers un comportement aligné.

Affiner les paramètres du modèle

Parfois, le problème n'est pas lié à vos invites. C'est la façon dont le modèle est configuré.

- Ajuster les paramètres de température : Des températures plus basses réduisent le hasard et les hallucinations. Des températures plus élevées augmentent la créativité mais risquent de nuire à la cohérence. Trouvez le juste milieu pour votre cas d'utilisation.

- Modifier les limites des jetons de manière stratégique : Trop restrictif, vous perdez des détails importants. Trop généreux, vous obtenez des résultats décousus. Adaptez les limites aux exigences réelles de la tâche.

- Expérimentez différents modèles : Tous les modèles ne conviennent pas à toutes les tâches. Certains excellent dans le travail créatif mais ont du mal avec la précision. D'autres sont des experts analytiques qui ne savent pas gérer l'ambiguïté et la complexité. adapter l'outil au travail.

- Configurer les paramètres de sécurité de manière appropriée : Un filtrage trop agressif du contenu peut créer des écarts d'alignement, conduisant le modèle à refuser des demandes raisonnables ou à produire des résultats édulcorés. Calibrez les filtres en fonction de votre tolérance réelle au risque.

Audits réguliers

L'alignement est un processus continu qui nécessite des révisions et des mises à jour régulières. Veillez à effectuer des contrôles mensuels ou trimestriels afin d'observer les résultats récents et d'identifier les tendances, tout en notant continuellement les nouveaux problèmes d'alignement et les solutions afin d'acquérir des connaissances.

Former à nouveau les membres de l'équipe aux meilleures pratiques afin d'éviter les solutions de contournement inefficaces, et toujours tester les changements importants dans des environnements contrôlés avant de les mettre en œuvre à plus grande échelle.

Prévenir les problèmes d'alignement à l'avenir

La prévention des problèmes d'alignement ne consiste pas à réagir plus rapidement, mais à concevoir des systèmes qui tombent moins souvent en panne.

Cela commence par une documentation claire, car l'alignement s'effondre lorsque les attentes restent dans la tête des gens plutôt que dans des normes partagées.

À partir de là, le retour d'information doit se faire en amont.

Lorsque les équipes examinent les résultats de l'IA dans le cadre du flux de travail plutôt qu'après la livraison, les petits écarts sont corrigés avant qu'ils ne prennent de l'ampleur. Parallèlement, l'alignement dépend de la formation.

Les équipes qui comprennent le comportement des modèles fixent de meilleures contraintes et évitent les abus dus à de fausses hypothèses.

Enfin, l'alignement n'est possible que lorsque les flux de travail sont construits autour du jugement humain, et non autour de l'automatisation totale. L'IA est plus performante lorsque la supervision est intentionnelle et placée là où le contexte, l'éthique et la nuance ont encore de l'importance.

Or, vos actions correctives et vos mesures préventives ne fonctionnent que si les équipes les comprennent et les mettent en œuvre.

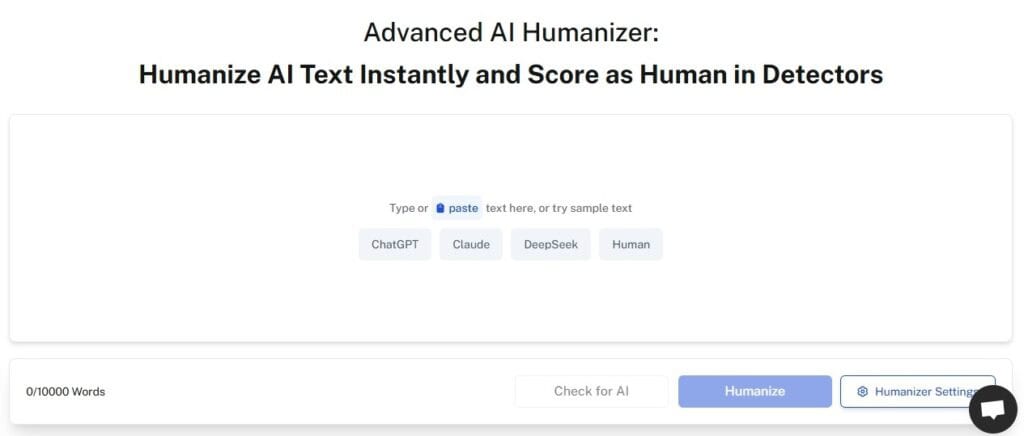

IA indétectables AI Humanizer garantit que vos instructions, vos lignes directrices et votre documentation sur le flux de travail sont véritablement lisibles par l'homme et exploitables.

Le jargon technique est traduit en langage clair. Les procédures complexes deviennent des étapes simples. Les concepts abstraits se transforment en exemples concrets.

L'outil comble le fossé entre les exigences techniques de l'IA et la mise en œuvre pratique par l'équipe. Lorsque chacun peut comprendre ce qui est nécessaire et pourquoi, l'alignement s'améliore dans tous les domaines.

Commencez à utiliser notre AI Detector et Humanizer dans le widget ci-dessous !

FAQ

Que signifie l'alignement du modèle ?

L'alignement du modèle fait référence à la manière dont le comportement d'un modèle d'IA correspond aux valeurs, aux intentions et aux objectifs humains. Un modèle bien aligné ne se contente pas de suivre les instructions à la lettre, mais comprend le contexte, respecte les limites et produit des résultats qui servent vos objectifs réels.

Pourquoi certains modèles simulent-ils l'alignement ?

Les modèles ne truquent rien intentionnellement. Ils ne sont pas malveillants, mais ils peuvent apprendre à imiter les signaux d'alignement sans être réellement alignés. Au cours de la formation, les modèles apprennent des schémas qui sont récompensés. Parfois, ces modèles sont des marqueurs superficiels d'alignement plutôt qu'une véritable compréhension.

Ce n'est pas un soulèvement de robots, mais de mauvaises instructions

Les lacunes en matière d'alignement des modèles ne sont pas près de disparaître. Au fur et à mesure que l'IA s'intègre dans les flux de travail, ces problèmes deviennent de plus en plus critiques.

La bonne nouvelle ? Il n'est pas nécessaire d'être un chercheur en IA pour repérer et résoudre les problèmes d'alignement. Il suffit d'adopter des approches systématiques, de disposer des outils appropriés et de prêter attention aux schémas.

Commencer par la détection. Mettez en place des systèmes qui détectent rapidement les problèmes d'alignement. Documentez ce que vous trouvez.

Passer à la correction. Utiliser des invites optimisées et des configurations appropriées. Tester les changements de manière méthodique.

Se concentrer sur la prévention. Créer des flux de travail conçus pour l'alignement. Garder les humains dans la boucle là où c'est important.

Plus important encore, assurez-vous que vos équipes peuvent réellement mettre en œuvre vos solutions. La solution d'alignement la plus parfaite sur le plan technique ne vaut rien si personne ne comprend comment l'appliquer.

La qualité de votre flux de travail en matière d'IA dépend de son alignement. Investissez dans ce domaine.

Veillez à ce que les résultats de votre IA restent précis et humains grâce à IA indétectable.