Veel scholen en schrijvers gebruiken nu standaard een AI-detector.

Het is niet omdat het studenten of schrijvers verboden is om AI schrijftools-In feite zijn veel universiteiten en agentschappen moedigen het gebruik ervan aan.

Wat wordt bekeken is hoe ze worden gebruikt.

AI-detectors zijn er niet altijd om mensen te straffen voor het gebruik van deze tools (hoewel het ervan afhangt of AI strikt verboden is in de situatie), want het wordt ook vaak gebruikt om schrijfwerk te betrappen dat te robotachtig en generiek aanvoelt.

AI kan worden gebruikt als een schrijfassistent, maar het uiteindelijke stuk moet klinken zoals jij.

Tegenwoordig is het gemakkelijk om een puur AI-geschreven stuk te herkennen door alleen maar de woorden die werden gebruikt.

Maar als het onduidelijk is, helpen AI-detectors bij het identificeren van de waarschijnlijkheid dat inhoud is gemaakt door een AI-platform zoals ChatGPT.

Maar hoe werken AI-detectors precies?

Dit is alles wat je moet weten over AI-detectors, hoe ze werken en hoe ze de kwaliteit van AI-gegenereerde inhoud kunnen verbeteren.

Wat is een AI-inhouddetector?

Een AI-contentdetector is een hulpmiddel dat tekst analyseert om te bepalen of deze door een mens is geschreven of door kunstmatige intelligentie is gegenereerd.

Het is als een digitale speurhond die patronen, structuren en linguïstische vingerafdrukken opspoort die schreeuwen "een robot heeft dit geschreven".

Deze tools onderzoeken alles van zinsverloop tot de frequentie van woordkeuzes.

Maak je nooit meer zorgen dat AI je sms'jes herkent. Undetectable AI Kan je helpen:

- Laat je AI-ondersteund schrijven verschijnen mensachtig.

- Omleiding alle grote AI-detectietools met slechts één klik.

- Gebruik AI veilig en vol vertrouwen op school en op het werk.

Ze zoeken naar tekenen die mensen meestal vermijden maar waar AI-modellen dol op zijn, zoals overdreven perfecte grammatica, herhalende zinnen of verdacht uitgebalanceerde zinsconstructies.

De technologie ontstond als een directe reactie op de explosie van AI-schrijftools. Toen ChatGPT werd eind 2022 uitgebrachthad iedereen opeens toegang tot geavanceerde hulp bij het schrijven.

Docenten begonnen essays te krijgen die te gepolijst leken. Contentmanagers merkten dat het werk van hun freelancers vreemd consistent werd.

AI-detectors kwamen het gat opvullen en beloofden orde in de chaos te scheppen.

Sommige werken beter dan andere, maar ze proberen allemaal hetzelfde probleem op te lossen: het identificeren van machinaal gegenereerde tekst in een wereld waar de grens tussen menselijk en AI-schrijfwerk steeds vager wordt.

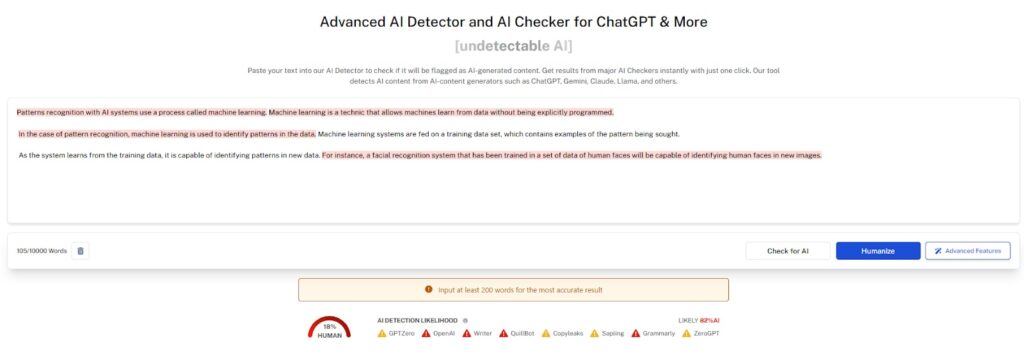

De meeste AI-detectors geven je een procentuele score. Iets als "85% waarschijnlijk door AI gegenereerd" of "12% kunstmatige inhoud gedetecteerd".

Deze cijfers lijken precies, maar het zijn eigenlijk gefundeerde gissingen op basis van patroonherkenning.

Hoe werken AI-detectors?

AI-detectoren maken gebruik van twee soorten technologie om AI-gegenereerde inhoud te detecteren: machinaal leren en natuurlijke taalprocessoren.

Met beide kan de AI-detector voorspelbare taalpatronen, zinsbouw en complexiteitsniveaus identificeren.

Als de detector genoeg van deze patronen herkent, is het waarschijnlijk dat AI de tekst heeft gegenereerd.

Maar waarmee vergelijken AI-detectors hun bevindingen? De meeste AI-detectors zijn getraind op duizenden, zo niet miljoenen datasets.

Dit helpt de detector om het tekstvoorbeeld te identificeren en te vergelijken met stukken AI-gegenereerde inhoud die het al heeft geleerd.

De detector vindt dus niet alleen patronen in het schrift die wijzen op AI-generatie, maar vergelijkt dit ook met duizenden voorbeelden van AI-tekst.

Het doel is om de verschillen te ontdekken tussen hoe mensen schrijven en hoe AI-modellen tekst construeren.

Dit is waar ze meestal naar kijken:

- Perplexiteitsscores meten hoe voorspelbaar de tekst is. Menselijk schrijven is vaak onvoorspelbaarder. We maken rare woordkeuzes, beginnen zinnen onhandig en schrijven in het algemeen op manieren die zelfs onszelf verbazen. AI-modellen hebben daarentegen de neiging om het volgende woord of de volgende zin te kiezen die statistisch het meest waarschijnlijk is.

- Barstanalyse onderzoekt variatie in zinslengte. Mensen schrijven met een natuurlijk ritme. We wisselen korte, krachtige zinnen af met langere, complexere zinnen. AI produceert vaak tekst met griezelig consistente zinslengtes en -structuren.

- Semantische patronen laten zien hoe ideeën van het ene in het andere overgaan. Menselijke schrijvers maken logische sprongen, hebben raakvlakken en keren soms terug naar eerdere punten. AI heeft de neiging om meer lineaire, voorspelbare denkpatronen te volgen.

- Woordenschatverdeling kijkt naar de frequentie van woordkeuzes. Mensen hebben favoriete woorden en zinnen die we te vaak gebruiken en we vermijden ook bepaalde woorden helemaal. AI-modellen hebben verschillende vocabulairevoorkeuren op basis van hun trainingsgegevens.

Veelvoorkomende problemen met de meeste AI-checkers

AI-detectoren zijn niet perfect.

Sterker nog, Sommige zijn behoorlijk gebrekkig. Het is belangrijk om hun beperkingen te begrijpen als je erop vertrouwt voor belangrijke beslissingen.

| Veelvoorkomende problemen met AI-detectoren | Impactniveau | Frequentie |

| Fout-positieven | Hoog | Zeer vaak |

| Vooringenomenheid bij training | Medium | Gewoon |

| Model Lag | Hoog | Doorlopend |

| Contextblindheid | Medium | Universeel |

| Drempel Verwarring | Laag | Gewoon |

- Vals positieven zijn schering en inslag. Veel AI-detectors markeren perfect door mensen geschreven inhoud als kunstmatig. Dit gebeurt vooral bij nietmoedertaalsprekers van het Engels, technisch schrijven of inhoud die bepaalde opmaakconventies volgt.

- Trainingsvooroordelen beïnvloeden de resultaten. De meeste AI-detectors zijn voornamelijk getraind op Engelse inhoud uit specifieke bronnen. Ze hebben moeite met andere talen, culturele schrijfstijlen of gespecialiseerde domeinen. Een technische handleiding kan hoog scoren voor AI-detectie, simpelweg omdat het precieze, formele taal gebruikt.

- Ze kunnen de nieuwe AI-modellen niet bijhouden. AI-schrijftechnologie evolueert snel en nieuwe modellen produceren meer mensachtige tekst. Maar detectors hebben tijd nodig om hun algoritmes aan te passen. Er is vaak een vertraging voordat nieuwe AI-gegenereerde inhoud wordt opgepikt.

- Context is belangrijk, maar sommige detectors begrijpen dat niet. Een medisch onderzoekspaper en een persoonlijke blogpost hebben compleet verschillende schrijfconventies. De meeste AI-detectors passen echter dezelfde analysecriteria toe op beide, wat leidt tot inconsistente en onbetrouwbare resultaten.

- Drempelverwarring zorgt voor problemen. Welk percentage is "AI-gegenereerd"? 50%? 80%? 95%? Verschillende tools gebruiken verschillende drempels en gebruikers begrijpen vaak niet wat de getallen eigenlijk betekenen.

- Lengteafhankelijkheid vertekent de resultaten. Korte teksten zijn moeilijker nauwkeurig te analyseren. Een antwoord van twee zinnen kan als AI worden gemarkeerd omdat er niet genoeg inhoud is om duidelijke patronen vast te stellen. Langere teksten leveren over het algemeen betrouwbaardere detectieresultaten op.

AI-detectors vs. plagiaatcheckers

Als je onderzoek hebt gedaan naar AI-detectoren, ben je ongetwijfeld ook plagiaatcheckers tegengekomen.

Wat is het verschil tussen een AI-detector en een plagiaatcontrole?

Een plagiaatchecker scant de tekst en vergelijkt deze met een enorme database van gepubliceerd werk op het internet.

In tegenstelling tot een AI-detector interesseert het een plagiaatcontrole niet wie of wat de inhoud heeft gemaakt, maar of de inhoud is gekopieerd van een andere bron.

Aan de andere kant analyseren AI-detectors schrijfpatronen.

Het maakt ze niet uit of de inhoud ergens anders bestaat. Ze willen weten of het oorspronkelijk door een mens of een machine is geschreven.

Bekijk het zo: plagiaatcontroleurs vragen: "Is dit gestolen?", terwijl AI-detectors vragen: "Is dit kunstmatig gecreëerd?".

De tools gebruiken totaal verschillende technologieën. Plagiaatcheckers vertrouwen op enorme databases en string-matching algoritmes.

AI-detectors gebruiken machine-learningmodellen die zijn getraind op het herkennen van schrijfpatronen.

Hun doelen verschillen ook. Plagiaatcheckers beschermen intellectueel eigendom en academische integriteit, terwijl AI-detectors de authenticiteit van inhoud en menselijk auteurschap verifiëren.

Als een zin overeenkomt met vijf of meer opeenvolgende woorden uit een andere bron, wordt deze gemarkeerd als plagiaat.

Kunnen plagiaatcontroles AI-gegenereerde inhoud detecteren

Hoewel het niet de taak van de plagiaatcontroleur is om AI-gegenereerde inhoud te detecteren, zijn er af en toe momenten waarop de twee elkaar overlappen.

Waarom zou dit gebeuren?

Geloof het of niet, maar sommige AI-taalmodellen hebben geplagieerde inhoud als uitvoer geleverd.

Het is misschien niet met opzet, maar AI-tools kunnen per ongeluk zinnen kopiëren van een andere bron op het internet.

Dit is nog een rode vlag om AI-gegenereerde inhoud als je eigen inhoud te laten doorgaan. Schrijvers moeten extra waakzaam zijn en hun inhoud ook door een plagiaatcontrole laten lopen.

Er is een grijs gebied met AI-detectietools, maar als je een betaalde schrijver bent die plagiaat pleegt, kan dat gevolgen hebben in het echte leven.

Verschil tussen AI-inhoud en geplagieerde inhoud

Hoewel er af en toe een overlap is tussen de twee soorten inhoud, bevinden ze zich meestal aan de andere kant van het spectrum.

AI-gegenereerde inhoud is meestal origineel, zij het geschreven in een mechanische stijl.

Deze inhoud moet worden gecontroleerd op feiten door een menselijke schrijver en worden gescand op mogelijk incidenteel plagiaat voordat het wordt ingediend of gepubliceerd.

Plagiaat kan worden gepleegd door een menselijke schrijver of door een AI-tool. Wanneer een mens plagiaat pleegt, is dit meestal opzettelijk.

Als een AI-tool plagiaat creëert, is dat bijna altijd per ongeluk.

Ondanks dit verschil moet inhoud nog steeds worden gescand op plagiaat, of deze nu is geschreven door een mens of door een AI-tool.

Bestraft Google AI-gegenereerde inhoud?

Dit is een vraag met gelaagde antwoorden.

Oppervlakkig gezien straft Google sites niet voor het publiceren van AI-gegenereerde inhoud.

Google's bijgewerkte beleid Het maakt niet uit of je AI-tekst gebruikt, AI-beeldenof een andere vorm van AI-inhoud op je site.

Je pagina wordt niet verwijderd en je advertentie-inkomsten worden niet verminderd.

Maar er zijn belangrijke voorbehouden.

- Kwaliteit boven bron is het officiële standpunt van Google. Ze geven er meer om of inhoud nuttig, nauwkeurig en waardevol is voor gebruikers dan of een mens of AI de inhoud heeft gemaakt. Hun algoritme evalueert inhoud op basis van E-A-T principes: Ervaring, Expertise, Autoriteit en Betrouwbaarheid.

- Openbaarmaking is niet vereist volgens de richtlijnen van Google. Je hoeft AI-gegenereerde inhoud niet als zodanig te labelen. Je blijft echter wel verantwoordelijk voor de kwaliteit en nauwkeurigheid van alles wat je publiceert.

- Massaal geproduceerde inhoud van lage kwaliteit Hier ontstaan problemen. Als je AI gebruikt om tonnen dunne, nutteloze inhoud te genereren alleen om zoekwoorden te targeten, zal Google dat waarschijnlijk afstraffen. Maar dit geldt voor alle massaal geproduceerde inhoud, of die nu door AI is gegenereerd of door mensen is geschreven.

- Recente algoritme-updates hebben de nadruk gelegd op de kwaliteit van de inhoud in plaats van kwantiteit. Het behulpzame inhoudssysteem van Google richt zich specifiek op inhoud die voornamelijk lijkt te zijn gemaakt voor zoekmachines in plaats van mensen. AI-gegenereerde inhoud die in deze categorie valt, zal het moeilijk krijgen in de rankings.

Verschillende prominente sites gebruiken AI-tools om inhoud te creëren en zijn niet gestraft op het gebied van SEO-ranking.

Maar wat Google heeft gedaan is zijn algoritme voor zoekresultaten bijwerken.

In een recente bijgewerkte SQO-richtlijnenGoogle benadrukte dat ervaring uit eerste hand en een ervaren expert zijn over het onderwerp cruciaal zijn voor een goede positie op de pagina.

Als je AI-inhoud gebruikt, bevat deze geen kennis of ervaring uit de eerste hand, omdat die alleen door een mens kan worden geleverd.

Bestraft Google Plagiaat van inhoud

Hoewel je zou denken dat dit een voor de hand liggende straf is, is het verrassend om te weten dat Google plagiaat niet bestraft.

Bijna 30% van de websites heeft dubbele inhoudwaardoor Google miljoenen sites zou moeten straffen.

Google Search Advocate John Mueller heeft onthuld dat dubbele inhoud geen invloed heeft op je zoekpositie.

Als het algoritme van Google dezelfde inhoud op meerdere pagina's vindt, zal het kiezen welke pagina het wil rangschikken op basis van hoe nuttig het is voor de lezer.

Het slechte nieuws is dat als iemand jouw inhoud kopieert, hij je mogelijk kan overtreffen met jouw werk.

Preventie is eenvoudig: maak originele inhoud of voorzie de inhoud die je gebruikt van andere bronnen van de juiste naam en licentie.

De meeste succesvolle websites hebben een strikt beleid tegen plagiaat.

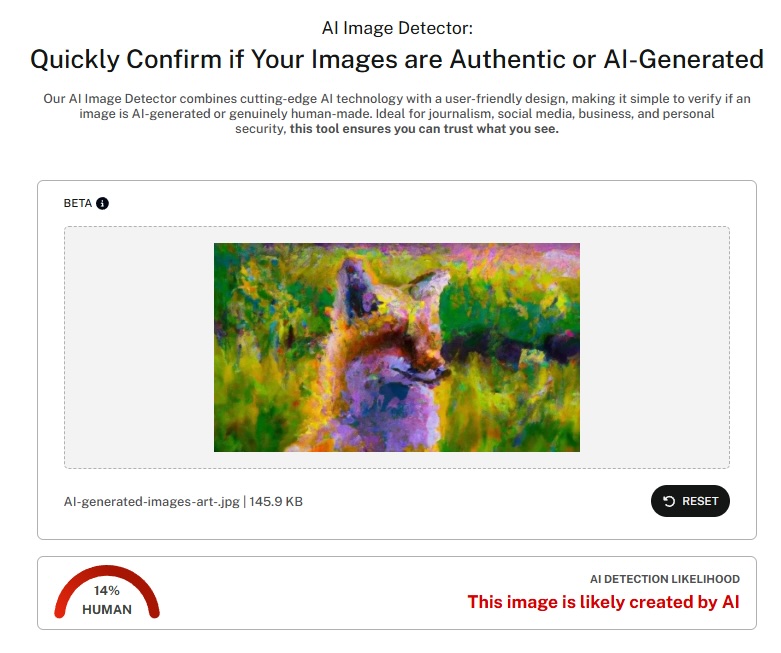

Over detectie gesproken: Undetectable AI heeft onlangs een afbeeldingsdetector gelanceerd die AI-gegenereerde afbeeldingen kan identificeren.

Deze AI beelddetector richt zich op de groeiende bezorgdheid over synthetische visuele inhoud en vult tekstgebaseerde detectiemogelijkheden aan.

Hoe maak ik AI-tekst onherkenbaar?

Om AI-tekst ondetecteerbaar te maken, moet je begrijpen hoe detectiealgoritmen werken en moet je de inhoud strategisch aanpassen om hun triggers te vermijden.

- Varieer met je zinsbouw dramatisch. AI heeft de neiging om consistente zinslengtes en -patronen te produceren. Meng korte, krachtige zinnen met langere, complexe zinnen. Gooi er wat fragmenten in voor de nadruk. Verander je ritme voortdurend.

- Voeg persoonlijke accenten en ervaringen toe. In AI-inhoud ontbreken vaak persoonlijke anekdotes, specifieke voorbeelden en menselijke eigenaardigheden. Voeg je eigen verhalen, meningen en unieke perspectieven toe. Deze elementen zijn voor AI bijna onmogelijk authentiek na te bootsen.

- Introduceer opzettelijke imperfecties. Mensen maken kleine grammaticale fouten, gebruiken spreektaal en schrijven met natuurlijke onvolkomenheden. Perfecte grammatica en foutloze structuur kunnen AI-detectie triggeren. Voeg wat menselijkheid toe aan je schrijven.

- Gebruik onverwachte woordkeuzes. AI-modellen hebben de neiging om voorspelbaar vocabulaire te kiezen. Kies verrassende synoniemen, gebruik jargon op de juiste manier en vermijd overdreven formeel taalgebruik, tenzij de context erom vraagt.

- Uitgebreid bewerken na AI-generatie. Herstel niet alleen grammatica en spelling. Herstructureer alinea's, herschik ideeën en herschrijf delen met je eigen stem. Hoe meer menselijke bewerking erbij betrokken is, hoe minder detecteerbaar de AI-oorsprong wordt.

- Voorspelbare patronen doorbreken. Als je inhoud een heel logische, lineaire structuur volgt, schud het dan door elkaar. Voeg raakvlakken toe, keer terug naar eerdere punten en laat je gedachten natuurlijker stromen.

Het doel is niet om te misleiden, maar om inhoud te creëren die echt menselijke denkprocessen en schrijfpatronen weerspiegelt.

Vraag AI om je inhoud te herschrijven

Geloof het of niet, maar je kunt tools als ChatGPT of Jasper.AI vragen om hun eigen inhoud te herschrijven.

Je kunt zelfs specifieke inputs gebruiken die de app instrueren om meer natuurlijke taal te gebruiken.

Het herschrijven van de inhoud met dezelfde app dwingt je om andere taal en woordenschat te gebruiken.

Vreemd genoeg levert een tweede of zelfs derde keer doornemen veel positievere resultaten op als je deze inhoud door een AI-detector haalt.

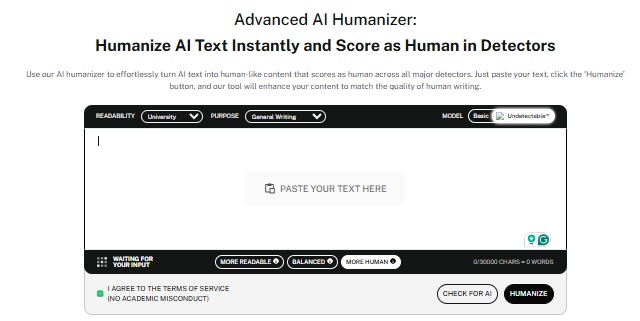

AI-verwarringstools gebruiken

Als je simpelweg geen tijd hebt om al je artikelen handmatig te bewerken, dan kan het gebruik van AI-scrambling tools een uitkomst zijn.

Deze tools kunnen je AI-gegenereerde content menselijk maken door het te herschikken op een manier die de AI-detectortests doorstaat.

AI-humaniseringstools weten precies waar AI-detectors naar zoeken en kunnen dit toepassen op je inhoud. Als je nog steeds wordt gemarkeerd door een AI-detector, kun je je inhoud meerdere keren door de AI-scrambler halen.

Elke keer zou een meer verfijnde uitvoer moeten opleveren en een grotere kans om die AI-tekst ondetecteerbaar te maken.

En als je de best mogelijke oplossing wilt, lees dan het volgende onderwerp:

Het beste hulpmiddel om AI-inhoud ondetecteerbaar te maken

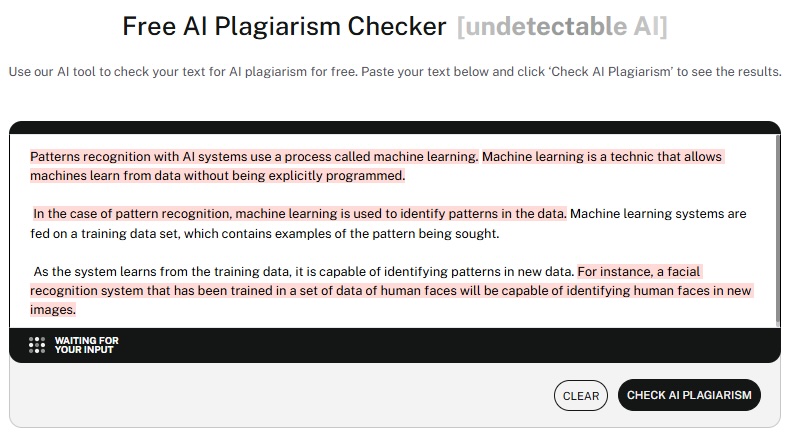

Als het aankomt op het ondetecteerbaar maken van AI-inhoud met behoud van kwaliteit, leidt Undetectable AI de markt met een uitgebreide reeks tools die zijn ontworpen voor verschillende behoeften aan inhoud.

De AI Detector en Humanizer combineert detectie en aanpassing in één platform. Eerst analyseert het je inhoud om door AI gegenereerde secties te identificeren.

Daarna herschrijft het die delen om menselijker te klinken terwijl de oorspronkelijke betekenis en bedoeling behouden blijven.

De humanizer maakt woorden niet willekeurig of voegt fouten toe, maar begrijpt de context, behoudt de samenhang en produceert inhoud die natuurlijk leest.

Op die manier krijg je de efficiëntie van AI-generatie met de authenticiteit van menselijk schrijven.

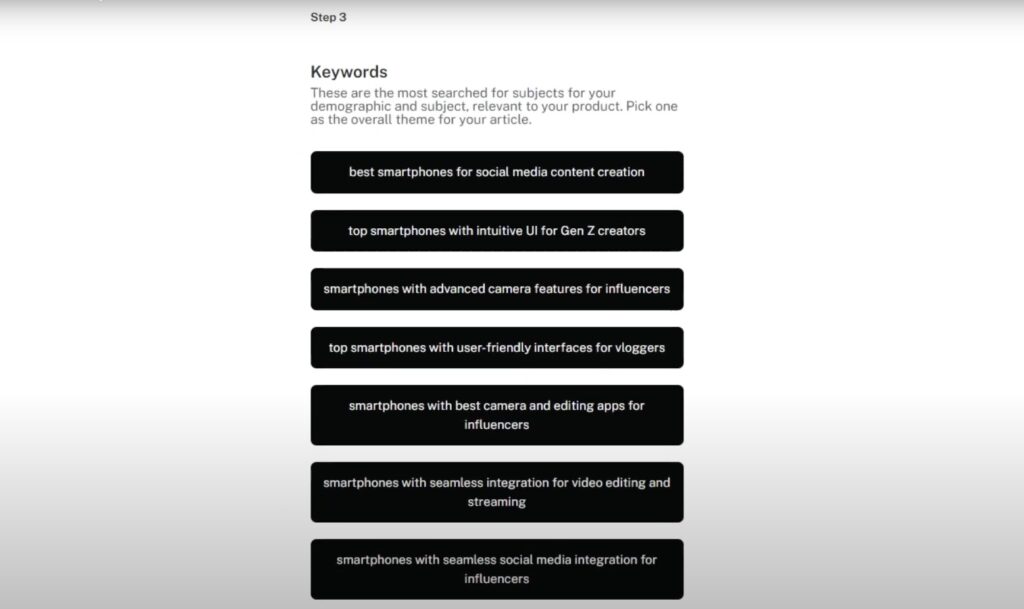

De AI SEO Content Schrijver creëert zoekgeoptimaliseerde inhoud die op natuurlijke wijze detectie triggers vermijdt.

Het begrijpt zowel SEO-vereisten als menselijke schrijfpatronen en produceert inhoud die goed scoort en de echtheidscontroles doorstaat.

Deze tool is perfect voor marketeers en content creators die hun output moeten opschalen zonder aan kwaliteit in te boeten of detectievlaggen op te werpen.

Het zorgt voor integratie van trefwoorden, metabeschrijvingen en inhoudsstructuur met behoud van natuurlijke taalstromen.

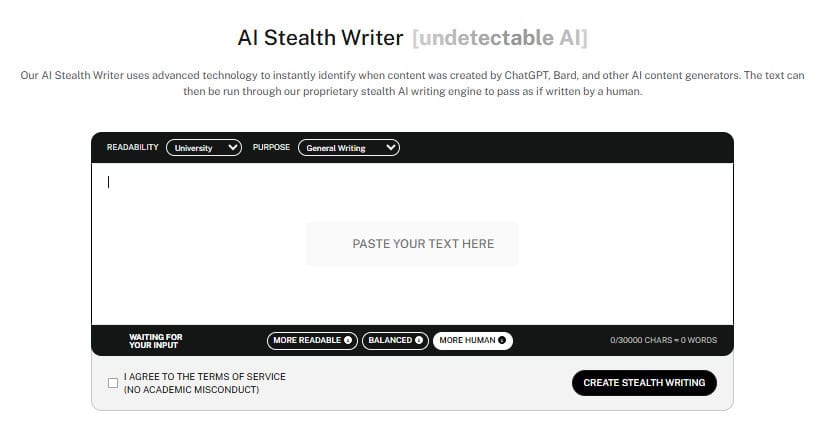

De AI Stealth Schrijver is gespecialiseerd in academisch en professioneel schrijven dat onder de radar moet blijven.

Het begrijpt de specifieke vereisten van verschillende schrijfcontexten en past zijn uitvoer daarop aan.

Of je nu werkt aan onderzoekspapers, zakelijke rapporten of technische documentatie, deze tool produceert inhoud die overeenkomt met menselijke schrijfpatronen in jouw specifieke vakgebied.

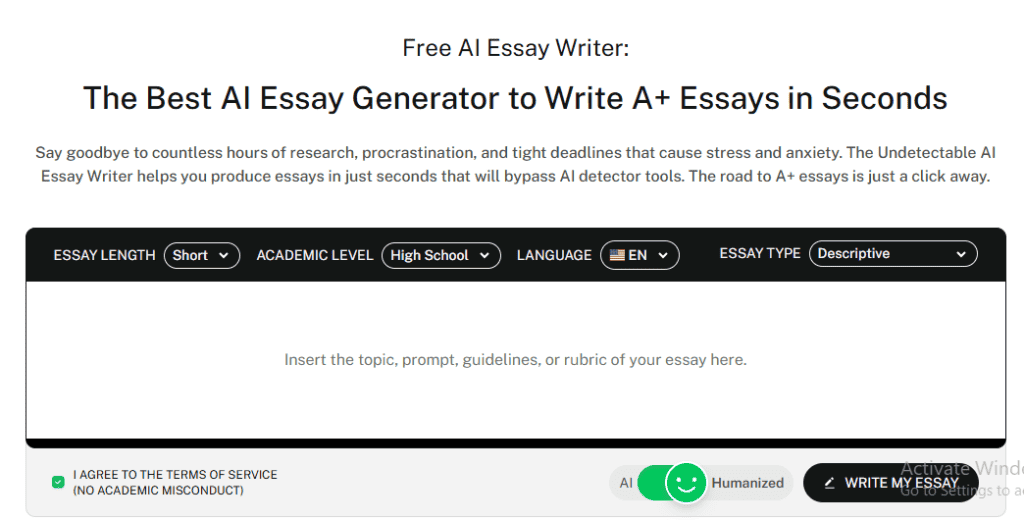

De AI Essay Schrijver maakt volledig originele essays die op natuurlijke wijze detectietriggers vermijden.

Het bevat onderzoek, ontwikkelt argumenten en structureert inhoud op de manier waarop menselijke schrijvers een essay schrijven.

Al deze tools werken samen om een complete oplossing te bieden voor iedereen die authentieke, niet detecteerbare content op schaal wil maken.

Krijg direct toegang tot onze AI Detector en Humanizer via onderstaande widget.

FAQs

Hoe betrouwbaar en nauwkeurig zijn AI-detectietools?

De nauwkeurigheid varieert tussen 60% en 80% in de beste scenario's, maar de prestaties in de praktijk zijn vaak lager.

Factoren zoals tekstlengte, schrijfstijl en nieuwere AI-modellen beïnvloeden de resultaten. Korte teksten en technisch schrijven leveren vaak valse positieven op, terwijl detectors nieuwere AI-gegenereerde inhoud kunnen missen.

Ze zijn het beste als screeningshulpmiddel, niet als definitief bewijs.

Kunnen AI-contentdetectors het mis hebben?

Ja, regelmatig. Valse positieven kunnen ten onrechte menselijk werk markeren, vooral technisch schrijven of niet-native English.

Valse negatieven laten AI er ongemerkt doorheen glippen terwijl modellen verbeteren.

Gebruik detectieresultaten als een aanwijzing, niet als definitief bewijs.

Wat is de toekomst van detectie van AI-gegenereerde inhoud?

Het is een wapenwedloop tussen slimmere AI en betere detectie. Multimodale analyse en betere trainingsgegevens zullen helpen, maar AI blijft zich ook ontwikkelen.

Verwacht meer integratie met platforms en duidelijkere regels voor AI-openbaarmaking en -gebruik.

Dit blijft een voortdurende uitdaging.

De toekomst van AI-detectie: Blijf voorop lopen

Je hebt nu dus de magie achter de werking van AI-detectors leren kennen.

Deze tools vertrouwen op grote datasets en voorspelbare patronen in AI-gegenereerde content.

Voor degenen die moeten werken met AI-gegenereerde inhoud en tegelijkertijd de authenticiteit moeten behouden, zijn er tools zoals Niet detecteerbare AI bieden geavanceerde oplossingen die de kwaliteit behouden en tegelijkertijd detectietriggers vermijden.

De toekomst zal waarschijnlijk verfijndere detectiemethoden en duidelijkere richtlijnen voor het gebruik van AI-inhoud brengen.

Maar voor nu moet de focus liggen op het maken van nuttige, accurate en waardevolle inhoud en tegelijkertijd transparant zijn over de tools en methoden die worden gebruikt in het creatieproces.

Het doel is niet om het systeem te misleiden. We willen de kracht van AI-hulp benutten en toch de authenticiteit en waarde behouden die lezers verdienen.