Mange skoler og skrivejobber bruker nå en AI-detektor som standard.

Det er ikke fordi studenter eller forfattere er utestengt fra å bruke AI-verktøy for skriving-Faktisk er det mange universiteter og byråer oppfordrer til bruk av dem.

Det som blir overvåket er hvordan de brukes.

AI-detektorer er ikke alltid til for å straffe folk for å bruke disse verktøyene (selv om det avhenger av om AI er strengt forbudt i situasjonen), ettersom de også ofte brukes til å fange opp skriving som føles for robotaktig og generisk.

AI kan brukes som skriveassistent, men det endelige verket skal høres ut som deg.

I dag er det lett å oppdage en ren AI-tekst bare ved å lese ord som ble brukt.

Men når det er uklart, hjelper AI-detektorer med å identifisere sannsynligheten for at innholdet er skapt av en AI-plattform som ChatGPT.

Men hvordan fungerer egentlig AI-detektorer?

Her er alt du trenger å vite om AI-detektorer, hvordan de fungerer, og hvordan de kan forbedre kvaliteten på AI-generert innhold.

Hva er en AI-innholdsdetektor?

En AI-innholdsdetektor er et verktøy som analyserer tekst for å finne ut om den er skrevet av et menneske eller generert av kunstig intelligens.

Det er som en digital sporhund som snuser opp mønstre, strukturer og språklige fingeravtrykk som skriker "dette er skrevet av en robot".

Disse verktøyene undersøker alt fra setningsflyt til ordvalgsfrekvens.

Aldri bekymre deg for at AI oppdager tekstene dine igjen. Undetectable AI Kan hjelpe deg:

- Få AI-assistert skriving til å vises ...menneskelignende.

- Bypass alle de viktigste AI-deteksjonsverktøyene med bare ett klikk.

- Bruk AI trygt og selvsikkert i skole og arbeid.

De ser etter tegn som mennesker vanligvis unngår, men som AI-modeller elsker, for eksempel overdrevent perfekt grammatikk, repeterende formuleringer eller mistenkelig balanserte setningsstrukturer.

Teknologien oppstod som en direkte respons på eksplosjonen av AI-skrivingsverktøy. Når ChatGPT ble lansert i slutten av 2022fikk alle plutselig tilgang til sofistikert skrivehjelp.

Lærere begynte å få essays som virket for polerte. Innholdsansvarlige la merke til at frilansernes arbeid ble merkelig konsistent.

AI-detektorer trådte inn for å fylle tomrommet, og lovet å gjenopprette orden i kaoset.

Noen fungerer bedre enn andre, men alle prøver å løse det samme problemet: å identifisere maskingenerert tekst i en verden der skillet mellom menneskelig og kunstig intelligens blir stadig mer utydelig.

De fleste AI-detektorer gir deg en prosentpoengsum. Noe sånt som "85% er sannsynligvis AI-generert" eller "12% kunstig innhold oppdaget".

Disse tallene virker presise, men de er i virkeligheten kvalifiserte gjetninger basert på mønstergjenkjenning.

Hvordan fungerer AI-detektorer?

AI-detektorer bruker to typer teknologi for å oppdage AI-generert innhold: maskinlæring og prosessorer for naturlig språk.

Begge disse gjør det mulig for AI-detektoren å identifisere forutsigbare språkmønstre, syntaks og kompleksitetsnivåer.

Hvis detektoren gjenkjenner mange nok av disse mønstrene, sannsynliggjør den at teksten er generert av kunstig intelligens.

Men hva sammenligner AI-detektorer funnene sine med? De fleste AI-detektorer har blitt trent opp på tusenvis, om ikke millioner, av datasett.

Dette hjelper detektoren med å identifisere og sammenligne teksteksemplet med AI-generert innhold som den allerede har lært.

Detektoren finner altså ikke bare mønstre i teksten som tyder på AI-generering, men den sammenligner den også med tusenvis av eksempler på AI-tekster.

Målet er å få øye på forskjellene mellom hvordan mennesker skriver og hvordan AI-modeller konstruerer tekst.

Her er hva de vanligvis ser etter:

- Perplexity score måler hvor forutsigbar teksten er. Menneskers skriving har en tendens til å være mer uforutsigbar. Vi tar merkelige ordvalg, starter setninger på en merkelig måte og skriver generelt på måter som overrasker selv oss selv. AI-modeller, derimot, har en tendens til å velge det neste ordet eller setningen som statistisk sett er mest sannsynlig.

- Burstiness-analyse undersøker variasjon i setningslengde. Mennesker skriver med en naturlig rytme. Vi veksler mellom korte, slagkraftige setninger og lengre, mer komplekse setninger. AI produserer ofte tekst med uhyggelig konsistente setningslengder og -strukturer.

- Semantiske mønstre avslører hvordan ideer flyter fra den ene til den neste. Menneskelige skribenter gjør logiske sprang, tar avstikkere og vender noen ganger tilbake til tidligere poenger. AI har en tendens til å følge mer lineære, forutsigbare tankemønstre.

- Fordeling av ordforråd ser på hyppigheten av ordvalg. Mennesker har favorittord og fraser som vi bruker for mye, og vi unngår også enkelte ord helt. AI-modeller har ulike ordforrådspreferanser basert på opplæringsdataene deres.

For dem som lager akademisk arbeid, for eksempel forskningssøknader, handler det ikke bare om å oppdage AI-innhold - det handler også om å verifisere sannhetsgehalten.

Det er der TruthScan kommer inn. TruthScan er utviklet for å støtte utdanningssektoren, og markerer ikke bare AI-genererte skrifter.

Den bidrar til å bekrefte påliteligheten til påstandene dine, fremheve fakta som ikke er underbygget, og foreslå revisjoner for å holde forskningen din akademisk forsvarlig.

Vanlige problemer med de fleste AI-sjekkere

AI-detektorer er ikke perfekte.

Faktisk.., noen av dem er ganske mangelfulle. Det er viktig å forstå begrensningene deres hvis du er avhengig av dem i viktige beslutninger.

| Vanlige problemer med AI-detektorer | Påvirkningsnivå | Frekvens |

| Falske positiver | Høy | Svært vanlig |

| Treningsskjevhet | Medium | Vanlig |

| Modellforsinkelse | Høy | Løpende |

| Kontekstblindhet | Medium | Universell |

| Terskelforvirring | Lav | Vanlig |

- Falske positive resultater er utbredt. Mange AI-detektorer flagger perfekt menneskeskrevet innhold som kunstig. Dette skjer spesielt med innhold som ikke er engelskspråklig, teknisk skriving eller innhold som følger visse formateringskonvensjoner.

- Treningsskjevhet påvirker resultatene. De fleste AI-detektorer er primært trent opp på engelsk innhold fra spesifikke kilder. De sliter med andre språk, kulturelle skrivestiler eller spesialiserte domener. En teknisk håndbok kan få høy score for AI-deteksjon bare fordi den bruker et presist, formelt språk.

- De klarer ikke å holde tritt med nye AI-modeller. AI-skriveteknologien utvikler seg raskt, og nye modeller produserer mer menneskelignende tekst. Men det tar tid for detektorene å tilpasse algoritmene sine. Det er ofte en forsinkelse før nytt AI-generert innhold blir fanget opp.

- Konteksten er viktig, men noen detektorer forstår den ikke. En medisinsk forskningsartikkel og et personlig blogginnlegg har helt forskjellige skrivekonvensjoner. De fleste AI-detektorer bruker imidlertid de samme analysekriteriene på begge, noe som fører til inkonsekvente og upålitelige resultater.

- Terskelforvirring skaper problemer. Hvor stor prosentandel utgjør "AI-genererte"? 50%? 80%? 95%? Ulike verktøy bruker ulike terskelverdier, og brukerne forstår ofte ikke hva tallene egentlig betyr.

- Lengdeavhengigheten gir skjeve resultater. Korte tekster er vanskeligere å analysere nøyaktig. Et svar på to setninger kan bli flagget som AI rett og slett fordi det ikke er nok innhold til å etablere klare mønstre. Lengre tekster gir generelt mer pålitelige deteksjonsresultater.

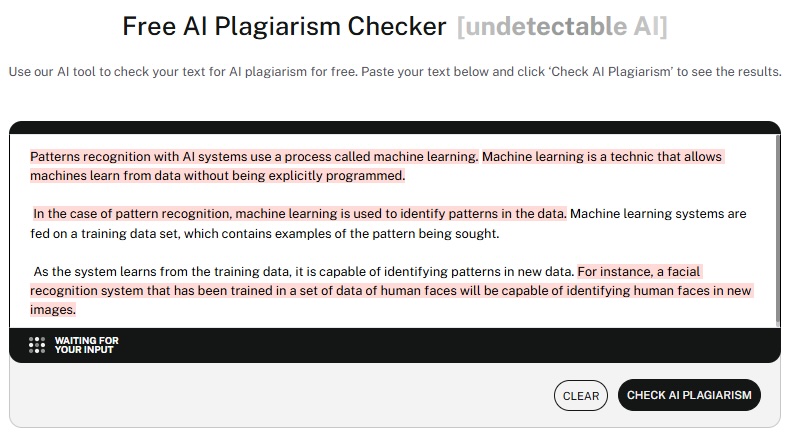

AI-detektorer vs. plagiatkontroller

Hvis du har forsket på AI-detektorer, har du utvilsomt også støtt på plagiatkontrollere.

Hva er forskjellen mellom en AI-detektor og en plagiatkontroll?

En plagiatkontroll skanner teksten og sammenligner den med en enorm database med publiserte arbeider på Internett.

I motsetning til en AI-detektor bryr ikke en plagiatkontroll seg om hvem eller hva som har skapt innholdet, men om innholdet er kopiert fra en annen kilde.

AI-detektorer analyserer derimot skrivemønstre.

De bryr seg ikke om innholdet finnes andre steder. De vil vite om det opprinnelig ble skrevet av et menneske eller en maskin.

Tenk på det på denne måten: Plagiatkontrollører spør: "Er dette stjålet?", mens AI-detektorer spør: "Er dette kunstig skapt?"

Verktøyene bruker helt forskjellige teknologier. Plagiatkontrollere baserer seg på store databaser og algoritmer som matcher strenger.

AI-detektorer bruker maskinlæringsmodeller som er opplært i å gjenkjenne skrivemønstre.

De har også ulike formål. Plagiatkontrollere beskytter intellektuell eiendom og akademisk integritet, mens AI-detektorer verifiserer innholdets autentisitet og menneskelig forfatterskap.

Hvis en frase samsvarer med fem eller flere påfølgende ord fra en annen kilde, flagges den vanligvis som plagiat.

Kan plagiatsjekkere oppdage AI-generert innhold?

Selv om plagiatkontrollens jobb ikke er å oppdage AI-generert innhold, hender det av og til at de to overlapper hverandre.

Hvorfor skulle dette skje?

Tro det eller ei, men noen AI-språkmodeller har levert plagiert innhold som resultat.

Det er ikke sikkert at det er med vilje, men AI-verktøy kan ved et uhell kopiere fraser fra en annen kilde på Internett.

Dette er et annet rødt flagg for å utgi AI-generert innhold for å være ditt eget. Skribenter bør være ekstra påpasselige med å kjøre innholdet sitt gjennom en plagiatkontroll.

Det finnes en gråsone når det gjelder AI-verktøy for å oppdage plagiat, men hvis du er en betalt skribent som publiserer plagiat, kan det få konsekvenser i det virkelige liv.

Forskjellen mellom AI-innhold og plagiert innhold

Selv om det av og til er overlapping mellom de to innholdstypene, befinner de seg vanligvis i hver sin ende av spekteret.

AI-generert innhold er ofte originalt, selv om det er skrevet i en mekanisk stil.

Dette innholdet må faktasjekkes av en menneskelig skribent og skannes for potensielt plagiat før det sendes inn eller publiseres.

Plagiert innhold kan produseres av enten en menneskelig skribent eller et AI-verktøy. Når et menneske lager plagiert innhold, er det som regel med vilje.

Hvis et AI-verktøy skaper plagiert innhold, er det nesten alltid ved et uhell.

Til tross for denne forskjellen bør innholdet likevel skannes for plagiat, uansett om det er skrevet av et menneske eller et AI-verktøy.

Straffer Google AI-generert innhold

Dette er et spørsmål med flere lag av svar.

På overflaten straffer ikke Google nettsteder for publisering av AI-generert innhold.

Googles oppdaterte retningslinjer bryr seg ikke om du bruker AI-tekst, AI-bildereller annen form for AI-innhold på nettstedet ditt.

Siden din vil ikke bli fjernet, og annonseinntektene dine vil heller ikke bli redusert.

Men det er viktige forbehold.

- Kvalitet fremfor kilde er Googles offisielle holdning. De bryr seg mer om hvorvidt innholdet er nyttig, nøyaktig og verdifullt for brukerne enn om det er skapt av et menneske eller en kunstig intelligens. Algoritmen deres evaluerer innhold basert på E-A-T-prinsippene: Erfaring, ekspertise, autoritet og troverdighet.

- Offentliggjøring er ikke påkrevd i henhold til Googles retningslinjer. Du trenger ikke å merke AI-generert innhold som sådan. Du er imidlertid fortsatt ansvarlig for kvaliteten og nøyaktigheten i alt du publiserer.

- Masseprodusert innhold av lav kvalitet er der problemene oppstår. Hvis du bruker kunstig intelligens til å generere tonnevis av tynt, unyttig innhold bare for å målrette mot søkeord, vil Google sannsynligvis straffe det. Men dette gjelder alt masseprodusert innhold, enten det er AI-generert eller menneskeskrevet.

- Nylige algoritmeoppdateringer har lagt vekt på innholdskvalitet fremfor kvantitet. Googles system for nyttig innhold retter seg spesifikt mot innhold som ser ut til å være laget primært for søkemotorer og ikke for mennesker. AI-generert innhold som faller inn i denne kategorien, vil slite med rangeringen.

Flere fremtredende nettsteder bruker AI-verktøy til å lage innhold og har ikke blitt straffet når det gjelder SEO-rangering.

Men det Google har gjort, er å oppdatere algoritmen for søkerangering.

I en nylig publisert oppdaterte SQO-retningslinjerI sin artikkel om "Førstehåndserfaring" understreket Google at førstehåndserfaring og det å være en erfaren ekspert på emnet er avgjørende for at siden skal rangeres godt.

Hvis du bruker AI-innhold, vil det ikke inneholde førstehåndskunnskap eller -erfaring, siden det bare kan gis av et menneske.

Straffer Google plagiert innhold?

Selv om man kanskje skulle tro at dette var en åpenbar straff, er det overraskende å vite at Google ikke straffer plagiert innhold.

Nesten 30% av nettsteder har duplisert innhold, noe som vil kreve at Google straffer millioner av nettsteder.

Googles søkeadvokat John Mueller har avslørt at duplisert innhold ikke vil påvirke søkerangeringen din.

Hvis Google-algoritmen finner det samme innholdet på flere sider, velger den hvilken side som skal rangeres, basert på hvor nyttig den er for leseren.

Den dårlige nyheten er at hvis noen kopierer innholdet ditt, kan de potensielt rangere høyere enn deg ved hjelp av arbeidet ditt.

Det er enkelt å forebygge: Lag originalt innhold, eller skriv riktig kildehenvisning og lisensier innhold du bruker fra andre kilder.

De fleste vellykkede nettsteder har strenge retningslinjer mot plagiat.

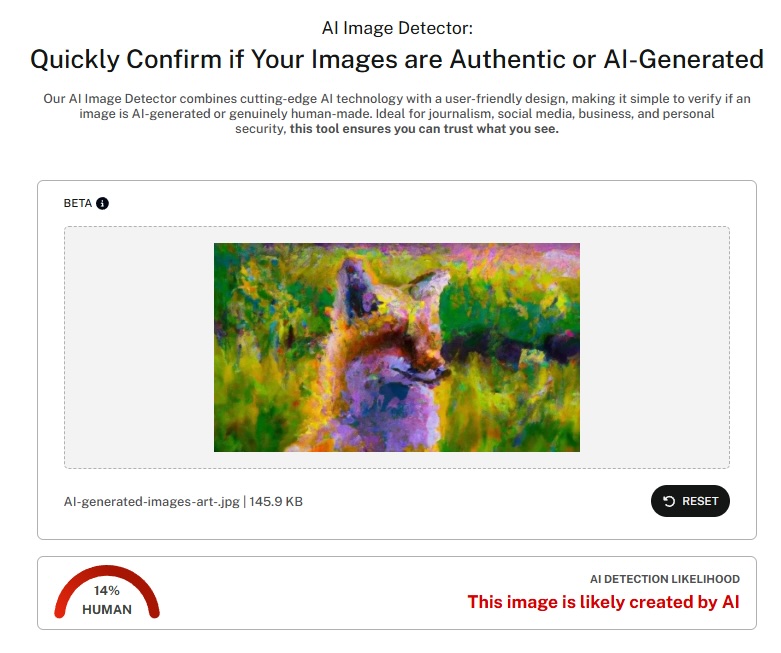

Apropos deteksjon, Undetectable AI lanserte nylig en bildedetektor som kan identifisere AI-genererte bilder.

Dette AI-bildedetektor tar for seg den økende bekymringen for syntetisk visuelt innhold, som et supplement til tekstbaserte deteksjonsfunksjoner.

Hvordan gjør jeg AI-tekst umulig å oppdage?

For å gjøre AI-tekst umulig å oppdage, må man forstå hvordan deteksjonsalgoritmene fungerer og endre innholdet strategisk for å unngå at de utløses.

- Varier setningsstrukturen din dramatisk. AI har en tendens til å produsere konsistente setningslengder og -mønstre. Bland korte, slagkraftige setninger med lengre, komplekse setninger. Legg inn noen fragmenter for å understreke. Endre rytmen din hele tiden.

- Legg til personlige innslag og opplevelser. AI-innhold mangler ofte personlige anekdoter, konkrete eksempler og menneskelige særegenheter. Legg inn dine egne historier, meninger og unike perspektiver. Disse elementene er nesten umulig for kunstig intelligens å gjenskape på en autentisk måte.

- Innfør tilsiktede ufullkommenheter. Mennesker gjør små grammatiske feil, bruker talemåter og skriver med naturlige ufullkommenheter. Perfekt grammatikk og feilfri struktur kan utløse AI-deteksjon. Legg til litt menneskelighet i det du skriver.

- Bruk uventede ordvalg. AI-modeller har en tendens til å velge et forutsigbart vokabular. Velg overraskende synonymer, bruk slang på en passende måte, og unngå overdrevent formelt språk med mindre konteksten krever det.

- Rediger i stor utstrekning etter AI-generering. Ikke bare fiks grammatikk og rettskriving. Omstrukturer avsnitt, omorganiser ideer og skriv om deler med din egen stemme. Jo mer menneskelig redigering som er involvert, desto mindre synlig blir AI-opphavet.

- Bryt opp forutsigbare mønstre. Hvis innholdet ditt følger en veldig logisk, lineær struktur, bør du riste litt i den. Legg til tangenter, gå tilbake til tidligere poenger, og la tankene flyte mer naturlig.

Målet er ikke å lure, men å skape innhold som virkelig gjenspeiler menneskelige tankeprosesser og skrivemønstre.

Be AI om å skrive om innholdet ditt

Tro det eller ei, men du kan be verktøy som ChatGPT eller Jasper.AI om å skrive om sitt eget innhold.

Du kan til og med bruke spesifikke innganger som instruerer appen til å bruke et mer naturlig språk.

Hvis du skriver om innholdet med den samme appen, tvinges du til å bruke et annet språk og vokabular.

Merkelig nok vil en andre eller til og med tredje gangs gjennomgang gi mye mer positive resultater når man kjører dette innholdet gjennom en AI-detektor.

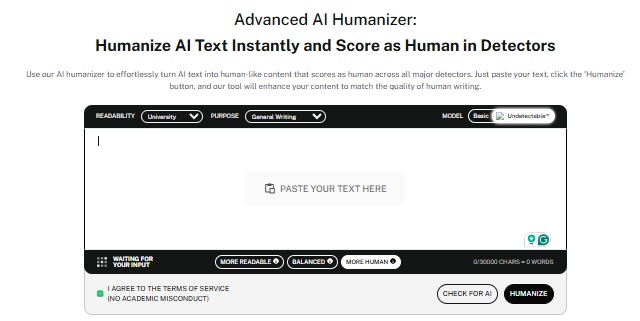

Bruk AI-verktøy for kryptering

Hvis du rett og slett ikke har tid til å redigere alle artiklene dine manuelt, kan det være en gave fra himmelen å bruke AI-krypteringsverktøy.

Disse verktøyene kan ta det AI-genererte innholdet og menneskeliggjøre det ved å omorganisere det på en måte som gjør at det består AI-detektortestene.

AI-humaniserende verktøy vet nøyaktig hva AI-detektorene ser etter, og kan bruke dette på innholdet ditt. Hvis du fortsatt blir flagget av en AI-detektor, kan du kjøre innholdet ditt gjennom AI-scrambleren flere ganger.

For hver gang bør resultatet bli mer raffinert og øke sjansen for at AI-teksten ikke kan oppdages.

Og hvis du vil ha den best mulige løsningen, bør du lese neste emne:

Det beste verktøyet for å gjøre AI-innhold umulig å oppdage

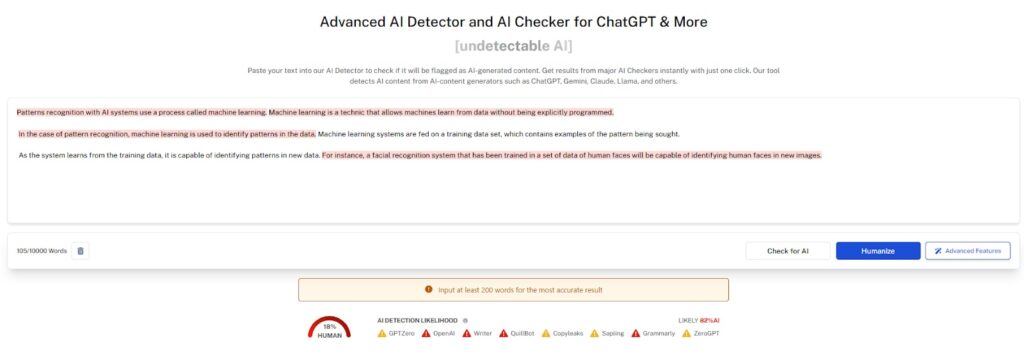

Når det gjelder å gjøre AI-innhold umulig å oppdage samtidig som kvaliteten opprettholdes, er Undetectable AI markedsledende med en omfattende pakke med verktøy som er utviklet for ulike innholdsbehov.

Den AI-detektor og humanizer kombinerer deteksjon og modifisering i én og samme plattform. Først analyserer den innholdet ditt for å identifisere AI-genererte seksjoner.

Deretter omskriver den disse delene slik at de høres mer menneskelige ut, samtidig som den opprinnelige meningen og hensikten bevares.

Humanizer bruker ikke bare tilfeldige ord eller legger til feil, men forstår konteksten, opprettholder sammenhengen og produserer innhold som leses naturlig.

På den måten får du effektiviteten til AI-generering med autentisiteten til menneskelig skriving.

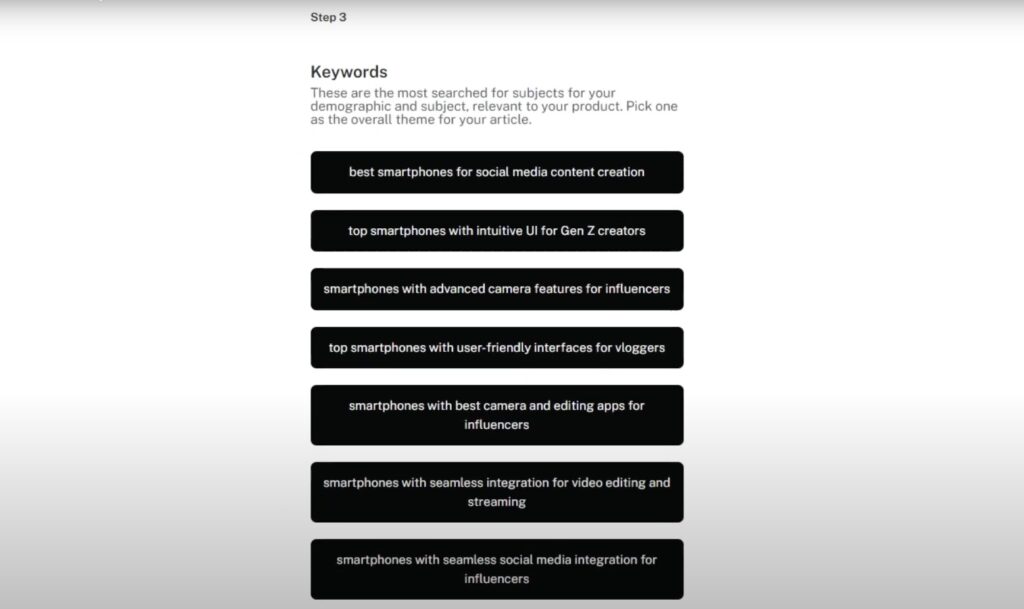

Den AI SEO-innholdsforfatter skaper søkeoptimalisert innhold som på en naturlig måte unngår å bli oppdaget.

Den forstår både SEO-krav og menneskelige skrivemønstre, og produserer innhold som rangerer godt og består autentisitetskontroller.

Dette verktøyet er perfekt for markedsførere og innholdsskapere som har behov for å skalere produksjonen sin uten at det går på bekostning av kvalitet eller oppdagelsesflagg.

Den håndterer integrering av søkeord, metabeskrivelser og innholdsstruktur samtidig som den naturlige språkflyten opprettholdes.

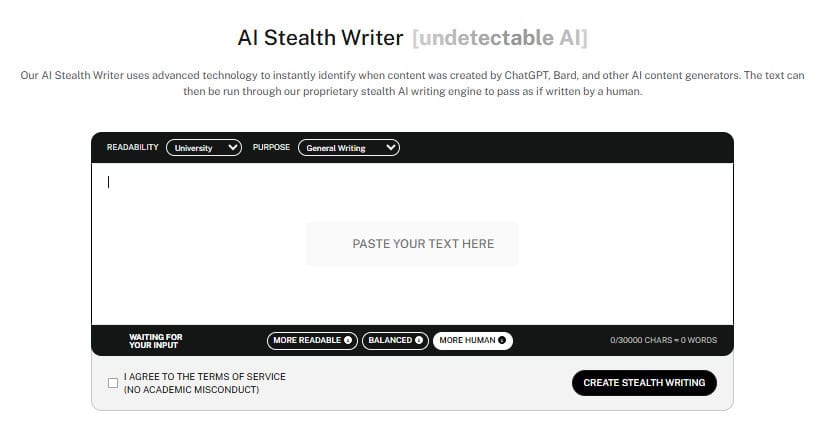

Den AI Stealth Writer spesialiserer seg på akademisk og profesjonell skriving som må fly under radaren.

Den forstår de spesifikke kravene som stilles i ulike skrivekontekster, og tilpasser utdataene deretter.

Enten du jobber med forskningsartikler, forretningsrapporter eller teknisk dokumentasjon, produserer dette verktøyet innhold som samsvarer med menneskelige skrivemønstre på ditt spesifikke felt.

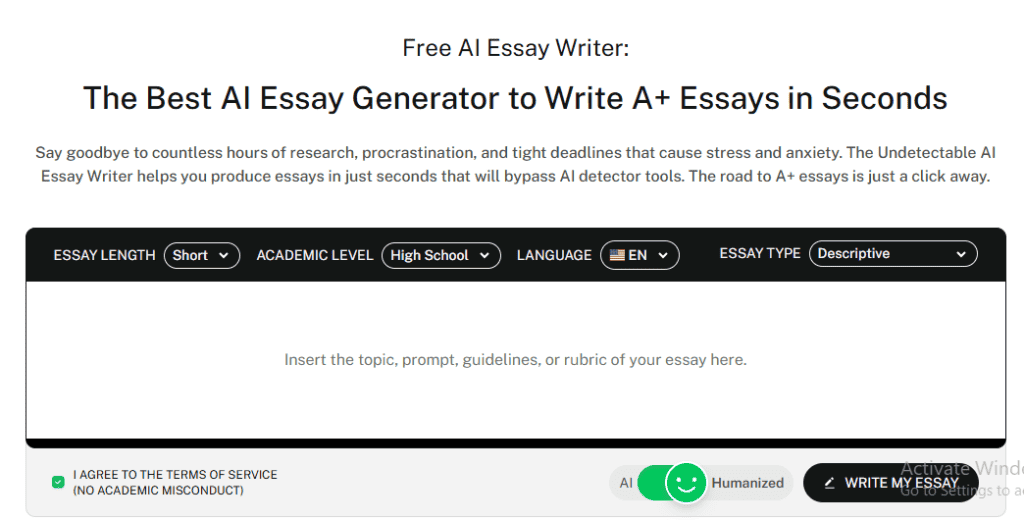

Den AI Essay Writer lager helt originale essays fra bunnen av som naturligvis unngår å bli oppdaget.

Den innlemmer forskning, utvikler argumenter og strukturerer innholdet på samme måte som menneskelige skribenter gjør når de skriver essay.

Alle disse verktøyene fungerer sammen og utgjør en komplett løsning for alle som har behov for å skape autentisk, uoppdagelig innhold i stor skala.

Få tilgang til AI Detector og Humanizer direkte via widgeten nedenfor.

Ofte stilte spørsmål

Hvor pålitelige og nøyaktige er AI-detektorverktøyene?

Nøyaktigheten varierer mellom 60% og 80% i beste fall, men i virkeligheten er ytelsen ofte lavere.

Faktorer som tekstlengde, skrivestil og nyere AI-modeller påvirker resultatene. Korte tekster og tekniske tekster gir ofte falske positiver, mens detektorer kan overse nyere AI-generert innhold.

De er best som screeningverktøy, ikke som endelige bevis.

Kan AI-innholdsdetektorer ta feil?

Ja, med jevne mellomrom. Falske positiver kan feilaktig flagge menneskelig arbeid, spesielt teknisk skriving eller engelsk som ikke er morsmål.

Falske negativer gjør at AI slipper uoppdaget gjennom etter hvert som modellene forbedres.

Bruk detektorresultatene som en ledetråd, ikke som et endelig bevis.

Hva er fremtiden for deteksjon av AI-generert innhold?

Det er et våpenkappløp mellom smartere AI og bedre deteksjon. Multimodal analyse og bedre treningsdata vil hjelpe, men AI-skriving fortsetter også å utvikle seg.

Forvent mer integrasjon med plattformer, samt klarere regler for offentliggjøring og bruk av AI.

Dette vil forbli en kontinuerlig utfordring.

Fremtiden for AI-deteksjon: Hold deg i forkant

Nå har du altså lært om magien bak hvordan AI-detektorer fungerer.

Disse verktøyene baserer seg på store datasett og forutsigbare mønstre i AI-generert innhold.

For de som trenger å jobbe med AI-generert innhold og samtidig opprettholde autentisitet, kan verktøy som Ikke påvisbar AI tilbyr sofistikerte løsninger som bevarer kvaliteten samtidig som man unngår utløsende faktorer for deteksjon.

Fremtiden vil sannsynligvis by på mer sofistikerte deteksjonsmetoder og klarere retningslinjer for bruk av AI-innhold.

Men inntil videre bør fokuset ligge på å skape nyttig, nøyaktig og verdifullt innhold, samtidig som man er åpen om verktøyene og metodene som brukes i produksjonsprosessen.

Målet er ikke å lure systemet. Vi ønsker å utnytte kraften i AI-assistanse samtidig som vi opprettholder den autentisiteten og verdien som leserne fortjener.