Der er én ting, som har været på alles læber de sidste par år: ChatGPT.

Lærere bekymre sig om, at det er at skrive elevernes lektier.

Forfattere frygter, at AI vil skrive bøger og historier i stedet for dem.

Kodere er bange for, at den vil bygge hjemmesider og apps bedre, end mennesker kan.

Nogle forudsiger endda, at Millioner af job kan forsvinde på grund af AI.

Vi har alle hørt om det. Men har du nogensinde undret dig over hvordan Virker ChatGPT?

Hvordan skriver ChatGPT et barns lektier? Hvad sker der bag kulisserne, når du skriver et spørgsmål, og den svarer som en rigtig person?

Hvordan kan en maskine skrive digte, historier og kode, selv om den ikke forstår ord på samme måde som os?

I denne blog, Vi kigger indenfor ChatGPT og forklare, hvad ChatGPT er, og hvordan det fungerer, trin for trin.

Du vil lære, hvordan den husker ting, hvad dens begrænsninger er, og hvordan værktøjer som dette overhovedet er bygget.

Lad os komme i gang!

Fundamentet: GPT-sprogmodeller

ChatGPT er en AI, der er lavet til at forstå og skrive som et menneske.

Det kaldes en sprogmodel fordi den arbejder med sprog - læser det, forudsiger det og genererer det.

Men den forstår ikke, som mennesker gør. Den tænker ikke. Den kender ikke til fakta. Den ser bare på mønstre.

Du skal aldrig bekymre dig om, at AI opdager dine tekster igen. Undetectable AI Kan hjælpe dig:

- Få din AI-assisterede skrivning til at fremstå Menneskelignende.

- Bypass alle større AI-detektionsværktøjer med bare ét klik.

- Brug AI sikkert og selvsikkert i skolen og på arbejdet.

For eksempel,

- Hvis du skriver, "Himlen er..."

- Der kan stå "Blå."

Ikke fordi den ved, at himlen er blå, men fordi den har set den sætning millioner af gange under træningen. Den har lært, at "blå" ofte kommer efter "himlen er".

Denne type AI kaldes en LLMsom står for Stor sprogmodel.

Den er trænet på tonsvis af lærebøger, hjemmesider og meget mere for at finde ud af, hvordan mennesker bruger ord. Men den læser ikke efter betydning. Den lærer, hvordan ord normalt optræder ved siden af hinanden.

GPT er en særlig form for LLM.

GPT står for "Generativ prætrænet transformator".

- Generativ - kan den skabe ny tekst.

- Forudgående trænet - den lærer, før den taler til dig.

- Transformator - nøgleteknologien bag, hvordan ChatGPT fungerer, som hjælper den med at forstå, hvordan ord relaterer til hinanden i en sætning, et afsnit eller endda en samtale.

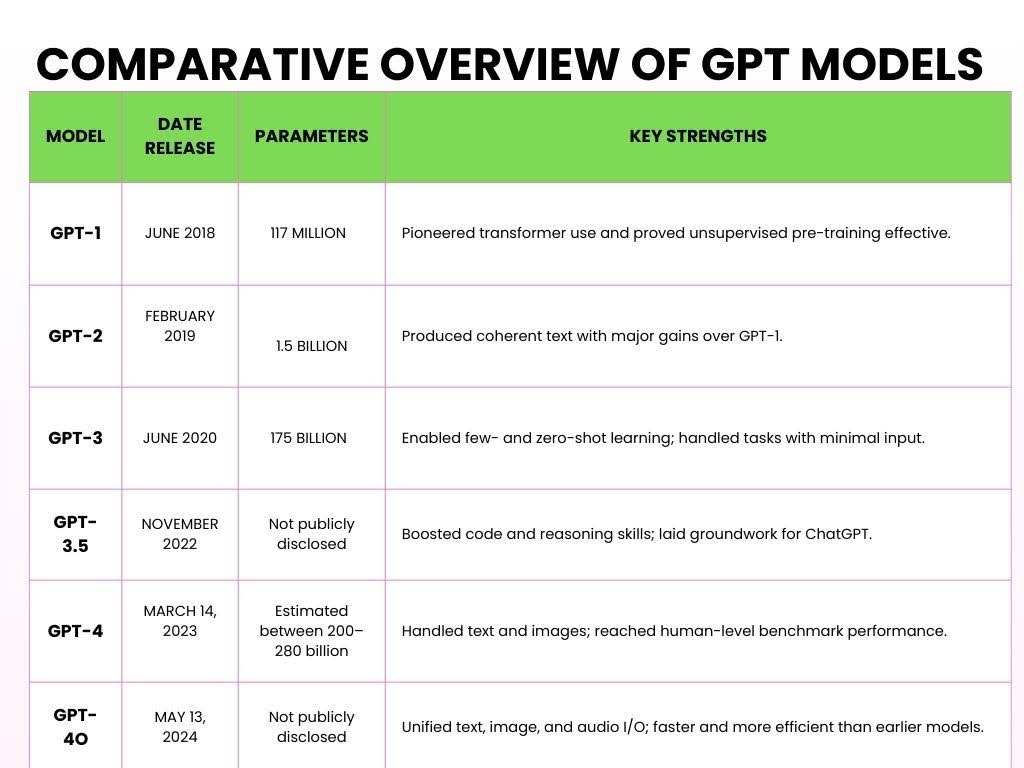

Her er de forskellige versioner af GPT, der er blevet lanceret i årenes løb.

Sådan fungerer ChatGPT

Her er en forenklet oversigt over, hvordan ChatGPT fungerer og behandler dine input i fem vigtige trin.

- Trin 1: Forudgående træning på massive data

Store sprogmodeller (LLM'er) som ChatGPT er prætrænet ved at behandle store mængder tekst fra internettet for at lære sprogmønstre.

Under fortræningen behandler modellen Billioner af tokens (små stykker tekst).

A symbol kan være et ord, en del af et ord eller endda tegnsætning, afhængigt af hvordan modellen tokeniserer inputtet.

For eksempel,

Du stiller ChatGPT et matematisk spørgsmål, som f.eks:

Problem:

- 2 + 3 = ?

Under træningen læser ChatGPT hundredvis af milliarder af ord fra bøger, nyheder, artikler, Wikipedia, historier, videnskabelige artikler og endda Reddit-tråde.

Denne træning og læsning hjælper den med at forstå, hvordan addition fungerer.

For eksempel,

Den kan måske lære Kommutativ egenskab (f.eks. 2 + 3 = 3 + 2) gennem sådanne sammenhænge.

ChatGPT ser mange eksempler som

- "2 + 3 = 5,"

- "7 + 8 = 15,"

- "9 + 4 = 13."

Den lærer ikke kun disse specifikke eksempler, den lærer additionsmønsteret.

Den forstår, hvordan tal interagerer med "+"-symbolet, og hvordan resultatet typisk følger "="-symbolet.

- Trin 2: Transformerens arkitektur

Da ChatGPT havde set en enorm mængde ord, havde den brug for en hjerne, der kunne give mening til al den information. Denne AI-hjerne hedder "Transformer."

Det, der adskiller Transformer, er dens evne til at fokusere opmærksomheden på de vigtigste dele af inputtet, ligesom vi behandler sprog.

For eksempel,

Lad os anvende dette på et matematisk problem:

- "Hvad er summen af 5 og 7?"

Når Transformer behandler dette, går den ikke bare ord for ord.

I stedet ser den på hele konteksten - "sum", "5" og "7" - på én gang.

Den anerkender, at "sum" refererer til "tilføjelse" og at "5" og "7" er de involverede tal.

Transformeren giver derefter mere "opmærksomhed" til de ord, der har direkte indflydelse på svaret, så den fokuserer på operationen ("sum") og tallene ("5" og "7").

Dette er en vigtig del af, hvordan ChatGPT fungerer - det ikke behandler problemet lineært, men på en måde, der hjælper den med at forstå forholdet mellem elementerne.

Det er denne evne til at se alt i en sammenhæng, der gør Transformer så stærk.

I stedet for bare at finde ud af, hvad der kommer bagefter, forstår den meningen ved at koble de relevante dele af sætningen sammen.

Desuden betyder det ofte, at man skal lære et helt nyt ordforråd, når man træder ind i et nyt onlinefællesskab, men man behøver ikke vente i flere måneder, før man kan begynde at tale sproget.

Desuden, hvis du ønsker at hjælpe dine beskeder med at passe perfekt ind, er Undetectable AI's Akronym-generator giver dig mulighed for at oprette brugerdefinerede forkortelser, der efterligner de komplekse mønstre, som AI-modeller bruger til at behandle og generere strukturerede sproglige forkortelser.

- Trin 3: Tokenisering og sprogbehandling

Når du skriver tekst i ChatGPT, deler den din prompt op i små symboler.

Nogle tokens er hele ord, mens andre kun er dele af ord.

For eksempel,

Når du indtaster "ChatGPT er smart," ChatGPT opdeler det i følgende tokens:

["Chat", "G", "PT", "er", "smart"].

Selv navnet "ChatGPT" bliver delt op i forskellige tokens.

Denne proces kaldes tokenisering. Fordi modellerne er blevet trænet på tokens i stedet for hele ord, er det meget mere fleksibelt, hvad den kan håndtere:

Flere sprog (da forskellige sprog har forskellige ordstrukturer),

Slang og forkortelser (som "u" for "you" eller "idk" for "I don't know").

Selv opdigtede ord eller variationer (som at dele "utroligt" op i "un", "believ", "able").

- Trin 4: Finjustering og sikkerhedslag

Når ChatGPT er blevet trænet på en stor mængde data, er den ikke helt klar til prime time.

Den har stadig brug for hjælp til at sikre, at den reagerer på den mest nyttige, høflige og sikre måde.

Igennem overvåget finjusteringgiver menneskelige bedømmere ChatGPT eksempler på, hvad der er et godt svar. For eksempel,

- "Hvad er 5 + 7?"

- Dårligt svar: Det er et nemt spørgsmål. Hvorfor ved du ikke det her?

- Godt svar: Summen af 5 og 7 er 12.

Med tiden trænes ChatGPT med bedre eksempler til at blive mere høflig, klar og fokuseret.

Når den har et solidt fundament, får den mere avanceret hjælp gennem Forstærkningslæring fra menneskelig feedback (RLHF).

Denne proces foregår på denne måde:

- ChatGPT svarer.

- Menneskers hastighed Det svar er baseret på, hvor godt det er - hvor nyttigt, præcist og sikkert det er.

- ChatGPT lærer af denne feedback og forsøger at give bedre svar i fremtiden.

For eksempel, Forestil dig, at ChatGPT besvarer et matematisk problem, f.eks. "Hvad er 12 divideret med 4?":

- ChatGPT svarer: "3."

- Menneskelig feedback: Dette svar er fantastisk.

- ChatGPT lærer af det: Den bliver ved med at give denne type svar, når lignende spørgsmål dukker op.

Målet er, at ChatGPT bliver ved med at forbedre sig, ligesom en studerende, der lærer af tidligere fejl.

Endelig er et vigtigt formål med at finjustere mennesker stemmer overens med menneskelige værdier.

Det skal ikke bare være smart, men også hjælpsomt, harmløst og ærligt.

For eksempel, hvis en bruger stiller et komplekst spørgsmål som f.eks, "Hvad er kvadratroden af -1?"

I stedet for at give et forkert svar som "jeg er svaret" uden nogen kontekst, ville det give:

Sikkert, tilpasset svar: Kvadratroden af -1 er et imaginært tal, almindeligvis repræsenteret som 'i'. Dette koncept bruges i avanceret matematik.

- Trin 5: Opfordring ind, svar ud

Dette er det sidste trin, hvor ChatGPT er klar til at besvare dine spørgsmål.

En prompt er den tekst (f.eks. et spørgsmål, en kommando eller et udsagn), du skriver i ChatGPT for at starte samtalen og få et svar.

For eksempel,

Du indtaster prompten "Hvordan er vejret i dag?"

Sådan fungerer ChatGPT bag kulisserne:

Du skriver en besked → ChatGPT opdeler den i symboler → Den leder efter mønstre i symbolerne → Forudser det næste ord → Danner et svar → Justerer tonen baseret på din tekst → Får dit endelige svar

For prompten "Hvordan er vejret i dag?", ChatGPT ville sandsynligvis svare med noget i retning af:

"Jeg kan ikke give vejropdateringer i realtid, men du kan tjekke et vejrsite eller en app som Weather.com eller dine lokale nyheder for at få de mest præcise oplysninger."

Det skyldes, at ChatGPT ikke har adgang til live-data, medmindre den er forbundet med et værktøj, der henter oplysninger i realtid.

Hvordan den "husker" samtaler

Når man taler med ChatGPT, virker det, som om den husker ting, man har sagt tidligere.

Og det gør det - men kun mens chatten er åben. Forestil dig en stor notesblok, hvor alt, hvad du skriver, bliver skrevet ned:

Det siger du:

- Min hund hedder Max.

Et par linjer senere siger du:

- Hvilke tricks kan Max lære?

ChatGPT forbinder prikkerne. Den husker, at Max er din hund, fordi den stadig står på notesblokken.

Denne notesblok kaldes en kontekstvindue, og den indeholder et begrænset antal ord (kaldet tokens).

Nogle versioner kan rumme omkring 8.000 tokens, mens de nyeste kan gå op til 32.000 tokens.

Men når du når grænsen, må den begynde at slette de ældste dele for at gøre plads til ny tekst.

Så hvis du siger "Min hund hedder Max" helt tilbage i starten af en lang chat - og så 50 afsnit senere spørge, "Hvad er en god snor til ham?" - så glemmer den måske, hvem "han" er.

Fordi den information allerede er slettet fra notesblokken.

Lad os nu tale om hukommelse mellem chats.

Normalt bliver notesblokken slettet, når du lukker chatten.

Så næste gang du åbner ChatGPT, starter den på en frisk.

Men hvis du slår brugerdefineret hukommelse til, kan ChatGPT huske ting på tværs af sessioner. For eksempel,

- Du fortæller det: Jeg driver et lille online-bageri, der hedder Sweet Crumbs.

- En uge senere siger du: Skriv en produktbeskrivelse til mig.

- Det kunne være et svar: Selvfølgelig! Her er en beskrivelse af dine Sweet Crumbs-kager...

Den husker ikke alt. Den husker kun det, du tillader, og du får besked, når noget bliver tilføjet. Du kan til enhver tid se, redigere eller slette minder.

Så det korte af det lange er ...

ChatGPT gør det faktisk ikke "Husk" som en person. Den ser bare på det, der er foran den - den aktuelle samtale.

Hvis det ser ud, som om den husker noget fra tidligere, er det, fordi den information stadig er inde i kontekstvinduet.

Begrænsninger i, hvordan ChatGPT fungerer

ChatGPT er utroligt nyttigt, men det er vigtigt at forstå dets begrænsninger, især hvis du bruger det til noget kundeorienteret eller konverteringsdrevet.

1 - Ingen reel forståelse eller bevidsthed

ChatGPT forstår ikke indhold, som mennesker gør. Den "kender" ikke fakta - den forudsiger blot det næste sandsynlige ord baseret på træningsdata.

For eksempel,

Hvis du spørger, "Hvad betyder succes?" Den genererer måske en flydende respons, men den har ikke overbevisninger, værdier eller bevidsthed. Den efterligner mønstre, den skaber ikke indsigt.

2 - Skævheder fra træningsdata

Fordi ChatGPT er trænet på store, blandede kilder fra internettet, bøger, fora og artikler, kan den arve de skævheder, der findes i disse data.

Hvis internettet hælder i én retning om et emne, kan ChatGPT afspejle det perspektiv - nogle gange subtilt, andre gange ikke - selv når neutralitet er påkrævet.

3 - Surfer ikke på internettet

ChatGPT kan ikke hente data i realtid. Spørg den om et produkt, der blev lanceret i sidste uge, eller en aktiekurs i dag, og den vil ikke have en anelse.

Dens træningsdata har en grænse, og alt efter dette punkt er uden for rækkevidde.

4 - Kan "hallucinere" fakta eller citere falske kilder

En af de mere farlige særheder: ChatGPT kan finde på ting. Spørg den om en statistik eller et citat, og den vil måske svare,

"Ifølge Verdenssundhedsorganisationen foretrækker 80% af de voksne mærke X frem for mærke Y."

Det lyder officielt - men den statistik findes sandsynligvis ikke.

Den blev ikke hentet, den blev opfundet. Dette problem er kendt som hallucinationog det er især risikabelt i forbindelse med forskning, journalistik eller teknisk indhold.

Hvis du spørger ChatGPT, hvordan det fungerer, vil du se, at det ikke altid er faktuelt korrekt.

Hvis du bruger ChatGPT til at skrive, vil outputtet føles stift, robotagtigt eller mangle den menneskelige kant.

Til sådanne nuancer kan du bruge AI Humanizer.

Den AI Humanizer omskriver ChatGPT-output til tone, nuance og følelse, så dit indhold får et hjerteslag.

Den Blødgør akavede fraseringer, tilfører varme, og får tekniske eller tørre tekster til at vække genklang hos dit publikum.

Når dit indhold lyder menneskeligt, fungerer det bedre.

Uanset om du skriver landingssider, e-mails eller LinkedIn-indlæg, er det relaterbarheden, der driver responsen. Og følelser driver konvertering.

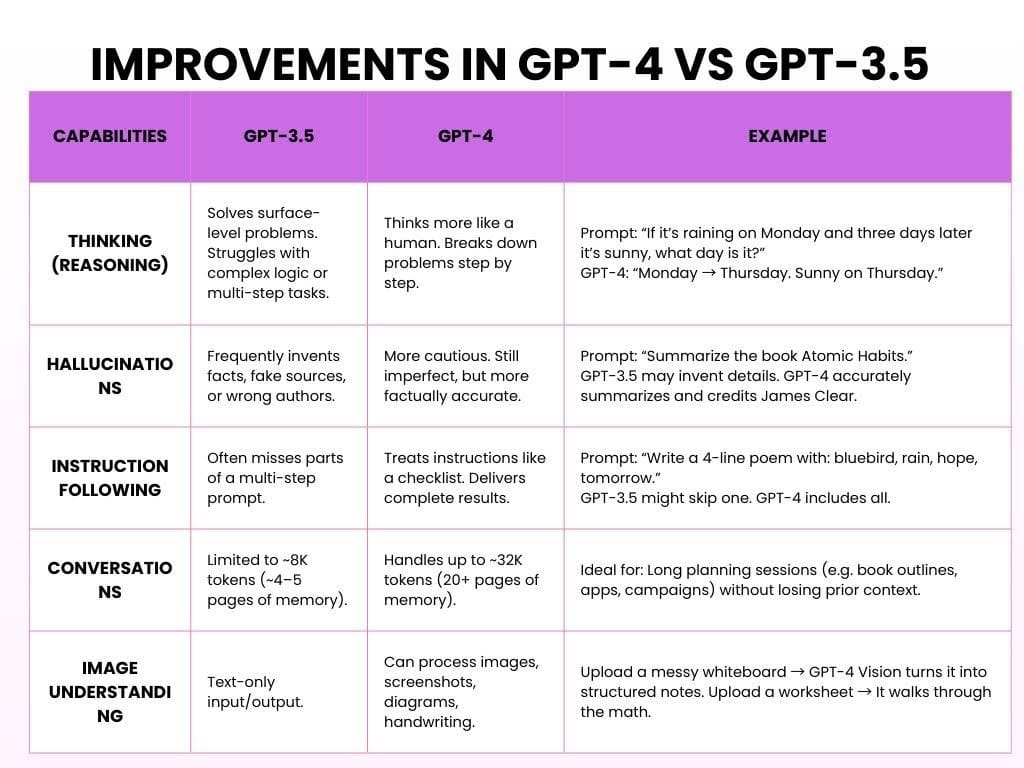

Forbedringer i GPT-4 i forhold til GPT-3.5

GPT-3.5 er den gratis version, som er hurtig, solid og god til simple opgaver. GPT-4 er en betalingsversion af OpenAI, som er smartere, mere kraftfuld og langt mere hjælpsom.

Sådan fungerer ChatGPT med begge modeller:

Konklusionen er, at GPT-3.5 var hjælpsom. GPT-4 er pålidelig, gennemtænkt og føles, som om den lytter.

Begynd at udforske - vores AI Detector og Humanizer venter i widgetten nedenfor!

Hvordan AI-værktøjer som ChatGPT er bygget

At skabe en AI som ChatGPT eller andre store sprogmodeller er et flerårigt projekt, der involverer massive datasæt, ekspertteams og ubarmhjertig iteration.

Her er, hvordan det typisk sker:

- Fase 1: Dataindsamling (6-12 måneder)

Målsætning: Undervis i modellens sprogmønstre.

Før en AI kan besvare spørgsmål, skal den lære, hvordan mennesker skriver og taler.

Det starter med at indsamle hundredvis af milliarder af ord fra bøger, hjemmesider, nyheder, artikler, akademiske afhandlinger og meget mere.

Den "læser" ikke som mennesker. I stedet identificerer den mønstre på samme måde, som vi har forklaret i ovenstående afsnit.

Nødvendig tid: 6-12 måneder, afhængigt af omfang og teamstørrelse.

- Fase to: Forudgående træning af modellen (6-9 måneder)

Målsætning: Byg hjernen op.

Fortræning indebærer, at man fodrer modellen med store mængder tekst og lader den forudsige manglende ord igen og igen, indtil den begynder at ramme rigtigt.

Denne fase kræver ofte stærke kræfter GPU-klynger og hundredvis af millioner dollars i computerressourcer.

Nødvendig tid: 6-9 måneders non-stop GPU-træning.

3. Fase tre: Finjustering og menneskelig feedback (3-6 måneder)

Målsætning: Gør AI'en nyttig.

Nu kan den tale - men giver det mening? Måske eller måske ikke. På dette tidspunkt vurderer menneskelige korrekturlæsere output, retter fejl og vejleder modellen ved hjælp af Reinforcement Learning from Human Feedback (RLHF).

Nødvendig tid: 3-6 måneder, ofte sideløbende med tidlig testning.

4. Fase fire: Implementering og infrastruktur (løbende)

Målsætning: Gør det skalerbart.

Når modellen er trænet, implementeres den på tværs af hjemmesider, apps, API'er og virksomhedsplatforme. Det kræver en seriøs backend-infrastruktur: datacentre, automatisk skalering af API'er og load-balancing-systemer til at håndtere millioner af samtidige brugere.

Tidsramme: Begynder efter træningen, men fortsætter på ubestemt tid.

5. Fase fem: Sikkerhed, bias og etik (løbende, parallelt)

Målsætning: Hold det sikkert, ærligt og ikke-skadeligt.

AI handler ikke kun om intelligens - det handler også om ansvar. Etiske teams arbejder parallelt med at markere potentielt misbrug, reducere bias, blokere skadeligt indhold og opretholde privatlivsstandarder. De evaluerer konstant, hvordan modellen opfører sig i den virkelige verden.

Tidsramme: Livslang proces; indlejret i alle ovenstående faser.

Ofte stillede spørgsmål om, hvordan ChatGPT fungerer

Søger ChatGPT på internettet efter svar?

Fra oktober 2024 fik ChatGPT mulighed for at surfe på internettet i realtid.

Denne funktion var oprindeligt eksklusiv for betalende brugere, men i december 2024 blev den tilgængelig for alle.

Er det en chatbot eller noget mere?

ChatGPT er en generativ AI-model. Generativ AI genererer dynamiske, kontekstbevidste svar ved hjælp af deep learning.

Ud over at chatte kan generativ AI skrive essays, generere billeder, komponere musik og endda skabe videoer, hvilket viser dens alsidighed på tværs af forskellige domæner.

Synes ChatGPT det?

Nej, ChatGPT tænker ikke på samme måde som mennesker. Den har ikke bevidsthed, overbevisninger, intentioner eller følelser.

Det, den gør, er statistisk at forudsige det næste ord i en sætning baseret på mønstre fra dens træningsdata. Det kan se ud som tænkning, men det er det ikke.

Afsluttende tanker

Store sprogmodeller (LLM'er) har ændret den måde, vi interagerer med teknologi på.

De kan skabe tekst, der lyder, som om den er skrevet af et menneske, og hjælpe med opgaver som at besvare spørgsmål og skabe kreativt indhold.

Men LLM'er gør det ikke "forstå" ting eller tænke som mennesker. De fungerer ved at forudsige mønstre i data, ikke gennem ægte menneskelig tænkning.

Efterhånden som LLM'erne bliver bedre, er vi nødt til at tænke på de problemer, de kan forårsage, såsom bias, privatlivsproblemer og misbrug.

Det er vigtigt at bruge AI omhyggeligt og sikre, at det er retfærdigt, gennemsigtigt og ikke spreder falsk information eller skader privatlivets fred.

Her er de retningslinjer for brug:

- Vær opmærksom på, at AI kan være forudindtaget i sit indhold.

- Brug AI-værktøjer på en måde, der følger reglerne for beskyttelse af personlige oplysninger.

- Dobbelttjek vigtige oplysninger fra pålidelige kilder.

- Stol ikke for meget på AI. Det er et værktøj, ikke en erstatning for menneskelig tænkning.

I takt med at AI-teknologien bliver mere og mere kraftfuld, opstår spørgsmålet: Hvordan kan vi sikre, at fremskridtene styrker den menneskelige kreativitet og beslutningstagning i stedet for at erstatte de ting, der gør os til unikke mennesker?