AI-detektorer er som Voight-Kampff-testen fra Blade Runner, et værktøj, der bruges til at skelne mellem rigtige og kunstige mennesker.

Men i stedet for at stille følelsesmæssige spørgsmål og scanne øjenbevægelser, er AI-detektorer afhængige af maskinlæring (ML) og behandling af naturligt sprog (NLP) til at identificere AI-genereret indhold.

Ironisk, ikke sandt?

ChatGPT og andre berømte AI-værktøjer bruger også ML'er og NLP'er til at generere indhold.

Det er som at bruge den samme tegning til at bygge et hus og så beskylde det for at være en kopi.

Så hvordan fungerer AI-detektorer egentlig? Og hvad betyder de for forfattere som dig? Lad os finde ud af det.

Det vigtigste at tage med

Før vi går ind i dette kaninhul, er her de vigtigste punkter, du skal huske:

- Opdagelsen er ikke perfekt. Selv de bedste AI-indholdsdetektorer tager fejl. Falske positiver og falske negativer sker jævnligt.

- Nøjagtigheden varierer meget. Nogle detektorer klarer sig knap nok bedre end tilfældige gæt. Andre opnår gode resultater, men laver stadig betydelige fejl.

- Konteksten betyder mere, end du tror. Skrivestil, emnekompleksitet og indholdslængde påvirker alle detektionsnøjagtigheden.

- Hybride tilgange fungerer bedre. Værktøjer, der kombinerer detektion med omskrivning af indhold, giver mere praktiske løsninger end detektion alene.

- Gennemsigtighed er sjælden. De fleste virksomheder offentliggør ikke reelle nøjagtighedsmålinger. Når de gør, er tallene ofte misvisende.

Hvordan fungerer AI-indholdsdetektorer?

AI-indholdsdetektorer er som mønstergenkendelsessystemer. De trænes på massive datasæt med menneskeskrevet og AI-genereret tekst.

Målet er enkelt: Lær at se forskellene.

Men det er her, det bliver kompliceret.

Du skal aldrig bekymre dig om, at AI opdager dine tekster igen. Undetectable AI Kan hjælpe dig:

- Få din AI-assisterede skrivning til at fremstå Menneskelignende.

- Bypass alle større AI-detektionsværktøjer med bare ét klik.

- Brug AI sikkert og selvsikkert i skolen og på arbejdet.

Disse værktøjer ser efter specifikke mønstre i teksten. Ting som sætningsstruktur, ordvalg og afsnitsflow. De tildeler sandsynlighedsscorer baseret på, hvor "AI-agtig" teksten ser ud.

Hvad er problemet? Det bliver sværere at skelne mellem menneskelig skrift og AI-skrift. Moderne AI-modeller som GPT-4o kan producere tekst, der er bemærkelsesværdigt menneskelignende.

Dette skaber en grundlæggende udfordring for detektionssystemer.

De fleste detektorer bruger en af to tilgange. Den første er perplexitetsanalyse. Den måler, hvor "overrasket" detektoren er over ordvalg.

AI har en tendens til at vælge mere forudsigelige ord, mens mennesker er mere tilfældige.

Den anden tilgang er detektion af burstiness. Her ser man på variation i sætningslængde og kompleksitet. Mennesker har en tendens til at skrive med mere variation. AI producerer ofte mere konsekvente mønstre.

Ingen af de to tilgange er idiotsikre. God AI-skrivning kan efterligne menneskelig tilfældighed.

Menneskelig skrift kan nogle gange virke meget systematisk.

Hvad skal betragtes som AI-indhold?

Dette spørgsmål er vanskeligere, end det ser ud til.

Betragtes indhold, der er 50% AI-genereret, som AI-indhold? Hvad med menneskeskrevet indhold, der er blevet redigeret af AI?

Branchen er ikke nået frem til klare definitioner. Nogle detektorer markerer alt indhold med AI-assistance. Andre markerer kun fuldt AI-genereret tekst.

Denne uoverensstemmelse gør det næsten umuligt at sammenligne nøjagtigheden.

Overvej disse scenarier:

- Et menneske skriver et udkast og bruger derefter AI til at forbedre grammatik og flow. Er dette AI-indhold?

- Nogen bruger AI til at generere idéer og skriver derefter alt fra bunden. AI-indhold eller ej?

- En skribent bruger AI til at skabe en disposition og skriver derefter originalt indhold efter denne struktur.

Disse marginaltilfælde afslører, hvorfor nøjagtighedsmålinger kan være misvisende. Forskellige værktøjer definerer "AI-indhold" forskelligt.

Det påvirker deres rapporterede nøjagtighed.

Til praktiske formål fokuserer de fleste værktøjer på at opdage indhold, der primært er AI-genereret. Men grænserne er stadig uklare.

Hvad gør en AI-indholdsdetektor "nøjagtig"?

Nøjagtighed i AI-detektion handler ikke kun om at få det rigtige svar. Det handler om at få det rigtige svar konsekvent på tværs af forskellige typer indhold og brugsscenarier.

Det er derfor, nogle er at afvise disse værktøjer.

Nogle hævder, at disse detektorer kan være lige så inkonsekvente som en lykkekages forudsigelser, hvilket rejser vigtige spørgsmål om pålidelighed og tillid.

Men ægte nøjagtighed kræver, at man afbalancerer to typer fejl. Falske positiver sker, når menneskeligt indhold bliver markeret som AI.

Falske negativer opstår, når AI-indhold fremstår som menneskeskrevet.

Omkostningerne ved disse fejl varierer efter kontekst. Når det gælder akademisk integritet, kan falske positiver ødelægge de studerendes tillid.

Ved indholdsmarkedsføring kan falske negativer føre til sanktioner fra søgemaskinerne.

Nøjagtigheden afhænger også af kvaliteten af træningsdata. Detektorer, der er trænet på ældre AI-modeller, kan have problemer med nyere, mere sofistikeret AI-skrivning.

Det skaber et konstant våbenkapløb mellem detektion og generation.

De bedste detektorer tager højde for flere faktorer:

- Statistiske mønstre i ordbrug og sætningsstruktur

- Semantisk sammenhæng og logisk flow

- Konsistent skrivestil i hele indholdet

- Domænespecifik viden og demonstration af ekspertise

Men selv omfattende tilgange har begrænsninger. Menneskelig skrivning varierer enormt. Nogle mennesker skriver naturligt i mønstre, der udløser AI-detektorer.

Andre kan efterligne AI-lignende konsistens.

Målet er ikke perfekt nøjagtighed. Det er pålidelig nøjagtighed, der tjener dine specifikke behov.

Og selv om ingen detektor er fejlfri, kan det rigtige værktøj gøre forskellen mellem en sikker indsendelse og et markeret dokument.

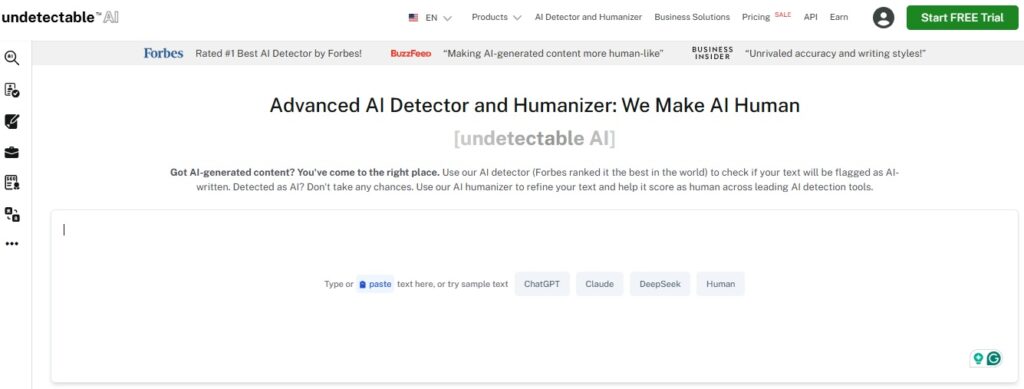

Uopdagelig AI's detektor og humanizer arbejder sammen i et enkelt workflow og tilbyder en afbalanceret tilgang, der ikke kun identificerer AI-genereret tekst, men også omskriver den naturligt.

Med denne integrerede løsning får du både detektionsnøjagtighed og praktiske løsninger i én problemfri oplevelse.

Prøv Undetectable AI Detector og Humanizer i dag, og oplev trygheden ved AI-frit, autentisk indhold, der er klar til enhver udfordring.

Sådan måler vi vores AI-detektorers nøjagtighed

De fleste virksomheder kaster om sig med nøjagtighedsprocenter uden at forklare, hvordan de har beregnet dem. Vi tror på gennemsigtighed.

Vores test af nøjagtighed følger stringent metodologi.

Vi bruger forskellige datasæt, der omfatter indhold fra flere AI-modeller, menneskelige skribenter på forskellige niveauer og forskellige indholdstyper.

Her er vores testproces:

- Oprettelse af datasæt: Tusindvis af AI-genererede teksteksempler. Dækker akademiske essays, marketingtekster, kreativ skrivning og teknisk dokumentation. Vi har hentet AI-indhold direkte fra førende modeller og kurateret menneskelig tekst for at få en bred repræsentation.

- Blindtestning: Vores detektor analyserer hver prøve uden at kende dens kilde og udsender tillidsscorer og klassifikationer (AI vs. menneske).

- Statistisk analyse: Derfra beregner vi:

- Sande positiver / falske positiver / sande negativer / falske negativer

- Præcision, tilbagekaldelse og F1-score, som er standardmålinger i evaluering af maskinlæring.

- Krydsvalidering: Vi tester på tværs af indholdstyper og -længder for at måle ydeevnen i den virkelige verden: akademisk, marketing, teknisk og kreativ. Undersøgelser viser, at kreativ skrivning er sværest at opdage præcist, så vi er ekstra opmærksomme på det.

- Kontinuerlig overvågning: AI-modeller udvikler sig hurtigt. Detektorer, der er trænet på ældre data, underpræsterer på nyere output. Vi sporer performance over tid og omtræner, når det er nødvendigt for at bevare nøjagtigheden.

Vores nuværende test viser betydelig variation baseret på indholdstype.

Akademisk skrivning er nemmest at registrere præcist. Kreativ skrivning giver de største udfordringer.

Nuværende nøjagtighed af vores AI-indholdsdetektor

Med Undetectable AI stoler vi ikke på rygter. Vi sætter selv vores detektor under lup:

- Brancheførende ekstern validering: Uafhængige tests viser, at Undetectable AI's detektor opnår 85 til 95% nøjagtighed på blandet menneske- og AI-indhold, hvilket konkurrerer med de bedste værktøjer på området.

- Evne til at opdage omskrivninger: Forskning viser, at Undetectable AI nøjagtigt spotter omskrevet AI-tekst 100% af tiden i flere værktøjssammenligninger, herunder gratis værktøjer som Sapling og QuillBot.

- Selvreflekterende test: Undetectables egen GPTZero-sammenligningstest markerede 99% af AI-genereret indhold korrekt, mens GPTZero kun markerede 85%.

- Kontinuerlig forbedring gennem blind swapping: Når brugere menneskeliggør AI-tekst via Undetectable AI, falder traditionelle detektorer (som Originality.ai) fra over 90% detektionsrater til under 30%, hvilket beviser styrken af vores omskrivningsmodel.

- Støttet af millioner: Vurderet som den bedste AI-detektor af Forbes, med over 4 millioner brugere og gratis brug på tværs af platforme.

I praksis betyder det, at Undetectable AI leverer detekteringsnøjagtighed i topklasse og kombinerer det med en avanceret humanizer til problemfri omskrivning.

Test dit indhold nu - gratis scanning med vores AI Detector. Start med selvtillid: tjek din tekst, få øjeblikkelig indsigt, og tag affære.

Hvorfor vi parrer AI Detector + Humanizer

Opdagelse alene er ikke nok. At vide, at indhold kan være AI-genereret, løser ikke det underliggende problem.

Du har brug for handlingsorienterede løsninger.

Det er derfor, vi har bygget vores platform op omkring detektor-humanizer-arbejdsgangen. I stedet for bare at markere potentielt AI-indhold, hjælper vi dig med at håndtere det.

Sådan fungerer den parvise tilgang:

- Opdagelse først: Vores AI-detektor analyserer dit indhold og identificerer afsnit, der kan være AI-genererede. Du får specifikke tillidsscorer for forskellige afsnit.

- Målrettet omskrivning: Vores humanizer fokuserer på de markerede afsnit. I stedet for at omskrive alt, ændrer den intelligent kun de dele, der skal forbedres.

- Verifikationsloop: Efter humanisering kører vi detektion igen for at bekræfte, at indholdet nu læses som menneskeskrevet.

- Bevarelse af kvalitet: Processen bevarer din oprindelige mening og stil, samtidig med at AI's registreringssignaturer reduceres.

Denne arbejdsgang løser reelle problemer. Indholdsskabere kan sikre, at deres arbejde ikke udløser falske positiver. Studerende kan verificere, at det, de skriver, ser ægte menneskeligt ud.

Markedsførere kan producere indhold, der kan spores, samtidig med at kvaliteten bevares.

Alternativet er ren detektion, som efterlader dig med problemer, men ingen løsninger.

Det hjælper ikke at vide, at indholdet måske er AI-genereret, hvis du ikke kan løse det.

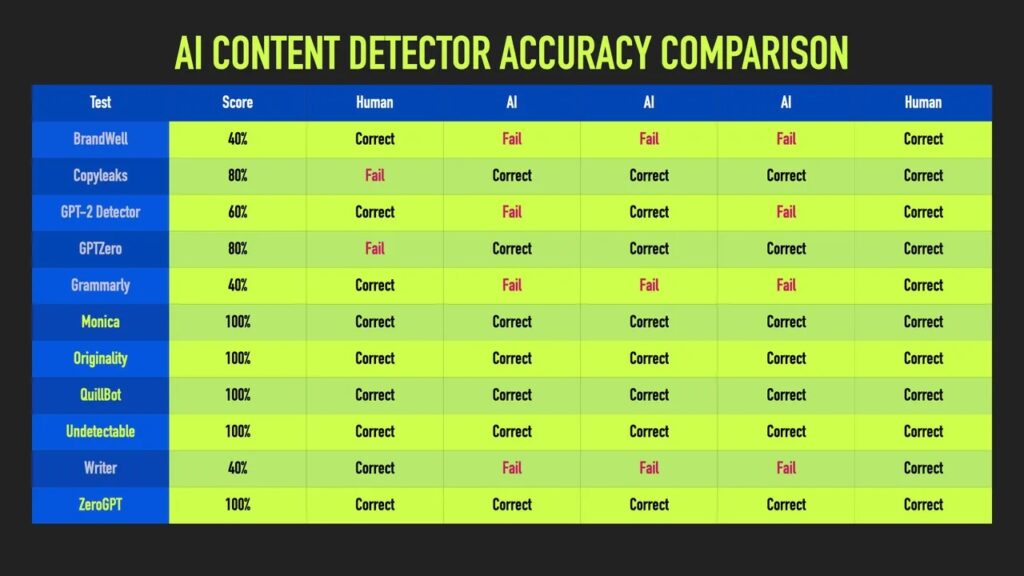

Sådan sammenligner vi os med andre AI-indholdsdetektorer

Landskabet for AI-detektion er fyldt med værktøjer, der kommer med ambitiøse påstande om nøjagtighed. Uafhængige tests kaster et klarere lys over, hvad der rent faktisk virker.

ZDNets dybe dyk ned i 10 store AI-indholdsdetektorer indebar, at man sendte de samme AI-genererede prøver til hvert værktøj og kontrollerede, hvilke der konsekvent identificerede AI-skrevet tekst.

Mange detektorer kom til kort. Nogle, der hævdede næsten perfekt nøjagtighed, scorede knap nok bedre end tilfældigt, når de blev testet på indhold fra den virkelige verden.

Uopdagelig AI skilte sig dog ud og landede i top fem for konsekvent AI-tekstopdagelse på tværs af alle prøver.

ZDNet testede 10 AI-detektorer ved hjælp af identiske AI-genererede prøver.

Ud af disse markerede kun tre værktøjer AI-tekst 100% af tiden på tværs af alle testede prøver.

Det er bemærkelsesværdigt, at vores resultater forblev solide uanset indholdstype, ikke kun på kuraterede, nemme eksempler.

- Konsekvent præstation på tværs af en bred vifte af AI-modeller og indholdstyper. Mens konkurrenterne ofte udmærker sig inden for snævre rammer, opretholder vi nøjagtigheden over hele linjen.

- Klar metodologi. Vi forklarer vores testprocedurer og opdaterer præstationsmålinger regelmæssigt uden vage påstande.

- Integrerede løsninger. Vi forbinder detektion med omskrivning via vores Humanizer. Værktøjer, der udelukkende fokuserer på detektion, efterlader dig med problemer, men ingen løsninger.

- Hyppig omskoling. Vi genoptræner løbende vores modeller, efterhånden som AI-generationen udvikler sig. Statiske detektorer mister hurtigt deres relevans.

- Ærlige begrænsninger. Vi kommunikerer tydeligt udfordringer og edge cases. At love for meget fører til brugerfrustration og dårlige beslutninger.

ZDNets undersøgelse understregede et vigtigt punkt: Konsistens trumfer prangende højder. En detektor, der er pålidelig 95% af tiden, slår en, der rammer 99% en gang imellem, men går ned til 60% i andre sammenhænge.

Test dit indhold nu | Gratis scanning med vores AI-detektor.

Se på første hånd, hvor du står. Scan dine tekster, få pålidelige resultater, og tag de næste skridt.

Se vores AI Detector og Humanizer i aktion - brug bare widgetten nedenfor!

Tillid, gennemsigtighed og værktøjer, der leverer varen

Nøjagtigheden af AI-indholdsdetektorer er mere end bare tal. Det handler om at forstå, hvad disse værktøjer kan og ikke kan gøre pålideligt.

Detektionsteknologien er lovende, men ufuldkommen. Selv de bedste værktøjer begår fejl. At kende disse begrænsninger hjælper dig med at bruge dem klogt.

Fremtiden for AI-detektion går i retning af multimodal analyse, adfærdsmønstre og kollaborativ verifikation.

Indtil videre skal detektionsværktøjer som Undetectable AI behandles som nyttige assistenter, ikke endelige dommere. Kombiner dem med menneskelig dømmekraft, og vælg løsninger, der passer til dine behov.

Ren detektion løser sjældent reelle problemer. Derfor tilbyder Undetectable AI en integreret arbejdsgang, der afbalancerer opdagelse med forbedring af indholdet.

Målet er ikke at udelukke AI fra at skrive, men at sikre gennemsigtighed, opretholde kvaliteten og bevare tilliden.

Forståelse af detektorens nøjagtighed, især med Uopdagelig AIgiver dig kontrol over processen.