Det er én ting som har vært på alles tunge de siste par årene: ChatGPT.

Lærere bekymre deg for at det er å skrive elevenes lekser.

Forfattere frykter at AI kan skrive bøker og historier i stedet for dem.

Kodere er redde for at den skal bygge nettsteder og apper bedre enn mennesker kan.

Noen spår til og med at millioner av arbeidsplasser kan forsvinne på grunn av kunstig intelligens.

Vi har alle hørt om det. Men har du noen gang lurt på hvordan Fungerer ChatGPT?

Hvordan skriver ChatGPT leksene til et barn? Hva skjer bak kulissene når du skriver inn et spørsmål og den svarer som en ekte person?

Hvordan kan en maskin skrive dikt, historier og kode, selv om den ikke forstår ord på samme måte som oss?

I denne bloggen, vil vi se inn i ChatGPT og forklare hva ChatGPT er og hvordan det fungerer, trinn for trinn.

Du vil lære hvordan den husker ting, hvilke begrensninger den har, og hvordan slike verktøy i det hele tatt er bygget opp.

La oss komme i gang!

Grunnlaget: GPT-språkmodeller

ChatGPT er en AI som er laget for å forstå og skrive som et menneske.

Det kalles en språkmodell fordi den arbeider med språk - leser det, forutser det og genererer det.

Men den forstår ikke slik mennesker gjør. Den tenker ikke. Den kjenner ikke til fakta. Den ser bare på mønstre.

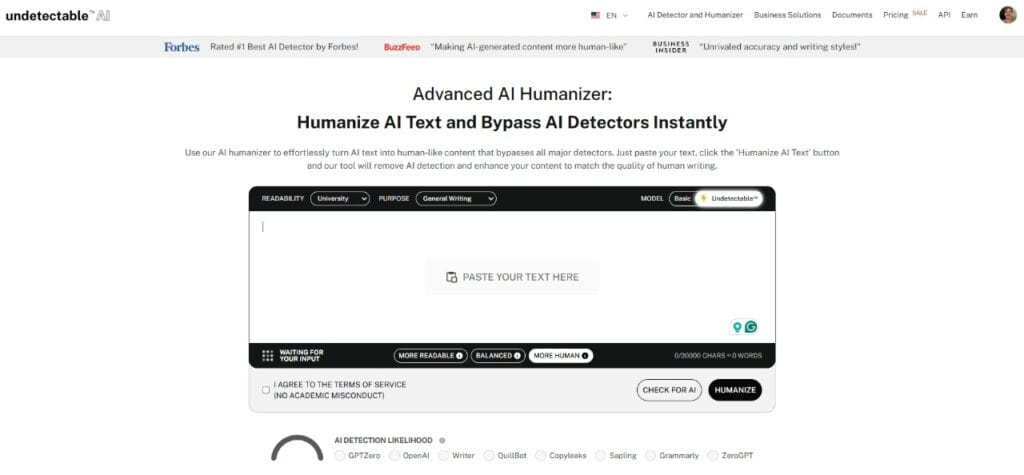

Aldri bekymre deg for at AI oppdager tekstene dine igjen. Undetectable AI Kan hjelpe deg:

- Få AI-assistert skriving til å vises ...menneskelignende.

- Bypass alle de viktigste AI-deteksjonsverktøyene med bare ett klikk.

- Bruk AI trygt og selvsikkert i skole og arbeid.

For eksempel,

- Hvis du skriver, "Himmelen er..."

- Det kan stå "Blå."

Ikke fordi den vet at himmelen er blå, men fordi den har sett den setningen millioner av ganger under treningen. Den har lært at "blå" ofte kommer etter "himmelen er".

Denne typen AI kalles en LLM, som står for Stor språkmodell.

Den er opplært på tonnevis av lærebøker, nettsteder og annet for å finne ut hvordan mennesker bruker ord. Men den leser ikke etter mening. Den lærer seg hvordan ord vanligvis dukker opp ved siden av hverandre.

GPT er en spesifikk form for LLM.

GPT står for "Generativ forhåndstrenet transformator".

- Generativ - kan den opprette ny tekst.

- Forutdannet - den lærer før den snakker med deg.

- Transformator - nøkkelteknologien bak hvordan ChatGPT fungerer, som hjelper den med å forstå hvordan ord relaterer seg til hverandre i en setning, et avsnitt eller til og med en samtale.

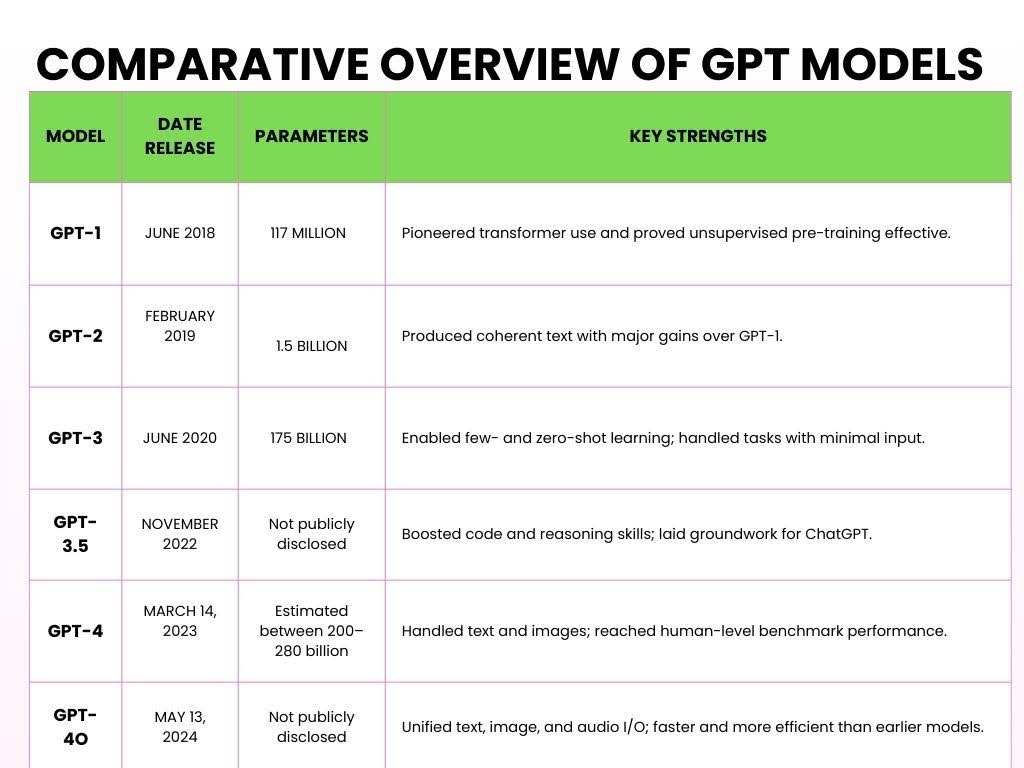

Her er de ulike versjonene av GPT som har blitt lansert opp gjennom årene.

Slik fungerer ChatGPT

Her er en forenklet oversikt over hvordan ChatGPT fungerer og behandler innspillene dine i fem viktige trinn.

- Trinn 1: Forhåndstrening på store datamengder

Store språkmodeller (LLM) som ChatGPT, er forhåndstrenet ved å behandle store mengder tekst fra Internett for å lære språkmønstre.

Under pretreningen behandler modellen billioner av tokens (bittesmå tekstbiter).

A symbol kan være et ord, en del av et ord eller til og med tegnsetting, avhengig av hvordan modellen tokeniserer inndataene.

For eksempel,

Du stiller ChatGPT et mattespørsmål, for eksempel:

Problem:

- 2 + 3 = ?

Under opplæringen leser ChatGPT hundrevis av milliarder av ord fra bøker, nyheter, artikler, Wikipedia, historier, vitenskapelige artikler og til og med Reddit-tråder.

Denne treningen og lesingen hjelper det å forstå hvordan addisjon fungerer.

For eksempel,

Den kan lære seg kommutativ egenskap (f.eks. 2 + 3 = 3 + 2) gjennom slike sammenhenger.

ChatGPT ser mange eksempler som

- "2 + 3 = 5,"

- "7 + 8 = 15,"

- "9 + 4 = 13."

Den lærer ikke bare disse spesifikke eksemplene, den lærer adderingsmønsteret.

Den forstår hvordan tall interagerer med "+"-symbolet og hvordan resultatet vanligvis følger "="-symbolet.

- Trinn 2: Transformatorarkitekturen

Når ChatGPT hadde sett en enorm mengde ord, trengte den en hjerne som kunne gi mening til all denne informasjonen. Denne AI-hjernen kalles "Transformator."

Det som skiller Transformer fra de andre, er dens evne til å fokusere oppmerksomheten på de viktigste delene av inndataene, på samme måte som vi behandler språk.

For eksempel,

La oss bruke dette på et matematisk problem:

- "Hva er summen av 5 og 7?"

Når Transformer behandler dette, går den ikke bare ord for ord.

I stedet ser den på hele konteksten - "sum", "5" og "7" - på én gang.

Den erkjenner at "sum" refererer til "tillegg" og at "5" og "7" er de involverte tallene.

Transformatoren gir deretter mer "oppmerksomhet" til de ordene som har direkte innvirkning på svaret, slik at den fokuserer på operasjonen ("sum") og tallene ("5" og "7").

Dette er en viktig del av hvordan ChatGPT fungerer - det ikke behandler problemet lineært, men på en måte som hjelper den å forstå forholdet mellom elementene.

Det er denne evnen til å se alt i sammenheng som gjør Transformer så kraftfull.

I stedet for bare å finne ut hva som kommer etterpå, forstår den meningen ved å koble sammen de relevante delene av setningen.

Videre betyr det å bli en del av et nytt nettsamfunn ofte at man må lære seg et helt nytt vokabular, men du trenger ikke å vente i flere måneder før du kan begynne å snakke språket.

I tillegg, hvis du ønsker at meldingene dine skal passe perfekt inn, kan Undetectable AI's Akronymgenerator lar deg lage tilpassede forkortelser som etterligner de komplekse mønstrene AI-modeller bruker til å behandle og generere strukturerte språklige forkortelser.

- Trinn 3: Tokenisering og språkbehandling

Når du skriver inn tekst i ChatGPT, deler den opp ledeteksten i små symboler.

Noen tokens er hele ord, mens andre bare er deler av ord.

For eksempel,

Når du skriver inn "ChatGPT er smart" ChatGPT deler den opp i følgende symboler:

["Chat", "G", "PT", "er", "smart"]

Til og med navnet "ChatGPT" blir delt inn i forskjellige tokens.

Denne prosessen kalles tokenisering. Fordi modellene er trent på tokens i stedet for hele ord, er den mye mer fleksibel:

Flere språk (siden ulike språk har ulike ordstrukturer),

Slang og forkortelser (som "u" for "du" eller "idk" for "jeg vet ikke").

Selv oppdiktede ord eller variasjoner (som å dele opp "utrolig" i "un", "believ", "able").

- Trinn 4: Finjustering og sikkerhetslag

Når ChatGPT har blitt trent opp på en stor mengde data, er den ikke helt klar for prime time.

Den trenger fortsatt hjelp til å sørge for at den reagerer på den mest nyttige, høflige og trygge måten.

Gjennom overvåket finjusteringgir menneskelige korrekturlesere ChatGPT eksempler på hva som er et godt svar. For eksempel,

- "Hva er 5 + 7?"

- Dårlig svar: Det er et enkelt spørsmål. Hvorfor vet du ikke dette?

- Godt svar: Summen av 5 og 7 er 12.

Over tid trenes ChatGPT opp med bedre eksempler for å bli mer høflig, tydelig og fokusert.

Når den har et solid grunnlag, får den mer avansert hjelp gjennom Forsterkningslæring fra menneskelige tilbakemeldinger (RLHF).

Denne prosessen foregår på denne måten:

- ChatGPT svarer.

- Mennesker rate det svaret basert på hvor bra det er - hvor nyttig, nøyaktig og trygt det er.

- ChatGPT lærer av disse tilbakemeldingene og forsøker å gi bedre svar i fremtiden.

For eksempel, Tenk deg at ChatGPT svarer på et matematisk problem, for eksempel "Hva er 12 delt på 4?":

- ChatGPT svarer: "3."

- Menneskelig tilbakemelding: Dette svaret er flott.

- ChatGPT lærer: Den fortsetter å gi denne typen svar når lignende spørsmål dukker opp.

Målet er at ChatGPT skal fortsette å forbedre seg, akkurat som en student som lærer av tidligere feil.

Til slutt, et viktig formål med finjustering av mennesker er er i tråd med menneskelige verdier.

Vi vil at den ikke bare skal være smart, men også nyttig, ufarlig og ærlig.

For eksempel, hvis en bruker stiller et komplekst spørsmål som f.eks, "Hva er kvadratroten av -1?"

I stedet for å gi et feil svar som "i er svaret" uten noen kontekst, ville det gitt:

Sikkert, justert svar: Kvadratroten av -1 er et imaginært tall, ofte representert som "i". Dette konseptet brukes i avansert matematikk.

- Trinn 5: Spør inn, svar ut

Dette er det siste trinnet der ChatGPT er klar til å svare på spørsmålene dine.

En ledetekst er teksten (f.eks. et spørsmål, en kommando eller et utsagn) du skriver inn i ChatGPT for å starte samtalen og få et svar.

For eksempel,

Du skriver inn ledeteksten "Hvordan er været i dag?"

Slik fungerer ChatGPT bak kulissene:

Du skriver inn en ledetekst → ChatGPT deler den opp i symboler → Den ser etter mønstre i symbolene → Forutser neste ord → Danner et svar → Justerer tonen basert på teksten din → Får det endelige svaret ditt

For ledeteksten "Hvordan er været i dag?", ChatGPT vil sannsynligvis svare med noe sånt som:

"Jeg kan ikke gi væroppdateringer i sanntid, men du kan sjekke en værside eller -app som Weather.com eller de lokale nyhetene for å få den mest nøyaktige informasjonen."

Dette skyldes at ChatGPT ikke har tilgang til sanntidsdata med mindre den er koblet til et verktøy som henter informasjon i sanntid.

Hvordan den "husker" samtaler

Når du snakker med ChatGPT, virker det som om den husker ting du har sagt tidligere.

Og det gjør det - men bare mens chatten er åpen. Forestill deg en stor notisblokk der alt du skriver blir skrevet ned:

Du sier det:

- Hunden min heter Max.

Noen linjer senere sier du

- Hvilke triks kan Max lære?

ChatGPT kobler sammen prikkene. Den husker at Max er hunden din, fordi den fortsatt er på notatblokken.

Denne notisblokken kalles en kontekstvindu, og den inneholder et begrenset antall ord (kalt tokens).

Noen versjoner har plass til rundt 8000 tokens, mens de nyeste kan gå opp til 32 000 tokens.

Men når du når grensen, må den begynne å slette de eldste delene for å gi plass til ny tekst.

Så hvis du sier "Hunden min heter Max" helt tilbake i begynnelsen av en lang prat - og så spør du 50 avsnitt senere, "Hva er et godt bånd til ham?" - ...kan den glemme hvem "han" er.

Fordi den informasjonen allerede er slettet fra notisblokken.

La oss nå snakke om hukommelse mellom samtaler.

Når du lukker chatten, blir notisblokken vanligvis slettet.

Så neste gang du åpner ChatGPT, starter den på nytt.

Men hvis du slår på tilpasset minne, kan ChatGPT huske ting på tvers av økter. For eksempel,

- Det kan du fortelle: Jeg driver et lite nettbakeri som heter Sweet Crumbs.

- En uke senere, sier du: Skriv en produktbeskrivelse.

- Den kan svare: Ja visst! Her er en beskrivelse av Sweet Crumbs-kakene dine...

Den husker ikke alt. Den husker bare det du tillater, og du får beskjed når noe blir lagt til. Du kan se, redigere eller slette minner når som helst.

Så det korte og det lange er...

ChatGPT gjør faktisk ikke "husk" som en person. Den ser bare på det den har foran seg - den aktuelle samtalen.

Hvis det ser ut som om den husker noe fra tidligere, er det fordi denne informasjonen fortsatt er inne i kontekstvinduet.

Begrensninger i hvordan ChatGPT fungerer

ChatGPT er utrolig nyttig, men det er viktig å forstå begrensningene, spesielt hvis du bruker det til noe som helst som er kundeorientert eller konverteringsdrevet.

1 - Ingen reell forståelse eller bevissthet

ChatGPT forstår ikke innhold slik mennesker gjør. Den "vet" ikke fakta - den forutsier ganske enkelt det neste sannsynlige ordet basert på treningsdata.

For eksempel,

Hvis du spør, "Hva betyr suksess?" Den kan generere en flytende respons, men den har ikke overbevisninger, verdier eller bevissthet. Den etterligner mønstre, ikke skaper innsikt.

2 - Skjevheter fra treningsdata

Fordi ChatGPT er opplært på store, blandede kilder fra internett, bøker, fora og artikler, kan den arve skjevheter som finnes i disse dataene.

Hvis internett lener seg i én retning når det gjelder et tema, kan ChatGPT speile dette perspektivet - noen ganger subtilt, andre ganger ikke - selv når nøytralitet er påkrevd.

3 - Surfer ikke på internett

ChatGPT kan ikke hente data i sanntid. Spør den om et produkt som ble lansert i forrige uke, eller en aksjekurs i dag, og den vil ikke ha en anelse.

Treningsdataene har en grenseverdi, og alt etter dette punktet er utenfor rekkevidde.

4 - Kan "hallusinere" fakta eller sitere falske kilder

En av de farligere særegenhetene: ChatGPT kan finne på ting. Be den om en statistikk eller et sitat, og den kan svare,

"Ifølge Verdens helseorganisasjon foretrekker 80% av alle voksne merkevare X fremfor merkevare Y."

Det høres offisielt ut - men den statistikken finnes sannsynligvis ikke.

Den ble ikke hentet, den ble oppfunnet. Dette problemet er kjent som hallusinasjonDet er spesielt risikabelt når det gjelder forskning, journalistikk eller teknisk innhold.

Hvis du spør ChatGPT om hvordan det fungerer, vil du se at det ikke alltid er faktabasert.

Hvis du bruker ChatGPT til å skrive, vil resultatet føles stivt, robotaktig eller mangle det menneskelige aspektet.

For slike nyanser kan du bruke AI Humanizer.

Den AI Humanizer omskriver ChatGPT-utdata for tone, nyanser og følelser, og gir innholdet ditt en puls.

Det myker opp vanskelige fraseringer, tilfører varme, og får tekniske eller tørre tekster til å gi gjenklang hos publikum.

Når innholdet ditt høres menneskelig ut, gir det bedre resultater.

Enten du skriver destinasjonssider, e-poster eller LinkedIn-innlegg, er det relaterbarhet som gir respons. Og følelser driver konvertering.

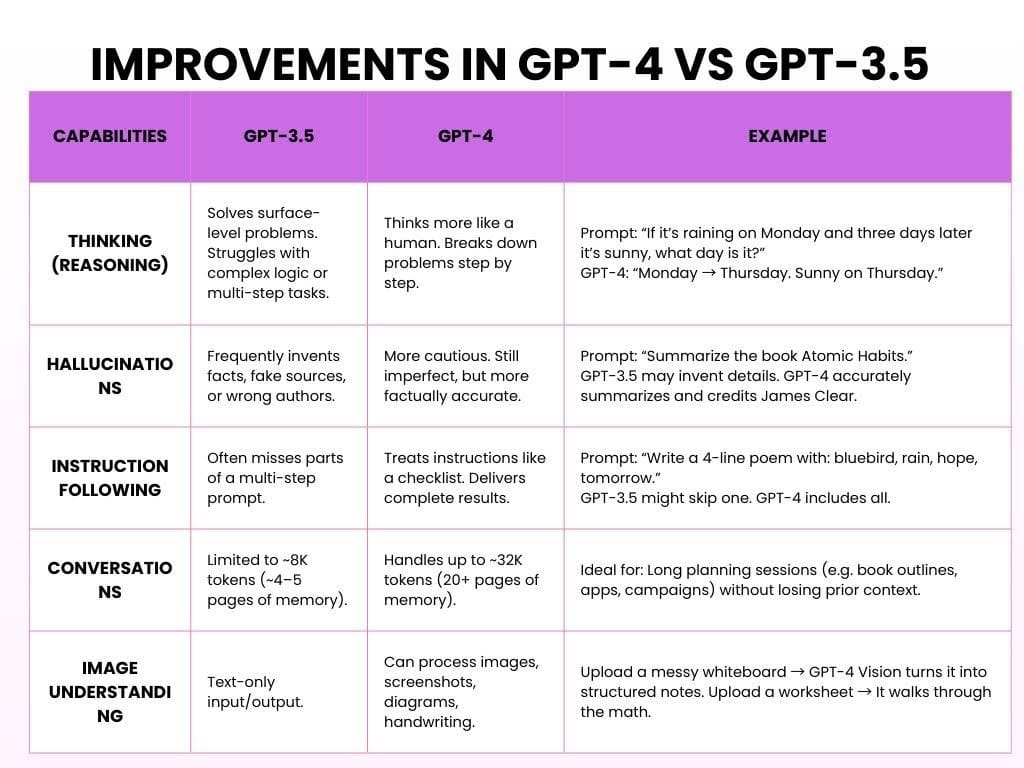

Forbedringer i GPT-4 i forhold til GPT-3.5

GPT-3.5 er gratisversjonen, som er rask, solid og perfekt for enkle oppgaver. GPT-4 er en betalt versjon av OpenAI som er smartere, kraftigere og langt mer nyttig.

Slik fungerer ChatGPT med begge modellene:

Poenget er at GPT-3.5 var nyttig. GPT-4 er pålitelig, gjennomtenkt og føles som om den lytter.

Begynn å utforske - vår AI Detector og Humanizer venter i widgeten nedenfor!

Hvordan AI-verktøy som ChatGPT er bygget opp

Å lage en kunstig intelligens som ChatGPT eller andre store språkmodeller er et flerårig prosjekt som involverer enorme datasett, ekspertteam og ubarmhjertig iterasjon.

Slik skjer det vanligvis:

- Fase én: Datainnsamling (6-12 måneder)

Målsetting: Lær bort modellspråkmønstrene.

Før en AI kan svare på spørsmål, må den lære seg hvordan mennesker skriver og snakker.

Dette starter med å samle inn hundrevis av milliarder av ord fra bøker, nettsteder, nyheter, artikler, akademiske artikler og mye mer.

Den "leser" ikke som mennesker. I stedet identifiserer den mønstre, akkurat slik vi har forklart i avsnittene ovenfor.

Nødvendig tid: 6-12 måneder, avhengig av omfang og teamstørrelse.

- Fase to: Forutrening av modellen (6-9 måneder)

Målsetting: Bygg hjernen.

Forutrening innebærer å mate modellen med store mengder tekst og la den forutsi manglende ord om og om igjen til den begynner å få rett.

Denne fasen krever ofte kraftige GPU-klynger og hundrevis av millioner dollar i databehandlingsressurser.

Nødvendig tid: 6-9 måneder med kontinuerlig GPU-trening.

3. Fase tre: Finjustering og tilbakemelding fra mennesker (3-6 måneder)

Målsetting: Gjør den kunstige intelligensen nyttig.

Nå kan den snakke - men gir det mening? Kanskje, eller kanskje ikke. På dette tidspunktet vurderer menneskelige korrekturlesere utdataene, korrigerer feil og veileder modellen ved hjelp av Reinforcement Learning from Human Feedback (RLHF).

Nødvendig tid: 3-6 måneder, ofte parallelt med tidlig testing.

4. Fjerde fase: Utrulling og infrastruktur (pågående)

Målsetting: Gjør det skalerbart.

Når modellen er opplært, distribueres den på tvers av nettsteder, apper, API-er og bedriftsplattformer. Dette krever en omfattende backend-infrastruktur: datasentre, automatisk skalering av API-er og systemer for lastbalansering for å håndtere millioner av samtidige brukere.

Tidsramme: Begynner etter trening, men fortsetter på ubestemt tid.

5. Fase fem: Sikkerhet, partiskhet og etikk (Pågående, parallelt)

Målsetting: Hold det trygt, ærlig og ikke-skadelig.

AI handler ikke bare om intelligens - det handler også om ansvar. Etiske team jobber parallelt med å flagge potensielt misbruk, redusere skjevheter, blokkere skadelig innhold og opprettholde personvernstandarder. De evaluerer kontinuerlig hvordan modellen oppfører seg i den virkelige verden.

Tidsramme: Livslang prosess; integrert i alle trinnene ovenfor.

Vanlige spørsmål om hvordan ChatGPT fungerer

Søker ChatGPT på internett etter svar?

Fra og med oktober 2024 fikk ChatGPT muligheten til å surfe på internett i sanntid.

Denne funksjonen var i utgangspunktet eksklusiv for betalende brukere, men i desember 2024 ble den tilgjengelig for alle.

Er det en chatbot eller noe mer?

ChatGPT er en generativ AI-modell. Generativ AI genererer dynamiske, kontekstbevisste svar ved hjelp av dyp læring.

I tillegg til å chatte kan generativ AI skrive essays, generere bilder, komponere musikk og til og med lage videoer, noe som viser dens allsidighet på tvers av ulike domener.

Tror ChatGPT det?

Nei, ChatGPT tenker ikke på samme måte som mennesker. Den har ikke bevissthet, tro, intensjoner eller følelser.

Det den gjør, er å statistisk forutsi neste ord i en setning basert på mønstre fra treningsdataene. Dette kan se ut som tenkning, men det er det ikke.

Avsluttende tanker

Store språkmodeller (Large Language Models, LLM) har endret måten vi samhandler med teknologi på.

De kan skape tekst som høres ut som om den er skrevet av et menneske, og hjelpe til med oppgaver som å svare på spørsmål og lage kreativt innhold.

Men LLM-er gjør ikke "forstå" ting eller tenker som mennesker. De fungerer ved å forutsi mønstre i data, ikke gjennom ekte menneskelig tankegang.

Etter hvert som LLM-ene blir bedre, må vi tenke på problemene de kan forårsake, som skjevheter, personvernproblemer og misbruk.

Det er viktig å bruke kunstig intelligens med omhu, slik at den er rettferdig, transparent og ikke sprer falsk informasjon eller skader personvernet.

Her er de retningslinjer for bruk:

- Vær oppmerksom på at kunstig intelligens kan ha skjevheter i innholdet.

- Bruk AI-verktøy på måter som følger personvernreglene.

- Dobbeltsjekk viktig informasjon fra pålitelige kilder.

- Ikke stol for mye på kunstig intelligens. Det er et verktøy, ikke en erstatning for menneskelig tenkning.

Etter hvert som AI-teknologien blir stadig mer kraftfull, melder spørsmålet seg: Hvordan kan vi sikre at fremskrittene fremmer menneskelig kreativitet og beslutningstaking, i stedet for å erstatte det som gjør oss til unike mennesker?