Mentre gli strumenti di intelligenza artificiale come ChatGPT diventano sempre più sofisticati e accessibili, nel settore dell'istruzione è emersa una preoccupazione pressante:

I college e le università possono rilevare in modo affidabile i contenuti generati dalla ChatGPT?

In questo articolo esaminiamo come le istituzioni stanno rispondendo all'ascesa dell'IA generativa, quali metodi di rilevamento vengono utilizzati nel 2025.

Le sfide che devono affrontare e come gli studenti possono utilizzare l'IA in modo responsabile senza compromettere l'integrità accademica.

Punti di forza

- I college possono rilevare il ChatGPT, ma non con una precisione perfetta. Strumenti come Turnitin e Copyleaks sono comunemente utilizzati, ma producono comunque falsi positivi e negativi.

- La revisione umana e l'analisi stilometrica sono fondamentali per valutare le incongruenze tra il lavoro precedente di uno studente e i nuovi lavori presentati.

- Il rilevamento si basa su modelli linguistici, statistici e contestuali, ma i risultati avanzati dell'IA possono spesso eludere l'analisi superficiale.

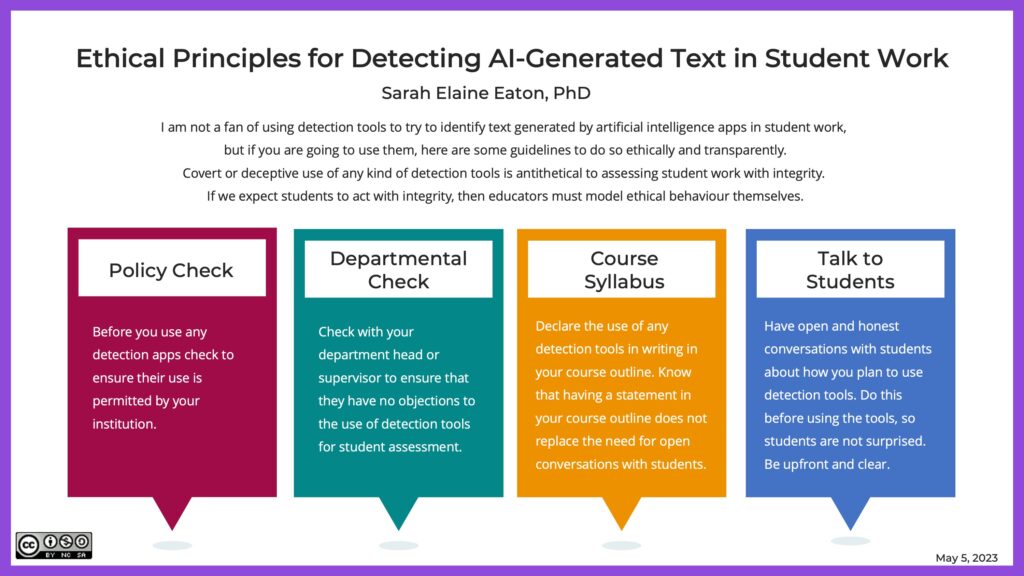

- Gli educatori stanno aggiornando le politiche e adottando esami orali, compiti di scrittura in tempo reale e valutazioni consapevoli dell'intelligenza artificiale per ridurre la dipendenza dai soli strumenti di rilevazione.

- L'uso etico dell'IA è possibile, soprattutto se guidato dalla trasparenza, dall'onestà accademica e da strumenti come Undetectable AI.

La ChatGPT è rilevabile nel 2025?

ChatGPT e altri modelli linguistici di grandi dimensioni sono migliorati notevolmente nella loro capacità di generare testi naturali, coerenti e simili a quelli umani.

Se da un lato questo progresso libera un potente potenziale educativo, dall'altro presenta nuove sfide per le istituzioni accademiche che cercano di preservare l'integrità del lavoro degli studenti.

La maggior parte dei rilevatori AI utilizzad dai college-compresa la funzione di rilevamento dell'intelligenza artificiale di Turnitin - si basano su modelli linguistici, perplessità, e scoppiettante per segnalare la scrittura generata dall'intelligenza artificiale.

Non preoccupatevi più che l'intelligenza artificiale rilevi i vostri messaggi. Undetectable AI Può aiutarvi:

- Fate apparire la vostra scrittura assistita dall'intelligenza artificiale simile all'uomo.

- Bypass tutti i principali strumenti di rilevamento dell'intelligenza artificiale con un solo clic.

- Utilizzo AI in modo sicuro e con fiducia a scuola e al lavoro.

Tuttavia, questi sistemi non sono infallibili. Molti studenti modificano i risultati dell'IA o li umanizzano utilizzando strumenti avanzati per eludere il rilevamento.

Questa corsa agli armamenti tra l'IA generativa e i rilevatori di IA ha lasciato le università in bilico tra equità, integrità accademica ed evoluzione delle esigenze degli studenti.

Metodi di rilevamento comuni nell'istruzione superiore

1. Stilometria

La stilometria esamina lo stile di scrittura unico di uno studente nei suoi precedenti lavori, analizzando la grammatica, la punteggiatura, la struttura delle frasi e il vocabolario.

Una brusca deviazione nel tono o nella complessità spesso segnala l'uso dell'IA. Questo metodo è particolarmente efficace quando gli educatori dispongono di un portfolio di lavori precedenti dello studente da confrontare.

2. Analisi dei modelli statistici

I contenuti generati dall'IA spesso presentano una coerenza innaturale nella lunghezza delle frasi, nella formalità o nella struttura.

Rilevatori come Turnitin analizzano le anomalie sulla base di schemi noti nella scrittura umana. Tuttavia, i contenuti AI altamente modificati possono eludere tale analisi.

3. Analisi contestuale e semantica

Invece di limitarsi alla grammatica di superficie, l'analisi contestuale valuta profondità, rilevanza e coerenza.

Gli strumenti di intelligenza artificiale possono produrre contenuti che "suonano bene" ma che mancano di un'analisi approfondita o di un collegamento con il materiale del corso.

4. Rilevamento tramite apprendimento automatico

Alcune istituzioni utilizzano l'IA per combattere l'IA, addestrando modelli di apprendimento automatico per distinguere tra testo umano e testo generato dalla macchina sulla base di migliaia di saggi campione.

5. Revisione umana

Nonostante l'automazione, Gli educatori esperti rimangono i più precisi rilevatori di IAsoprattutto quando conoscono la voce dei loro studenti.

Infatti, un 2025 Studio arXiv hanno scoperto che gli istruttori esperti superano i rilevatori di IA nell'individuare i compiti sottili generati dall'IA.

Limiti del rilevamento dell'IA in ambito accademico

Sebbene i sistemi di rilevamento siano migliorati, diversi limiti critici rimanere:

- Falsi positivi possono accusare ingiustamente gli studenti, soprattutto quelli la cui scrittura si discosta dalla norma (ad esempio, studenti ESL o neurodiversi).

- Costo e accessibilità limitano le università con budget più ridotti dall'acquisire gli strumenti di rilevamento dell'IA più avanzati.

- Preoccupazioni etiche emergono quando le pratiche di rilevamento invasive violano la privacy degli studenti o favoriscono la sfiducia.

- Disparità nell'utilizzo dell'IA può aumentare ulteriormente il divario di risultati tra gli studenti con diversi livelli di accesso all'alfabetizzazione e agli strumenti di IA.

Queste preoccupazioni hanno spinto molte istituzioni a rivalutare non solo il modo in cui rilevano l'IA, ma anche il modo in cui la rilevano. ripensare la valutazione del tutto.

Implicazioni dell'uso della ChatGPT per studenti e università

Integrità accademica: I contributi generati dall'intelligenza artificiale possono oscurare la vera comprensione dello studente.

Se usato in modo non etico, il ChatGPT mette in discussione l'accuratezza della valutazione accademica e compromette il valore dei voti e delle credenziali.

Dilemmi etici: Dall'equità alla privacy dei dati, le università stanno cercando di capire dove tracciare il confine dell'uso dell'IA. L'IA dovrebbe essere vietata del tutto o integrata in modo ponderato?

Impatto a lungo termine: Un eccessivo affidamento all'IA potrebbe indebolire competenze essenziali come il pensiero critico, l'argomentazione e la creatività.

Se i risultati accademici vengono percepiti come assistiti dall'IA, la credibilità dei titoli di studio potrebbe diminuire agli occhi dei datori di lavoro e dei corsi di laurea.

Modi per utilizzare in modo sicuro gli strumenti di intelligenza artificiale (con l'intelligenza artificiale non rilevabile)

L'intelligenza artificiale non deve essere necessariamente nemica dell'onestà accademica: se usata correttamente, può migliorare la comprensione senza sostituire il pensiero originale.

Ecco come gli studenti possono utilizzare l'IA in modo sicuro e trasparente:

- Usate l'intelligenza artificiale per fare brainstorming, non per scrivere saggi completi.

- Citare le fonti se l'IA ha contribuito a generare le intuizioni.

- Modificare pesantemente l'opera per renderla propria.

- Utilizzate strumenti di umanizzazione per garantire che la vostra scrittura rifletta la vostra voce personale.

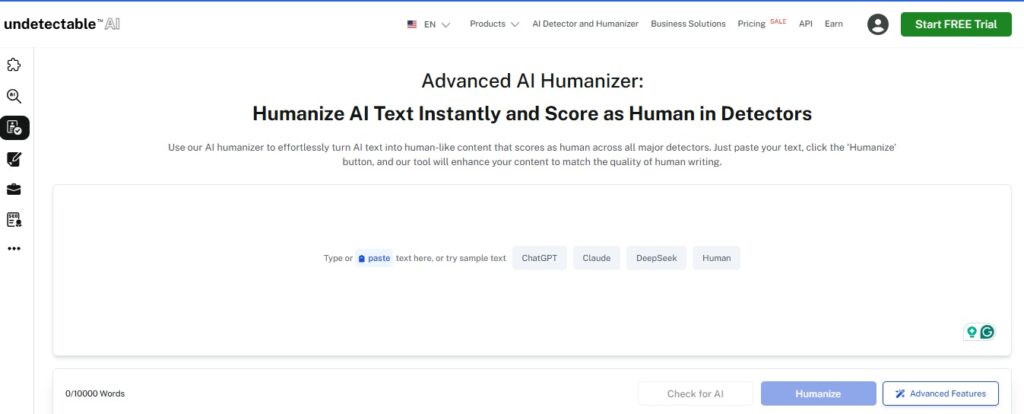

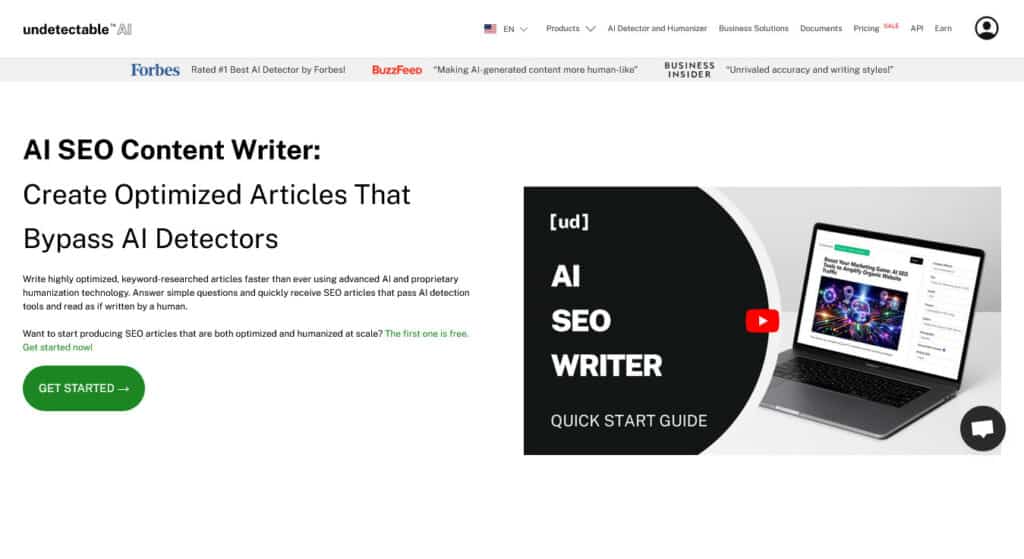

Strumenti consigliati da Undetectable AI

- Umanizzatore AI - Converte i risultati dell'intelligenza artificiale robotica in una scrittura simile a quella umana, in linea con la voce unica dell'utente.

- Scrittore di contenuti SEO AI - Ideale per gli studenti che gestiscono blog o portfolio personali e che necessitano di contenuti eticamente ottimizzati.

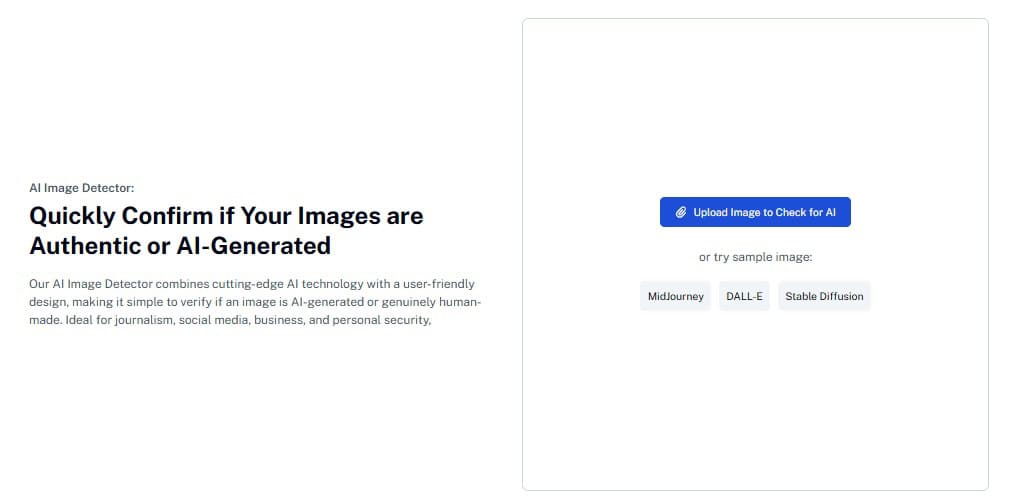

- Rilevamento delle immagini AIr - Progettato per i progetti visivi e le presentazioni multimediali, aiuta a garantire l'originalità e la conformità.

Utilizzando gli strumenti di Undetectable AI in modo responsabile, gli studenti possono abbracciare l'AI senza violare le aspettative accademiche e gli educatori possono creare fiducia attraverso la trasparenza.

Assicuratevi che la vostra scrittura sia in linea con gli standard della piattaforma: iniziate con il widget qui sotto.

Domande frequenti (FAQ)

Le università possono rilevare i contenuti generati da ChatGPT?

Sì, ma non sempre. Gli strumenti di rilevamento possono segnalare il probabile utilizzo dell'IA, ma spesso non identificano o identificano erroneamente i contenuti. La revisione umana rimane essenziale.

L'utilizzo di ChatGPT per l'aiuto è un imbroglio?

Dipende. Usare ChatGPT per fare brainstorming o chiarire un argomento può andare bene se approvato dal vostro istruttore. Spacciare per proprio il lavoro generato dall'intelligenza artificiale è considerato una disonestà accademica.

Cosa succede se un uno studente è accusato ingiustamente di aver usato l'AI?

I falsi positivi possono capitare. Per questo motivo le istituzioni sono invitate a combinare gli strumenti di IA con il giudizio degli educatori prima di prendere provvedimenti disciplinari.

Gli strumenti di intelligenza artificiale non rilevabili possono eludere il rilevamento?

L'intelligenza artificiale non rilevabile aiuta a umanizzare i contenuti e a ripristinare il flusso naturale, ma il suo scopo principale è quello di garantire chiarezza e originalità, non di ingannare i sistemi di rilevamento.

Le università continueranno ad evolvere le loro politiche sull'IA?

Assolutamente sì. La maggior parte delle istituzioni sta rivedendo attivamente le politiche, sviluppando nuove valutazioni ed esplorando come incorporare responsabilmente l'IA nell'istruzione.

Conclusione

Il futuro dell'istruzione non sta nell'evitare l'IA, ma nell'imparare a usarla con saggezza.

I college del 2025 stanno adottando sempre più metodi di rilevamento, ma la vera integrità accademica deriva dalla comprensione, dalla trasparenza e dalla fiducia degli studenti.

Che siate studenti alla ricerca di modi etici di utilizzare l'IAo un educatore che si sta adattando a un nuovo scenario di apprendimento, l'IA invisibile fornisce gli strumenti per supportare il vostro viaggio con integrità.

Esplora l'intelligenza artificiale non rilevabile e scoprire modi etici ed efficaci per lavorare con l'IA nelle aule scolastiche di oggi.