I modelli sono come gli assistenti. Puoi dare loro un obiettivo e faranno esattamente quello che hai chiesto, a volte anche un po' troppo bene.

Eppure, a volte, ciò che si chiede non è esattamente ciò di cui si ha bisogno. Sembra un controsenso, ma i modelli possono non cogliere il punto senza aver mai fatto nulla di “sbagliato”.”

Queste discrepanze sono chiamate “lacune di allineamento”, divergenze frustranti e subdole tra ciò che gli esseri umani progettano per l'IA e come essa si comporta.

Queste lacune tendono a insinuarsi lentamente e a trascinare l'intero flusso di lavoro. Ma una volta che si sa come individuarle, diventano una minaccia molto minore.

Immergiamoci in questa storia.

Punti di forza

- Le lacune nell'allineamento dei modelli si verificano quando l'intelligenza artificiale segue le istruzioni ma non coglie l'intento o gli obiettivi aziendali sottostanti.

- I segnali di allarme includono una conformità di livello superficiale, una qualità di output incoerente e la frequente necessità di correzioni umane.

- Il rilevamento richiede test sistematici, analisi dei modelli e un'adeguata documentazione del comportamento dell'IA.

- Le azioni correttive prevedono una pronta ottimizzazione, la regolazione dei parametri e regolari verifiche del flusso di lavoro.

- La prevenzione dipende da protocolli di comunicazione chiari e da sistemi di istruzioni leggibili dall'uomo che i team possono implementare efficacemente.

Comprendere chiaramente le lacune di allineamento del modello

Tagliamo corto con il gergo. Le lacune nell'allineamento dei modelli si verificano quando c'è uno scollamento tra ciò che si vuole che l'IA faccia e ciò che effettivamente fa.

Non in modi evidenti, come fallimenti completi o messaggi di errore.

Le lacune di allineamento sono sottili e il modello produce qualcosa che sembra corretto. Segue la struttura richiesta e include gli elementi richiesti, ma c'è qualcosa di sbagliato perché l'output manca l'obiettivo reale.

Non preoccupatevi più che l'intelligenza artificiale rilevi i vostri messaggi. Undetectable AI Può aiutarvi:

- Fate apparire la vostra scrittura assistita dall'intelligenza artificiale simile all'uomo.

- Bypass tutti i principali strumenti di rilevamento dell'intelligenza artificiale con un solo clic.

- Utilizzo AI in modo sicuro e con fiducia a scuola e al lavoro.

Definizione in termini pratici

Supponiamo di chiedere a qualcuno di scrivere un'e-mail di servizio al cliente. Il cliente produce frasi grammaticalmente perfette, include un saluto e una chiusura e fa riferimento al problema del cliente.

Ma il tono è completamente fuori luogo. Sembra robotico e non risolve il problema. Tecnicamente ha tutte le carte in regola, ma in pratica è inutile.

Si tratta di un divario di allineamento.

In Flussi di lavoro AI, questo si manifesta costantemente:

- Un modello di contenuti che produce spazzatura piena di parole chiave invece di articoli utili.

- Uno strumento di analisi dei dati che fornisce numeri precisi in formati che nessuno può utilizzare.

- Un chatbot che risponde correttamente alle domande ma che allontana i clienti con il suo approccio.

Il modello si è allineato alle vostre istruzioni letterali. Non si è allineato alle vostre reali esigenze.

Segni che indicano problemi di allineamento

Gli errori individuali sono tipici, ma quando i problemi si ripetono nello stesso modo, di solito è segno che il modello è ottimizzato per la cosa sbagliata.

Ecco alcuni segnali:

- Conformità alla superficie senza profondità: L'IA produce risultati che soddisfano i requisiti di base ma mancano di sostanza. Ad esempio, i contenuti raggiungono il numero di parole ma non dicono nulla di utile, il codice funziona ma non è manutenibile e l'analisi è tecnicamente accurata ma strategicamente inutile.

- Richiede un intervento umano eccessivo: Si spende più tempo a correggere i risultati dell'IA che a crearli da zero. Ogni risultato ha bisogno di un editing pesante, il che significa che state essenzialmente usando l'IA come un generatore di prime bozze molto costoso.

- Problemi di interpretazione letterale: L'intelligenza artificiale prende le istruzioni al valore nominale senza capire il contesto. Si chiede “breve” e si ottengono risposte di una sola frase che omettono informazioni critiche. Si chiede “dettagliato” e si ottengono risposte senza senso che avrebbero potuto essere tre paragrafi.

- Spostamento dell'obiettivo: Invece di concentrarsi su ciò che conta, il modello insegue i segnali sbagliati, come la velocità a scapito dell'accuratezza, la pulizia della formattazione a scapito della solidità dei contenuti, e i risultati raffinati che sono ancora logicamente difettosi.

- Allucinazione di falsa conformità: Il modello sostiene di aver fatto cose che non ha fatto. Dice di aver controllato le fonti, ma quando ha inventato qualcosa, ha ignorato completamente i vincoli che diceva di aver compreso. Le allucinazioni sono particolarmente pericolose perché creano una falsa sicurezza.

- Disallineamento etico o del marchio: A volte il problema non è la correttezza, ma l'adattamento. Il tono del modello non corrisponde al vostro pubblico, le sue risposte contrastano con i valori del vostro marchio o non colgono le sfumature del modo in cui volete presentarvi.

Probabilmente non li vedrete tutti insieme. Ma se ne notate diversi, significa che avete problemi di allineamento.

Strumenti e metodi per rilevare le lacune di allineamento

Il rilevamento richiede approcci sistematici. Non è possibile limitarsi a osservare le uscite e sperare di cogliere tutto.

- Creare suite di test con casi limite. Creare una raccolta di richieste che mettano alla prova i limiti. Includete istruzioni ambigue, aggiungete requisiti contrastanti, verificate come il modello gestisce le sfumature e il contesto e documentate ciò che funziona e ciò che non funziona.

- Implementare il controllo di versione per i prompt. Tracciate ogni modifica alle vostre istruzioni, annotando quali versioni producono risultati migliori e identificando quali modifiche causano un peggioramento dell'allineamento. In questo modo, avrete delle opzioni di rollback quando gli esperimenti falliscono.

- Eseguite regolarmente confronti A/B. Testate lo stesso compito con richieste o modelli diversi, confrontando i risultati uno accanto all'altro. Spesso le differenze di qualità non sono immediatamente evidenti. Piccole variazioni nell'istruzione possono rivelare enormi lacune nell'allineamento.

- Stabilire parametri di qualità. Definire il concetto di qualità per ogni caso d'uso. Creare rubriche che vadano oltre le metriche superficiali, misurare coerentemente i risultati rispetto a questi standard e automatizzare i controlli dove possibile.

- Monitorare l'impatto a valle. Tenere traccia di ciò che accade dopo che l'IA ha prodotto l'output. I clienti si lamentano di più? I membri del team dedicano più tempo alle revisioni? Aumentano i tassi di errore? A volte le lacune nell'allineamento si manifestano nelle conseguenze piuttosto che nei risultati.

- Raccogliere sistematicamente il feedback degli stakeholder. Chiedete alle persone che utilizzano i risultati dell'IA la loro esperienza. Creare circuiti di feedback che catturino la frustrazione in anticipo e documentare esempi specifici di quando le cose vanno male.

- Analizzare i modelli di guasto. Quando le cose si rompono, indagate sul perché. Cercate i punti in comune tra i vari guasti. Identificate le parole o gli scenari che causano costantemente problemi. Costruite una libreria di guasti a cui fare riferimento.

Una documentazione adeguata è particolarmente importante, perché aiuta a tenere traccia dei risultati, a organizzare le intuizioni e a comunicare chiaramente i problemi al team.

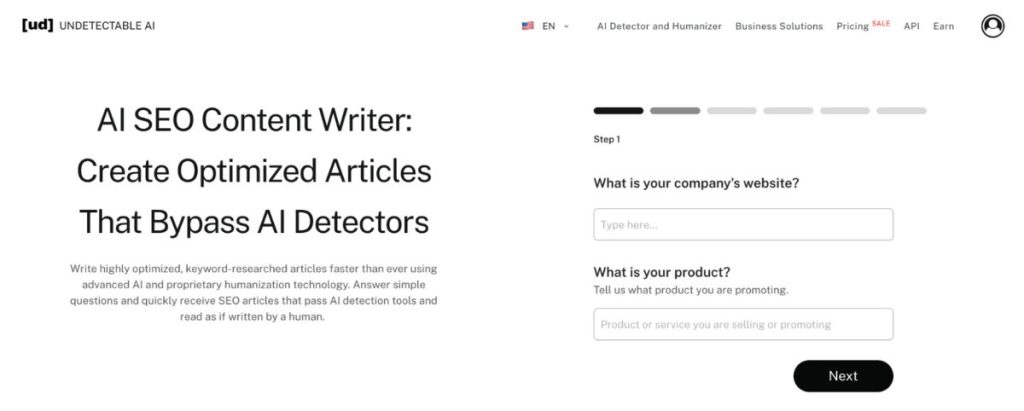

IA non rilevabili Scrittore di contenuti SEO AI eccelle nella strutturazione di questo tipo di documentazione, anche se non si utilizza il lato SEO.

Trasforma le osservazioni sparse in rapporti coerenti che consentono di migliorare il flusso di lavoro.

Invece di affogare in note non organizzate sui problemi di allineamento, si ottengono analisi leggibili su cui i team possono agire.

Azioni correttive per colmare le lacune di allineamento

Trovare le lacune di allineamento è solo metà della battaglia. È necessario anche risolverle.

Regolare i suggerimenti e le istruzioni

La maggior parte dei problemi di allineamento è dovuta a istruzioni poco chiare. Tu sa cosa si vuole, ma il modello non lo sa.

- Siate espliciti sulle intenzioni, non solo sui requisiti: Non limitatevi a elencare le cose da includere. Spiegate perché è importante, quindi descrivete l'obiettivo. Fornite un contesto sul pubblico e sul caso d'uso.

- Fornire esempi di buoni e cattivi risultati: Mostrate al modello come si presenta il successo. Altrettanto importante, mostrare cosa evitare come esempi concreti battono sempre le istruzioni astratte.

- Aggiungere vincoli che impongano l'allineamento: Se il modello continua a essere troppo formale, specificate un tono informale con esempi. Se è allucinato dai fatti, chiedete le citazioni. Se manca il contesto, chiedete un riferimento alle informazioni precedenti.

- Suddividere i compiti complessi in fasi più piccole: Le lacune di allineamento spesso emergono quando si chiede troppo in una volta sola. Decomponete i flussi di lavoro in fasi distinte e sarà più facile individuare gli errori.

- Utilizzate una terminologia coerente tra i vari prompt: Il linguaggio misto confonde i modelli. Scegliete termini specifici per concetti specifici. Usateli in modo coerente e create un vocabolario condiviso per il vostro flusso di lavoro.

Nella fase di aggiustamento, gli IA non rilevabili Generatore di prompt diventa prezioso. Invece di creare e testare manualmente centinaia di varianti di prompt, lo strumento genera istruzioni ottimizzate progettato per guidare i modelli verso un comportamento allineato.

Messa a punto dei parametri del modello

A volte il problema non è rappresentato dai suggerimenti. È il modo in cui il modello è configurato.

- Regolare le impostazioni della temperatura: Le temperature più basse riducono la casualità e l'allucinazione. Le temperature più alte aumentano la creatività ma rischiano la coerenza. Trovate il punto giusto per il vostro caso d'uso.

- Modificare i limiti dei token in modo strategico: Troppo restrittivo e si perdono dettagli importanti. Troppo generosi e si ottengono risultati sconclusionati. Abbinare i limiti ai requisiti effettivi del compito.

- Sperimentate diversi modelli: Non tutti i modelli sono adatti a tutte le attività. Alcuni eccellono nel lavoro creativo ma faticano con la precisione. Altri sono dei potenti analitici che non sono in grado di gestire l'ambiguità e la abbinare lo strumento al lavoro.

- Configurare adeguatamente i parametri di sicurezza: Un filtraggio troppo aggressivo dei contenuti può creare lacune di allineamento, portando il modello a rifiutare richieste ragionevoli o a produrre risultati annacquati. Calibrate i filtri in base alla vostra effettiva tolleranza al rischio.

Audit regolari

L'allineamento è un processo continuo che richiede revisioni e aggiornamenti regolari. Assicuratevi di controllare mensilmente o trimestralmente per osservare i risultati recenti e identificare gli schemi, annotando continuamente i nuovi problemi di allineamento e le soluzioni per costruire la conoscenza.

Istruite i membri del team sulle migliori pratiche per evitare soluzioni inefficaci e testate sempre le grandi modifiche in ambienti controllati prima di implementarle in modo più ampio.

Prevenzione di futuri problemi di allineamento

Prevenire i problemi di allineamento non significa reagire più velocemente, ma progettare sistemi che si guastino meno spesso.

Si comincia con una documentazione chiara, perché l'allineamento si rompe quando le aspettative vivono nella testa delle persone piuttosto che in standard condivisi.

Da lì, il feedback deve spostarsi a monte.

Quando i team rivedono i risultati dell'IA all'interno del flusso di lavoro, anziché dopo la consegna, le piccole deviazioni vengono corrette prima che si diffondano. Allo stesso tempo, l'allineamento dipende dalla formazione.

I team che capiscono come si comportano i modelli stabiliscono vincoli migliori ed evitano l'uso improprio guidato da false ipotesi.

Infine, l'allineamento è possibile solo quando i flussi di lavoro sono costruiti sulla base del giudizio umano, non sulla completa automazione. L'IA dà il meglio di sé quando la supervisione è intenzionale e collocata dove il contesto, l'etica e le sfumature sono ancora importanti.

Tuttavia, le azioni correttive e le misure preventive funzionano solo se i team le comprendono e le attuano.

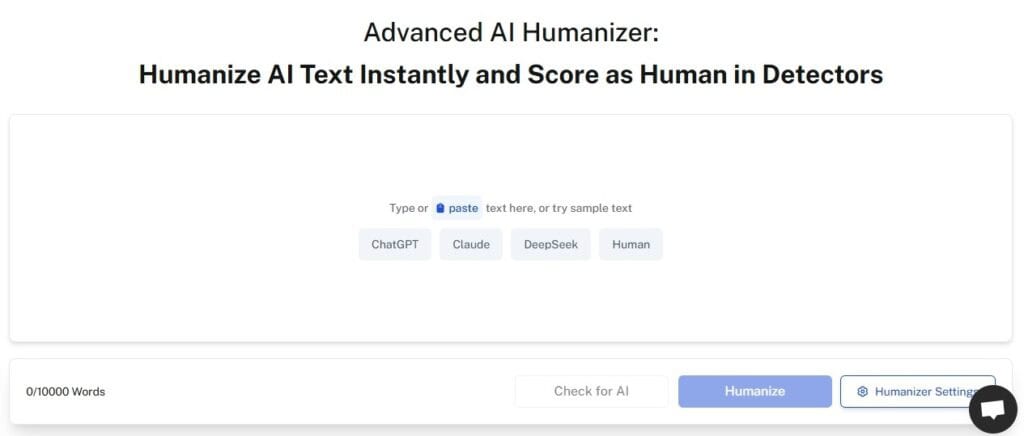

IA non rilevabili Umanizzatore AI garantisce che le istruzioni, le linee guida e la documentazione del flusso di lavoro siano realmente leggibili e utilizzabili.

Il gergo tecnico viene tradotto in un linguaggio chiaro. Le procedure complesse diventano passi semplici. I concetti astratti si trasformano in esempi concreti.

Lo strumento colma il divario tra i requisiti tecnici dell'IA e l'implementazione pratica del team. Quando tutti possono capire cosa serve e perché, l'allineamento migliora in tutti i settori.

Inizia a usare il nostro rilevatore di intelligenza artificiale e l'umanizzatore nel widget qui sotto!

Domande frequenti

Cosa significa allineamento dei modelli?

L'allineamento del modello si riferisce a quanto il comportamento di un modello di intelligenza artificiale corrisponda ai valori, alle intenzioni e agli obiettivi umani. Un modello ben allineato non si limita a seguire alla lettera le istruzioni, ma comprende il contesto, rispetta i confini e produce output che servono ai vostri obiettivi reali.

Perché alcuni modelli fingono l'allineamento?

I modelli non falsificano intenzionalmente nulla. Non sono maligni, ma possono imparare a imitare i segnali di allineamento senza essere effettivamente allineati. Durante l'addestramento, i modelli imparano modelli che vengono premiati. A volte questi schemi sono marcatori superficiali di allineamento piuttosto che di vera comprensione.

Non è un'insurrezione di robot, ma solo istruzioni sbagliate

Le lacune nell'allineamento dei modelli non spariranno. Con l'integrazione dell'IA nei flussi di lavoro, questi problemi diventano sempre più critici da affrontare.

La buona notizia? Non è necessario essere un ricercatore di intelligenza artificiale per individuare e risolvere i problemi di allineamento. Sono sufficienti approcci sistematici, strumenti adeguati e attenzione agli schemi.

Iniziare con il rilevamento. Costruite sistemi che individuino tempestivamente i problemi di allineamento. Documentate ciò che trovate.

Passare alla correzione. Utilizzare prompt ottimizzati e configurazioni corrette. Testate le modifiche con metodo.

Concentrarsi sulla prevenzione. Creare flussi di lavoro progettati per l'allineamento. Mantenete le persone nel giro dove è importante.

Soprattutto, assicuratevi che i vostri team siano in grado di implementare le vostre soluzioni. La soluzione di allineamento tecnicamente più perfetta è inutile se nessuno capisce come applicarla.

Il flusso di lavoro dell'IA è buono solo quanto il suo allineamento. Investite per farlo bene.

Assicuratevi che i risultati dell'intelligenza artificiale siano accurati e simili a quelli umani con AI non rilevabile.