Modeller er som assistenter. Du kan gi dem et mål, og de gjør akkurat det du ber om, noen ganger litt for godt.

Men noen ganger er det du ber om, ikke akkurat det du trenger. Det høres bakvendt ut, men modeller kan bomme på poenget uten å gjøre noe “galt”.”

Disse uoverensstemmelsene kalles “alignment gaps”, frustrerende og snikende avvik mellom hvordan mennesker designer AI, og hvordan den oppfører seg.

Disse hullene har en tendens til å snike seg inn sakte, og til slutt kan de ødelegge hele arbeidsflyten. Men når du først vet hvordan du skal oppdage dem, blir de en mye mindre trussel.

La oss dykke ned i det.

Det viktigste å ta med seg

- Gap i modelltilpasningen oppstår når AI følger instruksjonene, men ikke forstår den underliggende intensjonen eller forretningsmålene.

- Advarselstegnene omfatter overfladisk samsvar, inkonsekvent utdatakvalitet og hyppig behov for menneskelige korreksjoner.

- Oppdagelse krever systematisk testing, mønsteranalyse og skikkelig dokumentasjon av AI-atferd.

- Korrigerende tiltak innebærer rask optimalisering, parameterjusteringer og regelmessige arbeidsflytrevisjoner.

- Forebygging avhenger av tydelige kommunikasjonsprotokoller og lesbare instruksjonssystemer som teamene kan implementere på en effektiv måte.

Forstå hullene i modelltilpasningen på en tydelig måte

La oss gå gjennom sjargongen. Modelltilpasningsgap oppstår når det ikke er samsvar mellom det du ønsker at AI-en skal gjøre, og det den faktisk gjør.

Ikke på åpenbare måter, som komplette feil eller feilmeldinger.

Justeringsgapene er subtile, og modellen produserer noe som ser riktig ut. Den følger strukturen i ledeteksten og inneholder de elementene du har bedt om, men noe føles feil fordi resultatet ikke når det egentlige målet ditt.

Aldri bekymre deg for at AI oppdager tekstene dine igjen. Undetectable AI Kan hjelpe deg:

- Få AI-assistert skriving til å vises ...menneskelignende.

- Bypass alle de viktigste AI-deteksjonsverktøyene med bare ett klikk.

- Bruk AI trygt og selvsikkert i skole og arbeid.

Definisjon i praktiske termer

La oss si at du ber noen om å skrive en e-post til kundeservice. De skriver grammatisk perfekte setninger, inkluderer en hilsen og en avslutning, og henviser til kundens problem.

Men tonen er helt feil. Det høres robotaktig ut, og det løser faktisk ikke problemet. Teknisk sett oppfyller den alle kravene, men i praksis er den ubrukelig.

Det er et justeringsgap.

I AI-arbeidsflyter, ...manifesterer dette seg hele tiden:

- En innholdsmodell som produserer søkeordfylt søppel i stedet for nyttige artikler.

- Et dataanalyseverktøy som spytter ut nøyaktige tall i formater som ingen kan bruke.

- En chatbot som svarer riktig på spørsmål, men som skremmer bort kundene med sin tilnærming.

Modellen var i tråd med dine bokstavelige instruksjoner. Den samsvarte ikke med dine faktiske behov.

Tegn som indikerer problemer med innretting

Enkeltstående feil er typiske, men når problemene gjentar seg på samme måte, er det vanligvis et tegn på at modellen er optimalisert for feil ting.

Her er noen tegn:

- Overensstemmelse på overflatenivå uten dybde: Den kunstige intelligensen produserer resultater som oppfyller grunnleggende krav, men som mangler substans. For eksempel innhold som teller ord, men som ikke sier noe nyttig, kode som kjører, men som ikke kan vedlikeholdes, og analyser som er teknisk nøyaktige, men strategisk verdiløse.

- Overdreven menneskelig inngripen kreves: Du bruker mer tid på å fikse AI-resultater enn på å lage dem fra bunnen av. Hvert resultat må redigeres kraftig, noe som betyr at du i praksis bruker AI-en som en veldig dyr førsteutkastgenerator.

- Problemer med bokstavelig tolkning: Den kunstige intelligensen tar instruksjoner for pålydende uten å forstå konteksten. Du ber om “kort” og får svar på én setning som utelater viktig informasjon. Du ber om “detaljert” og får essaylangt nonsens som kunne ha vært tre avsnitt.

- Målforskyvning: I stedet for å fokusere på det som er viktig, jakter modellen på feil signaler, som hastighet fremfor nøyaktighet, ren formatering fremfor solid innhold, og polerte resultater som fortsatt er logisk mangelfulle.

- Hallusinasjon av falsk etterlevelse: Modellen hevder å ha gjort ting den ikke har gjort. Den sier at den har sjekket kilder, men når den fant på ting, ignorerte den fullstendig de begrensningene den hevdet å forstå. Hallusinasjoner er spesielt farlige fordi de skaper falsk tillit.

- Etisk eller merkevaremessig mistilpasning: Noen ganger er problemet ikke korrekthet, men passform. Modellens tone passer ikke til målgruppen din, svarene kolliderer med merkevareverdiene dine, eller den går glipp av nyansene i hvordan du ønsker å fremstå.

Du vil sannsynligvis ikke se alle disse på en gang. Men hvis du legger merke til flere av dem, har du problemer med justeringen.

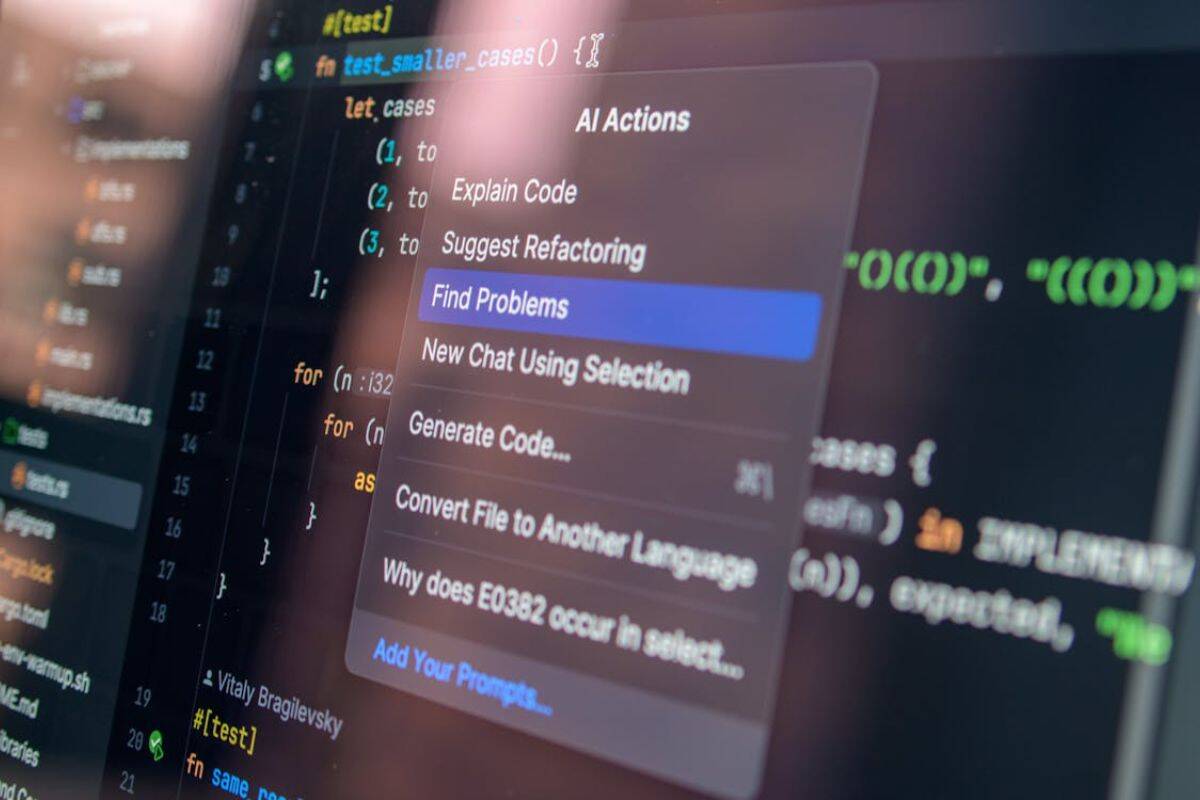

Verktøy og metoder for å oppdage Alignment Gaps

Oppdagelse krever systematiske tilnærminger. Du kan ikke bare se på utdataene og håpe at du fanger opp alt.

- Opprett testsuiter med edge cases. Bygg opp en samling oppgaver som tester grensene. Inkluder tvetydige instruksjoner, legg til motstridende krav, se hvordan modellen håndterer nyanser og kontekst, og dokumenter hva som fungerer og hva som ikke fungerer.

- Implementere versjonskontroll for ledetekster. Spor alle endringer i instruksjonene dine ved å notere hvilke versjoner som gir bedre resultater, og identifiser hvilke endringer som fører til at justeringen blir dårligere. På den måten har du mulighet til å tilbakestille når eksperimenter mislykkes.

- Kjør A/B-sammenligninger regelmessig. Test den samme oppgaven med ulike instruksjoner eller modeller, og sammenlign resultatene side om side. Ofte er kvalitetsforskjellene ikke umiddelbart åpenbare. Små variasjoner i instruksjonene kan avsløre store hull i tilpasningen.

- Fastsett kvalitetsreferanser. Definer hva som faktisk ser bra ut for hvert enkelt brukstilfelle. Lag kriterier som går lenger enn overfladiske beregninger, mål resultatene konsekvent opp mot disse standardene, og automatiser kontrollene der det er mulig.

- Overvåk effekten nedstrøms. Følg med på hva som skjer etter at AI-en har produsert output. Klager kundene mer? Bruker teammedlemmene ekstra tid på revisjoner? Øker feilraten? Noen ganger viser det seg at avvik i tilpasningen har konsekvenser i stedet for resultater.

- Samle inn tilbakemeldinger fra interessenter på en systematisk måte. Spør de som bruker AI-resultatene om hvordan de opplever dem. Lag tilbakemeldingssløyfer som fanger opp frustrasjon tidlig, og dokumenter konkrete eksempler på når ting går galt.

- Analyser feilmønstre. Når ting går i stykker, må du undersøke hvorfor. Se etter fellestrekk på tvers av feil. Identifiser utløsende ord eller scenarier som konsekvent forårsaker problemer. Bygg opp et feilbibliotek som du kan bruke som referanse.

Riktig dokumentasjon er spesielt viktig, ettersom det hjelper deg med å spore funn, organisere innsikt og kommunisere problemer tydelig til teamet ditt.

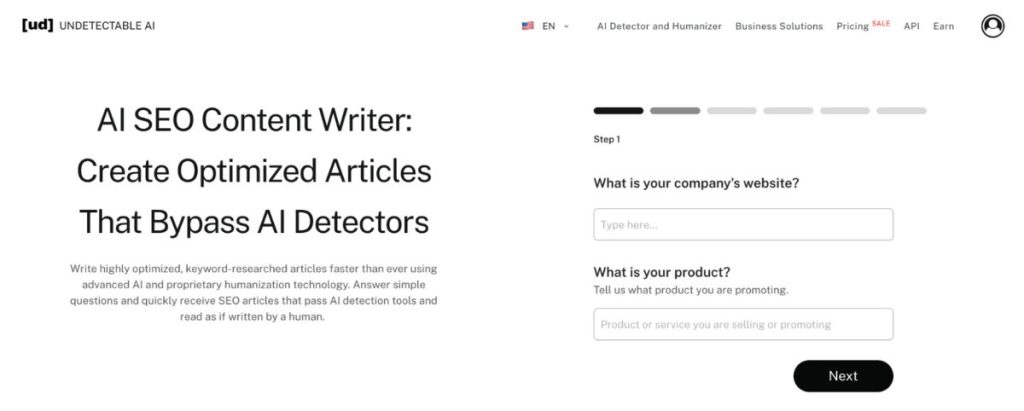

Uoppdagelige AI-er AI SEO-innholdsforfatter er utmerket til å strukturere denne typen dokumentasjon, selv om du ikke bruker SEO-siden.

Den forvandler spredte observasjoner til sammenhengende rapporter som faktisk fører til forbedringer i arbeidsflyten.

I stedet for å drukne i uorganiserte notater om tilpasningsproblemer, får du lesbare analyser som teamene kan handle ut fra.

Korrigerende tiltak for å utbedre mangler i tilpasningen

Å finne hull i justeringen er bare halve jobben. Du må også fikse dem.

Juster ledetekster og instruksjoner

De fleste justeringsproblemer skyldes uklare instruksjoner. Du vet hva du vil, men det gjør ikke modellen.

- Vær tydelig på intensjonen, ikke bare på kravene: Ikke bare list opp hva som skal være med. Forklar hvorfor det er viktig, og beskriv deretter målet. Gi kontekst om målgruppen og bruksområdet.

- Gi eksempler på gode og dårlige resultater: Vis modellen hvordan suksess ser ut. Like viktig er det å vise hva man bør unngå som konkrete eksempler slår abstrakte instruksjoner hver gang.

- Legg til begrensninger som håndhever innretting: Hvis modellen stadig er for formell, kan du spesifisere en uformell tone med eksempler. Hvis den hallusinerer om fakta, be om kildehenvisninger. Hvis den mangler kontekst, kan du be om en henvisning til tidligere informasjon.

- Del opp komplekse oppgaver i mindre trinn: Det oppstår ofte hull i tilpasningen når du ber om for mye på én gang. Hvis du deler opp arbeidsflyten i ulike faser, blir det lettere å oppdage hvor ting går galt.

- Bruk konsekvent terminologi på tvers av instruksjonene: Blandingsspråk forvirrer modeller. Velg spesifikke termer for spesifikke konsepter. Bruk dem konsekvent, og skap et felles vokabular for arbeidsflyten.

I justeringsfasen kan ikke detekterbare AI-er Spørregenerator blir uvurderlig. I stedet for å lage og teste hundrevis av variasjoner av ledetekster manuelt, genererer verktøyet optimaliserte instruksjoner utformet for å veilede modeller mot tilpasset atferd.

Finjustere modellparametere

Noen ganger er det ikke instruksjonene som er problemet. Det er hvordan modellen er konfigurert.

- Juster temperaturinnstillingene: Lavere temperaturer reduserer tilfeldigheter og hallusinasjoner. Høyere temperaturer øker kreativiteten, men risikerer å skape koherens. Finn den beste temperaturen for ditt bruksområde.

- Endre tokengrensene strategisk: Hvis du er for restriktiv, mister du viktige detaljer. Hvis du er for sjenerøs, får du uoversiktlige resultater. Tilpass grensene til de faktiske oppgavekravene.

- Eksperimenter med ulike modeller: Ikke alle modeller passer til alle oppgaver. Noen utmerker seg i kreativt arbeid, men sliter med presisjon. Andre er analytiske kraftpakker som ikke takler tvetydighet og tilpasse verktøyet til jobben.

- Konfigurer sikkerhetsparametrene på riktig måte: En for aggressiv filtrering av innhold kan skape mangler i tilpasningen, noe som kan føre til at modellen avviser rimelige forespørsler eller produserer utvannede resultater. Kalibrer filtrene etter din faktiske risikotoleranse.

Regelmessige revisjoner

Alignment er en kontinuerlig prosess som krever regelmessige gjennomganger og oppdateringer. Sørg for å sjekke inn månedlig eller kvartalsvis for å observere de siste resultatene og identifisere mønstre, samtidig som du kontinuerlig noterer ned nye tilpasningsproblemer og løsninger for å bygge opp kunnskap.

Gi teammedlemmene ny opplæring i beste praksis for å unngå ineffektive løsninger, og test alltid store endringer i kontrollerte miljøer før du implementerer dem bredt.

Forebygging av fremtidige justeringsproblemer

Å forebygge tilpasningsproblemer handler ikke om å reagere raskere, men om å utforme systemer som svikter sjeldnere.

Det begynner med tydelig dokumentasjon, fordi samkjøringen bryter sammen når forventningene lever i hodene på folk i stedet for i felles standarder.

Derfra må tilbakemeldingen gå oppstrøms.

Når teamene går gjennom AI-resultatene i arbeidsflyten i stedet for etter levering, kan små avvik korrigeres før de blir for store. Samtidig er tilpasning avhengig av utdanning.

Team som forstår hvordan modeller oppfører seg, setter bedre begrensninger og unngår misbruk basert på feilaktige antakelser.

Til slutt er det bare mulig å oppnå samsvar når arbeidsflyten er bygget rundt menneskelig dømmekraft, ikke rundt full automatisering. AI fungerer best når tilsynet er bevisst og plasseres der kontekst, etikk og nyanser fortsatt har betydning.

Korrigerende og forebyggende tiltak fungerer imidlertid bare hvis teamene forstår og gjennomfører dem.

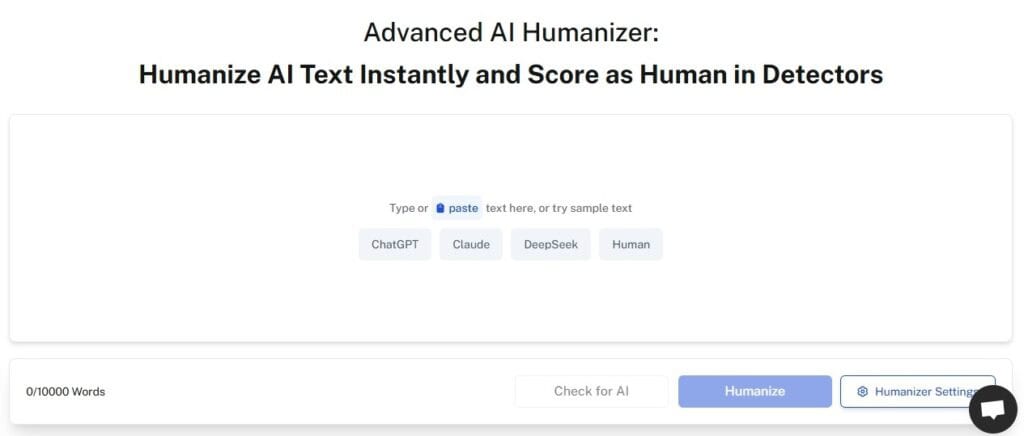

Uoppdagelige AI-er AI Humanizer sikrer at instruksjonene, retningslinjene og dokumentasjonen av arbeidsflyten er lett lesbare og handlingsrettede.

Teknisk sjargong blir oversatt til klart språk. Komplekse prosedyrer blir til enkle trinn. Abstrakte begreper blir til konkrete eksempler.

Verktøyet bygger bro mellom tekniske AI-krav og praktisk implementering i teamet. Når alle kan forstå hva som trengs og hvorfor, blir samkjøringen bedre over hele linjen.

Begynn å bruke vår AI Detector og Humanizer i widgeten nedenfor!

Ofte stilte spørsmål

Hva betyr modelltilpasning?

Modelltilpasning refererer til hvor godt en AI-modells atferd samsvarer med menneskelige verdier, intensjoner og mål. En godt tilpasset modell følger ikke bare instruksjonene bokstavelig, men forstår konteksten, respekterer grenser og produserer resultater som tjener de faktiske målene dine.

Hvorfor forfalsker noen modeller justeringen?

Modeller forfalsker ikke noe med vilje. De er ikke ondsinnede, men de kan lære seg å etterligne justeringssignaler uten å faktisk være justert. Under treningen lærer modellene mønstre som belønnes. Noen ganger er disse mønstrene overfladiske markører for alignment i stedet for ekte forståelse.

Ikke et robotopprør, bare dårlige instruksjoner

Manglene i modelltilpasningen forsvinner ikke. Etter hvert som AI blir mer integrert i arbeidsflyten, blir det stadig viktigere å ta tak i disse problemene.

Den gode nyheten? Du trenger ikke å være AI-forsker for å oppdage og løse justeringsproblemer. Du trenger bare en systematisk tilnærming, de riktige verktøyene og oppmerksomhet på mønstre.

Begynn med deteksjon. Bygg systemer som fanger opp justeringsproblemer tidlig. Dokumenter det du finner.

Gå til korreksjon. Bruk optimaliserte meldinger og riktige konfigurasjoner. Test endringene metodisk.

Fokuser på forebygging. Skap arbeidsflyter som er utformet for å samkjøre. Hold menneskene oppdatert der det er viktig.

Det viktigste er at du sørger for at teamene dine faktisk kan implementere løsningene dine. Den mest teknisk perfekte tilpasningsløsning er verdiløs hvis ingen forstår hvordan den skal brukes.

AI-arbeidsflyten din er bare så god som tilpasningen av den. Invester i å gjøre det riktig.

Sørg for at AI-resultatene dine forblir nøyaktige og menneskelignende med Ikke påvisbar AI.