AI-detektorer er som Voight-Kampff-testen fra Blade Runner, et verktøy som brukes til å skille mellom ekte og kunstige mennesker.

Men i stedet for å stille emosjonelle spørsmål og skanne øyebevegelser, baserer AI-detektorer seg på maskinlæring (ML) og naturlig språkbehandling (NLP) for å identifisere AI-generert innhold.

Ironisk, ikke sant?

ChatGPT og andre kjente AI-verktøy bruker også ML og NLP til å generere innhold.

Det er som å bygge et hus etter samme tegning og så beskylde det for å være en kopi.

Så hvordan fungerer egentlig AI-detektorer? Og hva betyr de for skribenter som deg? La oss finne ut av det.

Det viktigste å ta med seg

Før vi går inn i dette kaninhullet, her er de viktigste punktene du bør huske på:

- Oppdagelsen er ikke perfekt. Selv de beste AI-innholdsmålerne gjør feil. Falske positive og falske negative funn forekommer regelmessig.

- Nøyaktigheten varierer veldig. Noen detektorer presterer knapt bedre enn tilfeldig gjetting. Andre oppnår brukbare resultater, men gjør likevel betydelige feil.

- Konteksten betyr mer enn du tror. Skrivestil, emnets kompleksitet og innholdets lengde påvirker nøyaktigheten i deteksjonen.

- Hybride tilnærminger fungerer bedre. Verktøy som kombinerer deteksjon med omskriving av innhold, gir mer praktiske løsninger enn deteksjon alene.

- Åpenhet er sjelden. De fleste selskaper publiserer ikke reelle nøyaktighetsmålinger. Når de gjør det, er tallene ofte misvisende.

Hvordan fungerer AI-innholdsdetektorer?

AI-innholdssøkere er som mønstergjenkjenningssystemer. De trenes opp på massive datasett med menneskeskrevet og AI-generert tekst.

Målet er enkelt: Lær deg å se forskjellene.

Men det er her det blir komplisert.

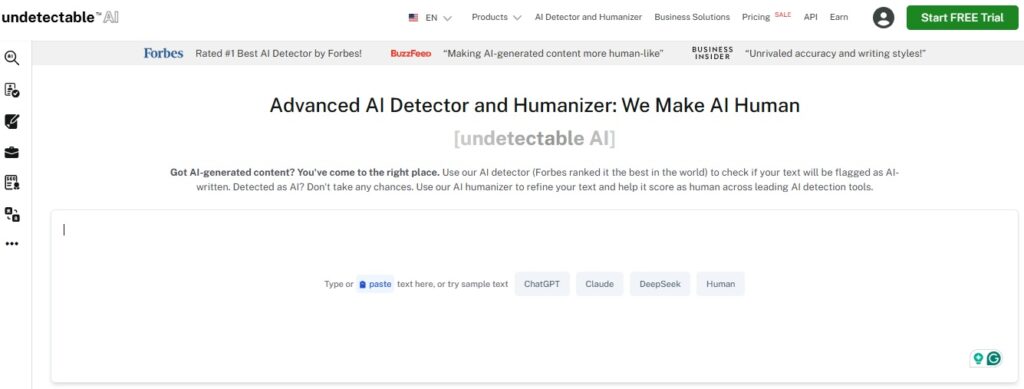

Aldri bekymre deg for at AI oppdager tekstene dine igjen. Undetectable AI Kan hjelpe deg:

- Få AI-assistert skriving til å vises ...menneskelignende.

- Bypass alle de viktigste AI-deteksjonsverktøyene med bare ett klikk.

- Bruk AI trygt og selvsikkert i skole og arbeid.

Disse verktøyene ser etter spesifikke mønstre i teksten. Ting som setningsstruktur, ordvalg og avsnittsflyt. De tildeler sannsynlighetspoeng basert på hvor "AI-aktig" teksten fremstår.

Hva er problemet? Det blir stadig vanskeligere å skille mellom menneskelig og kunstig intelligens. Moderne AI-modeller som GPT-4o kan produsere tekst som er bemerkelsesverdig menneskelignende.

Dette skaper en grunnleggende utfordring for deteksjonssystemer.

De fleste detektorer bruker en av to tilnærminger. Den første er perplexitetsanalyse. Denne måler hvor "overrasket" detektoren blir over ordvalgene.

AI har en tendens til å velge mer forutsigbare ord, mens mennesker er mer tilfeldige.

Den andre tilnærmingen er deteksjon av burstiness. Her ser man på variasjon i setningslengde og kompleksitet. Mennesker har en tendens til å skrive med mer variasjon. AI produserer ofte mer konsistente mønstre.

Ingen av de to tilnærmingene er idiotsikre. God AI-skriving kan etterligne menneskelig tilfeldighet.

Menneskelig skrift kan noen ganger virke veldig systematisk.

Hva bør regnes som AI-innhold?

Dette spørsmålet er vanskeligere enn det ser ut til.

Er innhold som er 50% AI-generert, å anse som AI-innhold? Hva med menneskeskrevet innhold som er redigert av AI?

Bransjen har ikke kommet frem til klare definisjoner. Noen detektorer flagger alt innhold med AI-assistanse. Andre flagger bare tekst som er fullstendig AI-generert.

Denne inkonsekvensen gjør det nesten umulig å sammenligne nøyaktigheten.

Tenk på disse scenariene:

- Et menneske skriver et utkast, og bruker deretter kunstig intelligens til å forbedre grammatikk og flyt. Er dette AI-innhold?

- Noen bruker AI til å generere ideer, og skriver deretter alt fra bunnen av. AI-innhold eller ikke?

- En skribent bruker AI til å lage en disposisjon, og skriver deretter originalt innhold som følger denne strukturen.

Disse unntakstilfellene viser hvorfor nøyaktighetsmålinger kan være misvisende. Ulike verktøy definerer "AI-innhold" forskjellig.

Dette påvirker deres rapporterte treffsikkerhet.

I praksis fokuserer de fleste verktøyene på å oppdage innhold som primært er generert av kunstig intelligens. Men grensene er fortsatt uklare.

Hva gjør en AI-innholdsdetektor "nøyaktig"?

Nøyaktighet i AI-deteksjon handler ikke bare om å få riktig svar. Det handler om å få riktig svar konsekvent, på tvers av ulike typer innhold og brukstilfeller.

Det er derfor noen er å avvise disse verktøyene.

Noen hevder at disse detektorene kan være like inkonsekvente som spådommene fra en lykkekake, noe som reiser viktige spørsmål om pålitelighet og tillit.

Men ekte nøyaktighet krever at man balanserer mellom to typer feil. Falske positiver skjer når menneskelig innhold blir flagget som AI.

Falske negativer oppstår når AI-innhold utgis for å være skrevet av mennesker.

Kostnadene ved disse feilene varierer fra kontekst til kontekst. Når det gjelder akademisk integritet, kan falske positive resultater ødelegge studentenes tillit.

Når det gjelder innholdsmarkedsføring, kan falske negativer føre til straff fra søkemotorer.

Nøyaktigheten avhenger også av kvaliteten på opplæringsdataene. Detektorer som er trent på eldre AI-modeller, kan slite med nyere, mer sofistikerte AI-skriving.

Dette skaper et konstant våpenkappløp mellom deteksjon og generasjon.

De beste detektorene tar hensyn til flere faktorer:

- Statistiske mønstre i ordbruk og setningsstruktur

- Semantisk koherens og logisk flyt

- Konsistent skrivestil gjennom hele innholdet

- Domenespesifikk kunnskap og demonstrasjon av kompetanse

Men selv omfattende tilnærminger har sine begrensninger. Menneskers skrivemåter varierer enormt. Noen mennesker skriver naturlig i mønstre som utløser AI-detektorer.

Andre kan etterligne AI-lignende konsistens.

Målet er ikke perfekt nøyaktighet. Det er pålitelig nøyaktighet som tjener dine spesifikke behov.

Og selv om ingen detektor er feilfri, kan det rette verktøyet utgjøre forskjellen mellom en sikker innsending og et flagget dokument.

Uoppdagelig AI-detektor og humanizer jobber sammen i én enkelt arbeidsflyt, og tilbyr en balansert tilnærming som ikke bare identifiserer AI-generert tekst, men som også omskriver den på en naturlig måte.

Med denne integrerte løsningen får du både deteksjonsnøyaktighet og praktiske løsninger i én og samme sømløse opplevelse.

Prøv Undetectable AI Detector and Humanizer i dag, og opplev tryggheten av AI-fritt, autentisk innhold som er klart for alle utfordringer.

Slik måler vi nøyaktigheten til AI-detektorene våre

De fleste selskaper slenger rundt seg med nøyaktighetsprosenter uten å forklare hvordan de har beregnet dem. Vi tror på åpenhet.

Våre nøyaktighetstester følger rigorøs metodikk.

Vi bruker ulike datasett som inkluderer innhold fra flere AI-modeller, menneskelige skribenter på ulike ferdighetsnivåer og ulike innholdstyper.

Her er testprosessen vår:

- Opprettelse av datasett: Tusenvis av AI-genererte teksteksempler. Vi har skrevet akademiske essays, markedsføringstekster, kreative tekster og teknisk dokumentasjon. Vi har hentet AI-innhold direkte fra ledende modeller og kuratert menneskelig tekst for å sikre bred representasjon.

- Blindtesting: Detektoren vår analyserer hver prøve uten å kjenne til kilden, og gir ut konfidensscore og klassifiseringer (AI vs. menneske).

- Statistisk analyse: Derfra regner vi ut:

- Sanne positive / Falske positive / Sanne negative / Falske negative

- Presisjon, tilbakekalling og F1-score, som er standardmål i maskinlæringsevaluering.

- Kryssvalidering: Vi tester på tvers av innholdstyper og -lengder for å måle ytelsen i reelle brukstilfeller: akademisk, markedsføring, teknisk og kreativt. Studier viser at kreativ skriving er vanskeligst å oppdage nøyaktig, så vi er ekstra oppmerksomme på dette.

- Kontinuerlig overvåking: AI-modeller utvikler seg raskt. Detektorer som er trent opp på eldre data, presterer dårligere på nyere data. Vi sporer ytelsen over tid og omskolerer ved behov for å opprettholde nøyaktigheten.

Testene våre viser at det er betydelig variasjon basert på innholdstype.

Akademisk skriving er lettest å oppdage nøyaktig. Kreative tekster byr på de største utfordringene.

Nøyaktigheten til AI-innholdsdetektoren vår

Med Undetectable AI stoler vi ikke på rykter. Vi setter detektoren vår under søkelyset selv:

- Bransjeledende ekstern validering: Uavhengige tester viser at Undetectable AIs detektor oppnår en nøyaktighet på 85 til 95% på blandet menneskelig og AI-innhold, og kan dermed konkurrere med de beste verktøyene på området.

- Evne til å oppdage parafraser: Forskning viser at Undetectable AI oppdager parafraserte AI-tekster i 100% av tilfellene i flere sammenligninger av verktøy, inkludert gratisverktøy som Sapling og QuillBot.

- Selvreflekterende testing: Undetectables egen GPTZero-sammenligningstest flagget 99% av AI-generert innhold korrekt, mens GPTZero bare flagget 85%.

- Kontinuerlig forbedring gjennom blindbytte: Når brukere menneskeliggjør AI-tekst via Undetectable AI, faller tradisjonelle detektorer (som Originality.ai) fra over 90% deteksjonsfrekvens til under 30%, noe som beviser styrken til omskrivingsmodellen vår.

- Støttet av millioner: Rangert som nummer én AI-detektor av Forbes, med over 4 millioner brukere og gratis bruk på alle plattformer.

I praksis betyr det at Undetectable AI leverer deteksjonsnøyaktighet i toppklasse og kombinerer det med en topp moderne humanizer for sømløs omskriving.

Test innholdet ditt nå - gratis skanning med vår AI-detektor. Start med selvtillit: sjekk det du skriver, få umiddelbar innsikt og iverksett tiltak.

Hvorfor vi kobler AI Detector + Humanizer

Oppdagelse alene er ikke nok. Å vite at innhold kan være AI-generert, løser ikke det underliggende problemet.

Du trenger handlingsrettede løsninger.

Derfor har vi bygget plattformen vår rundt arbeidsflyten detektor-humanizer. I stedet for bare å flagge potensielt AI-innhold, hjelper vi deg med å håndtere det.

Slik fungerer den parvise tilnærmingen:

- Oppdagelse først: AI-detektoren vår analyserer innholdet ditt og identifiserer avsnitt som kan være AI-genererte. Du får spesifikke tillitspoeng for ulike avsnitt.

- Målrettet omskriving: Vår humanizer fokuserer på de markerte delene. I stedet for å skrive om alt, modifiserer den på en intelligent måte bare de delene som trenger forbedring.

- Verifikasjonssløyfe: Etter humanisering kjører vi deteksjonen på nytt for å bekrefte at innholdet nå kan leses som menneskeskrevet.

- Bevaring av kvalitet: Prosessen opprettholder den opprinnelige meningen og stilen din, samtidig som den reduserer AI-deteksjonssignaturer.

Denne arbeidsflyten løser reelle problemer. Innholdsprodusenter kan sikre at arbeidet deres ikke utløser falske positiver. Studenter kan verifisere at det de skriver, fremstår som autentisk menneskelig.

Markedsførere kan produsere innhold som blir oppdaget, samtidig som kvaliteten opprettholdes.

Alternativet er ren deteksjon, og da står man igjen med problemer, men ingen løsninger.

Det hjelper ikke å vite at innholdet kan være AI-generert hvis du ikke kan fikse det.

Slik sammenligner vi oss med andre AI-innholdssøkere

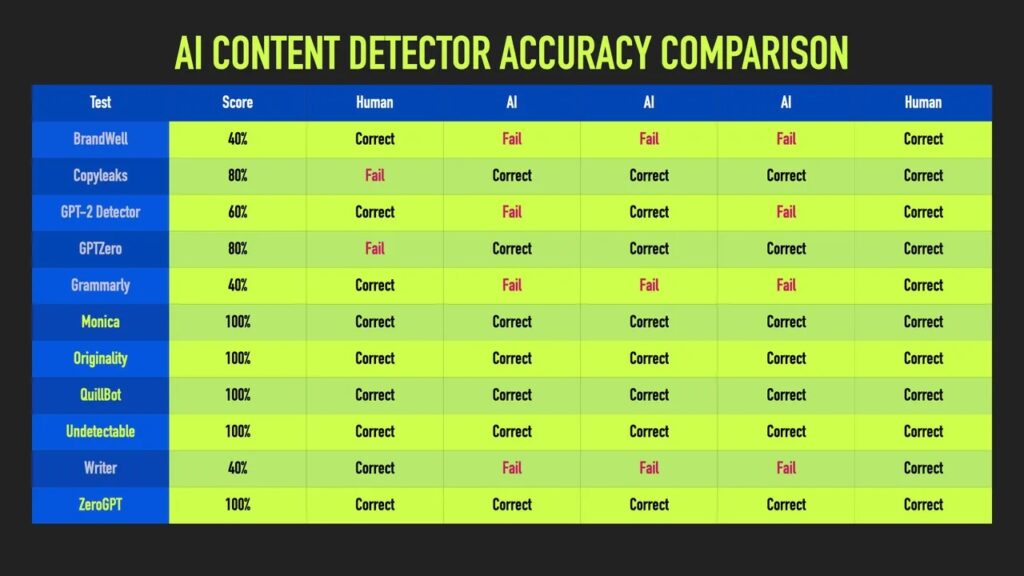

AI-deteksjonslandskapet er overfylt av verktøy med ambisiøse påstander om nøyaktighet. Uavhengige tester kaster et klarere lys over hva som faktisk fungerer.

ZDNets dypdykk i 10 store AI-innholdssøkere innebar å sende inn de samme AI-genererte prøvene til hvert verktøy og sjekke hvilke som konsekvent identifiserte AI-skrevet tekst.

Mange detektorer kom til kort. Noen av dem som hevdet at de hadde nesten perfekt nøyaktighet, fikk knapt bedre resultater enn tilfeldighetene da de ble testet på virkelig innhold.

Uoppdagelig AI skilte seg imidlertid ut og havnet blant de fem beste for konsekvent deteksjon av AI-tekst på tvers av alle prøver.

ZDNet testet 10 AI-detektorer ved hjelp av identiske AI-genererte prøver.

Av disse var det bare tre verktøy som flagget AI-tekst 100% av gangene i alle de testede prøvene.

Det er verdt å merke seg at resultatene våre var solide uansett innholdstype, ikke bare på kuraterte, enkle eksempler.

- Konsekvent ytelse over et bredt spekter av AI-modeller og innholdstyper. Mens konkurrentene ofte utmerker seg på snevre områder, har vi nøyaktighet over hele linjen.

- Tydelig metodikk. Vi forklarer testprosedyrene våre og oppdaterer ytelsesmålingene regelmessig, uten vage påstander.

- Integrerte løsninger. Vi kobler deteksjon med omskriving via Humanizer. Med rene deteksjonsfokuserte verktøy får du problemer, men ingen løsninger.

- Hyppig omskolering. Vi trener modellene våre kontinuerlig etter hvert som AI-generasjonen utvikler seg. Statiske detektorer mister raskt sin relevans.

- Ærlige begrensninger. Vi kommuniserer tydelig utfordringer og grensetilfeller. Overdrevne løfter fører til frustrasjon hos brukerne og dårlige beslutninger.

ZDNets studie understreket et viktig poeng: Konsistens trumfer prangende høyder. En detektor som er pålitelig 95% av gangene, slår en som treffer 99% av og til, men krasjer til 60% i andre sammenhenger.

Test innholdet ditt nå | Gratis skanning med vår AI-detektor.

Se på førstehånd hvor du står. Skann det du skriver, få pålitelige resultater, og ta de neste skrittene.

Se vår AI Detector og Humanizer i aksjon - bare bruk widgeten nedenfor!

Tillit, åpenhet og verktøy som leverer

Nøyaktigheten til AI-innholdssøkere handler om mer enn bare tall. Det handler om å forstå hva disse verktøyene kan og ikke kan gjøre på en pålitelig måte.

Deteksjonsteknologien er lovende, men ufullkommen. Selv de beste verktøyene gjør feil. Når du kjenner til disse begrensningene, kan du bruke dem på en klok måte.

Fremtiden for AI-deteksjon går i retning av multimodal analyse, atferdsmønstre og verifisering i samarbeid.

Inntil videre bør deteksjonsverktøy som Undetectable AI behandles som nyttige assistenter, ikke som endelige dommere. Kombiner dem med menneskelig dømmekraft, og velg løsninger som passer til dine behov.

Ren deteksjon løser sjelden reelle problemer. Derfor tilbyr Undetectable AI en integrert arbeidsflyt som balanserer deteksjon med forbedring av innholdet.

Målet er ikke å eliminere AI fra skrivingen, men å sikre åpenhet, opprettholde kvaliteten og bevare tilliten.

Forståelse av detektorens nøyaktighet, spesielt med Ikke påvisbar AIgir deg kontroll over prosessen.