Cu prompt AI dreapta, puteți face practic orice. Iată cât de puternice sunt deja instrumentele AI.

Instrumentele de inteligență artificială au remodelat modul de funcționare al întreprinderilor, permițându-le să eficientizeze procesele și să crească eficiența ca niciodată până acum.

Un domeniu în care AI excelează cu adevărat este crearea de conținut. Nu ne referim doar la redactarea de schițe sau la generarea de postări pe rețelele sociale.

AI vă poate ajuta chiar și scrieți cărți și să completeze lucrări de cercetare complexe.

Dar odată cu o mare putere vine și o mare responsabilitate, iar AI nu poate fi întotdeauna de încredere să facă ceea ce trebuie.

Uneori, AI produce ceea ce se numește "halucinații". Acestea sunt rezultate incorecte sau bizare care pot induce în eroare utilizatorii.

Aproape jumătate dintre organizații raportează provocări legate de calitatea datelor care pun în pericol inițiativele în domeniul IA.

Nu este un glonț de argint, dar "fundamentarea" urmărește să asigure că rezultatele AI se bazează pe informații fiabile.

Deși ar putea părea complex, răspunsul la întrebarea "Ce este împământarea și halucinațiile în inteligența artificială?" este crucial pentru oricine utilizează aceste instrumente puternice.

Să intrăm în detaliile halucinației AI, astfel încât să vă puteți maximiza cu încredere randamentul cu AI, asigurându-vă în același timp că informațiile dvs. rămân exacte.

Principalele concluzii

- Halucinațiile AI apar atunci când modelele generează informații false sau înșelătoare din cauza lacunelor de date sau a ajustării excesive.

- Fundamentarea ancorează rezultatele AI la date verificate, din lumea reală, pentru a reduce halucinațiile și a îmbunătăți fiabilitatea.

- Halucinațiile în crearea de conținut pot afecta credibilitatea, pot răspândi informații eronate și pot cauza probleme juridice.

- Preveniți problemele utilizând instrumente fiabile, verificând conținutul și oferind indicații clare și detaliate.

- Combinarea detecției AI și a supravegherii umane - ca în cazul AI nedetectabil - asigură acuratețea și autenticitatea.

Ce este împământarea și halucinațiile în IA?

Când vine vorba de a înțelege ce este halucinația în inteligența artificială, cunoașterea modului în care ar putea apărea este deosebit de utilă pentru organizațiile care au nevoie de informații cât mai exacte posibil.

Învățând despre împământare și halucinațiile inteligenței artificiale, veți putea să înțelegeți mai bine cum funcționează instrumentele AI și să garantați că Conținut generat de AI rămâne credibil.

Ce sunt halucinațiile în IA?

Imaginați-vă că cereți unui chatbot AI informații despre o persoană.

Nu vă mai îngrijorați niciodată că AI vă detectează textele. Undetectable AI Vă poate ajuta:

- Faceți să apară scrisul dvs. asistat de AI asemănătoare omului.

- Bypass toate instrumentele majore de detectare AI cu un singur clic.

- Utilizați AI în siguranță și cu încredere în școală și la locul de muncă.

Modelul furnizează cu acuratețe detalii frecvent menționate în diferite surse online.

Dar apoi, pe măsură ce verificați informațiile furnizate, observați că inteligența artificială ghicește incorect și informații mai puțin cunoscute, cum ar fi vârsta și nivelul de educație.

Aceste detalii greșite sunt ceea ce se numește "halucinații".

Ratele halucinațiilor poate varia între modele. ChatGPT a raportat anterior aproximativ 3%, în timp ce sistemele Google au fost estimate la până la 27%.

Aceste chatbots sunt conduse de un model lingvistic mare care învață din analiza unor cantități masive de text.

Acest lucru se întâmplă deoarece aceste modele sunt antrenate să prezică cuvinte pe baza tiparelor din datele pe care le-au analizat, fără a înțelege ce este adevărat sau nu.

Halucinațiile provin în principal din date de formare incomplete.

Rețineți că modelul poate detecta și reproduce erori în funcție de ceea ce primește.

Există, de asemenea, "supraajustarea", atunci când modelul identifică modele sau conexiuni false în date.

Rezolvarea halucinațiilor AI este o provocare, deoarece aceste modele, care funcționează pe baza probabilităților și a modelelor, vor produce inevitabil rezultate false.

Acest lucru poate induce în eroare utilizatorii care ar putea avea încredere în conținutul AI așa cum este. De aceea, este important să fiți conștienți de această limitare atunci când utilizați AI pentru crearea de conținut și verificarea faptelor.

Ce este Grounding AI?

Grounding AI este o metodă eficientă de reducere a halucinațiilor. Aceasta funcționează prin ancorarea răspunsurilor AI la datele din lumea reală.

De exemplu, un sistem fundamentat ar utiliza de la bun început o bază de date fiabilă pentru a oferi răspunsuri concrete, reducând probabilitatea ca inteligența artificială să inventeze lucruri.

În loc să se bazeze doar pe prezicerea următorului cuvânt pe baza modelelor, un sistem fundamentat extrage mai întâi informații dintr-o sursă credibilă.

Modelul este, de asemenea, mai acceptabil din punct de vedere etic, deoarece admite că contextul este insuficient, astfel încât nu va fi capabil să furnizeze toate informațiile de care aveți nevoie, în loc să ghicească.

Pentru a maximiza valoarea inteligenței artificiale, minimizând în același timp inexactitățile, organizațiile ar trebui să investească timp în colectarea de date de formare exacte, orientări și alte informații generale necesare.

Această pregătire ajută rezultatele AI să rămână ancorate în realitate și să poată fi acceptate de utilizatori.

Așadar, deși împământarea nu este o soluție infailibilă, aceasta poate îmbunătăți semnificativ calitatea ieșirilor AI.

Care este problema halucinației AI în crearea de conținut?

În crearea de conținut, halucinațiile AI pot lua diferite forme.

Atunci când creează o postare pe blog sau un articol, AI poate include fapte false, statistici incorecte sau citate inventate.

Halucinația AI nu este nici ea o înșelăciune intenționată. Modelul nu poate minți, deoarece nu are motivația de a înșela și nici nu este conștient că ceea ce spune este fals.

Pur și simplu îi lipsește o idee despre cât de fiabile sunt rezultatele sale.

Consecințele halucinațiilor AI în crearea de conținut pot fi grave.

- Răspândirea dezinformării: Mai mult de una din cinci persoane admit că este posibil să fi distribuit știri false fără să verifice.

- Daune aduse credibilității: Dacă o persoană sau o companie publică conținut cu informații înșelătoare, reputația sa poate avea de suferit. Încrederea este crucială pentru utilizatori, iar odată pierdută, poate fi dificil de recâștigat.

- Repercusiuni juridice și financiare: Publicarea de informații false poate duce la potențiale bătăi de cap, chiar și la procese. Este o luptă costisitoare cu care nu doriți să vă confruntați.

- Impactul negativ asupra deciziilor de afaceri: Companiile care se bazează pe inteligența artificială pentru a produce rapoarte și informații pentru luarea deciziilor pot duce la alegeri greșite bazate pe date incorecte. Informațiile false cauzează prejudicii atât publicului, cât și companiei sau persoanei care utilizează AI pentru crearea de conținut. Iar halucinațiile AI pot de fapt să agraveze această problemă prin generarea de conținut care pare credibil, dar care este de fapt eronat.

Cum să preveniți problemele cauzate de halucinațiile AI

Știm cât de valoroase sunt instrumentele AI în crearea de conținut. Utilizarea AI este chiar considerată una dintre cele mai cele mai bune modalități de a face bani astăzi și pentru a rămâne competitiv în industrie.

Acesta este și motivul pentru care abordarea problemei halucinațiilor AI este crucială pentru a vă asigura că conținutul pe care îl utilizați cu AI este corect.

Înțelegerea limitelor inteligenței artificiale

Deși știm deja cât de puternică este inteligența artificială, aceasta are limitele sale.

Când vine vorba de crearea de conținut, funcționează foarte bine la recunoașterea modelelor și la generarea de text pe baza unor seturi uriașe de date, dar îi lipsește orice simț al realității.

Țineți cont de aceste limitări atunci când utilizați AI:

- Se străduiește să înțeleagă contextul sau să înțeleagă distincțiile culturale subtile

- Se bazează în mare măsură pe calitatea și cantitatea informațiilor disponibile

- Tendința de a crea prejudecăți pe baza datelor de instruire

- îi lipsește creativitatea și originalitatea de tip uman

- Poate genera conținut care este discutabil din punct de vedere moral

- Are probleme în rezolvarea problemelor în afara a ceea ce știe sistemul

- Dificultate în adaptarea la situații schimbătoare sau în furnizarea de informații în timp real

- Vulnerabil la atacuri și poate compromite confidențialitatea datelor

Cunoașterea limitelor sale previne, de asemenea, halucinațiile AI. Limitele ajută la stabilirea unor așteptări realiste și facilitează detectarea inexactităților înainte ca acestea să devină publice.

Utilizați modele și instrumente fiabile

The cele mai bune instrumente AI pentru crearea de conținut faceți lucrurile mai ușoare. Aceste instrumente nu sunt perfecte, dar cele pe care le folosiți ar trebui cu siguranță să vă facă treaba.

Pentru chatbots AI, ChatGPT este încă cel mai puternic de acolo. GPT-4 se mândrește cu o rată ridicată de acuratețe de 97% și cea mai mică rată de halucinații ChatGPT.

Asigurați-vă doar că oferiți indicații clare și verificați rezultatele în raport cu surse de încredere.

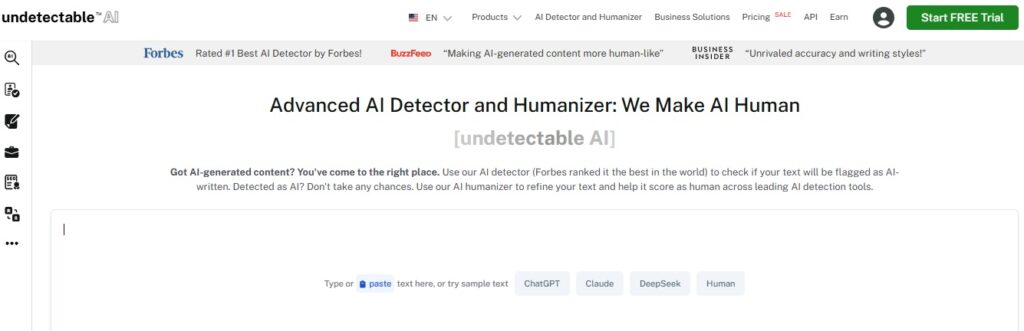

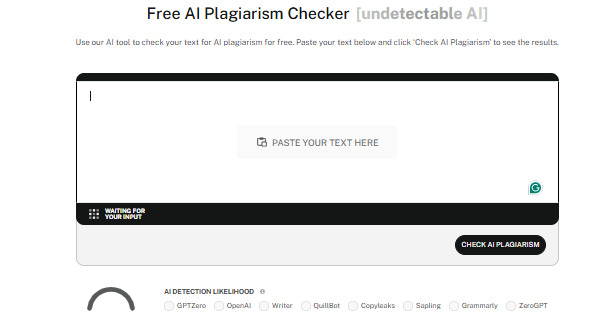

De asemenea, ar trebui să utilizați instrumente de detectare a IA de încredere, cum ar fi AI nedetectabil.

Detectoarele analizează eficient conținutul pentru a detecta chiar și cele mai subtile elemente AI, menținând autenticitatea în orice conținut pe care îl produceți și menținându-vă credibilitatea.

Undetectable are, de asemenea, un AI Humanizer care rafinează în continuare textul pentru a suna natural.

Cu ajutorul acestuia, nu treceți doar de detectarea AI, ci garantați și calitatea conținutului dvs.

Verificarea conținutului

Indiferent de modul în care utilizați inteligența artificială în procesul de creare a conținutului, este întotdeauna important să verificați conținutul pe care l-ați produs.

Acestea sunt câteva modalități comune de verificare a conținutului IA:

- Verificarea încrucișată prin compararea informațiilor din mai multe surse de încredere

- Utilizați instrumente de verificare a faptelor pentru a simplifica dezmințirea dezinformării

- Căutați informații de la experți în domeniu sau profesioniști în domeniu

- Revizuirea conținutului de către colegi pentru a ajuta la identificarea potențialelor erori, prejudecăți sau inexactități

- Utilizați software-ul de detectare a IA pentru a asigura originalitatea și a evita plagiat neintenționat

- Luați în considerare contextul istoric atunci când faceți referire la evenimente sau date pentru acuratețe

Luarea de măsuri de precauție dă rezultate. Verificarea conținutului AI vă oferă încrederea atât de necesară că ceea ce produceți este întotdeauna demn de încredere.

Furnizați instrucțiuni clare

Una dintre principalele cauze ale halucinației AI sunt instrucțiunile neclare.

Dacă adresați AI întrebări prea vagi, fără niciun context suplimentar, este mai probabil să genereze răspunsuri care nu prea au sens.

Indicațiile clare și specifice sunt cele care mențin AI pe drumul cel bun.

Așadar, fiți specifici și detaliați în îndemnurile voastre.

În loc să puneți întrebări prea generale, precum "Care este cel mai bun restaurant asiatic?", încercați ceva mai concentrat, precum "Care sunt cele mai bine cotate magazine de ramen din Kyoto?"

Specificitatea ajută inteligența artificială să rămână pe drumul cel bun și să producă rezultate exacte care să vă satisfacă așteptările.

Rămâneți la curent

Tehnologia continuă să avanseze, și asta într-un ritm rapid, așa că asigurați-vă că vă mențineți la curent.

IA învață, în esență, din datele pe care este antrenată, însă informațiile pot deveni rapid depășite.

Acest lucru este valabil mai ales în domenii cu evoluție rapidă precum cercetarea științifică sau asistența medicală.

Vă puteți informa urmărind surse de încredere pe rețelele de socializare sau puteți urma cursuri legate de domeniul dvs. de activitate și participa la evenimente din domeniu.

În acest fel, veți avea o perspectivă asupra faptului că conținutul furnizat de AI rămâne credibil.

Instrumentele de inteligență artificială se actualizează destul de des, de asemenea, așa că rămâneți la curent cu cele mai recente evoluții, astfel încât să fiți întotdeauna siguri că le utilizați pe cele mai bune.

Expertiza umană

Oameni și inteligență artificială trebuie să lucreze împreună pentru a asigura calitatea, acuratețea și autenticitatea în crearea de conținut

Până la urmă, noi suntem cei care aducem gândirea critică, creativitatea și judecata etică la masa de lucru.

Prin combinarea capacităților AI cu supravegherea umană, puteți verifica dacă conținutul nu este doar corect, ci și relevant din punct de vedere contextual - precum și dacă este captivant și dacă atinge notele potrivite.

Experții umani pot identifica prejudecățile, pot verifica de două ori informațiile și pot lua decizii pe care inteligența artificială singură nu le-ar putea înțelege.

Oamenii și inteligența artificială, împreună, pot crea conținut de încredere, perspicace și cu impact.

Consultați Detectorul AI și Humanizer în widgetul de mai jos!

Concluzie

Înțelegerea a ceea ce înseamnă împământare și halucinații în IA este esențială pentru oricine utilizează instrumente de IA în activitatea sa.

Fundamentarea face inteligența artificială mai precisă și menține integritatea conținutului dvs. prin utilizarea de date reale, verificate.

Conștientizarea halucinațiilor AI vă ajută, de asemenea, să cunoașteți modalitățile corecte de a le evita și de a vă feri de potențiale capcane.

Menținerea acurateții conținutului AI este doar o parte a procesului. Asigurați-vă că conținutul dvs. rămâne autentic și de înaltă calitate prin utilizarea AI nedetectabil.

Acest instrument acționează atât ca un detector AI, cât și ca un umanizator, asigurându-se că conținutul generat de AI se îmbină perfect cu scrisul uman și poate trece de detecții.

Alegeți cele mai bune opțiuni de verificare a conținutului AI pentru nevoile dvs. și lăsați AI nedetectabil păstrează în mod constant conținutul tău fiabil, original și uman. Începeți să îl utilizați astăzi.