Con il prompt AI destropuoi fare praticamente qualsiasi cosa. Ecco quanto sono potenti gli strumenti di intelligenza artificiale.

Gli strumenti di intelligenza artificiale hanno rimodellato il modo in cui le aziende operano, consentendo loro di semplificare i processi e di aumentare l'efficienza come mai prima d'ora.

Un'area in cui l'intelligenza artificiale eccelle davvero è la creazione di contenuti. Non stiamo parlando solo della stesura di bozze o della generazione di post sui social media.

L'intelligenza artificiale può anche aiutarti scrivere libri e completare documenti di ricerca complessi.

Ma da un grande potere derivano grandi responsabilità e non sempre ci si può fidare che l'IA faccia la cosa giusta.

A volte, l'intelligenza artificiale produce le cosiddette "allucinazioni". Si tratta di risultati errati o bizzarri che possono trarre in inganno gli utenti.

Quasi la metà delle organizzazioni riferisce problemi di qualità dei dati che mettono a rischio le iniziative di IA.

Non si tratta di una pallottola d'argento, ma la "messa a terra" mira a garantire che i risultati dell'IA siano basati su informazioni affidabili.

Anche se può sembrare complesso, la risposta alla domanda "Che cos'è il grounding e le allucinazioni nell'IA?" è fondamentale per chiunque utilizzi questi potenti strumenti.

Entriamo nei dettagli dell'allucinazione dell'IA in modo che tu possa massimizzare con sicurezza i tuoi risultati con l'IA e assicurarti che le tue informazioni siano accurate.

Punti di forza

- Le allucinazioni dell'intelligenza artificiale si verificano quando i modelli generano informazioni false o fuorvianti a causa di lacune nei dati o di overfitting.

- La messa a terra ancorerà i risultati dell'intelligenza artificiale a dati verificati e reali per ridurre le allucinazioni e migliorare l'affidabilità.

- Le allucinazioni nella creazione di contenuti possono danneggiare la credibilità, diffondere disinformazione e causare problemi legali.

- Prevenire i problemi utilizzando strumenti affidabili, verificando i contenuti e fornendo indicazioni chiare e dettagliate.

- La combinazione di rilevamento AI e supervisione umana, come nel caso di Undetectable AI, garantisce precisione e autenticità.

Cos'è il grounding e le allucinazioni nell'IA?

Quando si tratta di capire cosa sia l'allucinazione nell'IA, sapere come potrebbe verificarsi è particolarmente utile per le organizzazioni che hanno bisogno di informazioni il più possibile accurate.

Imparando a conoscere il grounding e le allucinazioni dell'intelligenza artificiale, sarai in grado di capire meglio come funzionano gli strumenti dell'IA e di garantire che il tuo Contenuti generati dall'intelligenza artificiale rimane credibile.

Cosa sono le allucinazioni nell'IA?

Immagina di chiedere a un chatbot AI informazioni su una persona.

Non preoccupatevi più che l'intelligenza artificiale rilevi i vostri messaggi. Undetectable AI Può aiutarvi:

- Fate apparire la vostra scrittura assistita dall'intelligenza artificiale simile all'uomo.

- Bypass tutti i principali strumenti di rilevamento dell'intelligenza artificiale con un solo clic.

- Utilizzo AI in modo sicuro e con fiducia a scuola e al lavoro.

Il modello fornisce con precisione i dettagli spesso citati in diverse fonti online.

Ma poi, facendo un controllo incrociato delle informazioni fornite, ti accorgi che l'intelligenza artificiale indovina anche informazioni meno conosciute, come l'età e il percorso di studi.

Questi dettagli sbagliati sono noti come "allucinazioni".

Tassi di allucinazione può variare da un modello all'altro. ChatGPT ha precedentemente riportato circa 3%, mentre i sistemi di Google sono stati stimati fino a 27%.

Questi chatbot sono guidati da un modello linguistico di grandi dimensioni che impara analizzando enormi quantità di testo.

Questo accade perché questi modelli vengono addestrati a predire le parole in base agli schemi presenti nei dati che hanno analizzato, senza capire cosa sia vero o meno.

Le allucinazioni derivano per lo più da dati di formazione incompleti.

Ricorda che il modello può rilevare e riprodurre errori a seconda di ciò che gli viene somministrato.

C'è anche l'"overfitting", in cui il modello identifica falsi schemi o connessioni nei dati.

Risolvere le allucinazioni dell'intelligenza artificiale è una sfida perché questi modelli, operando su probabilità e modelli, produrranno inevitabilmente falsi risultati.

Questo può fuorviare gli utenti che potrebbero fidarsi dei contenuti dell'IA così come sono. Ecco perché è importante essere consapevoli di questa limitazione quando si utilizza l'IA per la creazione di contenuti e il fact-checking.

Che cos'è il Grounding AI?

Il Grounding AI è un metodo efficace per ridurre le allucinazioni. Funziona ancorando le risposte dell'IA ai dati del mondo reale.

Ad esempio, un sistema fondato utilizzerebbe un database affidabile fin dall'inizio per fornire risposte concrete, riducendo la probabilità che l'IA si inventi qualcosa.

Invece di affidarsi solo alla previsione della parola successiva basata su schemi, un sistema fondato recupera prima le informazioni da una fonte credibile.

Il modello è anche più accettabile dal punto di vista etico perché ammette che il contesto è insufficiente, quindi non sarà in grado di fornire tutte le informazioni di cui hai bisogno, piuttosto che tirare a indovinare.

Per massimizzare il valore dell'IA e ridurre al minimo le imprecisioni, le aziende dovrebbero investire tempo in anticipo per raccogliere dati di formazione accurati, linee guida e altre informazioni di base necessarie.

Questa preparazione aiuta i risultati dell'IA a rimanere ancorati alla realtà e a fidarsi degli utenti.

Quindi, anche se la messa a terra non è una soluzione infallibile, può migliorare significativamente la qualità dei risultati dell'IA.

Qual è il problema dell'allucinazione dell'intelligenza artificiale nella creazione di contenuti?

Nella creazione di contenuti, le allucinazioni dell'IA possono assumere diverse forme.

Durante la creazione di un post o di un articolo, l'IA potrebbe includere fatti falsi, statistiche errate o citazioni inventate.

L'allucinazione dell'intelligenza artificiale non è nemmeno un inganno intenzionale. Il modello non può mentire perché non ha alcuna motivazione per ingannare, né è consapevole che ciò che sta dicendo è falso.

Manca semplicemente la percezione dell'affidabilità dei suoi risultati.

Le conseguenze delle allucinazioni dell'IA nella creazione di contenuti possono essere gravi.

- Diffusione della disinformazione: Più di una persona su cinque ammettere che potrebbero aver condiviso notizie false senza controllare.

- Danno alla credibilità: Se un individuo o un'azienda pubblica contenuti con informazioni fuorvianti, la sua reputazione può risentirne. La fiducia è fondamentale per gli utenti e, una volta persa, può essere difficile riconquistarla.

- Ripercussioni legali e finanziarie: La pubblicazione di informazioni false può portare a potenziali problemi e persino a cause legali. È una battaglia costosa che non vorrai affrontare.

- Impatto negativo sulle decisioni aziendali: Le aziende che si affidano all'IA per produrre report e approfondimenti per il processo decisionale possono fare scelte sbagliate basate su dati errati. Le informazioni false danneggiano sia il pubblico che l'azienda o l'individuo che utilizza l'IA per la creazione di contenuti. Inoltre, le allucinazioni dell'IA possono peggiorare il problema, generando contenuti che sembrano credibili ma che in realtà sono errati.

Come prevenire i problemi causati dalle allucinazioni dell'IA

Sappiamo quanto siano preziosi gli strumenti di intelligenza artificiale nella creazione di contenuti. L'utilizzo dell'intelligenza artificiale è addirittura considerato uno dei I migliori modi per fare soldi oggi e per rimanere competitivi nel settore.

È anche per questo che affrontare il problema delle allucinazioni dell'IA è fondamentale per garantire che i contenuti che utilizzi con l'IA siano accurati.

Comprendere i limiti dell'intelligenza artificiale

Sebbene sappiamo già quanto sia potente l'intelligenza artificiale, ha i suoi limiti.

Per quanto riguarda la creazione di contenuti, funziona molto bene nel riconoscimento dei modelli e nella generazione di testi basati su enormi set di dati, ma manca ancora il senso della realtà.

Tieni presente queste limitazioni quando usi l'IA:

- Fatica ad afferrare il contesto o a comprendere le sottili distinzioni culturali.

- Dipende molto dalla qualità e dalla quantità di informazioni disponibili.

- Tendenza a creare pregiudizi sulla base dei dati di formazione

- Manca di creatività e originalità simili a quelle umane

- Può generare contenuti moralmente discutibili

- Ha problemi a risolvere problemi che esulano dalle conoscenze del sistema.

- Difficoltà ad adattarsi a situazioni mutevoli o a fornire input in tempo reale.

- Vulnerabile agli attacchi e può compromettere la privacy dei dati

Conoscere i propri limiti previene anche le allucinazioni dell'AI. I limiti aiutano a stabilire aspettative realistiche e rendono più facile individuare le imprecisioni prima che diventino pubbliche.

Usa modelli e strumenti affidabili

Il I migliori strumenti di intelligenza artificiale per la creazione di contenuti semplificano le cose. Questi strumenti non sono perfetti, ma quelli che utilizzi dovrebbero essere in grado di portare a termine il lavoro.

Per i chatbot con intelligenza artificiale, ChatGPT è ancora il il più forte in circolazione. Il GPT-4 vanta un alto tasso di precisione di 97% e il più basso tasso di allucinazioni ChatGPT.

Assicurati di fornire indicazioni chiare e di verificare i risultati con fonti affidabili.

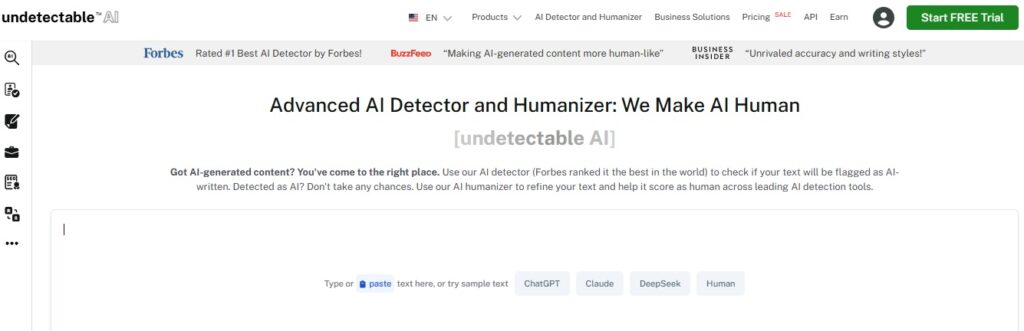

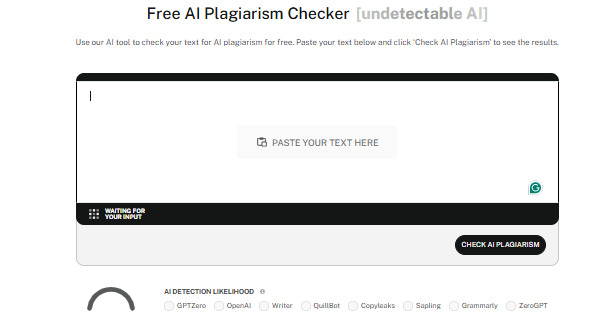

Dovresti anche utilizzare strumenti di rilevamento dell'intelligenza artificiale affidabili come AI non rilevabile.

I rilevatori analizzano i contenuti in modo efficace per individuare anche i più sottili elementi di IA, mantenendo l'autenticità dei contenuti che produci e la tua credibilità.

Undetectable ha anche un Umanizzatore AI che perfeziona ulteriormente il testo in modo che suoni naturale.

Con esso non solo superi il rilevamento dell'AI, ma garantisci anche la qualità dei tuoi contenuti.

Verifica il contenuto

Indipendentemente dal modo in cui utilizzi l'intelligenza artificiale nel processo di creazione dei contenuti, è sempre importante verificare i contenuti che hai prodotto.

Questi sono alcuni modi comuni per verificare i contenuti dell'IA:

- Verifica incrociata confrontando le informazioni su più fonti affidabili.

- Usa gli strumenti di fact-checking per semplificare lo smascheramento della disinformazione

- Cerca di ottenere informazioni da esperti del settore o da professionisti del settore.

- Fai rivedere i contenuti a colleghi o colleghi per individuare potenziali errori, pregiudizi o imprecisioni.

- Utilizza un software di rilevamento dell'intelligenza artificiale per garantire l'originalità ed evitare che plagio involontario

- Considera il contesto storico quando fai riferimento a eventi o dati per verificarne l'accuratezza.

Prendere precauzioni paga. La verifica dei contenuti dell'AI ti dà la certezza che ciò che produci è sempre affidabile.

Fornisci istruzioni chiare

Una delle cause principali dell'allucinazione da IA è la scarsa chiarezza delle istruzioni.

Se poni all'intelligenza artificiale domande troppo vaghe e prive di un contesto aggiuntivo, è più probabile che generi risposte prive di senso.

I suggerimenti chiari e specifici sono ciò che mantiene l'IA in carreggiata.

Quindi, sii specifico e dettagliato nei tuoi suggerimenti.

Invece di fare domande troppo ampie, come "Qual è il miglior ristorante asiatico?", prova a fare qualcosa di più mirato, come "Quali sono i negozi di ramen più quotati di Kyoto?".

La specificità aiuta l'IA a non perdere la rotta e a produrre risultati accurati che soddisfino le tue aspettative.

Rimanete aggiornati

La tecnologia continua a progredire, per di più a ritmi serrati, quindi assicurati di tenerti aggiornato.

L'intelligenza artificiale impara essenzialmente dai dati su cui viene addestrata, ma le informazioni possono diventare rapidamente obsolete.

Questo è particolarmente vero in campi in rapida evoluzione come la ricerca scientifica o l'assistenza sanitaria.

Puoi rimanere informato seguendo fonti attendibili sui social media, oppure seguire corsi relativi al tuo settore e partecipare a eventi di settore.

In questo modo, hai la certezza che i contenuti forniti dall'IA rimangano credibili.

Anche gli strumenti di intelligenza artificiale si aggiornano molto spesso, quindi tieniti aggiornato sugli ultimi sviluppi in modo da essere sempre sicuro di utilizzare i migliori.

Competenza umana

Umani e IA devono collaborare per garantire la qualità, l'accuratezza e l'autenticità della creazione di contenuti.

In fin dei conti, siamo noi a portare in tavola il pensiero critico, la creatività e il giudizio etico.

Combinando le capacità dell'intelligenza artificiale con la supervisione umana, puoi verificare che i contenuti non solo siano accurati ma anche contestualmente rilevanti, oltre che coinvolgenti e in grado di colpire nel segno.

Gli esperti umani possono individuare i pregiudizi, ricontrollare le informazioni e prendere decisioni che l'intelligenza artificiale da sola non sarebbe in grado di cogliere.

Gli esseri umani e l'intelligenza artificiale, insieme, sono in grado di creare contenuti affidabili, interessanti e d'impatto.

Scoprite il nostro AI Detector e Humanizer nel widget qui sotto!

Conclusione

Capire cosa sia il grounding e le allucinazioni nell'IA è essenziale per chiunque utilizzi strumenti di IA nel proprio lavoro.

La messa a terra rende l'intelligenza artificiale più accurata e mantiene l'integrità dei tuoi contenuti utilizzando dati reali e verificati.

Essere consapevoli delle allucinazioni dell'IA ti aiuta anche a conoscere i modi giusti per evitarle e a stare alla larga da potenziali insidie.

Mantenere accurati i contenuti dell'IA è solo un aspetto del processo. Assicurati che i tuoi contenuti siano autentici e di alta qualità utilizzando Undetectable AI.

Questo strumento agisce sia come rilevatore di AI che come umanizzatore, assicurandosi che i contenuti generati dall'AI si fondano perfettamente con la scrittura umana e possano superare i controlli.

Scegliete le migliori opzioni di verifica dei contenuti AI per le vostre esigenze e lasciate che AI non rilevabile mantenere costantemente i vostri contenuti affidabili, originali e umani. Iniziate a usarlo oggi stesso.